Blickverfolgung auf HoloLens 2

HoloLens 2 ermöglicht eine neue Ebene des Kontexts und des menschlichen Verständnisses innerhalb der holografischen Benutzeroberfläche, indem entwickler die Möglichkeit erhalten, Informationen darüber zu verwenden, was der Benutzer betrachtet. Auf dieser Seite wird erläutert, wie Entwickler von Eyetracking für verschiedene Anwendungsfälle profitieren können und worauf sie beim Entwerfen von Blick-basierten Benutzerinteraktionen achten müssen.

Die EyeTracking-API wurde unter Berücksichtigung der Privatsphäre eines Benutzers entwickelt. es verhindert die Weitergabe von identifizierbaren Informationen, insbesondere biometrischen Daten. Für Eyetracking-fähige Anwendungen muss der Benutzer der App die Berechtigung zur Verwendung von Eyetracking-Informationen erteilen.

Geräteunterstützung

| Feature | HoloLens (1. Generation) | HoloLens 2 | Immersive Headsets |

| Blick auf die Augen | ❌ | ✔️ | ❌ |

Demo der Entwurfskonzepte für Kopf- und Eyetracking

Wenn Sie die Entwurfskonzepte für Kopf- und Eyetracking in Aktion sehen möchten, sehen Sie sich unten unsere Videodemo Entwerfen von Hologrammen: Kopf- und Eyetracking an. Wenn Sie fertig sind, fahren Sie mit einem ausführlicheren Einblick in bestimmte Themen fort.

Dieses Video stammt aus der HoloLens 2-App "Entwerfen von Hologrammen". Sie können das vollständige Erlebnis hier herunterladen und genießen.

Kalibrierung

Damit eye tracking genau funktioniert, muss jeder Benutzer eine Eyetracking-Benutzerkalibrierung durchlaufen, für die der Benutzer eine Reihe holografischer Ziele betrachten muss. Dies ermöglicht es dem Gerät, das System anzupassen, was zu einer komfortableren und qualitativ hochwertigeren Anzeige für den Benutzer führt und gleichzeitig eine genaue Eyetracking gewährleistet.

Die Augenverfolgung sollte für die meisten Benutzer funktionieren, aber es gibt selten Fälle, in denen ein Benutzer nicht erfolgreich kalibrieren kann. Die Kalibrierung kann aus verschiedenen Gründen fehlschlagen, einschließlich, aber nicht beschränkt auf:

- Der Benutzer hat sich zuvor gegen den Kalibrierungsprozess entschieden.

- Der Benutzer wurde abgelenkt und befolgte nicht die Kalibrierungsziele.

- Der Benutzer verfügt über bestimmte Arten von Kontaktlinsen und Brillen, die das System noch nicht unterstützt.

- Der Benutzer hat bestimmte Augenphysiologie oder Augenerkrankungen oder hatte eine Augenoperation, die das System noch nicht unterstützt.

- Externe Faktoren, die eine zuverlässige Augenverfolgung verhindern, z. B. Schmierungen auf dem HoloLens-Visier oder der Brille, intensive direkte Sonneneinstrahlung und Verschlüsse durch Haare vor den Augen.

Entwickler sollten sicherstellen, dass sie ausreichend Unterstützung für Benutzer bereitstellen, für die Eyetracking-Daten möglicherweise nicht verfügbar sind (die nicht in der Lage sind, erfolgreich zu kalibrieren). Empfehlungen für Fallbacklösungen finden Sie im Abschnitt unten auf dieser Seite.

Weitere Informationen zur Kalibrierung und zur Gewährleistung einer reibungslosen Benutzererfahrung finden Sie auf unserer Seite zur Kalibrierung von Benutzern für Eyetrackings .

Verfügbare Eyetracking-Daten

Eyetracking auf HoloLens 2 ermöglicht Entwicklern das Entwerfen natürlicher und intuitiver Eingabe- und Interaktionsszenarien. Die EyeTracking-API stellt informationen darüber bereit, was der Benutzer als einzelner Blickstrahl (Blickherkunft und -richtung) bei etwa 30 FPS (30 Hz) betrachtet. Damit die Blickverfolgung exakt funktioniert, muss jeder Benutzer eine Benutzerkalibrierung für seine Blickverfolgung durchlaufen. Ausführlichere Informationen zum Zugriff auf Eyetracking-Daten finden Sie in unseren Entwicklerhandbüchern für die Verwendung des Blicks in DirectX und des Blicks in Unity.

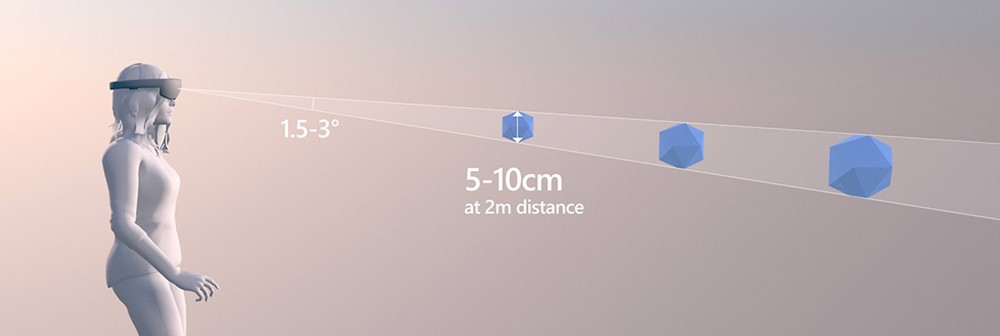

Der vorhergesagte Blick liegt ungefähr innerhalb von 1,5 Grad im Sichtwinkel um das tatsächliche Ziel (siehe Abbildung unten). Es werden geringfügige Ungenauigkeiten erwartet, daher sollten Entwickler einen gewissen Abstand um diesen niedrigeren Grenzwert einplanen (z. B. können 2,0 bis 3,0 Grad zu einer viel komfortableren Erfahrung führen). Im Folgenden wird ausführlicher erläutert, wie Sie die Auswahl kleiner Ziele behandeln können.

Optimale Zielgröße bei einer Entfernung von 2 Metern

Erweiterte EyeTracking-Daten

Erweiterte Eyetracking-APIs ermöglichen Es Entwicklern, die nächste Ebene innovativer Szenarien wie Gesundheitsbewertung, Überwachung und Therapie zu erschließen, indem sie präzisere Informationen über den Blick des Benutzers bereitstellen.

Erweiterte Eyetracking-APIs bieten Zugriff auf vorhandene Eyetrackingwerte und neue Features wie einzelne (linke und rechte) Blickvektoren, unterstützte Bildfrequenzen und die Möglichkeit, die Framerate für die Eyetracking auf 30, 60 oder 90fps festzulegen. Informationen zur Verwendung der erweiterten EyeTracking-API finden Sie in unseren Entwicklerhandbüchern zur Verwendung von erweiterten Eye Tracking-APIs für native Oder Unity.

Anwendungsfälle

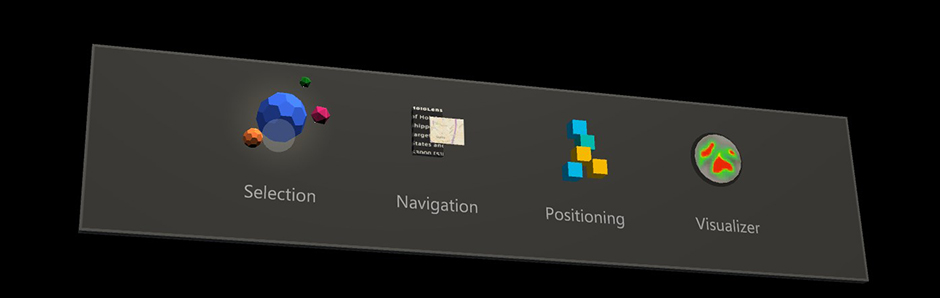

Mit der Blickverfolgung können Anwendungen in Echtzeit verfolgen, wohin der Benutzer schaut. In den folgenden Anwendungsfällen werden einige Interaktionen beschrieben, die mit Eyetracking auf HoloLens 2 in Mixed Reality möglich sind. Diese Anwendungsfälle sind noch nicht Teil der Holographic Shell-Benutzeroberfläche (die Benutzeroberfläche, die Beim Starten des HoloLens 2 angezeigt wird). Sie können einige davon im Mixed Reality Toolkit ausprobieren. Das Toolkit bietet mehrere interessante und leistungsstarke Beispiele für die Verwendung von Eyetracking, z. B. schnelle und mühelose, augengestützte Zielauswahl und automatisches Scrollen durch Text basierend auf dem, was der Benutzer sieht.

Benutzerabsicht

Informationen darüber, wo und was ein Benutzer ansieht, bieten einen leistungsstarken Kontext für andere Eingaben, z. B. Sprache, Hände und Controller. Dies kann für verschiedene Aufgaben verwendet werden. Der Benutzer kann z. B. schnell und mühelos auf die gesamte Szene ausgerichtet werden, indem er sich ein Hologramm anschaut und "auswählen" sagt (siehe auch Anvisieren und Commit) oder "Set this...", und dann hinschauen, wo das Hologramm platziert werden soll, und sagen "... dort". Beispiele hierfür finden Sie in den Artikeln Mixed Reality Toolkit – Eye-supported Target Selection (Mixed Reality-Toolkit – Blickgestützte Zielauswahl) und Mixed Reality Toolkit – Eye-supported Target Positioning (Mixed Reality-Toolkit – Blickgestützte Zielpositionierung).

Darüber hinaus kann ein Beispiel für die Benutzerabsicht die Verwendung von Informationen darüber enthalten, was Benutzer betrachten, um die Interaktion mit verkörperten virtuellen Agents und interaktiven Hologrammen zu verbessern. Beispielsweise können virtuelle Agents verfügbare Optionen und deren Verhalten basierend auf aktuell angezeigten Inhalten anpassen.

Implizite Aktionen

Die Kategorie der impliziten Aktionen steht in enger Beziehung zur Benutzerabsicht. Die Idee ist, dass Hologramme oder Benutzeroberflächenelemente instinktiv reagieren, die möglicherweise nicht einmal das Gefühl hat, dass der Benutzer überhaupt mit dem System interagiert, sondern dass das System und der Benutzer synchron sind. Ein Beispiel ist ein blickbasierter automatischer Bildlauf , bei dem der Benutzer einen langen Text lesen kann, der automatisch mit dem Bildlauf beginnt, sobald der Benutzer am Ende des Textfelds steht. Dadurch bleibt der Benutzer im Lesefluss, ohne einen Finger zu heben. Ein wichtiger Aspekt ist, dass sich die Bildlaufgeschwindigkeit an die Lesegeschwindigkeit des Benutzers anpasst.

Ein weiteres Beispiel ist das für die Augen unterstützte Zoomen und Schwenken , bei dem der Benutzer das Gefühl hat, genau auf das zu springen, worauf er sich konzentriert.

Das Auslösen und Steuern der Zoomgeschwindigkeit kann per Sprach- oder Handeingabe gesteuert werden, was wichtig ist, um dem Benutzer das Gefühl der Kontrolle zu geben und gleichzeitig nicht überfordert zu werden. Im Folgenden werden diese Entwurfsüberlegungen ausführlicher erläutert. Nach dem Vergrößern kann der Benutzer z. B. den Verlauf einer Straße reibungslos verfolgen, um seine Nachbarschaft mit seinem Blick zu erkunden. Demobeispiele für diese Arten von Interaktion finden Sie im Beispiel Mixed Reality Toolkit – Eye-supported Navigation (Mixed Reality-Toolkit – Blickgestützte Navigation).

Weitere Anwendungsfälle für implizite Aktionen können folgendes umfassen:

- Intelligente Benachrichtigungen: Ärgern Sie sich jemals über Benachrichtigungen, die mitten in Ihrer Ansicht angezeigt werden? Sie können diese Erfahrung verbessern, indem Sie Benachrichtigungen, von denen der Benutzer gerade blickt, ausgleichen. Dies schränkt Ablenkungen ein und schließt sie automatisch, sobald der Benutzer mit dem Lesen fertig ist.

- Aufmerksame Hologramme: Dies sind Hologramme, die auf subtile Weise reagieren, wenn sie anvisiert werden. Dies kann von leicht leuchtenden UI-Elementen über eine langsam blühende Blume bis hin zu einem virtuellen Hund reichen, der beginnt, auf den Benutzer zurückzublicken und mit dem Schwanz zu wedeln. Diese Interaktion kann ein interessantes Gefühl für Konnektivität und Zufriedenheit in Ihrer Anwendung bieten.

Aufmerksamkeitsverfolgung

Informationen darüber, wo oder was Benutzer betrachten, können ein immens leistungsfähiges Tool sein. Es kann helfen, die Nutzbarkeit von Designs zu bewerten und Probleme in Workflows zu identifizieren, um sie effizienter zu machen. Eyetrackingvisualisierung und -analyse sind eine gängige Praxis in verschiedenen Anwendungsbereichen. Mit HoloLens 2 bieten wir diesem Verständnis eine neue Dimension: 3D-Hologramme können in realen Kontexten platziert und entsprechend bewertet werden.

Das Mixed Reality Toolkit bietet grundlegende Beispiele für das Protokollieren und Laden von Eyetracking-Daten und deren Visualisierung.

Microsoft ist bestrebt, Innovationen zu ermöglichen und gleichzeitig sicherzustellen, dass Benutzer über eine informierte und transparente Erfahrung mit der Verwendung ihrer Eyetracking-Informationen verfügen. Wir arbeiten weiterhin mit unseren Entwicklern und UX-Teams zusammen, um Anleitungen für Dritte bereitzustellen, um sicherzustellen, dass die Benutzeroberflächen im Mittelpunkt stehen.

Zu diesem Bereich zählen möglicherweise auch die folgenden Anwendungen:

- Remote-Blickvisualisierung: Visualisieren Sie, was Remotemitarbeiter betrachten. Dies kann sofortiges Feedback geben und eine genauere Informationsverarbeitung ermöglichen.

- Studien zur Nutzerforschung: Die Aufmerksamkeitsnachverfolgung kann Erkenntnisse darüber liefern, wie Benutzer die natürliche Umgebung wahrnehmen und mit ihnen interagieren, ohne sich zu stören. Dies kann Entwicklern helfen, instinktive Interaktionen zwischen Mensch und Computer zu entwerfen. Eyetracking kann Informationen liefern, die von den Teilnehmern der Studie nicht direkt formuliert werden und vom Forscher leicht übersehen werden können.

- Trainings- und Leistungsüberwachung: Üben und optimieren Sie die Ausführung von Aufgaben, indem Sie Engpässe im Ausführungsablauf effektiver identifizieren. Eyetracking kann natürliche, in Echtzeit und objektive Informationen bereitstellen, um Training, Produktivität und Sicherheit am Arbeitsplatz zu verbessern.

- Designbewertungen, Marketing und Verbraucherforschung: Eyetracking ermöglicht es kommerziellen Unternehmen, Marketing- und Verbraucherstudien in realen Umgebungen durchzuführen oder zu analysieren, was die Aufmerksamkeit eines Benutzers auf sich nimmt, um das Produkt- oder Raumdesign zu verbessern.

Weitere Anwendungsfälle

- Gaming: Wollten Sie schon einmal Superkräfte haben? Hier kommt Ihre Chance!

Sie können Hologramme schweben, indem Sie sie anstarren.

Schießen Sie Laserstrahlen von Ihren Augen - probieren Sie es in RoboRaid aus, um HoloLens 2.

Verwandeln Sie Feinde in Stein oder frieren Sie sie.

Verwenden Sie Ihren Röntgenblick, um Gebäude zu erkunden.

Ihrer Phantasie sind keine Grenzen gesetzt! Achten Sie jedoch darauf, den Benutzer nicht zu überfordern. Weitere Informationen finden Sie in unseren Richtlinien für eingabebasierte Eingabedesigns.

Ausdrucksstarke Avatare: Eyetracking unterstützt ausdrucksstärkere 3D-Avatare, indem Live-Eyetracking-Daten verwendet werden, um die Augen des Avatars zu animieren und sie dazu zu bringen, dem zu folgen, was der Benutzer betrachtet.

Texteintrag: Eyetracking kann als Alternative für die Texteingabe mit geringem Aufwand verwendet werden, insbesondere wenn Sprache oder Hände unbequem zu verwenden sind.

Verwenden des Blicks für die Interaktion

Es kann eine Herausforderung sein, eine Interaktion zu entwickeln, die sich schnell bewegende Blickziele nutzt. Da sich Augen schnell bewegen können, können Benutzer die Erfahrung überwältigend oder ablenkend empfinden, wenn Sie nicht vorsichtig sind, wie die Eingabe des Blicks verwendet wird. Aber dies ist die Herausforderung wert, denn Eyetracking ermöglicht es Ihnen, wirklich magische Erfahrungen zu schaffen, die Ihre Benutzer begeistern werden! Um Ihnen zu helfen, sehen Sie sich unsere Übersicht über die wichtigsten Vorteile, Herausforderungen und Designempfehlungen für die Interaktion an.

Fallbacklösungen, wenn eyetracking nicht verfügbar ist

In seltenen Fällen sind Eyetracking-Daten möglicherweise nicht verfügbar. Dies kann aus einer Reihe von Gründen geschehen– die häufigsten sind unten aufgeführt:

- Das System konnte den Benutzer nicht kalibrieren.

- Der Benutzer hat die Kalibrierung übersprungen.

- Der Benutzer ist kalibriert, hat sich aber entschieden, Ihrer App keine Berechtigung zur Verwendung seiner Eyetracking-Daten zu erteilen.

- Der Benutzer verfügt über eine einzigartige Brille oder eine Augenbedingung, die das System noch nicht unterstützt.

- Externe Faktoren, die eine zuverlässige Augenverfolgung verhindern, z. B. Schmierungen auf dem HoloLens-Visier oder der Brille, intensive direkte Sonneneinstrahlung und Verdeckungen aufgrund von Haaren vor den Augen.

Entwickler sollten sicherstellen, dass für diese Benutzer geeignete Fallbackunterstützung vorhanden ist. Auf der Seite Eye Tracking in DirectX werden die APIs erläutert, die erforderlich sind, um zu erkennen, ob Eyetracking-Daten verfügbar sind.

Einige Benutzer sind möglicherweise der Ansicht, dass mehr Datenschutz für sie wichtiger ist als die verbesserte Benutzeroberfläche, die Eyetracking bieten kann, und widerrufen daher absichtlich den Zugriff auf ihre Eyetracking-Daten. In einigen Fällen kann dieser Widerruf jedoch unbeabsichtigt sein. Wenn Ihre App Eyetracking verwendet und dies ein wichtiger Bestandteil der Benutzeroberfläche ist, empfehlen wir, dies dem Benutzer klar zu kommunizieren. Wenn Sie dem Benutzer erklären, wie Eyetracking das volle Potenzial Ihrer Anwendung freischaltet, kann er besser verstehen, was er aufgibt. Wenn das Eyetracking aktiviert ist, aber nicht funktioniert, helfen Sie dem Benutzer, das Problem zu identifizieren und zu beheben, indem Sie die obige Checkliste als Leitfaden verwenden. Wenn Sie z. B. erkennen können, dass das System eyetracking unterstützt und der Benutzer kalibriert ist und seine Berechtigung erteilt hat, aber keine Eyetracking-Daten empfangen werden, kann dies auf Probleme wie Verschmierungen oder verschließte Augen hinweisen.

Es gibt selten Fälle, in denen Eyetracking für jemanden einfach nicht funktioniert und es keinen offensichtlichen Grund gibt. Achten Sie darauf, indem Sie dem Benutzer erlauben, Erinnerungen zum Aktivieren von Eyetracking in Ihrer App zu schließen oder zu deaktivieren.

Fallback für Apps, die den Blick als primären Eingabezeiger verwenden

Wenn Ihre App den Blick als Zeigereingabe verwendet, um schnell Hologramme in der gesamten Szene auszuwählen, aber keine Daten zur Eyetracking verfügbar sind, empfehlen wir, auf den Kopf-Blick zurück zu greifen und den Kopf-Anvisieren-Cursor anzuzeigen. Es wird empfohlen, ein Timeout (z. B. 500–1500 ms) zu verwenden, um zu bestimmen, ob gewechselt werden soll oder nicht. Diese Aktion verhindert, dass Cursor jedes Mal angezeigt werden, wenn das System aufgrund schneller Augenbewegungen oder winkend und blinkt. Wenn Sie Unity-Entwickler sind, wird das automatische Fallback auf den Blick bereits im Mixed Reality Toolkit behandelt. Wenn Sie DirectX-Entwickler sind, müssen Sie diesen Switch selbst verarbeiten.

Fallback für andere Eyetracking-spezifische Anwendungen

Ihre App kann den Blick auf eine einzigartige Weise verwenden, die speziell auf die Augen zugeschnitten ist, z. B. die Animierung der Augen eines Avatars oder augenbasierte Aufmerksamkeits-Wärmebilder, die auf präzisen Informationen über visuelle Aufmerksamkeit basieren. In diesem Fall gibt es keinen eindeutigen Fallback. Wenn eye tracking nicht verfügbar ist, müssen diese Funktionen möglicherweise deaktiviert werden. Auch hier wird empfohlen, dass Sie dies dem Benutzer klar mitteilen, der möglicherweise nicht weiß, dass die Funktion nicht funktioniert.

Diese Seite bietet Ihnen hoffentlich einen guten Überblick, damit Sie die Rolle von Eyetracking und Blickeingaben für die HoloLens 2 verstehen können. Um mit der Entwicklung zu beginnen, sehen Sie sich unsere Informationen über die Rolle des Blicks für die Interaktion mit Hologrammen, das Anvisieren von Augen in Unity und den Blick in DirectX an.