Imaginando el Futuro: pensamientos sobre computación

Dan Reed es una de las personas, más relevantes de Microsoft Corporación como Corp VP de Policy Technology, en el equipo de Craig Mundie.

Dan Reed , en su artículo sobre “Imaining the Future: Thoughts on Computing”, opina que hay nuevas ideas alrededor del mundo de la computación que nos van a traer sin duda una enorme cantidad de cambios con implicaciones muy significativas para nuestras profesiones y para nuestra sociedad.

Muchas de las asunciones habituales y clásicas en computación se van superando de la misma forma que nuevas ideas se van materializando.

La capacidad de proceso se desplaza sin duda a un enorme conjunto de dispositivos especializados que van desde los smartphones a los sensores embebidos en objetos muy cotidianos.

Los interfaces naturales de usuario (es decir, alternativas más humanas al clásico teclado y ratón para interaccionar con la tecnología e información) tales como el multitouch, 3D, procesamiento de voz etc, sin duda son por fin un mainstream.

La densidad de almacenamiento digital continua creciendo a ritmos exponenciales (la información creada en los dos últimos años, es mayor que toda la información previa existente).

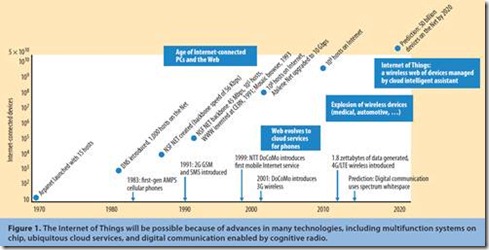

El internet de las cosas, es decir, esa web invisible y creciente de “objetos inteligentes” interconectados, promete transformar radicalmente la forma en la que interactuamos con los objetos más cotidianos.

Y por supuesto, toda esta tecnología, sumadas a nuestras expectativas son un reto para nuestros conceptos tradicionales de Seguridad y Privacidad.

Esta unión de nuevas y viejas tecnologías presenta adicionalmente una serie de importantes retos y la oportunidad de desarrolla ideas que nos acerquen a ese futuro que visionamos. Por ejemplo la explosión de los smartPhones y de dispositivos Wireless está agotando el espectro utilizado en comunicaciones. Podríamos aprovechar otros rangos del espectro de radiofrecuencias y evitar este más que previsible cuello de botella? Podemos sacar partido de los llamados WhiteSpaces o zonas del espectro electromagnético en desuso?

Las proyecciones en el tiempo de algunas tendencias actuales apuntan a la cifra de más de 50 Billones de dispositivos conectados a internet en tan solo unos pocos años. ¿Cómo podremos gestionar y securizar todo esto? ¿Podremos conciliar nuestras históricas nociones de seguridad y privacidad, enraizadas en conceptos de personas y lugares, con el nuevo mundo de servicios cloud y flujos de datos trasnacionales?

Cada uno de los DataCenters que en la actualidad se están construyendo para proporcionar servicios de cloud, tienen más computación y almacenamiento que la totalidad del Internet de hace unos pocos años. ¿Cómo deberemos diseñar los sistemas para una operación energéticamente eficiente?

Pero la tecnología también apunta a la mejora o solución de problemas sociales importantes. La población envejece en la mayor parte del mundo. ¿Cómo toda esta tecnología puede mejorar la calidad de vida de nuestros “mayores”? ¿O como la revolución biológica se aprovecha de las tecnologías de la información en pro de una medicina auténticamente personalizada? ¿Pueden los sistemas educativos responder a las necesidades de aprendizaje de las personas para los trabajos del futuro?

Predecir el futuro es siempre aventurado, pero sin embargo estos cambios sociales y tecnológicos son tan significativos que debemos considerar sus efectos en el futuro de la investigación, educación en computación y respuestas sociales más amplias.

Desde esta perspectiva hablamos entonces de las Major Computing Technology Trends. En los últimos años, los cambios vienen de la mano de tanto avance tecnológicos como de la acertada integración de los componentes tecnológicos apropiados:

I. Silicon scaling and Moore’s Law

Durante mucho tiempo hemos asistido al incremento de la capacidad de computación de los procesadores, más rápidos y energéticamente eficientes a través de la paulatina reducción en tamaño de los transistores pero, y simplificando mucho, hemos llegado a tamaños de “unos cuantos” átomos. Y eso significa que difícilmente vamos a poder seguir avanzando en ese camino y las mejoras difícilmente conseguirán velocidades sustancialmente mayores. Pero los chips multicore, la computación en paralelo, los servicios WEB y el Cloud Computing, proporcionan el rendimiento necesario. Incluso el multicore en palalelo proporciona computación heterogenea, es decir, con coprocesadores desarrollando tareas especializadas.

Y crear los modelos de programación, herramientas que faciliten el diseño de software en este mundo paralelo y distribuido, y la educación especializada al respeto, es uno de los retos más importantes.

II. El Mundo multi-dispositivo, la Internet de las Cosas y el Cloud

Que diversos dispositivos tengan un procesador, no es una gran novedad. Pero que además incluso el dispositivo más simples tenga la capacidad de conectarse a Internet, es un factor a tener en cuenta pues el número de dispositivos conectados a Internet, excede el número de las personas que las usan. El Cloud proporciona la capacidad analítica que permite a esos dispositivos adaptarse y personalizar su comportamiento. El Cloud es el necesario “pegamento” que une y da sentido a una “internet de las Cosas”. El Cloud puede almacenar datos que necesitan ser accesibles a un enorme número de dispositivos diferentes proporcionando recursos de computación suficiente para “sofisticados agentes”.

III. DataCenter Cloud y escalabilidad

Un solo dato: el 90% de los datos existentes en la actualidad, ha sido creado en los 2 últimos años ¡! Miriadas de fuentes de información (sensores de alta resolución, comunicaciones digitales, interacciones humanas-computadora. Microsoft, Google, Amazon, Facebook … etc. construyen grandes DataCenters. Pero a pesar de las mejoras en las infraestructuras físicas, los datacenter mantienen aun retos por delante en relación a su consumo de potencia, integración y operación.

IV. Software y Servicios Cloud

LA evolución del Software a los servicios Cloud es una tendencia que simplifica muchas interacciones human-computer, reemplazando conceptos abstractos de bajo nivel (como máquinas, carpetas, ficheros) por conceptos como p.e. los álbumes fotográficos accesibles desde cualquier dispositivo etc..

Este paradigma basado en la diversidad de dispositivos enlazados por almacenamientos comunes, requiere nuevas práctivcas de desarrollo de software.

V. Post-WIMP y NUI

WIMP=Window, Icon, Menu, Pointing … ;-) es nuestra forma más habitual interactuar con la tecnología en los últimos 30 años. Los Natural User Interfaces (NUI), emergen para permitir formas diferentes de interacción tales como los gestos o la voz. La idea no es nueva, y se lleva visualizando desde hace mucho tiempo, pero en los últimos 10 años se ha producido una gran evolución que no hará sino aumentar.

VI. Computación asistente y predictiva

Para disponer de una interfaz auténticamente natural, debemos ir más alla´de la pura reacción o comandos explícitos y construir sistemas que entiendan de preguntas implícitas y anticipen preguntas y acciones.

Es decir, tecnología que en base al análisis de los datos compartidos en contexto por nuestros dispositivos digitales, sean capaces de comprender perfectamente nuestro contexto en cada momento, como base para cualquier acción o servicio posterior. BigData analytics será solo una de las partes a afrontar en este gran reto.

VII. Comunicación multimodal

Wi-Fi devices everywhere, smartphones, … Hay un acceso a datos Wireless sin precedentes, lo que aumenta la presión sobre los reguladores de telecomunicaciones y proveedores de telefonía móvil al respecto del uso del Espectro e infraestructuras de comunicaciones respectivamente. Pero esta “tensión” solo ocurre en una banda determinada del espectro electromagnético.

Algunas tendencias alimentan especialmente esta necesidad. La primera es el aumento de los Natural User Interfaces que integran datos aportados por multiples sensores y dispositivos que operan a través de diferentes bandas y distancias. Desde las áreas de comuinicaciones basadas en Bluetooth, transmisiones de video de alta definición a 60GHz, Wifi, SuperWifi (en Whitespaces) comunicaciones de largo alcance en smartGrids, etc, las comunicaciones multimodales serán la norma más que la excepción. Las negociaciones a tiempo real para uso del espectro basadas en múltiples criterios (potencia, prioridades, pago, forma de acceso etc).. serán muy comunes. Pero para ello harán falta nuevas políticas y regulaciones que agilicen y optimicen el uso del espectro.

VIII. Evolucion del concepto de Privacidad

La explosión de la información digital producida por las personas y sus interacciones personales es sin duda una característica de nuestros tiempos, que no hará otra cosa que aumentar. No solo por el comercio electrónico. La navegación WEB, servicios de localización etc, todo ello genera preocupación sobre la privacidad y la gestión de la información. Los conceptos habituales de privacidad y seguridad han ido muy ligados a la localización física y a la persona, aunque la información sabemos que cruza muy rápida y fácilmente fronteras y jurisdicciones. Y nuestros conceptos suelen ser un tanto binarios: o la información está cifrada e inaccesible o está en claro y accesible. Parece que nos falta toda una gama de grises. Lo que para una persona es un “amigo”, en absoluto lo es para otras, lo que es admisible en unas culturas, en absoluto lo es en otras, lo que define a una generación, no preocupa a la siguiente etc..

Todo esto nos indica que probablemente debamos redefinir nuestros conceptos de Seguridad y privacidad y los mecanismos asociados para la protección de la información, de los datos y de las personas. Es decir, necesitamos protocolos y estándares que reflejen la complejidad de las interacciones de hoy en día. Y muy probablemente, debamos basarlos en tres principios básios:

I. Lifetime constraints, es decir, limitación del intervalo de tiempo durante el que un dato puede ser accedido

II. Transitivity Bounds: definición del alcance de la compratición más allá del primer receptor y …

III. Claim-based Acess: es decir, especificar el propósito para el que esa información puede ser utilizada.

El reto es permitir tal nivel de control del usuario de forma simple, intuitiva y no invasiva y generar las condiciones que permitan nuevos usos y modelos económicos.