Note

Access to this page requires authorization. You can try signing in or changing directories.

Access to this page requires authorization. You can try changing directories.

Introduktion

Scale Out File Servers (SOFS) är ett spännande upplägg som möjliggör en smart, relativt billig och effektiv lagringslösning för dina applikationer, det kan vara SQL Server eller virtuella maskiner på Hyper-V.

På pappret är det enkelt: SOFS är en klusterbaserad lösning som gör det möjligt för flera noder i ditt kluster att samtidigt komma åt samma filer, när en server vill komma åt en specifik fil kan den alltså göra det via alla noderna i klustret. Allt bygger på Windows Server Failover Clustering och SMB 3.0.

Fördelar

Med SOFS får du:

Active-Active file shares

Vilket innebär att alla noder samtidigt kan hantera klientförfrågningar. Detta innebär i sin tur att noder kan gå ner (p.g.a. underhåll eller katastrof) utan att dina klienter märker av detta överhuvudtaget.

Ökad bandbredd med fler noder

Då alla noder samtidigt kan komma åt ditt delade data kan du öka bandbredden genom att lägga till fler noder. Ju fler noder desto mer bandbredd helt enkelt. Detta är en radikal förändring mot hur det fungerat i tidigare klusterlösningar för lagring där den enskilda noden bestämt bandbredden.

CHKDSK utan nedtid

CHKDSK i Windows Server 2012 gjordes löjligt mycket snabbare än tidigare och nedtiden minimerades. Med CSV-volymer i Windows Server 2012 har man tagit detta till sitt slutgiltiga steg och du kan nu utföra CHKDSK på dina CSV-volymer helt utan nedtid.

Enklare administration

Med SOFS behöver du inte längre hantera hur och var filer ska placeras i ditt kluster och mellan dina olika CSV-volymer och file shares, du behöver inte längre bry dig om att försöka optimera nyttjandet av alla dina noder. Med SOFS görs detta automatiskt och hela tiden.

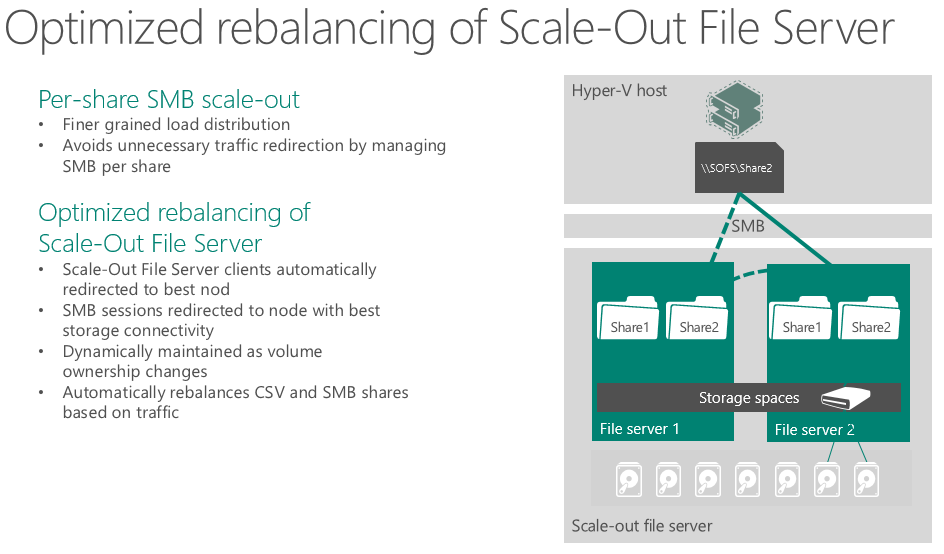

Lastbalansering och skalbarhet med SOFS

SOFS löser alltså alla problem som kan uppstå när en viss nod inte längre är tillgänglig och din applikation inte längre kan läsa/skriva. Tidigare har du behövt hantera detta i din applikation genom att på något sätt få applikationen att försöka skriva en gång till om den misslyckas. Med SOFS och SMB 3.0 är tanken att detta aldrig ska hända. Applikationer som skriver, kopierar, gör en back up, eller vad det nu kan vara, ska kunna fortsätta som om ingenting hänt om en eller flera noder går ner och lasten måste flyttas till en annan nod i klustret.

Det enda du eller applikationen kan märka av är en eventuell bandbreddsminskning som kan leda till att ditt data skickas lite saktare.

Inga driftstörningar alltså, hejja SOFS!

Din noder hanterar all last på ett intelligent sätt, lasten delas ut till de noder som för tillfället är bäst lämpade och en viss klients förfrågningar kan spridas till flera olika noder.

Mååålnet

Ingen bloggpost utan ett moln, eller hur? Bilden visar bara hur det är tänkt att hänga ihop när allt är klart och när du byggt din SOFS-lösning tillsammans med Storage Spaces.

Du har massa disk som är grupperade i Storage Pool:er. På dom ligger virtuella diskar som ditt SOFS-kluster läser och skriver på och ovanpå det har du dina virtuella maskiner.

I slutändan har du med Storage Spaces möjlighet till högtillgängliga, skalbara och effektivt utnyttjade diskar och med SOFS har du fått högtillgänglig åtkomst till dina diskar vilket gör att dina virtuella maskiner lever ett tryggt och säkert liv högst upp på din smarta lagringsinfrastruktur.

Och! Allt detta utan ett dyrt och leverantörsspecifikt SAN.

SOFS och Virtual Machine Manager

Alla som gillar Virtual Machine Manager (VMM) för hantering av din virtuella infrastruktur kan hantera sina SOFS-kluster direkt i VMM:en.

Förutom hantering av redan existerande kluster kan du direkt från VMM skapa SOFS-kluster och du kan även göra det vi kallar för Bare Metal Deployments (installation och konfiguration på ny och tom hårdvara) för att lägga till fler noder i ditt SOFS-kluster.

Steg-för-steg

Vill du ha hjälp med installationen? Här en en bra guide skriven av superproffset Aidan Finn: http://www.petri.co.il/create-basic-scale-out-file-server-sofs.htm#. Den bygger inte på VMM:en utan lösningen byggs här med Window Server 2012 eller Windows Server 2012 R2.