Planeamiento de capacidad para Active Directory Domain Services

Este tema está escrito originalmente por Ken Brumfield, Responsable de programas de Microsoft y proporciona recomendaciones para el planeamiento de capacidad para Active Directory Domain Services (AD DS).

Objetivos del planeamiento de capacidad

El planeamiento de capacidad no es lo mismo que la solución de problemas de incidentes de rendimiento. Están estrechamente relacionados, pero son muy diferentes. Los objetivos del planeamiento de capacidad son:

- Implementación y funcionamiento correctos de un entorno

- Minimización el tiempo dedicado a solucionar problemas de rendimiento.

En el planeamiento de capacidad, una organización podría tener un objetivo de línea base de uso del procesador del 40 % durante los períodos máximos para satisfacer los requisitos de rendimiento del cliente y adaptarse al tiempo necesario para actualizar el hardware en el centro de datos. Mientras que, para recibir notificaciones de incidentes de rendimiento anómalos, se podría establecer un umbral de alerta de supervisión en el 90 % durante un intervalo de 5 minutos.

La diferencia es que cuando se supera continuamente un umbral de administración de capacidad (un evento único no es un problema), agregar capacidad (es decir, agregar más procesadores o más rápidos) sería una solución o escalar el servicio entre varios servidores sería una solución. Los umbrales de alerta de rendimiento indican que la experiencia del cliente está sufriendo actualmente y se necesitan pasos inmediatos para solucionar el problema.

Como analogía: la administración de la capacidad consiste en prevenir un accidente de automóvil (conducción defensiva, asegurarse de que los frenos funcionen correctamente, etc.), mientras que la solución de problemas de rendimiento es lo que hacen la policía, el departamento de bomberos y los profesionales médicos de emergencias después de un accidente. Esto tema trata sobre "conducción defensiva", al estilo de Active Directory.

En los últimos años, la guía de planeamiento de capacidad para el escalado vertical de los sistemas ha cambiado drásticamente. Los siguientes cambios en las arquitecturas del sistema han desafiado las suposiciones fundamentales sobre el diseño y el escalado de un servicio:

- Plataformas de servidor de 64 bits

- Virtualización

- Mayor atención al consumo de energía

- Almacenamiento en SSD

- Escenarios de nube

Además, el enfoque cambia de un ejercicio de planeamiento de capacidad basado en servidores a un ejercicio de planeamiento de capacidad basado en servicios. Active Directory Domain Services (AD DS), un servicio distribuido y maduro que muchos productos de Microsoft y de terceros usan como back-end, se convierten en uno de los productos más críticos en cuanto a su correcto planeamiento para garantizar la capacidad necesaria para que se ejecuten otras aplicaciones.

Requisitos de línea base para la guía de planeamiento de capacidad

A lo largo de este artículo, se esperan los siguientes requisitos de línea base:

- Los lectores han leído y están familiarizados con el documento Directrices de optimización del rendimiento para Windows Server 2012 R2.

- La plataforma Windows Server es una arquitectura basada en x64. Pero incluso si el entorno de Active Directory está instalado en Windows Server 2003 x86 (ahora más allá del final del ciclo de vida de soporte técnico) y tiene un árbol de información de directorio (DIT) que tiene menos de 1,5 GB de tamaño y que se puede mantener fácilmente en memoria, las directrices de este artículo siguen siendo aplicables.

- El planeamiento de capacidad es un proceso continuo y se debe revisar periódicamente cómo cumple el entorno las expectativas.

- La optimización se producirá en varios ciclos de vida del hardware a medida que cambian los costos del hardware. Por ejemplo, la memoria se vuelve más barata, el costo por núcleo disminuye o cambia el precio de las distintas opciones de almacenamiento.

- Planee teniendo en cuenta el período de actividad máxima del día. Se recomienda examinarlo en intervalos de 30 minutos o de una hora. Un intervalo mayor puede ocultar los picos reales y uno menor puede verse distorsionado por "picos transitorios".

- Planee teniendo en cuenta el crecimiento durante el ciclo de vida del hardware para la empresa. Esto puede incluir una estrategia de actualización o adición de hardware de forma escalonada o una actualización completa cada tres a cinco años. Cada uno necesitará una "estimación" del crecimiento de la carga en Active Directory. Los datos históricos, si se han recopilado, le ayudarán con esta evaluación.

- Planee teniendo en cuenta la tolerancia a errores. Una vez que se llega a una estimación de N, planee escenarios que incluyan N – 1, N – 2, N – x.

Agregue servidores adicionales según la necesidad de la organización de asegurarse de que la pérdida de uno o varios servidores no supere las estimaciones máximas de capacidad máxima.

Tenga en cuenta también que es necesario integrar el plan de crecimiento y el plan de tolerancia a errores. Por ejemplo, si se requiere un controlador de dominio para admitir la carga, pero la estimación es que la carga se duplicará en el próximo año y requerirá dos controladores de dominio en total, no habrá suficiente capacidad para admitir la tolerancia a errores. La solución sería empezar con tres controladores de dominio. También se podría planear agregar el tercer controlador de dominio después de 3 o 6 meses si los presupuestos están ajustados.

Nota

Agregar aplicaciones compatibles con Active Directory podría tener un impacto notable en la carga del controlador de dominio, tanto si la carga procede de los servidores de aplicaciones como de los clientes.

Proceso de tres pasos para el ciclo de planeamiento de capacidad

En el planeamiento de capacidad, decida primero qué calidad de servicio se necesita. Por ejemplo, un centro de datos principal admite un mayor nivel de simultaneidad y requiere una experiencia más coherente para los usuarios y las aplicaciones que lo consumen, lo que requiere una mayor atención a la redundancia y minimizar los cuellos de botella de la infraestructura y del sistema. Por el contrario, una ubicación satélite con unos pocos usuarios no necesita el mismo nivel de simultaneidad y tolerancia a errores. Por lo tanto, es posible que la oficina satélite no necesite tanta atención para optimizar el hardware y la infraestructura subyacentes, lo que puede dar lugar a un ahorro de costos. Todas las recomendaciones y directrices que se indican aquí son para un rendimiento óptimo y se pueden relajar selectivamente para escenarios con requisitos menos exigentes.

La siguiente pregunta es: ¿virtualizado o físico? Desde la perspectiva del planeamiento de capacidad, no hay ninguna respuesta correcta o incorrecta; solo hay un conjunto diferente de variables con el que trabajar. Los escenarios de virtualización se reducen a una de estas dos opciones:

- "Asignación directa" con un invitado por host (donde la virtualización existe únicamente para abstraer el hardware físico del servidor)

- "Host compartido"

Los escenarios de pruebas y producción indican que el escenario de "asignación directa" se puede tratar de forma idéntica a un host físico. Sin embargo, el "host compartido" presenta una serie de consideraciones descritas con más detalle más adelante. El escenario de "host compartido" significa que AD DS también compite por los recursos y hay penalizaciones y consideraciones de optimización para hacerlo.

Teniendo en cuenta estas consideraciones, el ciclo de planeamiento de capacidad es un proceso iterativo de tres pasos:

- Medir el entorno existente, determinar dónde se encuentran actualmente los cuellos de botella del sistema y obtener los aspectos básicos del entorno necesarios para planear la cantidad de capacidad necesaria.

- Determinar el hardware necesario según los criterios descritos en el paso 1.

- Supervisar y validar que la infraestructura implementada funcione dentro de las especificaciones. Algunos datos recopilados en este paso se convierten en la línea base del siguiente ciclo de planeamiento de capacidad.

Aplicación del proceso

Para optimizar el rendimiento, asegúrese de que estos componentes principales estén seleccionados y optimizados correctamente para las cargas de las aplicaciones:

- Memoria

- Red

- Storage

- Procesador

- Net Logon

Los requisitos de almacenamiento básicos de AD DS y el comportamiento general del software cliente bien escrito permiten entornos de 10 000 a 20 000 usuarios para evitar una gran inversión en el planeamiento de capacidad con respecto al hardware físico, ya que casi cualquier sistema moderno de clase servidor controlará la carga. Dicho esto, la tabla siguiente resume cómo evaluar un entorno existente para seleccionar el hardware correcto. Cada componente se analiza en detalle en secciones posteriores para ayudar a los administradores de AD DS a evaluar su infraestructura mediante recomendaciones de línea base y principios específicos del entorno.

En general:

- Cualquier dimensionamiento basado en los datos actuales solo será preciso para el entorno actual.

- En el caso de las estimaciones, espere que la demanda crezca durante el ciclo de vida del hardware.

- Determine si aumentar el tamaño hoy y crecer en un entorno más grande, o agregar capacidad a lo largo del ciclo de vida.

- Para la virtualización, se aplican todos los mismos principios y metodologías de planeamiento de capacidad, salvo que se debe agregar la sobrecarga de la virtualización a cualquier cosa relacionada con el dominio.

- El planeamiento de capacidad, como cualquier cosa que intenta hacer predicciones, no es una ciencia precisa. No espere que las cosas se calculen perfectamente y con una precisión del 100 %. Las instrucciones aquí son la recomendación más ajustada; agregue capacidad para mayor seguridad y valide continuamente que el entorno permanece en el objetivo.

Tablas de resumen de recopilación de datos

Nuevo entorno

| Componente | Estimaciones |

|---|---|

| Tamaño de almacenamiento y base de datos | De 40 KB a 60 KB por cada usuario |

| RAM | Tamaño de base de datos Recomendaciones de sistema operativo base Aplicaciones de terceros |

| Red | 1 GB |

| CPU | 1000 usuarios simultáneos por cada núcleo |

Criterios generales de evaluación

| Componente | Criterios de evaluación | Consideraciones de planeamiento |

|---|---|---|

| Tamaño de almacenamiento y base de datos | La sección titulada "Para activar el registro del espacio en disco que se libera mediante la desfragmentación" de Límites de almacenamiento | |

| Rendimiento del almacenamiento y la base de datos |

|

|

| RAM |

|

|

| Red |

|

|

| CPU |

|

|

| NetLogon |

|

|

Planificación

Durante mucho tiempo, la recomendación de la comunidad para el dimensionamiento de AD DS ha sido "poner tanta RAM como el tamaño de la base de datos". Por lo general, esa recomendación es todo por lo que deben preocuparse la mayoría de los entornos. Pero el ecosistema que consume AD DS se ha vuelto mucho más grande, como los propios entornos de AD DS, desde su introducción en 1999. Aunque el aumento de la potencia de proceso y el cambio de arquitecturas x86 a arquitecturas x64 ha hecho que los aspectos más sutiles del ajuste de tamaño para el rendimiento no sean pertinentes para un conjunto mayor de clientes que ejecutan AD DS en hardware físico, el crecimiento de la virtualización ha vuelto a introducir las preocupaciones de optimización a un público mayor que antes.

Por lo tanto, las instrucciones siguientes tratan sobre cómo determinar y planear las demandas de Active Directory como servicio, independientemente de si se implementa en un escenario físico, una combinación de virtual y físico, o un escenario puramente virtualizado. Por lo tanto, desglosaremos la evaluación en cada uno de los cuatro componentes principales: almacenamiento, memoria, red y procesador. En resumen, para maximizar el rendimiento en AD DS, el objetivo es acercarse lo más posible al límite del procesador.

RAM

Simplemente, cuanto más se pueda almacenar en caché en RAM, menos necesario es acceder al disco. Para maximizar la escalabilidad del servidor, la cantidad mínima de RAM debe ser la suma del tamaño de la base de datos actual, el tamaño total de SYSVOL, la cantidad recomendada del sistema operativo y las recomendaciones del proveedor para los agentes (antivirus, supervisión, copia de seguridad, etc.). Se debe agregar una cantidad adicional para dar cabida al crecimiento durante la vida útil del servidor. Esto será subjetivo del entorno en función de las estimaciones de crecimiento de la base de datos en función de los cambios del entorno.

En entornos en los que maximizar la cantidad de RAM no es rentable (por ejemplo, una ubicación satélite) o no es factible (el DIT es demasiado grande), consulte la sección Almacenamiento para asegurarse de que el almacenamiento se haya diseñado adecuadamente.

Un corolario que aparece en el contexto general del dimensionamiento de la memoria es el dimensionamiento del archivo de paginación. En el mismo contexto que todo lo demás relacionado con la memoria, el objetivo es minimizar el acceso al disco, que es mucho más lento. Por lo tanto, la pregunta debe pasar de "¿cómo se debe ajustar el tamaño del archivo de paginación?" a "¿cuánta RAM se necesita para minimizar la paginación?" La respuesta a esta última pregunta se describe en el resto de esta sección. Esto deja la mayor parte de la discusión sobe el dimensionamiento del archivo de paginación al campo de las recomendaciones generales del sistema operativo y la necesidad de configurar el sistema para volcados de memoria, que no están relacionados con el rendimiento de AD DS.

Evaluando

La cantidad de RAM que necesita un controlador de dominio (DC) es realmente un ejercicio complejo por estas razones:

- Alta posibilidad de error al intentar usar un sistema existente para medir la cantidad de RAM necesaria, ya que LSASS lo truncará en condiciones de presión de memoria, desinflando artificialmente la necesidad.

- El hecho subjetivo es que un controlador de dominio individual solo necesita almacenar en caché lo que es "interesante" para sus clientes. Esto significa que los datos que se deben almacenar en caché en un controlador de dominio de un sitio que solo tiene un servidor Exchange serán muy diferentes de los datos que se deben almacenar en caché en un controlador de dominio que solo autentique a los usuarios.

- El trabajo de evaluar la RAM para cada controlador de dominio caso a caso es prohibitivo y cambia a medida que cambia el entorno.

- Los criterios subyacentes a la recomendación ayudarán a tomar decisiones fundamentadas:

- Cuanto más se pueda almacenar en caché en RAM, menos necesario es acceder al disco.

- El almacenamiento es con mucho el componente más lento de un equipo. El acceso a los datos en medios de almacenamiento basados en eje y en SSD se encuentra en el orden de 1 000 000 de veces más lento que el acceso a los datos de la memoria RAM.

Por lo tanto, para maximizar la escalabilidad del servidor, la cantidad mínima de RAM es la suma del tamaño de la base de datos actual, el tamaño total de SYSVOL, la cantidad recomendada del sistema operativo y las recomendaciones del proveedor para los agentes (antivirus, supervisión, copia de seguridad, etc.). Agregue cantidades adicionales para dar cabida al crecimiento durante la vida útil del servidor. Esto será subjetivo del entorno en función de las estimaciones de crecimiento de la base de datos. Sin embargo, en el caso de las ubicaciones satélite con un pequeño conjunto de usuarios finales, estos requisitos se pueden relajar, ya que estos sitios no tendrán que almacenar en caché tanto para atender la mayoría de las solicitudes.

En entornos en los que maximizar la cantidad de RAM no es rentable (por ejemplo, una ubicación satélite) o no es factible (el DIT es demasiado grande), consulte la sección Almacenamiento para asegurarse de que el almacenamiento tenga el tamaño correcto.

Nota

Un corolario en el dimensionamiento de la memoria es el dimensionamiento del archivo de paginación. Dado que el objetivo es minimizar el uso del disco, que es mucho más lento, la pregunta pasa de "¿cómo se debe dimensionar el archivo de paginación?" a "¿cuánta RAM se necesita para minimizar la paginación?" La respuesta a esta última pregunta se describe en el resto de esta sección. Esto deja la mayor parte de la discusión sobe el dimensionamiento del archivo de paginación al campo de las recomendaciones generales del sistema operativo y la necesidad de configurar el sistema para volcados de memoria, que no están relacionados con el rendimiento de AD DS.

Consideraciones de virtualización para la memoria RAM

Evite la confirmación excesiva de memoria en el host. El objetivo fundamental al optimizar la cantidad de RAM es minimizar la cantidad de tiempo dedicado en el acceso al disco. En escenarios de virtualización, el concepto de confirmación excesiva de memoria se produce cuando se asigna más RAM a los invitados que la que existe en la máquina física. Esto, por sí mismo, no es un problema. Se convierte en un problema cuando la memoria total utilizada activamente por todos los invitados supera la cantidad de RAM del host y el host subyacente comienza a paginar. El rendimiento se convierte en algo relacionado con el disco en los casos en los que el controlador de dominio accede al archivo NTDS.dit para obtener datos, o el controlador de dominio accede al archivo de paginación para obtener datos, o el host accede al disco para obtener datos que el invitado piensa que están en memoria RAM.

Ejemplo de resumen de cálculo

| Componente | Memoria estimada (ejemplo) |

|---|---|

| RAM recomendada para el sistema operativo base (Windows Server 2008) | 2 GB |

| Tareas internas de LSASS | 200 MB |

| Agente de supervisión | 100 MB |

| Antivirus | 100 MB |

| Base de datos (catálogo global) | 8,5 GB |

| Espacio de amortiguación para que se ejecute la copia de seguridad y los administradores inicien sesión sin impacto | 1 GB |

| Total | 12 GB |

Recomendado: 16 GB

A lo largo del tiempo, se puede suponer que se agregarán más datos a la base de datos y el servidor probablemente estará en producción entre 3 y 5 años. En función de una estimación de crecimiento del 33 %, 16 GB serían una cantidad razonable de RAM para poner en un servidor físico. En una máquina virtual, dada la facilidad con la que se puede modificar la configuración y se puede agregar RAM a la máquina virtual, a partir de 12 GB con un plan para supervisar y actualizar en el futuro sería razonable.

Red

Evaluando

Esta sección tiene menos que ver con la evaluación de las demandas relacionadas con el tráfico de replicación, que se centra en el tráfico que atraviesa la WAN y se trata exhaustivamente en Tráfico de replicación de Active Directory, y se trata más de evaluar el ancho de banda total y la capacidad de red necesaria, incluido el de las consultas de cliente, las aplicaciones de directiva de grupo, etc. En el caso de los entornos existentes, esto se puede recopilar mediante los contadores de rendimiento "Network Interface(*)\Bytes Received/sec" y "Network Interface(*)\Bytes Sent/sec". Tome muestras de los contadores de la interfaz de red en intervalos de 15, 30 o 60 minutos. Cualquier intervalo menor generalmente será demasiado volátil para obtener buenas medidas; cualquier intervalo mayor suavizará excesivamente los picos diarios.

Nota

Por lo general, la mayoría del tráfico de red en un controlador de dominio es saliente, ya que el controlador de dominio responde a las consultas de cliente. Esta es la razón de centrarse en el tráfico saliente, aunque se recomienda evaluar también cada entorno para el tráfico entrante. Se pueden usar los mismos enfoques para abordar y revisar los requisitos del tráfico de red entrante. Para obtener más información, consulte el artículo de Knowledge Base 929851: El intervalo predeterminado de puertos dinámicos para TCP/IP ha cambiado desde Windows Vista y en Windows Server 2008.

Necesidades de ancho de banda

El planeamiento de la escalabilidad de red abarca dos categorías distintas: la cantidad de tráfico y la carga de CPU debida al tráfico de red. Cada uno de estos escenarios es sencillo en comparación con algunos de los otros temas de este artículo.

Al evaluar la cantidad de tráfico que se debe admitir, hay dos categorías únicas de planeamiento de capacidad para AD DS en términos de tráfico de red. La primera es el tráfico de replicación que transcurre entre controladores de dominio y se trata exhaustivamente en el artículo de referencia Tráfico de replicación de Active Directory y sigue siendo pertinente para las versiones actuales de AD DS. La segunda es el tráfico de cliente a servidor dentro del sitio. Uno de los escenarios más sencillos de planear, el tráfico dentro del sitio, recibe principalmente solicitudes pequeñas de los clientes en relación con las grandes cantidades de datos enviados de vuelta a los clientes. Por lo general, 100 MB serán adecuados en entornos de hasta 5000 usuarios por servidor, en un sitio. Se recomienda usar un adaptador de red de 1 GB y la compatibilidad con el Escalado del lado de la recepción (RSS) para cualquier valor superior a 5000 usuarios. Para validar este escenario, especialmente en el caso de escenarios de consolidación de servidores, examine el valor de Network Interface(*)\Bytes/sec en todos los controladores de dominio de un sitio, súmelo y divídalo por el número de controladores de dominio objetivo para asegurarse de que haya una capacidad adecuada. La manera más fácil de hacerlo es usar la vista "Área apilada" en Confiabilidad de Windows y Monitor de rendimiento (anteriormente conocida como Perfmon), asegurándose de que todos los contadores tengan la misma escala.

Considere el ejemplo siguiente (también conocido como una manera realmente compleja de validar que la regla general es aplicable a un entorno específico). Se realizan las siguientes suposiciones:

- El objetivo es reducir la superficie al menor número de servidores posible. Lo ideal es que un servidor lleve la carga y se implemente un servidor adicional para la redundancia (escenario N + 1).

- En este escenario, el adaptador de red actual solo admite 100 MB y está en un entorno conmutado. El uso máximo objetivo de ancho de banda de red es del 60 % en un escenario de N (pérdida de un controlador de dominio).

- Cada servidor tiene unos 10 000 clientes conectados a él.

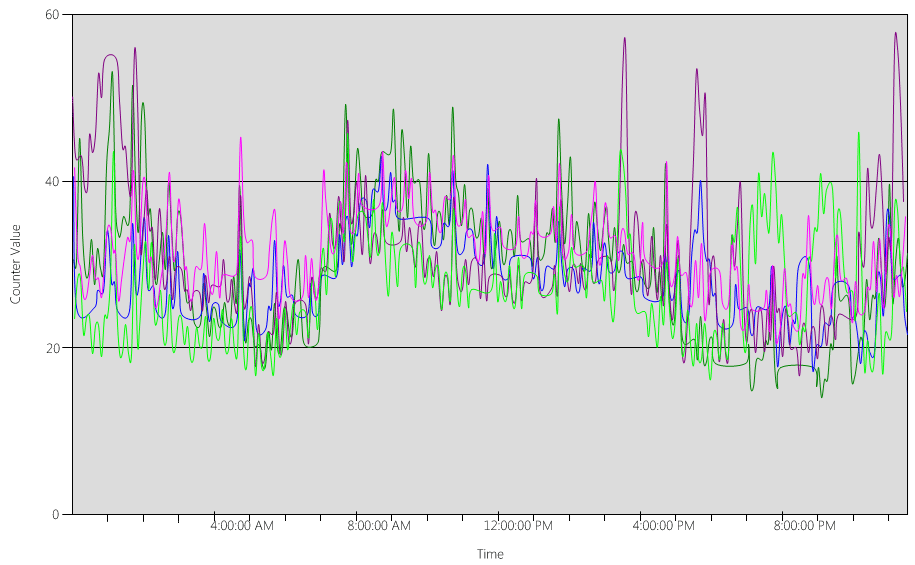

Conocimientos obtenidos de los datos del gráfico (Network Interface(*)\Bytes Sent/sec):

- El día laborable comienza a subir alrededor de las 5:30 y baja a las 7:00 p. m.

- El período más ocupado va de las 8:00 a las 8:15 a. m., con más de 25 bytes enviados por segundo en el controlador de dominio más ocupado.

Nota

Todos los datos de rendimiento son históricos. Por lo tanto, el punto de datos máximo a las 8:15 indica la carga de las 8:00 a las 8:15.

- Hay picos antes de las 4:00 a. m., con más de 20 bytes enviados por segundo en el controlador de dominio más ocupado, lo que podría indicar una carga desde diferentes zonas horarias o una actividad de la infraestructura en segundo plano, como las copias de seguridad. Puesto que el pico a las 8:00 a. m. supera esta actividad, no es pertinente.

- Hay cinco controladores de dominio en el sitio.

- La carga máxima es de aproximadamente 5,5 MB/s por cada controlador de dominio, que representa el 44 % de la conexión de 100 MB. Con estos datos, se puede calcular que el ancho de banda total necesario entre las 8:00 a. m. y las 8:15 a. m. es de 28 MB/s.

Nota

Tenga cuidado con el hecho de que los contadores de envío y recepción de la interfaz de red están en bytes y el ancho de banda de red se mide en bits. 100 MB ÷ 8 = 12.5 MB, 1 GB ÷ 8 = 128 MB.

Conclusiones:

- Este entorno actual cumple el nivel N+1 de tolerancia a errores con un uso objetivo del 60 %. Desconectar un sistema cambiará el ancho de banda por servidor de aproximadamente 5,5 MB/s (44 %) a aproximadamente 7 MB/s (56 %).

- En función del objetivo indicado anteriormente de consolidar en un servidor, esto supera el uso objetivo máximo y teóricamente el posible uso de una conexión de 100 MB.

- Con una conexión de 1 GB, esto representará el 22 % de la capacidad total.

- En condiciones de funcionamiento normales en el escenario N + 1, la carga de cliente se distribuirá relativamente uniformemente a unos 14 MB/s por servidor o el 11 % de la capacidad total.

- Para asegurarse de que la capacidad sea adecuada durante la falta de disponibilidad de un controlador de dominio, los objetivos de funcionamiento normales por servidor serían aproximadamente de un 30 % de uso de red o 38 MB/s por cada servidor. Los objetivos de conmutación por error serían de un 60 % del uso de red o 72 MB/s por servidor.

En resumen, la implementación final de los sistemas debe tener un adaptador de red de 1 GB y estar conectado a una infraestructura de red que admita dicha carga. Una nota adicional es que, dada la cantidad de tráfico de red generado, la carga de CPU de las comunicaciones de red puede tener un impacto significativo y limitar la escalabilidad máxima de AD DS. Este mismo proceso se puede usar para calcular la cantidad de comunicación entrante al controlador de dominio. Pero, dado el predominio del tráfico saliente en relación con el tráfico entrante, es un ejercicio académico para la mayoría de los entornos. Es importante garantizar la compatibilidad del hardware con RSS en entornos con más de 5000 usuarios por servidor. En escenarios con un tráfico de red elevado, el equilibrio de la carga de interrupción puede ser un cuello de botella. Esto se puede detectar porque el valor de Processor(*)% Interrupt Time se distribuye de forma desigual entre las CPU. Las NIC habilitadas para RSS pueden mitigar esta limitación y aumentar la escalabilidad.

Nota

Se puede usar un enfoque similar para calcular la capacidad adicional necesaria al consolidar centros de datos o retirar un controlador de dominio de una ubicación satélite. Simplemente recopile el tráfico saliente y entrante a los clientes y esa será la cantidad de tráfico que ahora estará presente en los vínculos WAN.

En algunos casos, es posible que experimente más tráfico de lo esperado porque el tráfico es más lento, como cuando la comprobación de certificados no cumple los tiempos de espera agresivos de la WAN. Por este motivo, el dimensionamiento y el uso de WAN deben ser un proceso iterativo y continuo.

Consideraciones de virtualización para el ancho de banda de red

Es fácil hacer recomendaciones para un servidor físico: 1 GB para servidores que admitan más de 5000 usuarios. Una vez que varios invitados empiecen a compartir una infraestructura de conmutador virtual subyacente, se necesita atención adicional para asegurarse de que el host tenga el ancho de banda de red adecuado para admitir a todos los invitados del sistema y, por tanto, requiere un rigor adicional. Esto no es más que una extensión de garantizar la infraestructura de red en la máquina host. Esto es independientemente de si la red incluye el controlador de dominio que se ejecuta como invitado de máquina virtual en un host con el tráfico de red que pasa por un conmutador virtual o si se conecta directamente a un conmutador físico. El conmutador virtual es solo un componente más en el que el enlace ascendente debe admitir la cantidad de datos que se transmiten. Por lo tanto, el adaptador de red físico del host físico vinculado al conmutador debe ser capaz de admitir la carga del controlador de dominio más todos los demás invitados que comparten el conmutador virtual conectado al adaptador de red físico.

Ejemplo de resumen de cálculo

| Sistema | Ancho de banda máximo |

|---|---|

| DC 1 | 6,5 MB/s |

| DC 2 | 6,25 MB/s |

| DC 3 | 6,25 MB/s |

| DC 4 | 5,75 MB/s |

| DC 5 | 4,75 MB/s |

| Total | 28,5 MB/s |

Recomendado: 72 MB/s (28,5 MB/s dividido por 40 %)

| Número de sistemas objetivo | Ancho de banda total (según aparece anteriormente) |

|---|---|

| 2 | 28,5 MB/s |

| Comportamiento normal resultante | 28,5 ÷ 2 = 14,25 MB/s |

Como siempre, se puede hacer la suposición de que la carga de cliente aumentará con el tiempo y se debe planear este crecimiento lo mejor posible. La cantidad recomendada para planear permitiría un crecimiento estimado del tráfico de red del 50 %.

Almacenamiento

El planeamiento del almacenamiento tiene dos componentes:

- Capacidad o tamaño del almacenamiento

- Rendimiento

Se invierte una gran cantidad de tiempo y documentación en planear la capacidad, lo que hace que a menudo se pase completamente por alto el rendimiento. Con los costos de hardware actuales, la mayoría de los entornos no son lo suficientemente grandes como para que ninguno de ellos sea realmente un problema, y la recomendación de "poner tanta RAM como el tamaño de la base de datos" normalmente cubre el resto, aunque puede ser excesiva para las ubicaciones satélite en entornos más grandes.

Ajuste de tamaño

Evaluación del almacenamiento

En comparación con hace 13 años, cuando se presentó Active Directory, un tiempo en el que las unidades de 4 GB y 9 GB eran los tamaños de unidad más comunes, el ajuste de tamaño de Active Directory no es ni siquiera una consideración para todos excepto para los entornos más grandes. Con los tamaños de disco duro más pequeños disponibles de aproximadamente 180 GB, todo el sistema operativo, SYSVOL y NTDS.dit pueden caber fácilmente en una unidad. Por lo tanto, se recomienda poner en desuso una gran inversión en esta área.

La única recomendación que se debe tener en cuenta es asegurarse de que esté disponible el 110 % del tamaño del archivo NTDS.dit para habilitar la desfragmentación. Además, se deben hacer preparativos para el crecimiento durante la vida útil del hardware.

La primera consideración y la más importante es evaluar el tamaño de NTDS.dit y SYSVOL. Estas medidas llevarán al dimensionamiento del disco fijo y la asignación de RAM. Debido al costo (relativamente) bajo de estos componentes, las matemáticas no necesitan ser rigurosas y precisas. Puede encontrar contenido sobre cómo evaluarlo para entornos nuevos y existentes en la serie de artículos Almacenamiento de datos. Específicamente, consulte los siguientes artículos:

Para entornos existentes: la sección titulada "Para activar el registro del espacio en disco que se libera mediante la desfragmentación" de Límites de almacenamiento.

Para nuevos entornos: el artículo titulado Estimaciones de crecimiento para usuarios y unidades organizativas de Active Directory.

Nota

Los artículos se basan en las estimaciones de tamaño de datos realizadas en el momento de la publicación de Active Directory en Windows 2000. Use tamaños de objeto que reflejen el tamaño real de los objetos de su entorno.

Al revisar los entornos existentes con varios dominios, puede haber variaciones en los tamaños de base de datos. Cuando esto sea cierto, use los tamaños de catálogo global (GC) y no GC más pequeños.

El tamaño de la base de datos puede variar entre las versiones del sistema operativo. Los controladores de dominio que ejecutan sistemas operativos anteriores, como Windows Server 2003, tienen un tamaño de base de datos menor que un controlador de dominio que ejecuta un sistema operativo posterior, como Windows Server 2008 R2, especialmente cuando se habilitan características como la Papelera de reciclaje de Active Directory o las Credenciales móviles.

Nota

- En el caso de los nuevos entornos, observe que las estimaciones del artículo Estimaciones de crecimiento para usuarios y unidades organizativas de Active Directory indican que 100 000 usuarios (en el mismo dominio) consumen aproximadamente 450 MB de espacio. Tenga en cuenta que los atributos rellenados pueden tener un gran impacto en la cantidad total. Los atributos se rellenarán en muchos objetos tanto por productos de terceros como por Microsoft, incluidos Microsoft Exchange Server y Lync. Se prefiere una evaluación basada en la cartera de productos del entorno, pero el ejercicio de detallar los cálculos matemáticos y pruebas de estimaciones precisas para todos menos los entornos más grandes pueden no merecer realmente un tiempo y esfuerzo significativos.

- Asegúrese de que esté disponible el 110 % del tamaño del archivo NTDS.dit como espacio libre para habilitar la desfragmentación sin conexión y planee el crecimiento durante un período de vida útil de hardware de tres a cinco años. Dado que el almacenamiento es barato, es seguro calcular el almacenamiento en un 300 % del tamaño del DIT como asignación de almacenamiento para adaptarse al crecimiento y la posible necesidad de la desfragmentación sin conexión.

Consideraciones de virtualización para el almacenamiento

En un escenario en el que se asignan varios archivos de disco duro virtual (VHD) en un único volumen, se usa un disco de tamaño fijo de al menos un 210 % (100 % del DIR + 110 % de espacio disponible) del tamaño del DIT para asegurarse de que haya espacio adecuado reservado.

Ejemplo de resumen de cálculo

| Datos recopilados en la fase de evaluación | Size |

|---|---|

| Tamaño del archivo NTDS.dit | 35 GB |

| Modificador para permitir la desfragmentación sin conexión | 2,1 GB |

| Almacenamiento total necesario | 73,5 GB |

Nota

Este almacenamiento necesario se suma al almacenamiento necesario para SYSVOL, el sistema operativo, el archivo de paginación, los archivos temporales, los datos almacenados en caché local (como los archivos del instalador) y las aplicaciones.

Rendimiento del almacenamiento

Evaluación del rendimiento del almacenamiento

Como el componente más lento de cualquier equipo, el almacenamiento puede tener el mayor impacto adverso en la experiencia del cliente. Para aquellos entornos lo suficientemente grandes como para los que las recomendaciones de dimensionamiento de RAM no sean factibles, las consecuencias de pasar por alto el planeamiento del almacenamiento para el rendimiento pueden ser perjudiciales. Además, las complejidades y las variedades de la tecnología de almacenamiento aumentan aún más el riesgo de error, ya que la pertinencia de los procedimientos recomendados de larga duración de "poner sistema operativo, los registros y la base de datos" en discos físicos independientes está limitado en escenarios útiles. Esto se debe a que el procedimiento recomendado de larga duración se basa en la suposición de que un "disco" es un eje dedicado y esto permite que la E/S esté aislada. Estas suposiciones que hacen que esto sea cierto ya no son pertinentes con la introducción de:

- RAID

- Nuevos tipos de almacenamiento y escenarios de almacenamiento virtualizado y compartido

- Ejes compartidos en una red de área de almacenamiento (SAN)

- Archivo VHD en una SAN o un almacenamiento conectado a la red

- Unidades de estado sólido

- Arquitecturas de almacenamiento en capas (por ejemplo, SSD, almacenamiento en caché de nivel de almacenamiento, almacenamiento basado en un eje mayor)

Específicamente, el almacenamiento compartido (RAID, SAN, NAS, JBOD (por ejemplo, Espacios de almacenamiento), VHD) tiene la capacidad de tener suscripciones y cargas excesivas por parte otras cargas de trabajo que se ubiquen en el almacenamiento de back-end. También agregan el desafío de que los problemas de la SAN, la red y el controlador (todo lo que hay entre el disco físico y la aplicación de AD) pueden provocar limitaciones o retrasos. Como aclaración, estas no son configuraciones "incorrectas", son configuraciones más complejas que requieren que todos los componentes funcionen correctamente, lo que requiere atención adicional para garantizar que el rendimiento sea aceptable. Consulte el Apéndice C, subsección "Introducción a las SAN" y el Apéndice D más adelante en este documento para obtener explicaciones más detalladas. Además, aunque las unidades de estado sólido no tienen la limitación de los discos giratorios (unidades de disco duro) con respecto a permitir que solo se procese una operación de E/S a la vez, siguen teniendo limitaciones de E/S, y es posible cargar y suscribir en exceso los discos SSD. En resumen, el objetivo final de todos los esfuerzos de rendimiento del almacenamiento, independientemente de la arquitectura y el diseño de almacenamiento subyacentes, es asegurarse de que esté disponible la cantidad necesaria de operaciones de entrada y salida por segundo (IOPS) y que esas IOPS se produzcan dentro de un período de tiempo aceptable (como se especifica en otra parte de este documento). Para aquellos escenarios con almacenamiento conectado localmente, consulte el Apéndice C para conocer los conceptos básicos sobre cómo diseñar escenarios de almacenamiento local tradicionales. Estos principios se suelen aplicar a capas de almacenamiento más complejas y también ayudarán en el diálogo con los proveedores que admiten soluciones de almacenamiento de back-end.

- Dada la amplia gama de opciones de almacenamiento disponibles, se recomienda aprovechar la experiencia de los equipos de soporte técnico y los proveedores de hardware para asegurarse de que la solución específica satisfaga las necesidades de AD DS. Las cifras siguientes son la información que se proporcionaría a los especialistas de almacenamiento.

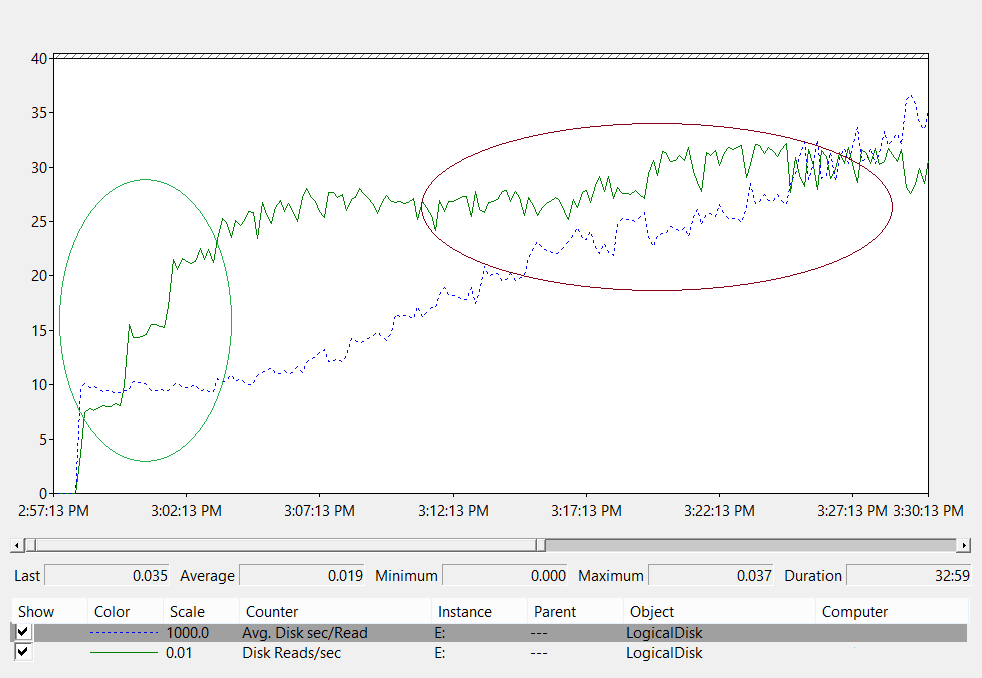

En entornos en los que la base de datos es demasiado grande para mantenerse en RAM, use los contadores de rendimiento para determinar cuánta E/S se debe admitir:

- LogicalDisk(*)\Avg Disk sec/Read (por ejemplo, si el archivo NTDS.dit se almacena en la unidad D:/, la ruta de acceso completa sería LogicalDisk(D:)\Avg Disk sec/Read)

- LogicalDisk(*)\Avg Disk sec/Write

- LogicalDisk(*)\Avg Disk sec/Transfer

- LogicalDisk(*)\Reads/sec

- LogicalDisk(*)\Writes/sec

- LogicalDisk(*)\Transfers/sec

Estos valores se deben muestrear en intervalos de 15/30/60 minutos para crear puntos de referencia de las demandas del entorno actual.

Evaluación de los resultados

Nota

El enfoque se centra en las lecturas de la base de datos, ya que suele ser el componente más exigente; la misma lógica se puede aplicar a las escrituras en el archivo de registro sustituyendo LogicalDisk(<registro de NTDS>)\Avg Disk sec/Write y LogicalDisk(<registro de NTDS>)\Writes/sec):

- LogicalDisk(<NTDS>)\Avg Disk sec/Read indica si el almacenamiento actual tiene el tamaño adecuado. Si los resultados son aproximadamente iguales al tiempo de acceso al disco de ese tipo de disco, LogicalDisk(<NTDS>)\Reads/sec es una medida válida. Consulte las especificaciones del fabricante del almacenamiento en el back-end, pero los intervalos correctos para LogicalDisk(<NTDS>)\Avg Disk sec/Read serían aproximadamente:

- 7200: de 9 a 12,5 milisegundos (ms)

- 10 000: de 6 a 10 ms

- 15 000: de 4 a 6 ms

- SSD: de 1 a 3 ms

-

Nota

Existen recomendaciones que indican que el rendimiento del almacenamiento se degrada de 15 ms a 20 ms (según el origen). La diferencia entre los valores anteriores y las demás instrucciones es que los valores anteriores son el intervalo de funcionamiento normal. Las demás recomendaciones son la guía de solución de problemas para identificar cuándo se degrada significativamente la experiencia del cliente y se vuelve notable. Consulte el Apéndice C para obtener una explicación más detallada.

- LogicalDisk(<NTDS>)\Reads/sec es la cantidad de E/S que se está llevando a cabo.

- Si LogicalDisk(<NTDS>)\Avg Disk sec/Read está dentro del intervalo óptimo para el almacenamiento de back-end, se puede usar directamente LogicalDisk(<NTDS>)\Reads/sec para dimensionar el almacenamiento.

- Si LogicalDisk(<NTDS>)\Avg Disk sec/Read no está dentro del intervalo óptimo para el almacenamiento de back-end, se necesitan E/S adicionales según la siguiente fórmula: (LogicalDisk(<NTDS>)\Avg Disk sec/Read) ÷ (Tiempo de acceso al disco físico) × (LogicalDisk(<NTDS>)\Avg Disk sec/Read)

Consideraciones:

- Tenga en cuenta que si el servidor está configurado con una cantidad de RAM por debajo de la óptima, estos valores serán inexactos con fines de planeamiento. Estarán erróneamente en el lado alto y se pueden seguir usando como el peor escenario.

- Agregar u optimizar la RAM llevará específicamente a una disminución de la cantidad de E/S de lectura (LogicalDisk(<NTDS>)\Reads/Sec). Esto significa que es posible que la solución de almacenamiento no sea tan sólida como se calculó inicialmente. Desafortunadamente, cualquier instrucción más específica que esta declaración general depende del entorno de la carga del cliente y no se pueden proporcionar instrucciones generales. La mejor opción es ajustar el tamaño del almacenamiento después de optimizar la RAM.

Consideraciones de virtualización para el rendimiento

De forma similar a todas las explicaciones sobre virtualización anteriores, la clave aquí es asegurarse de que la infraestructura compartida subyacente pueda admitir la carga del controlador de dominio más los demás recursos que usan el medio compartido subyacente y todas las rutas de acceso a él. Esto es cierto si un controlador de dominio físico comparte el mismo medio subyacente en una infraestructura SAN, NAS o iSCSI que otros servidores o aplicaciones, ya sea un invitado que usa el acceso a una infraestructura SAN, NAS o iSCSI que comparte el medio subyacente, o si el invitado usa un archivo VHD que reside en medios compartidos localmente o en una infraestructura SAN, NAS o iSCSI. El ejercicio de planeamiento consiste en asegurarse de que los medios subyacentes puedan admitir la carga total de todos los consumidores.

Además, desde una perspectiva de invitado, dado que hay rutas de acceso de código adicionales que se deben recorrer, hay un impacto en el rendimiento por tener que pasar por un host para acceder a cualquier almacenamiento. No es sorprendente que las pruebas de rendimiento del almacenamiento indiquen que la virtualización tiene un impacto en el rendimiento que es subjetivo respecto al uso del procesador del sistema host (consulte el Apéndice A: Criterios de dimensionamiento de CPU), que obviamente se ve influenciado por los recursos del host solicitados por el invitado. Esto contribuye a las consideraciones sobre virtualización relacionadas con las necesidades de procesamiento en un escenario virtualizado (consulte Consideraciones de virtualización para el procesamiento).

Para que esto sea más complejo, hay una variedad de opciones de almacenamiento diferentes que están disponibles y todas tienen diferentes impactos en el rendimiento. Como estimación segura al migrar de físico a virtual, use un multiplicador de 1,10 para ajustar las diferentes opciones de almacenamiento para invitados virtualizados en Hyper-V, como el almacenamiento de acceso directo y los adaptadores SCSI o IDE. Los ajustes que se deben realizar al transferir entre los distintos escenarios de almacenamiento no son pertinentes en cuanto a si el almacenamiento es local, SAN, NAS o iSCSI.

Ejemplo de resumen de cálculo

Determinar la cantidad de E/S necesaria para un sistema en estado correcto en condiciones de funcionamiento normales:

- LogicalDisk(<Unidad de la base de datos NTDS>)\Transfers/sec durante el período de actividad máxima de 15 minutos

- Para determinar la cantidad de E/S necesaria para el almacenamiento cuando se supera la capacidad del almacenamiento subyacente:

IOPS necesarias = (LogicalDisk(<Unidad de la base de datos NTDS>)\Avg Disk sec/Read ÷ <Target Avg Disk sec/Read>) × LogicalDisk(<Unidad de la base de datos NTDS>)\Read/sec

| Contador | Valor |

|---|---|

| Real: LogicalDisk(<Unidad de la base de datos NTDS>)\Avg Disk sec/Transfer | 0,02 segundos (20 milisegundos) |

| Objetivo: LogicalDisk(<Unidad de la base de datos NTDS>)\Avg Disk sec/Transfer | 0,01 segundos |

| Multiplicador para el cambio en la E/S disponible | 0,02 ÷ 0,01 = 2 |

| Nombre del valor | Valor |

|---|---|

| LogicalDisk(<Unidad de la base de datos NTDS>)\Transfers/sec | 400 |

| Multiplicador para el cambio en la E/S disponible | 2 |

| IOPS totales necesarias durante el período máximo | 800 |

Para determinar la velocidad a la que se desea activar la memoria caché:

- Determine el tiempo máximo aceptable para activar la memoria caché. Es la cantidad de tiempo que se debe tardar en cargar toda la base de datos desde el disco o, en escenarios en los que no se puede cargar toda la base de datos en RAM, este sería el tiempo máximo para rellenar la RAM.

- Determine el tamaño de la base de datos, excepto el espacio en blanco. Para más información, consulte Evaluación del almacenamiento.

- Divida el tamaño de la base de datos entre 8 KB; que será el total de E/S necesaria para cargar la base de datos.

- Divida el número total de E/S por el número de segundos del período de tiempo definido.

Tenga en cuenta que la tasa calculada, aunque precisa, no será exacta porque las páginas cargadas previamente se expulsan si ESE no está configurado para tener un tamaño fijo de caché y AD DS usa de manera predeterminada el tamaño de caché variable.

| Puntos de datos que se van a recopilar | Valores |

|---|---|

| Tiempo máximo aceptable para la activación | 10 minutos (600 segundos) |

| Tamaño de base de datos | 2 GB |

| Paso de cálculo | Fórmula | Resultado |

|---|---|---|

| Cálculo del tamaño de la base de datos en páginas | (2 GB × 1024 × 1024) = Tamaño de la base de datos en KB | 2 097 152 KB |

| Cálculo del número de páginas de la base de datos | 2 097 152 KB ÷ 8 KB = Número de páginas | 262 144 páginas |

| Cálculo de las IOPS necesarias para activar completamente la memoria caché | 262 144 páginas ÷ 600 segundos = IOPS necesarias | 437 IOPS |

Processing

Evaluación del uso de procesador de Active Directory

En la mayoría de los entornos, después de que el almacenamiento, la RAM y las redes se hayan ajustado correctamente, como se describe en la sección Planeamiento, la administración de la cantidad de capacidad de procesamiento será el componente que merece la mayor atención. Hay dos desafíos en la evaluación de la capacidad de CPU necesaria:

Si las aplicaciones del entorno se comportan bien o no en una infraestructura de servicios compartidos, y se describe en la sección titulada "Seguimiento de búsquedas costosas e ineficaces" del artículo Creación de aplicaciones más eficaces habilitadas para Microsoft Active Directory o migración de llamadas SAM de nivel inferior a llamadas LDAP.

En entornos más grandes, la razón por la que esto es importante es que las aplicaciones codificadas de forma deficiente pueden impulsar la volatilidad de la carga de la CPU, "robar" una cantidad de tiempo extraordinaria de CPU a otras aplicaciones, aumentar artificialmente las necesidades de capacidad y distribuir de forma desigual la carga en los controladores de dominio.

Como AD DS es un entorno distribuido con una gran variedad de clientes potenciales, estimar el gasto de un "cliente único" es subjetivo del entorno debido a los patrones de uso y al tipo y la cantidad de aplicaciones que utilizan AD DS. En resumen, al igual que en la sección de redes, para una aplicabilidad amplia, esto se aborda mejor desde la perspectiva de evaluar la capacidad total necesaria en el entorno.

En el caso de los entornos existentes, dado que el ajuste de tamaño del almacenamiento se explicó anteriormente, se da por supuesto que el almacenamiento ahora tiene el tamaño correcto y, por tanto, los datos relacionados con la carga del procesador son válidos. Para repetir, es fundamental asegurarse de que el cuello de botella en el sistema no es el rendimiento del almacenamiento. Cuando existe un cuello de botella y el procesador está esperando, hay estados inactivos que desaparecerán una vez que se quite el cuello de botella. A medida que se quitan los estados de espera del procesador, por definición, aumenta el uso de la CPU, ya que ya no tiene que esperar a los datos. Por lo tanto, recopile los contadores de rendimiento "Logical Disk(<Unidad de la base de datos NTDS>)\Avg Disk sec/Read" y "Process(lsass)\% Processor Time". Los datos de "Process(lsass)\% Processor Time" serán artificialmente bajos si "Logical Disk(<Unidad de la base de datos NTDS>)\Avg Disk sec/Read" supera los 10/15 ms, que es un umbral general que Microsoft admite para solucionar problemas de rendimiento relacionados con el almacenamiento. Como antes, se recomienda que los intervalos de muestra sean de 15, 30 o 60 minutos. Cualquier intervalo menor generalmente será demasiado volátil para obtener buenas medidas; cualquier intervalo mayor suavizará excesivamente los picos diarios.

Introducción

Para planear la capacidad de los controladores de dominio, la potencia de procesamiento requiere la mayor atención y comprensión. Al ajustar el tamaño de los sistemas para garantizar el máximo rendimiento, siempre hay un componente que es el cuello de botella y, en un controlador de dominio de tamaño correcto, será el procesador.

De forma similar a la sección de redes, en la que se revisa la demanda del entorno sitio a sitio, se debe hacer lo mismo para la capacidad de proceso demandada. A diferencia de la sección de redes, donde las tecnologías de redes disponibles superan con creces la demanda normal, preste más atención al dimensionamiento de la capacidad de CPU. Como cualquier entorno de tamaño incluso moderado, cualquier cosa que supere unos miles de usuarios simultáneos puede poner una carga significativa en la CPU.

Desafortunadamente, debido a la enorme variabilidad de las aplicaciones cliente que aprovechan AD, una estimación general de usuarios por CPU es inaplicable a todos los entornos. Específicamente, las demandas de proceso están sujetas al comportamiento del usuario y al perfil de aplicación. Por lo tanto, se debe dimensionar de forma individual cada entorno.

Perfil de comportamiento objetivo del sitio

Como se mencionó anteriormente, al planear la capacidad de un sitio completo, el objetivo es dirigirse a un diseño con un diseño de capacidad de N + 1, de modo que un error en un sistema durante el período máximo permita la continuación del servicio con un nivel razonable de calidad. Esto significa que, en un escenario de "N", la carga en todos los equipos debe ser inferior al 100 % (mejor aún, inferior al 80 %) durante los períodos máximos.

Además, si las aplicaciones y los clientes del sitio usan los procedimientos recomendados para buscar los controladores de dominio (es decir, mediante la función DsGetDcName), los clientes se deben distribuir de manera relativamente uniforme con picos transitorios menores debido a cualquier número de factores.

En el ejemplo siguiente, se realizan las siguientes suposiciones:

- Cada uno de los cinco controladores de dominio del sitio tiene cuatro CPU.

- El uso total de CPU objetivo durante el horario laborable está por debajo del 40 % en condiciones de funcionamiento normales ("N + 1") y del 60 % en caso contrario ("N"). Durante las horas no laborables, el uso de CPU objetivo es del 80 % porque se espera que el software de copia de seguridad y otras operaciones de mantenimiento consuman todos los recursos disponibles.

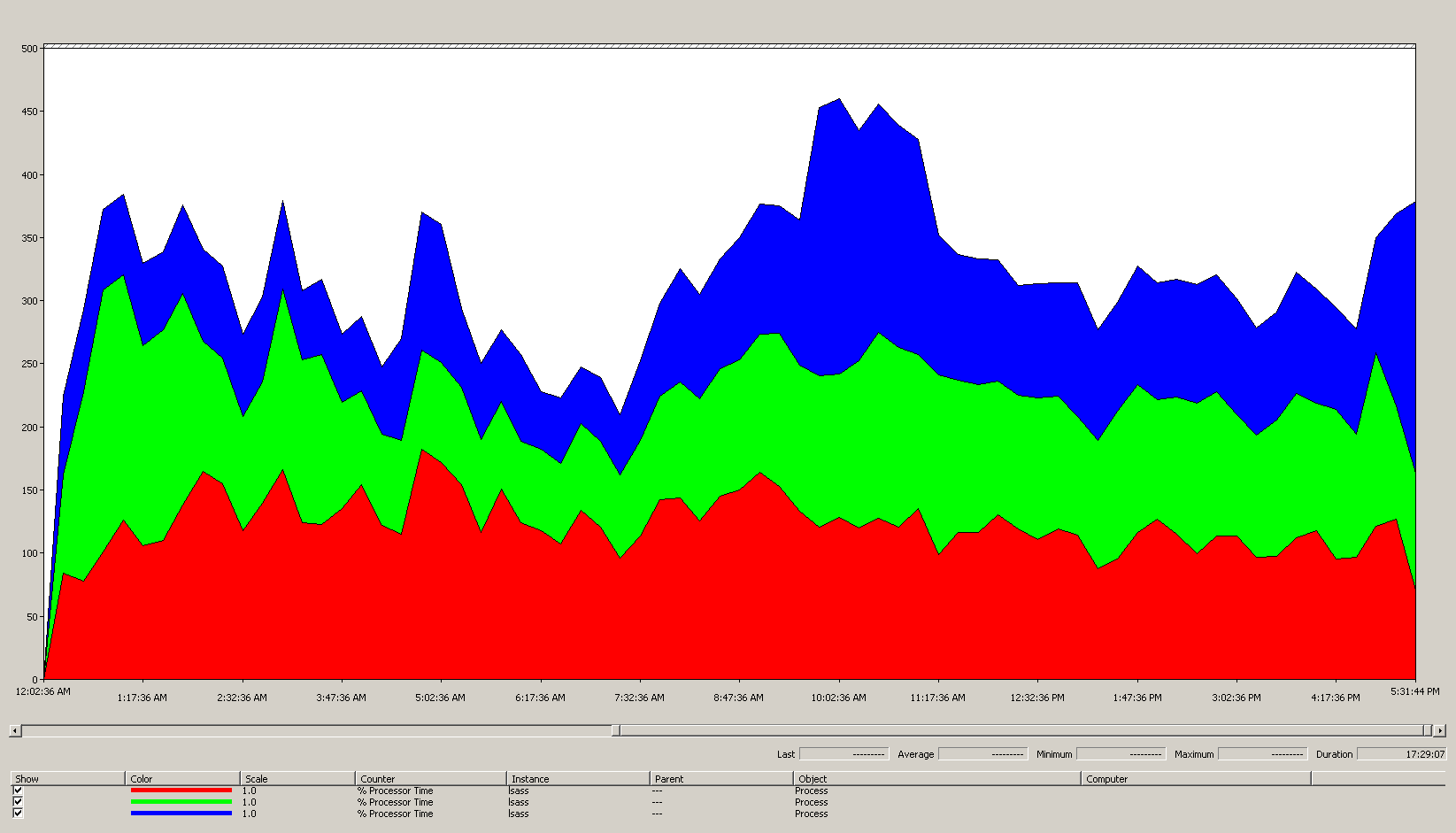

Análisis de los datos del gráfico (Processor Information(_Total)\% Processor Utility) para cada uno de los controladores de dominio:

En su mayor parte, la carga se distribuye de manera relativamente uniforme, que es lo que se esperaría cuando los clientes usan el localizador de controlador de dominio y tienen búsquedas bien escritas.

Hay una serie de picos de cinco minutos del 10 %, con algunos que llegan al 20 %. Por lo general, a menos que provoquen que se supere el objetivo del plan de capacidad, no merece la pena investigarlos.

El período máximo de todos los sistemas está comprendido entre las 8:00 a. m. y las 9:15 a. m. Con una transición fluida desde aproximadamente las 5:00 a. m. hasta las 5:00 p. m., esto es generalmente indicativo del ciclo empresarial. Los picos más aleatorios de uso de CPU en un escenario equipo a equipo entre las 5:00 p. m. y las 4:00 a. m. estarían fuera de los problemas de planeamiento de capacidad.

Nota

En un sistema bien administrado, estos picos podrían ser software de copia de seguridad en ejecución, exámenes completos del sistema del antivirus, inventario de hardware o software, implementación de software o revisiones, etc. Dado que se encuentran fuera del ciclo empresarial máximo del usuario, no se superan los objetivos.

Dado que cada sistema está aproximadamente al 40 % y todos los sistemas tienen el mismo número de CPU, si se produce un error en uno o se desconecta, los sistemas restantes se ejecutarían en un 53 % estimado (la carga del 40 % del sistema se divide uniformemente y se agrega a la carga existente del 40 % del sistema A y del sistema C). Por varias razones, esta suposición lineal no es perfectamente precisa, pero proporciona suficiente precisión para medir.

Escenario alternativo: dos controladores de dominio en ejecución al 40 %: se produce un error en un controlador de dominio, la CPU estimada en el resto sería un 80 %. Esto supera con mucho los umbrales descritos anteriormente para el plan de capacidad y también comienza a limitar gravemente la cantidad de espacio del 10 % al 20 % visto en el perfil de carga anterior, lo que significa que los picos llevarían al controlador de dominio entre el 90 % y el 100 % durante el escenario "N" y, definitivamente, se degrada la capacidad de respuesta.

Cálculo de las demandas de CPU

El contador de objetos de rendimiento "Process\% Processor Time" suma la cantidad total de tiempo que emplean todos los subprocesos de una aplicación en la CPU y se divide por la cantidad total de tiempo del sistema que ha transcurrido. El efecto de esto es que una aplicación de varios subprocesos en un sistema de varias CPU puede superar el 100 % del tiempo de CPU, y se interpretaría de forma MUY diferente al valor de "Processor Information\% Processor Utility". En la práctica, el valor de "Process(lsass)\% Processor Time" se puede ver como el número de CPU en ejecución al 100 % que son necesarias para admitir las demandas del proceso. Un valor del 200 % significa que son necesarias 2 CPU, cada una al 100 %, para admitir la carga completa de AD DS. Aunque una CPU que se ejecuta con una capacidad del 100 % es la más rentable desde la perspectiva del dinero invertido en CPU y el consumo de energía, por varias razones detalladas en el Apéndice A, se produce una mejor capacidad de respuesta en un sistema multisubproceso cuando el sistema no está en ejecución al 100 %.

Para dar cabida a picos transitorios en la carga de cliente, se recomienda establecer como objetivo una CPU en período máximo de entre el 40 % y el 60 % de la capacidad del sistema. En el caso del ejemplo anterior, esto significaría que se necesitarían entre 3,33 (objetivo del 60 %) y 5 CPU (objetivo del 40 %) para la carga de AD DS (proceso lsass). Se debe agregar capacidad adicional según las demandas del sistema operativo base y otros agentes necesarios (como antivirus, copia de seguridad, supervisión, etc.). Aunque el impacto de los agentes se debe evaluar para cada entorno, se puede realizar una estimación de entre el 5 % y el 10 % de una sola CPU. En el ejemplo actual, esto sugeriría que son necesarias entre 3,43 (objetivo del 60 %) y 5,1 CPU (objetivo del 40 %) durante los períodos máximos.

La manera más fácil de hacerlo es usar la vista "Área apilada" en Confiabilidad de Windows y Monitor de rendimiento (perfmon), asegurándose de que todos los contadores tengan la misma escala.

Se supone que:

- El objetivo es reducir la superficie al menor número de servidores posible. Lo ideal es que un servidor lleve la carga y se agregue un servidor adicional para la redundancia (escenario N + 1).

Conocimientos obtenidos de los datos del gráfico (Process(lsass)\% Processor Time):

- El día laborable comienza a subir alrededor de las 7:00 y baja a las 5:00 p. m.

- El período más ocupado es de 9:30 a 11:00 a. m.

Nota

Todos los datos de rendimiento son históricos. El punto de datos máximo a las 9:15 indica la carga de las 9:00 a las 9:15.

- Hay picos antes de las 7:00 a. m., lo que podría indicar una carga desde diferentes zonas horarias o una actividad de la infraestructura en segundo plano, como las copias de seguridad. Puesto que el pico a las 9:30 a. m. supera esta actividad, no es pertinente.

- Hay tres controladores de dominio en el sitio.

En la carga máxima, lsass consume aproximadamente el 485 % de una CPU o 4,85 CPU que se ejecuten al 100 %. Según las matemáticas anteriores, esto significa que el sitio necesita aproximadamente 12,25 CPU para AD DS. Agregue las sugerencias anteriores del 5 % al 10 % para los procesos en segundo plano y eso significa que para sustituir el servidor hoy se necesitarían aproximadamente de 12,30 a 12,35 CPU para admitir la misma carga. Ahora, es necesario tener en cuenta una estimación del entorno en cuanto al crecimiento.

Cuándo ajustar las ponderaciones de LDAP

Hay varios escenarios en los que se debe tener en cuenta el ajuste de LdapSrvWeight. En el contexto del planeamiento de capacidad, esto se haría cuando la aplicación o las cargas de usuario no se equilibran uniformemente, o los sistemas subyacentes no se equilibran uniformemente en términos de funcionalidad. Los motivos para hacerlo más allá del planeamiento de capacidad están fuera del ámbito de este artículo.

Hay dos razones comunes para ajustar loas ponderaciones de LDAP:

- El emulador de PDC es un ejemplo que afecta a cada entorno para el que el comportamiento de la carga de usuario o la aplicación no se distribuye uniformemente. Dado que ciertas herramientas y acciones tienen como destino el emulador de PDC (como las herramientas de administración de directiva de grupo, los segundos intentos en caso de errores de autenticación, el establecimiento de la confianza, etc.), los recursos de CPU en el emulador de PDC pueden ser más demandados que en otras partes del sitio.

- Solo es útil ajustar esto si hay una diferencia notable en el uso de CPU para reducir la carga en el emulador de PDC y aumentar la carga en otros controladores de dominio permitirá una distribución más uniforme de la carga.

- En este caso, establezca LDAPSrvWeight entre 50 y 75 para el emulador de PDC.

- Servidores con diferente número de CPU (y velocidades) en un sitio. Por ejemplo, supongamos que hay dos servidores de ocho núcleos y un servidor de cuatro núcleos. El último servidor tiene la mitad de procesadores que los otros dos servidores. Esto significa que una carga de cliente bien distribuida aumentará la carga media de CPU del equipo de cuatro núcleos hasta aproximadamente el doble que en los equipos de ocho núcleos.

- Por ejemplo, los dos equipos de ocho núcleos estarían en ejecución al 40 % y el equipo de cuatro núcleos estaría en ejecución al 80 %.

- Además, tenga en cuenta el impacto de la pérdida de un equipo de ocho núcleos en este escenario, específicamente el hecho de que el equipo de cuatro núcleos ahora se sobrecargaría.

Ejemplo 1: PDC

| Sistema | Uso con valores predeterminados | Nuevo LdapSrvWeight | Nuevo uso estimado |

|---|---|---|---|

| DC 1 (emulador de PDC) | 53 % | 57 | 40% |

| DC 2 | 33 % | 100 | 40% |

| DC 3 | 33 % | 100 | 40% |

El aprendizaje aquí es que si se transfiere o se utiliza el rol de emulador de PDC, especialmente a otro controlador de dominio del sitio, habrá un aumento drástico en el nuevo emulador de PDC.

Con el ejemplo de la sección Perfil de comportamiento objetivo del sitio, se da por supuesto que los tres controladores de dominio del sitio tenían cuatro CPU. ¿Qué debería ocurrir, en condiciones normales, si uno de los controladores de dominio tenía ocho CPU? Habría dos controladores de dominio con un uso del 40 % y uno con un 20 %. Aunque esto no es malo, hay una oportunidad de equilibrar la carga un poco mejor. Aproveche las ponderaciones de LDAP para lograrlo. Un escenario de ejemplo sería:

Ejemplo 2: diferentes números de CPU

| Sistema | Processor Information\ % Processor Utility(_Total) Uso con valores predeterminados |

Nuevo LdapSrvWeight | Nuevo uso estimado |

|---|---|---|---|

| DC 1 de 4-CPU | 40 | 100 | 30 % |

| DC 2 de 4-CPU | 40 | 100 | 30 % |

| DC 3 de 8-CPU | 20 | 200 | 30 % |

Tenga mucho cuidado con estos escenarios. Como se pudo ver anteriormente, las matemáticas se ven realmente bonitas sobre el papel. Sin embargo, en todo este artículo, el planeamiento de un escenario "N + 1" es de importancia primordial. Se debe calcular para cada escenario el impacto de un controlador de dominio que se queda sin conexión. En el escenario inmediatamente anterior en el que la distribución de la carga es uniforme, con el fin de garantizar una carga del 60 % durante un escenario de "N", con la carga equilibrada uniformemente en todos los servidores, la distribución estará bien porque las relaciones permanecen coherentes. Al examinar el escenario de ajuste del emulador de PDC y, en general, cualquier escenario en el que la carga de usuario o de aplicación esté desequilibrada, el efecto es muy diferente:

| Sistema | Uso optimizado | Nuevo LdapSrvWeight | Nuevo uso estimado |

|---|---|---|---|

| DC 1 (emulador de PDC) | 40% | 85 | 47 % |

| DC 2 | 40% | 100 | 53 % |

| DC 3 | 40% | 100 | 53 % |

Consideraciones de virtualización para el procesamiento

Hay dos capas de planeamiento de capacidad que se deben realizar en un entorno virtualizado. En el nivel de host, de forma similar a la identificación del ciclo empresarias descrito anteriormente para el procesamiento del controlador de dominio, es necesario identificar los umbrales durante el período máximo. Dado que los principios subyacentes son los mismos para una máquina host que programa subprocesos de invitado en la CPU que para obtener subprocesos de AD DS en la CPU de una máquina física, se recomienda el mismo objetivo del 40 % al 60 % en el host subyacente. En la capa siguiente, la capa de invitado, dado que los principios de la programación de subprocesos no han cambiado, el objetivo dentro del invitado permanece en el intervalo del 40 % al 60 %.

En un escenario de asignación directa, un invitado por host, todo el planeamiento de capacidad realizado hasta este punto se debe agregar a los requisitos (RAM, disco, red) del sistema operativo del host subyacente. En un escenario de host compartido, las pruebas indican que hay un impacto del 10 % en la eficacia de los procesadores subyacentes. Esto significa que si un sitio necesita 10 CPU al objetivo del 40 %, la cantidad recomendada de CPU virtuales para asignar entre todos los "N" invitados sería 11. En un sitio con una distribución mixta de servidores físicos y servidores virtuales, el modificador solo se aplica a las máquinas virtuales. Por ejemplo, si un sitio tiene un escenario "N + 1", un servidor físico o de asignación directa con 10 CPU sería aproximadamente equivalente a un invitado con 11 CPU en un host, con 11 CPU reservadas para el controlador de dominio.

A lo largo del análisis y cálculo de las cantidades de CPU necesarias para admitir la carga de AD DS, las cifras de CPU que se asignan a lo que se puede comprar en términos de hardware físico no necesariamente se asignan de forma exacta. La virtualización elimina la necesidad de redondear. La virtualización reduce el esfuerzo necesario para agregar capacidad de proceso a un sitio, dada la facilidad con la que se puede agregar una CPU a una máquina virtual. No elimina la necesidad de evaluar con precisión la potencia de proceso necesaria para que el hardware subyacente esté disponible cuando sea necesario agregar CPU adicionales a los invitados. Como siempre, recuerde planear y supervisar el crecimiento de la demanda.

Ejemplo de resumen de cálculo

| Sistema | CPU máxima |

|---|---|

| DC 1 | 120% |

| DC 2 | 147 % |

| DC 3 | 218 % |

| CPU total en uso | 485 % |

| Número de sistemas objetivo | Ancho de banda total (según aparece anteriormente) |

|---|---|

| CPU necesarias en el objetivo del 40 % | 4,85 ÷ 4 = 12,25 |

Como repetición, debido a la importancia de este punto, recuerde planear el crecimiento. Suponiendo un crecimiento del 50 % en los próximos tres años, este entorno necesitará 18,375 CPU (12,25 × 1,5) en el plazo de tres años. Un plan alternativo sería revisar después del primer año y agregar capacidad adicional según sea necesario.

Carga de la autenticación de cliente de confianza cruzada para NTLM

Evaluación de la carga de la autenticación de cliente de confianza cruzada

Muchos entornos pueden tener uno o varios dominios conectados por una confianza. Una solicitud de autenticación para una identidad en otro dominio que no usa la autenticación Kerberos debe atravesar una confianza mediante el canal seguro del controlador de dominio a otro controlador de dominio, ya sea en el dominio de destino o en el siguiente dominio de la ruta de acceso al dominio de destino. El número de llamadas simultáneas mediante el canal seguro que un controlador de dominio puede realizar a un controlador de dominio de un dominio de confianza se controla mediante una configuración conocida como MaxConcurrentAPI. En el caso de los controladores de dominio, garantizar que el canal seguro pueda controlar la cantidad de carga se logra mediante uno de los dos enfoques: ajuste de MaxConcurrentAPI o, dentro de un bosque, creando confianzas de acceso directo. Para medir el volumen de tráfico en una confianza individual, consulte Cómo realizar el ajuste del rendimiento para la autenticación NTLM mediante la configuración MaxConcurrentApi.

Durante la recopilación de datos, esto, al igual que con todos los demás escenarios, se debe recopilar durante los períodos de actividad máxima del día para que los datos sean útiles.

Nota

Los escenarios dentro del bosque y entre bosques pueden hacer que la autenticación recorra varias confianzas y se deba optimizar cada fase.

Planificación

Hay varias aplicaciones que usan la autenticación NTLM de manera predeterminada o la usan en un escenario de configuración determinado. Los servidores de aplicaciones crecen en capacidad y dan servicio a un número cada vez mayor de clientes activos. También hay una tendencia en los clientes de mantener abiertas las sesiones durante un tiempo limitado y volver a conectarse periódicamente (como la sincronización de extracción de correo electrónico). Otro ejemplo común para una carga elevada de NTLM son los servidores proxy web que requieren autenticación para el acceso a Internet.

Estas aplicaciones pueden provocar una carga significativa para la autenticación NTLM, lo que puede suponer un esfuerzo significativo en los controladores de dominio, especialmente cuando los usuarios y los recursos están en dominios diferentes.

Hay varios enfoques para administrar la carga de confianza cruzada, que en la práctica se usan conjuntamente en lugar de en un escenario excluyente. Las opciones posibles son:

- Reduzca la autenticación de cliente de confianza cruzada ubicando los servicios que consume un usuario en el mismo dominio en el que reside el usuario.

- Aumente el número de canales seguros disponibles. Esto es importante para el tráfico dentro del bosque y entre bosques, y se conoce como confianzas de acceso directo.

- Optimice la configuración predeterminada de MaxConcurrentAPI.

Para optimizar MaxConcurrentAPI en un servidor existente, la ecuación es:

New_MaxConcurrentApi_setting ≥ (semaphore_acquires + semaphore_time-outs) × average_semaphore_hold_time ÷ time_collection_length

Para obtener más información, consulte el artículo de KB 2688798: Cómo realizar el ajuste del rendimiento para la autenticación NTLM mediante la configuración MaxConcurrentApi.

Consideraciones de virtualización

Ninguno, se trata de una configuración de ajuste del sistema operativo.

Ejemplo de resumen de cálculo

| Tipo de datos | Value |

|---|---|

| Adquisiciones de semáforo (mínimo) | 6161 |

| Adquisiciones de semáforo (máximo) | 6762 |

| Tiempos de espera del semáforo | 0 |

| Promedio de tiempo de retención del semáforo | 0,012 |

| Duración de la recopilación (segundos) | 1:11 minutos (71 segundos) |

| Fórmula (según KB 2688798) | ((6762 – 6161) + 0) × 0,012 / |

| Valor mínimo de MaxConcurrentAPI | ((6762 – 6161) + 0) × 0,012 ÷ 71 = 0,101 |

Para este sistema durante este período de tiempo, los valores predeterminados son aceptables.

Supervisión del cumplimiento de los objetivos de planeamiento de capacidad

A lo largo de este artículo, se ha explicado que el planeamiento y el escalado van dirigidos a los objetivos de uso. Este es un gráfico de resumen de los umbrales recomendados que se deben supervisar para asegurarse de que los sistemas funcionan dentro de los umbrales de capacidad adecuados. Tenga en cuenta que no son umbrales de rendimiento, sino umbrales de planeamiento de capacidad. Un servidor que opere por encima de estos umbrales funcionará, pero es el momento de empezar a validar que todas las aplicaciones se comportan bien. Si dichas aplicaciones se comportan bien, es hora de empezar a evaluar las actualizaciones de hardware u otros cambios de configuración.

| Category | Contador de rendimiento | Intervalo/muestreo | Destino | Advertencia |

|---|---|---|---|---|

| Procesador | Processor Information(_Total)\% Processor Utility | 60 min | 40% | 60% |

| RAM (Windows Server 2008 R2 o versiones anteriores) | Memory\Available MB | < 100 MB | N/D | < 100 MB |

| RAM (Windows Server 2012) | Memory\Long-Term Average Standby Cache Lifetime(s) | 30 min | Se debe probar | Se debe probar |

| Red | Network Interface(*)\Bytes Sent/sec Network Interface(*)\Bytes Received/sec |

30 min | 40% | 60% |

| Almacenamiento | LogicalDisk(<Unidad de la base de datos NTDS>)\Avg Disk sec/Read LogicalDisk(<Unidad de la base de datos NTDS>)\Avg Disk sec/Write |

60 min | 10 ms | 15 ms |

| Servicios de AD | Netlogon(*)\Average Semaphore Hold Time | 60 min | 0 | 1 segundo |

Apéndice A: Criterios de dimensionamiento de CPU

Definiciones

Procesador (microprocesador): un componente que lee y ejecuta instrucciones de programas

CPU: unidad central de procesamiento

Procesador de varios núcleos: varias CPU en el mismo circuito integrado

Multi-CPU: varias CPU, no en el mismo circuito integrado

Procesador lógico: un motor de procesamiento lógico desde la perspectiva del sistema operativo

Esto incluye con hipersubprocesamiento, un núcleo en un procesador de varios núcleos o un procesador de un solo núcleo.

Como los sistemas de servidor actuales tienen varios procesadores, varios procesadores de varios núcleos e hipersubprocesamiento, esta información se generaliza para cubrir ambos escenarios. Por lo tanto, se usará el término procesador lógico porque representa la perspectiva del sistema operativo y las aplicaciones sobre los motores procesamiento disponibles.

Paralelismo de nivel de subproceso

Cada subproceso es una tarea independiente, ya que cada subproceso tiene su propia pila e instrucciones. Dado que AD DS tiene multisubprocesamiento y el número de subprocesos disponibles se puede optimizar como se indica en Cómo ver y establecer la directiva LDAP en Active Directory mediante Ntdsutil.exe, se escala bien entre varios procesadores lógicos.

Paralelismo de nivel de datos

Esto implica compartir datos entre varios subprocesos dentro de un proceso (en el caso del proceso de AD DS por sí solo) y entre varios subprocesos de varios procesos (en general). Con precaución por simplificar demasiado el caso, esto significa que los cambios en los datos se reflejan en todos los subprocesos en ejecución en todos los distintos niveles de caché (L1, L2, L3) en todos los núcleos que ejecutan dichos subprocesos, así como en la actualización de la memoria compartida. El rendimiento se puede degradar durante las operaciones de escritura, en tanto que todas las distintas ubicaciones de memoria sean coherentes antes de que el procesamiento de instrucciones pueda continuar.

Consideraciones sobre velocidad de CPU frente a varios núcleos

La regla general es que los procesadores lógicos más rápidos reducen la duración que se tarda en procesar una serie de instrucciones, mientras que más procesadores lógicos significa que se pueden ejecutar más tareas al mismo tiempo. Estas reglas generales se desglosan a medida que los escenarios se vuelven intrínsecamente más complejos, con consideraciones de recuperación de datos de la memoria compartida, espera del paralelismo de nivel de datos y la sobrecarga de administrar varios subprocesos. Esto también es el motivo por el que la escalabilidad en sistemas de varios núcleos no es lineal.

Tenga en cuenta las siguientes analogías en estas consideraciones: piense en una autopista, en la que cada subproceso es un automóvil individual, cada carril es un núcleo y el límite de velocidad es la velocidad del reloj.

- Si solo hay un automóvil en la autopista, no importa si hay dos carriles o 12 carriles. Ese automóvil solo irá tan rápido como permita el límite de velocidad.

- Supongamos que los datos que necesita el subproceso no están disponibles inmediatamente. La analogía sería que un segmento de carretera está fuera de servicio. Si solo hay un automóvil en la carretera, no importa cuál sea el límite de velocidad hasta que se vuelva a abrir el carril (se recuperan los datos de la memoria).

- A medida que aumenta el número de automóviles, aumenta la sobrecarga necesaria para administrar el número de automóviles. Compare la experiencia de conducción y la cantidad de atención necesaria cuando la carretera está prácticamente vacía (por ejemplo, tarde por la noche) frente a cuando el tráfico es pesado (por ejemplo, media tarde, pero no hora punta). Además, tenga en cuenta la cantidad de atención necesaria al conducir en una autopista de dos carriles, donde solo hay otro carril para preocuparse de lo que hacen los conductores, frente a una autopista de seis carriles donde hay que preocuparse por lo que hacen muchos otros conductores.

Nota

La analogía sobre el escenario de hora punta se extiende en la sección siguiente: Tiempo de respuesta/Cómo afecta al rendimiento la disponibilidad del sistema.

Como resultado, los detalles sobre usar más procesadores o más rápidos se convierten en muy subjetivos del comportamiento de la aplicación, que en el caso de AD DS es muy específico del entorno e incluso varía de servidor a servidor dentro de un entorno. Esta es la razón por la que las referencias anteriores del artículo no invierten mucho en ser demasiado precisas y se incluye un margen de seguridad en los cálculos. Al tomar decisiones de compra controladas por un presupuesto, se recomienda optimizar primero el uso de los procesadores al 40 % (o el número deseado para el entorno), antes de considerar la posibilidad de comprar procesadores más rápidos. El aumento de la sincronización entre más procesadores reduce la verdadera ventaja de más procesadores respecto a la progresión lineal (2× número de procesadores proporciona menos de 2× potencia de proceso adicional disponible).

Nota

La ley de Amdahl y la ley de Gustafson son los conceptos pertinentes aquí.

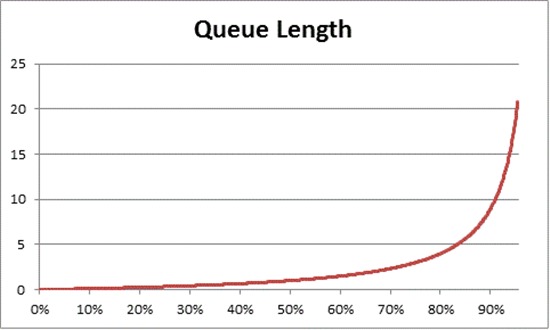

Tiempo de respuesta/Cómo afecta al rendimiento la disponibilidad del sistema

La teoría de colas es el estudio matemático de las líneas de espera (colas). En la teoría colas, la Ley de utilización se representa mediante la ecuación:

U k = B ÷ T

Donde U k es el porcentaje de utilización, B es la cantidad de tiempo ocupado y T es el tiempo total que se observó el sistema. Traducido al contexto de Windows, esto significa el número de subprocesos del intervalo de 100 nanosegundos (ns) que se encuentran en estado En ejecución dividido por el número de intervalos de 100 ns que estaban disponibles en un intervalo de tiempo determinado. Esta es exactamente la fórmula para calcular el porcentaje de utilidad del procesador (consulte objeto Processor y PERF_100NSEC_TIMER_INV).

La teoría de colas también proporciona la fórmula: N = U k ÷ (1 – U k) para calcular el número de elementos en espera en función del uso (N es la longitud de la cola). La creación de gráficos en todos los intervalos de uso proporciona las siguientes estimaciones sobre cuánto tiempo tarda la cola en tener el procesador en una carga de CPU determinada.

Se observa que después de una carga de CPU del 50 %, en promedio siempre hay una espera de otro elemento en la cola, con un aumento notablemente rápido después de aproximadamente un 70 % de uso de CPU.

Volviendo a la analogía de conducción usada anteriormente en esta sección:

- Las horas ocupadas de "media tarde" estarían, hipotéticamente, en algún lugar del intervalo del 40 % al 70 %. Hay suficiente tráfico como para que la capacidad de elegir cualquier carril no esté restringida en gran medida y la posibilidad de que otro conductor esté en el camino, aunque alta, no requiere el nivel de esfuerzo para "encontrar" un hueco seguro entre otros automóviles de la carretera.

- Se observará que, a medida que el tráfico se acerca a la hora punta, el sistema de carreteras se aproxima al 100 % de capacidad. Cambiar de carril puede ser muy difícil porque los automóviles están tan cerca que se debe ejercer mayor precaución para hacerlo.

Este es el motivo por el que los promedios a largo plazo de capacidad que se han calculado de forma conservadora en un 40 % permiten un espacio para picos anormales en la carga, ya sean dichos picos transitorios (como consultas mal codificadas que se ejecutan durante unos minutos) o ráfagas anómalas en la carga general (la mañana del primer día después de un fin de semana largo).

La declaración anterior relativa a que el cálculo del porcentaje de tiempo de procesador es el mismo que la Ley de utilización es un poco una simplificación para la facilidad del lector general. Para aquellos más rigurosos matemáticamente: