Inteligencia artificial de confianza y responsable

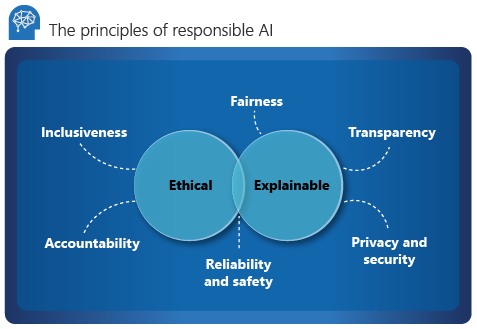

Microsoft destaca seis principios rectores para la inteligencia artificial responsable: responsabilidad, inclusión, confiabilidad y seguridad, equidad, transparencia y privacidad y seguridad. Estos principios son esenciales para crear una IA responsable y confiable a medida que avanza hacia los productos y servicios principales. Se guían por dos perspectivas: ética y explicable.

Ética

Desde una perspectiva ética, la inteligencia artificial debe:

- Ser justa e inclusive en sus aserciones.

- Ser responsable de sus decisiones.

- No discriminar ni obstaculizar las diferentes razas, discapacidades o antecedentes.

En 2017, Microsoft estableció un comité asesor para inteligencia artificial, ética y efectos en ingeniería e investigación (Aether). La responsabilidad principal del comité es asesorar sobre problemas, tecnologías, procesos y mejores prácticas para una IA responsable. Para obtener más información, consulte Descripción del modelo de gobernanza: AETHER + IA responsable de Office.

Rendición de cuentas

La responsabilidad es un pilar esencial de la inteligencia artificial responsable. Las personas que diseñan e implementan un sistema de inteligencia artificial deben ser responsables de sus acciones y decisiones, especialmente a medida que avanzamos hacia sistemas más autónomos.

Las organizaciones deben considerar la posibilidad de establecer un cuerpo de revisión interno que proporcione supervisión, conclusiones y orientación sobre el desarrollo e implementación de sistemas de inteligencia artificial. Esta guía puede variar según la empresa y la región, y debe reflejar el recorrido de IA de una organización.

Inclusión

La inclusión exige que la inteligencia artificial tenga en cuenta todas las razas y experiencias humanas. Las prácticas de diseño inclusivo pueden ayudar a los desarrolladores a comprender y abordar las posibles barreras que podrían excluir a las personas involuntariamente. Siempre que sea posible, las organizaciones deben utilizar tecnología de voz a texto, de texto a voz y de reconocimiento visual para empoderar a las personas que tienen discapacidades auditivas, visuales y de otro tipo.

Confiabilidad y seguridad

Para que los sistemas de inteligencia artificial sean de confianza, deben ser confiables y seguros. Es importante que un sistema funcione como se diseñó originalmente y que responda de manera segura a situaciones nuevas. Su resistencia inherente debe soportar la manipulación prevista o imprevista.

Una organización debe establecer rigurosas pruebas y validación para las condiciones de funcionamiento para garantizar que el sistema responda de forma segura a los casos perimetrales. Debe integrar los métodos de prueba A/B y champion/challenger en el proceso de evaluación.

El rendimiento de un sistema de inteligencia artificial puede degradarse con el tiempo. Una organización debe establecer un proceso sólido de supervisión y seguimiento de modelos para medir de forma reactiva y proactiva el rendimiento del modelo (y volver a entrenarlo para la modernización, según sea necesario).

Explicable

La explicabilidad ayuda a los científicos de datos, auditores y tomadores de decisiones comerciales a garantizar que los sistemas de inteligencia artificial puedan justificar sus decisiones y cómo llegan a sus conclusiones. La explicabilidad también ayuda a garantizar el cumplimiento de las políticas de la empresa, los estándares de la industria y las reglamentaciones gubernamentales.

Un científico de datos debe poder explicar a una parte interesada cómo lograron ciertos niveles de precisión y lo qué influyó en el resultado. Del mismo modo, para cumplir con las políticas de la empresa, un auditor necesita una herramienta que valide el modelo. Un responsable de la toma de decisiones empresariales debe obtener confianza proporcionando un modelo transparente.

Herramientas con explicabilidad

Microsoft ha desarrollado InterpretML, un conjunto de herramientas de código abierto que ayuda a las organizaciones a lograr la explicabilidad del modelo. Admite modelos de caja de cristal y caja negra:

Los modelos de caja de cristal se pueden interpretar debido a su estructura. Para estos modelos, Explicable Boosting Machine (EBM) proporciona el estado del algoritmo basado en un árbol de decisión o modelos lineales. EBM proporciona explicaciones sin pérdida y es editable por expertos en dominio.

Los modelos de caja negra son más difíciles de interpretar debido a que tienen una estructura interna compleja, la red neuronal. Los explicadores como las explicaciones locales interpretables agnósticas del modelo (LIME) o SHapley Additive exPlanations (SHAP) interpretan estos modelos analizando la relación entre la entrada y la salida.

Fairlearn es una integración de Azure Machine Learning y un kit de herramientas de código abierto para el SDK y la interfaz gráfica de usuario de AutoML. Usa explicadores para comprender qué influye principalmente en el modelo y utiliza expertos en el dominio para validar estas influencias.

Para obtener más información sobre la explicabilidad, explore la interpretabilidad del modelo en Azure Machine Learning.

Imparcialidad

La equidad es un principio ético básico que todos los seres humanos tienen como objetivo comprender y aplicar. Este principio aún es más importante cuando se desarrollan sistemas de inteligencia artificial. Las comprobaciones y los equilibrios clave deben asegurarse de que las decisiones del sistema no discriminan o expresan un sesgo hacia, un grupo o individuo en función del género, la raza, la orientación sexual o la religión.

Microsoft proporciona una lista de comprobación de equidad de inteligencia artificial que ofrece instrucciones y soluciones para sistemas de inteligencia artificial. Estas soluciones se clasifican de forma flexible en cinco fases: planeamiento, prototipo, compilación, lanzamiento y evolución. Cada fase muestra las actividades de diligencia debida recomendadas que ayudan a minimizar el impacto de la injusticia en el sistema.

Fairlearn se integra con Azure Machine Learning y permite a los científicos de datos y desarrolladores evaluar y mejorar la equidad de sus sistemas de inteligencia artificial. Proporciona algoritmos de mitigación de injusticia y un tablero interactivo que visualiza la imparcialidad del modelo. Una organización debe usar el kit de herramientas y evaluar estrechamente la equidad del modelo mientras se está creando. Esta actividad debe ser una parte integral del proceso de ciencia de datos.

Obtenga información sobre cómo mitigar la injusticia en los modelos de aprendizaje automático.

Transparencia

Lograr transparencia ayuda al equipo a comprender lo siguiente:

- Los datos y algoritmos que se usaron para entrenar el modelo.

- Lógica de transformación que se aplicó a los datos.

- Modelo final que se generó.

- Recursos asociados del modelo.

Esta información ofrece información sobre cómo se creó el modelo, para que el equipo pueda reproducirlo de manera transparente. Las instantáneas de las áreas de trabajo de Azure Machine Learning admiten la transparencia mediante el registro o reentrenamiento de todos los recursos y métricas relacionados con el entrenamiento implicados en el experimento.

Privacidad y seguridad

Un titular de datos está obligado a proteger los datos en un sistema de inteligencia artificial. La privacidad y la seguridad son parte integral de este sistema.

Los datos personales deben estar protegidos y el acceso a ellos no debe poner en peligro la privacidad de una persona. La privacidad diferencial de Azure ayuda a proteger y preservar la privacidad al aleatorizar datos y agregar ruido para ocultar información personal a los científicos de datos.

Directrices de la inteligencia artificial centrada en el usuario

Las directrices del diseño de la inteligencia artificial centrada en el usuario se componen de 18 principios que tienen lugar a lo largo de cuatro periodos: en el inicio, durante la interacción, cuando es incorrecto y a lo largo del tiempo. Estos principios ayudan a una organización a producir un sistema de inteligencia artificial más inclusivo y centrado en el ser humano.

En el inicio

Aclare lo que puede hacer el sistema. Si el sistema de inteligencia artificial usa o genera métricas, es importante mostrarlas todas e indicar cómo se realiza el seguimiento.

Aclare la eficacia del sistema para hacer lo que hace. Ayude a los usuarios a comprender que la inteligencia artificial no es completamente precisa. Establezca las expectativas para cuando el sistema de inteligencia artificial pueda cometer errores.

Durante la interacción

Muestre la información contextualmente relevante. Proporcione información visual relacionada con el contexto y el entorno actual del usuario, como hoteles cercanos. Devuelve los detalles cerca del destino y la fecha de destino.

Mitigue los sesgos sociales. Asegúrese de que el idioma y el comportamiento no presentan estereotipos ni sesgos no deseados. Por ejemplo, una característica de autocompletar debe ser inclusiva de la identidad de género.

Cuando es incorrecto

- Admita una opción para descartar que sea eficaz. Proporcione un mecanismo fácil para ignorar o descartar funciones o servicios no deseados.

- Admita una corrección eficaz. Proporcione una manera intuitiva de facilitar la edición, el refinamiento o la recuperación.

- Clarifique el motivo de la acción del sistema. Optimice la inteligencia artificial explicable para ofrecer conclusiones sobre las aserciones del sistema de IA.

A lo largo del tiempo

- Recuerde las interacciones recientes. Conserve un historial de interacciones para futuras referencias.

- Aprenda del comportamiento de los usuarios. Personalice la interacción en función del comportamiento del usuario.

- Realice actualizaciones y adaptaciones con precaución. Limite los cambios perturbadores y haga actualizaciones según el perfil del usuario.

- Anime a los usuarios a realizar comentarios pormenorizados. Recopile comentarios de los usuarios sobre sus interacciones con el sistema de IA.

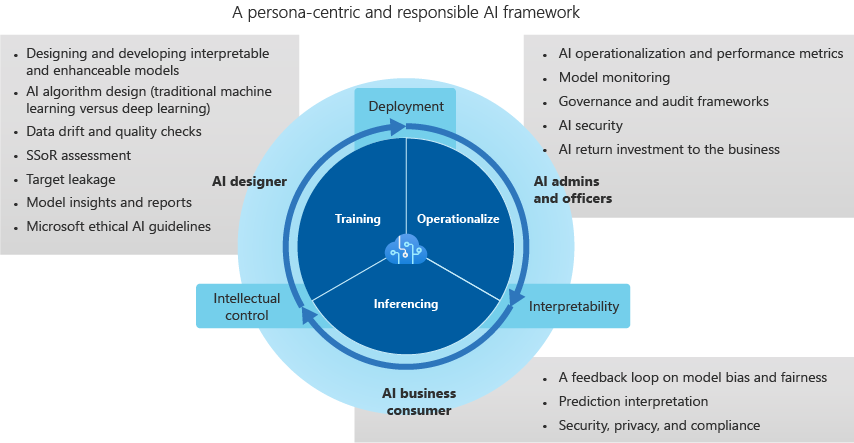

Marco de inteligencia artificial de confianza

Diseñador de IA

El diseñador de IA crea el modelo y es responsable de lo siguiente:

Realizar comprobaciones de calidad y desfase de datos. El diseñador detecta valores atípicos y realiza comprobaciones de calidad de datos para identificar los valores que faltan. El diseñador también estandariza la distribución, examina los datos y genera informes de proyectos y casos de uso.

Evaluar los datos en el origen del sistema para identificar posibles sesgos.

Diseñar algoritmos de inteligencia artificial para minimizar los sesgos de datos. Estos esfuerzos incluyen descubrir cómo el agrupamiento, la agrupación y la normalización (especialmente en los modelos tradicionales de aprendizaje automático, como los basados en árboles) pueden eliminar a los grupos minoritarios de los datos. El diseño categórico de inteligencia artificial reitera los sesgos de los datos al agrupar las clases sociales, raciales y de género en sectores verticales de la industria que se basan en información de salud protegida (PHI) y datos personales.

Optimizar la supervisión y las alertas para identificar la pérdida de destinos y fortalecer el desarrollo del modelo.

Establecimiento de procedimientos recomendados para informes e información que ofrecen un conocimiento pormenorizados del modelo. El diseñador evita los enfoques de caja negra que utilizan la importancia de las características o los vectores, la agrupación en clústeres de proyección y aproximación de colectores uniformes (UMAP), la estadística H de Friedman, los efectos de características y técnicas relacionadas. Las métricas de identificación ayudan a definir influencias, relaciones y dependencias predictivas entre correlaciones en conjuntos de valores complejos y modernos.

Administradores y responsables de inteligencia artificial

El administrador y los responsables de inteligencia artificial supervisan las operaciones y las métricas de rendimiento de la inteligencia artificial, el gobierno y el marco de auditoría. También supervisan cómo se implementa la seguridad de la inteligencia artificial y la rentabilidad de la inversión de la empresa. Sus tareas incluyen:

Supervisión de un panel de seguimiento que ayuda a la supervisión del modelo y combina las métricas del modelo para los modelos de producción. El panel se centra en la precisión, la degradación del modelo, el desfase de datos, la desviación y los cambios en la velocidad/error de inferencia.

Implementación flexible y reimplementación (preferiblemente, a través de una API de REST) que permite implementar modelos en una arquitectura abierta e independiente. La arquitectura integra el modelo con procesos empresariales y genera un valor para los bucles de comentarios.

Al trabajar para construir un modelo de gobernanza y acceso para establecer límites y mitigar el impacto comercial y operativo negativo. Los estándares de control de acceso basado en roles (RBAC) determinan los controles de seguridad, que preservan los entornos de producción restringidos y la propiedad intelectual.

Uso de los marcos de auditoría y cumplimiento de inteligencia artificial para realizar un seguimiento de cómo los modelos desarrollan y cambian para cumplir los estándares específicos del sector. La IA interpretable y responsable se basa en medidas de explicabilidad, características concisas, visualizaciones de modelos y lenguaje del segmento vertical del sector.

Consumidores empresariales de IA

Los consumidores empresariales de IA (expertos empresariales) cierran el bucle de comentarios y proporcionan entradas para el diseñador de IA. La toma de decisiones predictiva y las posibles implicaciones de sesgo, como la equidad y las medidas éticas, la privacidad y el cumplimiento y la eficiencia empresarial, ayudan a evaluar los sistemas de IA. Estas son algunas consideraciones para los consumidores empresariales:

Los bucles de retroalimentación pertenecen al ecosistema de una empresa. Los datos que muestran el sesgo, los errores, la velocidad de predicción y la equidad de un modelo establecen la confianza y el equilibrio entre el diseñador, el administrador y los funcionarios de inteligencia artificial. La evaluación centrada en la persona debe mejorar gradualmente la inteligencia artificial a lo largo del tiempo.

Minimizar el aprendizaje de inteligencia artificial a partir de datos complejos y multidimensionales puede ayudar a evitar el aprendizaje sesgado. Esta técnica se denomina aprendizaje de menos de un disparo (LO-shot).

El uso de herramientas y diseño de interpretabilidad responsabiliza a los sistemas de inteligencia artificial de posibles sesgos. Los problemas de sesgo y equidad del modelo deben marcarse y enviarse a un sistema de alerta y detección de anomalías que aprenda de este comportamiento y aborde automáticamente los sesgos.

Cada valor predictivo debe dividirse en características o vectores individuales por importancia o impacto. Debe ofrecer explicaciones exhaustivas de predicción que se puedan exportar a un informe comercial para auditorías y revisiones de cumplimiento, transparencia del cliente y preparación comercial.

Debido a los crecientes riesgos globales de seguridad y privacidad, las mejores prácticas para resolver infracciones de datos durante la inferencia requieren cumplir con las regulaciones en industrias verticales individuales. Entre los ejemplos se incluyen alertas sobre la falta de cumplimiento con la PHI y los datos personales, o alertas sobre la infracción de las leyes nacionales o regionales de seguridad.

Pasos siguientes

Explore las instrucciones de la IA centrada en el usuario para obtener más información sobre la IA responsable.

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente GitHub Issues como mecanismo de comentarios sobre el contenido y lo sustituiremos por un nuevo sistema de comentarios. Para más información, vea: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de