Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

SE APLICA A: Azure Data Factory Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. Aprenda a iniciar una nueva evaluación gratuita.

En este tutorial, va a utilizar Azure Portal para crear una canalización de Azure Data Factory que ejecuta un cuaderno de Databricks en el clúster de trabajos de Databricks. También pasa parámetros de Azure Data Factory al cuaderno de Databricks durante la ejecución.

En este tutorial, realizará los siguientes pasos:

Creación de una factoría de datos.

Cree una canalización que utiliza la actividad Notebook de Databricks.

Desencadenamiento de una ejecución de la canalización

Supervisión de la ejecución de la canalización

Si no tiene una suscripción de Azure, cree una cuenta gratuita antes de empezar.

Nota:

Para obtener información detallada sobre cómo usar la actividad del cuaderno de Databricks, incluida la utilización de bibliotecas y la transmisión de parámetros de entrada y salida, consulte la documentación de la actividad del cuaderno de Databricks.

Requisitos previos

- Área de trabajo de Azure Databricks. Cree un área de trabajo de Databricks o use una existente. Va a crear un cuaderno de Python en el área de trabajo de Azure Databricks. Después, va a ejecutar el cuaderno y le pasará parámetros mediante Azure Data Factory.

Crear una factoría de datos

Inicie el explorador web Microsoft Edge o Google Chrome . Actualmente, la interfaz de usuario de Data Factory solo se admite en los exploradores web Microsoft Edge y Google Chrome.

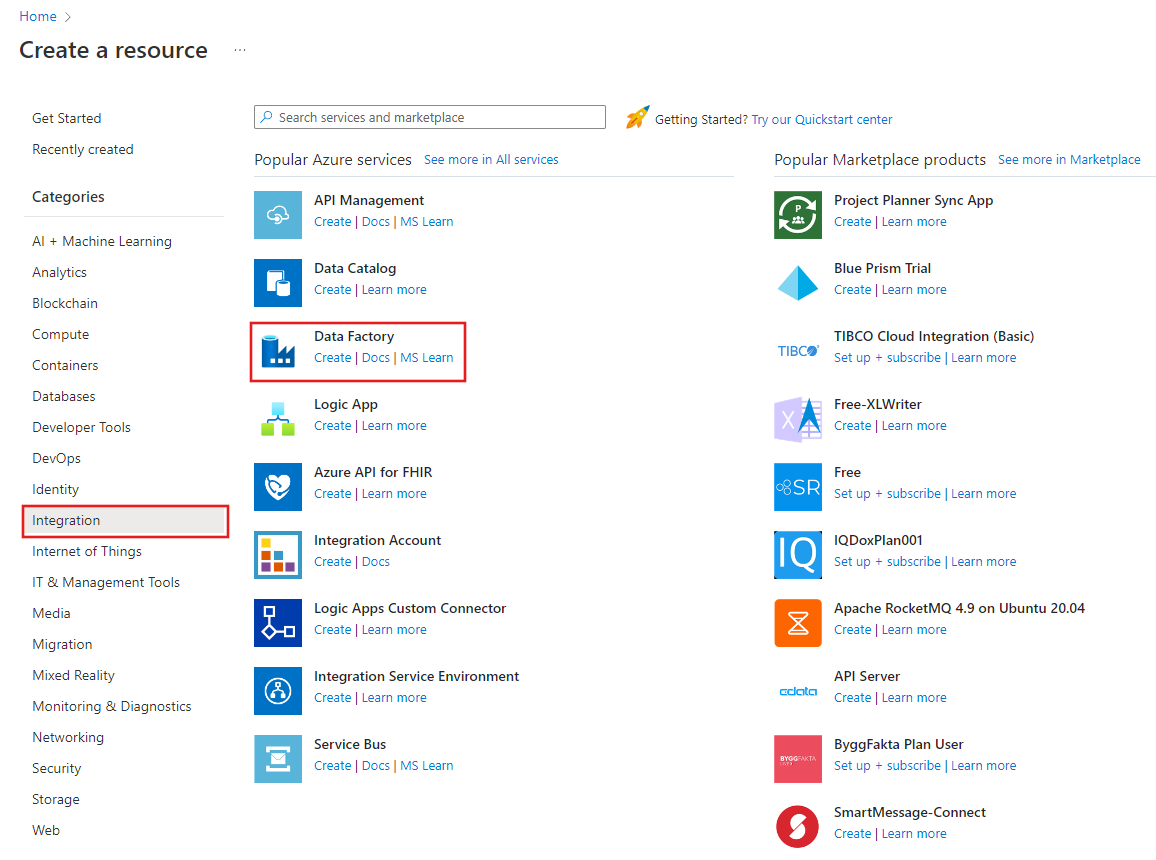

Seleccione Crear un recurso en el menú de Azure Portal y, a continuación, seleccione Analytics>Data Factory :

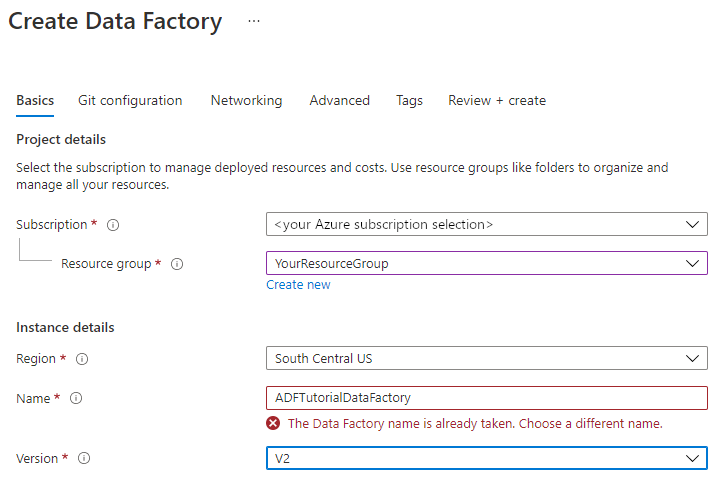

En la página Crear factoría de datos , en la pestaña Aspectos básicos , seleccione la suscripción de Azure en la que desea crear la factoría de datos.

En Grupo de recursos, siga uno de los pasos siguientes:

Seleccione un grupo de recursos existente de la lista desplegable.

Seleccione Crear nuevo y escriba el nombre de un nuevo grupo de recursos.

Para más información sobre los grupos de recursos, consulte Uso de grupos de recursos para administrar los recursos de Azure.

En Región, seleccione la ubicación de la factoría de datos.

En la lista solo se muestran las ubicaciones que admite Data Factory y dónde se almacenarán los metadatos de Azure Data Factory. Los almacenes de datos asociados (como Azure Storage y Azure SQL Database) y los procesos (como Azure HDInsight) que usa Data Factory se pueden ejecutar en otras regiones.

En Nombre, escriba ADFTutorialDataFactory.

El nombre de la factoría de datos de Azure debe ser único globalmente. Si ve el siguiente error, cambie el nombre de la factoría de datos (por ejemplo, use <sunombre>ADFTutorialDataFactory). Para conocer las reglas de nomenclatura de los artefactos de Data Factory, consulte el artículo Reglas de nomenclatura de Data Factory .

En Versión, seleccione V2.

Seleccione Siguiente: Configuración de Git y, a continuación, active la casilla Configurar Git más adelante .

Seleccione Revisar y crear y, después de pasar la validación, seleccione Crear .

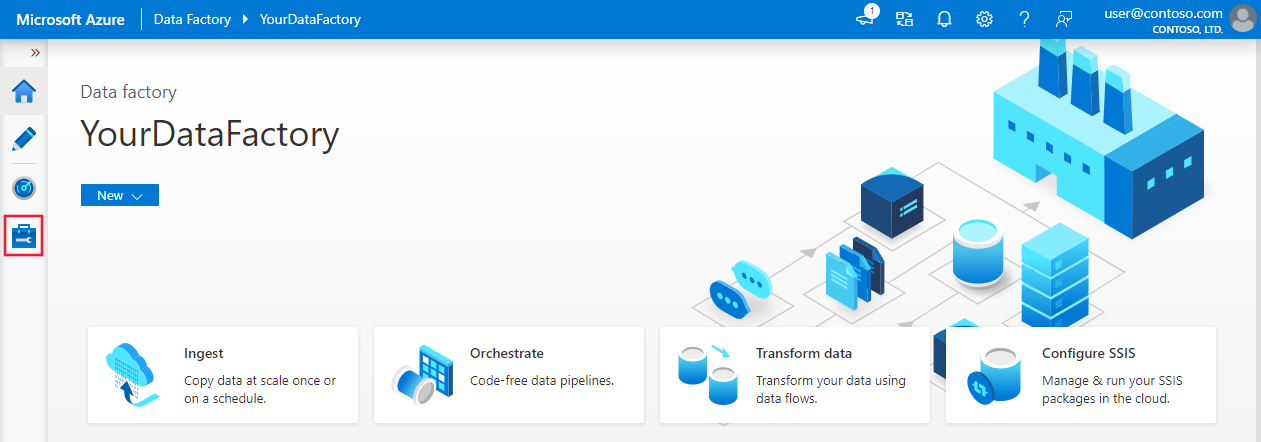

Una vez completada la creación, seleccione Ir al recurso para ir a la página Data Factory . Seleccione el icono Abrir Azure Data Factory Studio para iniciar la aplicación de interfaz de usuario (UI) de Azure Data Factory en una pestaña independiente del explorador.

Crear servicios vinculados

En esta sección, va a crear un servicio vinculado de Databricks. Este servicio vinculado contiene la información de conexión al clúster de Databricks:

Creación de un servicio vinculado de Azure Databricks

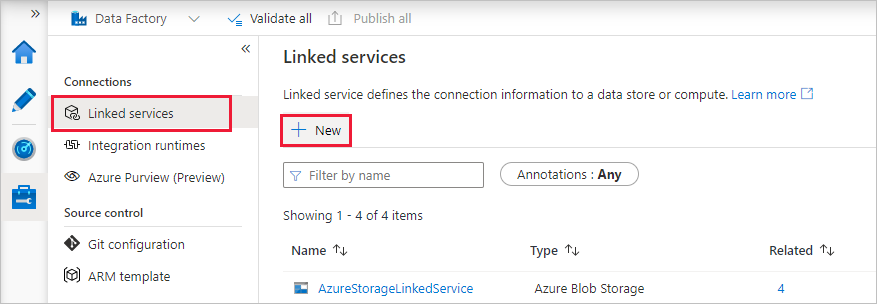

En la página principal, cambie a la pestaña Administrar del panel izquierdo.

Seleccione Servicios vinculados en Conexiones y, a continuación, seleccione + Nuevo.

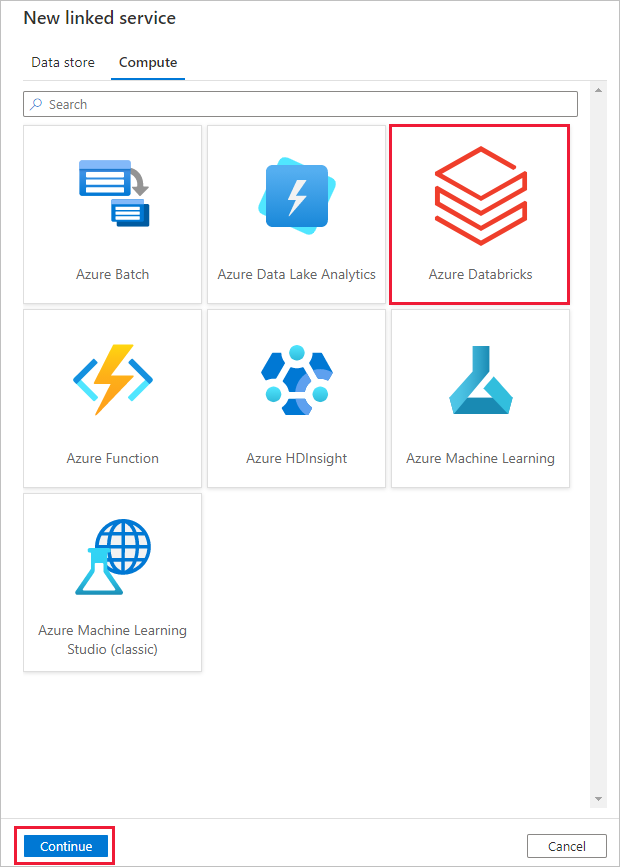

En la ventana Nuevo servicio vinculado, seleccione Compute>Azure Databricks, y a continuación, seleccione Continuar.

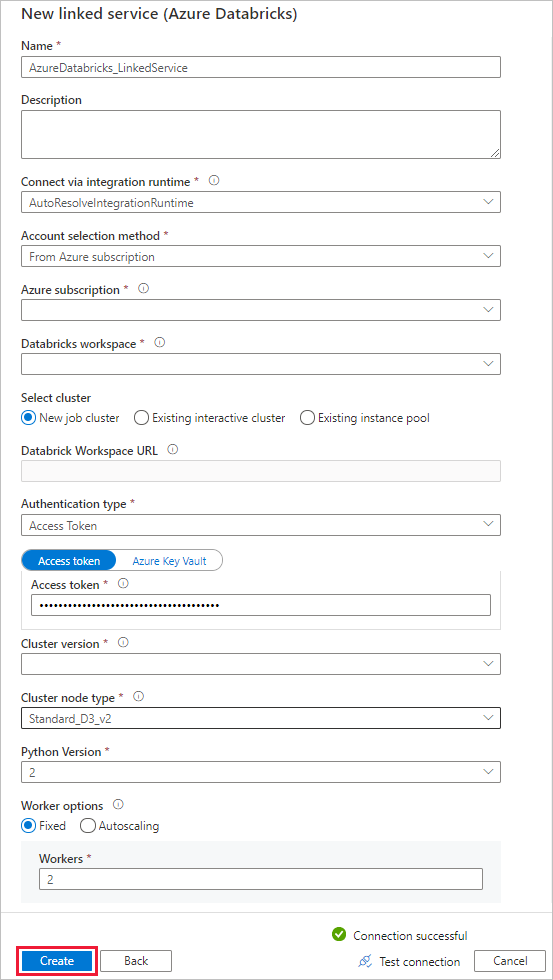

En la ventana Nuevo servicio vinculado , complete los pasos siguientes:

En Nombre, escriba AzureDatabricks_LinkedService.

Seleccione el área de trabajo de Databricks adecuada en la que ejecutará el cuaderno.

En Seleccionar clúster, seleccione Nuevo clúster de trabajos.

En el caso de la dirección URL del área de trabajo de Databricks, la información debe rellenarse automáticamente.

En Tipo de autenticación, si selecciona Token de acceso, genérelo desde el área de trabajo de Azure Databricks. Puede encontrar los pasos aquí. En Identidad de servicio administrada y Identidad administrada asignada por el usuario, conceda el rol Colaborador a ambas identidades en el menú Control de acceso del recurso de Azure Databricks.

En Versión del clúster, seleccione la versión que desea usar.

En Tipo de nodo de clúster, seleccione Standard_D3_v2 en la categoría De uso general (HDD) para este tutorial.

En Trabajadores, introduzca 2.

Seleccione Crear.

Crear una canalización

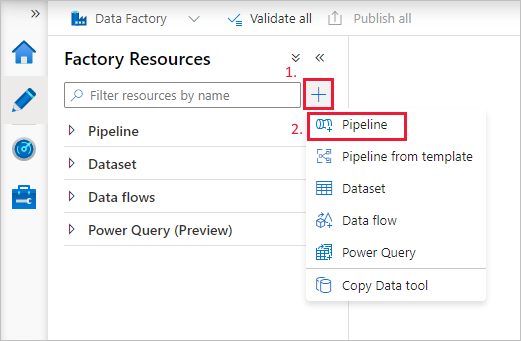

Seleccione el botón + (más) y, después, seleccione Canalización en el menú.

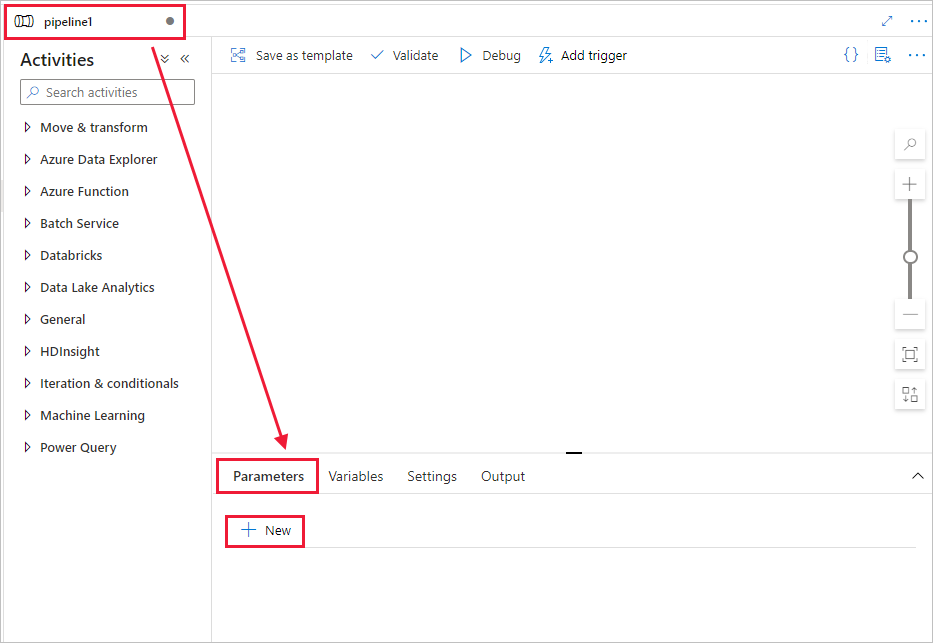

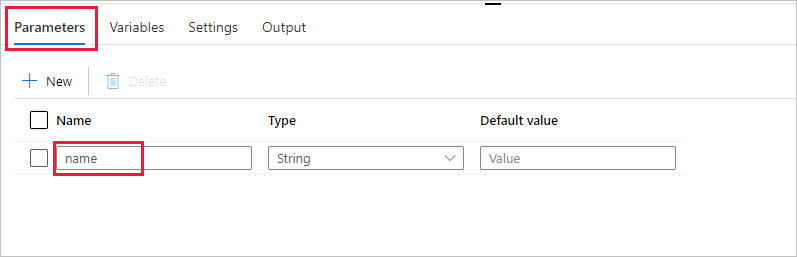

Cree un parámetro que se usará en el Pipeline. Más adelante va a pasar este parámetro a la actividad Notebook de Databricks. En la canalización vacía, seleccione la pestaña Parámetros y, a continuación, seleccione + Nuevo y asígnelo como "nombre".

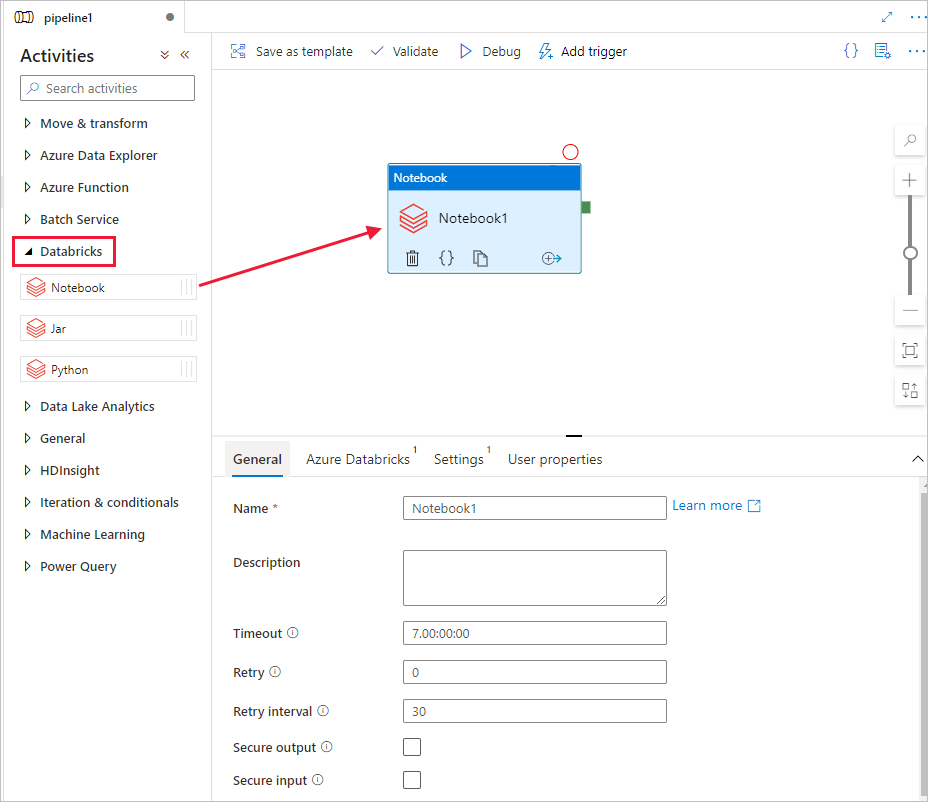

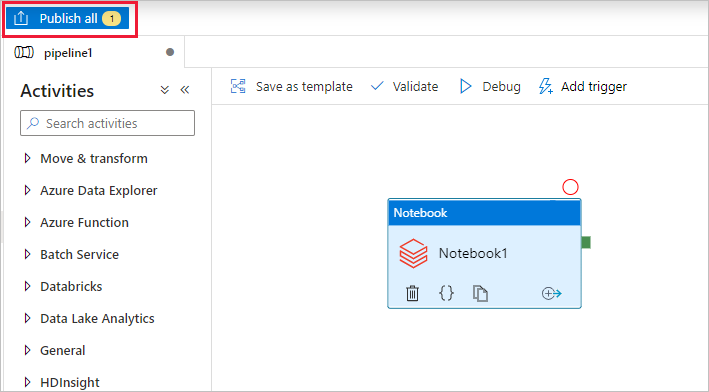

En el cuadro de herramientas Actividades, expanda Databricks. Arrastre la actividad Notebook del cuadro de herramientas Activities a la superficie del diseñador de canalizaciones.

En las propiedades de la ventana de actividad Notebook de Databricks de la parte inferior, realice los pasos siguientes:

Cambie a la pestaña Azure Databricks .

Seleccione AzureDatabricks_LinkedService (que creó en el procedimiento anterior).

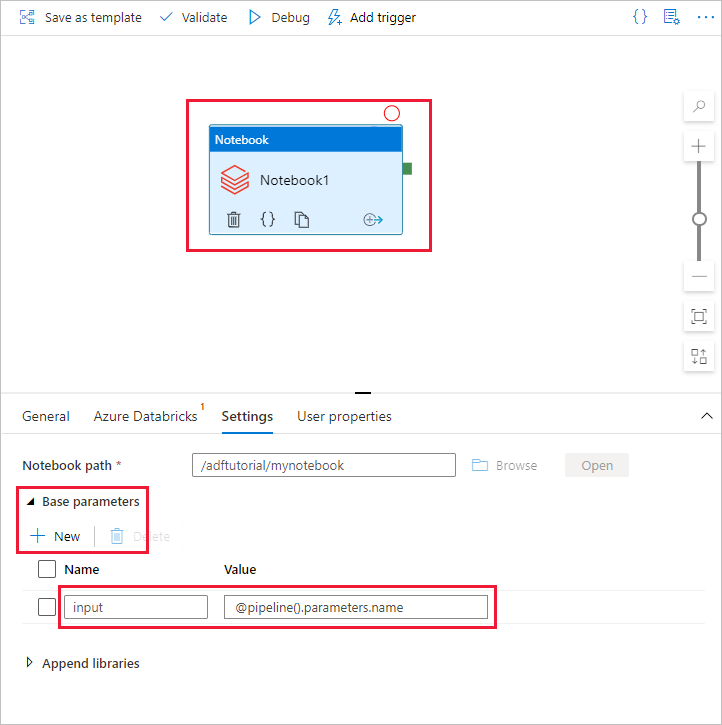

Cambie a la pestaña Configuración .

Seleccione una Ruta de acceso de cuaderno para Databricks. Vamos a crear un cuaderno y especifique aquí la ruta de acceso. Para obtener la ruta de acceso del cuaderno, siga los pasos siguientes.

Inicie el área de trabajo de Azure Databricks.

Cree una nueva carpeta en Workplace y llámela como adftutorial.

Crea un nuevo cuaderno, llamémoslo mynotebook. Haga clic con el botón derecho en la carpeta adftutorial y seleccione Crear.

En el cuaderno "mynotebook" recién creado, agregue el código siguiente:

# Creating widgets for leveraging parameters, and printing the parameters dbutils.widgets.text("input", "","") y = dbutils.widgets.get("input") print ("Param -\'input':") print (y)La Ruta de acceso del cuaderno en este caso es /adftutorial/mynotebook.

Vuelva a la herramienta de creación de la interfaz de usuario de Data Factory. Vaya a la pestaña Configuración en la actividad Notebook1 .

a) Agregue un parámetro a la actividad Notebook. Use el mismo parámetro que se ha agregado antes a la Canalización.

b. Asigne un nombre al parámetro como entrada y proporcione el valor como expresión @pipeline().parameters.name.

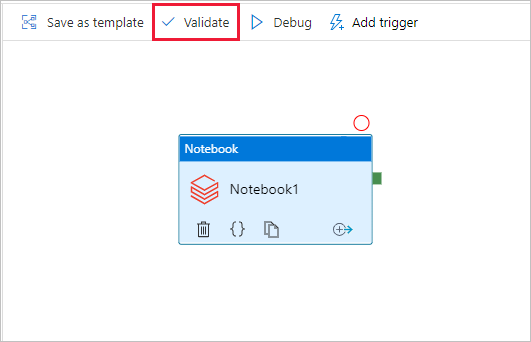

Para validar la canalización, seleccione el botón Validar de la barra de herramientas. Para cerrar la ventana de validación, seleccione el botón Cerrar .

Seleccione Publicar todo. La interfaz de usuario de Data Factory permite publicar entidades (servicios vinculados y canalizaciones) en el servicio Azure Data Factory.

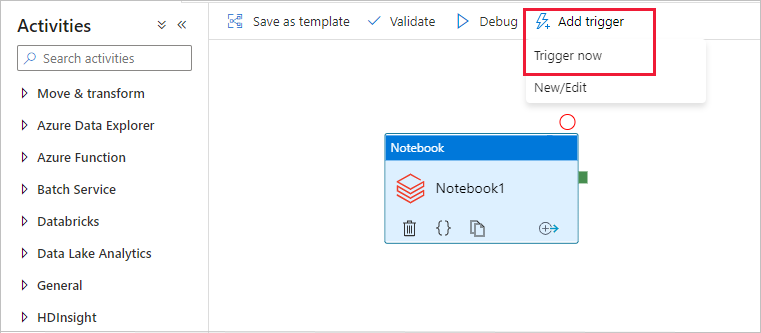

Desencadenamiento de una ejecución de la canalización

Seleccione Agregar desencadenador en la barra de herramientas y, a continuación, seleccione Desencadenar ahora.

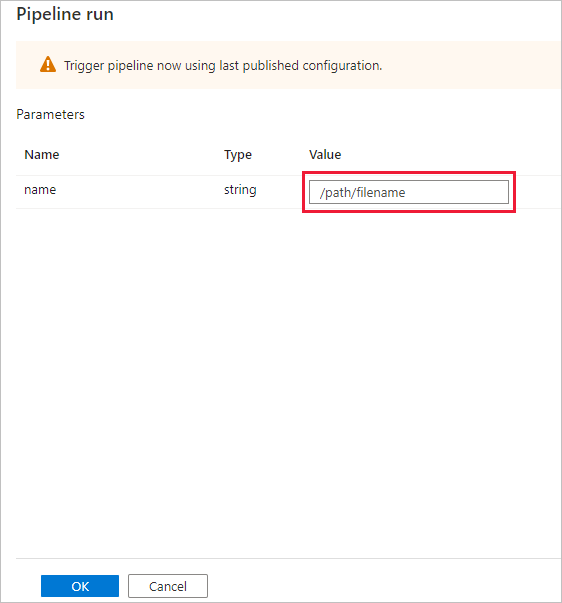

En el cuadro de diálogo Ejecución de canalización se solicita el parámetro name. Use /path/filename como parámetro aquí. Seleccione Aceptar.

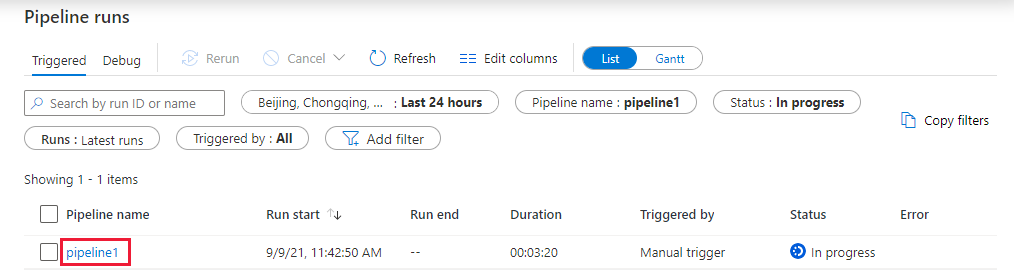

Supervisión de la ejecución de la canalización

Cambie a la pestaña Monitor. Confirme que ve una ejecución de canalización. Se tarda aproximadamente entre 5 y 8 minutos crear un clúster de trabajo de Databricks, donde se ejecuta el cuaderno.

Seleccione Actualizar periódicamente para comprobar el estado de la ejecución de la canalización.

Para ver las ejecuciones de actividad asociadas a la ejecución de la canalización, seleccione el vínculo pipeline1 en la columna Nombre de canalización.

En la página Ejecuciones de actividad, seleccione Salida en la columna Nombre de la actividad para ver la salida de cada actividad y puede encontrar el vínculo a los registros de Databricks en el panel Salida para obtener registros de Spark más detallados.

Para volver a la vista de ejecuciones de canalización, seleccione el vínculo Todas las ejecuciones de la canalización en el menú de la ruta de navegación de la parte superior.

Comprobación del resultado

Puede iniciar sesión en el área de trabajo de Azure Databricks, ir a Ejecuciones de trabajos y puede ver el estado del trabajo como ejecución pendiente, en ejecución o finalizado.

Puede seleccionar el nombre del trabajo y navegar para ver más detalles. Si la ejecución se realiza correctamente, puede validar los parámetros pasados y la salida del cuaderno de Python.

Resumen

La canalización de este ejemplo desencadena una actividad Notebook de Databricks y le pasa un parámetro. Ha aprendido a:

Creación de una factoría de datos.

Creación de una canalización que utiliza la actividad Notebook de Databricks.

Desencadenamiento de una ejecución de la canalización

Supervisión de la ejecución de la canalización