API de modelo de Databricks Foundation

Este artículo ofrece información general acerca de las API del modelo Foundation en Azure Databricks. Incluye requisitos para usar, modelos admitidos y limitaciones.

¿Qué son las API de modelo de Databricks Foundation?

El servicio de modelos de Databricks ahora admite las API de modelos fundacionales que permiten acceder a los modelos abiertos más avanzados y consultarlos desde un punto de conexión de servicio. Con las API de Foundation Model, puede crear aplicaciones de forma rápida y sencilla que aprovechen un modelo de inteligencia artificial generativa de alta calidad sin mantener su propia implementación de modelos.

Las API de Foundation Model se proporcionan en dos modos de precios:

- Pago por token: Esta es la manera más fácil de empezar a acceder a los modelos de base en Databricks y se recomienda para comenzar su recorrido con las API de Foundation Model. Este modo no está diseñado para aplicaciones de alto rendimiento ni cargas de trabajo de producción de alto rendimiento.

- Rendimiento aprovisionado: Este modo se recomienda para todas las cargas de trabajo de producción, especialmente aquellas que requieren un alto rendimiento, garantías de rendimiento, modelos optimizados o requisitos de seguridad adicionales. Los puntos de conexión de rendimiento aprovisionados están disponibles con certificaciones de cumplimiento como HIPAA.

Para obtener información sobre el uso de estos dos modos y los modelos admitidos, consulte Uso de las API de modelos fundacionales.

Con las API de Foundation Model puede hacer lo siguiente:

- Consulte un LLM generalizado para comprobar la validez de un proyecto antes de invertir más recursos.

- Consulte un LLM generalizado para crear una prueba de concepto rápida de una aplicación basada en LLM antes de invertir en el entrenamiento y despliegue de un modelo personalizado.

- Use un modelo de base, junto con una base de datos vectorial, para compilar un bot de chat mediante la generación aumentada de recuperación (RAG).

- Reemplace los modelos propietarios por alternativas abiertas para optimizar el costo y el rendimiento.

- Compare eficazmente los LLM para ver cuál es el mejor candidato para su caso de uso, o intercambie un modelo de producción con uno que cuyo rendimiento sea mejor.

- Cree una aplicación LLM para desarrollo o producción sobre una solución de servicio LLM escalable respaldada por el Acuerdo de Nivel de Servicio que pueda admitir sus picos de tráfico de producción.

Requisitos

- Token de API de Databricks para autenticar solicitudes de punto de conexión.

- Proceso sin servidor (para modelos de rendimiento aprovisionados).

- Un área de trabajo en una región admitida:

Nota:

Para cargas de trabajo de rendimiento aprovisionadas que usan el modelo base DBRX, vea los Límites de las API de Foundation Model para la disponibilidad de regiones.

Use las API del modelo Foundation

Tiene varias opciones para usar las API de Foundation Model.

Las API son compatibles con OpenAI, por lo que incluso puede usar el cliente de OpenAI para realizar consultas. También puede usar la interfaz de usuario, el SDK de Python de las API de Foundation Models, el SDK de implementaciones de MLflow o la API de REST para consultar los modelos admitidos. Databricks recomienda usar el SDK de implementaciones de MLflow o la API de REST para interacciones extendidas y la interfaz de usuario para probar la característica.

Vea Modelos de base de consulta para obtener ejemplos de puntuación.

API de modelos fundacionales de pago por token

Importante

Esta característica está en versión preliminar pública.

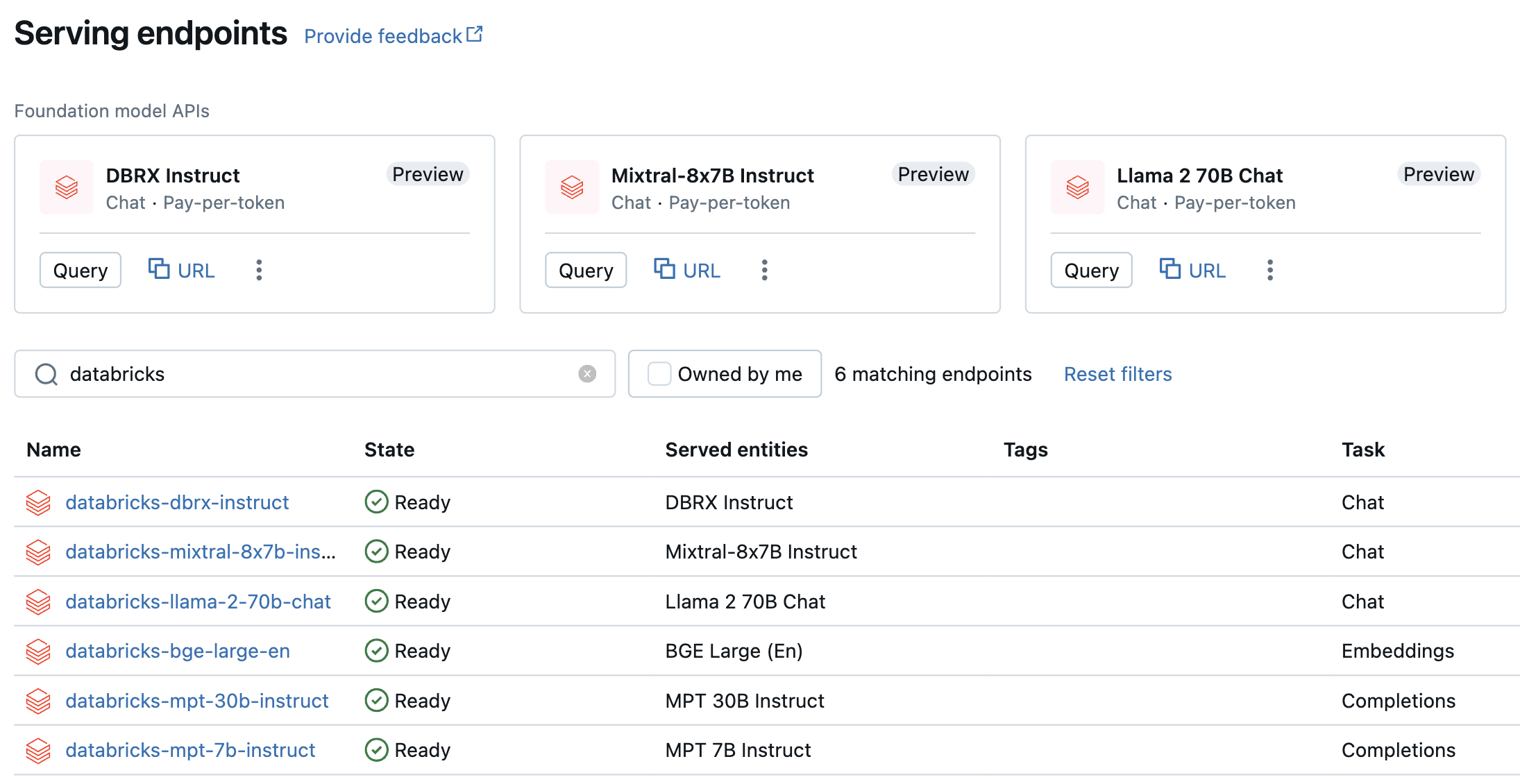

Los modelos de pago por tokens son accesibles en el área de trabajo de Azure Databricks y se recomiendan para empezar. Para acceder a ellos desde su área de trabajo, vaya a la pestaña Servicio de la barra lateral izquierda. Las API de modelo de Foundation se encuentran en la parte superior de la vista de lista puntos de conexión.

En la tabla siguiente se resumen los modelos admitidos para el pago por token. Consulte Modelos admitidos para de pago por token para obtener información adicional sobre el modelo.

Si quiere probar y chatear con estos modelos, puede hacerlo mediante AI Playground. Consulte Chat con los LLM admitidos con AI Playground.

| Modelo | Tipo de tarea | Punto de conexión |

|---|---|---|

| DBRX Instruct | Chat | databricks-dbrx-instruct |

| Meta-Llama-3-70B-Instruct | Chat | databricks-meta-llama-3-70b-instruct |

| Meta-Llama-2-70B-Chat | Charlar | databricks-llama-2-70b-chat |

| Mixtral-8x7B Instruct | Charlar | databricks-mixtral-8x7b-instruct |

| Instrucciones de MPT 7B | Completion | databricks-mpt-7b-instruct |

| Instrucciones de MPT 30B | Completion | databricks-mpt-30b-instruct |

| BGE Large (inglés) | Embedding | databricks-bge-large-en |

- Vea Modelos de base de consulta para obtener instrucciones sobre cómo consultar las API de Foundation Model.

- Vea Referencia de la API REST de modelo de Foundation para conocer los parámetros y la sintaxis necesarios.

API de modelos fundacionales de rendimiento aprovisionado

El rendimiento aprovisionado está disponible con carácter general y Databricks recomienda el rendimiento aprovisionado para cargas de trabajo de producción. El rendimiento aprovisionado proporciona puntos de conexión con inferencia optimizada para cargas de trabajo del modelo de base que requieren garantías de rendimiento. Consulte API de modelo Foundation de rendimiento aprovisionado para obtener instrucciones paso a paso sobre cómo implementar las API de Foundation Model en el modo aprovisionado a lo largo del modo.

La compatibilidad con el rendimiento aprovisionado incluye:

- Modelos base de todos los tamaños, como DBRX Base. A los modelos base se puede acceder mediante Databricks Marketplace, o bien se pueden descargar desde Hugging Face, o desde cualquier otro origen externo, y registrarlos en Unity Catalog. Este último enfoque funciona con cualquier variante ajustada de los modelos admitidos, independientemente del método de ajuste preciso empleado.

- Variantes optimizadas de modelos base, como LlamaGuard-7B. Esto incluye modelos que están optimizados en datos bajo propiedad.

- Ponderaciones y tokenizadores totalmente personalizados, como los entrenados desde cero o entrenados previamente o otras variaciones mediante la arquitectura del modelo base (como CodeLlama, Yi-34B-Chat o SOLAR-10.7B).

En la tabla siguiente se resumen las arquitecturas de modelo admitidas para el rendimiento aprovisionado.

| Arquitectura del modelo | Tipos de tarea | Notas |

|---|---|---|

| DBRX | Chat o Completion | Vea los límites de la API de Foundation Model para obtener disponibilidad regional. |

| Meta Llama 3 | Chat o Completion | |

| Meta Llama 2 | Chat o Completion | |

| Mistral | Chat o Completion | |

| Mixtral | Chat o Completion | |

| MPT | Chat o Completion | |

| BGE v1.5 (inglés) | Embedding |

Limitaciones

Consulte límites de servicio de modelos y regiones.