Cursos

Módulo

Introducción al flujo de avisos para desarrollar aplicaciones de modelo de lenguaje grande (LLM).

Este explorador ya no se admite.

Actualice a Microsoft Edge para aprovechar las características y actualizaciones de seguridad más recientes, y disponer de soporte técnico.

Crear un buen aviso es una tarea difícil que requiere mucha creatividad, claridad y relevancia. Una buena solicitud puede obtener el resultado deseado de un modelo de lenguaje previamente entrenado, mientras que una mala solicitud puede conducir a resultados inexactos, irrelevantes o sin sentido. Por lo tanto, es necesario ajustar las solicitudes para optimizar su rendimiento y solidez en diferentes tareas y dominios.

Por ello, introducimos el concepto de variantes que puede ayudarte a probar el comportamiento del modelo bajo diferentes condiciones, como diferentes palabras, formatos, contextos, temperaturas o top-k, comparar y encontrar la mejor solicitud y configuración que maximice la precisión, diversidad o coherencia del modelo.

En este artículo, le mostraremos cómo utilizar las variantes para ajustar las instrucciones y evaluar el rendimiento de las diferentes variantes.

Antes de leer este artículo, es mejor que consulte:

En este artículo, utilizaremos Clasificación Web como ejemplo.

Abra el flujo de ejemplo y elimine el nodo prepare_examples para empezar.

Utilice la siguiente consulta como consulta de referencia en el nodo classify_with_llm.

Your task is to classify a given url into one of the following types:

Movie, App, Academic, Channel, Profile, PDF or None based on the text content information.

The classification will be based on the url, the webpage text content summary, or both.

For a given URL : {{url}}, and text content: {{text_content}}.

Classify above url to complete the category and indicate evidence.

The output shoule be in this format: {"category": "App", "evidence": "Both"}

OUTPUT:

Para optimizar este flujo, puede haber múltiples formas, y a continuación se indican dos direcciones:

Para el nodo classify_with_llm: He aprendido de la comunidad y los documentos que una temperatura más baja da una mayor precisión, pero menos creatividad y sorpresa, por lo que una temperatura más baja es adecuada para las tareas de clasificación y también pocos disparos puede aumentar el rendimiento LLM. Por lo tanto, me gustaría probar cómo se comporta mi flujo cuando la temperatura se cambia de 1 a 0, y cuando el aviso es con pocos ejemplos.

Para summarize_text_content nodo: También quiero probar el comportamiento de mi flujo cuando cambio resumen de 100 palabras a 300, para ver si más contenido de texto puede ayudar a mejorar el rendimiento.

Para clasificar_con_llm nodo, basado en la variante_0:

Your task is to classify a given url into one of the following types:

Movie, App, Academic, Channel, Profile, PDF or None based on the text content information.

The classification will be based on the url, the webpage text content summary, or both.

Here are a few examples:

URL: https://play.google.com/store/apps/details?id=com.spotify.music

Text content: Spotify is a free music and podcast streaming app with millions of songs, albums, and original podcasts. It also offers audiobooks, so users can enjoy thousands of stories. It has a variety of features such as creating and sharing music playlists, discovering new music, and listening to popular and exclusive podcasts. It also has a Premium subscription option which allows users to download and listen offline, and access ad-free music. It is available on all devices and has a variety of genres and artists to choose from.

OUTPUT: {"category": "App", "evidence": "Both"}

URL: https://www.youtube.com/channel/UC_x5XG1OV2P6uZZ5FSM9Ttw

Text content: NFL Sunday Ticket is a service offered by Google LLC that allows users to watch NFL games on YouTube. It is available in 2023 and is subject to the terms and privacy policy of Google LLC. It is also subject to YouTube's terms of use and any applicable laws.

OUTPUT: {"category": "Channel", "evidence": "URL"}

URL: https://arxiv.org/abs/2303.04671

Text content: Visual ChatGPT is a system that enables users to interact with ChatGPT by sending and receiving not only languages but also images, providing complex visual questions or visual editing instructions, and providing feedback and asking for corrected results. It incorporates different Visual Foundation Models and is publicly available. Experiments show that Visual ChatGPT opens the door to investigating the visual roles of ChatGPT with the help of Visual Foundation Models.

OUTPUT: {"category": "Academic", "evidence": "Text content"}

URL: https://ab.politiaromana.ro/

Text content: There is no content available for this text.

OUTPUT: {"category": "None", "evidence": "None"}

For a given URL : {{url}}, and text content: {{text_content}}.

Classify above url to complete the category and indicate evidence.

OUTPUT:

Para el nodo summarize_text_content, basado en variant_0, puede crear variant_1 donde 100 words se cambia a 300 palabras en prompt.

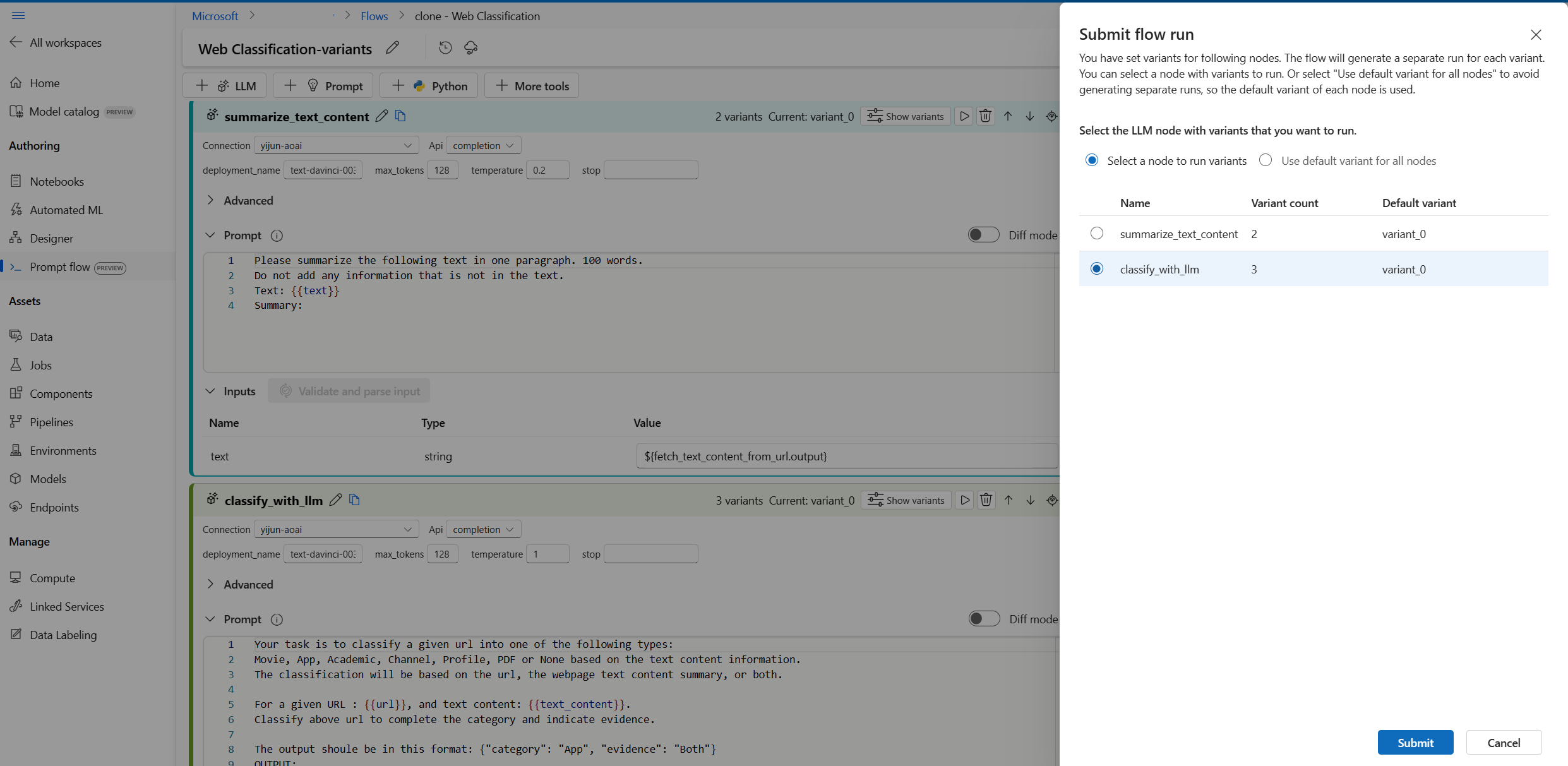

Ahora, el flujo tiene el siguiente aspecto, 2 variantes para el nodo summarize_text_content y 3 para el nodo classify_with_llm.

Para asegurarse de que todas las variantes pueden ejecutarse correctamente y funcionan como se espera, puede ejecutar el flujo con una única fila de datos para probarlo.

Nota

Cada vez puede seleccionar solo un nodo LLM con variantes para ejecutar mientras que otros nodos LLM utilizarán la variante predeterminada.

En este ejemplo, configuramos variantes tanto para el nodo summarize_text_content como para el nodo classify_with_llm, por lo que tendrá que ejecutar dos veces para probar todas las variantes.

Cuando ejecuta las variantes con unos pocos datos y comprueba los resultados a simple vista, no puede reflejar la complejidad y diversidad de los datos del mundo real, mientras que el resultado no es medible, por lo que es difícil comparar la eficacia de las diferentes variantes y elegir la mejor.

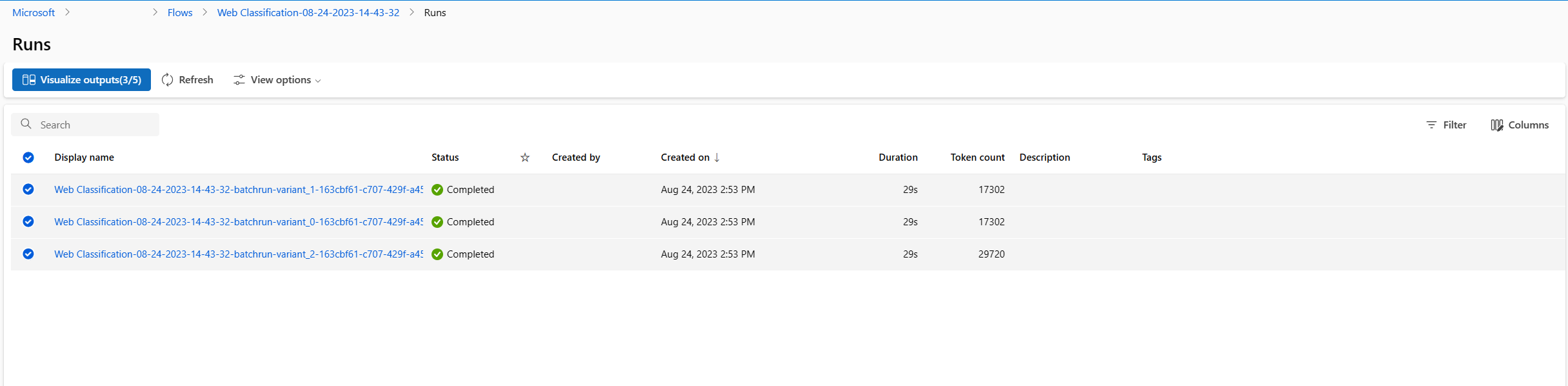

Puede enviar una ejecución por lotes, que le permite probar las variantes con una gran cantidad de datos y evaluarlas con métricas, para ayudarle a encontrar la más adecuada.

Primero necesita preparar un conjunto de datos, que sea lo suficientemente representativo del problema del mundo real que quiere resolver con el flujo de avisos. En este ejemplo, se trata de una lista de URL y su clasificación real. Utilizaremos la precisión para evaluar el rendimiento de las variantes.

Seleccione Evaluar en la parte superior derecha de la página.

Aparece un asistente para Ejecutar por lotes y evaluar. El primer paso es seleccionar un nodo para ejecutar todas sus variantes.

Para comprobar lo bien que funcionan las distintas variantes en cada nodo de un flujo, es necesario realizar una ejecución por lotes para cada nodo con las variantes una a una. Esto le ayuda a evitar la influencia de las variantes de otros nodos y a centrarse en los resultados de las variantes de este nodo. Esto sigue la regla del experimento controlado, que significa que solo cambia una cosa cada vez y mantiene todo lo demás igual.

Por ejemplo, puede seleccionar el nodo classify_with_llm para ejecutar todas las variantes; el nodo summarize_text_content utilizará su variante predeterminada para esta ejecución por lotes.

A continuación, en Configuración de la ejecución por lotes, puede establecer el nombre de la ejecución por lotes, elegir un tiempo de ejecución y cargar los datos preparados.

A continuación, en Configuración de la evaluación, seleccione un método de evaluación.

Dado que este flujo es para clasificación, puede seleccionar el método Evaluación de la precisión de la clasificación para evaluar la precisión.

La precisión se calcula mediante la comparación de las etiquetas predichas asignadas por el flujo (predicción) con las etiquetas reales de los datos (verdad básica) y contando cuántas de ellas coinciden.

En la sección Asignación de entrada de evaluación, debe especificar que la verdad básica procede de la columna de categoría del conjunto de datos de entrada, y que la predicción procede de una de las salidas del flujo: categoría.

Después de revisar todas las configuraciones, puede enviar la ejecución por lotes.

Una vez enviada la ejecución, seleccione el enlace y vaya a la página de detalles de la ejecución.

Nota

La ejecución puede tardar varios minutos en completarse.

Ahora, ha terminado el proceso de ajuste de solicitudes mediante variantes. Puede aplicar esta técnica a su propio flujo de avisos a fin de encontrar la mejor variante para el nodo LLM.

Cursos

Módulo

Introducción al flujo de avisos para desarrollar aplicaciones de modelo de lenguaje grande (LLM).

Documentación

Desarrollo del flujo de avisos - Azure Machine Learning

Obtenga información sobre cómo desarrollar un flujo de avisos y un flujo de chat en el Estudio de Azure Machine Learning.

Integración de LangChain en flujos de avisos - Azure Machine Learning

Aprenda a integrar LangChain en los flujos de avisos de Estudio de Azure Machine Learning.

Ecosistema del flujo de avisos - Azure Machine Learning

Introducción al ecosistema de flujo de avisos, que incluye el proyecto de código abierto de flujo de avisos, tutoriales, el SDK, la CLI y la extensión de VS Code.