Abrir la herramienta LLM de modelo

La herramienta Open Model LLM permite el uso de varios modelos abiertos y modelos fundamentales, como Falcon y Llama 2, para el procesamiento de lenguaje natural en el flujo de mensajes de Azure Machine Learning.

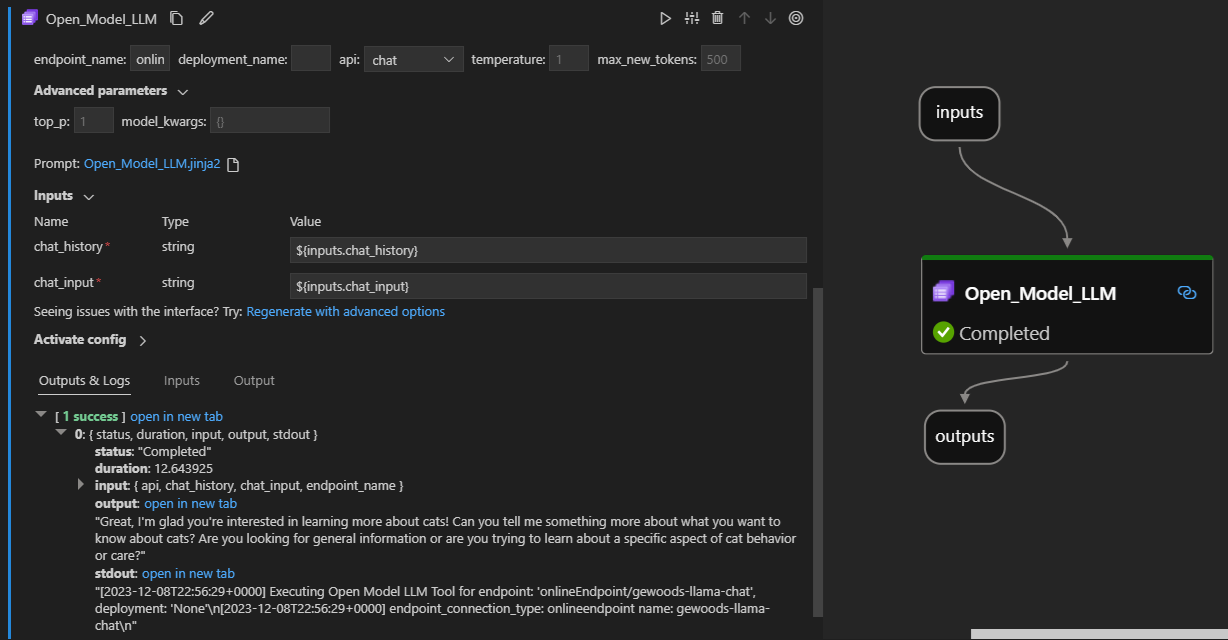

Así es como se ve en acción en la extensión del flujo de avisos de Visual Studio Code. En este ejemplo, la herramienta se usa para llamar a un punto de conexión de chat de LlaMa-2 y preguntar "¿Qué es CI?".

Esta herramienta de flujo de mensajes admite dos tipos de API LLM diferentes:

- Chat: se muestra en el ejemplo anterior. El tipo de API de Chat facilita conversaciones interactivas con entradas y respuestas basadas en texto.

- Completion: el tipo de API Completion se usa para generar finalizaciones de texto de respuesta única en función de la entrada del aviso proporcionado.

Información general rápida: Cómo usar la herramienta Open Model LLM?

- Elija un modelo en el catálogo de modelos de Azure Machine Learning y insítelo.

- Conectar a la implementación del modelo.

- Configure los valores de la herramienta llm del modelo abierto.

- Preparación del aviso.

- Ejecute el flujo.

Requisitos previos: Implementación del modelo

- Elija el modelo que coincida con el escenario del catálogo de modelos de Azure Machine Learning.

- Use el botón Implementar para implementar el modelo en un punto de conexión de inferencia en línea de Azure Machine Learning.

- Use una de las opciones de implementación De pago por uso.

Para más información, consulte Implementación de modelos básicos en puntos de conexión para la inferencia.

Requisitos previos: Conectar al modelo

Para que el flujo de solicitud use el modelo implementado, debe conectarse a él. Hay dos maneras de conectarse.

Conexiones de punto de conexión

Una vez asociado el flujo a un área de trabajo de Azure Machine Learning o Azure AI Studio, la herramienta Open Model LLM puede usar los puntos de conexión de esa área de trabajo.

Uso de áreas de trabajo de Azure Machine Learning o Azure AI Studio: si usa el flujo de solicitud en una de las áreas de trabajo de exploradores basadas en páginas web, los puntos de conexión en línea disponibles en esa área de trabajo que se activan automáticamente.

Uso primero de VS Code o código: si usa el flujo de mensajes en VS Code o una de las ofertas de Code First, debe conectarse al área de trabajo. La herramienta Open Model LLM usa el cliente azure.identity DefaultAzureCredential para la autorización. Una manera es establecer valores de credenciales de entorno.

Conexiones personalizadas

La herramienta Open Model LLM usa custom Conectar ion. El flujo de mensajes admite dos tipos de conexiones:

Conexiones del área de trabajo: Conectar ions que se almacenan como secretos en un área de trabajo de Azure Machine Learning. Aunque estas conexiones se pueden usar, en muchos lugares, normalmente se crean y mantienen en la interfaz de usuario de Studio. Para obtener información sobre cómo crear una conexión personalizada en la interfaz de usuario de Studio, consulte cómo crear una conexión personalizada.

Conexiones locales: Conectar ions que se almacenan localmente en el equipo. Estas conexiones no están disponibles en la experiencia del usuario de Studio, pero se pueden usar con la extensión de VS Code. Para obtener información sobre cómo crear una Conectar ion personalizada local, consulte cómo crear una conexión local.

Las claves necesarias para establecer son:

- endpoint_url

- Este valor se puede encontrar en el punto de conexión de inferencia creado anteriormente.

- endpoint_api_key

- Asegúrese de establecerlo como un valor secreto.

- Este valor se puede encontrar en el punto de conexión de inferencia creado anteriormente.

- model_family

- Valores admitidos: LLAMA, DOLLY, GPT2 o FALCON

- Este valor depende del tipo de implementación de destino.

Ejecución de la herramienta: Entradas

La herramienta Open Model LLM tiene muchos parámetros, algunos de los cuales son necesarios. Consulte la tabla siguiente para obtener más información, puede hacer coincidir estos parámetros con la captura de pantalla anterior para mayor claridad visual.

| Nombre | Escribir | Descripción | Obligatorio |

|---|---|---|---|

| api | string | Modo de API que depende del modelo usado y del escenario seleccionado. Valores admitidos: (Completion | Chat) | Sí |

| endpoint_name | string | Nombre de un punto de conexión de inferencia en línea con un modelo admitido implementado en él. Tiene prioridad sobre la conexión. | Sí |

| temperatura | FLOAT | La aleatoriedad del texto generado. El valor predeterminado es 1. | No |

| max_new_tokens | integer | El número máximo de tokens a generar en la finalización. El valor predeterminado es 500. | No |

| top_p | FLOAT | Probabilidad de usar la opción superior de los tokens generados. El valor predeterminado es 1. | No |

| model_kwargs | diccionario | Esta entrada se usa para proporcionar la configuración específica del modelo usado. Por ejemplo, el modelo Llama-02 puede usar {"temperature":0.4}. Valor predeterminado{}: | No |

| deployment_name | cadena | Nombre de la implementación que se va a usar en el punto de conexión de inferencia en línea. Si no se pasa ningún valor, se usa la configuración de tráfico del equilibrador de carga de inferencia. | No |

| símbolo del sistema | cadena | Mensaje de texto que usa el modelo de lenguaje para generar su respuesta. | Sí |

Salidas

| API | Tipo de valor devuelto | Descripción |

|---|---|---|

| Completion | cadena | Texto de una finalización prevista |

| Chat | cadena | Texto de una respuesta de la conversación. |

Implementación en un punto de conexión en línea

Al implementar un flujo que contiene la herramienta Open Model LLM en un punto de conexión en línea, hay un paso adicional para configurar los permisos. Durante la implementación a través de las páginas web, hay una opción entre los tipos de identidad asignados por el sistema y asignados por el usuario. En cualquier caso, mediante Azure Portal (o una funcionalidad similar), agregue el rol de función de trabajo "Lector" a la identidad en el área de trabajo de Azure Machine Learning o en el proyecto de Ai Studio, que hospeda el punto de conexión. Es posible que sea necesario actualizar la implementación del flujo de solicitud.

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente GitHub Issues como mecanismo de comentarios sobre el contenido y lo sustituiremos por un nuevo sistema de comentarios. Para más información, vea: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de