Captura de datos de Event Hubs en formato Parquet

En este artículo se explica cómo usar el editor de no código para capturar automáticamente datos de streaming en Event Hubs en una cuenta de Azure Data Lake Storage Gen2 en formato Parquet.

Requisitos previos

Un espacio de nombres de Azure Event Hubs con un centro de eventos y una cuenta de Azure Data Lake Storage Gen2 con un contenedor para almacenar los datos capturados. Estos recursos deben ser accesibles públicamente y no puede estar detrás de un firewall o protegidos en una red virtual de Azure.

Si no tiene un centro de eventos, cree uno siguiendo las instrucciones de Inicio rápido: Creación de un centro de eventos.

Si no tiene una cuenta de Data Lake Storage Gen2, cree una siguiendo las instrucciones de Creación de una cuenta de almacenamiento

Los datos de Event Hubs deben serializarse en formato JSON, CSV o Avro. Para fines de prueba, seleccione Generar datos (versión preliminar) en el menú de la izquierda, seleccione Datos de acciones para el conjunto de datos y, a continuación, seleccione Enviar.

Configuración de un trabajo para capturar datos

Siga estos pasos para configurar un trabajo de Stream Analytics para capturar datos en Azure Data Lake Storage Gen2.

En Azure Portal, vaya al centro de eventos.

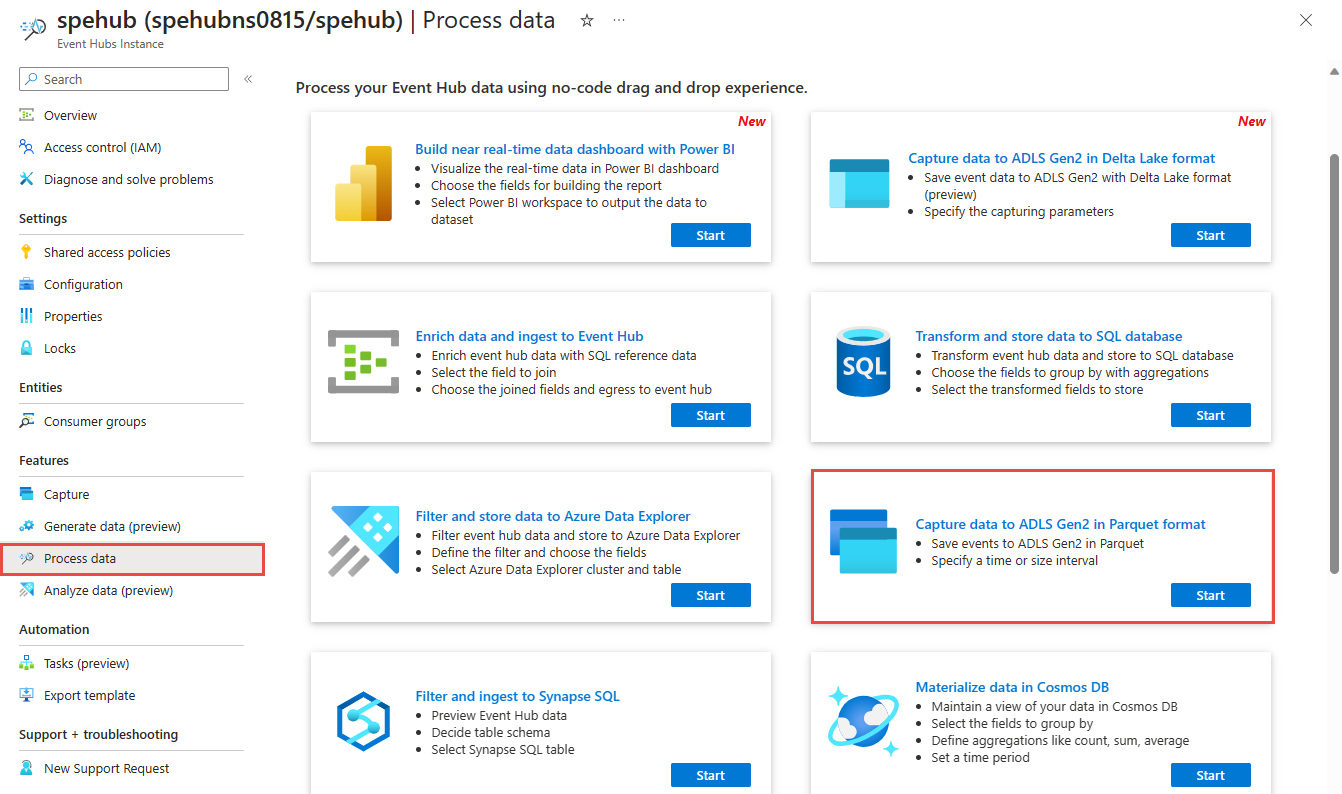

En el menú de la izquierda, seleccione Procesar datos en Características. A continuación, seleccione Iniciar en la tarjeta Capturar datos a ADLS Gen2 en formato Parquet.

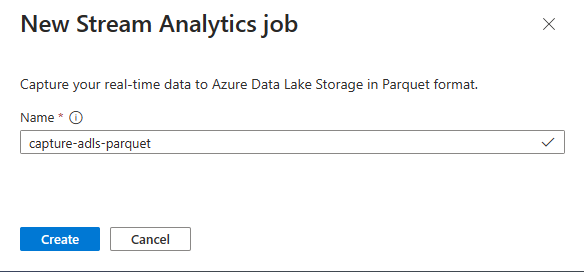

Escriba un nombre para el trabajo de Stream Analytics y, a continuación, seleccione Crear.

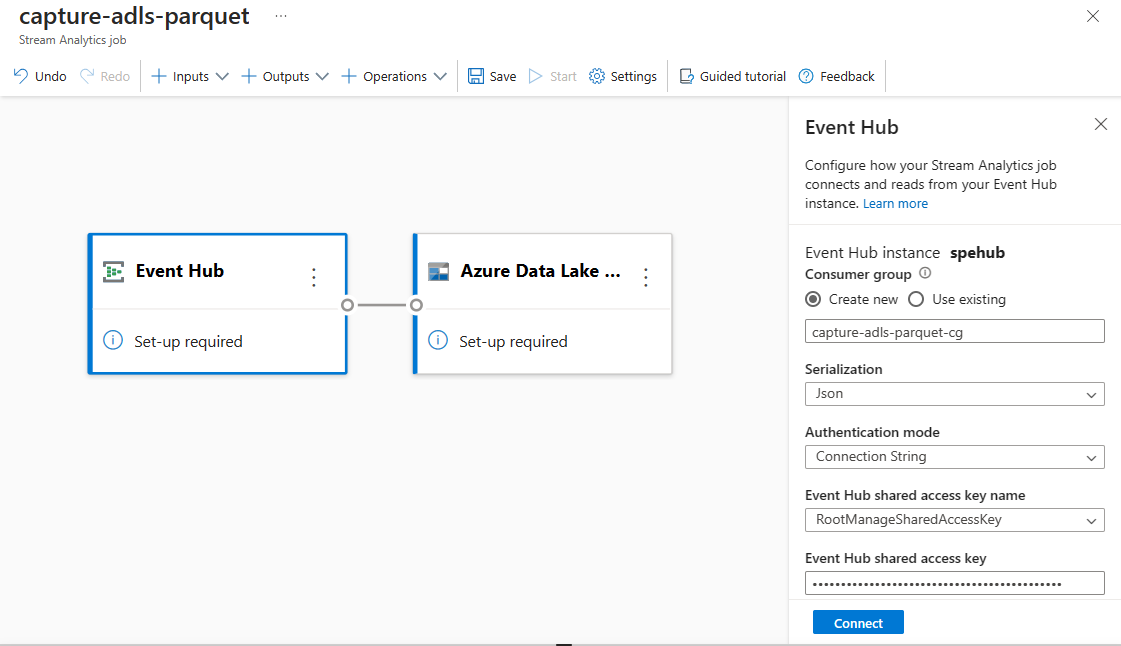

Especifique el tipo de Serialización de los datos en Event Hubs y el Método de autenticación que usa el trabajo para conectarse a Event Hubs. A continuación, seleccione Conectar.

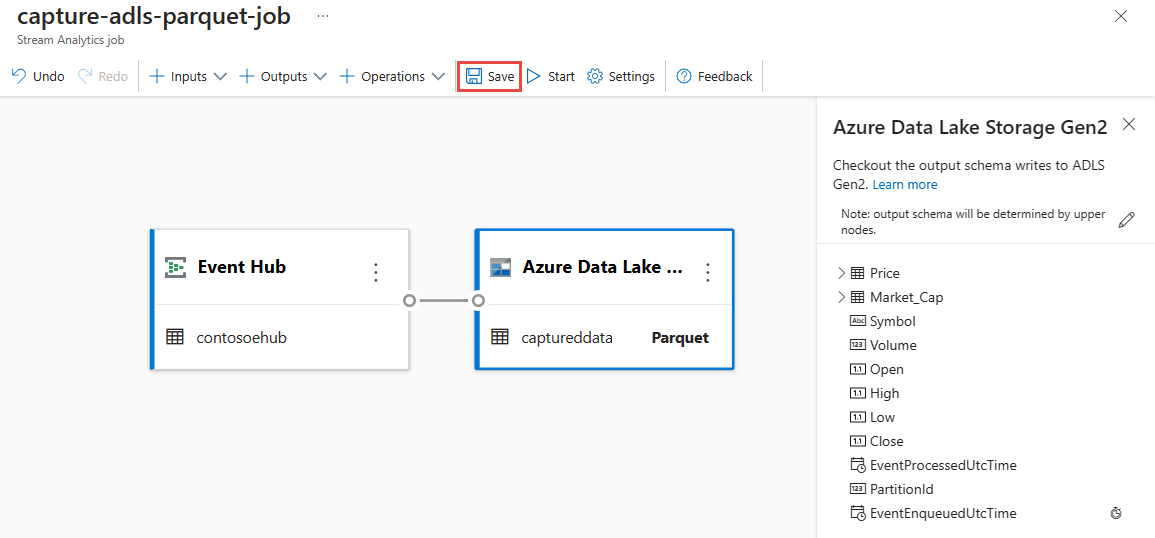

Cuando la conexión se establezca correctamente, verá lo siguiente:

Campos que están presentes en los datos de entrada. Puede elegir Agregar campo o puede seleccionar el símbolo de los tres puntos junto a un campo para, opcionalmente, eliminar, renombrar o cambiar su nombre.

Ejemplo dinámico de datos entrantes en la tabla de Vista previa de los datos en la vista de diagrama. Se actualiza periódicamente. Puede seleccionar Pausar la versión preliminar del streaming para ver una vista estática de la entrada de la muestra.

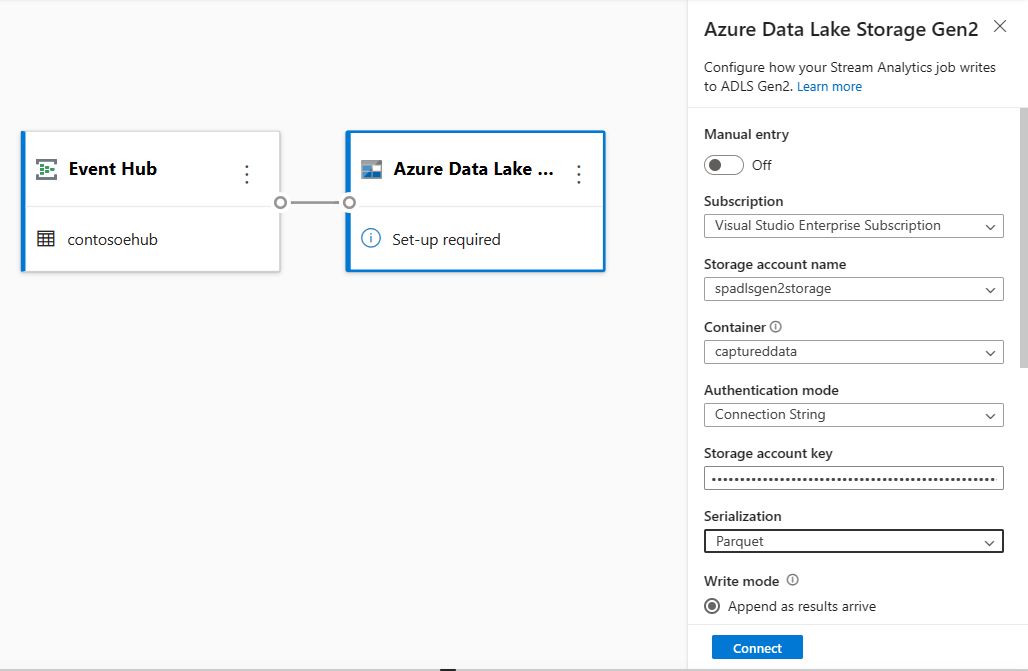

Seleccione el mosaico Azure Data Lake Storage Gen2 para editar la configuración.

En la página de configuración de Azure Data Lake Storage Gen2, siga estos pasos:

Seleccione la suscripción, el nombre de la cuenta de almacenamiento y el contenedor en el menú desplegable.

Una vez seleccionada la suscripción, el método de autenticación y la clave de la cuenta de almacenamiento deberían rellenarse automáticamente.

Seleccione Parquet en el formato de serialización.

En el caso de los blobs de streaming, se espera que el patrón de ruta de acceso del directorio sea un valor dinámico. Es necesario para que la fecha forme parte de la ruta de acceso de archivo del blob, a la que se hace referencia como

{date}. Para más información sobre los patrones de ruta de acceso personalizados, consulte Creación de particiones de salida de blobs personalizados de Azure Stream Analytics.Seleccione Conectar.

Cuando se establezca la conexión, verá los campos que están presentes en los datos de salida.

Seleccione Guardar en la barra de comandos para guardar la configuración.

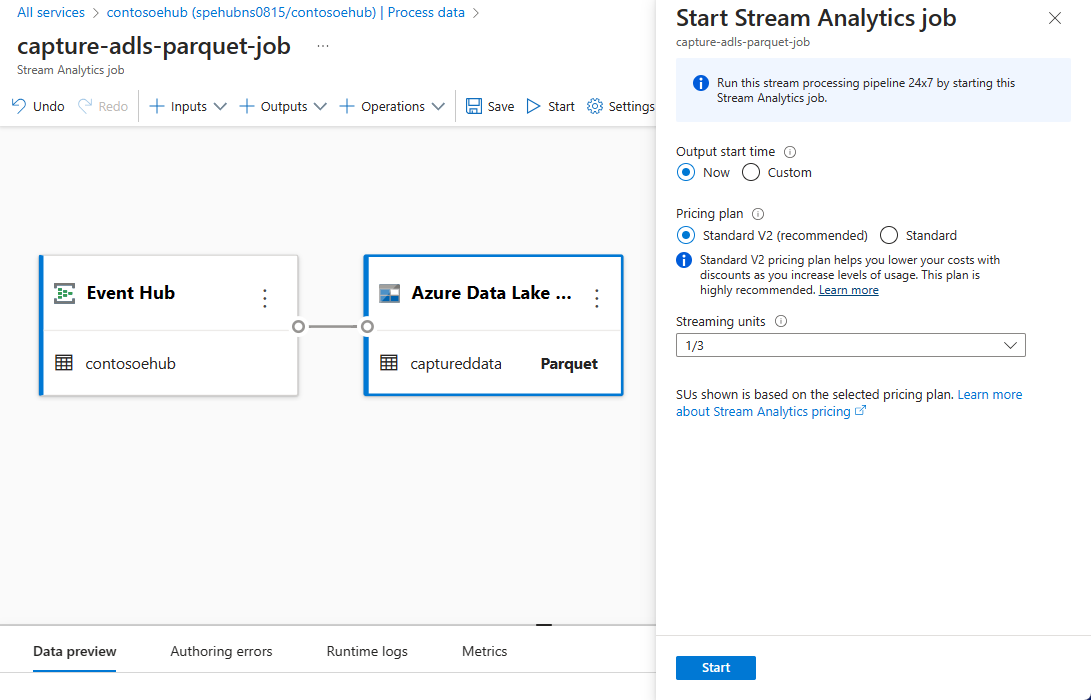

Seleccione Iniciar en la barra de comandos para iniciar el flujo de streaming y capturar datos. A continuación, en la ventana Iniciar trabajo de Stream Analytics:

Seleccione la hora de inicio de la salida.

Seleccione el plan de precios.

Seleccione el número de Unidades de streaming (SU) con las que se ejecuta el trabajo. Las unidades de streaming representan los recursos informáticos que se asignan para ejecutar un trabajo de Stream Analytics. Para más información, consulte Unidades de streaming en Azure Stream Analytics.

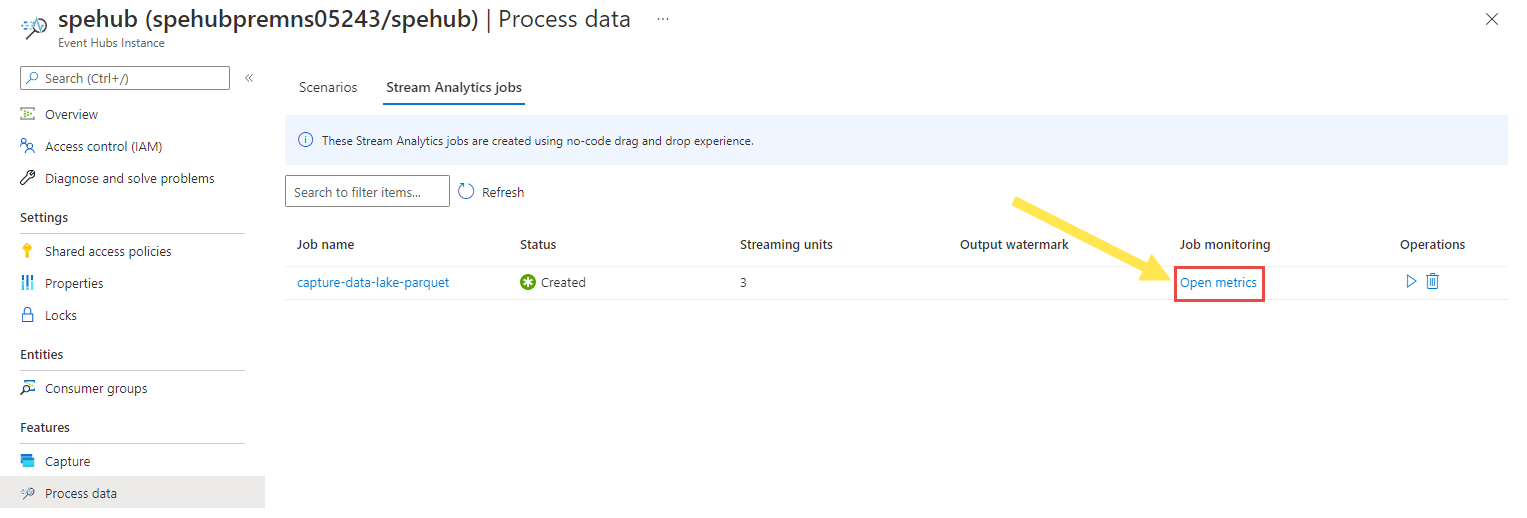

Debería ver el trabajo de Stream Analytics en la pestaña Trabajo de Stream Analytics de la página Procesar datos del centro de eventos.

Comprobar salida

En la página Instancia de Event Hubs, seleccione Generar datos, seleccione Datos de inventario para el conjunto de datos y, a continuación, seleccione Enviar para enviar algunos datos de muestra al centro de eventos.

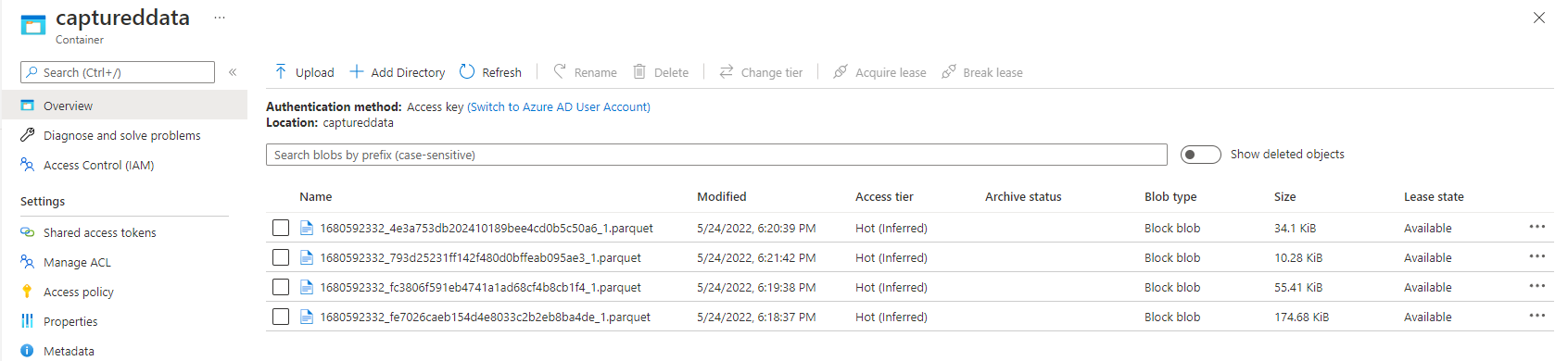

Compruebe que los archivos Parquet se han generado en el contenedor de Azure Data Lake Storage.

Seleccione Procesar datos en el menú de la izquierda. Cambie a la pestaña Trabajos de Stream Analytics. Seleccione Abrir métricas para supervisarlo.

Esta es una captura de pantalla de ejemplo de las métricas que muestran los eventos de entrada y salida.

Pasos siguientes

Ahora sabe cómo usar el editor de código de Stream Analytics para crear un trabajo que capture los datos de Event Hubs para Azure Data Lake Storage Gen2 en formato Parquet. A continuación, puede obtener más información sobre Azure Stream Analytics y cómo supervisar el trabajo que ha creado.