Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

En este artículo se describe cómo puede usar el editor sin código para crear fácilmente un trabajo de Stream Analytics. Lee continuamente desde Event Hubs, filtra los datos entrantes y, a continuación, escribe los resultados continuamente en Azure Data Lake Storage Gen2.

Requisitos previos

- Los recursos de Azure Event Hubs deben ser accesibles públicamente y no estar detrás de un firewall o protegidos en una instancia de Azure Virtual Network.

- Los datos de Event Hubs deben serializarse en formato JSON, CSV o Avro.

Desarrollo de un trabajo de Stream Analytics para filtrar e ingerir datos en tiempo real

En Azure Portal, busque y seleccione la instancia de Azure Event Hubs.

Seleccione Características>Procesar datos y, a continuación, seleccione Iniciar en la tarjeta Filter and ingest to ADLS Gen2 (Filtrar e ingerir en ADLS Gen2).

Escriba un nombre para el trabajo de Stream Analytics y seleccione Crear.

Especifique el tipo de serialización de los datos en la ventana de Event Hubs y el Método de autenticación que usará el trabajo para conectarse a Event Hubs. A continuación, seleccione Conectar.

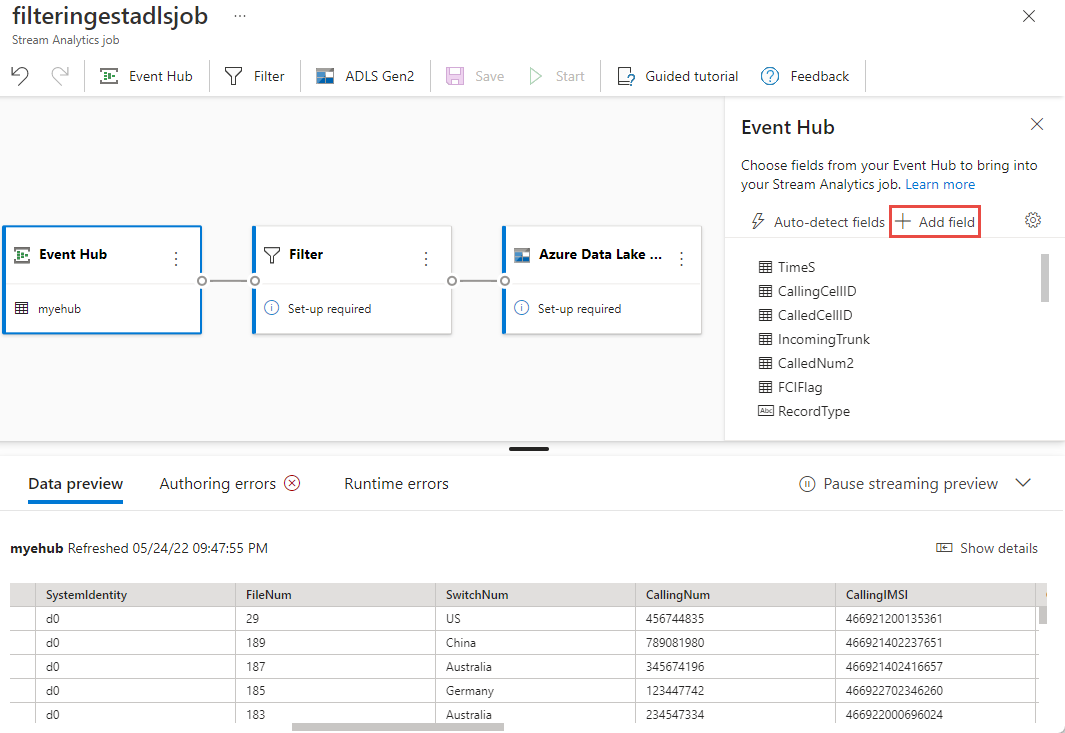

Si la conexión se establece correctamente y tiene flujos de datos que fluyen a la instancia de Event Hubs, verá inmediatamente dos cosas:

- Campos que están presentes en los datos de entrada. Puede elegir Agregar campo o seleccionar el símbolo de puntos suspensivos junto a cada campo para quitar, cambiar el nombre o cambiar su tipo.

- Ejemplo dinámico de datos entrantes en la tabla Vista previa de los datos en la vista de diagrama. Se actualiza automáticamente de manera periódica. Puede seleccionar Pause streaming preview (Pausar vista previa de streaming) para ver una vista estática de los datos de entrada de ejemplo.

- Campos que están presentes en los datos de entrada. Puede elegir Agregar campo o seleccionar el símbolo de puntos suspensivos junto a cada campo para quitar, cambiar el nombre o cambiar su tipo.

Seleccione el icono de Filtro. En el área Filtro, seleccione un campo para filtrar los datos entrantes con una condición.

Selección del icono Azure Data Lake Storage Gen2. Seleccione la cuenta de Azure Data Lake Gen2 para enviar los datos filtrados:

- Seleccione la suscripción, el nombre de la cuenta de almacenamiento y el contenedor en el menú desplegable.

- Una vez seleccionada la suscripción, el método de autenticación y la clave de la cuenta de almacenamiento se rellenarán automáticamente. Seleccione Conectar.

Para obtener más información sobre los campos y ver ejemplos de patrones de ruta de acceso, consulte Salida de Blob Storage y Azure Data Lake Gen2 de Azure Stream Analytics.

Opcionalmente, seleccione Get static preview/Refresh static preview (Obtener vista previa estática o Actualizar vista previa estática) para ver la vista previa de datos que se ingerirá desde Azure Data Lake Storage Gen2.

Seleccione Guardar y, a continuación, seleccione Iniciar para iniciar el trabajo de Stream Analytics.

Para iniciar el trabajo, especifique el número de Unidades de streaming (SU) con las que se ejecuta el trabajo. Las SU representan la cantidad de procesos y memoria asignadas al trabajo. Se recomienda empezar con tres y, a continuación, ajustar la cantidad según sea necesario.

Después de seleccionar Iniciar, el trabajo comienza a ejecutarse en un máximo de dos minutos y las métricas se abrirán en la sección de pestañas siguiente.

Puede ver el trabajo en la sección Datos del proceso en la pestaña Trabajos de Stream Analytics. Seleccione Actualizar hasta que vea el estado del trabajo como En ejecución. Seleccione Abrir métricas para supervisarlo, detenerlo o reiniciarlo, según sea necesario.

Esta es una página de métricas de ejemplo:

Comprobación de datos en Data Lake Storage

Debería ver los archivos creados en el contenedor que especificó.

Descargue y abra el archivo para confirmar que solo ve los datos filtrados. En el ejemplo siguiente, verá los datos con SwitchNum establecido en EE. UU.

{"RecordType":"MO","SystemIdentity":"d0","FileNum":"548","SwitchNum":"US","CallingNum":"345697969","CallingIMSI":"466921402416657","CalledNum":"012332886","CalledIMSI":"466923101048691","DateS":"20220524","TimeType":0,"CallPeriod":0,"ServiceType":"S","Transfer":0,"OutgoingTrunk":"419","MSRN":"1416960750071","callrecTime":"2022-05-25T02:07:10Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:09.5140000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"552","SwitchNum":"US","CallingNum":"012351287","CallingIMSI":"262021390056324","CalledNum":"012301973","CalledIMSI":"466922202613463","DateS":"20220524","TimeType":3,"CallPeriod":0,"ServiceType":"V","Transfer":0,"OutgoingTrunk":"442","MSRN":"886932428242","callrecTime":"2022-05-25T02:07:13Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:12.7350000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"559","SwitchNum":"US","CallingNum":"456757102","CallingIMSI":"466920401237309","CalledNum":"345617823","CalledIMSI":"466923000886460","DateS":"20220524","TimeType":1,"CallPeriod":696,"ServiceType":"V","Transfer":1,"OutgoingTrunk":"419","MSRN":"886932429155","callrecTime":"2022-05-25T02:07:22Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:21.9190000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null}

Consideraciones al usar la característica de replicación geográfica de Event Hubs

Azure Event Hubs lanzó recientemente la característica Replicación geográfica en versión preliminar pública. Esta característica es diferente de la característica de Recuperación ante desastres geográfica de Azure Event Hubs.

Cuando el tipo de conmutación por error es Forzado y la coherencia de la replicación es Asincrónica, el trabajo de Stream Analytics no garantiza exactamente una salida una vez en una salida de Azure Event Hubs.

Azure Stream Analytics, como productor con un centro de eventos una salida, podría observar el retraso de la marca de agua en el trabajo durante la duración de la conmutación por error y durante la limitación por Event Hubs en caso de que el retraso de replicación entre principal y secundario alcance el retraso máximo configurado.

Azure Stream Analytics, como consumidor con Event Hubs como entrada, puede observar el retraso de la marca de agua en el trabajo durante la duración de la conmutación por error y podría omitir los datos o buscar datos duplicados una vez completada la conmutación por error.

Debido a estas advertencias, se recomienda reiniciar el trabajo de Stream Analytics con la hora de inicio adecuada justo después de que se complete la conmutación por error de Event Hubs. Además, dado que la característica de replicación geográfica de Event Hubs está en versión preliminar pública, no se recomienda usar este patrón para trabajos de producción de Stream Analytics en este momento. El comportamiento actual de Stream Analytics mejorará antes de que la característica de replicación geográfica de Event Hubs esté disponible con carácter general y se pueda usar en trabajos de producción de Stream Analytics.

Pasos siguientes

Obtenga más información sobre Azure Stream Analytics y cómo supervisar el trabajo que ha creado.