Tutorial: Escritura en una tabla Delta almacenada en Azure Data Lake Storage Gen2

En este tutorial se muestra cómo puede crear un trabajo de Stream Analytics para escribir en una tabla Delta de Azure Data Lake Storage Gen2. En este tutorial, aprenderá a:

- Implementar un generador de eventos que envía datos de ejemplo al centro de eventos

- Creación de un trabajo de Stream Analytics

- Configurar Azure Data Lake Storage Gen2 con una tabla delta

- Ejecución del trabajo de Stream Analytics

Requisitos previos

Antes de empezar, complete los pasos siguientes:

- Si no tiene una suscripción a Azure, cree una cuenta gratuita.

- Implemente el generador de eventos de TollApp en Azure, use este vínculo para implementar la plantilla de TollApp de Azure. Establezca el parámetro "interval" en 1. Cree y use un nuevo grupo de recursos para este paso.

- Cree una cuenta de Data Lake Storage Gen2.

Creación de un trabajo de Stream Analytics

Inicie sesión en Azure Portal.

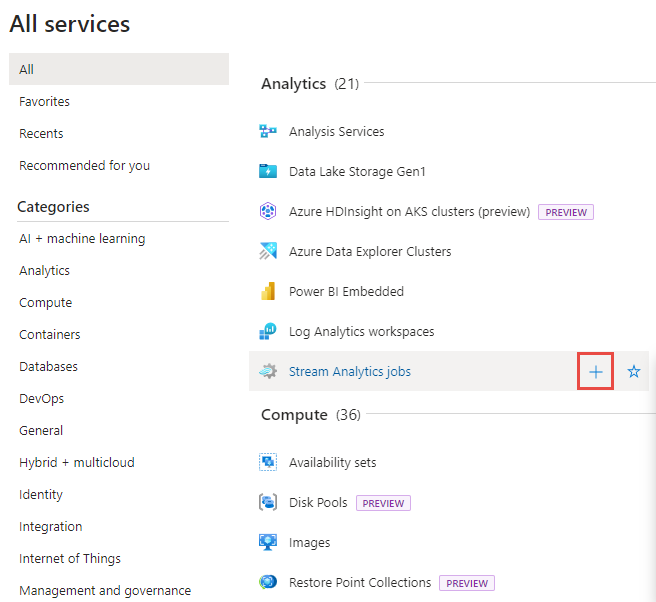

Seleccione Todos los servicios en el menú de la izquierda.

Mueva el mouse sobre Trabajos de Stream Analytics en la sección Analytics y seleccione + (más).

Haga clic en Crear un recurso en la esquina superior izquierda de Azure Portal.

Seleccione Analytics>Trabajo de Stream Analytics en la lista de resultados.

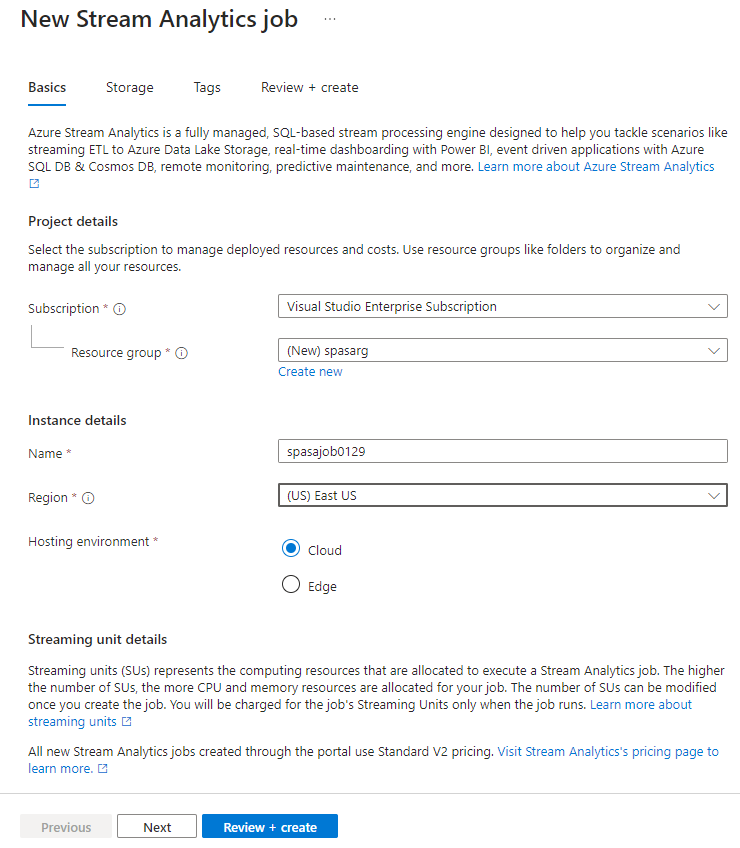

En la página Nuevo trabajo de Stream Analytics, siga estos pasos:

- En Suscripción, seleccione su suscripción de Azure.

- En Grupo de recursos, seleccione el mismo recurso que usó anteriormente en la implementación de TollApp.

- En Nombre, escriba un nombre para el trabajo. Debe tener una longitud de entre 3 y 63 caracteres, y solo puede incluir caracteres alfanuméricos, guiones y guiones bajos.

- En Entorno de hospedaje, confirme que la opción Nube está seleccionada.

- En Unidades de streaming, seleccione 1. Las unidades de streaming representan los recursos informáticos que se necesitan para ejecutar un trabajo. Para información sobre el escalado de unidades de streaming, consulte el artículo Descripción y ajuste de las unidades de streaming.

En la parte inferior de la página, seleccione Revisar y crear.

En la página Revisar y crear, revise la configuración y seleccione Crear para crear una página de Stream Analytics.

En la página de implementación, seleccione Ir al recurso para ir a la página Trabajo de Stream Analytics.

Configuración de la entrada del trabajo

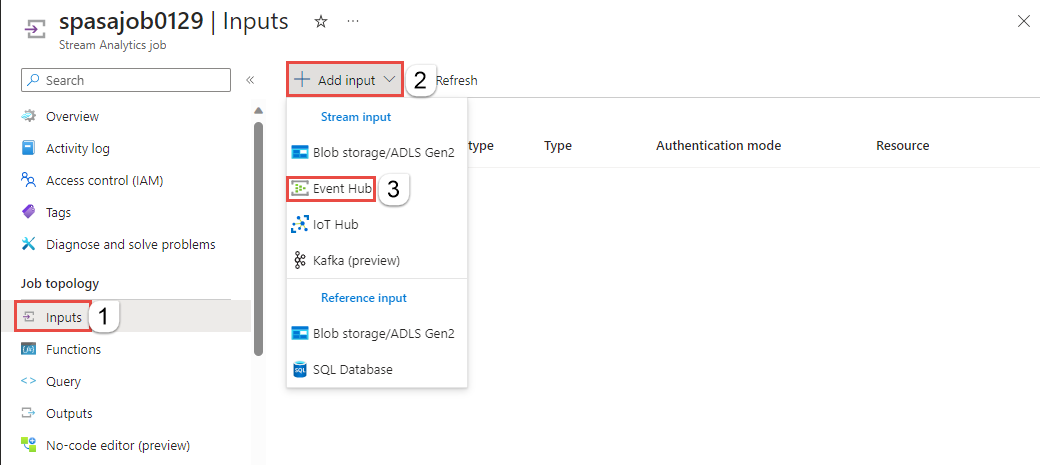

El paso siguiente consiste en definir un origen de entrada para que el trabajo lea los datos mediante el centro de eventos que se creó en la implementación de TollApp.

Busque el trabajo de Stream Analytics que se creó en la sección anterior.

En la sección Topología de trabajo del trabajo de Stream Analytics, seleccione Entradas.

Haga clic en Agregar entrada y seleccione Centro de eventos.

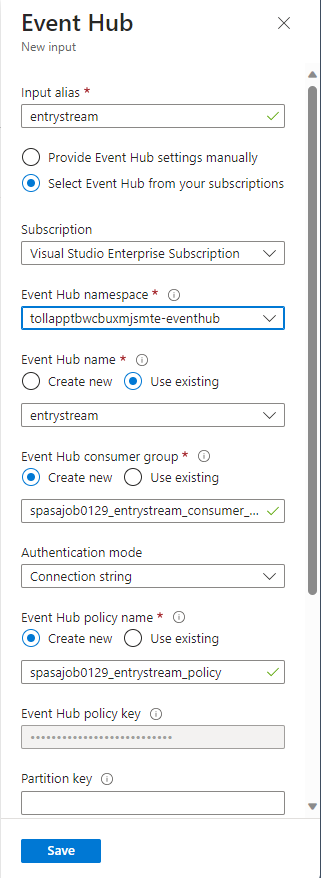

Rellene el formulario de entrada con los valores siguientes, creados mediante la plantilla de TollApp de Azure:

Escriba entrystream como Alias de entrada.

Elija Seleccionar centro de eventos de entre las suscripciones.

En Suscripción, seleccione su suscripción de Azure.

En Espacio de nombres del centro de eventos, seleccione el espacio de nombres del centro de eventos que creó en la sección anterior.

Use las opciones predeterminadas en el resto de los valores y seleccione Guardar.

Configuración de la salida del trabajo

El paso siguiente consiste en definir un receptor de salida en el que el trabajo pueda escribir los datos. En este tutorial, escribirá una salida en una tabla Delta en Azure Data Lake Storage Gen2.

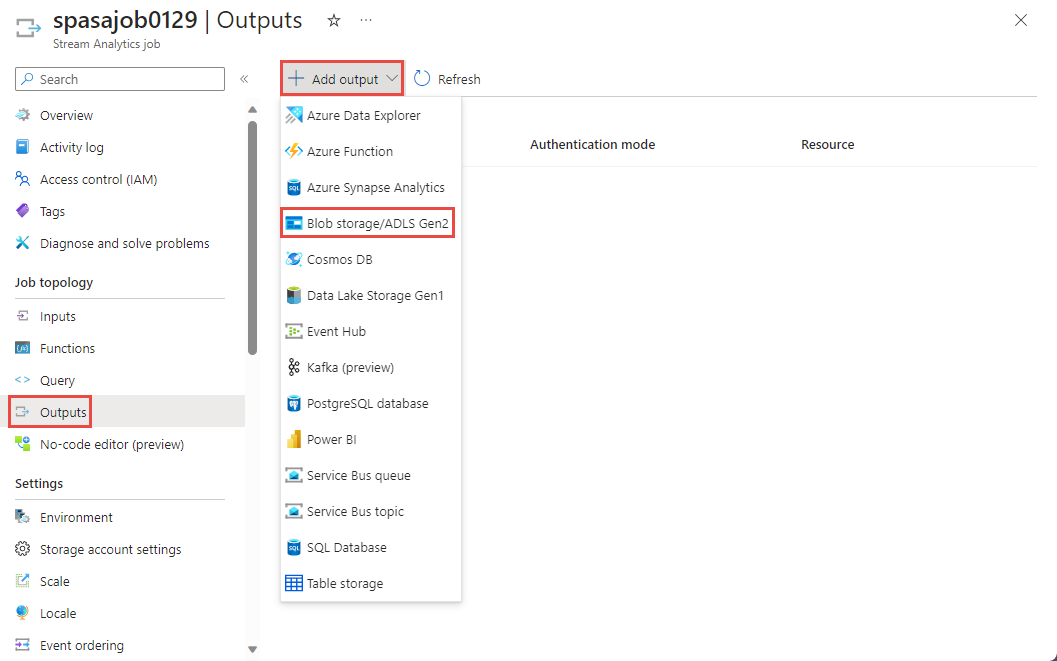

En la sección Topología de trabajo del trabajo de Stream Analytics, seleccione la opción Salidas.

Seleccione +Agregar salida>Blob storage/ADLS Gen2.

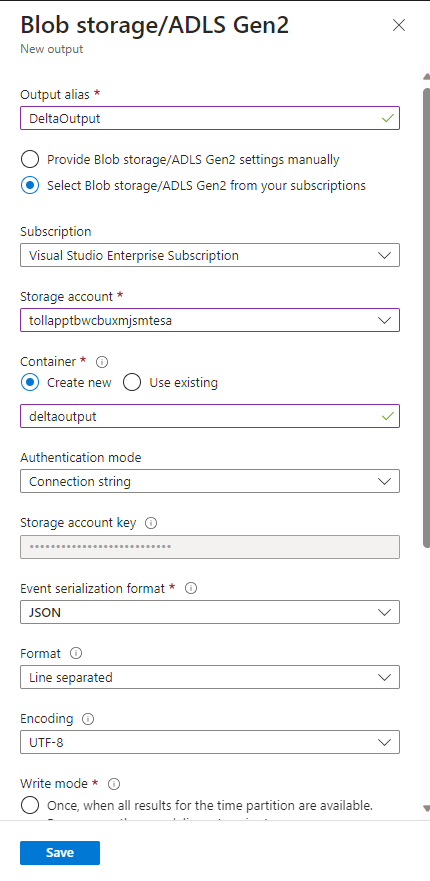

Rellene el formulario con los siguientes detalles y seleccione Guardar:

En Alias de salida, escriba DeltaOutput.

Elija Seleccionar almacenamiento de blobs/ADLS Gen2 de entre las suscripciones.

En Suscripción, seleccione su suscripción de Azure.

En Cuenta de almacenamiento, elija la cuenta de ADLS Gen2 (la que empieza por tollapp) que creó.

Para contenedor, seleccione Crear nuevo y proporcione un nombre de contenedor único.

En Formato de serialización de eventos, seleccione Delta Lake. Aunque Delta Lake aparece aquí como una de las opciones, no es un formato de datos. Delta Lake usa archivos Parquet con versiones para almacenar los datos. Para obtener más información sobre Delta Lake.

Como ruta de acceso de la tabla delta, escriba carpeta del tutorial/tabla delta.

Use las opciones predeterminadas en el resto de los valores y seleccione Guardar.

Creación de consultas

En este momento, tiene un trabajo de Stream Analytics configurado para leer un flujo de datos entrantes. El siguiente paso consiste en crear una consulta que analice los datos en tiempo real. Las consultas usan un lenguaje de tipo SQL que tiene algunas extensiones específicas para Stream Analytics.

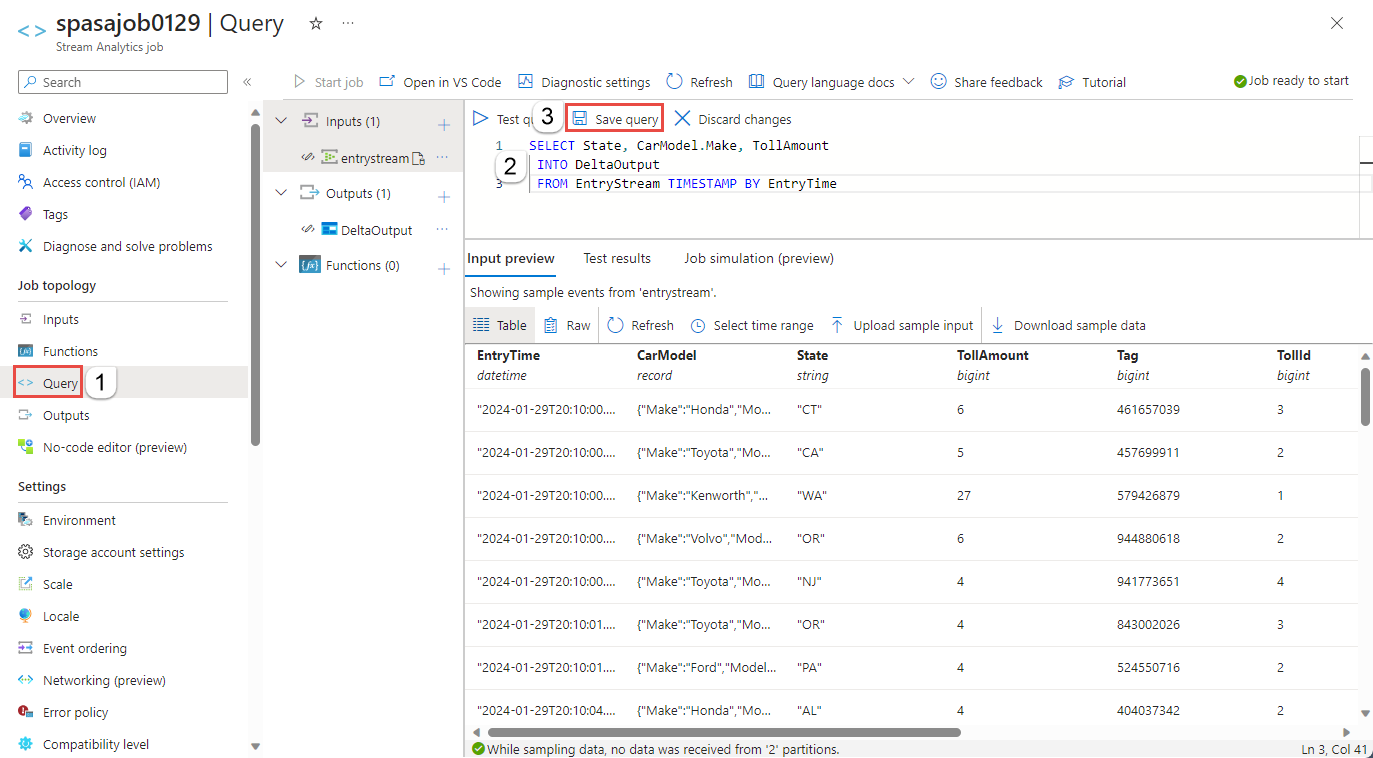

Ahora, seleccione Consulta en Topología de trabajo en el menú de la izquierda.

Introduzca la siguiente consulta en la ventana de consulta. En este ejemplo, la consulta lee los datos de Event Hubs y copia los valores seleccionados en una tabla Delta de ADLS Gen2.

SELECT State, CarModel.Make, TollAmount INTO DeltaOutput FROM EntryStream TIMESTAMP BY EntryTimeSeleccione Guardar consulta en la barra de herramientas.

Inicio del trabajo de Stream Analytics y consulta de la salida

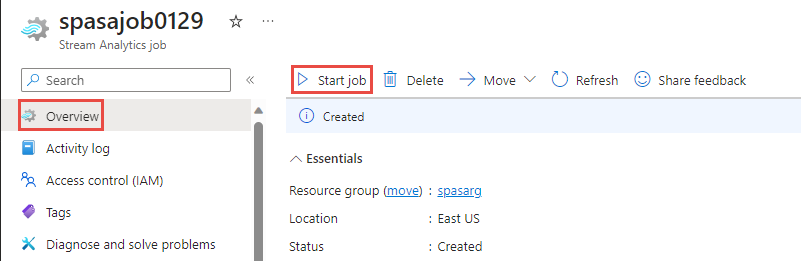

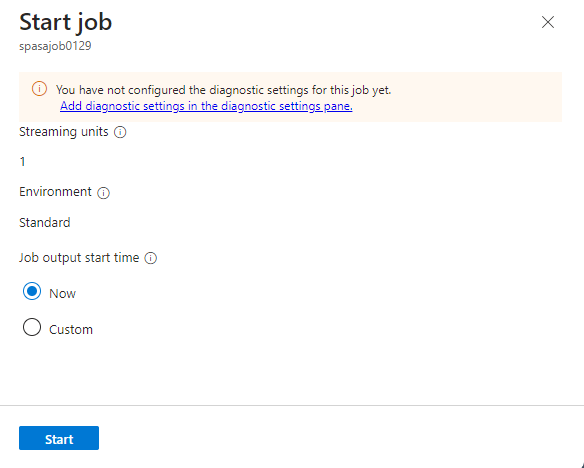

Vuelva a la página de información general del trabajo en Azure Portal y seleccione Iniciar.

En la página Iniciar trabajo, confirme que la opción Ahora está seleccionada para la hora de inicio de la salida del trabajo y, a continuación, seleccione Iniciar en la parte inferior de la página.

Al cabo de unos minutos, en el portal, busque la cuenta de almacenamiento y el contenedor que ha configurado como salida para el trabajo. Ahora puede ver la tabla delta en la carpeta especificada en el contenedor. El trabajo tarda unos minutos en iniciarse por primera vez; una vez iniciado, continuará ejecutándose a medida que llegan los datos.

Limpieza de recursos

Cuando no los necesite, elimine el grupo de recursos, el trabajo de Stream Analytics y todos los recursos relacionados. La eliminación del trabajo evita la facturación de las unidades de streaming utilizadas por el trabajo. Si piensa utilizar el trabajo en el futuro, puede detenerlo y volver a iniciarlo más adelante cuando sea necesario. Si no va a seguir usando este trabajo, siga estos pasos para eliminar todos los recursos creados en este tutorial:

- En el menú de la izquierda de Azure Portal, seleccione Grupos de recursos y luego el nombre del recurso que creó.

- En la página del grupo de recursos, seleccione Eliminar, escriba el nombre del recurso que quiere eliminar en el cuadro de texto y, luego, seleccione Eliminar.

Pasos siguientes

En este tutorial, ha creado un trabajo sencillo de Stream Analytics, ha filtrado los datos entrantes y ha escrito los resultados en una tabla Delta en la cuenta de ADLS Gen2. Para obtener más información sobre los trabajos de Stream Analytics: