Supervisión detallada de aplicaciones Apache Spark

Con Microsoft Fabric, use Apache Spark para ejecutar cuadernos, trabajos y otros tipos de aplicaciones en su área de trabajo. En este artículo se explica cómo supervisar las aplicaciones Apache Spark, lo que le permite vigilar el estado de ejecución más reciente, los problemas y el progreso de sus trabajos.

Visualización de aplicaciones de Apache Spark

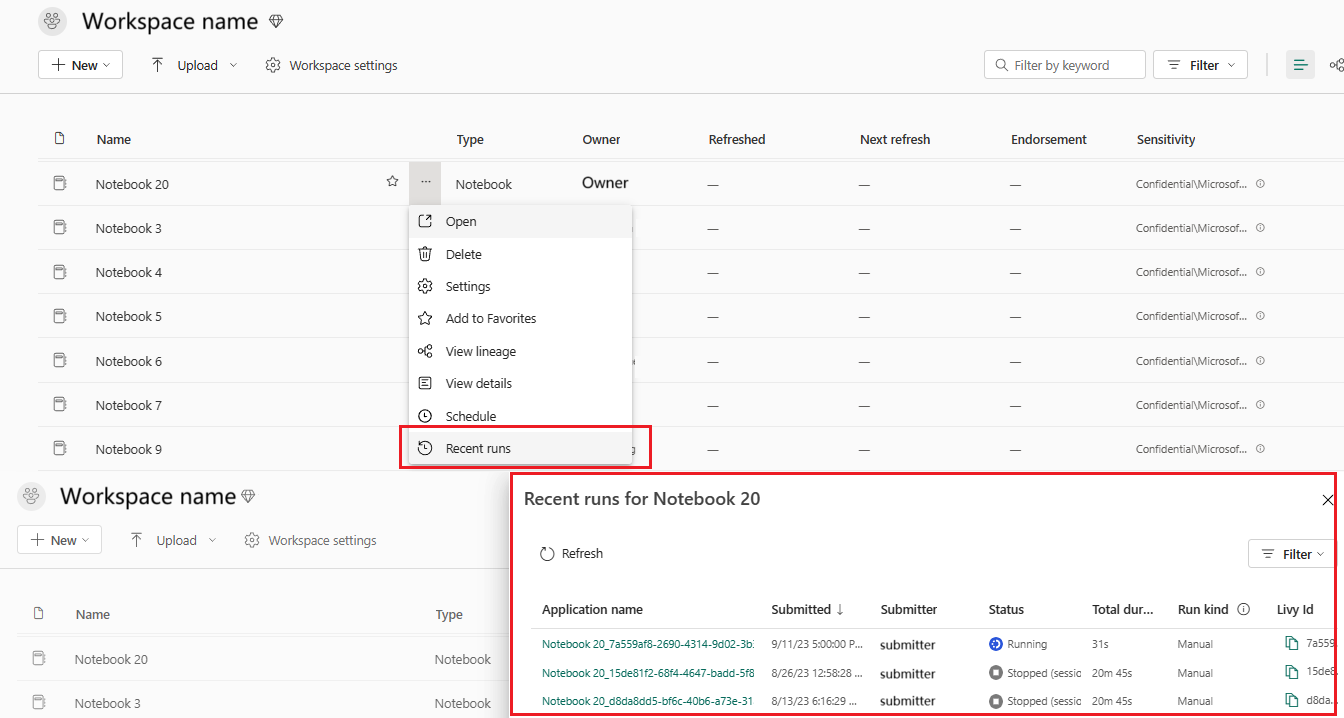

Puede ver todas las aplicaciones de Apache Spark desde la Definición del trabajo de Spark o el menú contextual del elemento de cuaderno muestra la opción de ejecución reciente ->Ejecuciones recientes.

Puede seleccionar el nombre de la aplicación que desea ver en la lista de aplicaciones, en la página de detalles de la aplicación puede ver los detalles de la aplicación.

Supervisión del estado de la aplicación Apache Spark

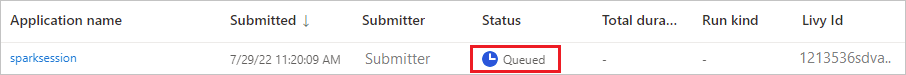

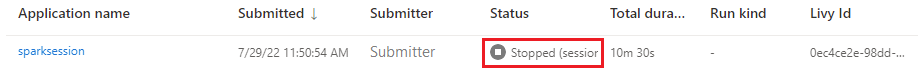

Abra la página Ejecuciones recientes del cuaderno o la definición de trabajo de Spark; puede ver el estado de la aplicación Apache.

- Correcto

- En cola

- Detenido

- Canceled

- Con errores

Trabajos

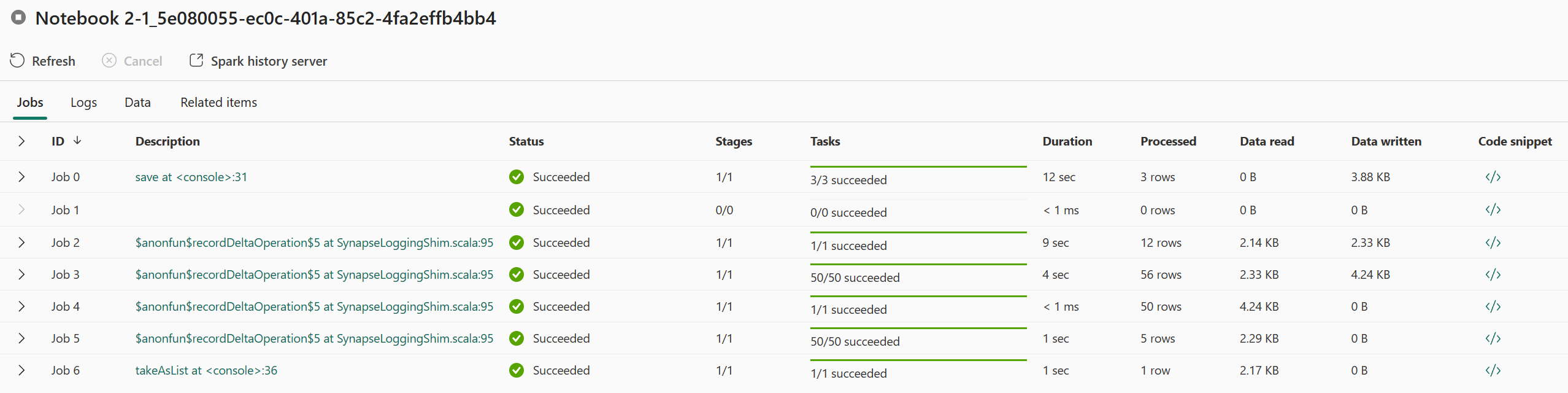

Abra un trabajo de aplicación de Apache Spark desde el menú contextual Definición de trabajo de Spark o elemento de cuaderno que muestra la opción Ejecución reciente ->Ejecuciones recientes -> seleccione un trabajo en la página ejecuciones recientes.

En la página de detalles de supervisión de aplicaciones de Apache Spark, la lista de ejecuciones de trabajos se muestra en la pestaña Trabajos, puede ver los detalles de cada trabajo aquí, incluido el identificador de trabajo, la descripción, el estado, las fases, las tareas, la duración, los datos procesados, los datos leídos, los datos escritos y el fragmento de código.

- Al hacer clic en Id. de trabajo, puede expandir o contraer el trabajo.

- Haga clic en la descripción del trabajo, puede ir a la página de trabajo o fase en la interfaz de usuario de Spark.

- Haga clic en el fragmento de código del trabajo, puede comprobar y copiar el código relacionado con este trabajo.

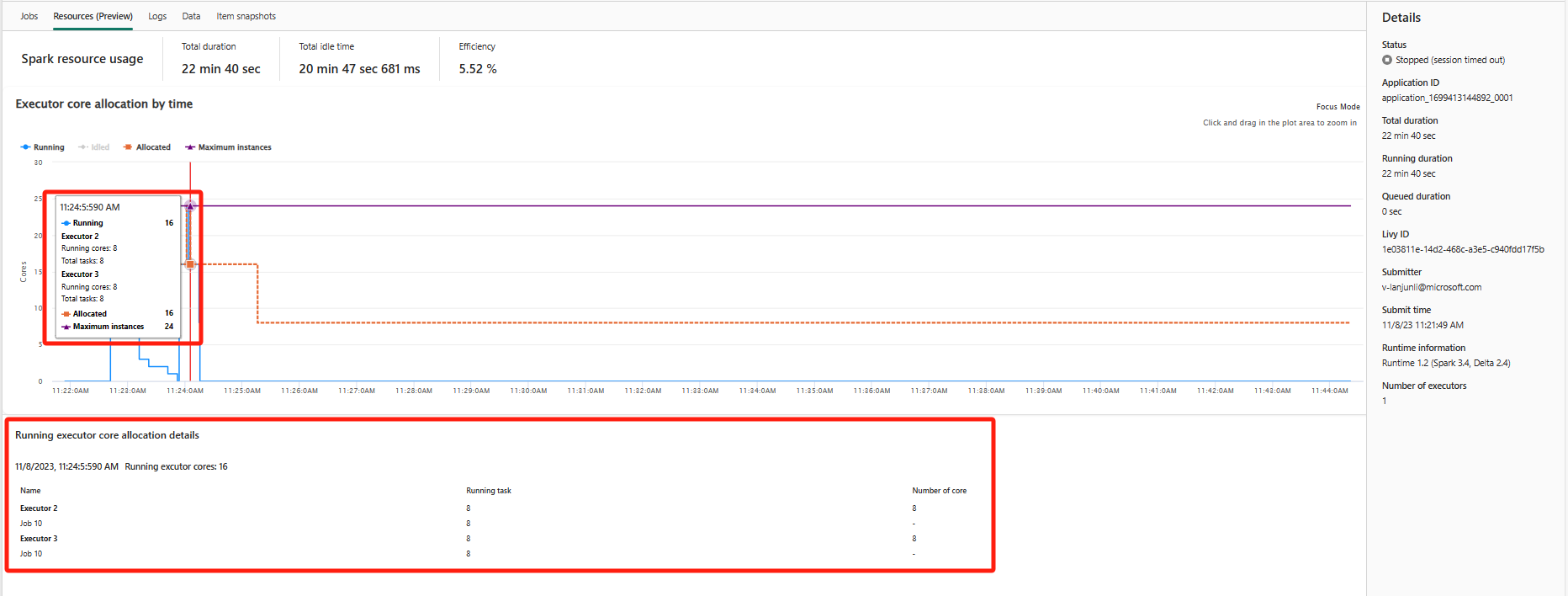

Recursos (versión preliminar)

El gráfico de uso del ejecutor muestra visualmente la asignación de ejecutores de trabajos de Spark y el uso de recursos. Actualmente, solo la información en tiempo de ejecución de Spark 3.4 y versiones posteriores mostrará esta característica. Cunado seleccione Recursos (versión preliminar), se dibujarán cuatro curvas de tipos sobre el uso del ejecutor, incluidas En ejecución, Inactivos, Asignados y Máximo de instancias.

Asignados hace referencia a la situación principal que se asigna durante la ejecución de la aplicación Spark.

Número máximo de instancias hace referencia al número máximo de núcleos asignados a la aplicación Spark.

En Ejecución hace referencia al número real de núcleos que usa la aplicación Spark cuando se ejecuta. Haga clic en un punto temporal dado mientras se ejecuta la aplicación Spark. Puede ver los detalles de asignación principal del ejecutor en ejecución en la parte inferior del gráfico.

Para Inactivos, es el número de núcleos sin usar mientras se ejecuta la aplicación Spark.

A veces, para algún punto temporal el número de tareas puede superar la capacidad de los núcleos del ejecutor (es decir, números de tarea > núcleos de ejecutor total/spark.task.cpus). Esto es lo esperado, ya que existe un lapso de tiempo entre una tarea marcada como en ejecución y su ejecución real en un núcleo del ejecutor. Por lo tanto, es posible que algunas tareas se muestren como en ejecución, pero no se ejecuten en ningún núcleo.

Seleccione el icono de color para seleccionar o anular la selección del contenido correspondiente en todos los gráficos.

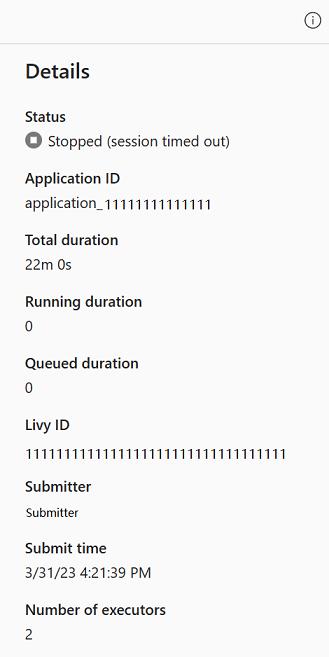

Panel de resumen

En la página de supervisión de aplicaciones de Apache Spark, haga clic en el botón Propiedades para abrir o contraer el panel de resumen. Puede ver los detalles de esta aplicación en Detalles.

- Estado de esta aplicación de Spark.

- El identificador de esta aplicación de Spark.

- Duración total.

- Duración de ejecución de esta aplicación de Spark.

- Duración en cola para esta aplicación de Spark.

- Id. de Livy

- Remitente de esta aplicación de Spark.

- Tiempo de envío para esta aplicación de Spark.

- Número de ejecutores.

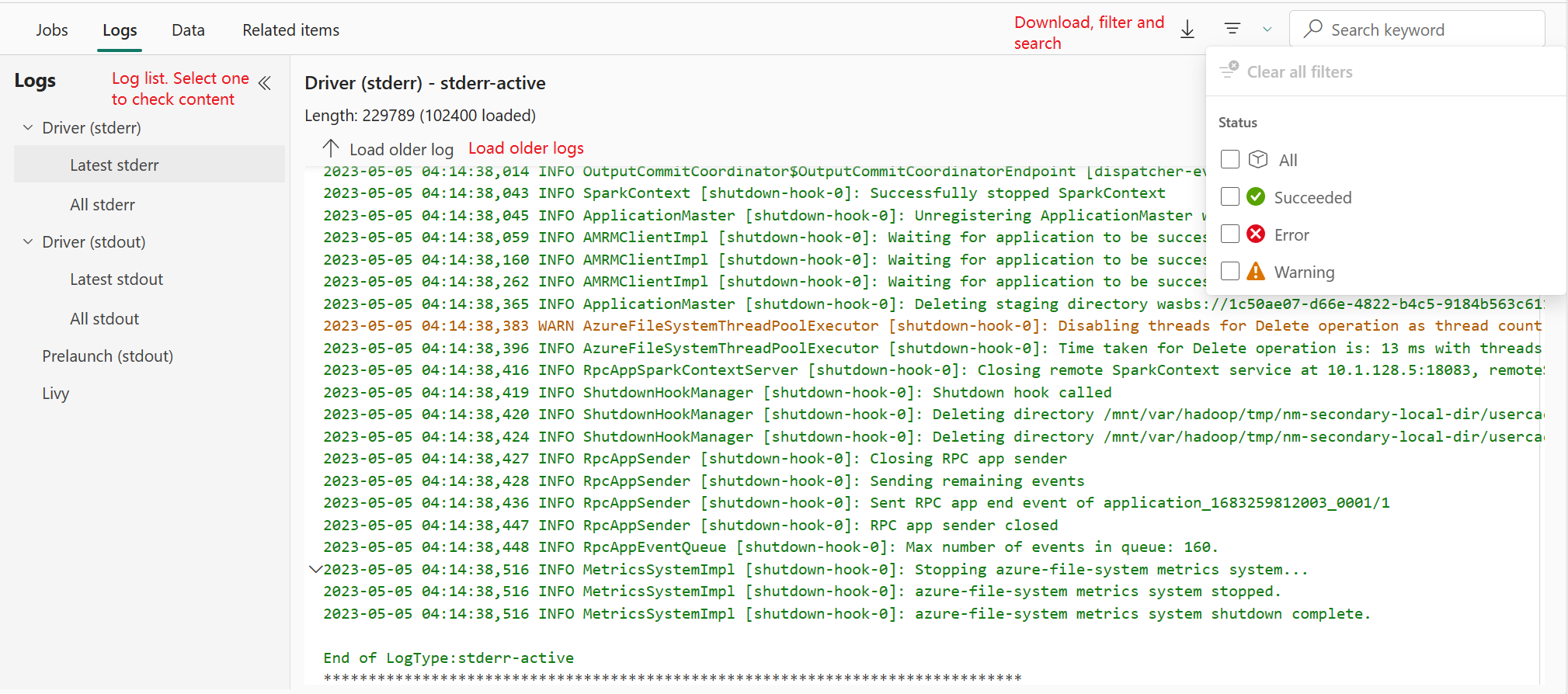

Registros

Para la pestaña Registros, puede ver el registro completo de Livy, Inicio previo y Registro de controladores con diferentes opciones seleccionadas en el panel izquierdo. Y puede recuperar directamente la información de registro necesaria buscando palabras clave y ver los registros filtrando el estado del registro. Haga clic en Descargar registro para descargar la información del registro en el entorno local.

A veces no hay registros disponibles, ya que el estado del trabajo está en cola y se produce un error en la creación del clúster.

Los registros activos solo están disponibles cuando se produce un error en el envío de la aplicación y también se proporcionan registros de controladores.

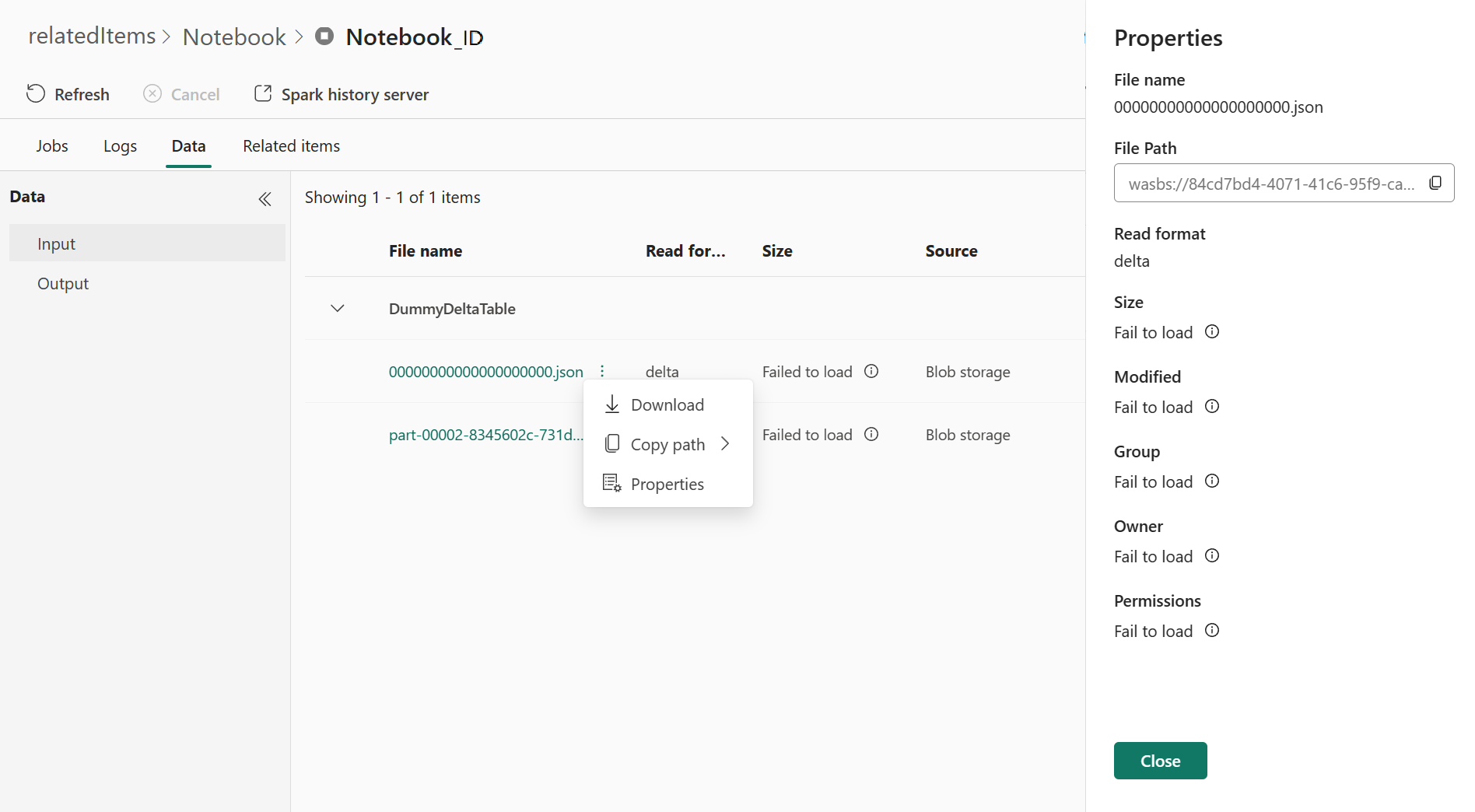

Data

En la pestaña Datos, puede copiar la lista de datos en el Portapapeles, descargar la lista de datos y los datos únicos y comprobar las propiedades de cada dato.

- El panel izquierdo se puede expandir o contraer.

- El nombre, el formato de lectura, el tamaño, el origen y la ruta de acceso de los archivos de entrada y salida se mostrarán en esta lista.

- Los archivos de entrada y salida se pueden descargar, copiar la ruta de acceso y ver las propiedades.

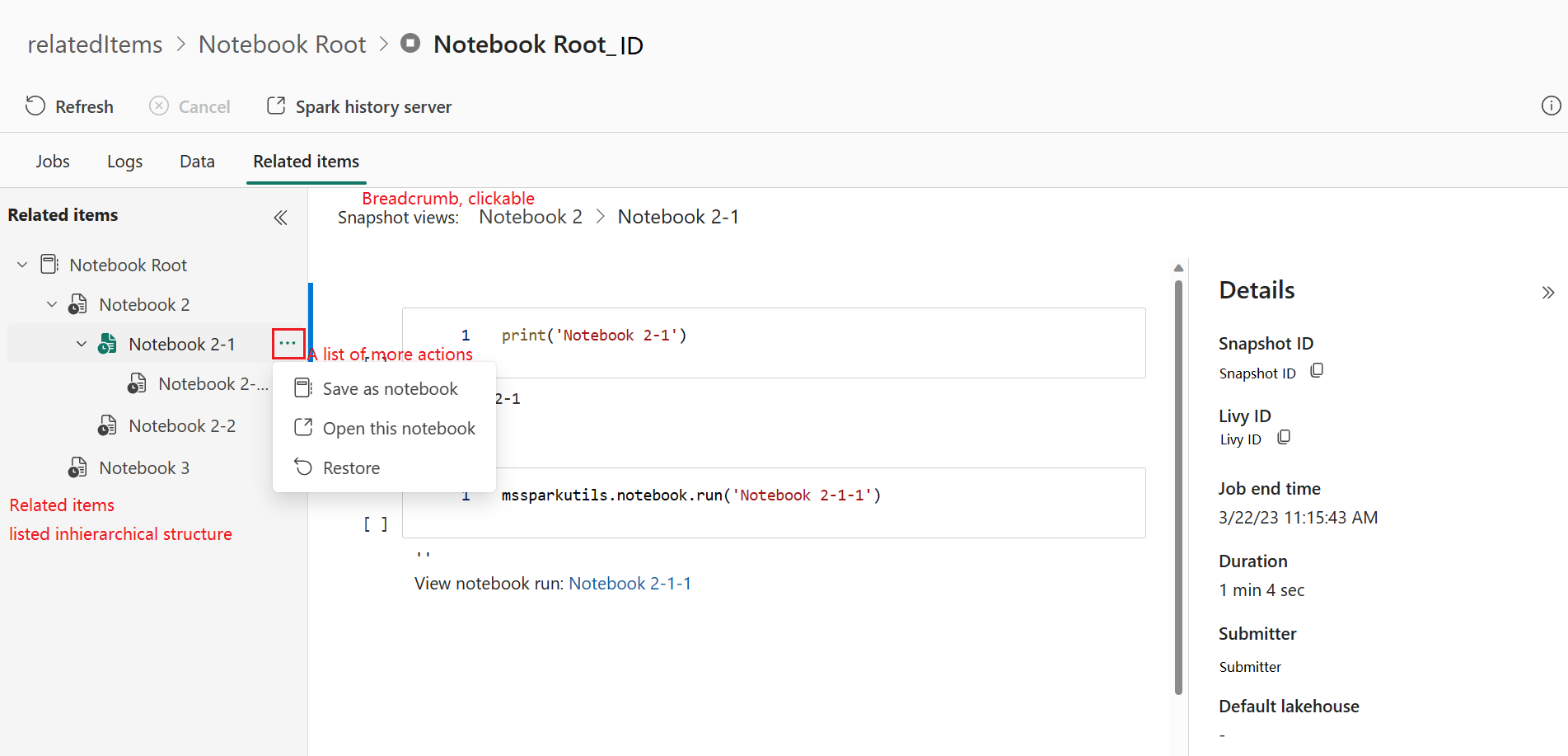

Elementos relacionados

La pestaña Elementos relacionados permite examinar y ver los elementos asociados a la aplicación de Apache Spark, incluidos cuadernos, definición de trabajo de Spark o canalizaciones. La página de elementos relacionados muestra la instantánea de los valores de código y parámetro en el momento de la ejecución de Notebooks. También muestra la instantánea de todos los parámetros y configuraciones en el momento del envío para las definiciones de trabajos de Spark. Si la aplicación de Apache Spark está asociada a una canalización, la página de elementos relacionados también presenta la canalización correspondiente y la actividad de Spark.

En la pantalla Elementos relacionados, puede:

- Examine y navegue por los elementos relacionados en el árbol jerárquico.

- Haga clic en el icono de puntos suspensivos "Una lista de más acciones" de cada elemento para realizar diferentes acciones.

- Haga clic en el elemento de instantánea para ver su contenido.

- Vea la ruta de navegación para ver la ruta de acceso del elemento seleccionado a la raíz.

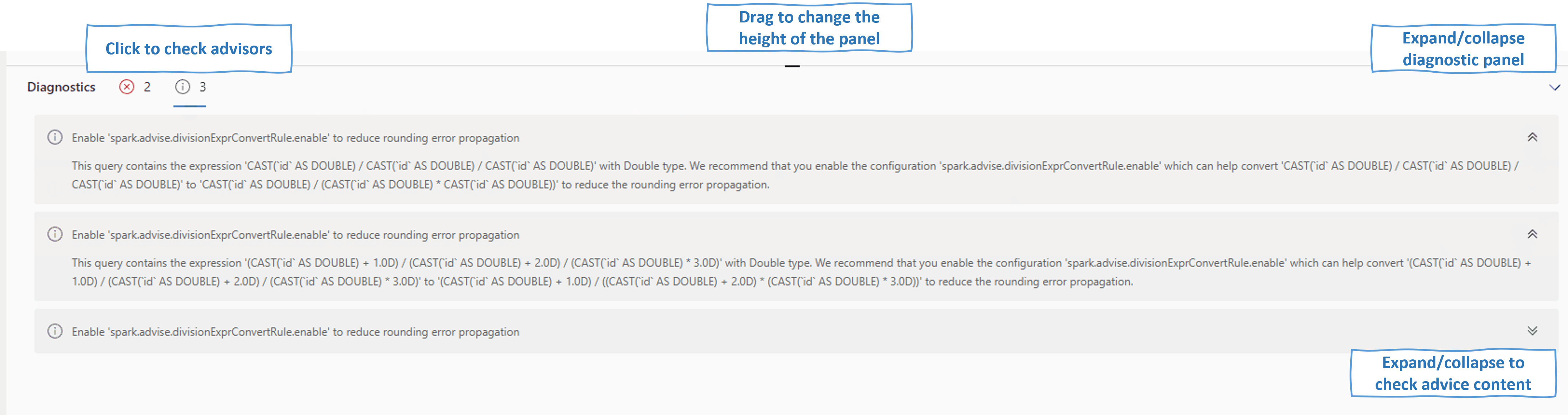

Diagnóstico

El panel de diagnóstico proporciona a los usuarios recomendaciones en tiempo real y análisis de errores, que el Asesor de Spark genera a través de un análisis del código del usuario. Con los patrones integrados, el Asesor de Apache Spark ayuda a los usuarios a evitar errores comunes y a analizar los errores para identificar su causa principal.

Contenido relacionado

El siguiente paso después de ver los detalles de una aplicación de Apache Spark es ver el progreso del trabajo de Spark debajo de la celda Notebook. Puede hacer referencia a:

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente GitHub Issues como mecanismo de comentarios sobre el contenido y lo sustituiremos por un nuevo sistema de comentarios. Para más información, vea: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de