Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Azure Synapse es un servicio de análisis ilimitado que reúne el almacenamiento de datos empresariales y el análisis de macrodatos. En este tutorial se muestra cómo conectarse a OneLake mediante Azure Synapse Analytics.

Escritura de datos desde Synapse mediante Apache Spark

Siga estos pasos para usar Apache Spark para escribir datos de ejemplo en OneLake desde Azure Synapse Analytics.

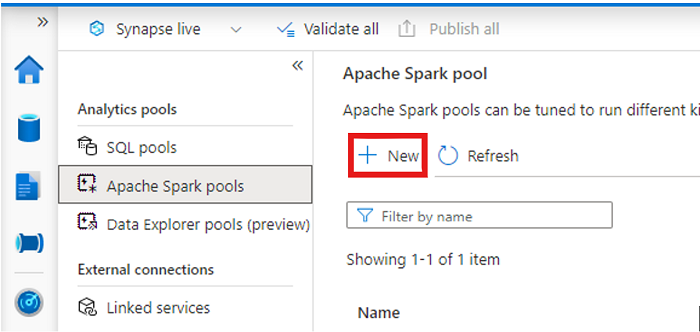

Abra su área de trabajo Synapse y cree un pool Apache Spark con sus parámetros preferidos.

Cree un nuevo cuaderno de Apache Spark.

Abra el cuaderno, establezca el lenguaje en PySpark (Python) y conéctelo al grupo de Spark recién creado.

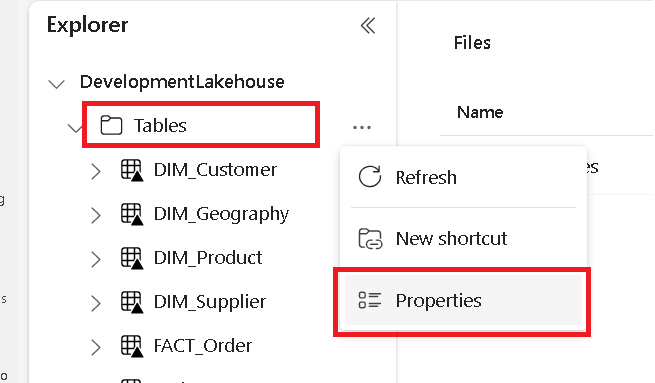

En una pestaña independiente, vaya a la instancia de Lakehouse de Microsoft Fabric y busque la carpeta Tablas de nivel superior.

Haga clic con el botón derecho en la carpeta Tablas y seleccione Propiedades.

Copie la ruta ABFS del panel de propiedades.

De nuevo en el cuaderno Azure Synapse, en la primera celda de código nueva, proporcione la ruta de acceso de lakehouse. Este lago es donde se escriben los datos más adelante. Ejecute la celda.

# Replace the path below with the ABFS path to your lakehouse Tables folder. oneLakePath = 'abfss://WorkspaceName@onelake.dfs.fabric.microsoft.com/LakehouseName.lakehouse/Tables'En una nueva celda de código, cargue datos de un conjunto de datos abierto de Azure en una trama de datos. Este conjunto de datos es el que se carga en el lago. Ejecute la celda.

yellowTaxiDf = spark.read.parquet('wasbs://nyctlc@azureopendatastorage.blob.core.windows.net/yellow/puYear=2018/puMonth=2/*.parquet') display(yellowTaxiDf.limit(10))En una nueva celda de código, filtre, transforme o prepare los datos. En este escenario, puede reducir el conjunto de datos para una carga más rápida, unirse a otros conjuntos de datos o filtrar por resultados específicos. Ejecute la celda.

filteredTaxiDf = yellowTaxiDf.where(yellowTaxiDf.tripDistance>2).where(yellowTaxiDf.passengerCount==1) display(filteredTaxiDf.limit(10))En una nueva celda de código, con la ruta de acceso de OneLake, escriba la trama de datos filtrada en una nueva tabla de Delta-Parquet en fabric lakehouse. Ejecute la celda.

filteredTaxiDf.write.format("delta").mode("overwrite").save(oneLakePath + '/Taxi/')Por último, en una nueva celda de código, pruebe que los datos se escribieron correctamente leyendo el archivo recién cargado desde OneLake. Ejecute la celda.

lakehouseRead = spark.read.format('delta').load(oneLakePath + '/Taxi/') display(lakehouseRead.limit(10))

¡Enhorabuena! Ahora puede leer y escribir datos en OneLake mediante Apache Spark en Azure Synapse Analytics.

Lectura de datos de Synapse mediante SQL

Siga estos pasos para usar SQL sin servidor para leer datos de OneLake desde Azure Synapse Analytics.

Abra una instancia de Fabric Lakehouse e identifique una tabla que le gustaría consultar desde Synapse.

Haga clic con el botón derecho en la tabla y seleccione Propiedades.

Copie la ruta de acceso de ABFS de la tabla.

Abra el área de trabajo en Synapse Studio.

Se creará un nuevo script de SQL.

En el editor de consultas SQL, escriba la siguiente consulta, reemplazando por

ABFS_PATH_HEREla ruta de acceso que copió anteriormente.SELECT TOP 10 * FROM OPENROWSET( BULK 'ABFS_PATH_HERE', FORMAT = 'delta') as rows;Ejecute la consulta para ver las 10 primeras filas de la tabla.

¡Enhorabuena! Ahora puede leer datos de OneLake utilizando SQL sin servidor en Azure Synapse Analytics.