Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Una vez creada una secuencia de eventos, puede conectarla a varios orígenes de datos y destinos.

Nota:

Las funcionalidades mejoradas se habilitan de manera predeterminada al crear flujos de eventos ahora. Si tienes flujos de eventos creados con funcionalidades estándar, esos flujos de eventos seguirán funcionando. Todavía puedes editarlos y usarlos como de costumbre. Se recomienda crear una nueva secuencia de eventos para reemplazar las secuencias de eventos estándar para que pueda aprovechar las funcionalidades adicionales y las ventajas de las secuencias de eventos mejoradas.

Una vez creado un eventstream, puede conectarlo a varios orígenes y destinos de datos.

Eventstream no solo permite transmitir datos de orígenes de Microsoft, sino que también admite la ingesta desde plataformas de terceros como Google Cloud y Amazon Kinesis con nuevos conectores de mensajería. Esta funcionalidad ampliada ofrece una integración perfecta de secuencias de datos externos en Fabric, lo que proporciona mayor flexibilidad y le permite obtener información en tiempo real de varios orígenes.

En este artículo, obtendrá información sobre los orígenes de eventos que puede agregar a una secuencia de eventos.

Requisitos previos

- Acceso a un área de trabajo en el modo de licencia de capacidad de Fabric (o) el modo de licencia de prueba con los permisos Colaborador o superior.

- Requisitos previos específicos de cada origen que se documentan en los siguientes artículos específicos del origen.

Orígenes compatibles

Las secuencias de eventos de Fabric con funcionalidades mejoradas admiten los siguientes orígenes. En cada artículo se proporcionan detalles e instrucciones para agregar orígenes específicos.

| Orígenes | Descripción |

|---|---|

| Azure Data Explorer (versión preliminar) | Si tiene una base de datos de Azure Data Explorer y una tabla, puede ingerir datos de la tabla en Microsoft Fabric mediante Eventstream. |

| Azure Event Hubs | Si tiene un centro de eventos de Azure, puede ingerir datos del centro de eventos en Microsoft Fabric mediante Eventstream. |

| Azure Event Grid (versión preliminar) | Si tiene un espacio de nombres de Azure Event Grid, puede ingerir datos de eventos MQTT o no MQTT en Microsoft Fabric mediante Eventstream. |

| Azure Service Bus (versión preliminar) | Puede ingerir datos de una cola de Azure Service Bus o la suscripción de un tema a Microsoft Fabric mediante Eventstream. |

| Azure IoT Hub | Si tiene un centro de IoT de Azure, puede ingerir datos de IoT en Microsoft Fabric mediante Eventstream. |

| Punto de conexión personalizado (es decir, aplicación personalizada en la funcionalidad estándar) | La característica de punto de conexión personalizado permite que las aplicaciones o los clientes de Kafka se conecten a Eventstream mediante una cadena de conexión, lo que permite la ingesta fluida de datos de streaming en Eventstream. |

| Datos de ejemplo | Puede elegir Bicicletas, Taxi amarillo, o Eventos de mercado de valores como un origen de datos de ejemplo para probar la ingesta de datos al configurar un eventstream. |

| Tiempo real (versión preliminar) | Puede agregar un origen meteorológico en tiempo real a un eventstream para transmitir datos meteorológicos en tiempo real desde diferentes ubicaciones. |

| Captura de datos modificados de la base de datos Azure SQL | El conector de origen de CDC de Azure SQL Database permite capturar una instantánea de los datos actuales en una base de datos de Azure SQL. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| CDC de base de datos de PostgreSQL | El conector de origen de captura de datos modificados (CDC) de la base de datos de PostgreSQL permite capturar una instantánea de los datos actuales en una base de datos de PostgreSQL. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| CDC de base de datos de MySQL | El conector de origen de captura de datos modificados (CDC) de Azure MySQL Database permite capturar una instantánea de los datos actuales en una base de datos de Azure Database for MySQL. Puede especificar las tablas que se van a supervisar y Eventstream registra los cambios futuros de nivel de fila en las tablas. |

| CDC de Azure Cosmos DB | El conector de origen de captura de datos modificados (CDC) de Azure Cosmos DB para flujos de eventos de Microsoft Fabric permite capturar una instantánea de los datos actuales en una base de datos de Azure Cosmos DB. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| SQL Server en CDC de base de datos (DB) de máquina virtual (VM) | El conector de origen de la base de datos de SQL Server en la máquina virtual (CDC) para flujos de eventos de Fabric permite capturar una instantánea de los datos actuales de una base de datos de SQL Server en la máquina virtual. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| Azure SQL Managed Instance CDC | El conector de origen de Azure SQL Managed Instance CDC para flujos de eventos de Microsoft Fabric permite capturar una instantánea de los datos actuales en una base de datos de SQL Managed Instance. A continuación, el conector supervisa y registra los cambios futuros a nivel de fila en estos datos. |

| Eventos de elemento del área de trabajo de Fabric | Los eventos de elementos del área de trabajo de Fabric son eventos discretos de Fabric que se producen cuando se realizan cambios en el área de trabajo de Fabric. Estos cambios incluyen la creación, actualización o eliminación de un elemento de Fabric. Con flujos de eventos de Fabric, puede capturar estos eventos del área de trabajo de Fabric, transformarlos y enrutarlos a varios destinos de Fabric para su posterior análisis. |

| Eventos de Fabric OneLake | Los eventos OneLake le permiten suscribirse a los cambios en archivos y carpetas de OneLake y, a continuación, reaccionar a esos cambios en tiempo real. Con los flujos de eventos de Fabric, puede capturar estos eventos oneLake, transformarlos y enrutarlos a varios destinos de Fabric para su posterior análisis. Esta integración sin problemas de eventos de OneLake en flujos de eventos de Fabric le ofrece una mayor flexibilidad para supervisar y analizar actividades en OneLake. |

| Eventos de trabajo de Fabric | Los eventos de trabajo permiten suscribirse a los cambios producidos cuando Fabric ejecuta un trabajo. Por ejemplo, puede reaccionar a los cambios al actualizar un modelo semántico, ejecutar una canalización programada o ejecutar un cuaderno. Cada una de estas actividades puede generar un trabajo correspondiente, que a su vez genera un conjunto de eventos de trabajo correspondientes. Con flujos de eventos de Fabric, puede capturar estos eventos de trabajo, transformarlos y enrutarlos a varios destinos de Fabric para su posterior análisis. Esta integración sin problemas de eventos de trabajo en flujos de eventos de Fabric proporciona una mayor flexibilidad para supervisar y analizar actividades en el trabajo. |

| Eventos de Azure Blob Storage | Los eventos de Azure Blob Storage se desencadenan cuando un cliente crea, reemplaza o elimina un blob. El conector permite vincular eventos de Blob Storage a eventos de Fabric en el centro en tiempo real. Puede convertir estos eventos en flujos de datos continuos y transformarlos antes de enrutarlos a varios destinos de Fabric. |

| Google Cloud Pub/Sub | Google Pub/Sub es un servicio de mensajería que permite publicar y suscribirse a secuencias de eventos. Puede agregar Google Pub/Sub como origen a su secuencia de eventos para capturar, transformar y enrutar eventos en tiempo real a varios destinos de Fabric. |

| Flujos de datos de Amazon Kinesis | Amazon Kinesis Data Streams es un servicio de procesamiento y ingesta de datos muy duradero y escalable de forma masiva optimizado para datos de streaming. Al integrar Amazon Kinesis Data Streams como origen dentro de la secuencia de eventos, puede procesar sin problemas flujos de datos en tiempo real antes de enrutarlos a varios destinos dentro de Fabric. |

| Confluent Cloud for Apache Kafka | Confluent Cloud for Apache Kafka es una plataforma de streaming que ofrece funcionalidades eficaces de procesamiento y streaming de datos mediante Apache Kafka. Mediante la integración de Confluent Cloud para Apache Kafka como origen dentro de la secuencia de eventos, puede procesar sin problemas flujos de datos en tiempo real antes de enrutarlos a varios destinos dentro de Fabric. |

| Apache Kafka (versión preliminar) | Apache Kafka es una plataforma distribuida de código abierto para crear sistemas de datos escalables y en tiempo real. Al integrar Apache Kafka como origen dentro de la secuencia de eventos, puede traer sin problemas eventos en tiempo real de Apache Kafka y procesarlos antes de enrutarlos a varios destinos dentro de Fabric. |

| Amazon MSK Kafka | Amazon MSK Kafka es un servicio Kafka totalmente administrado que simplifica la configuración, el escalado y la administración. Al integrar Amazon MSK Kafka como origen dentro de la secuencia de eventos, puede traer sin problemas los eventos en tiempo real de su MSK Kafka y procesarlos antes de enrutarlos a varios destinos dentro de Fabric. |

| MQTT (versión preliminar) | Los flujos de eventos de Microsoft Fabric permiten conectarse a un agente MQTT, donde los mensajes del agente MQTT se ingieren en el flujo de eventos de Fabric y se enrutan a varios destinos dentro de Fabric. |

| Solace PubSub+ (versión preliminar) | Los flujos de eventos de Microsoft Fabric le permiten conectarse a Solace PubSub+, donde los mensajes de Solace PubSub+ se ingieren en Fabric Eventstream y enrutan a varios destinos dentro de Fabric. |

Nota:

Una secuencia de eventos puede admitir hasta 11 orígenes y destinos combinados solo cuando se usan los siguientes tipos:

- Origen: punto de conexión personalizado.

- Destinos: punto de conexión personalizado y Eventhouse con ingesta directa.

Los orígenes o destinos no incluidos en la lista anterior y los destinos no anexados a la secuencia predeterminada no cuentan hacia este límite.

Contenido relacionado

Requisitos previos

Para empezar, debe completar los siguientes requisitos previos:

- Acceso a un área de trabajo en el modo de licencia de capacidad de Fabric (o) el modo de licencia de prueba con los permisos Colaborador o superior.

- Para agregar Azure Event Hubs o Azure IoT Hub como origen de eventstream, debe tener el permiso adecuado para acceder a sus claves de directiva. Deben ser accesibles públicamente y no estar detrás de un firewall o protegidos en una red virtual.

Orígenes compatibles

Los flujos de eventos de Fabric admiten los siguientes orígenes. Usa los vínculos de la tabla para ir a artículos que proporcionan más detalles sobre cómo agregar orígenes específicos.

| Orígenes | Descripción |

|---|---|

| Azure Event Hubs | Si tiene un centro de eventos de Azure, puede ingerir datos del centro de eventos en Microsoft Fabric mediante Eventstream. |

| Azure IoT Hub | Si tiene un centro de IoT de Azure, puede ingerir datos de IoT en Microsoft Fabric mediante Eventstream. |

| Datos de ejemplo | Puede elegir Bicicletas, Taxi amarillo, o Eventos de mercado de valores como un origen de datos de ejemplo para probar la ingesta de datos al configurar un eventstream. |

| Aplicación personalizada | La característica de aplicación personalizada permite que las aplicaciones o los clientes de Kafka se conecten a Eventstream mediante una cadena de conexión, lo que permite la ingesta fluida de datos de streaming en Eventstream. |

Nota:

Una secuencia de eventos puede admitir hasta 11 orígenes y destinos combinados solo cuando se usan los siguientes tipos:

- Origen: punto de conexión personalizado.

- Destinos: punto de conexión personalizado y Eventhouse con ingesta directa.

Los orígenes o destinos no incluidos en la lista anterior y los destinos no anexados a la secuencia predeterminada no cuentan hacia este límite.

Administración de un origen

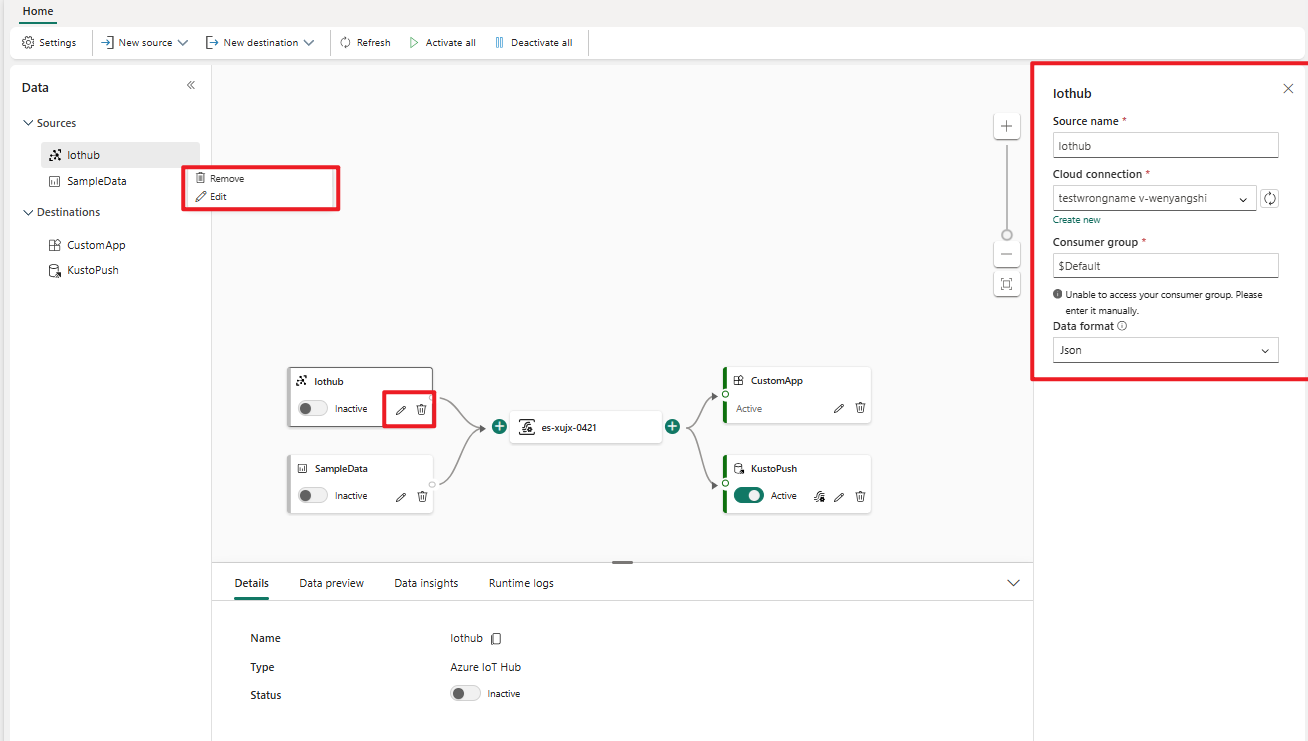

Editar o quitar: puede seleccionar un origen de eventstream para editar o quitar a través del panel de navegación o el lienzo. Al seleccionar Editar, el panel de edición se abre a la derecha del editor principal.

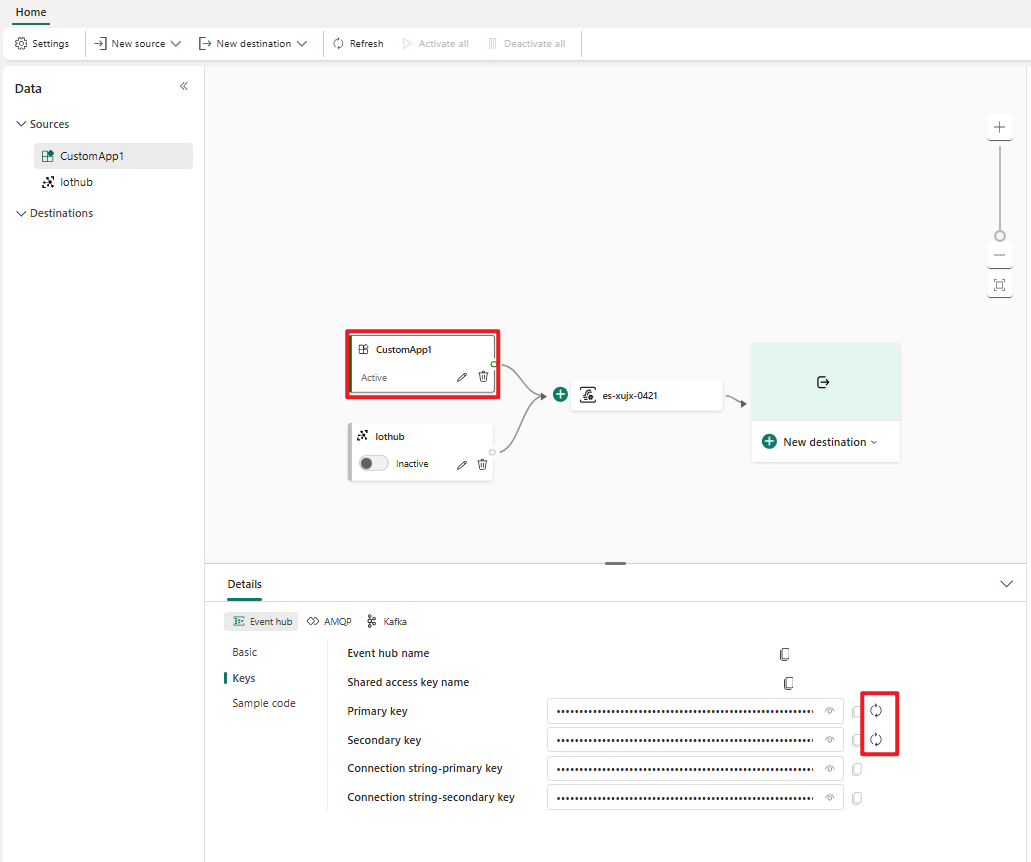

Regenerar clave para una aplicación personalizada: si quiere volver a generar una nueva clave de conexión para la aplicación, seleccione uno de los orígenes de la aplicación personalizados en el lienzo y seleccione Regenerar para obtener una nueva clave de conexión.