Transmisión de datos de Azure Storage Blob a Azure Data Lake Storage Gen1 mediante Stream Analytics

En este artículo aprenderá a utilizar Azure Data Lake Storage Gen1 como salida para un trabajo de Azure Stream Analytics. En este artículo se muestra un escenario simple en el que se leen datos desde un blob de Azure Storage (entrada) y se escriben en Data Lake Storage Gen1 (salida).

Prerrequisitos

Antes de empezar este tutorial, debe contar con lo siguiente:

Una suscripción de Azure. Consulte Obtención de una versión de evaluación gratuita.

Cuenta de Azure Storage. Usará un contenedor de blobs desde esta cuenta para introducir datos en un trabajo de Stream Analytics. En este tutorial, se asume que tiene una cuenta de almacenamiento denominada storageforasa y un contenedor dentro de la cuenta denominado storageforasacontainer. Una vez creado el contenedor, va a cargar un archivo de datos de ejemplo en él.

Cuenta de Data Lake Storage Gen1. Siga las instrucciones de Introducción a Azure Data Lake Storage Gen1 con Azure Portal. Supongamos que tiene una cuenta de Data Lake Storage Gen1 llamada myadlsg1.

Creación de un trabajo de Stream Analytics

Primero debe crear un trabajo de Stream Analytics que incluya un origen de entrada y un destino de salida. Para este tutorial, el origen es un contenedor de blobs de Azure y el destino es Data Lake Storage Gen1.

Inicie sesión en Azure Portal.

En el panel izquierdo, haga clic en Trabajos de Stream Analytics y luego haga clic en Agregar.

Nota

Asegúrese de crear el trabajo en la misma región que la cuenta de almacenamiento o incurrirá en costos adicionales derivados de mover datos entre regiones.

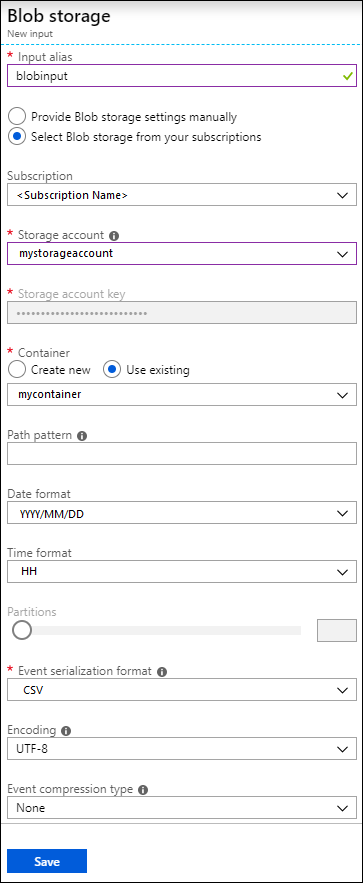

Creación de una entrada de blob para el trabajo

Abra la página del trabajo de Stream Analytics y en el panel izquierdo haga clic en la pestaña Inputs (Entradas) y luego haga clic en Agregar.

En la hoja Nueva entrada, proporcione los valores siguientes.

En Alias de entrada, escriba un nombre único para la entrada del trabajo.

En Source type (Tipo de origen), seleccione Flujo de datos.

En Origen, seleccione Blob storage.

En Suscripción, seleccione Usar almacenamiento de blobs de la suscripción actual.

En Cuenta de almacenamiento, seleccione la cuenta de almacenamiento que creó como parte de los requisitos previos.

En Contenedor, seleccione el contenedor que creó en la cuenta de almacenamiento seleccionada.

En Formato de serialización de eventos, seleccione CSV.

En Delimitador, seleccione tabulación.

En Codificación, seleccione UTF-8.

Haga clic en Crear. El portal ahora agrega la entrada y prueba la conexión a ella.

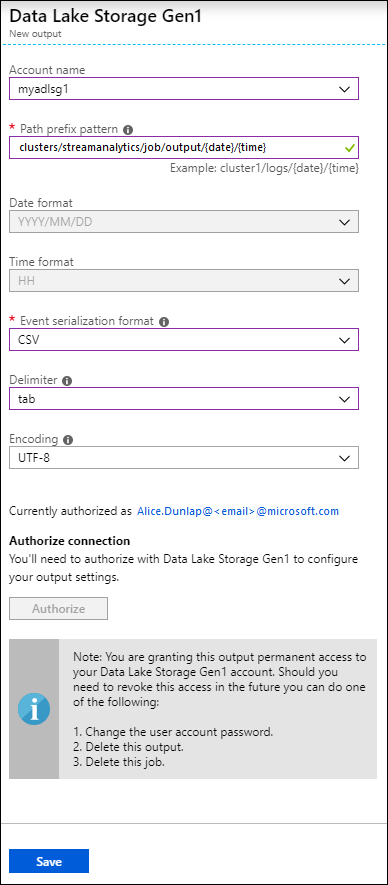

Creación de una salida de Data Lake Storage Gen1 para el trabajo

Abra la página del trabajo de Stream Analytics, haga clic en la pestaña Salidas y en Agregar y seleccione Data Lake Storage Gen1.

En la hoja Nueva salida, proporcione los siguientes valores.

- En Alias de salida, escriba un nombre único para la salida del trabajo. Se trata de un nombre descriptivo utilizado en las consultas para dirigir la salida de la consulta a esta cuenta de Data Lake Storage Gen1.

- Se le pedirá que autorice el acceso a la cuenta de Data Lake Storage Gen1. Haga clic en Autorizar.

En la hoja Nueva salida, proporcione los siguientes valores.

En Nombre de cuenta, seleccione la cuenta de Data Lake Storage Gen1 que ya ha creado como ubicación a la que quiere que se envíe la salida del trabajo.

En Patrón de prefijo de la ruta, escriba una ruta de archivo usada para escribir los archivos en la cuenta de Data Lake Storage Gen1 especificada.

En Date format (Formato de fecha), si usó un token de fecha en la ruta del prefijo, puede seleccionar el formato de fecha en el que se organizan sus archivos.

En Time format (Formato de hora), si usó un token de hora en la ruta del prefijo, especifique el formato de hora en el que se organizan sus archivos.

En Formato de serialización de eventos, seleccione CSV.

En Delimitador, seleccione tabulación.

En Codificación, seleccione UTF-8.

Haga clic en Crear. El portal ahora agrega la salida y prueba la conexión a ella.

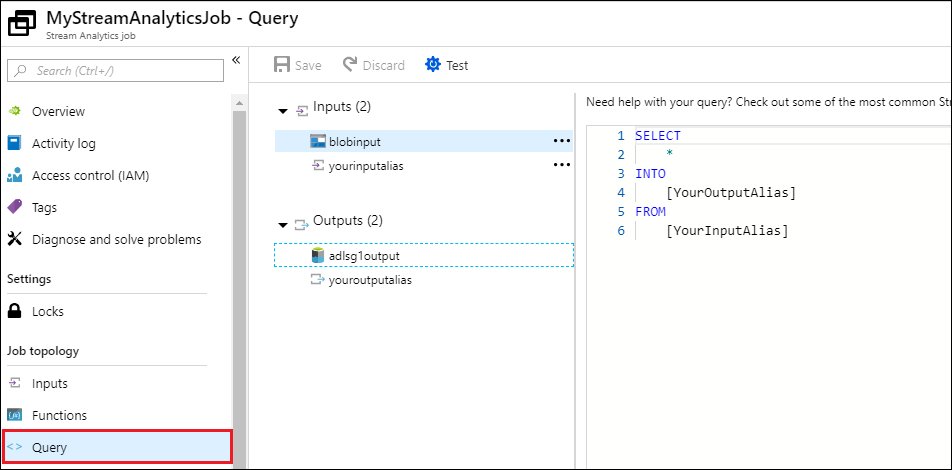

Ejecución del trabajo de Stream Analytics

Para ejecutar un trabajo de Stream Analytics, debe ejecutar una consulta desde la pestaña Consulta. En este tutorial, puede ejecutar la consulta de ejemplo mediante el reemplazo de los marcadores de posición con los alias de entrada y salida del trabajo, tal como se muestra en la captura de pantalla siguiente.

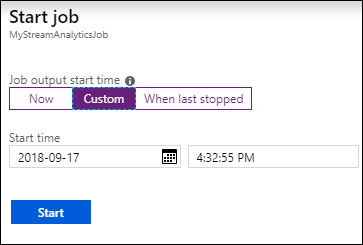

Haga clic en Guardar en la parte superior de la pantalla y, a continuación, en Overview (Introducción), haga clic en Iniciar. En el cuadro de diálogo, seleccione Hora personalizada y, después, seleccione la fecha y la hora actuales.

Haga clic en Iniciar para iniciar el trabajo. Puede tardar unos minutos en iniciarse el trabajo.

Para desencadenar el trabajo que selecciona los datos del blob, copie un archivo de datos de ejemplo en el contenedor de blobs. Puede obtener un archivo de datos de ejemplo en el repositorio Git de Azure Data Lake. En este tutorial, vamos a copiar el archivo vehicle1_09142014.csv. Puede utilizar varios clientes, como el explorador de Azure Storage, para cargar datos en un contenedor de blobs.

En la pestaña Overview (Introducción), en Monitoring (Supervisión), consulte cómo se han procesado los datos.

Finalmente, puede verificar que los datos de salida del trabajo estén disponibles en la cuenta de Data Lake Storage Gen1.

En el panel del Explorador de datos, tenga en cuenta que la salida se escribe en una ruta de carpeta, según lo especificado en la configuración de salida de Data Lake Storage Gen1 (

streamanalytics/job/output/{date}/{time}).