Identificación de las cargas de trabajo de Azure Databricks

Azure Databricks ofrece funcionalidades para varias cargas de trabajo, como Machine Learning y modelos de lenguaje grande (LLM), ciencia de datos, ingeniería de datos, BI y almacenamiento de datos y procesamiento de streaming.

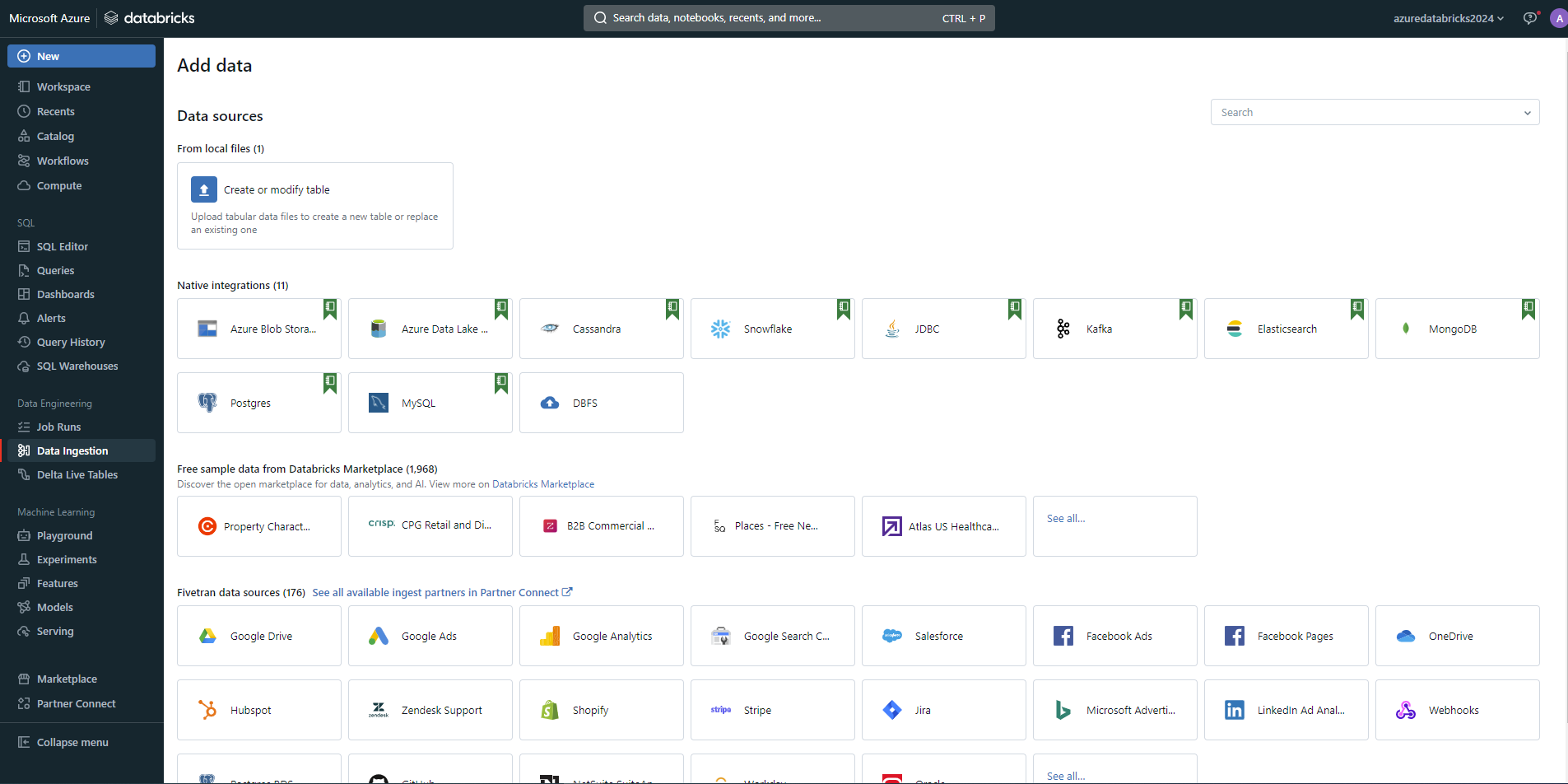

Ingeniería de datos

Azure Databricks proporciona funcionalidades para científicos de datos e ingenieros que necesitan colaborar en tareas complejas de procesamiento de datos. Proporciona un entorno integrado con Apache Spark para el procesamiento de macrodatos en una instancia de almacén de lago de datos y admite varios lenguajes, como Python, R, Scala y SQL. La plataforma facilita la exploración, visualización y desarrollo de las canalizaciones de datos.

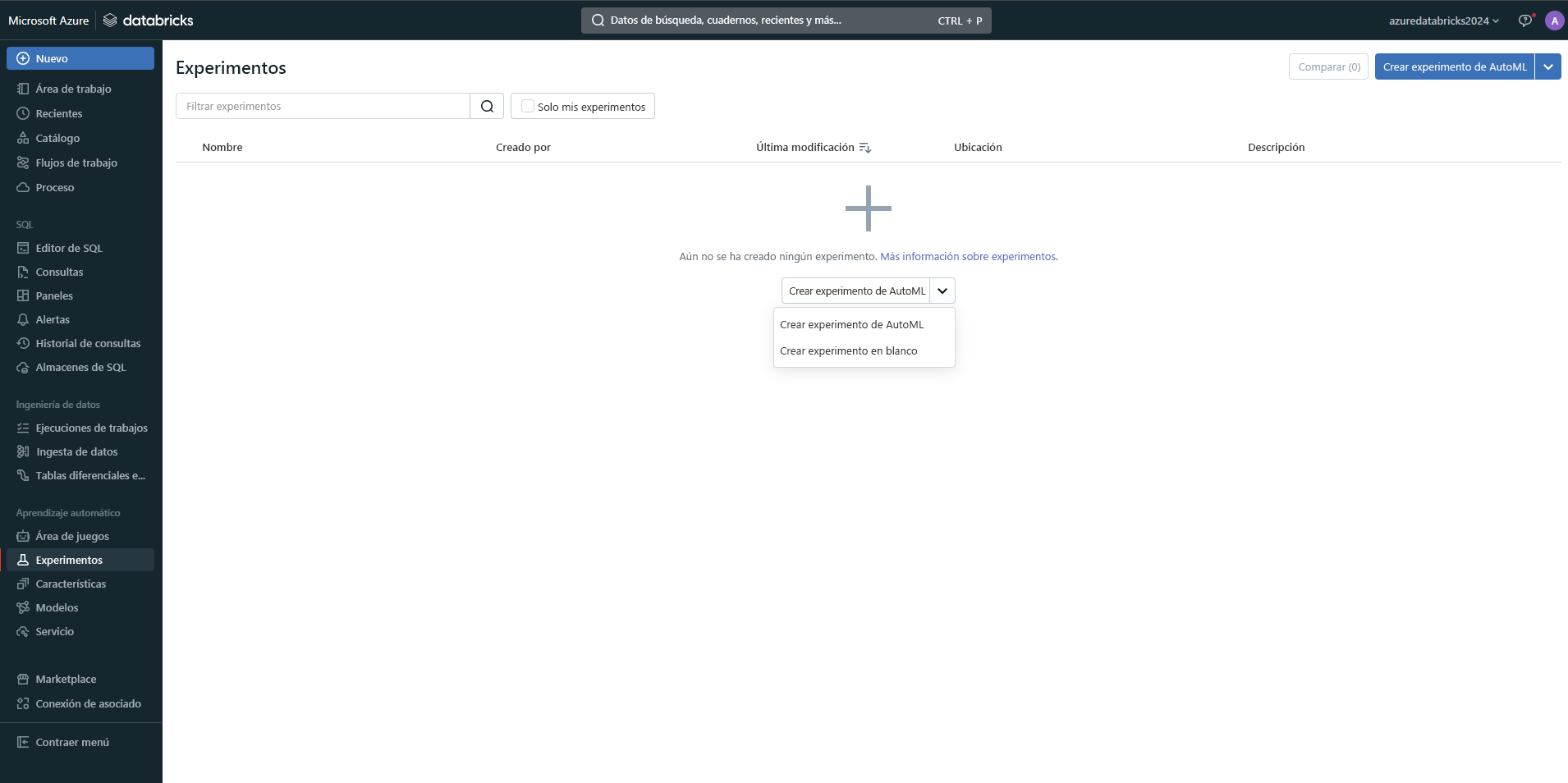

Aprendizaje automático

Azure Databricks admite la creación, el entrenamiento y la implementación de modelos de Machine Learning a escala. Incluye MLflow, una plataforma de código abierto para administrar el ciclo de vida de Machine Learning, incluida la experimentación, la reproducibilidad y la implementación. También admite varios marcos de aprendizaje automático, como TensorFlow, PyTorch y Scikit-learn, lo que lo hace versátil para diferentes tareas de Machine Learning.

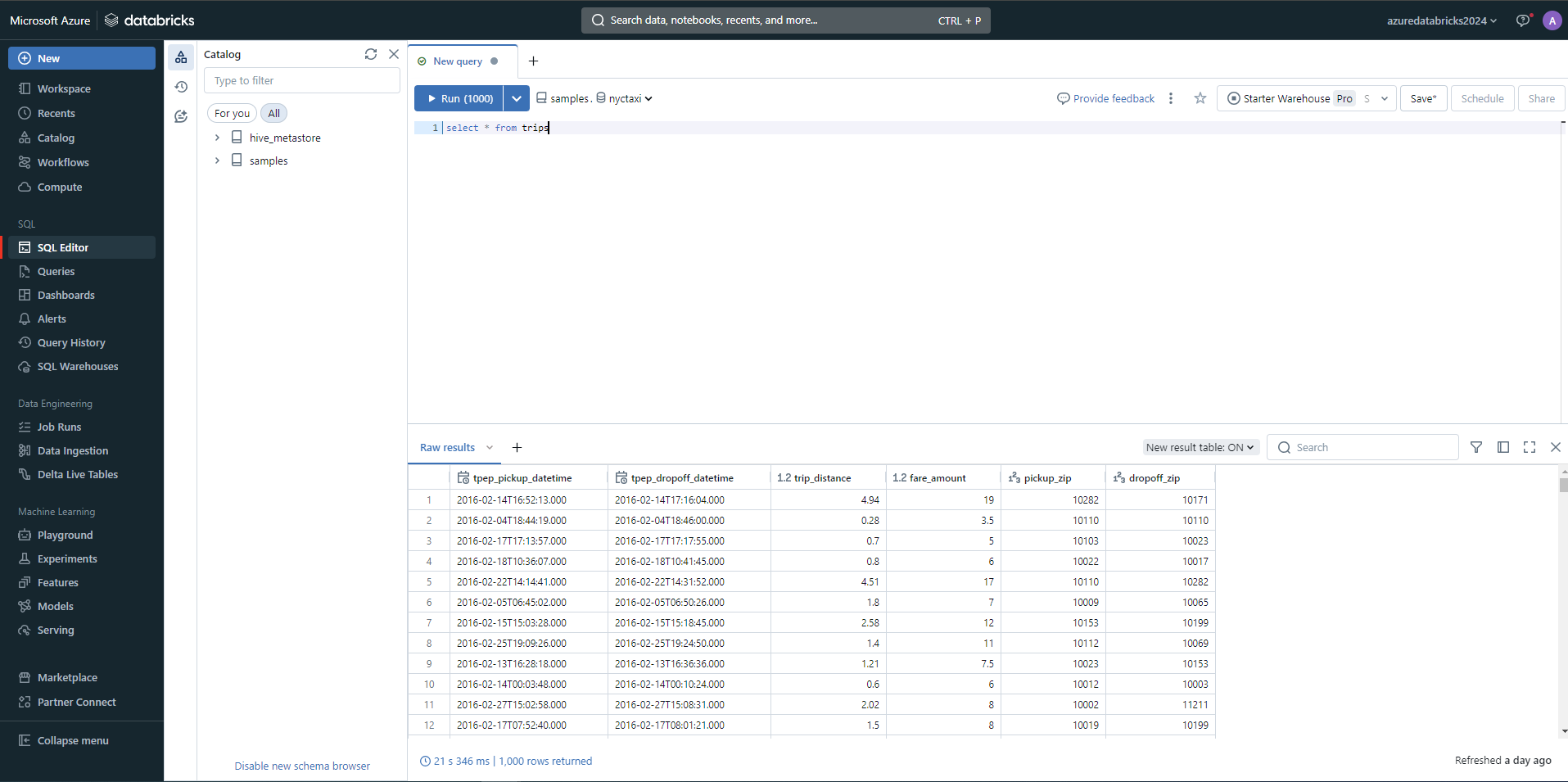

SQL

Los analistas de datos que interactúan principalmente con los datos a través de SQL pueden usar almacenes de SQL en Azure Databricks. La interfaz de usuario del área de trabajo de Azure Databricks proporciona un conocido editor de SQL, paneles y herramientas de visualización automática para analizar y visualizar datos directamente en Azure Databricks. Esta carga de trabajo es ideal para ejecutar consultas ad hoc rápidas y crear informes a partir de grandes conjuntos de datos.

Nota:

Los almacenes de SQL se incluyen en el nivel Premium (o superior). El área de trabajo estándar no proporciona almacenamientos de SQL.