Describir cómo Microsoft Copilot for Security procesa las solicitudes de consultas

Por lo tanto, ahora que hay un conocimiento básico de los complementos, capacidades y cómo interactúa el usuario con Microsoft Copilot for Security mediante avisos, vale la pena echar un vistazo a los entresijos, para ver cómo estos componentes se unen a fin de procesar una solicitud de aviso y ayudar a los analistas de seguridad.

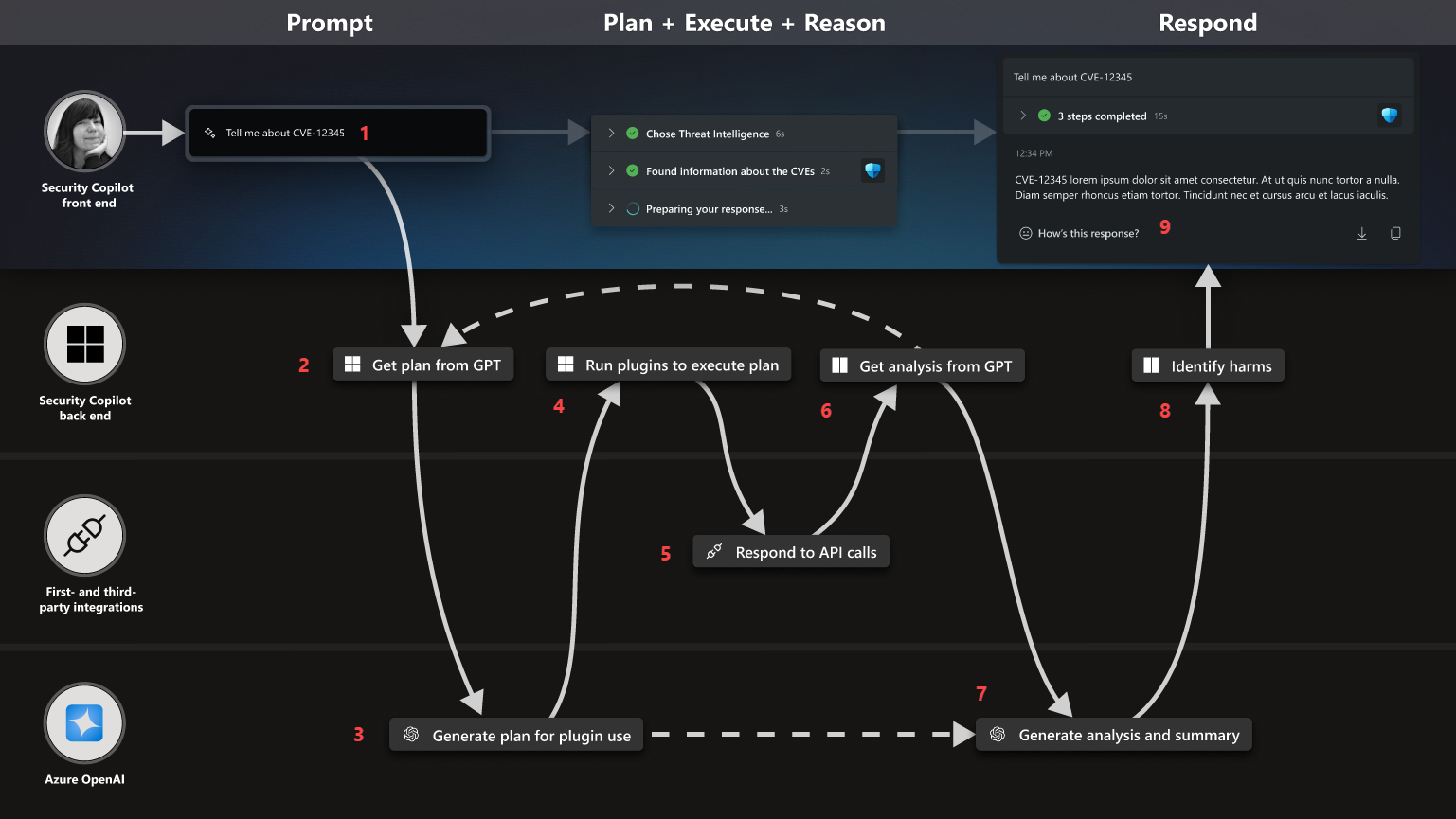

Flujo del proceso

Cuando un usuario envía un aviso, Copilot procesa ese aviso para generar la mejor respuesta posible. En el diagrama siguiente se muestran los pasos del proceso para proporcionar una comprensión general de lo que sucede y cómo se produce la respuesta.

El proceso se inicia cuando un usuario envía un aviso en la barra de avisos. Una vez que el usuario envía su aviso, se envía al back-end de Copilot al que se conoce como orquestador. El orquestador es el sistema de Copilot para crear capacidades juntas a fin de responder a la solicitud de un usuario.

Copilot agrupa la solicitud del usuario y una lista completa de las capacidades de Copilot para los orígenes habilitados (complementos y knowledge bases) y, a continuación, la envía a Azure OpenAI con la solicitud de elaborar un plan para satisfacer la solicitud del usuario

Azure OpenAI ejecuta LLM avanzados para hacer coincidir la solicitud con las capacidades disponibles y crear un plan (conjunto de pasos) para satisfacer la solicitud del usuario. Ese plan se devuelve al orquestador.

- Si no coincide ninguna funcionalidad, la respuesta a la solicitud del usuario se genera mediante el LLM de conocimiento general y el proceso salta al paso 7.

- El LLM de conocimiento general es bueno en conocimientos generales y la resolución de problemas, pero no está centrado exclusivamente en la seguridad, por lo que hay una mayor probabilidad de que la respuesta proporcionada no sea precisa. Por este motivo, resulta beneficioso habilitar complementos y conectarse a las bases de conocimiento para aportar una colección de capacidades específicas de recursos a Copilot.

El orquestador de Copilot lleva a cabo el plan; para ello, ejecuta el código de los complementos o capacidades seleccionados y llama a las interfaces de programación de aplicaciones (API) adecuadas a fin de recopilar información y tomar medidas.

Las aplicaciones de asociados de integración propias y de terceros recopilan información, ejecutan acciones basadas en la llamada API y envían la respuesta a Copilot.

El orquestador recibe la respuesta de las llamadas API, pero aún no está lista para enviarse al usuario. Copilot recorre en iteración el proceso para garantizar la mejor respuesta. Antes de que se pueda enviar una respuesta final al usuario, el orquestador agrupa esa respuesta con la solicitud original y la envía de vuelta a Azure OpenAI.

Azure OpenAI usa el poder de su LLM avanzado a fin de componer una respuesta mediante lenguaje que tendrá sentido para un ser humano.

Esa respuesta se envía a Copilot para que lo revisen los modelos de IA responsable de Microsoft que buscan cualquier comentario malintencionado, discurso de odio, etc.

- Si todo está bien, se envía la respuesta al usuario.

- Si se detecta algo malintencionado o inapropiado, se genera un mensaje de error en lugar de enviar la información al usuario.

El usuario recibe la respuesta de Copilot.

Registro de procesos

Durante este proceso, Copilot genera un registro de procesos que es visible para el usuario. El usuario puede ver qué capacidad se usa para generar la respuesta. Esto es importante porque permite al usuario determinar si la respuesta se ha generado a partir de una fuente de confianza. En la captura de pantalla siguiente, el registro de procesos muestra que Copilot eligió el complemento de Microsoft Sentinel y enumera la capacidad seleccionada. El registro del proceso también muestra que el resultado final pasó por comprobaciones de seguridad, lo que forma parte del compromiso de Microsoft con una IA responsable.