¿Qué es Azure Content Moderator?

Importante

Azure Content Moderator está en desuso desde febrero de 2024 y se retirará en febrero de 2027. Será reemplazada por Seguridad del contenido de Azure AI, que ofrece características avanzadas de IA y un rendimiento mejorado.

Seguridad del contenido de Azure AI es una solución completa diseñada para detectar contenido perjudicial generado por el usuario y generado por IA en aplicaciones y servicios. Seguridad del contenido de Azure AI es adecuada para muchos escenarios, como marketplaces en línea, empresas de juegos, plataformas de mensajería social, empresas de medios empresariales y proveedores de soluciones para educación K-12. Esta es una introducción a sus características y funcionalidades:

- API de detección de texto e imágenes: examina texto e imágenes para detectar contenido sexual, violencia, odio y autolesión con varios niveles de gravedad.

- Content Safety Studio: una herramienta en línea diseñada para controlar todo aquel contenido que sea potencialmente ofensivo, arriesgado o no deseable mediante nuestros últimos modelos de ML de moderación de contenido. Proporciona plantillas y flujos de trabajo personalizados que permiten a los usuarios crear sus propios sistemas de moderación de contenido.

- Compatibilidad con idiomas: Seguridad del contenido de Azure AI admite más de 100 idiomas y está entrenada específicamente en inglés, alemán, japonés, español, francés, italiano, portugués y chino.

Seguridad del contenido de Azure AI proporciona una solución sólida y flexible para sus necesidades de moderación de contenido. Al cambiar de Content Moderator a Seguridad del contenido de Azure AI, puede aprovechar las herramientas y tecnologías más recientes para asegurarse de que el contenido siempre esté moderado conforme a sus especificaciones exactas.

Obtenga más información sobre Seguridad del contenido de Azure AI y explore cómo puede elevar su estrategia de moderación de contenido.

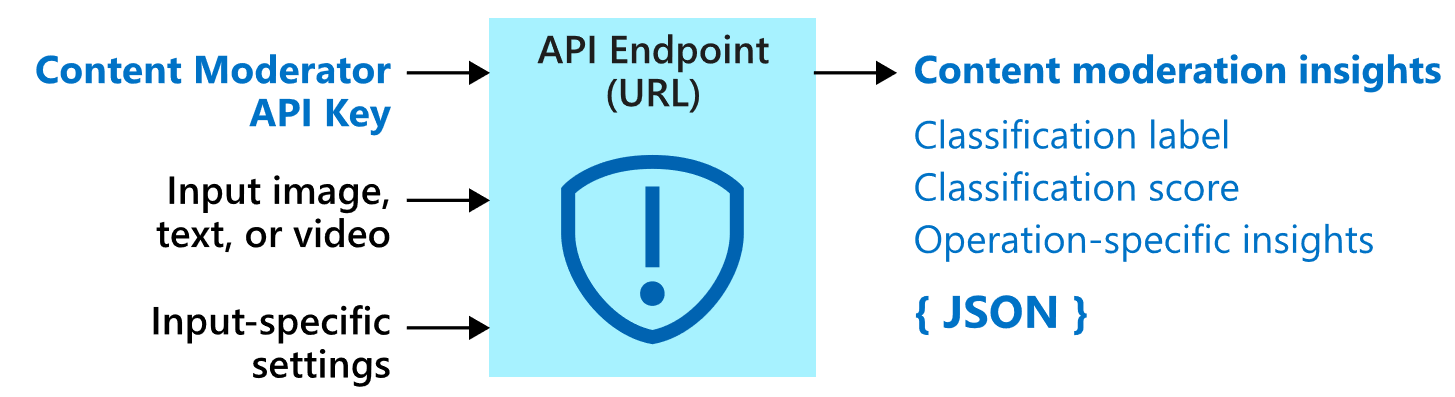

Azure Content Moderator es un servicio de inteligencia artificial que le permite controlar el contenido que puede ser ofensivo, arriesgado o no deseable. Incluye el servicio de moderación de contenido basado en IA que analiza texto, imágenes y vídeos, así como aplica marcas de contenido automáticamente.

Compile software de filtrado de contenido en la aplicación para cumplir con las regulaciones o para mantener el entorno previsto para los usuarios.

Esta documentación contiene los siguientes tipos de artículos:

- Los inicios rápidos son instrucciones de inicio que le guiarán a la hora de hacer solicitudes al servicio.

- Las guías de procedimientos contienen instrucciones para usar el servicio de una manera más específica o personalizada.

- Los conceptos proporcionan explicaciones detalladas sobre la funcionalidad y las características del servicio.

Para obtener un enfoque más estructurado, siga un módulo de entrenamiento para Content Moderator.

Dónde se usa

Los siguientes son algunos escenarios en los que un desarrollador o un equipo de desarrolladores de software usaría un servicio de moderación de contenido:

- Mercados en línea que moderan catálogos de productos y otro contenido generado por el usuario.

- Empresas de juegos que moderan los artefactos de juego generados por el usuario y las salas de chat.

- Plataformas de mensajería de las redes sociales que moderan las imágenes, el texto y los vídeos que agregan los usuarios.

- Empresas multimedia que implementan la moderación de centralizada de su contenido.

- Proveedores de soluciones educativas de tipo K-12 que filtran contenido que no es apropiado para alumnos y educadores.

Importante

No puede usar Content Moderator para detectar imágenes ilegales de explotación infantil. Sin embargo, las organizaciones cualificadas pueden usar PhotoDNA Cloud Service para filtrar este tipo de contenido.

Qué incluye

El servicio Content Moderator consta de varias API de servicio de web disponibles mediante llamadas REST y un SDK de .NET.

API de moderación

El servicio Content Moderator incluye las API de moderación, que comprueban el contenido en busca de material que sea potencialmente inadecuado o inapropiado.

En la tabla siguiente se describen los distintos tipos de API de moderación.

| Grupo de API | Descripción |

|---|---|

| Moderación de texto | Examina si el texto contiene contenido ofensivo, sexualmente explícito o sugerente, blasfemias y datos personales. |

| Listas de términos personalizada | Analiza el texto con respecto a una lista personalizada de términos, además de los términos integrados. Use listas personalizadas para bloquear o permitir el contenido en función de sus propias directivas de contenido. |

| Moderación de imágenes | Analiza imágenes en busca de contenido para adultos o inapropiado, detecta texto en imágenes con la funcionalidad de reconocimiento óptico de caracteres (OCR) y detecta rostros. |

| Listas de imágenes personalizadas | Analiza imágenes con una lista personalizada de imágenes. Use las listas de imágenes personalizadas para filtrar el contenido comúnmente recurrente que no desea volver a clasificar. |

| Moderación en vídeos | Examina si los vídeos tienen contenido para adultos o inapropiado y devuelve los marcadores de tiempo de dicho contenido. |

Seguridad y privacidad de datos

Al igual que sucede con todos los servicios de Azure AI, los desarrolladores que usan el servicio Content Moderator deben estar al tanto de las directivas de Microsoft sobre los datos de los clientes. Para más información, consulte la página de servicios de Azure AI en Microsoft Trust Center.

Pasos siguientes

- Complete un inicio rápido de la biblioteca cliente o API de REST para implementar los escenarios básicos en el código.