Selección de cámara en la inteligencia artificial de visión de Azure IoT Edge

Uno de los componentes más críticos de un sistema de Computer Vision es la cámara. La cámara debe capturar y presentar imágenes que los modelos de inteligencia artificial (IA) o aprendizaje automático (ML) puedan evaluar e identificar correctamente. En este artículo, se proporciona una descripción detallada de los distintos tipos de cámara, funcionalidades y consideraciones.

Tipos de cámaras

Los tipos de cámara incluyen el examen de área, el examen de línea y las cámaras inteligentes insertadas. Hay muchos fabricantes diferentes para estas cámaras. Seleccione un proveedor que se adapte a sus necesidades específicas.

Cámaras de examen de área

Las cámaras de examen de área generan una imagen de cámara tradicional. Esta cámara normalmente tiene una matriz de sensores de píxeles. La cámara captura una imagen 2D y la envía al hardware de Azure IoT Edge para su evaluación.

Las cámaras de examen de área observan un área grande y son buenas para detectar cambios. Algunos ejemplos de cargas de trabajo que pueden usar cámaras de examen de área son la seguridad del área de trabajo o la detección o recuento de objetos en un entorno.

Cámaras de examen de línea

Una cámara de examen de línea tiene una sola fila de sensores de píxeles lineales. La cámara toma imágenes de 1 píxel de ancho en una sucesión rápida, las une en una secuencia de vídeo y envía la secuencia al dispositivo IoT Edge para su procesamiento.

Las cámaras de examen de línea son ideales para las cargas de trabajo de visión en las que los elementos que se van a identificar se mueven más allá de la cámara o se deben rotar para detectar defectos. A continuación, la cámara de examen de línea genera un flujo de imágenes continuo para su evaluación. Algunos ejemplos de cargas de trabajo que funcionarían mejor con una cámara de examen de línea son:

- Detección de defectos de elementos en piezas que se mueven en una cinta transportadora

- Cargas de trabajo que requieren girar para ver un objeto cilíndrico

- Cargas de trabajo que requieren rotación

Cámaras inteligentes integradas

Una cámara inteligente insertada es un sistema independiente y autocontenido que puede procesar y adquirir imágenes. Las cámaras inteligentes insertadas pueden utilizar una cámara de examen de área o una cámara de examen de línea para capturar las imágenes, aunque una cámara inteligente de examen de línea es poco habitual. Estas cámaras normalmente tienen un puerto de salida RS232 o Ethernet, por lo que pueden integrarse directamente en un controlador lógico programable (PLC) u otro controlador IoT industrial (IIoT).

Características de la cámara

Hay varias características que se deben tener en cuenta al seleccionar una cámara para una carga de trabajo de visión. En las secciones siguientes, se describe el tamaño, la resolución y la velocidad del sensor. Otras características de la cámara que se deben tener en cuenta son:

- Selección de lentes

- Longitud focal

- Profundidad monocromática o de color

- Profundidad de estéreo

- Desencadenadores

- Tamaño físico

- Soporte técnico

Los fabricantes de cámaras pueden ayudarle a comprender qué características específicas requiere la aplicación.

Tamaño del sensor

El tamaño del sensor es uno de los factores más importantes que se deben evaluar en una cámara. Un sensor es el hardware de una cámara que captura el objetivo y lo convierte en señales, lo que genera una imagen. El sensor contiene millones de fotodetectores semiconductores llamados fotositios.

Un número mayor de megapíxeles no siempre produce una imagen mejor. Por ejemplo, una cámara con 12 millones de fotositios y un sensor de 1 pulgada genera una imagen más clara y más nítida que una cámara con 12 millones de fotositios y un sensor de ½ pulgada. Las cámaras para cargas de trabajo de Computer Vision suelen tener tamaños de sensor entre ¼ de pulgada y 1 pulgada. Algunos casos pueden requerir sensores mucho más grandes.

Elija sensores más grandes si la carga de trabajo de visión tiene:

- Necesidad de medidas de precisión

- Condiciones de poca luz

- Tiempos de exposición más cortos o elementos que se mueven rápidamente

Resolución

La resolución es otro factor importante en la selección de la cámara. Necesita cámaras de mayor resolución si la carga de trabajo:

- Debe identificar características finas, como la escritura en un chip de circuito integrado.

- Intenta detectar caras

- Necesita identificar los vehículos desde una distancia

En las imágenes siguientes, se muestra el problema con el uso de una resolución incorrecta para un caso de uso determinado. Ambas imágenes se tomaron a 6 metros del automóvil. Los cuadros rojos pequeños representan un píxel.

La siguiente imagen se tomó con 480 píxeles horizontales:

La siguiente imagen se tomó con 5184 píxeles horizontales:

Velocidad

Si la carga de trabajo de visión requiere capturar muchas imágenes por segundo, son importantes dos factores. El primer factor es la velocidad de la conexión de la interfaz de la cámara. El segundo factor es el tipo de sensor. Los sensores se clasifican en dos tipos: dispositivos acoplados a carga (CCD) y sensores de píxeles activos (CMOS). Los sensores CMOS tienen una lectura directa desde los fotositios, por lo que normalmente ofrecen una velocidad de fotogramas mayor.

Selección de ubicación de la cámara

Los elementos que debe capturar en la carga de trabajo de visión determinan las ubicaciones y los ángulos para la ubicación de la cámara. La ubicación de la cámara también puede afectar al tipo de sensor, el tipo de lente y el tipo de cuerpo de la cámara. Dos de los factores más críticos para determinar la ubicación de la cámara son la iluminación y el campo de visión.

Iluminación de la cámara

En una carga de trabajo de Computer Vision, la iluminación es crítica para la ubicación de la cámara. Puede aplicar varias condiciones de iluminación diferentes. Las condiciones de iluminación que son útiles para una carga de trabajo de visión pueden producir efectos no deseados en una carga de trabajo diferente.

Hay varios tipos de iluminación comunes para cargas de trabajo de Computer Vision:

- La iluminación directa es la condición de iluminación más común. La fuente de luz se proyecta en el objeto que se va a capturar.

- La iluminación de línea es una matriz única de luces, más usadas con cámaras de examen de línea. La iluminación de línea crea una sola línea de luz en el foco de la cámara.

- La iluminación difusa ilumina un objeto, pero evita sombras inesperadas. La iluminación difusa se usa principalmente en torno a objetos especulares o reflectantes.

- La iluminación difusa axial a menudo se usa con objetos altamente reflectantes o para evitar sombras en la pieza que se va a capturar.

- La retroiluminación se usa detrás del objeto, lo que produce una silueta del objeto. La retroiluminación es muy útil cuando se toman medidas, para la detección de bordes o la orientación de objetos.

- La iluminación de cuadrícula personalizada es una condición de iluminación estructurada que dispone una cuadrícula de luz en el objeto. La proyección de cuadrícula conocida proporciona medidas más precisas de los componentes, las piezas y la colocación de los elementos.

- La iluminación estroboscópica se usa para piezas que se mueven a alta velocidad. La iluminación estroboscópica debe estar sincronizada con la cámara para tomar una imagen congelada del objeto para su evaluación. La iluminación estroboscópica ayuda a evitar efectos de desenfoque en movimiento.

- La iluminación de campo oscuro usa varias luces con ángulos diferentes para la pieza que se va a capturar. Por ejemplo, si el elemento está plano en una cinta transportadora, las luces están en un ángulo de 45 grados con respecto a la cinta. La iluminación de campo oscuro es más útil con objetos claros muy reflectantes y se usa normalmente para las detecciones de arañazos de lentes.

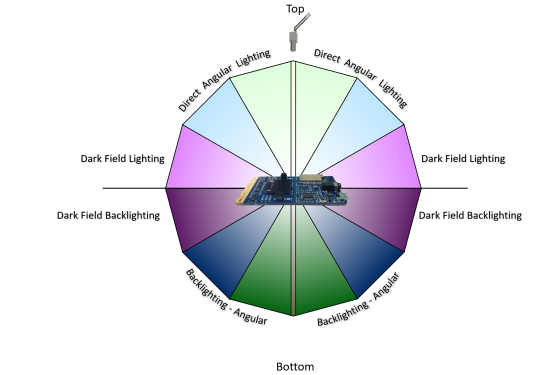

En la ilustración siguiente, se muestra la ubicación angular de las fuentes de luz:

Campo de visión

Al planear una carga de trabajo de visión, debe conocer el campo de visión (FOV) de los objetos que está evaluando. El FOV desempeña un papel en la selección de la cámara, la selección de sensores y la configuración de la lente. Los componentes del FOV incluyen:

- Distancia a los objetos. Por ejemplo, ¿se está supervisando el objeto en una cinta transportadora con la cámara unos centímetros encima o en un aparcamiento? Los sensores de cámara y las configuraciones de lentes son diferentes para diferentes distancias.

- Área de cobertura. ¿el área que intenta supervisar el sistema de Computer Vision es pequeña o grande? Este factor se correlaciona directamente con la resolución, la lente y el tipo de sensor de la cámara.

- Dirección del sol. Si la carga de trabajo de Computer Vision está en el exterior, debe tener en cuenta la dirección del sol a lo largo del día. El ángulo del sol a medida que se mueve podría afectar al modelo de Computer Vision. Si la cámara recibe luz solar directa en la lente, es posible que la cámara se ciegue hasta que cambie el ángulo del sol. Si el sol proyecta una sombra sobre el objeto que se está supervisando, el objeto podría estar oscurecido.

- Ángulo de la cámara con los objetos. Si la cámara está demasiado alta o demasiado baja, puede que se pierdan los detalles que intenta capturar la carga de trabajo.

Interfaz de comunicación

Al planear una carga de trabajo de Computer Vision, es importante comprender cómo interactúa la salida de la cámara con el resto del sistema. Hay varias maneras estándar en las que las cámaras se comunican con los dispositivos IoT Edge:

El Protocolo de streaming en tiempo real (RTSP) es un protocolo de red de nivel de aplicación que controla los servidores de vídeo de streaming. RTSP transfiere datos de vídeo en tiempo real desde la cámara al punto de conexión de proceso de IoT Edge mediante una conexión TCP/IP.

Open Network Video Interface Forum (ONVIF) es un foro global del sector abierto que desarrolla estándares abiertos para cámaras basadas en IP. Estos estándares describen la comunicación entre las cámaras IP y los sistemas del flujo descendente, la interoperabilidad y son de código abierto.

Las cámaras conectadas al bus serie universal (USB) se conectan mediante el puerto USB directamente al dispositivo de proceso de IoT Edge. Esta conexión es menos compleja, pero limita la distancia a la que se puede encontrar la cámara del dispositivo IoT Edge.

La interfaz serie de cámara (CSI) incluye varios estándares de la alianza Mobile Industry Processor Interface (MIPI). CSI describe la comunicación entre una cámara y un procesador host. CSI-2, publicado en 2005, tiene varias capas:

- Capa física (C-PHY o D-PHY)

- Capa de fusión de carril

- Capa de protocolo de bajo nivel

- Capa de conversión de píxel a byte

- Nivel de aplicación

CSI-2 v3.0 agregó compatibilidad con la profundidad de color RAW-24, el vínculo serie unificado y la región de interés inteligente.

Colaboradores

Microsoft mantiene este artículo. Originalmente lo escribieron los siguientes colaboradores.

Autor principal:

- Keith Hill | Administrador PM sénior

Para ver los perfiles no públicos de LinkedIn, inicie sesión en LinkedIn.

Pasos siguientes

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente las Cuestiones de GitHub como mecanismo de retroalimentación para el contenido y lo sustituiremos por un nuevo sistema de retroalimentación. Para más información, consulta: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de