¿Cómo funciona el Administrador de orquestación de flujo de trabajo de Azure Data Factory?

SE APLICA A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Sugerencia

Pruebe Data Factory en Microsoft Fabric, una solución de análisis todo en uno para empresas. Microsoft Fabric abarca todo, desde el movimiento de datos hasta la ciencia de datos, el análisis en tiempo real, la inteligencia empresarial y los informes. ¡Obtenga más información sobre cómo iniciar una nueva evaluación gratuita!

Nota:

El Administrador de orquestación de flujo de trabajo cuenta con la tecnología de Apache Airflow.

Nota:

El Administrador de orquestación de flujo de trabajo para Azure Data Factory se basa en la aplicación Apache Airflow de código abierto. Puede encontrar documentación y más tutoriales para Airflow en las páginas de documentación o la comunidad de Apache Airflow.

El Administrador de orquestación de flujo de trabajo en Azure Data Factory usa grafos acíclicos dirigidos (DAG) basados en Python para ejecutar los flujos de trabajo de orquestación. Para usar esta característica, debe proporcionar sus DAG y complementos en Azure Blob Storage. Para administrar los DAG, puede lanzar la interfaz de usuario de Airflow desde ADF mediante una interfaz de línea de comandos (CLI) o un kit de desarrollo de software (SDK).

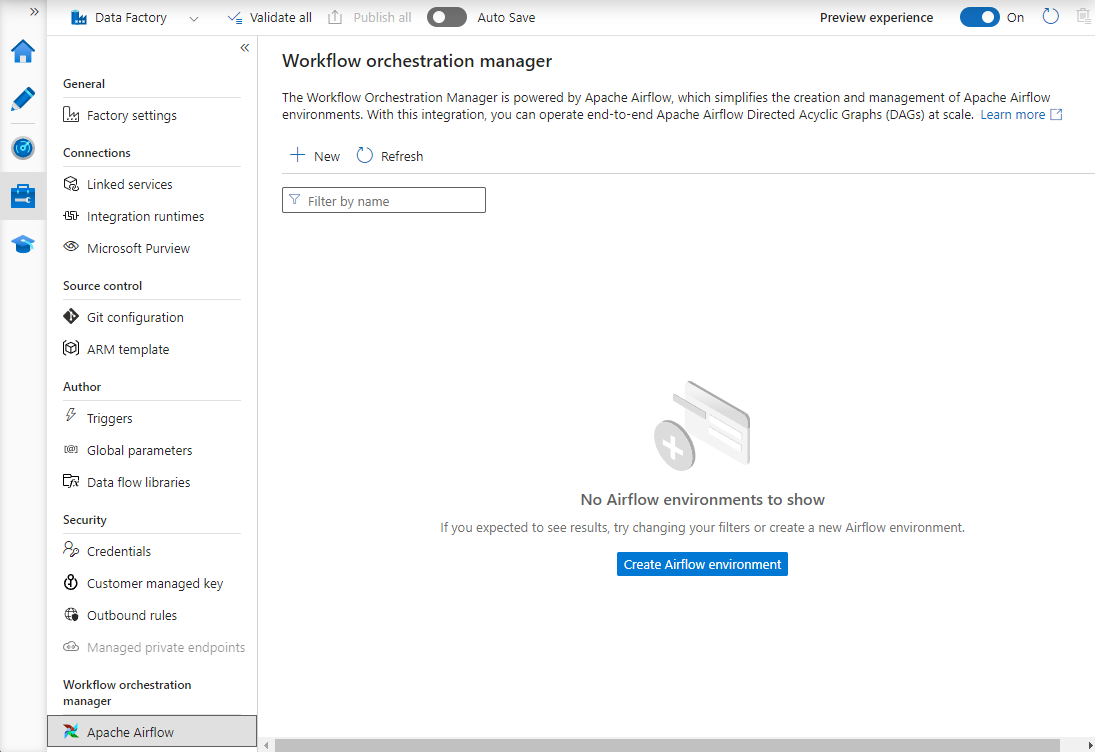

Creación de un entorno del Administrador de orquestación de flujo de trabajo

En los pasos siguientes se configura el entorno del Administrador de orquestación de flujo de trabajo.

Requisitos previos

Suscripción de Azure: si no tiene una suscripción a Azure, cree una cuenta gratuita antes de empezar. Crea o selecciona una instancia de Data Factory existente en la región donde se admita la versión preliminar del Administrador de orquestación de flujo de trabajo.

Pasos para crear el entorno

Crea un entorno del Administrador de orquestación de flujo de trabajo. Vaya a Administrar centro ->Airflow (versión preliminar) ->+Nuevo para crear un entorno de Airflow.

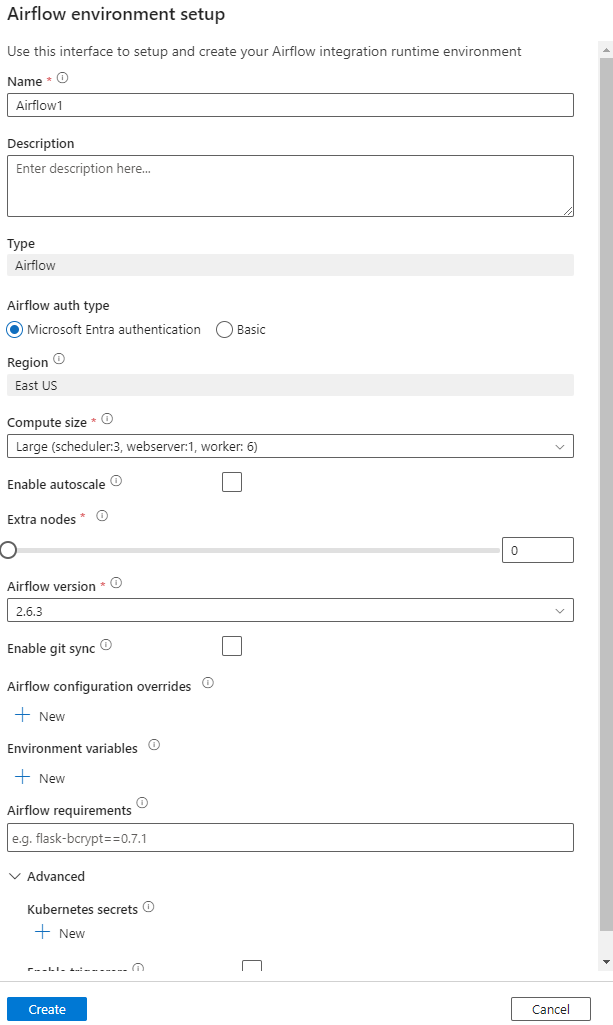

Proporcione los detalles (configuración de Airflow).

Importante

Al usar la autenticación Básica, recuerde el nombre de usuario y la contraseña especificados en esta pantalla. Será necesario iniciar sesión más adelante en la interfaz de usuario del Administrador de orquestación de flujo de trabajo. La opción predeterminada es Microsoft Entra ID y no requiere la creación de un nombre de usuario o contraseña para el entorno de Airflow, sino que usa las credenciales del usuario que ha iniciado sesión en Azure Data Factory para iniciar sesión o supervisar DAG.

Las variables de entorno son un almacén de pares clave-valor simple en Airflow para almacenar y recuperar contenido o configuración arbitrarios.

Los requisitos se pueden usar para instalar previamente las bibliotecas de Python. También puede actualizarlas más adelante.

Importación de DAG

En los pasos siguientes se describe cómo importar DAG en el Administrador de orquestación de flujo de trabajo.

Requisitos previos

Deberá cargar un DAG de ejemplo en una cuenta de almacenamiento accesible (debe estar en la carpeta dags).

Nota:

Durante la versión preliminar no se admite Blob Storage detrás de la red virtual.

No se admite la configuración de KeyVault en storageLinkedServices para importar dags.

Ejemplo de DAG de Airflow de Apache v2.x. Ejemplo de DAG de Airflow de Apache v1.10.

Pasos para importar

Copie y pegue el contenido (v2.x o v1.10 en función del entorno de Airflow que haya configurado) en un nuevo archivo denominado tutorial.py.

Cargue el archivo tutorial.py en un almacenamiento de blobs. (Procedimientos para cargar un archivo en un blob)

Nota:

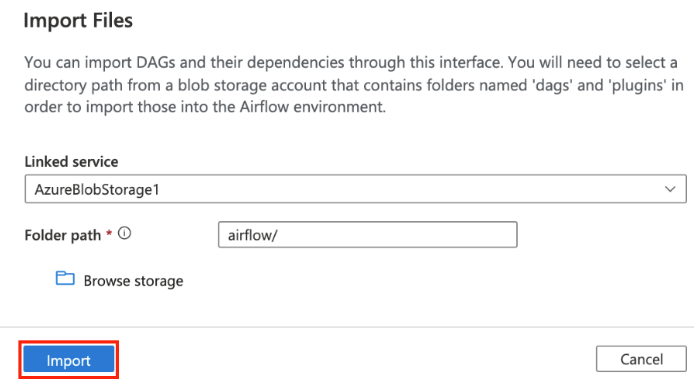

Tendrá que seleccionar una ruta de acceso de directorio de una cuenta de Blob Storage que contenga carpetas denominadas dags y plugins para importarlos en el entorno de Airflow. Los complementos no son obligatorios. También puede tener un contenedor denominado dags y cargar todos los archivos de Airflow en él.

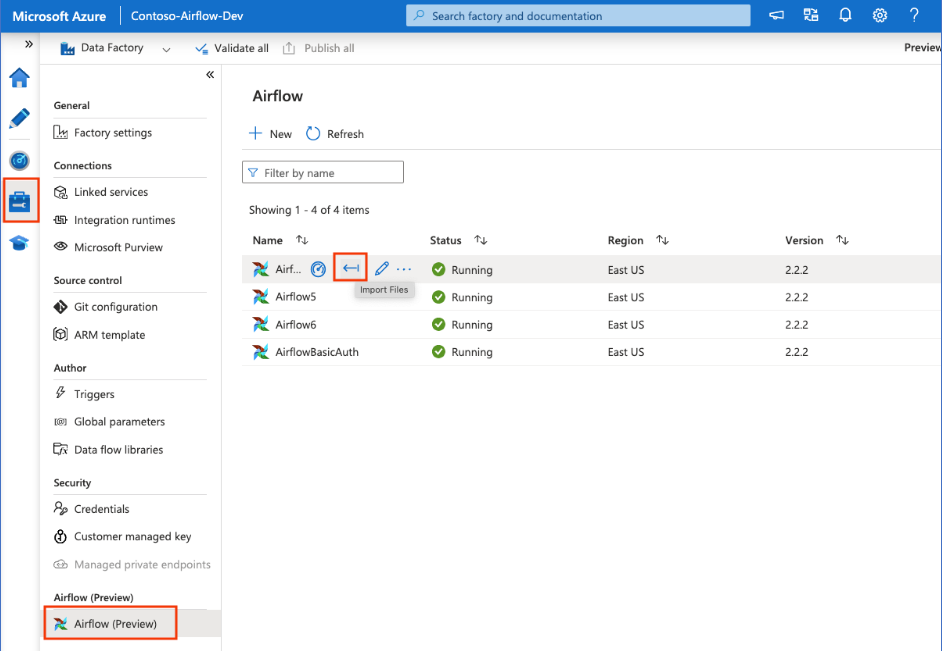

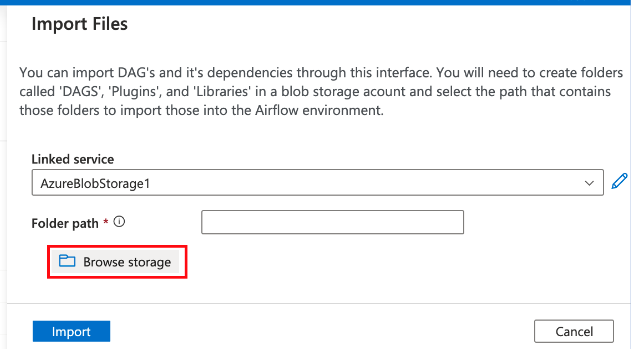

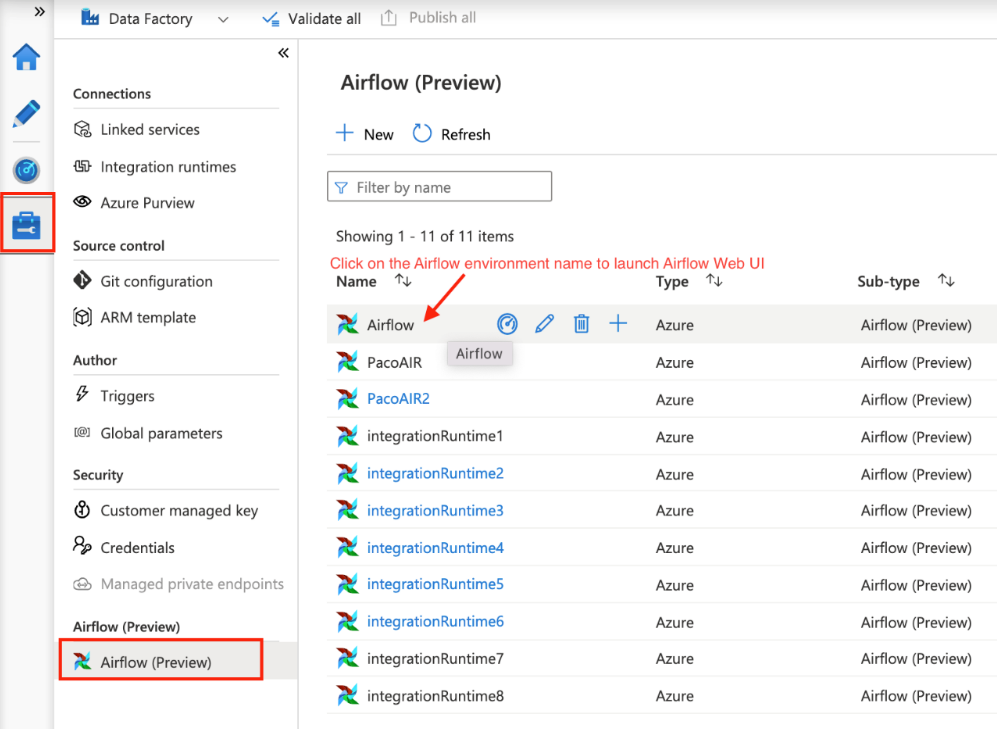

Seleccione Airflow (versión preliminar) en Administrar centro. Después, mantenga el puntero sobre el entorno de Airflow creado anteriormente y seleccione Importar archivos para importar todos los DAG y dependencias en el entorno de Airflow.

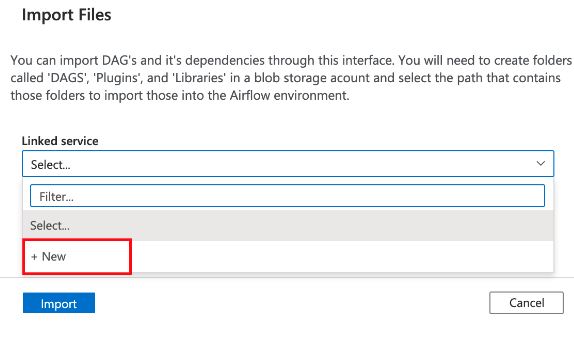

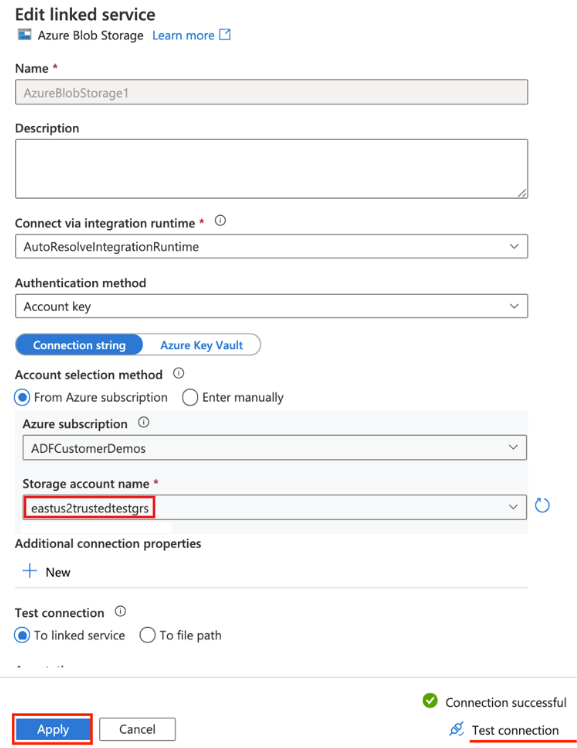

Cree un servicio vinculado a la cuenta de almacenamiento accesible mencionada en el requisito previo (o use uno existente si ya tiene sus propios DAG).

Use la cuenta de almacenamiento donde cargó el DAG (compruebe los requisitos previos). Pruebe la conexión y, después, seleccione Crear.

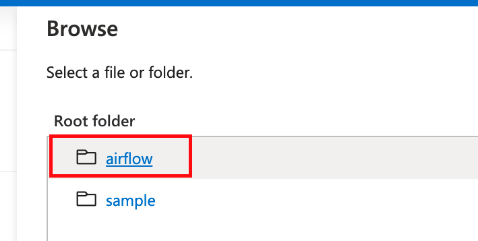

Examine y seleccione Airflow si usa la dirección URL de SAS de ejemplo o seleccione la carpeta que contiene la carpeta dags con archivos DAG.

Nota:

Puede importar DAG y sus dependencias mediante esta interfaz. Tendrá que seleccionar una ruta de acceso de directorio de una cuenta de Blob Storage que contenga carpetas denominadas dags y plugins para importarlos en el entorno de Airflow. Los complementos no son obligatorios.

Nota:

La importación de DAG puede tardar un par de minutos durante la versión preliminar. El centro de notificaciones (icono de campana en la interfaz de usuario de ADF) se puede usar para realizar un seguimiento de las actualizaciones del estado de la importación.

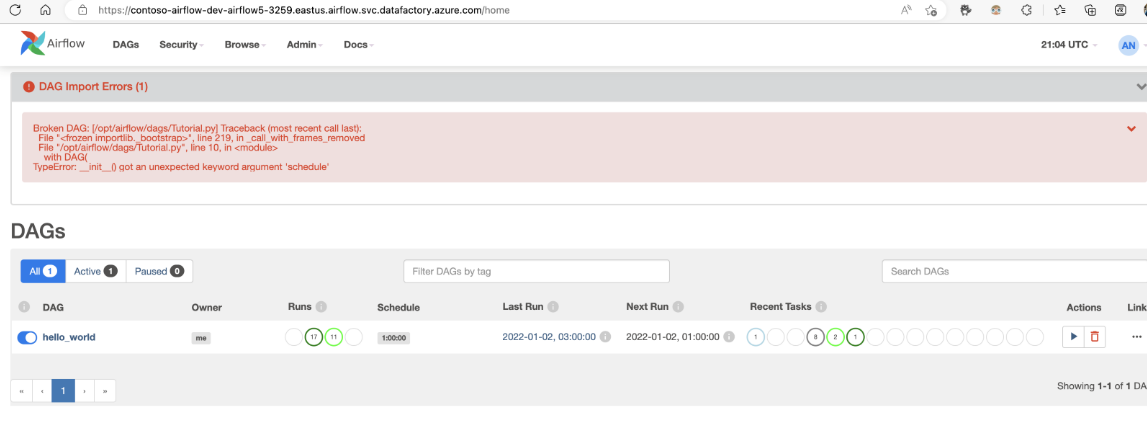

Solución de problemas de importación de DAG

Problema: la importación de DAG tarda más de 5 minutos. Mitigación: reduzca el tamaño de los DAG importados con una sola importación. Una manera de lograrlo es creando varias carpetas DAG con menos DAG en cada una en varios contenedores.

Problema: los DAG importados no aparecen al iniciar sesión en la interfaz de usuario de Airflow. Mitigación: inicie sesión en la interfaz de usuario de Airflow y compruebe si hay errores de análisis de DAG. Esto podría ocurrir si los archivos DAG contienen código incompatible. Encontrará los números de línea exactos y los archivos que tienen el problema mediante la interfaz de usuario de Airflow.

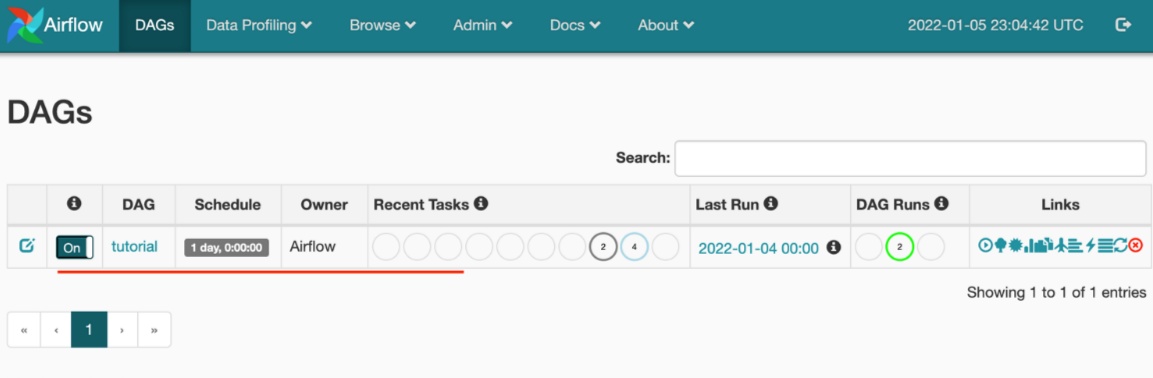

Supervisión de ejecuciones de DAG

Para supervisar los DAG de Airflow, inicie sesión en la interfaz de usuario de Airflow con el nombre de usuario y la contraseña creados anteriormente.

Seleccione en el entorno de Airflow creado.

Inicie sesión con el nombre de usuario y la contraseña proporcionados durante la creación del entorno de ejecución de integración de Airflow. (Puede restablecer el nombre de usuario o la contraseña editando el entorno de ejecución de integración de Airflow si es necesario).

Eliminación de DAG del entorno de Airflow

Si usa la versión 1.x de Airflow, elimine los DAG que se implementan en cualquier entorno de Airflow (IR); deberá eliminar los DAG en dos lugares diferentes.

- Eliminar el DAG de la interfaz de usuario de Airflow

- Eliminar el DAG en la interfaz de usuario de ADF

Nota:

Esta es la experiencia actual durante la Versión preliminar pública y seguiremos mejorándola.

Contenido relacionado

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente las Cuestiones de GitHub como mecanismo de retroalimentación para el contenido y lo sustituiremos por un nuevo sistema de retroalimentación. Para más información, consulta: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de