Acceso al cliente de la CLI de Apache Flink® mediante Secure Shell (SSH) en HDInsight en clústeres de AKS con Azure Portal

Nota:

Retiraremos Azure HDInsight en AKS el 31 de enero de 2025. Antes del 31 de enero de 2025, deberá migrar las cargas de trabajo a Microsoft Fabric o un producto equivalente de Azure para evitar la terminación repentina de las cargas de trabajo. Los clústeres restantes de la suscripción se detendrán y quitarán del host.

Solo el soporte técnico básico estará disponible hasta la fecha de retirada.

Importante

Esta funcionalidad actualmente está en su versión preliminar. En Términos de uso complementarios para las versiones preliminares de Microsoft Azure encontrará más términos legales que se aplican a las características de Azure que están en versión beta, en versión preliminar, o que todavía no se han lanzado con disponibilidad general. Para más información sobre esta versión preliminar específica, consulte la Información de Azure HDInsight sobre la versión preliminar de AKS. Para plantear preguntas o sugerencias sobre la característica, envíe una solicitud en AskHDInsight con los detalles y síganos en la comunidad de Azure HDInsight para obtener más actualizaciones.

En este ejemplo se explica cómo escribir el cliente de la CLI de Apache Flink en HDInsight en clústeres de AKS mediante SSH en Azure Portal, se tratan SQL y Flink DataStream.

Requisitos previos

- Es necesario seleccionar SSH durante la creación del clúster de Flink

Conexión a SSH desde Azure Portal

Una vez creado el clúster de Flink, puede observar en el panel izquierdo la opción configuración para acceder a Secure Shell

Apache Flink SQL

Conexión con el cliente SQL

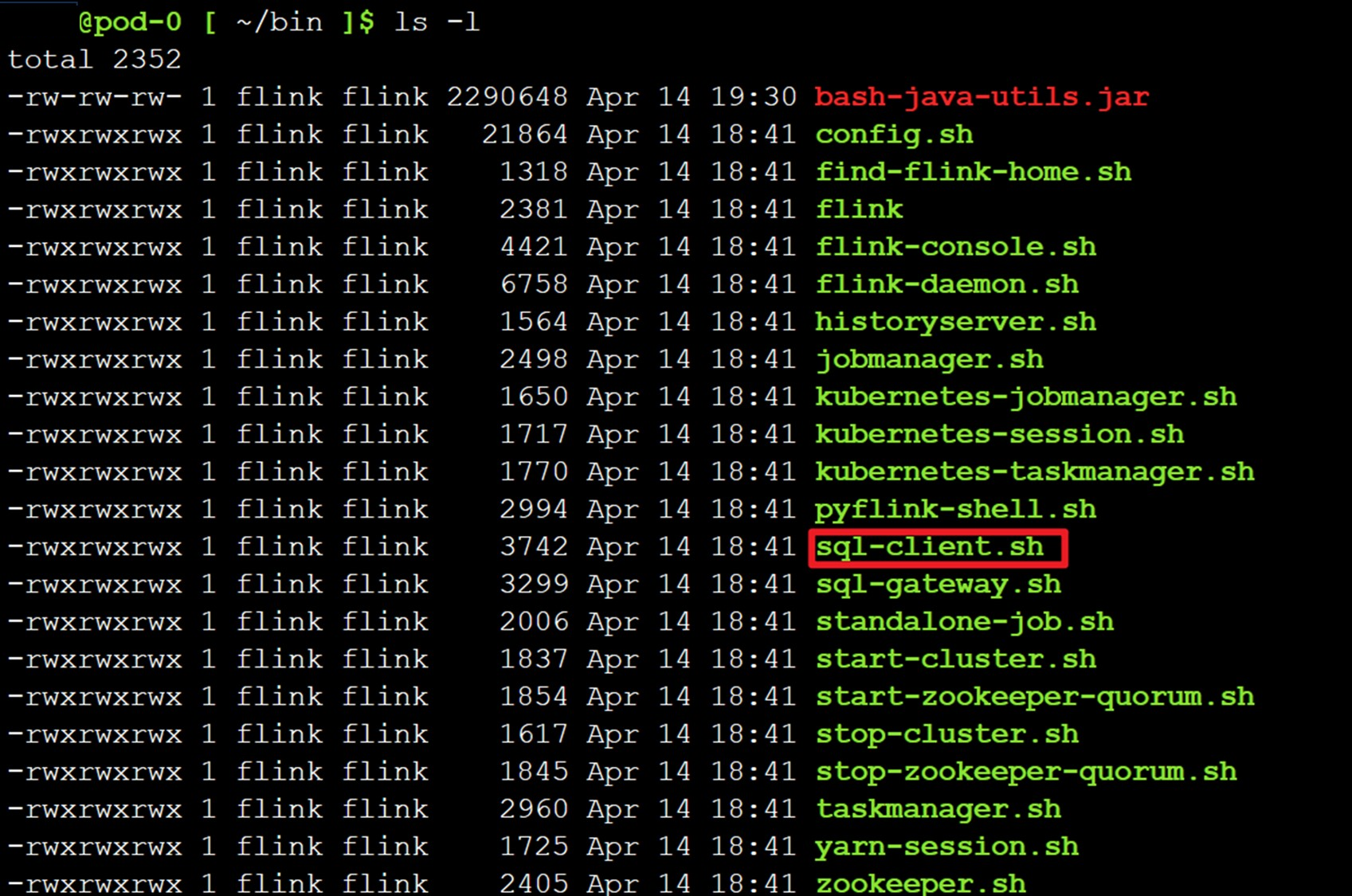

Es necesario cambiar el directorio a /opt/flink-webssh/bin y, a continuación, ejecutar ./sql-client.sh

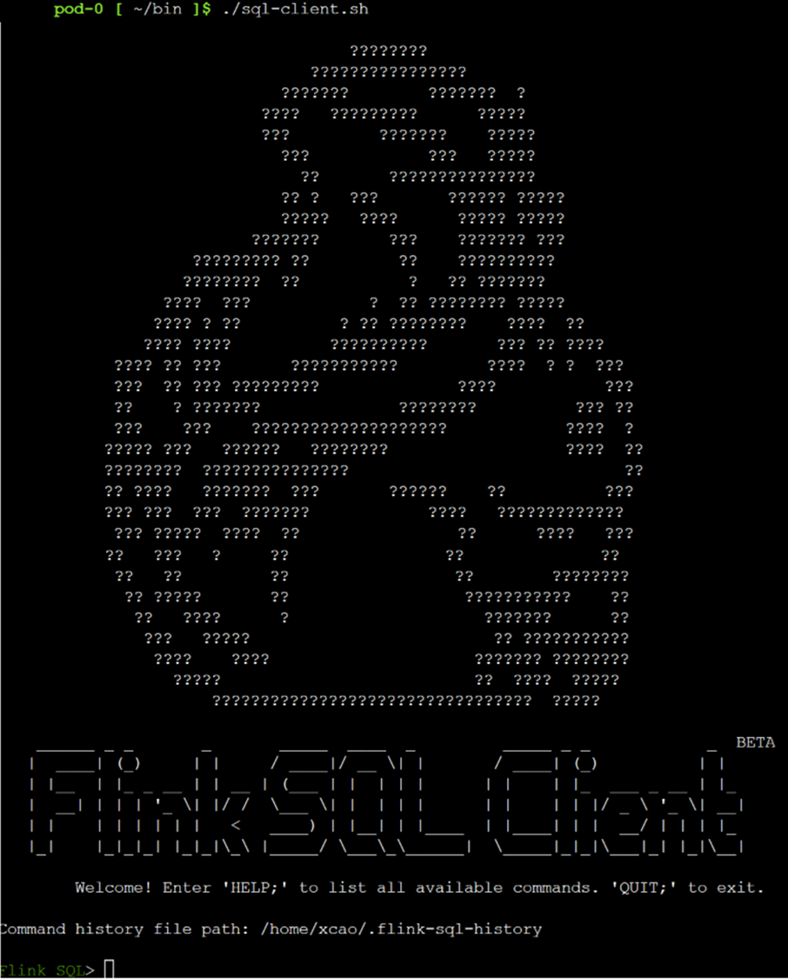

Ahora está en el cliente SQL de Flink

Consulte este documento para realizar algunas pruebas más.

DataStream de Apache Flink

Flink proporciona una CLI (interfaz de línea de comandos) bin/flink para ejecutar programas que se empaquetan como archivos JAR y controlar su ejecución.

La CLI forma parte de Secure Shell (SSH) y se conecta al JobManager en ejecución y usa las configuraciones de cliente especificadas en conf/flink-conf.yaml.

Enviar un trabajo significa cargar el archivo JAR del trabajo en el pod SSH e iniciar la ejecución del trabajo. Para ilustrar un ejemplo de este artículo, seleccionamos un trabajo de larga duración como examples/streaming/StateMachineExample.jar.

Nota:

Para administrar las dependencias, la expectativa es compilar y enviar un archivo fat JAR para el trabajo.

Cargue el archivo fat JAR del trabajo desde ABFS a WebSSH.

En función del caso de uso, debe editar las configuraciones de cliente mediante administración de configuración de Flink en flink-client-configs.

Vamos a ejecutar StateMachineExample.jar

./bin/flink run \ --detached \ ./examples/streaming/StateMachineExample.jar

Nota:

El envío del trabajo mediante --detached permitirá que el comando devuelva un valor una vez finalizado el envío. La salida contiene el id. del trabajo recién enviado.

Referencia

- Cliente SQL de Flink

- Apache, Apache Flink, Flink y los nombres de proyecto de código abierto asociados son marcas comerciales de Apache Software Foundation (ASF).