Uso de Azure Machine Learning Notebook en Spark

Importante

Azure HDInsight en AKS se retiró el 31 de enero de 2025. Descubra más a través de este anuncio.

Debe migrar las cargas de trabajo a microsoft Fabric o un producto equivalente de Azure para evitar la terminación repentina de las cargas de trabajo.

Importante

Esta característica está actualmente en versión preliminar. Los Términos de uso complementarios para las versiones preliminares de Microsoft Azure incluyen más términos legales que se aplican a las características de Azure que se encuentran en versión beta, en versión preliminar o, de lo contrario, aún no se han publicado en disponibilidad general. Para obtener información sobre esta versión preliminar específica, consulte información de la versión preliminar de Azure HDInsight en AKS. Para preguntas o sugerencias de características, envíe una solicitud en AskHDInsight con los detalles y síganos para obtener más actualizaciones sobre Comunidad de Azure HDInsight.

El aprendizaje automático es una tecnología creciente, que permite a los equipos aprender automáticamente de los datos anteriores. El aprendizaje automático usa varios algoritmos para crear modelos matemáticos y realizar predicciones que usan datos históricos o información. Tenemos un modelo definido hasta algunos parámetros y el aprendizaje es la ejecución de un programa informático para optimizar los parámetros del modelo mediante los datos de entrenamiento o la experiencia. El modelo puede ser predictivo para realizar predicciones en el futuro o descriptivas para obtener conocimiento de los datos.

En el siguiente cuaderno del tutorial se muestra un ejemplo de entrenamiento de modelos de aprendizaje automático en datos tabulares. Puede importar este cuaderno y ejecutarlo usted mismo.

Sube el archivo CSV en tu almacenamiento

Encuentra tu almacenamiento y nombre del contenedor en la vista JSON del portal

Vaya al almacenamiento HDI principal>, carpeta base de>,>, y cargue el archivo CSV ,

Inicie sesión en el clúster y abra Jupyter Notebook.

Importación de bibliotecas de Spark MLlib para crear la canalización

import pyspark from pyspark.ml import Pipeline, PipelineModel from pyspark.ml.classification import LogisticRegression from pyspark.ml.feature import VectorAssembler, StringIndexer, IndexToString

Lectura del archivo CSV en un dataframe de Spark

df = spark.read.("abfss:///iris_csv.csv",inferSchema=True,header=True)Dividir los datos para el entrenamiento y las pruebas

iris_train, iris_test = df.randomSplit([0.7, 0.3], seed=123)Creación de la canalización y entrenamiento del modelo

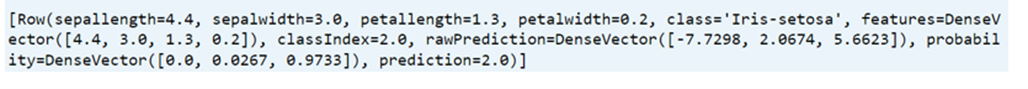

assembler = VectorAssembler(inputCols=['sepallength', 'sepalwidth', 'petallength', 'petalwidth'],outputCol="features",handleInvalid="skip") indexer = StringIndexer(inputCol="class", outputCol="classIndex", handleInvalid="skip") classifier = LogisticRegression(featuresCol="features", labelCol="classIndex", maxIter=10, regParam=0.01) pipeline = Pipeline(stages=[assembler,indexer,classifier]) model = pipeline.fit(iris_train) # Create a test `dataframe` with predictions from the trained model test_model = model.transform(iris_test) # Taking an output from the test dataframe with predictions test_model.take(1)

Evaluación de la precisión del modelo

import pyspark.ml.evaluation as ev evaluator = ev.MulticlassClassificationEvaluator(labelCol='classIndex') print(evaluator.evaluate(test_model,{evaluator.metricName: 'accuracy'}))