Procesamiento de datos en el perímetro con canalizaciones del procesador de datos de Azure IoT (versión preliminar)

Importante

Operaciones de IoT de Azure, habilitado por Azure Arc, está actualmente en VERSIÓN PRELIMINAR. No se debería usar este software en versión preliminar en entornos de producción.

Consulte Términos de uso complementarios para las versiones preliminares de Microsoft Azure para conocer los términos legales que se aplican a las características de Azure que se encuentran en la versión beta, en versión preliminar o que todavía no se han publicado para que estén disponibles con carácter general.

Los recursos industriales generan datos en muchos formatos diferentes y usan varios protocolos de comunicación. Esta diversidad de orígenes de datos, junto con los distintos esquemas y medidas unitarias, dificulta el uso y el análisis eficaz de los datos industriales sin procesar. Además, por motivos de cumplimiento, seguridad y rendimiento, no puede cargar todos los conjuntos de datos en la nube.

El procesamiento tradicional de estos datos requiere ingeniería de datos costosa, compleja y lenta. El procesador de datos de Azure IoT (versión preliminar) es un servicio de procesamiento de datos configurable que puede administrar las complejidades y la diversidad de los datos industriales. Use el procesador de datos para que los datos de orígenes dispares sean más comprensibles, utilizables y valiosos.

¿Qué es el Procesador de datos de Azure IoT (versión preliminar)?

El procesador de datos de Azure IoT (versión preliminar) es un componente opcional de la versión preliminar de Operaciones de IoT de Azure. El procesador de datos le permite agregar, enriquecer, normalizar y filtrar los datos de los dispositivos. El procesador de datos es un motor de procesamiento de datos basado en canalizaciones que le permite procesar datos en el perímetro antes de enviarlos a los otros servicios en el perímetro o en la nube:

El procesador de datos ingiere datos de streaming en tiempo real de orígenes como servidores OPC UA, historiadores y otros sistemas industriales. Normaliza estos datos convirtiendo varios formatos de datos en un formato estandarizado y estructurado, lo que facilita su consulta y análisis. El procesador de datos también puede contextualizar los datos, enriquecerlos con datos de referencia o con los últimos valores conocidos (LKV) para proporcionarle una vista completa de sus operaciones industriales.

La salida del procesador de datos son datos limpios, enriquecidos y estandarizados que están listos para aplicaciones de nivel inferior, como herramientas de análisis y de obtención de información en tiempo real. El procesador de datos reduce significativamente el tiempo necesario para transformar los datos sin procesar en información práctica.

Entre las características clave del procesador de datos se incluyen las siguientes:

Normalización de datos flexible para convertir varios formatos de datos en una estructura estandarizada.

Enriquecimiento de flujos de datos con datos de referencia o LKV para mejorar el contexto y obtener información más valiosa.

Integración de Microsoft Fabric para simplificar el análisis de datos limpios.

Capacidad de procesar datos de varios orígenes y publicar los datos en varios destinos.

Como plataforma de procesamiento de datos independiente de los datos, el procesador de datos puede ingerir datos en cualquier formato, procesarlos y, después, escribirlos en un destino. Para admitir estas funcionalidades, el procesador de datos puede deserializar y serializar varios formatos. Por ejemplo, puede serializar los datos en formato parquet para escribir archivos en Microsoft Fabric.

Directivas de reintento automáticas y configurables para controlar errores transitorios al enviar datos a destinos en la nube.

Implementación del procesador de datos

De manera predeterminada, el procesador de datos no se incluye en una implementación de la versión preliminar de Operaciones de IoT de Azure. Si tienes previsto usar el procesador de datos, debes incluirlo al implementar la versión preliminar de Operaciones de IoT de Azure; no puedes agregarlo más adelante. Para implementar el procesador de datos, debes agregar el argumento --include-dp al ejecutar el comando az iot ops init. Para obtener más información, consulta Implementación de extensiones de la versión preliminar de Operaciones de IoT de Azure en un clúster de Kubernetes.

¿Qué es una canalización?

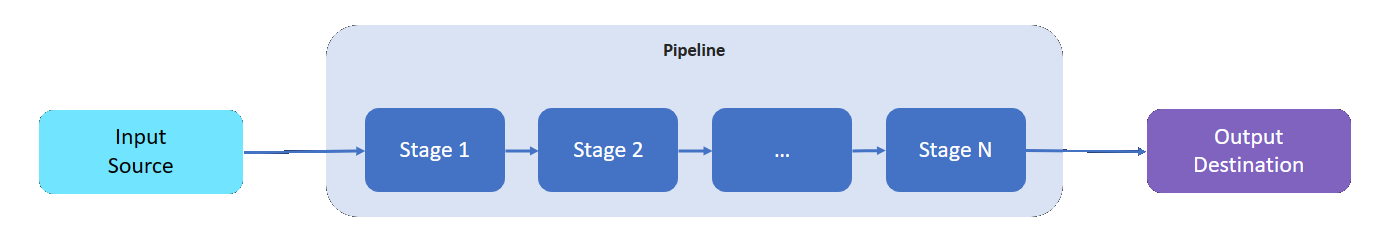

Una canalización del procesador de datos tiene un origen de entrada desde el que lee los datos, un destino en el que escribe los datos procesados y un número variable de fases intermedias para procesar los datos.

Las fases intermedias representan las distintas funcionalidades de procesamiento de datos disponibles:

- Puede agregar tantas fases intermedias como necesite a una canalización.

- Puede ordenar las fases intermedias de una canalización según sea necesario. Puede reordenar las fases después de crear una canalización.

- Cada fase se adhiere a una interfaz de implementación definida y a un contrato de esquema de entrada/salida.

- Cada fase es independiente de las demás fases de la canalización.

- Todas las fases funcionan dentro del ámbito de una partición. Los datos no se comparten entre las distintas particiones.

- Los datos solo fluyen de una fase a la siguiente.

Las canalizaciones del procesador de datos pueden usar las siguientes fases:

| Fase | Descripción |

|---|---|

| Origen: MQ | Recupera datos de un MQTT broker. |

| Origen: punto de conexión HTTP | Recupera datos de un punto de conexión HTTP. |

| Origen: SQL | Recupera datos de una base de datos de Microsoft SQL Server. |

| Origen: InfluxDB | Recupera datos de una base de datos de InfluxDB. |

| Filter | Filtra los datos que llegan a través de la fase. Por ejemplo, filtre cualquier mensaje con una temperatura fuera del intervalo 50F-150F. |

| Transformación | Normaliza la estructura de los datos. Por ejemplo, cambie la estructura de {"Name": "Temp", "value": 50} a {"temp": 50}. |

| LKV | Almacena los valores de determinadas métricas en un almacén de último valor conocido (LKV). Por ejemplo, almacene solo las medidas de temperatura y humedad en LKV, y omita el resto. Una fase posterior puede enriquecer un mensaje con los datos almacenados de LKV. |

| Enriquecimiento | Enriquece los mensajes con datos del almacén de datos de referencia. Por ejemplo, agregue un nombre de operador y un número de lote del conjunto de datos de operaciones. |

| Agregado | Agrega valores que pasan por la fase. Por ejemplo, cuando los valores de temperatura se envían cada 100 milisegundos, emiten una métrica de temperatura media cada 30 segundos. |

| Llamada | Realiza una llamada a un servicio HTTP o gRPC externo. Por ejemplo, llame a una función de Azure para convertir de un formato de mensaje personalizado a JSON. |

| Destino: MQ | Escribe los datos procesados, limpios y contextualizados en un tema MQTT. |

| Destino: referencia | Escribe los datos procesados en el almacén de referencias integrado. Otras canalizaciones pueden usar el almacén de referencias para enriquecer sus mensajes. |

| Destino: gRPC | Envía los datos procesados, limpios y contextualizados a un punto de conexión gRPC. |

| Destino: HTTP | Envía los datos procesados, limpios y contextualizados a un punto de conexión HTTP. |

| Destino: Fabric Lakehouse | Envía los datos procesados, limpios y contextualizados a una instancia de Microsoft Fabric Lakehouse en la nube. |

| Destino: Azure Data Explorer | Envía los datos procesados, limpios y contextualizados a un punto de conexión de Azure Data Explorer en la nube. |

Paso siguiente

Para probar las canalizaciones del procesador de datos, consulte las guías de inicio rápido de Operaciones de IoT de Azure.

Para obtener más información sobre el procesador de datos, consulte:

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente las Cuestiones de GitHub como mecanismo de retroalimentación para el contenido y lo sustituiremos por un nuevo sistema de retroalimentación. Para más información, consulta: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de