Inicio rápido: Transformación de datos mediante la definición de trabajo de Apache Spark

En esta guía de inicio rápido, usará Azure Synapse Analytics para crear una canalización mediante la definición de trabajo de Apache Spark.

Requisitos previos

- Suscripción de Azure: Si no tiene una suscripción a Azure, cree una cuenta gratuita de Azure antes de empezar.

- Área de trabajo de Azure Synapse: Cree un área de trabajo de Synapse desde Azure Portal siguiendo las instrucciones que se indican en Inicio rápido: Creación de un área de trabajo de Synapse.

- Definición de trabajo de Apache Spark: cree una definición de trabajo de Apache Spark en el área de trabajo de Synapse siguiendo las instrucciones de Tutorial:Creación de una definición de trabajo de Apache Spark en Synapse Studio.

Desplazamiento a Synapse Studio

Una vez creada el área de trabajo de Azure Synapse, hay dos maneras de abrir Synapse Studio:

- Abrir el área de trabajo de Synapse en Azure Portal. Seleccione Abrir en la tarjeta Abrir Synapse Studio en Comenzar.

- Abra Azure Synapse Analytics e inicie sesión en su área de trabajo.

En este inicio rápido, se usa como ejemplo el área de trabajo denominada "sampletest".

Creación de una canalización con una definición de trabajo de Apache Spark

Una canalización contiene el flujo lógico para una ejecución de un conjunto de actividades. En esta sección, creará una canalización que contiene una actividad de definición de trabajo de Apache Spark.

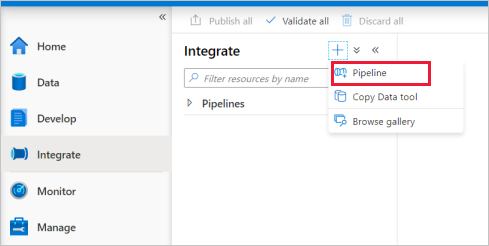

Vaya a la pestaña Integración. Seleccione el icono de signo más junto al encabezado Canalizaciones y seleccione Canalización.

En la página de configuración Propiedades de la canalización, escriba demo en Nombre.

En Synapse, en el panel Actividades, arrastre la definición del trabajo de Spark al lienzo de la canalización.

Establecimiento del lienzo de la definición de trabajo de Apache Spark

Una vez que haya creado la definición de trabajo de Apache Spark, se le enviará automáticamente al lienzo de la definición de trabajo de Spark.

Configuración general

Seleccione el módulo de la definición de trabajo de Spark en el lienzo.

En la pestaña General, escriba sample en el cuadro Nombre.

(Opción) También puede escribir una descripción.

Tiempo de espera: cantidad máxima de tiempo que se puede ejecutar una actividad. El valor predeterminado es siete días, que también es la cantidad máxima de tiempo permitida. El formato es D.HH:MM:SS.

Reintento: número máximo de reintentos.

Intervalo de reintento: número de segundos entre cada reintento.

Secure output (Salida segura): cuando se selecciona, la salida de la actividad no se captura en el registro.

Secure input (Entrada segura): cuando se selecciona, la entrada de la actividad no se captura en el registro.

Pestaña Settings

En este panel, puede hacer referencia a la definición de trabajo de Spark que se va a ejecutar.

Expanda la lista de definiciones de trabajo de Spark, puede elegir una definición de trabajo de Apache Spark existente. También puede crear una nueva definición de trabajo de Apache Spark. Para ello, seleccione el botón Nuevo y haga referencia a la definición de trabajo de Spark que se debe ejecutar.

(Opcional) Se puede rellenar la información de la definición de trabajo de Apache Spark. Si la configuración siguiente está vacía, se usará la configuración de la propia definición de trabajo de Spark para ejecutarse. Si la configuración siguiente no está vacía, reemplazará la configuración de la propia definición de trabajo de Spark.

Propiedad Descripción Main definition file (Archivo de definición principal) Archivo principal usado para el trabajo. Seleccione un archivo PY/JAR/ZIP en el almacenamiento. Puede seleccionar Upload file (Cargar archivo) para cargar un archivo en una cuenta de almacenamiento.

Ejemplo:abfss://…/path/to/wordcount.jarReferencias de subcarpetas Si se examinan las subcarpetas desde la carpeta raíz del archivo de definición principal, estos archivos se agregarán como archivos de referencia. Se analizarán las carpetas denominadas "jars", "pyFiles", "files" o "archives"; los nombres de las carpetas distinguen mayúsculas de minúsculas. Nombre de clase principal Identificador completo o clase principal que se encuentra en el archivo de definición principal.

Ejemplo:WordCountArgumentos de la línea de comandos Puede agregar argumentos de línea de comandos al hacer clic en el botón Nuevo. Debe tener en cuenta que agregar argumentos de línea de comandos invalida los argumentos establecidos por la definición de trabajo de Spark.

Ejemplo:abfss://…/path/to/shakespeare.txtabfss://…/path/to/resultGrupo de Apache Spark Puede seleccionar el grupo de Apache Spark en la lista. Referencia de código de Python Otros archivos de código de Python que se usan como referencia en el archivo de definición principal.

Admite pasar archivos (.py, .py3, .zip) a la propiedad "pyFiles". Invalida la propiedad "pyFiles" establecida en la definición de trabajo de Spark.Reference files (Archivos de referencia) Otros archivos usados como referencia en el archivo de definición principal. Asignación dinámica de ejecutores Esta configuración se asigna a la propiedad de asignación dinámica de la configuración de Spark para la asignación de ejecutores de aplicaciones de Spark. Mínimo de ejecutores Número mínimo de ejecutores que se asignarán en el grupo de Spark especificado para el trabajo. Máximo de ejecutores Número máximo de ejecutores que se asignarán en el grupo de Spark especificado para el trabajo. Driver size (Tamaño del controlador) Número de núcleos y memoria que se van a usar para el controlador proporcionado en el grupo de Apache Spark especificado para el trabajo. Configuración de Spark Especifique valores para las propiedades de configuración de Spark enumeradas en el artículo Configuración de Spark: Propiedades de la aplicación. Los usuarios pueden usar la configuración predeterminada y la personalizada.

Puede agregar contenido dinámico haciendo clic en el botón Agregar contenido dinámico o presionando la tecla de método abreviado Alt+Mayús+D. En la página Agregar contenido dinámico, puede usar cualquier combinación de expresiones, funciones y variables del sistema para agregar contenido dinámico.

Pestaña Propiedades de usuario

Puede agregar propiedades para la actividad de definición de trabajo de Apache Spark en este panel.

Contenido relacionado

Avance a los artículos siguientes para aprender sobre la compatibilidad de Azure Synapse Analytics: