Tamaños de las máquinas virtuales de la serie HB

Se aplica a: ✔️ Máquinas virtuales Linux ✔️ Máquinas virtuales Windows ✔️ Conjuntos de escalado flexibles ✔️ Conjuntos de escalado uniformes

Se han realizado varias pruebas de rendimiento en los distintos tamaños de la serie HB. Estos son algunos de los resultados de esta prueba.

| Carga de trabajo | HB |

|---|---|

| STREAM Triad | 260 GB/s (32-33 GB/s por CCX) |

| High-Performance Linpack (HPL) | 1000 GigaFLOPS (Rpeak), 860 GigaFLOPS (Rmax) |

| Latencia y ancho de banda de RDMA | 1,27 microsegundos; 99,1 Gb/s |

| FIO en SSD NVMe local | 1,7 GB/s en lecturas; 1,0 GB/s en escrituras |

| IOR en SSD Premium 4 * Azure (P30 Managed Disks, RAID0) ** | 725 MB/s lecturas, 780 MB/escrituras |

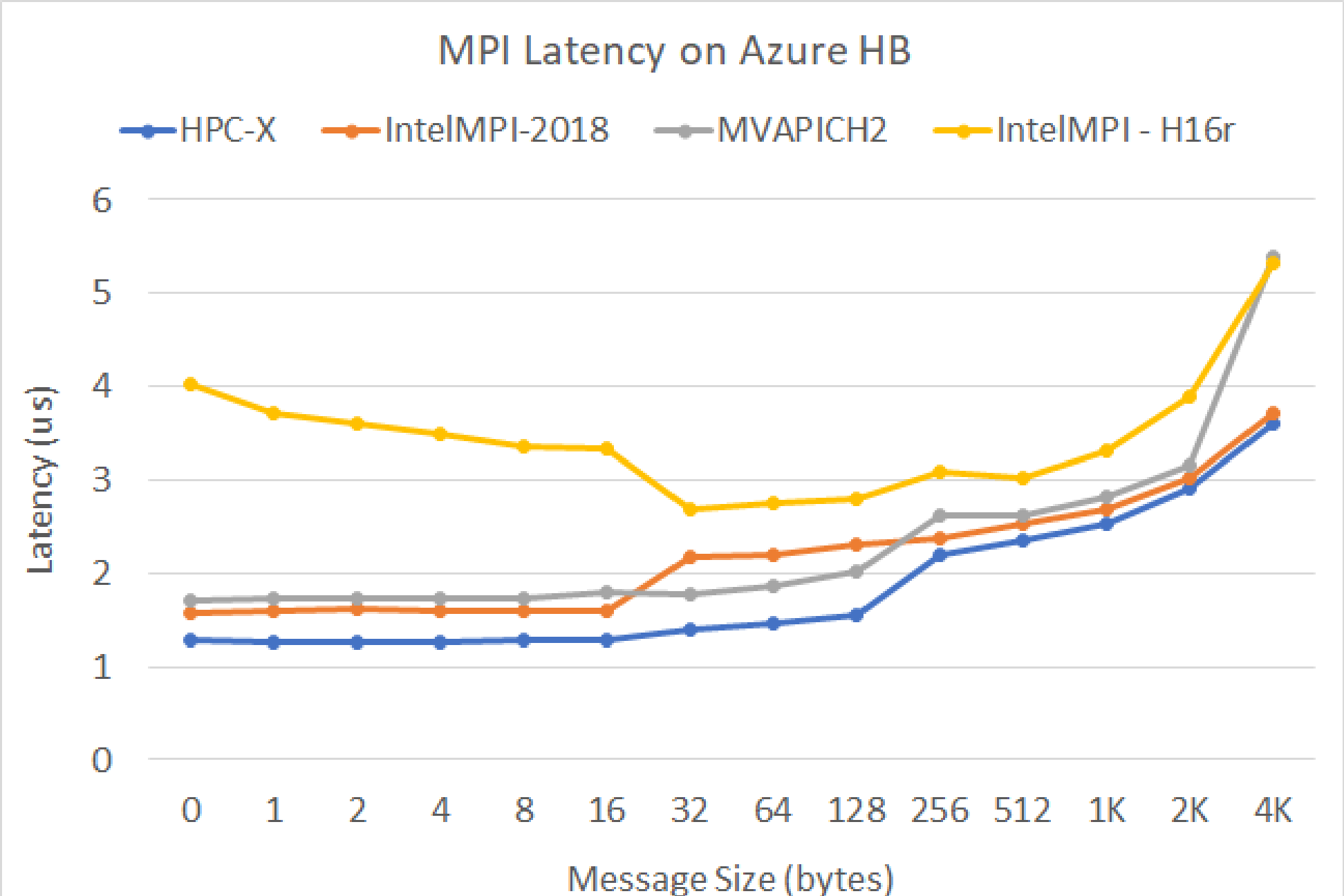

Latencia de MPI

Se ejecuta la prueba de latencia de MPI del conjunto de pruebas OSU de microrrealización. Los scripts de ejemplo se encuentran en GitHub

./bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./osu_latency

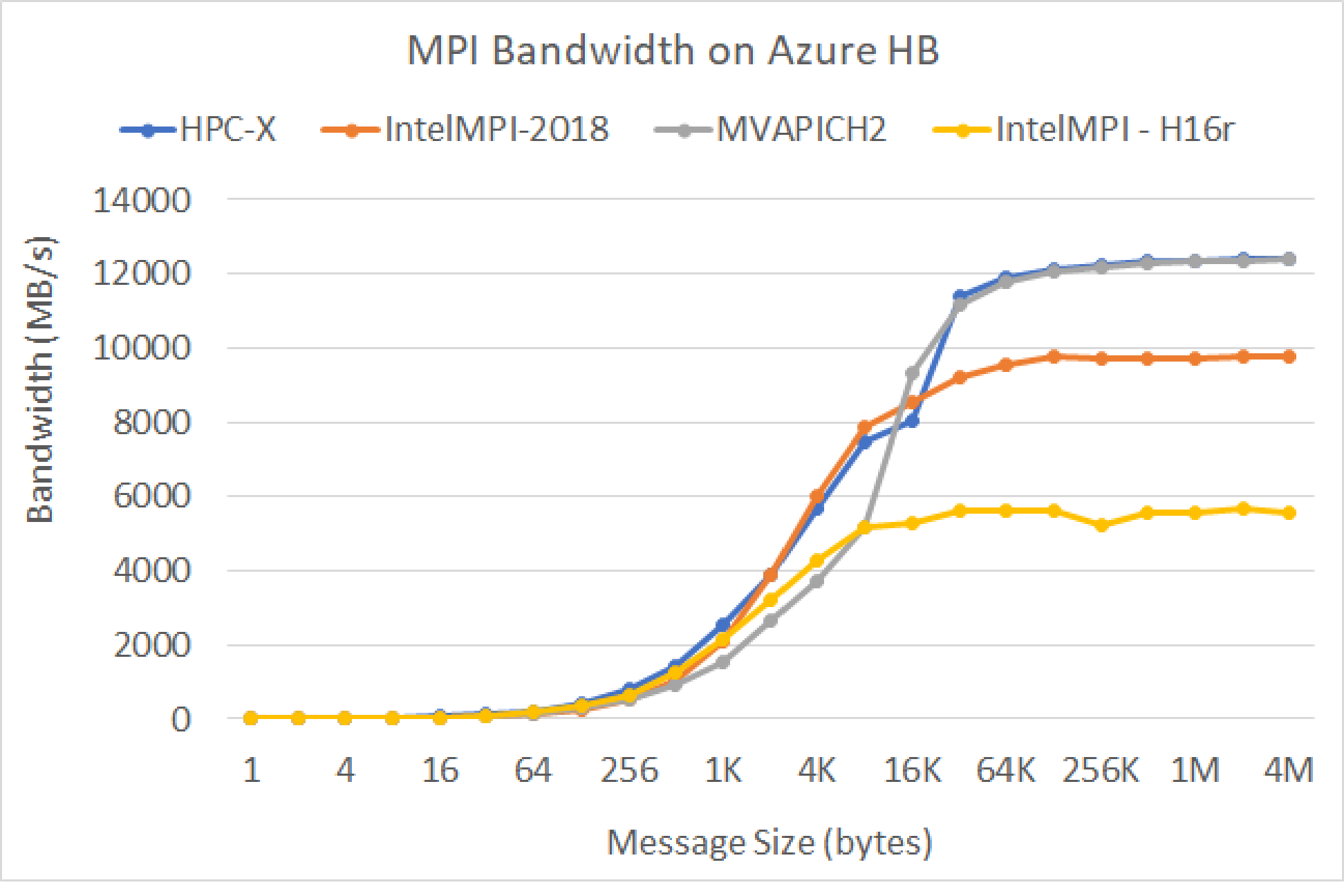

Ancho de banda de MPI

Se ejecuta la prueba de ancho de banda de MPI del conjunto de pruebas OSU de microrrealización. Los scripts de ejemplo se encuentran en GitHub

./mvapich2-2.3.install/bin/mpirun_rsh -np 2 -hostfile ~/hostfile MV2_CPU_MAPPING=[INSERT CORE #] ./mvapich2-2.3/osu_benchmarks/mpi/pt2pt/osu_bw

Mellanox Perftest

El paquete Mellanox Perftest tiene muchas pruebas de InfiniBand, como la de latencia (ib_send_lat) y la de ancho de banda (ib_send_bw). El siguiente es un ejemplo de comando.

numactl --physcpubind=[INSERT CORE #] ib_send_lat -a

Pasos siguientes

- En los blogs de Azure Compute Community Tech, encontrará los anuncios más recientes, ejemplos de la carga de trabajo HPC y resultados de HPC.

- Si quiere una visión general de la arquitectura de la ejecución de cargas de trabajo de HPC, consulte Informática de alto rendimiento (HPC) en Azure.