Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Microsoft Fabric Runtime es una plataforma integrada en Azure basada en Apache Spark que permite la ejecución y administración de experiencias de ingeniería de datos y ciencia de datos. Combina componentes clave de orígenes internos y de código abierto, lo que proporciona a los clientes una solución completa. Para simplificar, nos referiremos a Microsoft Fabric Runtime con tecnología de Apache Spark como Fabric Runtime.

Principales componentes de Fabric Runtime:

Apache Spark: una potente biblioteca informática distribuida de código abierto que permite realizar tareas de análisis y procesamiento de datos a gran escala. Apache Spark proporciona una plataforma versátil y de alto rendimiento para experiencias de ingeniería de datos y ciencia de datos.

Delta Lake : una capa de almacenamiento de código abierto que aporta transacciones ACID y otras características de confiabilidad de datos a Apache Spark. Integrado en Fabric Runtime, Delta Lake mejora las capacidades de procesamiento de datos y garantiza la coherencia de los datos en múltiples operaciones simultáneas.

El motor de ejecución nativo es una mejora transformadora para las cargas de trabajo de Apache Spark, que ofrece importantes mejoras de rendimiento al ejecutar directamente las consultas de Spark en la infraestructura de almacén de lago de datos. Integrado a la perfección, no requiere cambios en el código y evita el bloqueo del proveedor, ya que admite los formatos Parquet y Delta en todas las API de Apache Spark en Runtime 1.3 (Spark 3.5). Este motor aumenta la velocidad de las consultas hasta cuatro veces más rápido que OSS Spark tradicional, como se muestra en el banco de pruebas TPC-DS 1TB, lo que reduce los costos operativos y mejora la eficacia en varias tareas de datos, como la ingesta de datos, ETL, análisis y consultas interactivas. El motor de ejecución nativo se basa en dos componentes clave del OSS: Velox, una biblioteca de aceleración de bases de datos de C++ introducida por Meta y Apache Gluten (incubación), una capa intermedia responsable de descargar la ejecución de motores SQL basados en JVM en motores nativos introducidos por Intel.

Paquetes por defecto para Java/Scala, Python y R: paquetes compatibles con diversos lenguajes y entornos de programación. Estos paquetes se instalan y configuran automáticamente, lo que permite a los desarrolladores aplicar sus lenguajes de programación preferidos para las tareas de procesamiento de datos.

Microsoft Fabric Runtime se basa en un sólido sistema operativo de código abierto, lo que garantiza la compatibilidad con diversas configuraciones de hardware y requisitos del sistema.

A continuación, encontrará una comparación completa de los principales componentes, como las versiones de Apache Spark, los sistemas operativos compatibles, Java, Scala, Python, Delta Lake y R, para los entornos de ejecución basados en Apache Spark dentro de la plataforma de Microsoft Fabric.

Sugerencia

Use siempre la versión en tiempo de ejecución (GA) más reciente y disponible con carácter general para la carga de trabajo de producción, que actualmente es Runtime 1.3.

| Componente | Runtime 1.2 | Runtime 1.3 | Runtime 2.0 |

|---|---|---|---|

| Etapa de lanzamiento | EOSA | Disponibilidad general | Experimental (versión preliminar) |

| Versión de Apache Spark | 3.4.1 | 3.5.5 | 4.0.0 |

| Sistema operativo | Mariner 2.0 | Mariner 2.0 | Mariner 3.0 |

| Versión de Java | 11 | 11 | Veintiuno |

| Versión de Scala | 2.12.17 | 2.12.17 | 2.13.16 |

| Versión de Python | 3.10 | 3,11 | 3.12.11 |

| Versión de Delta Lake | 2.4.0 | 3.2 | 4.0.0 |

Visite Runtime 1.2, Runtime 1.3 o Runtime 2.0 para explorar detalles, nuevas características, mejoras y escenarios de migración para la versión específica del entorno de ejecución.

Optimizaciones de Fabric

En Microsoft Fabric, tanto el motor de Spark como las implementaciones de Delta Lake incorporan características y optimizaciones específicas de la plataforma. Estas características están diseñadas para usar integraciones nativas dentro de la plataforma. Es importante tener en cuenta que todas estas características se pueden deshabilitar para lograr la funcionalidad de Spark estándar y Delta Lake. Los runtimes de Fabric para Apache Spark abarcan:

- La versión completa de código abierto de Apache Spark.

- Una colección de casi 100 mejoras integradas y distintas de rendimiento de las consultas. Estas mejoras incluyen características como el almacenamiento en caché de particiones (habilitando la caché de partición FileSystem para reducir las llamadas de metastore) y la combinación cruzada a la proyección de la subconsulta escalar.

- Caché inteligente integrada.

Dentro de Fabric Runtime para Apache Spark y Delta Lake, hay funcionalidades nativas de escritura que sirven para dos propósitos clave:

- Ofrecen un rendimiento diferenciado para escribir cargas de trabajo, optimizando el proceso de escritura.

- De forma predeterminada, se ajustan a la optimización V-Order de archivos Delta Parquet. La optimización V-Order de Delta Lake es fundamental para ofrecer un rendimiento de lectura superior en todos los motores de Fabric. Para comprender mejor el funcionamiento y la administración, consulte el artículo dedicado sobre Optimización de la tabla Delta Lake y V-Order.

Compatibilidad con varios runtimes

Fabric admite varios runtimes, lo que ofrece a los usuarios la flexibilidad de cambiar sin problemas entre ellos, minimizando el riesgo de incompatibilidades o interrupciones.

De forma predeterminada, todas las áreas de trabajo nuevas usan la versión más reciente del entorno de ejecución de disponibilidad general, que actualmente es Runtime 1.3.

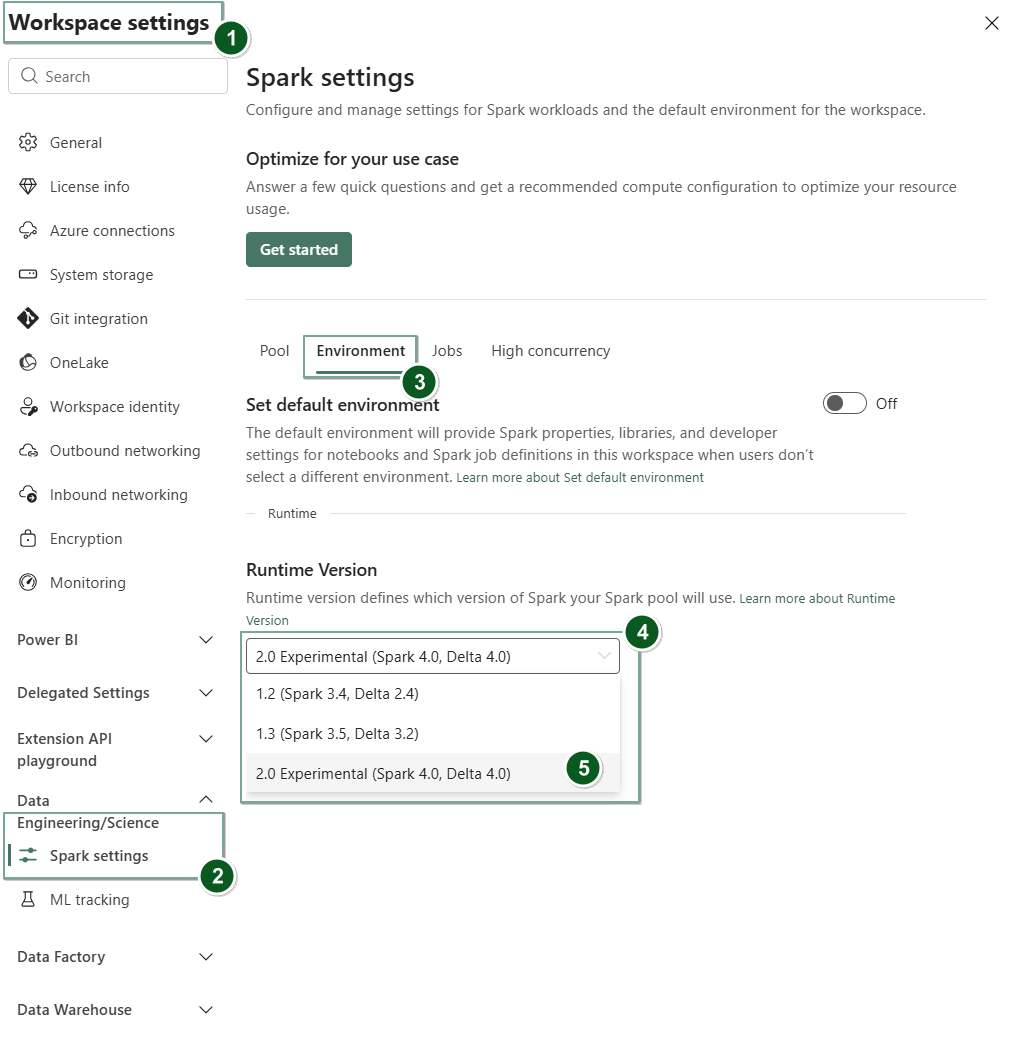

Para cambiar la versión de tiempo de ejecución a nivel de área de trabajo, vaya a Configuración del área de trabajo>Ingeniería de datos/Ciencia>Configuración de Spark. Desde la pestaña de entorno , seleccione la versión de entorno de ejecución deseada entre las opciones disponibles. Seleccione Guardar para confirmar la selección.

Una vez realizado este cambio, todos los elementos creados por el sistema en el área de trabajo, incluidos Lakehouses, SJD y Notebooks, funcionarán con la nueva versión seleccionada de runtime de nivel de área de trabajo a partir de la siguiente sesión Spark. Si actualmente usa un cuaderno con una sesión existente para un trabajo o cualquier actividad relacionada con un lakehouse, esa sesión Spark continúa tal como está. Sin embargo, a partir de la siguiente sesión o trabajo, se aplicará la versión de runtime seleccionada.

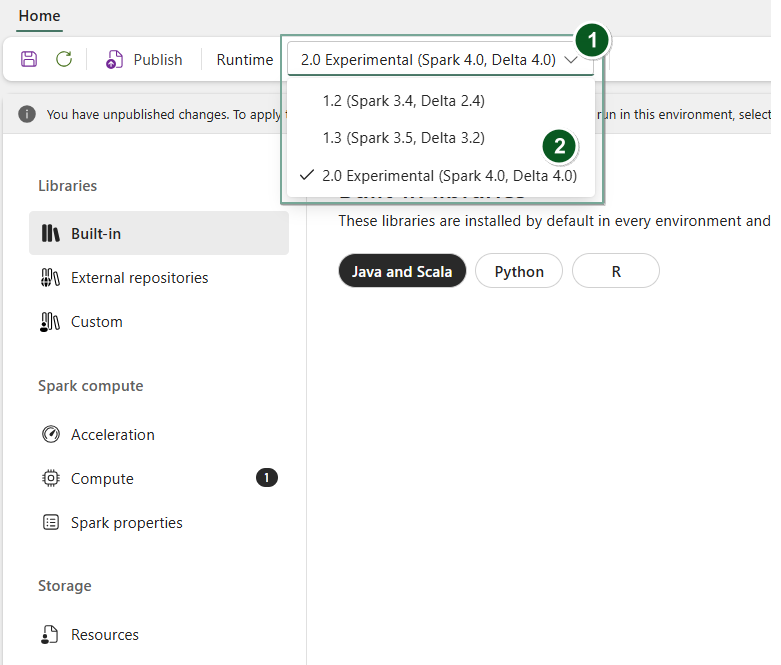

Además, para cambiar el tiempo de ejecución a nivel de Environment elemento, cree un nuevo elemento Entorno o abra uno existente, en la lista desplegable Runtime, seleccione la versión deseada de tiempo de ejecución de las opciones disponibles, luego seleccione Save y, a continuación, Publish para guardar los cambios. A continuación, puede usar este Environment elemento con su Notebook o su Spark Job Definition.

Consecuencias de los cambios de runtime en la configuración de Spark

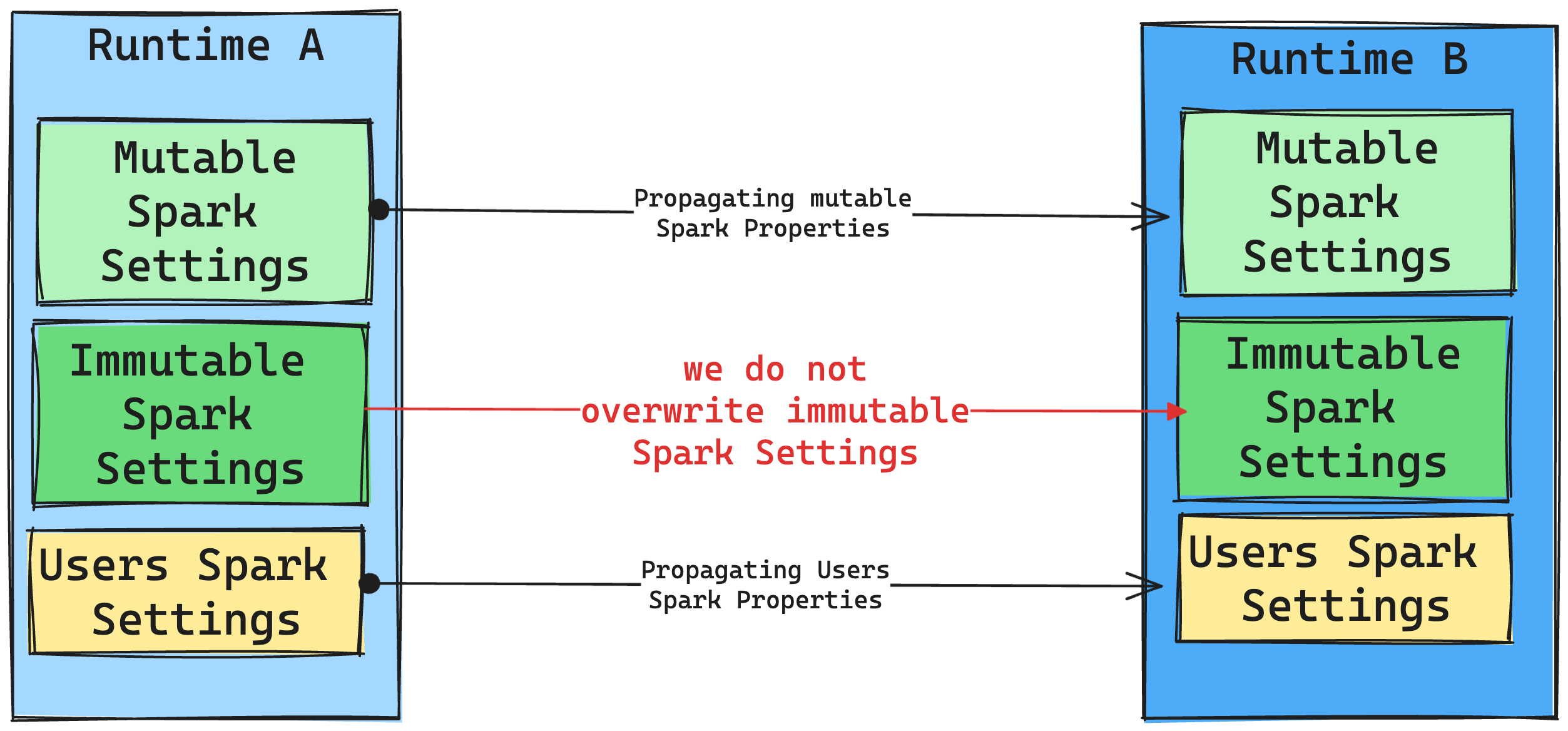

En general, pretendemos migrar toda la configuración de Spark. Sin embargo, si identificamos que la configuración de Spark no es compatible con Runtime B, emitimos un mensaje de advertencia y nos abstenemos de implementar la configuración.

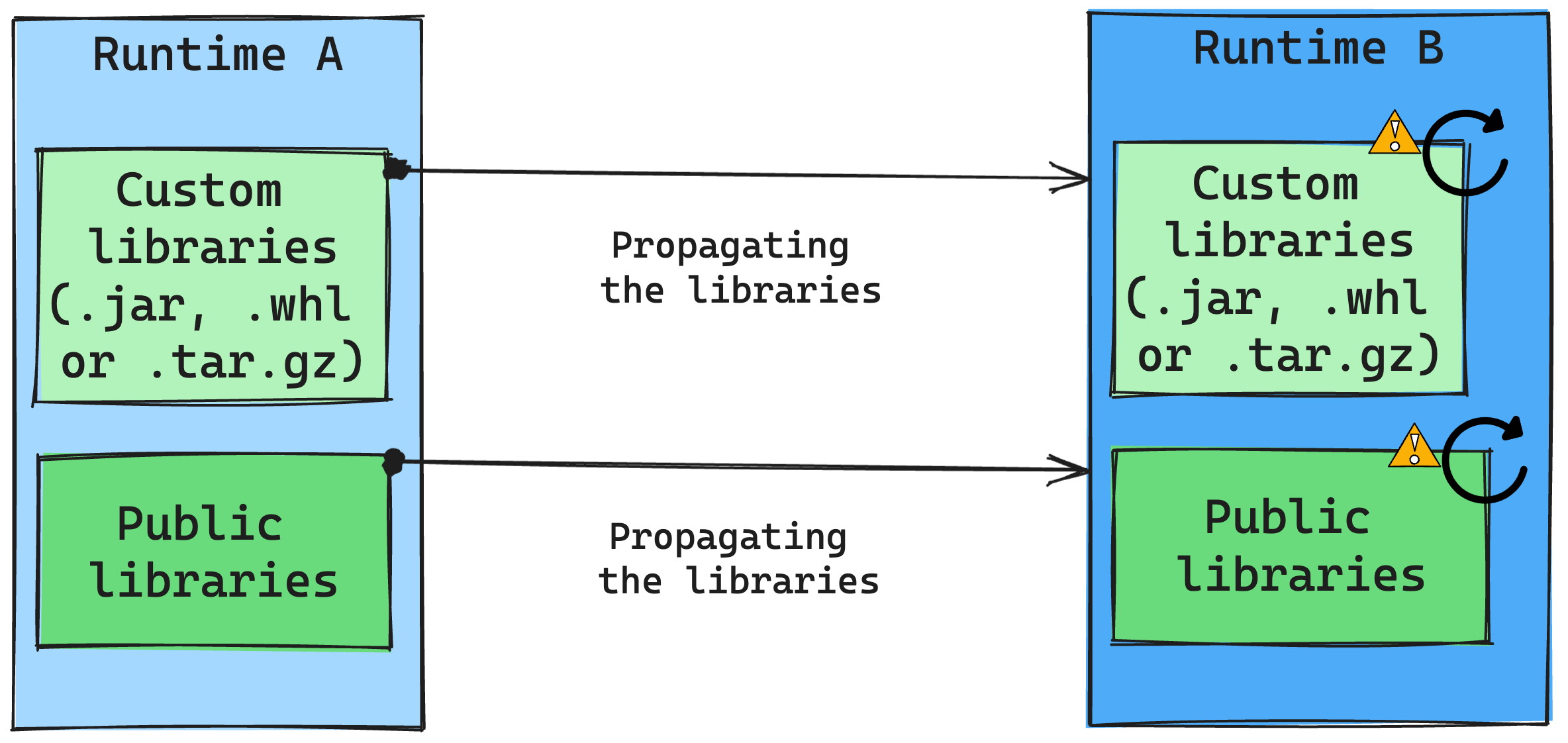

Consecuencias de los cambios de runtime en la administración de la biblioteca

En general, nuestro enfoque consiste en migrar todas las bibliotecas de Runtime A a Runtime B, incluidos los runtimes públicos y personalizados. Si las versiones de Python y R permanecen sin cambios, las bibliotecas deben funcionar correctamente. Sin embargo, para Jars, hay una probabilidad significativa de que no funcionen debido a alteraciones en las dependencias y otros factores, como los cambios en Scala, Java, Spark y el sistema operativo.

El usuario es responsable de actualizar o reemplazar las bibliotecas que no funcionan con runtime B. Si hay un conflicto, lo que significa que runtime B incluye una biblioteca definida originalmente en tiempo de ejecución A, nuestro sistema de administración de bibliotecas intenta crear la dependencia necesaria para runtime B en función de la configuración del usuario. Sin embargo, se produce un error en el proceso de creación si se produce un conflicto. En el registro de errores, los usuarios pueden ver qué bibliotecas están causando conflictos y hacer ajustes en sus versiones o especificaciones.

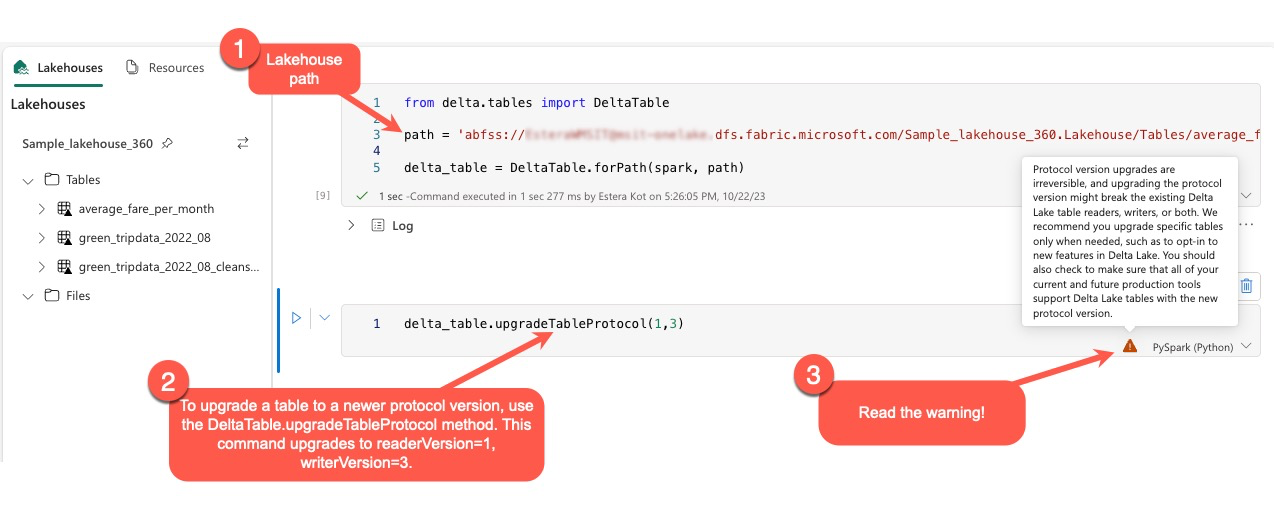

Actualizar el protocolo Delta Lake

Las características de Delta Lake siempre son compatibles con versiones anteriores, lo que garantiza que las tablas creadas en una versión inferior de Delta Lake puedan interactuar sin problemas con versiones superiores. Sin embargo, cuando determinadas características están habilitadas (por ejemplo, mediante el delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) método , la compatibilidad directa con versiones inferiores de Delta Lake podría verse comprometida. En tales casos, es esencial modificar las cargas de trabajo que hacen referencia a las tablas actualizadas para alinearse con una versión de Delta Lake que mantenga la compatibilidad.

Cada tabla Delta está asociada a una especificación de protocolo, definiendo las características que admite. Las aplicaciones que interactúan con la tabla, ya sea para leer o escribir, dependen de esta especificación de protocolo para determinar si son compatibles con el conjunto de características de la tabla. Si una aplicación no tiene la capacidad de controlar una característica que aparece como compatible con el protocolo de la tabla, no puede leer ni escribir en esa tabla.

La especificación del protocolo se divide en dos componentes distintos: el protocolo "read" y el protocolo "write". Para obtener más información, visite la página "¿Cómo administra Delta Lake la compatibilidad de características?".

Los usuarios pueden ejecutar el comando delta.upgradeTableProtocol(minReaderVersion, minWriterVersion) en el entorno de PySpark y en Spark SQL y Scala. Este comando les permite iniciar una actualización en la tabla Delta.

Es importante tener en cuenta que al realizar esta actualización, los usuarios reciben una advertencia que indica que la actualización de la versión del protocolo Delta es un proceso no reversible. Esto significa que una vez ejecutada la actualización, no se puede deshacer.

Las actualizaciones de la versión del protocolo pueden afectar potencialmente a la compatibilidad de los lectores de tablas, escritores o ambos existentes de Delta Lake. Por lo tanto, es aconsejable continuar con precaución y actualizar la versión del protocolo solo cuando sea necesario, como al adoptar nuevas características en Delta Lake.

Importante

Para obtener más información sobre qué versiones y características de protocolo son compatibles en todas las experiencias de Microsoft Fabric, lea Interoperabilidad con formato de tabla delta Lake.

Además, los usuarios deben comprobar que todas las cargas de trabajo y procesos de producción actuales y futuros son compatibles con las tablas Delta Lake mediante la nueva versión del protocolo para garantizar una transición sin problemas y evitar posibles interrupciones.