Preparación para usar Apache Spark

Apache Spark es un marco de procesamiento de datos distribuido que permite el análisis de datos a gran escala mediante la coordinación del trabajo en varios nodos de procesamiento en un clúster. En pocas palabras, Spark usa un enfoque de "divide y vencerás" para procesar grandes volúmenes de datos rápidamente distribuyendo el trabajo entre varios equipos. Spark controla el proceso de distribución de las tareas y recopilación de los resultados. Usted envía un trabajo de procesamiento de datos en forma de código que inicia un programa controlador. Este programa usa un objeto de administración de clúster denominado SparkContext para administrar la distribución del procesamiento en el clúster de Spark. En la mayoría de los casos, estos detalles se abstraen: solo tiene que escribir el código necesario para realizar las operaciones necesarias en los datos.

Spark puede ejecutar código escrito en una amplia gama de lenguajes, como Java, Scala (lenguaje de scripting basado en Java), Spark R, Spark SQL y PySpark (variante de Python específica para Spark). La mayoría de las cargas de trabajo de análisis e ingeniería de datos se realizan con una combinación de PySpark y Spark SQL.

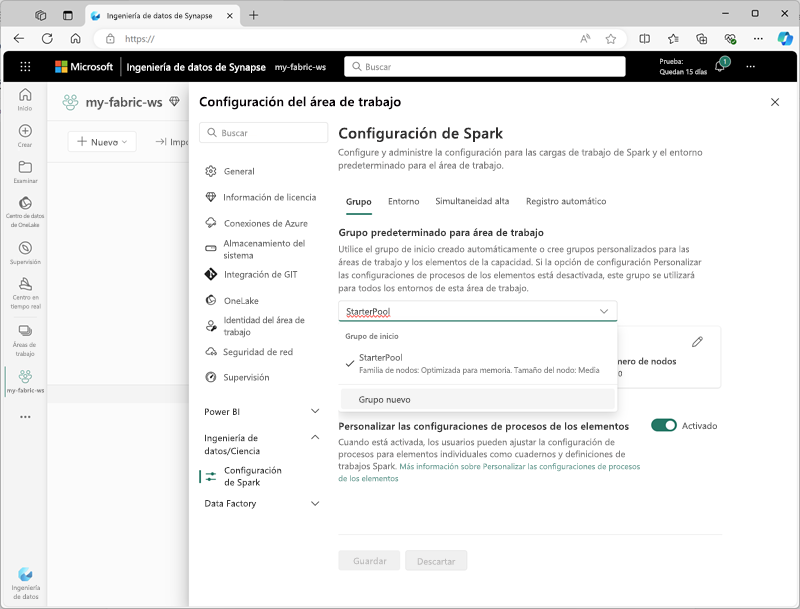

Configuración de Spark

En Microsoft Fabric, a cada área de trabajo se le asigna un clúster de Spark. Un administrador puede administrar la configuración del clúster de Spark en la sección Ingeniería/ciencia de datos de la configuración del área de trabajo.

Las opciones de configuración específicas son las siguientes:

- Familia de nodos: tipo de máquinas virtuales que se usan para los nodos del clúster de Spark. En la mayoría de los casos, los nodos optimizados para memoria proporcionan un rendimiento óptimo.

- Versión del entorno de ejecución: versión de Spark (y los subcomponentes dependientes) que debe ejecutarse en el clúster.

- Propiedades de Spark: configuración específica de Spark que desea habilitar o reemplazar en el clúster. Puede ver una lista de propiedades en la documentación de Apache Spark.

Nota:

En la mayoría de los escenarios, la configuración predeterminada proporciona una configuración óptima para Spark en Microsoft Fabric.

Bibliotecas

El ecosistema de código abierto de Spark incluye una amplia selección de bibliotecas de código para tareas comunes (y a veces muy especializadas). Dado que una gran cantidad de procesamiento de Spark se realiza con PySpark, es muy probable que, gracias a la enorme gama de bibliotecas de Python, haya una biblioteca para la tarea que necesita realizar.

De forma predeterminada, los clústeres de Spark en Microsoft Fabric incluyen muchas de las bibliotecas más usadas. Para establecer bibliotecas predeterminadas adicionales o especificaciones de biblioteca persistentes para elementos de código, necesita permisos de administrador del área de trabajo para crear un entorno y establecer el entorno predeterminado para el área de trabajo.

Sugerencia

Para obtener más información sobre la administración de bibliotecas, consulte Administración de bibliotecas de Apache Spark en Microsoft Fabric en la documentación de Microsoft Fabric.