Tester votre modèle

Une fois l’entraînement de votre modèle réussi, vous pouvez utiliser des traductions pour évaluer la qualité de votre modèle. Pour prendre une décision informée quant à l’utilisation de notre modèle standard ou de votre modèle personnalisé, vous devez évaluer le delta entre le score BLEU de votre modèle personnalisé et le score BLEU de référence de notre modèle standard. Si votre modèle est entraîné au sein d’un domaine étroit et que vos données d’apprentissage correspondent à celles des tests, vous pouvez vous attendre à un score BLEU élevé.

Score BLEU

BLEU (Bilingual Evaluation Understudy) est un algorithme qui permet d’évaluer la précision ou la justesse d’un texte traduit automatiquement d’une langue à une autre. Custom Translator utilise la métrique BLEU pour indiquer la justesse de la traduction.

Un score BLEU est un nombre compris entre zéro et 100. Un score égal à zéro indique une traduction de faible qualité, où rien dans la traduction ne correspond à la référence. Un score égal à 100 indique une traduction parfaite identique à la référence. Il n’est pas nécessaire d’atteindre un score de 100. Un score BLEU compris entre 40 et 60 indique une traduction de haute qualité.

Détails du modèle

Sélectionnez le panneau Détails du modèle.

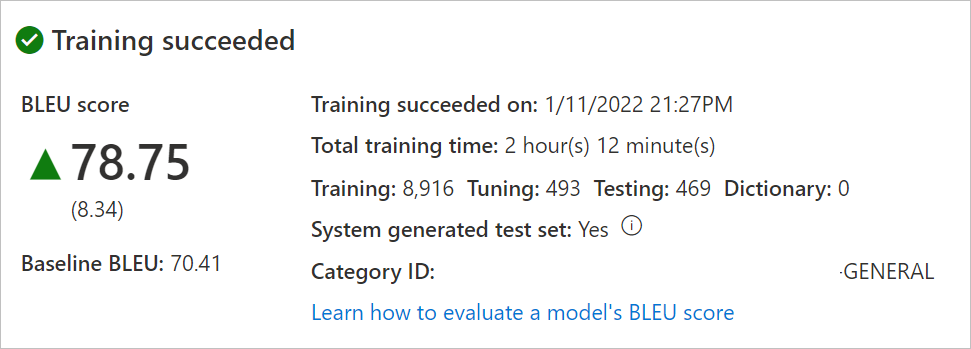

Sélectionnez le nom du modèle. Vérifiez la date/heure de l’entraînement, la durée totale de l’entraînement, le nombre de phrases utilisées pour l’entraînement, l’optimisation, le test et le dictionnaire. Vérifiez si le système a généré les jeux de test et d’optimisation. Utilisez

Category IDpour effectuer les demandes de traduction.Évaluez le score BLEU du modèle. Examinez l’ensemble de tests : le score BLEU est le score du modèle personnalisé et le BLEU de base est le modèle de base de référence pré-entraîné utilisé pour la personnalisation. Un score BLEU plus élevé signifie une très bonne qualité de traduction à l’aide du modèle personnalisé.

Tester la qualité de la traduction de votre modèle

Sélectionnez le panneau Tester le modèle.

Sélectionnez le Nom du modèle.

Évaluez manuellement la traduction à partir de votre Modèle personnalisé et du Modèle de référence (notre base de référence pré-entraînée utilisée pour la personnalisation) par rapport à la Référence (traduction cible du jeu de test).

Si ces résultats vous conviennent, faites une demande de déploiement pour le modèle concerné.