Note

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

S’APPLIQUE À : tous les niveaux de Gestion des API

Cet article explique comment importer une API Google Gemini compatible OpenAI pour accéder à des modèles tels que gemini-2.0-flash. Pour ces modèles, Gestion des API Azure peut gérer un point de terminaison de saisie semi-automatique compatible OpenAI.

En savoir plus sur la gestion des API IA dans Gestion des API :

Conditions préalables

- Une instance existante de gestion d’API. Si vous ne l’avez pas déjà fait, créez-en un.

- Clé API pour l’API Gemini. Si vous n’en avez pas, créez-le dans Google AI Studio et stockez-le dans un endroit sûr.

Importer une API Gemini compatible OpenAI à l’aide du portail

Dans le portail Azure, accédez à votre instance Gestion des API.

Dans le menu de gauche, sous API, sélectionnez API>+ Ajouter une API.

Sous Définir une nouvelle API, sélectionnez API De modèle de langage.

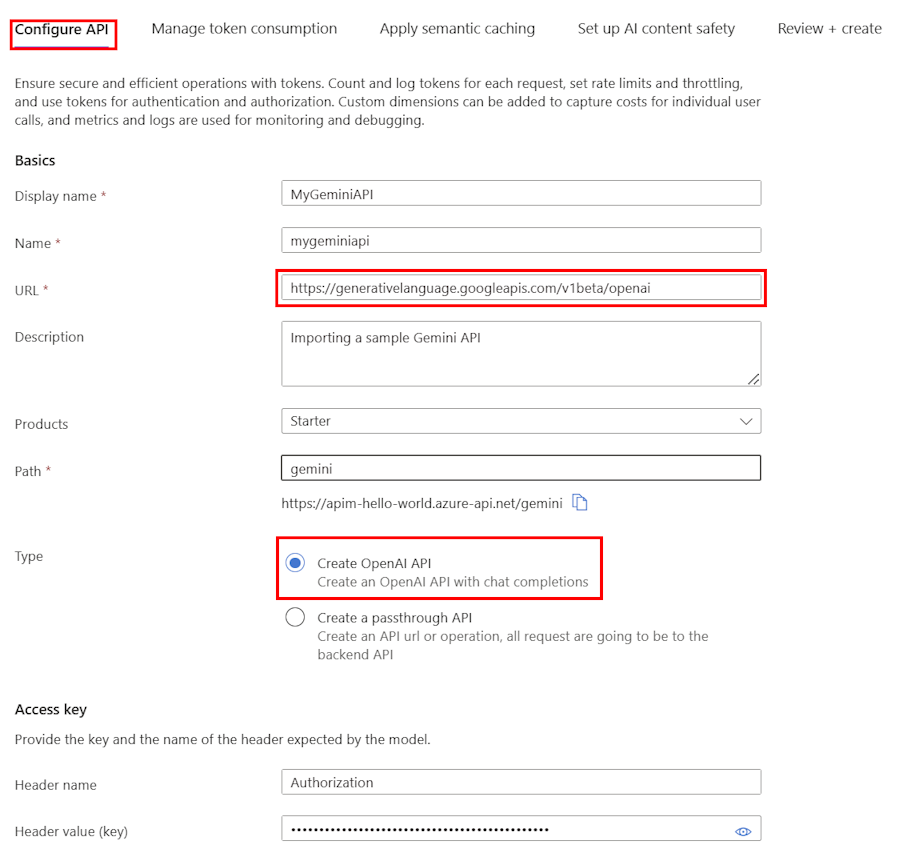

Sous l’onglet Configurer l’API :

Entrez un Nom d’affichage et une Description facultative pour l’API.

Dans l’URL, entrez l’URL de base suivante à partir de la documentation de compatibilité Gemini OpenAI :

https://generativelanguage.googleapis.com/v1beta/openaiDans Path, ajoutez un chemin d’accès que votre instance Gestion des API utilise pour acheminer les requêtes vers les points de terminaison de l’API Gemini.

Dans Type, sélectionnez Créer une API OpenAI.

Dans la clé Access, entrez les éléments suivants :

- Nom de l’en-tête : Autorisation.

- Valeur d’en-tête (clé) :

Bearersuivie de votre clé API pour l’API Gemini.

Sous les onglets restants, configurez éventuellement des stratégies pour gérer la consommation des jetons, la mise en cache sémantique et la sécurité du contenu IA. Pour plus d’informations, consultez Importer une API de modèle de langage.

Sélectionnez Révision.

Une fois que vos paramètres sont validés, sélectionnez Créer.

Gestion des API crée l’API et configure les éléments suivants :

- Une ressource back-end et une stratégie set-backend-service qui dirige les demandes d’API vers le point de terminaison Google Gemini.

- Accédez au back-end LLM à l’aide de la clé API Gemini que vous avez fournie. La clé est protégée en tant que valeur secrète nommée dans Gestion des API.

- (facultatif) Stratégies pour vous aider à surveiller et à gérer l’API.

Tester le modèle Gemini

Après avoir importé l’API, vous pouvez tester le point de terminaison de saisie semi-automatique de conversation pour l’API.

Sélectionnez l’API que vous avez créée à l’étape précédente.

Sélectionnez l’onglet Test.

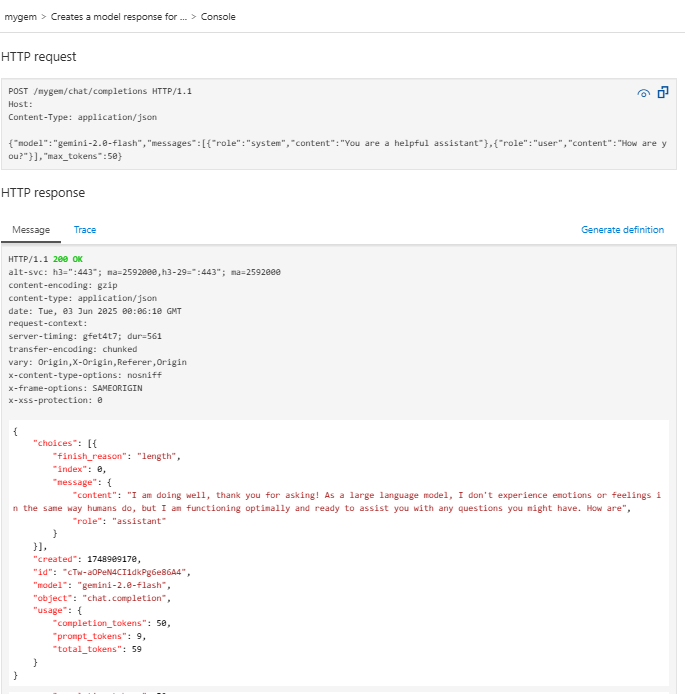

Sélectionnez l’opération

POST Creates a model response for the given chat conversation, qui est unePOSTrequête vers le/chat/completionspoint de terminaison.Dans la section Corps de la demande , entrez le code JSON suivant pour spécifier le modèle et un exemple d’invite. Dans cet exemple, le

gemini-2.0-flashmodèle est utilisé.{ "model": "gemini-2.0-flash", "messages": [ { "role": "system", "content": "You are a helpful assistant" }, { "role": "user", "content": "How are you?" } ], "max_tokens": 50 }Lorsque le test réussit, le backend répond avec un code de réponse HTTP réussi et quelques données. Les données d’utilisation des jetons sont ajoutées à la réponse pour vous aider à surveiller et à gérer la consommation de jetons de votre modèle linguistique.