Introduction

MLOps (DevOps pour le Machine Learning) met à la disposition des équipes en science des données et en informatique des pratiques de supervision, de validation et de gouvernance pour collaborer et accélérer le développement et le déploiement de modèles Machine Learning. MLOps apporte la philosophie de DevOps au Machine Learning (ML) en automatisant les workflows de bout en bout. MLOps fait partie d’Azure Machine Learning et peut être déployé sur des appareils IoT Edge.

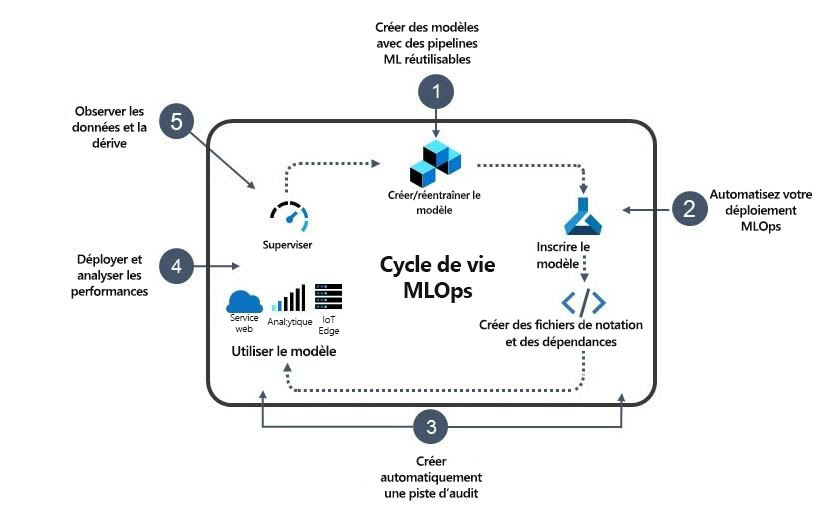

Le cycle de vie du Machine Learning de bout en bout est illustré ci-dessous :

Créez des modèles avec des pipelines Machine Learning réutilisables à l’aide de l’extension Azure Machine Learning pour Azure DevOps. Stockez votre code dans GitHub pour qu’il s’intègre automatiquement à votre pipeline MLOps.

Automatisez votre lancement MLOps à l’aide d’Azure DevOps + Azure Machine Learning pour les modèles de version avec une gestion avancée des métadonnées et des événements.

Créez automatiquement une piste d’audit pour tous les artefacts de votre pipeline MLOps pour garantir l’intégrité des ressources et répondre à la réglementation.

Déployez vos modèles et supervisez leurs performances pour pouvoir publier vos modèles en toute confiance et savoir quand les réentraîner.

Observez la dérive de données et les commentaires associés à vos modèles pour améliorer les entraînements futurs.

Le déploiement de modèles Machine Learning en production est l’une des principales sources de problèmes dans le workflow. Le processus de déploiement présente des défis supplémentaires quand la plateforme cible est IoT Edge. En voici quelques-uns :

Les modèles Machine Learning IoT évoluant rapidement, ils se dégradent plus vite (compte tenu de la dérive des données actuelles). Ils nécessitent donc des réentraînements automatiques plus fréquents.

Les modèles Machine Learning IoT doivent pouvoir être déployés sur différentes plateformes cibles, ce qui vous oblige à exploiter les capacités de ces plateformes en termes de performances, de sécurité, etc.

Les solutions IoT Edge peuvent avoir besoin de s’exécuter hors connexion. Vous devez alors autoriser le travail hors connexion en tenant compte de la fréquence d’actualisation des modèles.

Scénario

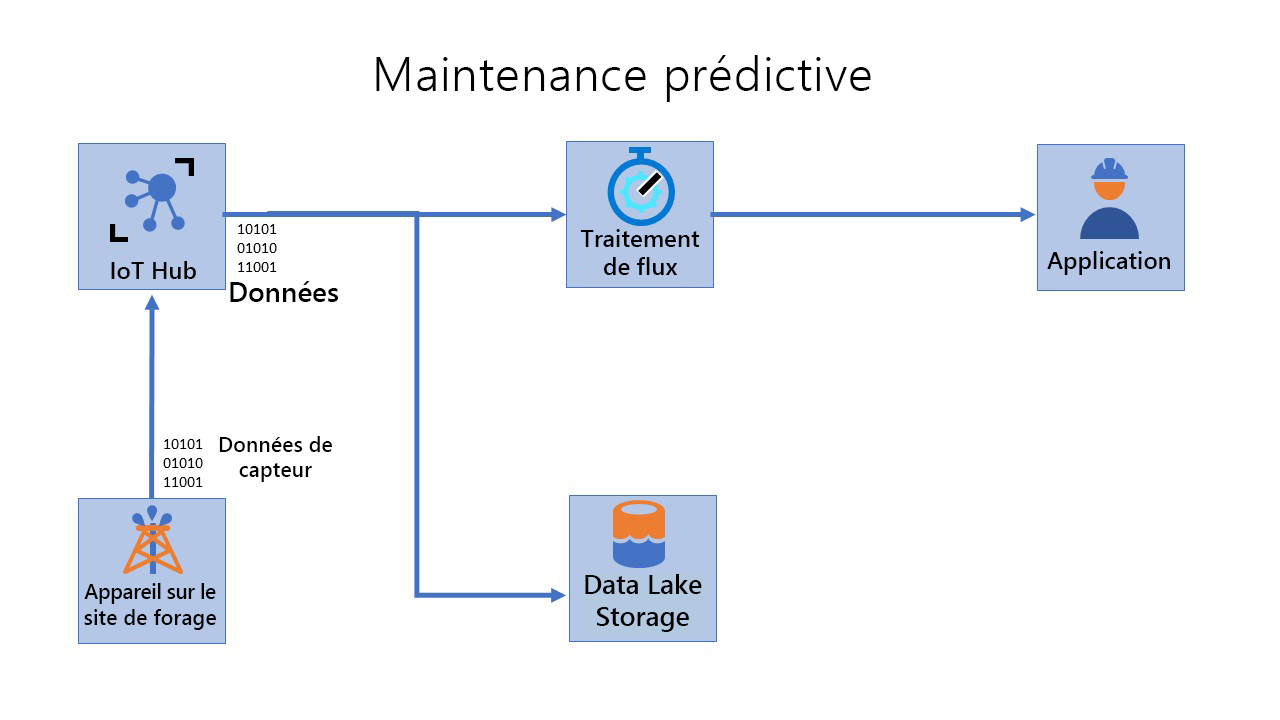

Prenons un exemple. Vous travaillez dans l’industrie pétrolière et gazière et vous êtes responsable de la maintenance de milliers de pompes en activité dans des sites distants/offshore. Même si ces sites sont distants, votre équipe doit rapidement identifier les pannes et les réparer sur le terrain. Vous souhaitez donc créer et déployer un système de maintenance prédictive pour les pompes. Avant de créer un modèle de maintenance prédictive, vous devez implémenter un système de supervision à distance des appareils connectés pour ingérer les données des capteurs dans un flux, les traiter et les stocker dans une base de données. IoT Edge permet actuellement à votre équipe d’atteindre ces objectifs. Vous pouvez ainsi récupérer les données de plusieurs capteurs connectés à des pompes sur le terrain. Pour l’instant, la détection des anomalies s’effectue visuellement dans un tableau de bord. Vos ingénieurs souhaitent donc déployer un nouveau système de maintenance prédictive capable de détecter des anomalies à partir de modèles Machine Learning à jour. Les modèles générés par le nouveau système de maintenance prédictive doivent refléter dynamiquement l’état actuel des données en tenant compte de la dérive de données. Le système doit donc autoriser le réentraînement automatique et fréquent des modèles pour indiquer l’état. Vous devez également déployer les modèles entraînés sur toute une gamme de pompes de différents fabricants. Le système doit utiliser les caractéristiques uniques des logiciels installés sur les pompes, aussi bien en matière de performances que de sécurité. Enfin, les modèles déployés doivent pouvoir s’exécuter hors connexion sur l’appareil périphérique si nécessaire. En atteignant ces objectifs, l’entreprise peut réduire considérablement ses coûts de maintenance et de production, accroître la sécurité au travail et diminuer son impact environnemental.

Ce module couvre le contrôle de code source, le pipeline d’entraînement reproductible, le stockage de modèles et la gestion de versions, l’empaquetage de modèles, la validation de modèles, le déploiement, la supervision de modèles en production et le réentraînement de modèles dans le contexte des appareils IoT Edge.

Dans ce module, vous allez examiner l’importance de MLOps pour IoT Edge dans le contexte du scénario ci-dessus pour le développement et le déploiement de modèles Machine Learning.