Filtrer et ingérer pour Azure Data Lake Storage Gen2 à l’aide de Stream Analytics sans éditeur de code

Cet article explique comment utiliser l’éditeur sans code pour créer facilement un travail Stream Analytics. Il lit en continu à partir de votre Event Hubs, filtre les données entrantes, puis écrit les résultats en continu dans Azure Data Lake Storage Gen2.

Prérequis

- Vos ressources Azure Event Hubs doivent être accessibles publiquement et ne peuvent pas résider derrière un pare-feu ou être sécurisées dans un réseau virtuel Azure

- Les données de votre instance d’Event Hubs doivent être sérialisées au format JSON, CSV ou Avro.

Développer un travail Stream Analytics pour filtrer et ingérer des données en temps réel

Sur le portail Azure, recherchez et sélectionnez l’instance d’Azure Event Hubs.

Sélectionnez Fonctionnalités>Traiter les données, puis sélectionnez Démarrer sur la carte Filtrer et ingérer vers ADLS Gen2.

Saisissez un nom pour le travail Stream Analytics, puis sélectionnez Créer.

Spécifiez le type de sérialisation de vos données dans la fenêtre Event Hubs et la méthode d’authentification que le travail utilisera pour se connecter aux Event Hubs. Sélectionnez Connecter.

Si la connexion est établie avec succès et que vous disposez de flux de données qui circulent dans l’instance Event Hubs, vous verrez immédiatement deux éléments :

- Champs présents dans les données d’entrée. Vous pouvez choisir Ajouter un champ ou sélectionner le symbole trois points en regard de chaque champ pour supprimer, renommer ou modifier son type.

- Exemple dynamique de données entrantes dans la table d’aperçu des données sous la vue diagramme. Il s’actualise automatiquement à intervalles réguliers. Vous pouvez sélectionner Suspendre la préversion de streaming pour afficher une vue statique des exemples de données d’entrée.

- Champs présents dans les données d’entrée. Vous pouvez choisir Ajouter un champ ou sélectionner le symbole trois points en regard de chaque champ pour supprimer, renommer ou modifier son type.

Sélectionnez la vignette Filtrer. Dans la zone Filtre, sélectionnez un champ pour filtrer les données entrantes avec une condition.

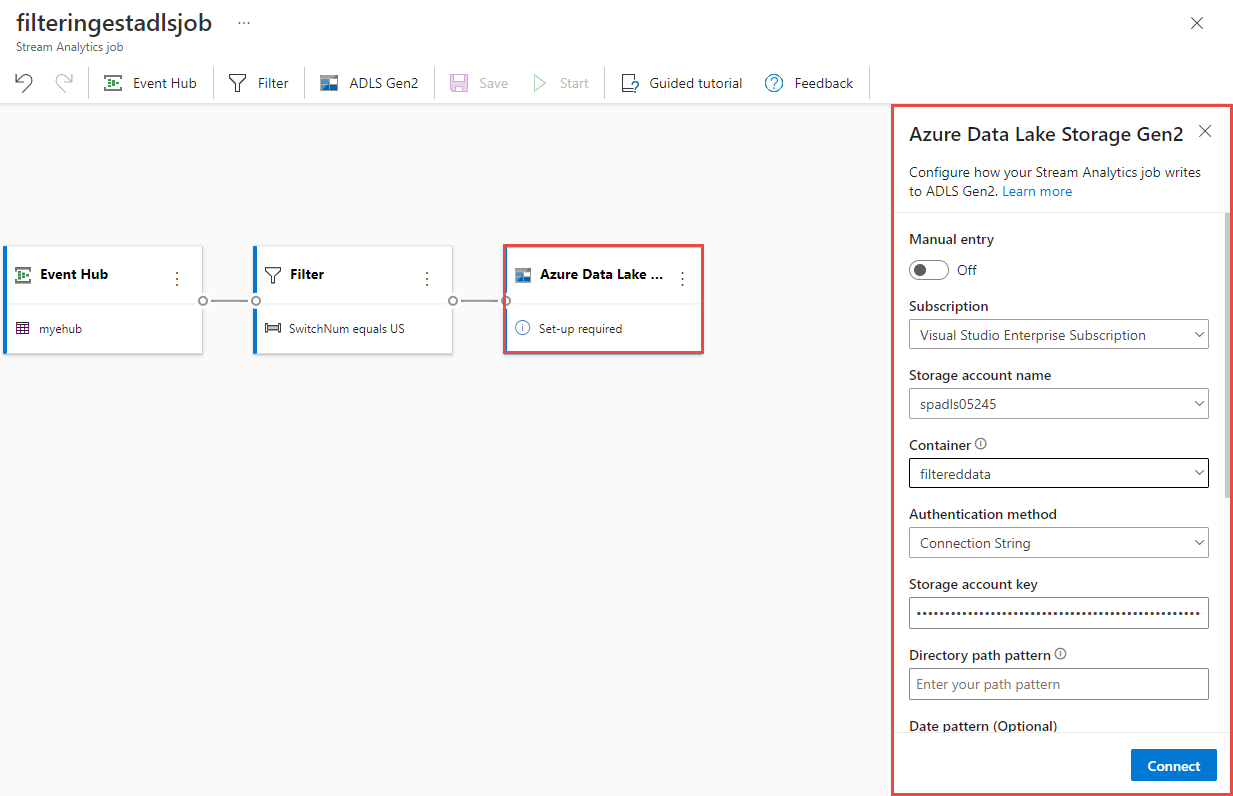

Sélectionnez la vignette Azure Data Lake Storage Gen2. Sélectionnez le compte Azure Data Lake Gen2 pour envoyer vos données filtrées :

- Sélectionnez l’abonnement, le nom du compte de stockage et le conteneur dans le menu déroulant.

- Une fois l’abonnement sélectionné, la méthode d’authentification et la clé de compte de stockage doivent être renseignées automatiquement. Sélectionnez Connecter.

Pour obtenir plus d'informations sur les champs ainsi que des exemples de modèle de chemin, consultez Sortie de stockage d’objets blob et Azure Data Lake Gen2 à partir d’Azure Stream Analytics.

Si vous le souhaitez, sélectionnez Obtenir l’aperçu statique/Actualiser la préversion statique pour afficher la préversion des données qui sera ingérée à partir d’Azure Data Lake Storage Gen2.

Sélectionnez Enregistrer, puis Démarrer le travail Stream Analytics.

Pour lancer le travail, spécifiez le nombre d'unités de streaming (SU) avec lesquelles le travail s'exécute. Les SU représentent les capacités de calcul et de mémoire allouées au travail. Nous vous recommandons de commencer par trois, puis d’ajuster selon les besoins.

Une fois que vous avez sélectionné Démarrer, le travail commence à s’exécuter dans les deux minutes, et les métriques s’ouvrent dans la section d’onglet en-dessous.

Vous pouvez voir le travail sous la section Traiter les données sous l’onglet Travaux Stream Analytics. Sélectionnez Actualiser jusqu’à ce que l’état du travail soit En cours d’exécution. Sélectionnez Ouvrir les métriques pour superviser le travail, ou pour l’arrêter et le redémarrer, selon les besoins.

Voici un exemple de page Métriques :

Vérifier les données dans Data Lake Storage

Vous voyez normalement des fichiers créés dans le conteneur que vous avez spécifié.

Téléchargez et ouvrez le fichier pour vérifier que vous voyez seulement les données filtrées. Dans l’exemple suivant, vous voyez des données avec SwitchNum défini sur US.

{"RecordType":"MO","SystemIdentity":"d0","FileNum":"548","SwitchNum":"US","CallingNum":"345697969","CallingIMSI":"466921402416657","CalledNum":"012332886","CalledIMSI":"466923101048691","DateS":"20220524","TimeType":0,"CallPeriod":0,"ServiceType":"S","Transfer":0,"OutgoingTrunk":"419","MSRN":"1416960750071","callrecTime":"2022-05-25T02:07:10Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:09.5140000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"552","SwitchNum":"US","CallingNum":"012351287","CallingIMSI":"262021390056324","CalledNum":"012301973","CalledIMSI":"466922202613463","DateS":"20220524","TimeType":3,"CallPeriod":0,"ServiceType":"V","Transfer":0,"OutgoingTrunk":"442","MSRN":"886932428242","callrecTime":"2022-05-25T02:07:13Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:12.7350000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"559","SwitchNum":"US","CallingNum":"456757102","CallingIMSI":"466920401237309","CalledNum":"345617823","CalledIMSI":"466923000886460","DateS":"20220524","TimeType":1,"CallPeriod":696,"ServiceType":"V","Transfer":1,"OutgoingTrunk":"419","MSRN":"886932429155","callrecTime":"2022-05-25T02:07:22Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:21.9190000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null}

Considérations relatives à l’utilisation de la fonctionnalité de géo Event Hubs

Azure Event Hubs a récemment lancé la fonctionnalité géo en préversion publique. Cette fonctionnalité est différente de la fonctionnalité récupération d’urgence géo d’Azure Event Hubs.

Lorsque le type de basculement est Forcé et que la cohérence de la réplication est Asynchrone, le travail Stream Analytics ne garantit pas exactement une sortie vers une sortie Azure Event Hubs.

Azure Stream Analytics, comme producteur avec un hub d’événements en tant que sortie, peut observer un retard de filigrane sur le travail pendant la durée de basculement et pendant la limitation par Event Hubs au cas où le décalage de réplication entre le serveur principal et le serveur secondaire atteint la limite maximale configurée de décalage.

Azure Stream Analytics, comme consommateur avec Event Hubs en tant qu’entrée, peut observer un délai de filigrane sur le travail pendant la durée de basculement et peut ignorer les données ou rechercher des données dupliquées une fois le basculement terminé.

En raison de ces avertissements, nous vous recommandons de redémarrer le travail Stream Analytics avec l’heure de début appropriée juste après la fin du basculement d’Event Hubs. En outre, étant donné que la fonctionnalité géo d’Event Hubs est en préversion publique, nous vous déconseillons d’utiliser ce modèle pour les travaux Stream Analytics de production à ce stade. Le comportement actuel de Stream Analytics s’améliore avant que la fonctionnalité de géo d’Event Hubs soit généralement disponible et puisse être utilisée dans des travaux de production Stream Analytics.

Étapes suivantes

En savoir plus sur Azure Stream Analytics et sur la surveillance du travail que vous avez créé.