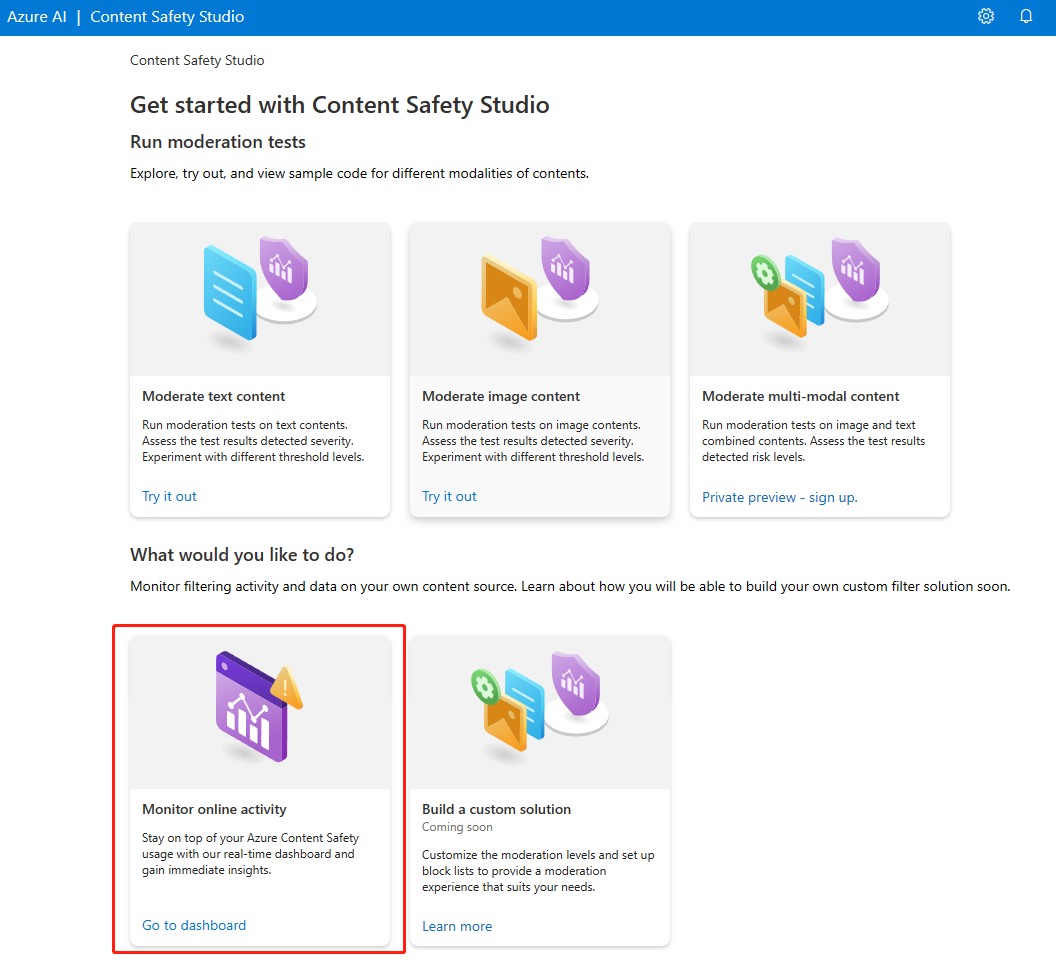

Démarrage rapide : Azure AI Content Safety Studio

Dans ce guide de démarrage rapide, commencez à utiliser le service Azure AI Sécurité du Contenu à l’aide de Content Safety Studio dans votre navigateur.

Attention

Certains des exemples de contenu fournis par Content Safety Studio peuvent être choquants. Les exemples d’images sont floutés par défaut. Ils s’adressent à des utilisateurs avertis.

Prérequis

- Un compte Azure actif. Si vous n’en avez pas, vous pouvez en créer un gratuitement.

- Une ressource Azure Content Safety.

- Connectez-vous à Content Safety Studio avec votre abonnement Azure et votre ressource Content Safety.

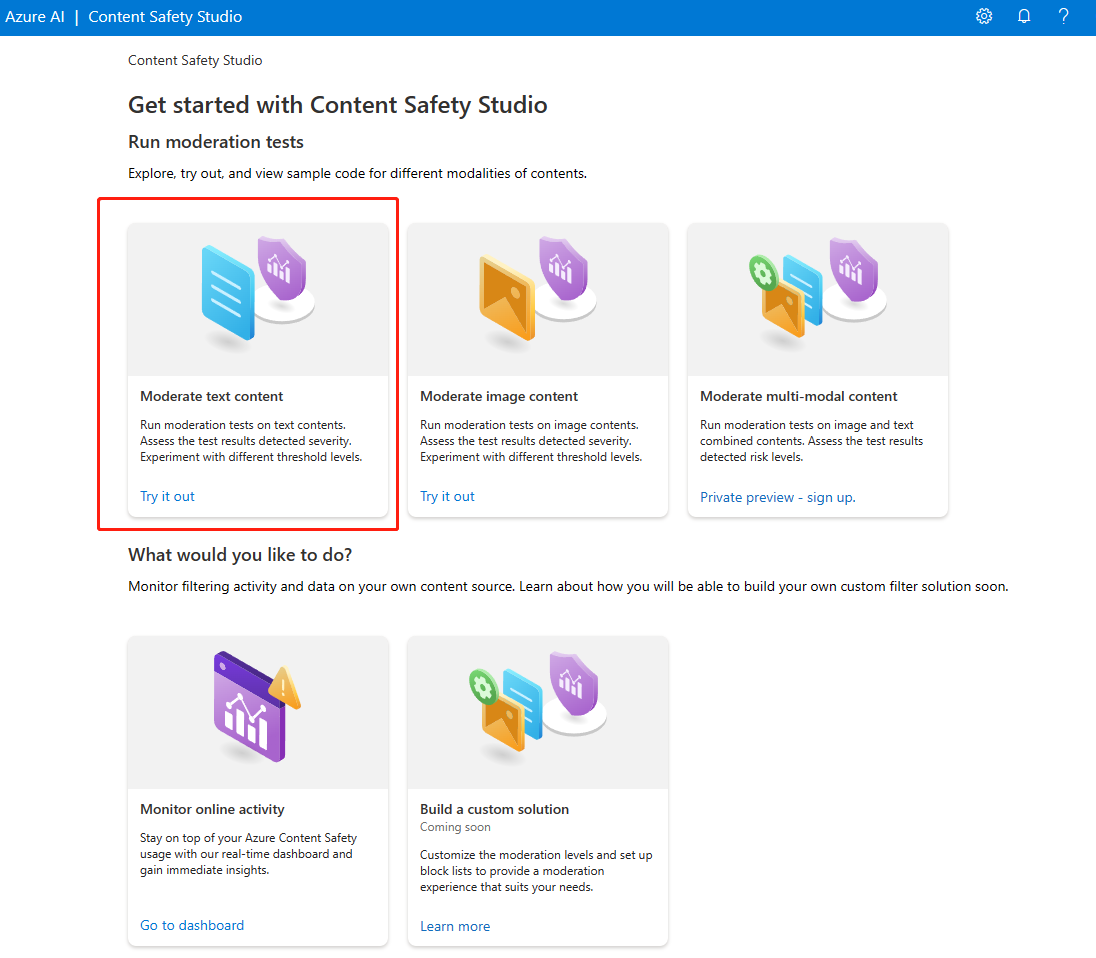

Analyser le contenu d’un texte

La page Modérer le contenu d’un texte vous permet de tester rapidement la modération du texte.

- Sélectionnez le panneau Modérer le contenu d’un texte.

- Ajoutez du texte au champ d’entrée ou sélectionnez un exemple de texte dans les panneaux de la page.

Conseil

Taille et granularité du texte

La longueur maximale par défaut pour les envois de texte est de 10 000 caractères.

- Sélectionnez Exécuter le test.

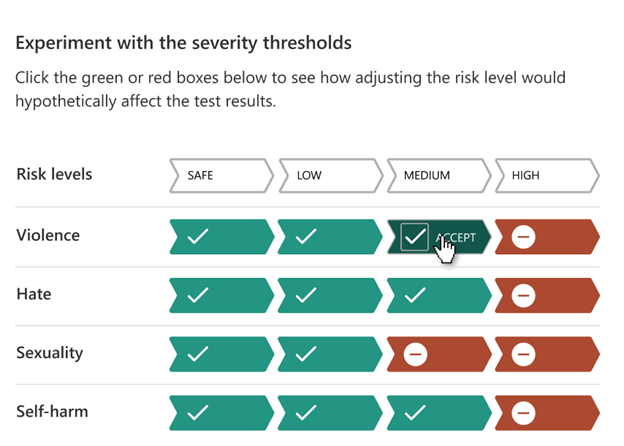

Le service retourne toutes les catégories qui ont été détectées, avec le niveau de gravité pour chacune (0-Sûr, 2-Faible, 4-Moyen, 6-Élevé). Il retourne également un résultat binaire Accepté/Refusé, en fonction des filtres que vous configurez. Utilisez la matrice de l’onglet Configurer les filtres à droite pour définir vos niveaux de gravité autorisés/interdits pour chaque catégorie. Ensuite, vous pouvez réexécuter le texte pour voir comment fonctionne le filtre.

L’onglet Utiliser une liste de refus à droite vous permet de créer, de modifier et d’ajouter une liste de refus au workflow de modération. Si une liste de refus est activée lorsque vous exécutez le test, vous obtenez un panneau Détection de liste de refus sous Résultats. Il signale toutes les correspondances avec la liste de refus.

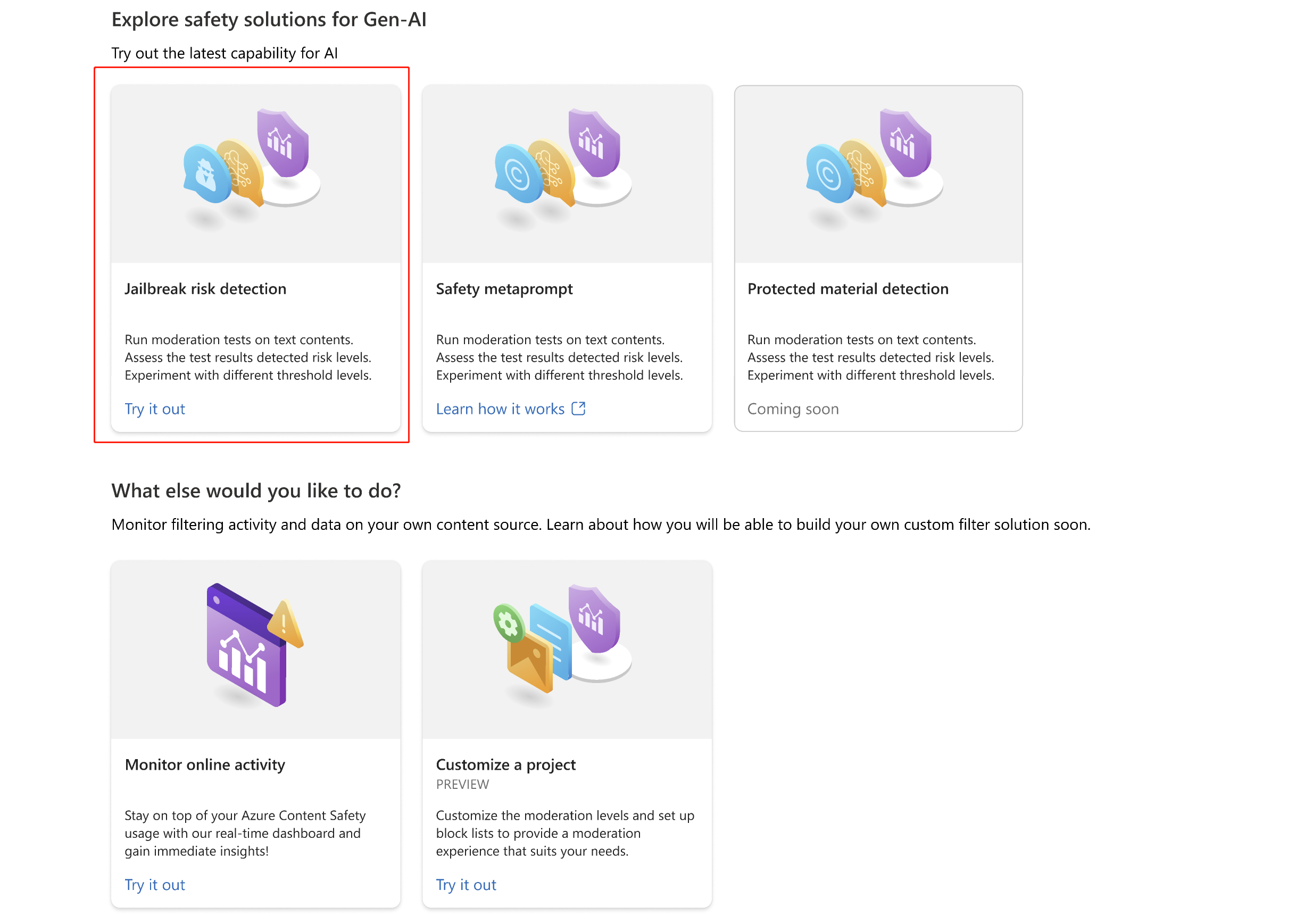

Détecter les attaques par entrée utilisateur

Le panneau Boucliers de prompt vous permet d’essayer la détection du risque d’entrée utilisateur. Détectez les prompts utilisateur conçus pour inciter le modèle d’IA générative à adopter des comportements qu’il a été entraîné à éviter ou à enfreindre les règles définies dans le message système. Ces attaques peuvent varier d’un rôle complexe à une subversion subtile de l’objectif de sécurité.

- Sélectionnez le panneau Boucliers de prompt.

- Sélectionnez un exemple de texte sur la page ou entrez votre propre contenu à des fins de test. Vous pouvez également charger un fichier CSV pour effectuer un test par lots.

- Sélectionnez Exécuter le test.

Le service renvoie l’indicateur et le type de risque pour chaque exemple.

Pour plus d’informations, consultez le guide conceptuel sur les boucliers de prompt.

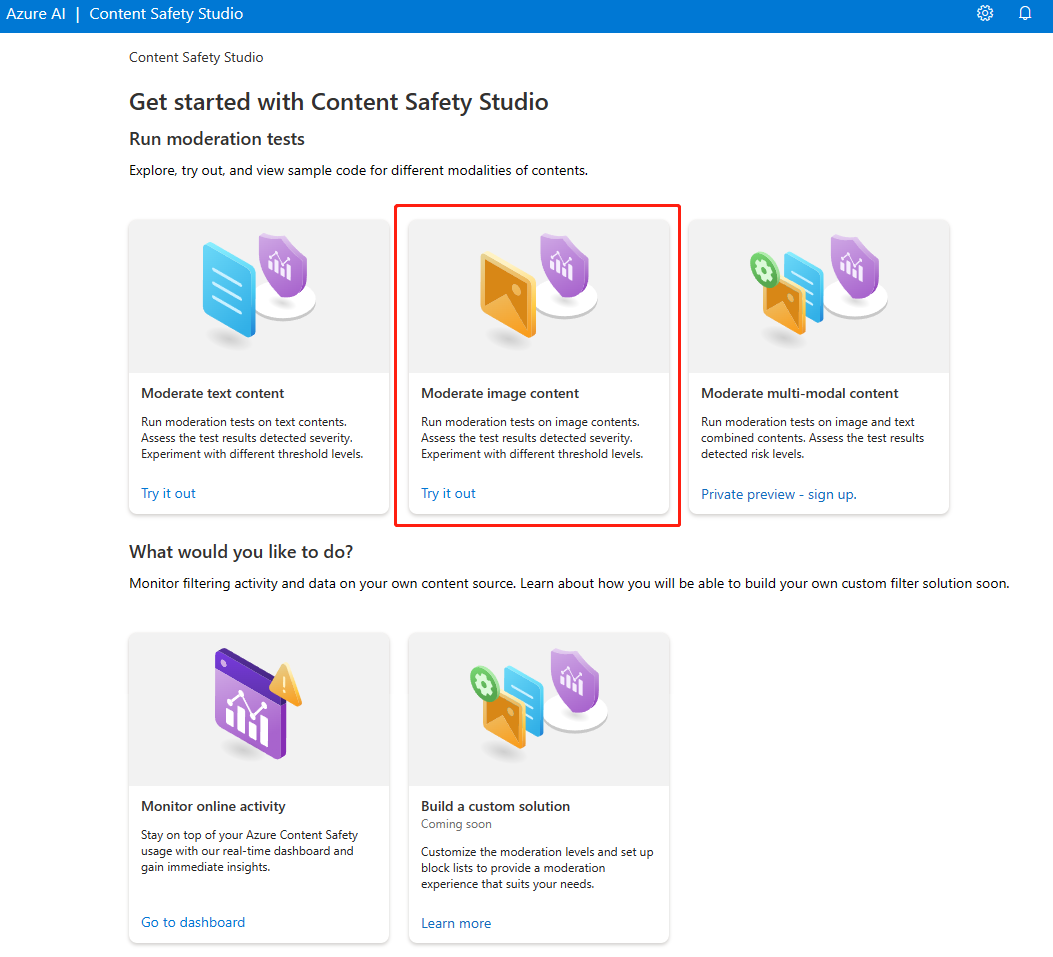

Analyser le contenu d’une image

La page Modérer le contenu d’une image vous permet de tester rapidement la modération d’une image.

- Sélectionnez le panneau Modérer le contenu d’une image.

- Sélectionnez un exemple d’image dans les panneaux de la page, ou chargez votre propre image. La taille maximale pour les envois d’images est de 4 Mo, et les dimensions de l’image doivent être comprises entre 50 x 50 pixels et 2 048 x 2 048 pixels. Les images peuvent être aux formats JPEG, PNG, GIF, BMP, TIFF ou WEBP.

- Sélectionnez Exécuter le test.

Le service retourne toutes les catégories qui ont été détectées, avec le niveau de gravité pour chacune (0-Sûr, 2-Faible, 4-Moyen, 6-Élevé). Il retourne également un résultat binaire Accepté/Refusé, en fonction des filtres que vous configurez. Utilisez la matrice de l’onglet Configurer les filtres à droite pour définir vos niveaux de gravité autorisés/interdits pour chaque catégorie. Ensuite, vous pouvez réexécuter le texte pour voir comment fonctionne le filtre.

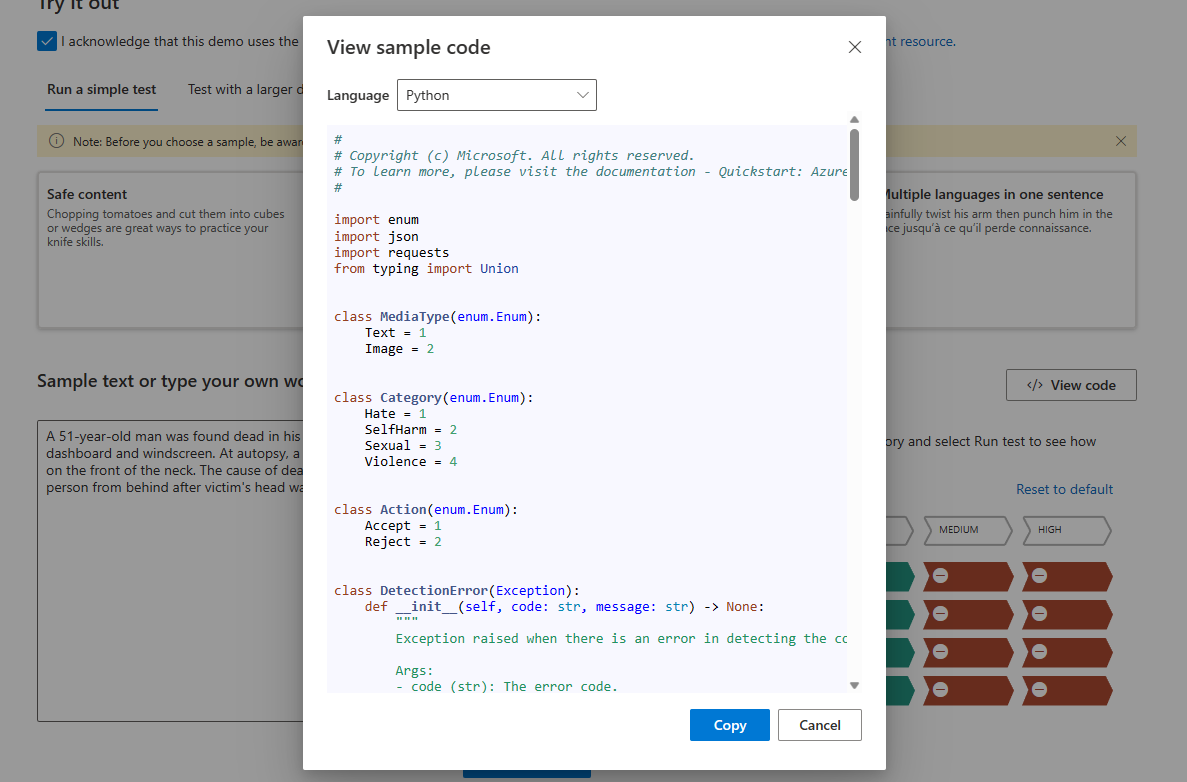

Afficher et exporter du code

Vous pouvez utiliser la fonctionnalité Afficher le code dans la page Analyser le contenu d’un texte ou Analyser le contenu d’une image pour afficher et copier l’exemple de code, qui comprend la configuration du filtrage de gravité, les listes de blocage et les fonctions de modération. Vous pouvez ensuite déployer le code de votre côté.

Surveiller l’activité en ligne

La page Surveiller l’activité en ligne vous permet de voir l’utilisation et les tendances de votre API.

Vous pouvez choisir le Type de média à surveiller. Vous pouvez également spécifier l’intervalle de temps que vous souhaitez vérifier en sélectionnant Afficher les données de la ou des dernières __.

Dans le graphique Taux de refus par catégorie, vous pouvez également ajuster les seuils de gravité pour chaque catégorie.

Vous pouvez également modifier les listes de blocage si vous souhaitez changer certains termes, en fonction du graphique Top 10 des termes bloqués.

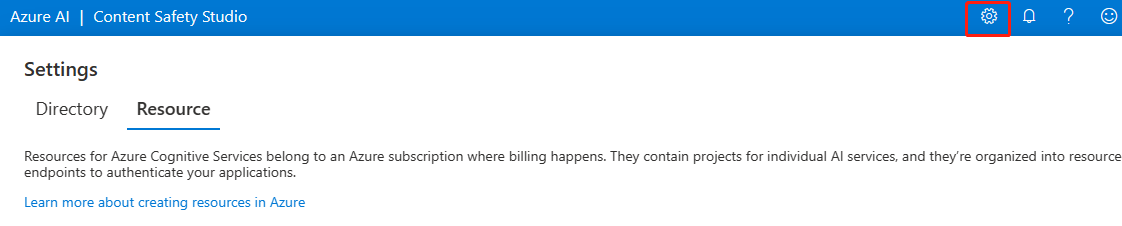

Gérer votre ressource

Pour afficher les détails d’une ressource comme son nom et son niveau tarifaire, sélectionnez l’icône Paramètres dans l’angle supérieur droit de la page d’accueil de Content Safety Studio, puis sélectionnez l’onglet Ressource. Si vous avez d’autres ressources, vous pouvez également changer de ressource ici aussi.

Nettoyer les ressources

Si vous voulez nettoyer et supprimer une ressource Azure AI services, vous pouvez supprimer la ressource ou le groupe de ressources. La suppression du groupe de ressources efface également les autres ressources qui y sont associées.

Étapes suivantes

Ensuite, commencez à utiliser Azure AI Sécurité du Contenu via les API REST ou un Kit de développement logiciel (SDK) client afin de pouvoir intégrer le service dans votre application de façon fluide.