Règles de collecte de données (DCR) dans Azure Monitor

Les Règles de collecte de données (DCR) font partie d’un processus de collecte de données de type ETL qui améliore les méthodes de collecte de données héritées pour Azure Monitor. Ce processus utilise un pipeline d’ingestion de données commun, le pipeline Azure Monitor, pour toutes les sources de données, et une méthode standard de configuration plus gérable et scalable que les autres méthodes. Les avantages spécifiques de la collecte de données basée sur les DCR sont les suivants :

- Méthode cohérente pour la configuration de différentes sources de données.

- Possibilité d’appliquer une transformation pour filtrer ou modifier les données entrantes avant leur stockage.

- Options de configuration évolutives prenant en charge l’infrastructure en tant que processus de code et DevOps.

- Option de pipeline de périphérie dans votre propre environnement pour fournir une scalabilité haut de gamme, des configurations réseau en couches et une connectivité périodique.

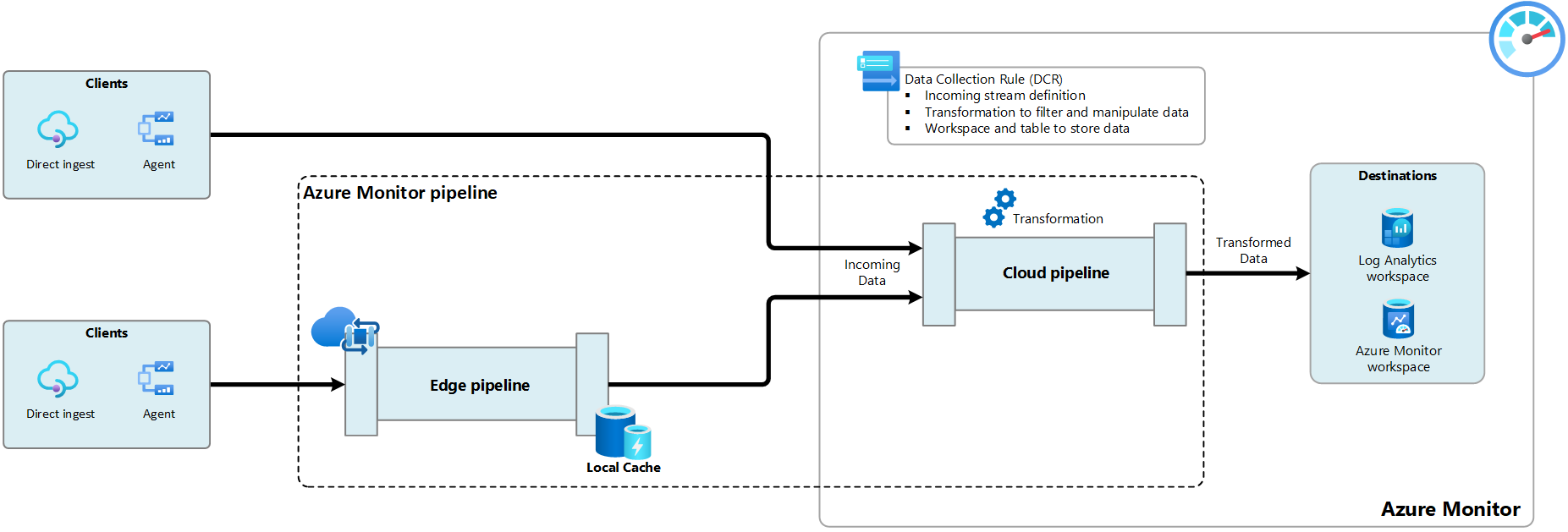

La collecte de données à l’aide du pipeline Azure Monitor est illustrée dans le diagramme ci-dessous. Chaque scénario de collecte est défini dans une DCR qui spécifie la façon dont les données doivent être traitées et où elles doivent être envoyées. Le pipeline Azure Monitor est constitué de deux composants :

- Le pipeline cloud est un composant d’Azure Monitor qui est automatiquement disponible dans votre abonnement Azure. Il ne nécessite aucune configuration et ne s’affiche pas dans le portail Azure. Il représente le chemin de traitement des données envoyées à Azure Monitor. La DCR fournit des instructions sur la façon dont le pipeline cloud doit traiter les données qu’il reçoit.

- Le pipeline de périphérie est un composant facultatif qui étend le pipeline Azure Monitor à votre propre centre de données. Il active la collecte à grande échelle et le routage des données de télémétrie avant qu’elles ne soient livrées au pipeline cloud. Consultez Pipeline de périphérie pour plus d’informations sur la valeur de ce composant.

Utilisation des règles de collecte de données

Les règles de collecte de données (DCR) sont stockées dans Azure pour être déployées et gérées de manière centralisée comme toutes les autres ressources Azure. Ce sont des ensembles d’instructions qui prennent en charge la collecte de données en utilisant le pipeline Azure Monitor. Elles fournissent un moyen cohérent et centralisé de définir et de personnaliser différents scénarios de collecte de données. Selon le scénario, les DCR spécifient des détails tels que les données à collecter, comment les transformer et où les envoyer.

Il y a deux façons fondamentales de spécifier des DCR pour un scénario de collecte de données particulier, comme décrit dans les sections suivantes.

Associations de règles de collecte de données (DCRA)

Les associations de règles de collecte de données (DCRA) sont utilisées pour associer une DCR à une ressource monitorée. Il s’agit d’une relation plusieurs-à-plusieurs, où une DCR peut être associée à plusieurs ressources, et une ressource peut être associée à plusieurs DCR. Cela vous permet de développer une stratégie pour assurer le monitoring sur différents ensembles de ressources qui ont des exigences différentes.

Par exemple, le diagramme suivant illustre la collecte de données pour l’agent Azure Monitor (AMA) exécuté sur une machine virtuelle. Une fois l’agent installé, il se connecte à Azure Monitor pour récupérer les DCR associées. Dans ce scénario, la DCR spécifie les événements et les données de performances à colelcter, que l’agent utilise pour déterminer les données à collecter à partir de la machine et les envoyer à Azure Monitor. Une fois les données livrées, le pipeline cloud exécute la transformation spécifiée dans la DCR pour filtrer et modifier les données, puis envoie les données à l’espace de travail et à la table spécifiés.

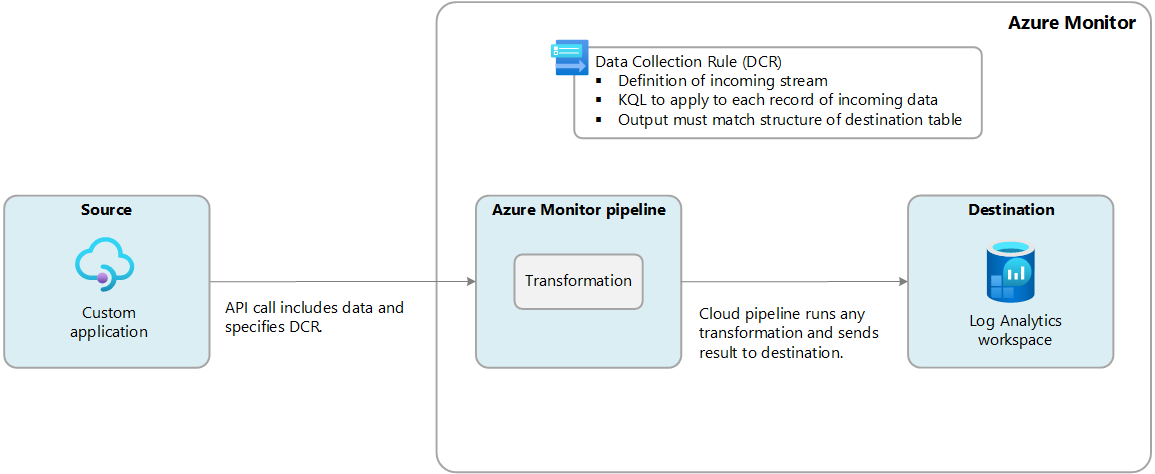

Ingestion directe

Avec l’ingestion directe, une DCR particulière est spécifiée pour traiter les données entrantes. Par exemple, le diagramme suivant illustre les données d’une application personnalisée en utilisant l’API d’ingestion des journaux. Chaque appel d’API spécifie la DCR qui doit traiter ses données. La DCR comprend la structure des données entrantes, inclut une transformation qui garantit que les données sont au format de la table cible et spécifie un espace de travail et une table auxquels envoyer les données transformées.

Transformations

Les transformations vous permettent de modifier les données entrantes avant leur stockage dans Azure Monitor. Vous pouvez filtrer les données inutiles pour réduire vos coûts d’ingestion, supprimer les données sensibles qui ne doivent pas être conservées dans l’espace de travail Log Analytics ou mettre en forme les données pour qu’elles correspondent au schéma de leur destination. Les transformations sont des requêtes KQL définies dans la DCR qui s’exécutent dans le pipeline cloud.

Points de terminaison

Les données envoyées au pipeline cloud doivent être envoyées sur l’URL d’un point de terminaison spécifique. Selon le scénario, il peut s’agir d’un point de terminaison public, d’un point de terminaison fourni par la DCR elle-même ou d’un point de terminaison de collecte de données (DCE) que vous créez dans votre abonnement Azure. Pour plus d’informations sur les points de terminaison utilisés dans différents scénarios de collecte de données, consultez Points de terminaison de collecte de données dans Azure Monitor.

Pipeline de périphérie

Le pipeline de périphérie étend le pipeline Azure Monitor à votre propre centre de données. Il prend en charge la collecte à grande échelle et le routage des données de télémétrie avant leur livraison à Azure Monitor dans le cloud Azure.

Les cas d’usage spécifiques du pipeline de périphérie Azure Monitor sont les suivants :

- Scalabilité. Le pipeline de périphérie peut gérer de grands volumes de données provenant de ressources monitorées qui peuvent être limitées par d’autres méthodes de collecte telles que l’agent Azure Monitor.

- Connectivité périodique. Dans certains environnements, la connectivité au cloud peut ne pas être fiable ou des pertes de connexion inattendues peuvent survenir pendant de longues périodes. Le pipeline de périphérie peut mettre en cache les données localement et se synchroniser avec le cloud une fois la connectivité restaurée.

- Réseau en couches. Dans certains environnements, le réseau est segmenté et les données ne peuvent pas être envoyées directement au cloud. Vous pouvez utiliser le pipeline de périphérie pour collecter des données à partir de ressources monitorées sans accès au cloud et gérer la connexion à Azure Monitor dans le cloud.

Scénarios de collecte de données

Le tableau suivant décrit les scénarios de collecte de données actuellement pris en charge avec les DCR et le pipeline Azure Monitor. Consultez les liens de chaque entrée pour plus d’informations sur sa configuration.

| Scénario | Description |

|---|---|

| Machines virtuelles | Installez l’agent Azure Monitor sur une machine virtuelle et associez-le à un ou plusieurs contrôleurs de domaine qui définissent les événements et les données de performances à collecter à partir du système d’exploitation client. Vous pouvez effectuer cette configuration à l’aide du portail Azure afin de ne pas avoir à modifier directement la DCR. Voir Collecter des données avec l’agent Azure Monitor. |

| Lorsque vous activez VM Insights sur une machine virtuelle, il déploie l’agent Azure Monitor sur la télémétrie à partir du client de machine virtuelle. La DCR est créée pour vous permettre de collecter automatiquement un ensemble prédéfini de données de performances. Consultez Activer la vue d’ensemble de VM Insights. |

|

| Container Insights | Lorsque vous activez Container Insights sur votre cluster Kubernetes, il déploie une version conteneurisée de l’agent Azure Monitor pour envoyer des journaux d’activité du cluster à un espace de travail Log Analytics. La DCR est créée automatiquement, mais vous devrez peut-être la modifier pour personnaliser vos paramètres de collection. Consultez Configurer la collecte de données dans Container Insights à l’aide d’une règle de collecte de données. |

| API d’ingestion de journaux | L’API d’ingestion des journaux vous permet d’envoyer des données à un espace de travail Log Analytics à partir de n’importe quel client REST. L’appel d’API spécifie la DCR pour accepter ses données et spécifie le point de terminaison de la DCR. La DCR comprend la structure des données entrantes, inclut une transformation qui garantit que les données sont au format de la table cible et spécifie un espace de travail et une table auxquels envoyer les données transformées. Consultez API Ingestion des journaux dans Azure Monitor. |

| Azure Event Hubs | Envoyer des données à un espace de travail Log Analytics à partir d’Azure Event Hubs. La DCR définit le flux entrant et définit la transformation pour mettre en forme les données de son espace de travail de destination et de sa table. Consultez Tutoriel : ingérer des événements d'Azure Event Hubs dans les journaux Azure Monitor (préversion publique) |

| DCR de transformation de l’espace de travail | La DCR de transformation de l’espace de travail est une DCR spéciale associée à un espace de travail Log Analytics et vous permet d’effectuer des transformations sur les données collectées à l’aide d’autres méthodes. Vous créez un DCR unique pour l’espace de travail et ajoutez une transformation à une ou plusieurs tables. La transformation est appliquée à toutes les données envoyées à ces tables par le biais d’une méthode qui n’utilise pas de DCR. Consultez DCR de transformation d’espace de travail dans Azure Monitor. |

Régions DCR

Les règles de collecte de données sont disponibles dans toutes les régions publiques où les espaces de travail Log Analytics et les clouds Azure Government et Chine sont pris en charge. Les clouds en « air gap » ne sont pas encore pris en charge. Une DCR est créée et stockée dans une région particulière, et est sauvegardée dans la région jumelée au sein de la même zone géographique. Le service est déployé sur les trois zones de disponibilité au sein de la région. Il s’agit donc d’un service redondant interzone, ce qui augmente encore la disponibilité.

Résidence des données monorégion est une fonctionnalité en préversion permettant le stockage de données client dans une seule région. Elle n’est actuellement disponible que dans la région Asie Sud-Est (Singapour) de la zone géographique Asie-Pacifique et dans la région Brésil Sud (État de Sao Paulo) de la zone géographique Brésil. La résidence monorégion est activée par défaut dans ces régions.

Étapes suivantes

Consultez les articles suivants pour plus d’informations sur la manière de travailler avec les DCR.

- Structure des règles de collecte des données pour obtenir une description de la structure JSON des DCR et des différents éléments utilisés pour les flux de travail.

- Exemples de règles de collecte de données (DCR) pour les exemples de DCR pour différents scénarios de collecte de données.

- Créer et modifier des règles de collecte de données (DCR) dans Azure Monitor pour différentes méthodes de création de DCR pour différents scénarios de collecte de données.

- Limites du service Azure Monitor pour connaître les limites qui s’appliquent à chaque règle de collecte de données.