Outils pour la migration de l’entrepôt de données Teradata vers Azure Synapse Analytics

Cet article est la sixième partie d’une série de sept parties qui fournit des conseils sur la migration de Netezza vers Azure Synapse Analytics. Cet article se concentre sur les meilleures pratiques pour les outils Microsoft et les outils tiers.

Outils de migration d’entrepôt de données

En migrant votre entrepôt de données existant vers Azure Synapse, vous bénéficiez des avantages suivants :

Une base de données analytique sécurisée, évolutive, à faible coût, native dans le cloud et avec paiement à l’utilisation.

L’écosystème analytique Microsoft riche qui existe sur Azure. Cet écosystème se compose de technologies permettant de moderniser votre entrepôt de données et étend vos fonctionnalités analytiques après la migration pour augmenter la valeur de votre entreprise.

Plusieurs outils de Microsoft et de partenaires tiers peuvent vous aider à migrer votre entrepôt de données existant vers Azure Synapse. Cet article décrit les types d’outils suivants :

Outils de migration de données et de base de données Microsoft.

Outils d’automatisation de l’entrepôt de données tiers pour automatiser et documenter la migration vers Azure Synapse.

Outils de migration de l’entrepôt de données tiers pour migrer le schéma et les données vers Azure Synapse.

Outils tiers pour combler les différences SQL entre le système de gestion de base de données de votre entrepôt de données existant et Azure Synapse.

Outils de migration de données Microsoft

Microsoft propose plusieurs outils pour vous aider à migrer votre entrepôt de données existant vers Azure Synapse, par exemple :

Services Microsoft pour le transfert de données physiques.

Services Microsoft pour l’ingestion de données.

Les sections suivantes décrivent ces outils de façon plus détaillée.

Microsoft Azure Data Factory

Data Factory est un service d’intégration de données hybride complètement managé, avec paiement à l’utilisation, pour un traitement ETL et ELT hautement évolutif. Il utilise Apache Spark pour traiter et analyser les données en parallèle et en mémoire afin de maximiser le débit.

Conseil

Data Factory vous permet de créer des pipelines d’intégration de données évolutifs sans code.

Les connecteurs Data Factory prennent en charge les connexions à des sources de données et des bases de données externes et disposent de modèles pour les tâches d’intégration de données courantes. Une interface graphique utilisateur de type navigateur front-end visuelle permet aux non-programmeurs de créer et d’exécuter des pipelines pour ingérer, transformer et charger des données. Les programmeurs plus expérimentés peuvent incorporer du code personnalisé, tel que des programmes Python.

Conseil

Data Factory permet un développement collaboratif entre les professionnels de l’entreprise et les professionnels de l’informatique.

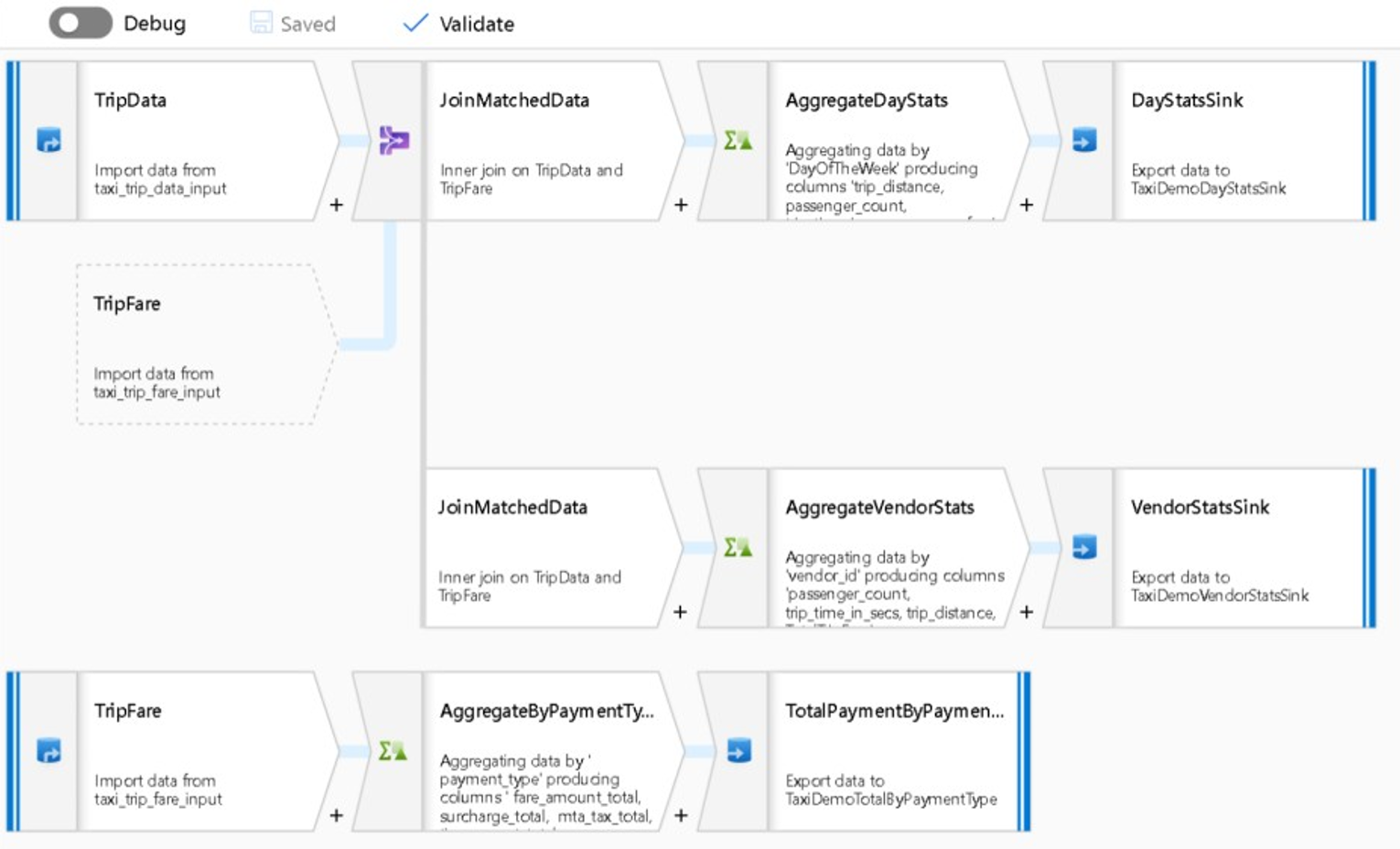

Data Factory est également un outil d’orchestration et est le meilleur outil Microsoft pour automatiser le processus de migration de bout en bout. Automation réduit les risques, les efforts et le temps de migration et rend le processus de migration facilement reproductible. Le schéma suivant illustre un flux de données de mappage dans Data Factory.

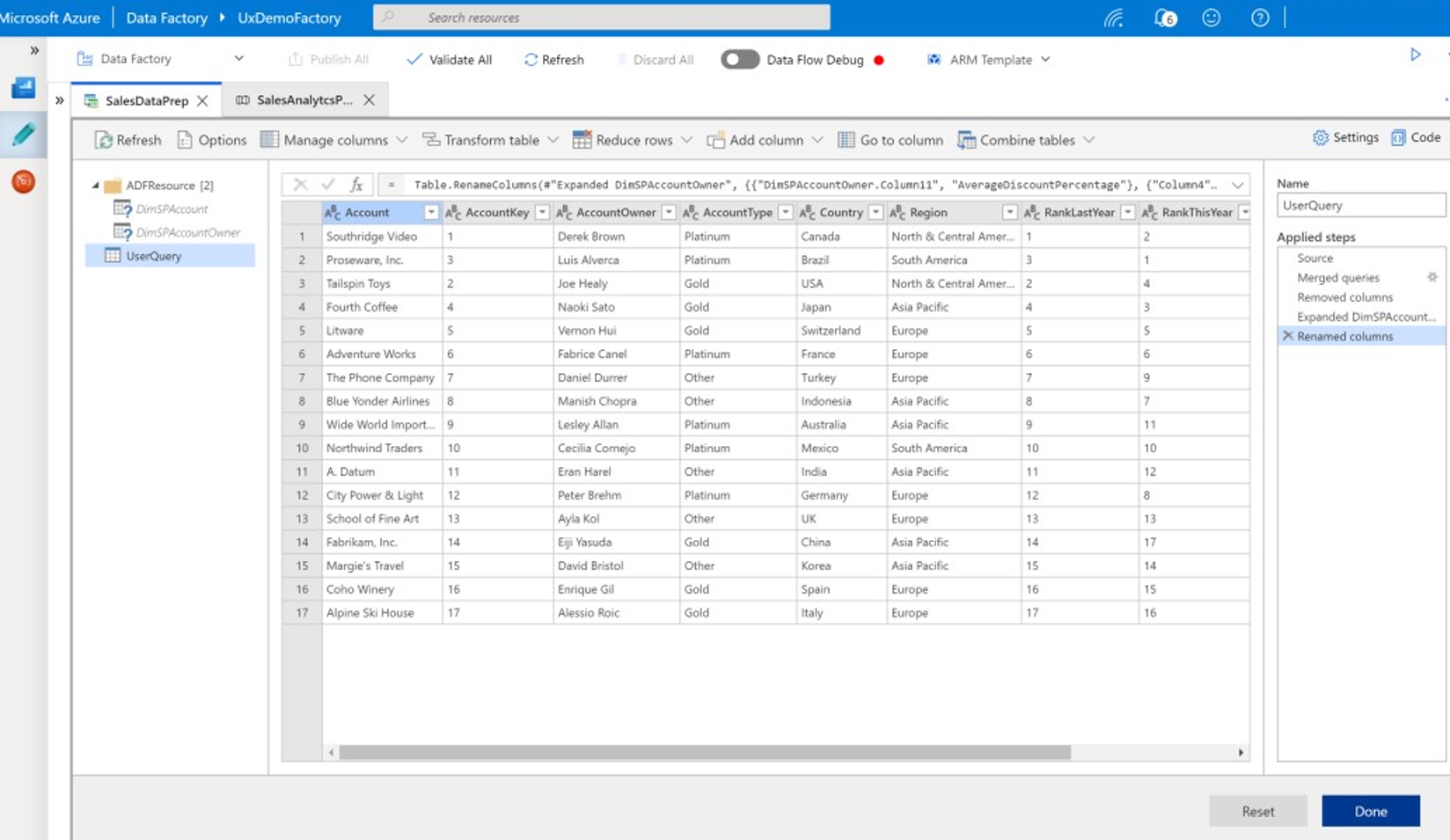

La capture d’écran suivante montre un flux de wrangling data dans Data Factory.

Dans Data Factory, vous pouvez développer des processus ETL et ELT simples ou complets sans codage ni maintenance en quelques clics. Les processus ETL/ELT comprennent l’ingestion, le déplacement, la préparation, la transformation et le traitement de vos données. Vous pouvez concevoir et gérer la planification et les déclencheurs dans Data Factory pour générer un environnement d’intégration et de chargement automatisés des données. Dans Data Factory, vous pouvez définir, gérer et planifier des processus de chargement de données en bloc PolyBase.

Conseil

Data Factory inclut des outils pour faciliter la migration de vos données et de l’ensemble de votre entrepôt de données vers Azure.

Vous pouvez utiliser Data Factory pour implémenter et gérer un environnement hybride avec des données locales, cloud, en diffusion en continu et SaaS de manière sécurisée et cohérente. Les données SaaS peuvent provenir d’applications telles que Salesforce.

Les flux de wrangling data correspondent à une nouvelle fonctionnalité dans Data Factory. Cette capacité ouvre Data Factory aux utilisateurs professionnels qui souhaitent découvrir visuellement, explorer et préparer des données à grande échelle sans écrire de code. Les flux de données wrangling offrent une préparation des données en libre-service, comme les flux de données Microsoft Excel, Power Query et Microsoft Power BI. Les utilisateurs professionnels peuvent préparer et intégrer des données via une interface utilisateur de style feuille de calcul avec des options de transformation déroulante.

Data Factory est l’approche recommandée pour implémenter des processus d’intégration de données et ETL/ELT pour un environnement Azure Synapse, en particulier si les processus hérités existants doivent être refactorisés.

Services Microsoft pour le transfert de données physiques.

Les sections suivantes décrivent une gamme de produits et de services que Microsoft propose pour aider les clients à transférer des données.

Azure ExpressRoute

Azure ExpressRoute crée des connexions privées entre les centres de données Azure et votre infrastructure locale ou dans un environnement de colocalisation. Les connexions ExpressRoute ne passent pas par l’Internet public. Elles offrent une plus grande fiabilité, des vitesses supérieures et des latences plus faibles par rapport à des connexions Internet classiques. Dans certains cas, l’utilisation de connexions ExpressRoute pour le transfert de données entre des systèmes locaux et Azure offre des avantages significatifs en matière de coûts.

AzCopy

AzCopy est un utilitaire de ligne de commande qui copie des fichiers vers le Stockage Blob Azure via une connexion Internet standard. Dans un projet de migration d’entrepôt, vous pouvez utiliser AzCopy pour charger des fichiers texte extraits, compressés et délimités avant de les charger dans Azure Synapse à l’aide de PolyBase. AzCopy peut charger des fichiers individuels, des sélections de fichiers ou des dossiers de fichiers. Si les fichiers exportés sont au format Parquet, utilisez plutôt un lecteur Parquet natif.

Azure Data Box

Azure Data Box est un service Microsoft qui vous fournit un appareil de stockage physique propriétaire sur lequel vous pouvez copier des données de migration. Vous envoyez ensuite l’appareil à un centre de données Azure pour le chargement des données vers le stockage cloud. Ce service peut être rentable pour de grands volumes de données (par exemple, des dizaines ou des centaines de téraoctets) ou lorsque la bande passante réseau n’est pas facilement disponible. Azure Data Box est généralement utilisé pour un grand chargement ponctuel de données historiques dans Azure Synapse.

Azure Data Box Gateway

Azure Data Box Gateway est un dispositif de passerelle de stockage cloud virtualisé qui réside localement et envoie vos données image, multimédias et autres vers Azure. Utilisez Data Box Gateway pour les tâches de migration ponctuelles ou les chargements de données incrémentielles en cours.

Services Microsoft pour l’ingestion de données.

Les sections suivantes décrivent les produits et services que Microsoft propose pour aider les clients pour l’ingestion des données.

COPY INTO

L’instruction COPY INTO offre une souplesse maximale pour l’ingestion de données à débit élevé dans Azure Synapse. Pour plus d’informations sur les capacités de COPY INTO, consultez COPY (Transact-SQL).

PolyBase

PolyBase est la méthode la plus rapide et la plus évolutive pour le chargement de données en masse dans Azure Synapse. PolyBase utilise l’architecture de traitement massivement parallèle (MPP) d’Azure Synapse pour le chargement parallèle de données afin d’obtenir le débit le plus rapide. PolyBase peut lire des données à partir de fichiers plats dans le Stockage Blob Azure, ou directement à partir de sources de données externes et d’autres bases de données relationnelles via des connecteurs.

Conseil

PolyBase peut charger des données en parallèle à partir du Stockage Blob Azure dans Azure Synapse.

PolyBase peut également lire directement à partir de fichiers compressés avec gzip, ce qui réduit le volume physique des données pendant un processus de chargement. PolyBase prend en charge les formats de données populaires tels que le texte délimité, ORC et Parquet.

Conseil

Vous pouvez appeler PolyBase à partir de Data Factory dans le cadre d’un pipeline de migration.

PolyBase est étroitement intégré à Data Factory pour prendre en charge le développement rapide des processus ETL/ELT de chargement de données. Vous pouvez planifier des processus de chargement de données via une interface utilisateur visuelle pour une productivité plus élevée et moins d’erreurs que le code écrit manuellement. Microsoft recommande PolyBase pour l’ingestion de données dans Azure Synapse, en particulier pour l’ingestion de données à volume élevé.

PolyBase utilise des instructions CREATE TABLE AS ou INSERT...SELECT pour charger les données.

CREATE TABLE AS réduit la journalisation pour obtenir le débit le plus élevé. Le format d’entrée le plus efficace pour le chargement des données est le fichier texte délimité et compressé. Pour un débit maximal, fractionnez des fichiers d’entrée volumineux en plusieurs fichiers plus petits et chargez-les en parallèle. Pour un chargement plus rapide vers une table intermédiaire, définissez la table cible comme type HEAP et utilisez la distribution par tourniquet (round robin).

PolyBase a certaines limitations, par exemple, que la longueur de ligne de données soit inférieure à 1 mégaoctet et ne prend pas en charge les formats imbriqués à largeur fixe comme JSON et XML.

Partenaires Microsoft pour les migrations Netezza

Les partenaires Microsoft offrent des outils, des services et de l’expertise pour vous aider à migrer votre plateforme d’entrepôt de données locale héritée vers Azure Synapse.

Étapes suivantes

Pour en savoir plus sur l’implémentation d’entrepôts de données modernes, consultez l’article suivant de cette série : Au-delà de la migration Netezza, l’implémentation d’un entrepôt de données moderne dans Microsoft Azure.