Qu’est-ce qu’Azure Content Moderator ?

Important

Azure Content Moderator sera déconseillé en février 2024 et mis hors service d’ici février 2027. Il est remplacé par Azure AI Sécurité du Contenu, qui offre des fonctionnalités d’IA avancées et des performances améliorées.

Azure AI Content Safety est une solution complète conçue pour détecter le contenu nuisible généré par l’utilisateur et généré par l’IA dans les applications et les services. Azure AI Content Safety convient à de nombreux scénarios tels que les places de marché en ligne, les sociétés de jeux, les plateformes de messagerie sociale, les entreprises de médias d’entreprise et les fournisseurs de solutions d’enseignement primaire et secondaire. Voici une vue d’ensemble de ses fonctionnalités :

- API détection de texte et d’images : analysez le texte et les images pour détecter le contenu à caractère sexuel, la violence, la haine et l’automutilation selon plusieurs niveaux de gravité.

- Content Safety Studio : outil en ligne conçu pour gérer le contenu potentiellement choquant, à risque ou indésirable en utilisant nos derniers modèles ML de modération de contenu. Il fournit des modèles et des workflows personnalisés qui permettent aux utilisateurs de créer leur propre système de modération de contenu.

- Prise en charge linguistique : Azure AI Content Safety prend en charge plus de 100 langues et est spécifiquement formé sur l’anglais, l’allemand, le japonais, l’espagnol, le français, l’italien, le portugais et le chinois.

Azure AI Content Safety fournit une solution robuste et flexible qui répond à vos besoins de modération de contenu. En passant de Content Moderator à Azure AI Content Safety, vous pouvez tirer parti des derniers outils et technologies pour vous assurer que votre contenu est toujours modéré selon vos spécifications exactes.

Apprenez-en davantage sur Azure AI Content Safety et découvrez comment il peut améliorer votre stratégie de modération de contenu.

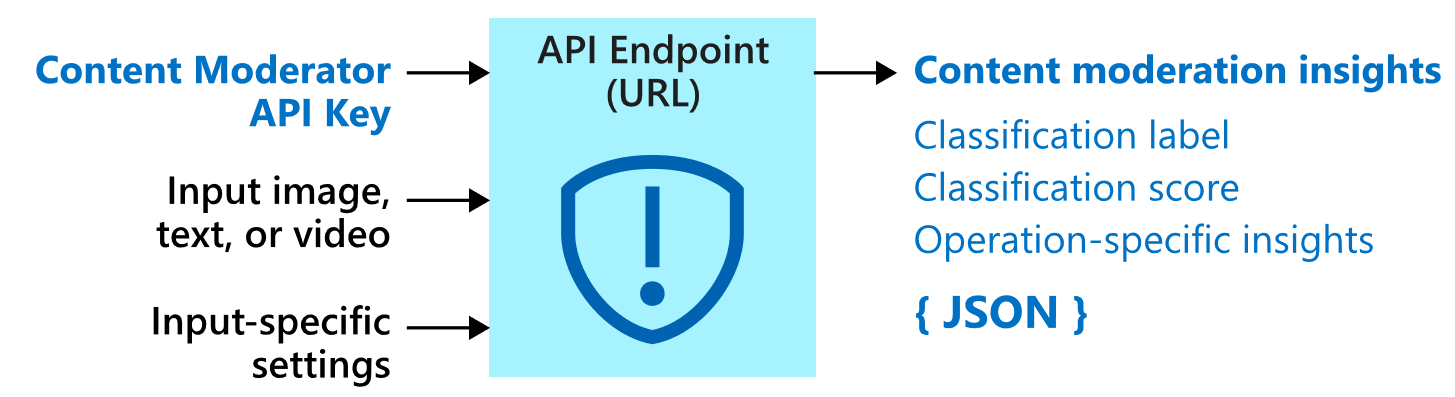

Azure Content Moderator est un service d’IA qui vous permet de gérer le contenu potentiellement offensant, risqué ou indésirable. Il inclut le service de modération de contenu alimenté par l’IA qui analyse le texte, les images et les vidéos, et applique automatiquement des indicateurs de contenu.

Vous pouvez être amené à intégrer un logiciel de filtrage de contenu dans votre application afin de vous conformer aux réglementations ou de maintenir l’environnement souhaité pour vos utilisateurs.

Cette documentation contient les types d’articles suivants :

- Les Démarrages rapides sont des instructions de prise en main qui vous guident dans la formulation de vos requêtes au service.

- Les Guides pratiques contiennent des instructions sur l’utilisation du service de manière plus spécifique ou personnalisée.

- Les Concepts fournissent des explications approfondies sur les fonctions et fonctionnalités du service.

Pour une approche plus structurée, suivez un module de formation pour Content Moderator.

Utilisation

Voici quelques scénarios dans lesquels un développeur de logiciels ou une équipe requiert un service de modération de contenu :

- Modération des catalogues de produits et du contenu généré par l’utilisateur sur les marketplaces en ligne

- Modération des artefacts créés par les utilisateurs et des messageries instantanées par les sociétés de jeu

- Modération des images, du texte et des vidéos ajoutés par les utilisateurs sur les plateformes de messagerie sociale

- Mise en place par les sociétés de contenu d’entreprise d’un système de modération centralisé du contenu

- Filtrage du contenu inapproprié pour les élèves et les enseignants par les fournisseurs de solutions éducatives (maternelle-terminale)

Important

Vous ne pouvez pas utiliser Content Moderator pour détecter des images illégales d’exploitation d’enfants. Toutefois, les organisations qualifiées peuvent utiliser le service cloud PhotoDNA de Microsoft pour détecter ce type de contenu.

Contenu

Le service Content Moderator se compose de plusieurs API de service web disponibles via les appels REST et un SDK .NET.

API de modération

Le service Content Moderator inclut des API de modération qui vérifient le contenu afin d'y détecter des éléments potentiellement inappropriés ou répréhensibles.

Le tableau suivant décrit les différents types d’API de modération.

| Groupe d’API | Description |

|---|---|

| Modération de texte | Analyse du texte à la recherche de contenu offensant, de contenu sexuellement explicite ou suggestif, de blasphèmes et de données personnelles. |

| Listes de termes personnalisées | Analyse du texte par rapport à une liste personnalisée de termes, en plus des termes prédéfinis. Utilisez les listes personnalisées pour bloquer ou autoriser du contenu en fonction de vos propres stratégies de contenu. |

| Modération d’images | Analyse des images à la recherche de contenu pour adultes et osé, détection de texte dans les images grâce à la reconnaissance optique des caractères (OCR) et détection des visages. |

| Listes d’images personnalisées | Analyse des images par rapport à une liste d’images personnalisée. Utilisez les listes d’images personnalisées pour filtrer les instances de contenu récurrent que vous ne souhaitez pas classifier à nouveau. |

| Modération de vidéos | Analyse des vidéos à la recherche de contenu pour adultes ou osé, en renvoyant des marqueurs de temps pour ce contenu. |

Sécurité et confidentialité des données

Comme avec tous les services Azure AI services, les développeurs utilisant le service Content Moderator doivent connaître les politiques de Microsoft relatives aux données client. Pour obtenir plus d’informations, consultez la page Azure AI services du Centre de gestion de la confidentialité Microsoft.

Étapes suivantes

- Effectuez un démarrage rapide de la bibliothèque cliente ou de l’API REST pour implémenter les scénarios de base dans du code.