Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Ce contenu s’applique à :![]() v3.0 (GA)

v3.0 (GA)![]() v3.1 (GA)

v3.1 (GA)![]() v4.0 (GA)

v4.0 (GA)

Azure AI Intelligence documentaire est un service Azure AI qui vous permet de générer des logiciels de traitement de données automatisé à l’aide de la technologie Machine Learning. Intelligence documentaire vous permet d’identifier et d’extraire du texte, des paires clé/valeur, des marques de sélection et des données de tableau de vos documents, et bien plus encore. Les résultats sont fournis sous forme de données structurées qui.../ incluent les relations dans le fichier d’origine. Les conteneurs traitent uniquement les données qui leur sont fournies et utilisent uniquement les ressources auxquelles ils sont autorisés à accéder. Les conteneurs ne peuvent pas traiter des données d’autres régions.

Dans cet article, vous découvrez comment télécharger, installer et exécuter des conteneurs Intelligence documentaire. Les conteneurs vous permettent d’exécuter le service Intelligence documentaire dans votre propre environnement. Les conteneurs conviennent particulièrement bien à certaines exigences de sécurité et de gouvernance des données.

Le modèle de disposition est pris en charge par les conteneurs Document Intelligence v4.0.

Les modèles Lecture, Disposition, ID du document, Reçu et Facture sont pris en charge par les conteneurs de Document Intelligence v3.1.

Les modèles Lecture, Disposition, Document général, Carte de visite et Personnalisation sont pris en charge par les conteneurs Intelligence documentaire v3.0.

Support de version

La prise en charge des conteneurs est disponible avec Intelligence documentaire version v3.0: 2022-08-31 (GA) pour tous les modèles, version v3.1 2023-07-31 (GA) pour les modèles Lecture, Disposition, Document d’identité, Reçu et Facture et version v4.0 2024-11-30 (GA) pour Disposition :

- API REST

v3.0: 2022-08-31 (GA) - API REST

v3.1: 2023-07-31 (GA) - API REST

v4.0: 2024-11-30 (GA) - Bibliothèques de client ciblant

REST API v3.0: 2022-08-31 (GA) - Bibliothèques de client ciblant

REST API v3.1: 2023-07-31 (GA) - Bibliothèques de client ciblant

REST API v4.0: 2024-11-30 (GA)

Prérequis

Pour commencer, il vous faut un compte Azure actif. Si vous n’en avez pas, vous pouvez créer un compte gratuit.

Vous avez également besoin des éléments suivants pour utiliser les conteneurs Intelligence documentaire :

| Obligatoire | Objectif |

|---|---|

| Bonne connaissance de Docker | Vous devez comprendre les concepts de base liés à Docker (comme les registres, les référentiels, les conteneurs et les images conteneurs), et connaître les principaux docker utilisés pour . |

| Moteur Docker installé |

|

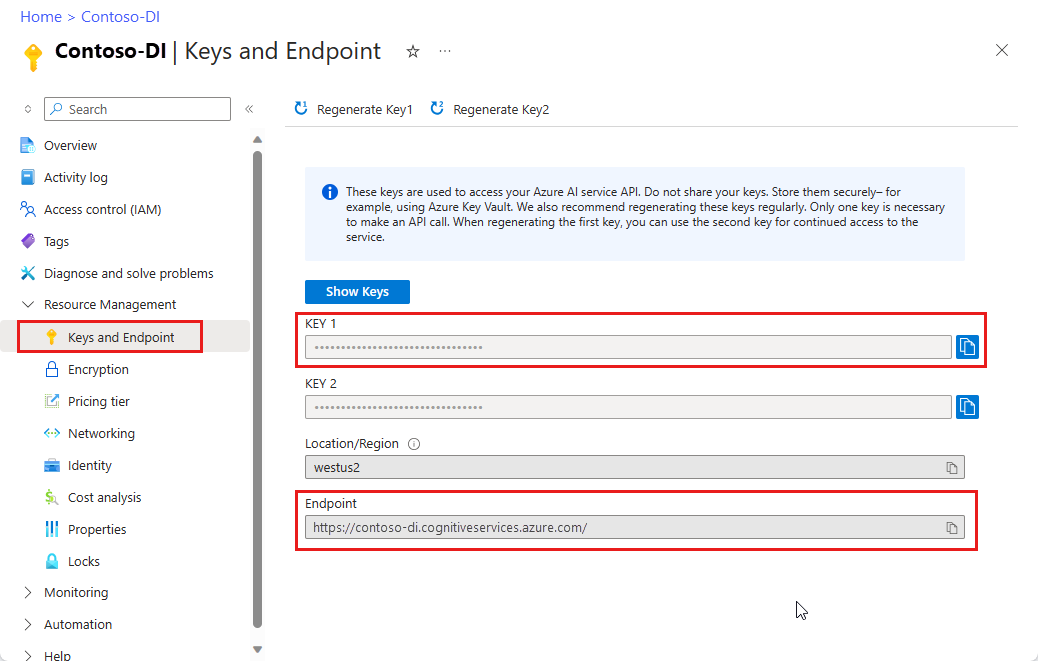

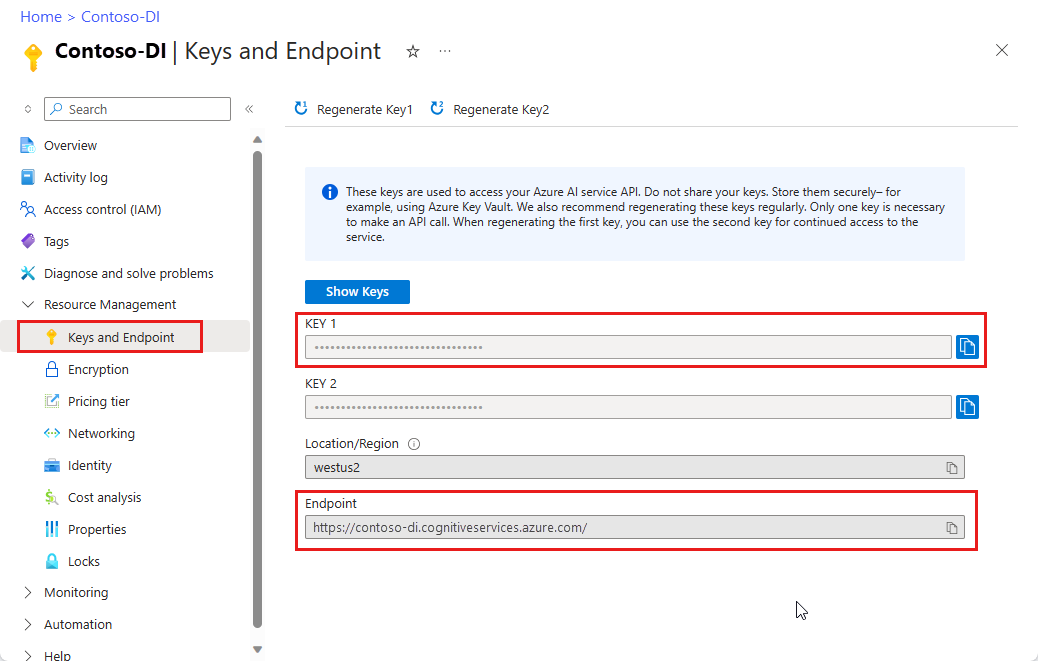

| Ressource Intelligence documentaire | Une ressource Azure AI Intelligence documentaire à service unique ou multiservice dans le Azure Portal. Pour utiliser ces conteneurs, vous devez disposer de la clé et de l’URI de point de terminaison associés. Ces deux valeurs sont disponibles dans la page Clés et point de terminaison Intelligence documentaire dans le Portail Azure :

|

| Facultatif | Objectif |

|---|---|

| Azure CLI (interface de ligne de commande) | L’interface Azure CLI vous permet d’utiliser un ensemble de commandes en ligne pour créer et gérer des ressources Azure. Elle peut s’installer dans les environnements Windows, macOS et Linux, et s’exécuter dans un conteneur Docker et Azure Cloud Shell. |

Ordinateur hôte requis

L’hôte est un ordinateur x64 qui exécute le conteneur Docker. Il peut s’agir d’un ordinateur local ou d’un service d’hébergement Docker dans Azure, comme :

- Azure Kubernetes Service.

- Azure Container Instances.

- Un cluster Kubernetes déployé sur Azure Stack. Pour plus d’informations, consultez Déployer Kubernetes sur Azure Stack.

Remarque

Le conteneur Studio ne peut pas être déployé et exécuté dans Azure Kubernetes Service. Le conteneur Studio est uniquement pris en charge pour s’exécuter sur des ordinateurs locaux.

Exigences et suggestions relatives au conteneur

Conteneurs de prise en charge requis

Le tableau suivant liste le ou les conteneurs qui prennent en charge chacun des conteneurs Intelligence documentaire que vous téléchargez. Pour plus d’informations, consultez la section Facturation.

| Conteneur de fonctionnalités | Conteneurs de soutien |

|---|---|

| Lire | Non requis |

| Mise en page | Non requis |

| Carte de visite | Lire |

| Document général | Mise en page |

| Facture | Mise en page |

| Réception | Lecture ou Mise en page |

| Document d’ID | Lire |

| Modèle personnalisé | Mise en page |

Cœurs de processeur et mémoire recommandés

Remarque

Les valeurs minimale et recommandée sont basées sur les limites de Docker, pas sur les ressources de la machine hôte.

Conteneurs d'intelligence documentaire

| Conteneur | Minimum | Recommandé |

|---|---|---|

Read |

8 cœurs, 10 Go de mémoire |

8 cœurs, 24 Go de mémoire |

Layout |

8 cœurs, 16 Go de mémoire |

8 cœurs, 24 Go de mémoire |

Business Card |

8 cœurs, 16 Go de mémoire |

8 cœurs, 24 Go de mémoire |

General Document |

8 cœurs, 12 Go de mémoire |

8 cœurs, 24 Go de mémoire |

ID Document |

8 cœurs, 8 Go de mémoire |

8 cœurs, 24 Go de mémoire |

Invoice |

8 cœurs, 16 Go de mémoire |

8 cœurs, 24 Go de mémoire |

Receipt |

8 cœurs, 11 Go de mémoire |

8 cœurs, 24 Go de mémoire |

Custom Template |

8 cœurs, 16 Go de mémoire |

8 cœurs, 24 Go de mémoire |

- Chaque cœur doit être cadencé à au moins 2,6 gigahertz (GHz).

- Le nombre de cœurs et la quantité de mémoire correspondent aux paramètres

--cpuset--memory, qui sont utilisés dans le cadre de la commandedocker composeoudocker run.

Conseil

Vous pouvez utiliser la commande docker images pour lister vos images conteneurs téléchargées. Par exemple, la commande suivante liste l’ID, le référentiel et la balise de chaque image conteneur téléchargée dans un tableau :

docker images --format "table {{.ID}}\t{{.Repository}}\t{{.Tag}}"

IMAGE ID REPOSITORY TAG

<image-id> <repository-path/name> <tag-name>

Exécuter le conteneur à l’aide de la commande docker-compose up

Remplacez les valeurs {ENDPOINT_URI} et {API_KEY} par votre URI de point de terminaison de ressource et la clé dans la page de ressources Azure.

Vérifiez que la valeur de

EULAest définie sur accepter.Vous devez spécifier les valeurs

EULA,BillingetApiKey; sinon, le conteneur ne démarrera pas.

Important

Les clés sont utilisées pour accéder à votre ressource Intelligence documentaire. Ne partagez pas vos clés. Stockez-les en toute sécurité, par exemple, à l’aide de Azure Key Vault. Nous vous recommandons également de régénérer ces clés régulièrement. Une seule clé est nécessaire pour effectuer un appel d’API. Lors de la régénération de la première clé, vous pouvez utiliser la deuxième clé pour un accès continu au service.

L’exemple de code suivant est un exemple docker compose autonome permettant d’exécuter le conteneur Intelligence documentaire Disposition. Avec docker compose, vous utilisez un fichier YAML pour configurer les services de votre application. Ensuite, avec la commande docker-compose up, vous créez et démarrez tous les services à partir de votre configuration. Entrez les valeurs {FORM_RECOGNIZER_ENDPOINT_URI} et {FORM_RECOGNIZER_KEY} pour votre instance de conteneur Disposition.

version: "3.9"

services:

azure-form-recognizer-layout:

container_name: azure-form-recognizer-layout

image: mcr.microsoft.com/azure-cognitive-services/form-recognizer/layout-4.0

environment:

- EULA=accept

- billing={FORM_RECOGNIZER_ENDPOINT_URI}

- apiKey={FORM_RECOGNIZER_KEY}

ports:

- "5000:5000"

networks:

- ocrvnet

networks:

ocrvnet:

driver: bridge

Maintenant, vous pouvez démarrer le service à l’aide de la commande docker compose :

docker-compose up

Exécuter le conteneur à l’aide de la commande docker-compose up

Remplacez les valeurs {ENDPOINT_URI} et {API_KEY} par votre URI de point de terminaison de ressource et la clé dans la page de ressources Azure.

Vérifiez que la valeur de

EULAest définie sur accepter.Vous devez spécifier les valeurs

EULA,BillingetApiKey; sinon, le conteneur ne démarrera pas.

Important

Les clés sont utilisées pour accéder à votre ressource Intelligence documentaire. Ne partagez pas vos clés. Stockez-les en toute sécurité, par exemple, à l’aide de Azure Key Vault. Nous vous recommandons également de régénérer ces clés régulièrement. Une seule clé est nécessaire pour effectuer un appel d’API. Lors de la régénération de la première clé, vous pouvez utiliser la deuxième clé pour un accès continu au service.

L’exemple de code suivant est un exemple docker compose autonome permettant d’exécuter le conteneur Intelligence documentaire Disposition. Avec docker compose, vous utilisez un fichier YAML pour configurer les services de votre application. Ensuite, avec la commande docker-compose up, vous créez et démarrez tous les services à partir de votre configuration. Entrez les valeurs {FORM_RECOGNIZER_ENDPOINT_URI} et {FORM_RECOGNIZER_KEY} pour votre instance de conteneur Disposition.

version: "3.9"

services:

azure-form-recognizer-layout:

container_name: azure-form-recognizer-layout

image: mcr.microsoft.com/azure-cognitive-services/form-recognizer/layout-3.1

environment:

- EULA=accept

- billing={FORM_RECOGNIZER_ENDPOINT_URI}

- apiKey={FORM_RECOGNIZER_KEY}

ports:

- "5000:5000"

networks:

- ocrvnet

networks:

ocrvnet:

driver: bridge

Maintenant, vous pouvez démarrer le service à l’aide de la commande docker compose :

docker-compose up

Créer un fichier docker compose

Nommez ce fichier docker-compose.yml

L’exemple de code suivant est un exemple

docker composeautonome permettant d’exécuter ensemble des conteneurs Intelligence documentaire Disposition, Studio et Modèle personnalisé. Avecdocker compose, vous utilisez un fichier YAML pour configurer les services de votre application. Ensuite, avec la commandedocker-compose up, vous créez et démarrez tous les services à partir de votre configuration.

version: '3.3'

services:

nginx:

image: nginx:alpine

container_name: reverseproxy

depends_on:

- layout

- custom-template

volumes:

- ${NGINX_CONF_FILE}:/etc/nginx/nginx.conf

ports:

- "5000:5000"

layout:

container_name: azure-cognitive-service-layout

image: mcr.microsoft.com/azure-cognitive-services/form-recognizer/layout-3.0:latest

environment:

eula: accept

apikey: ${FORM_RECOGNIZER_KEY}

billing: ${FORM_RECOGNIZER_ENDPOINT_URI}

Logging:Console:LogLevel:Default: Information

SharedRootFolder: /share

Mounts:Shared: /share

Mounts:Output: /logs

volumes:

- type: bind

source: ${SHARED_MOUNT_PATH}

target: /share

- type: bind

source: ${OUTPUT_MOUNT_PATH}

target: /logs

expose:

- "5000"

custom-template:

container_name: azure-cognitive-service-custom-template

image: mcr.microsoft.com/azure-cognitive-services/form-recognizer/custom-template-3.0:latest

restart: always

depends_on:

- layout

environment:

AzureCognitiveServiceLayoutHost: http://azure-cognitive-service-layout:5000

eula: accept

apikey: ${FORM_RECOGNIZER_KEY}

billing: ${FORM_RECOGNIZER_ENDPOINT_URI}

Logging:Console:LogLevel:Default: Information

SharedRootFolder: /share

Mounts:Shared: /share

Mounts:Output: /logs

volumes:

- type: bind

source: ${SHARED_MOUNT_PATH}

target: /share

- type: bind

source: ${OUTPUT_MOUNT_PATH}

target: /logs

expose:

- "5000"

studio:

container_name: form-recognizer-studio

image: mcr.microsoft.com/azure-cognitive-services/form-recognizer/studio:3.0

environment:

ONPREM_LOCALFILE_BASEPATH: /onprem_folder

STORAGE_DATABASE_CONNECTION_STRING: /onprem_db/Application.db

volumes:

- type: bind

source: ${FILE_MOUNT_PATH} # path to your local folder

target: /onprem_folder

- type: bind

source: ${DB_MOUNT_PATH} # path to your local folder

target: /onprem_db

ports:

- "5001:5001"

user: "1000:1000" # echo $(id -u):$(id -g)

Créer un fichier docker compose

Nommez ce fichier docker-compose.yml

L’exemple de code suivant est un exemple

docker composeautonome permettant d’exécuter ensemble des conteneurs Intelligence documentaire Disposition, Studio et Modèle personnalisé. Avecdocker compose, vous utilisez un fichier YAML pour configurer les services de votre application. Ensuite, avec la commandedocker-compose up, vous créez et démarrez tous les services à partir de votre configuration.

version: '3.3'

services:

nginx:

image: nginx:alpine

container_name: reverseproxy

depends_on:

- layout

- custom-template

volumes:

- ${NGINX_CONF_FILE}:/etc/nginx/nginx.conf

ports:

- "5000:5000"

layout:

container_name: azure-cognitive-service-layout

image: mcr.microsoft.com/azure-cognitive-services/form-recognizer/layout-3.1:latest

environment:

eula: accept

apikey: ${FORM_RECOGNIZER_KEY}

billing: ${FORM_RECOGNIZER_ENDPOINT_URI}

Logging:Console:LogLevel:Default: Information

SharedRootFolder: /share

Mounts:Shared: /share

Mounts:Output: /logs

volumes:

- type: bind

source: ${SHARED_MOUNT_PATH}

target: /share

- type: bind

source: ${OUTPUT_MOUNT_PATH}

target: /logs

expose:

- "5000"

custom-template:

container_name: azure-cognitive-service-custom-template

image: mcr.microsoft.com/azure-cognitive-services/form-recognizer/custom-template-3.1:latest

restart: always

depends_on:

- layout

environment:

AzureCognitiveServiceLayoutHost: http://azure-cognitive-service-layout:5000

eula: accept

apikey: ${FORM_RECOGNIZER_KEY}

billing: ${FORM_RECOGNIZER_ENDPOINT_URI}

Logging:Console:LogLevel:Default: Information

SharedRootFolder: /share

Mounts:Shared: /share

Mounts:Output: /logs

volumes:

- type: bind

source: ${SHARED_MOUNT_PATH}

target: /share

- type: bind

source: ${OUTPUT_MOUNT_PATH}

target: /logs

expose:

- "5000"

studio:

container_name: form-recognizer-studio

image: mcr.microsoft.com/azure-cognitive-services/form-recognizer/studio:3.1

environment:

ONPREM_LOCALFILE_BASEPATH: /onprem_folder

STORAGE_DATABASE_CONNECTION_STRING: /onprem_db/Application.db

volumes:

- type: bind

source: ${FILE_MOUNT_PATH} # path to your local folder

target: /onprem_folder

- type: bind

source: ${DB_MOUNT_PATH} # path to your local folder

target: /onprem_db

ports:

- "5001:5001"

user: "1000:1000" # echo $(id -u):$(id -g)

Le conteneur de modèles personnalisé et le conteneur de disposition peut utiliser des files d’attente Stockage Azure ou des files d’attente en mémoire. Les variables d’environnement Storage:ObjectStore:AzureBlob:ConnectionString et queue:azure:connectionstring ne doivent être définies que si vous utilisez des files d’attente Stockage Azure. En cas d’exécution locale, supprimez ces variables.

Veiller à ce que le service soit en cours d’exécution

Pour s'assurer que le service est opérationnel. exécutez ces commandes dans un interpréteur Ubuntu.

$cd <folder containing the docker-compose file>

$source .env

$docker-compose up

Les conteneurs de modèle personnalisé nécessitent quelques configurations différentes et prennent en charge d’autres configurations facultatives.

| Réglage | Obligatoire | Descriptif |

|---|---|---|

EULA |

Oui | Acceptation de licence. Exemple : Eula=accept |

| Facturation | Oui | URI de point de terminaison de facturation de la ressource FR |

| ApiKey | Oui | Clé de point de terminaison de la ressource FR |

| Queue:Azure:ConnectionString | Non | Chaîne de connexion File d’attente Azure |

| Storage:ObjectStore:AzureBlob:ConnectionString | Non | Chaîne de connexion Blob Azure |

| HealthCheck:MemoryUpperboundInMB | Non | Seuil de mémoire pour signaler l’état non sain de liveness. Par défaut : identique à la mémoire recommandée |

| StorageTimeToLiveInMinutes | Non | Durée (TTL) pour supprimer tous les fichiers intermédiaires et finaux. Par défaut, la durée peut être définie à deux jours mais elle peut être ajustée entre cinq minutes et sept jours (TTL). |

| Task:MaxRunningTimeSpanInMinutes | Non | Durée maximale d’exécution avant de considérer la demande comme expirée. Valeur par défaut : 60 minutes |

| HTTP_PROXY_BYPASS_URLS | Non | Spécifier des URL pour contourner le proxy. Exemple : HTTP_PROXY_BYPASS_URLS = abc.com, xyz.com |

| AzureCognitiveServiceReadHost (conteneurs Reçu et Document d’identité uniquement) | Oui | Spécifier l’URI du conteneur Lecture. Exemple : AzureCognitiveServiceReadHost=http://onprem-frread:5000 |

| AzureCognitiveServiceLayoutHost (conteneurs de documents et de factures uniquement) | Oui | Spécifier l’URI du conteneur de mise en page. Exemple: AzureCognitiveServiceLayoutHost=http://onprem-frlayout:5000 |

Utiliser le Studio Intelligence documentaire pour effectuer l’apprentissage d’un modèle

Rassemblez au moins cinq formulaires du même type. Vous allez utiliser ces données pour entraîner le modèle et tester un formulaire. Vous pouvez utiliser un exemple de jeu de données (téléchargez et extrayez sample_data.zip).

Une fois que vous avez vérifié que les conteneurs sont en cours d’exécution, ouvrez un navigateur et accédez au point de terminaison sur lequel vous avez déployé les conteneurs. Si ce déploiement est votre ordinateur local, le point de terminaison est

[http://localhost:5001](http://localhost:5001).Sélectionnez la vignette du modèle d’extraction personnalisé.

Sélectionnez l’option

Create project.Indiquez un nom de projet et éventuellement une description.

À l’étape « Configurer votre ressource », fournissez le point de terminaison à votre modèle personnalisé. Si vous avez déployé les conteneurs sur votre ordinateur local, utilisez cette URL

[http://localhost:5000](http://localhost:5000).Fournissez un sous-dossier pour l’emplacement de vos données d’entraînement dans le dossier files.

Enfin, créez le projet.

Vous devez à présent avoir un projet créé, prêt pour l’étiquetage. Chargez vos données d’entraînement et commencez l’étiquetage. Si vous débutez avec l’étiquetage, consultez Créer et effectuer l’apprentissage d’un modèle personnalisé.

Utilisation de l’API pour effectuer l’apprentissage

Si vous envisagez d’appeler les API directement pour entraîner un modèle, l’API d’apprentissage du modèle personnalisé nécessite un fichier zip codé en base64 qui correspond au contenu de votre projet d’étiquetage. Vous pouvez omettre les fichiers PDF ou image et envoyer uniquement les fichiers JSON.

Une fois votre jeu de données étiqueté et les fichiers *.ocr.json, *.labels.json et fields.json ajoutés à un fichier zip, utilisez les commandes PowerShell pour générer la chaîne codée en base64.

$bytes = [System.IO.File]::ReadAllBytes("<your_zip_file>.zip")

$b64String = [System.Convert]::ToBase64String($bytes, [System.Base64FormattingOptions]::None)

Utilisez l’API de création de modèle pour publier la requête.

POST http://localhost:5000/formrecognizer/documentModels:build?api-version=2023-07-31

{

"modelId": "mymodel",

"description": "test model",

"buildMode": "template",

"base64Source": "<Your base64 encoded string>",

"tags": {

"additionalProp1": "string",

"additionalProp2": "string",

"additionalProp3": "string"

}

}

Vérifier que le serveur est en cours d’exécution

Il existe plusieurs façons de vérifier que le conteneur est exécuté :

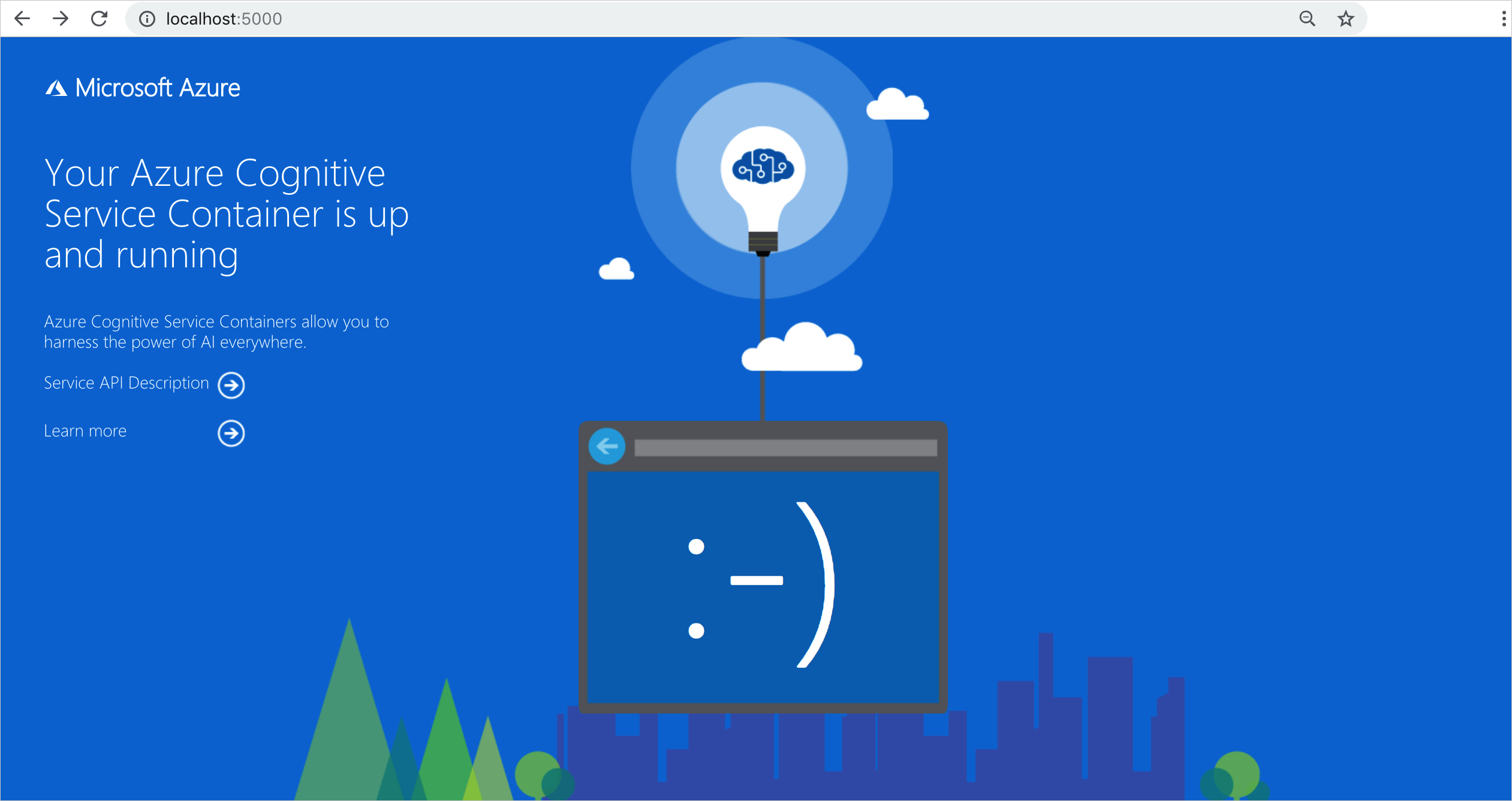

Le conteneur fournit une page d’accueil à

\comme validation visuelle que le conteneur est en cours d’exécution.Vous pouvez ouvrir votre navigateur web habituel, puis accéder à l’adresse IP externe et au port exposé du conteneur en question. Utilisez les URL des requêtes listées pour vérifier que le conteneur est en cours d’exécution. Les exemples d’URL de requête listés sont

http://localhost:5000, mais votre conteneur spécifique peut varier. N’oubliez pas que vous accédez à l’adresse IP externe et au port exposé de votre conteneur.URL de la demande Objectif http:// localhost :5000/ Le conteneur fournit une page d'accueil. http:// localhost :5000/ready Cette demande, effectuée avec GET, permet de vérifier que le conteneur est prêt à accepter une requête exécutée sur le modèle. Cette requête peut être utilisée pour les sondes de vivacité et de disponibilité de Kubernetes. http:// localhost :5000/status Cette demande, effectuée avec GET, permet de vérifier si la clé API servant à démarrer le conteneur est valide sans provoquer de requête de point de terminaison. Cette requête peut être utilisée pour les sondes de vivacité et de disponibilité de Kubernetes. http:// localhost :5000/swagger Le conteneur fournit un ensemble complet de documentation pour les points de terminaison et une fonctionnalité Essayer. Avec cette fonctionnalité, vous pouvez entrer vos paramètres dans un formulaire HTML basé sur le web, et constituer la requête sans avoir à écrire du code. Une fois la requête retournée, un exemple de commande CURL est fourni pour illustrer le format du corps et des en-têtes HTTP requis.

Arrêter les conteneurs

Pour arrêter les conteneurs, utilisez la commande suivante :

docker-compose down

Facturation

Les conteneurs Intelligence documentaire envoient des informations de facturation à Azure à l’aide d’une ressource Intelligence documentaire de votre compte Azure.

Les requêtes sur le conteneur sont facturées au niveau tarifaire de la ressource Azure utilisée pour l’API Key. La facturation est calculée pour chaque instance de conteneur utilisée afin de traiter vos documents et images.

Si vous recevez l’erreur suivante : Le conteneur n’est pas dans un état valide. Échec de la validation de l’abonnement avec l’état « OutOfQuota ». La clé API est hors quota. Cela indique que vos conteneurs ne communiquent pas avec le point de terminaison de facturation.

Connexion à Azure

Le conteneur a besoin des paramètres de facturation pour fonctionner. Ces valeurs permettent au conteneur de se connecter au point de terminaison de facturation. Le conteneur crée des rapports sur l’utilisation toutes les 10 à 15 minutes. Si le conteneur ne se connecte pas à Azure dans la fenêtre de temps imparti, il continue de s’exécuter, mais ne traite pas les requêtes tant que le point de terminaison de facturation n’est pas restauré. Une tentative de connexion est effectuée 10 fois, toutes les 10 à 15 minutes. S’il ne parvient pas à se connecter au point de terminaison de facturation au cours de ces 10 essais, le conteneur cesse de traiter les demandes. Pour obtenir un exemple des informations envoyées à Microsoft en lien avec la facturation, veuillez consulter les Questions fréquentes sur les conteneurs Azure AI.

Arguments de facturation

La commande docker-compose up démarre le conteneur quand des valeurs valides sont attribuées aux trois options suivantes :

| Choix | Descriptif |

|---|---|

ApiKey |

Clé de la ressource Azure AI Foundry utilisée pour suivre les informations de facturation. La valeur de cette option doit être définie sur une clé pour la ressource approvisionnée spécifiée dans Billing. |

Billing |

Point de terminaison de la ressource Azure AI Foundry utilisée pour suivre les informations de facturation. La valeur de cette option doit être définie sur l’URI de point de terminaison d’une ressource Azure provisionnée. |

Eula |

Indique que vous avez accepté la licence pour le conteneur. La valeur de cette option doit être définie sur accepter. |

Pour plus d’informations sur ces options, consultez Configurer des conteneurs.

Résumé

C’est tout ! Dans cet article, vous avez découvert les concepts et les flux de travail de téléchargement, d’installation et d’exécution des conteneurs Intelligence documentaire. En résumé :

- Intelligence documentaire fournit sept conteneurs Linux pour Docker.

- Les images de conteneur sont téléchargées à partir de MCR.

- Les images conteneurs s’exécutent dans Docker.

- Vous devez spécifier les informations de facturation lors de l’instanciation d’un conteneur.

Important

Les conteneurs Azure AI ne sont pas autorisés à s’exécuter sans être connectés à Azure pour le comptage. Les clients doivent permettre aux conteneurs de toujours communiquer les informations de facturation au service de contrôle. Les conteneurs Azure AI n’envoient pas de données client (par exemple, l’image ou le texte en cours d’analyse) à Microsoft.