Choix des caméras pour Azure IoT Edge vision AI

Un des composants les plus critiques d’un système de vision par ordinateur est la caméra. La caméra doit capturer et présenter les images que les modèles d’IA ou de ML peuvent évaluer et identifier correctement. Cet article permet une compréhension approfondie des différents types de caméras, de leurs fonctionnalités et des éléments à prendre en compte.

Types de caméras

Les différents types de caméras sont les caméras à balayage de zone, les caméras à balayage linéaire et les caméras intelligentes intégrées. Il existe de nombreux fabricants différents pour ces caméras. Sélectionnez un fournisseur qui répond à vos besoins spécifiques.

Caméras matricielles

Les caméras à balayage de zone génèrent une image de caméra traditionnelle. Cette caméra possède généralement une matrice de capteurs de pixels. La caméra capture une image 2D et l’envoie au matériel Azure IoT Edge pour évaluation.

Les caméras à balayage de zone observent une zone étendue et conviennent pour la détection des changements. Les exemples de charges de travail qui peuvent utiliser des caméras à balayage de zone sont la sécurité des lieux de travail, ou la détection ou le comptage d’objets dans un environnement.

Caméras d’analyse de ligne

Une caméra à balayage linéaire a une seule ligne de capteurs de pixels linéaires. La caméra prend des images d’une largeur de 1 pixel en succession rapide, les assemble dans un flux vidéo et envoie le flux à l’appareil IoT Edge pour traitement.

Les caméras à balayage linéaire sont idéales pour les charges de travail de vision dans lesquelles les éléments passent devant la caméra ou doivent être pivotés pour détecter les défauts. La caméra à balayage linéaire produit ensuite un flux d’images continu pour évaluation. Voici des exemples de charges de travail appropriées pour les caméras à balayage linéaire :

- Détection de défauts sur des pièces qui se déplacent sur un tapis roulant

- Charges de travail nécessitant une rotation pour voir un objet cylindrique

- Charges de travail nécessitant une rotation

Caméras intelligentes intégrées

Une caméra intelligente intégrée est un système autonome qui peut traiter et acquérir des images. Les caméras intelligentes intégrées peuvent utiliser des caméras à balayage de zone ou des caméras à balayage linéaire pour capturer des images, même si les caméras intelligentes à balayage linéaire sont rares. Ces caméras disposent généralement d’un port de sortie RS232 ou Ethernet, afin de pouvoir s’intégrer directement à un contrôleur logique programmable (PLC) ou à un autre contrôleur IoT industriel (IIoT).

Caractéristiques de caméra

Il existe plusieurs fonctionnalités à prendre en compte lors de la sélection d’une caméra pour une charge de travail de vision. Les sections suivantes traitent de la taille, de la résolution et de la rapidité du capteur. Les autres fonctionnalités des caméras à prendre en compte sont les suivantes :

- Sélection de l’objectif

- Longueur de la focale

- Profondeur du monochrome ou de la couleur

- Profondeur stéréo

- Déclencheurs

- Taille physique

- Support

Les fabricants de caméras peuvent vous aider à comprendre les fonctionnalités spécifiques nécessaires pour votre application.

Taille de capteur

La taille du capteur est un des facteurs les plus importants à évaluer pour une caméra. Le capteur est le composant matériel d’une caméra qui capture la cible et la convertit en signaux, qui vont ensuite produire une image. Le capteur contient des millions de photodétecteurs semi-conducteurs appelés photosites.

Un nombre plus élevé de mégapixels ne produit pas toujours une meilleure image. Par exemple, une caméra avec 12 millions de photosites et un capteur de 1 pouce produit une image plus claire et plus nette qu’une caméra avec des 12 millions de photosites et un capteur d’un 1/2 pouce. Les caméras pour les charges de travail de vision par ordinateur ont généralement des tailles de capteur comprises entre 1/4 et 1 pouce. Certains cas peuvent nécessiter des capteurs plus grands.

Choisissez des capteurs plus grands si votre charge de travail vision a :

- Un besoin de mesures de précision

- Des conditions d’éclairage faible

- Des temps d’exposition courts ou des éléments se déplaçant rapidement.

Résolution

La résolution est un autre facteur important dans le choix d’une caméra. Vous avez besoin de caméras de plus haute résolution si votre charge de travail :

- Doit identifier des caractéristiques fines, comme l’écriture sur une puce de circuit intégré

- Essaye de détecter des visages

- Doit identifier des véhicules à une certaine distance

Les images suivantes montrent le problème dû à l’utilisation d’une résolution incorrecte pour un cas d’usage donné. Les deux images ont été prises à 6 mètres de la voiture. Les petites zones rouges représentent un pixel.

L’image suivante a été prise avec 480 pixels horizontaux :

L’image suivante a été prise avec 5 184 pixels horizontaux :

Vitesse

Si votre charge de travail de vision nécessite la capture d’un grand nombre d’images par seconde, deux facteurs sont importants. Le premier facteur est la vitesse de la connexion de l’interface de la caméra. Le deuxième facteur est le type de capteur. Les capteurs sont de deux types : CCD (Charge-Coupled Device) et CMOS (Complementary Metal-Oxide-Semiconductor). Les capteurs CMOS permettent une lecture directe auprès des photosites : ils offrent donc généralement une fréquence d’images plus élevée.

Positionnement de la caméra

Les éléments que vous devez capturer dans votre charge de travail de vision déterminent les emplacements et les angles de positionnement des caméras. Le positionnement de la caméra peut aussi interagir avec le type de capteur, le type d’objectif et le type de corps de la caméra. Deux des facteurs les plus critiques pour déterminer le positionnement de la caméra sont l’éclairage et le champ de vision.

Éclairage de la caméra

Dans une charge de travail de vision par ordinateur, l’éclairage est critique pour le positionnement de la caméra. Vous pouvez appliquer plusieurs conditions d’éclairage différentes. Les conditions d’éclairage qui sont utiles pour une charge de travail de vision peuvent produire des effets indésirables dans une autre charge de travail.

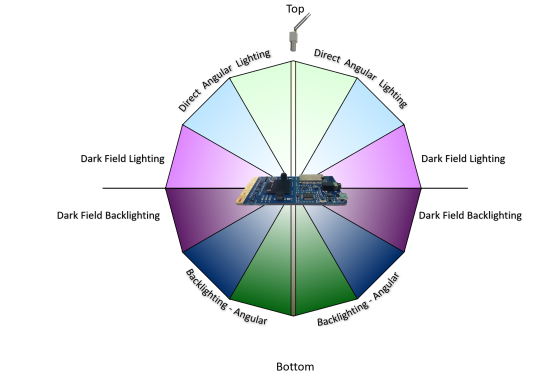

Il existe plusieurs types d’éclairage courants pour les charges de travail de vision par ordinateur :

- L’éclairage direct est la condition d’éclairage la plus courante. Cette source de lumière est projetée sur l’objet à capturer.

- L’éclairage linéaire est un groupe unique de lampes utilisé avec les caméras à balayage linéaire. L’éclairage linéaire crée une ligne de lumière unique à la distance focale de la caméra.

- L’éclairage diffus éclaire un objet, mais évite les ombres portées. L’éclairage diffus est principalement utilisé pour des objets spéculaires ou réfléchissants.

- L’éclairage diffus axial est souvent utilisé avec des objets très réfléchissants ou pour éviter des ombres sur la pièce à capturer.

- Le rétro-éclairage est utilisé derrière l’objet, produisant une silhouette de celui-ci. Le rétro-éclairage est particulièrement utile pour les mesures, la détection des contours ou l’orientation des objets.

- L’éclairage de grille personnalisé est une condition d’éclairage structuré qui projette une grille de lumière sur l’objet. La projection de grille connue fournit des mesures plus précises des composants, des pièces et de l’emplacement d’un élément.

- L’éclairage stroboscopique est utilisé pour capter les pièces qui se déplacent à haute vitesse. Le stroboscope doit être synchronisé avec la caméra pour prendre un instantané de l’objet pour évaluation. L’éclairage stroboscopique permet d’éviter les effets de flou du mouvement.

- L’éclairage en champ sombre utilise plusieurs lumières avec des angles différents pour la pièce à capturer. Par exemple, si la pièce est à plat sur un tapis roulant, les lumières sont à un angle de 45 degrés par rapport au tapis. L’éclairage en champ sombre est particulièrement utile avec les objets clairs très réfléchissants et il est couramment utilisé pour les détections des rayures sur les lentilles.

La figure suivante montre le positionnement angulaire des sources de lumière :

Champ de vision

Lors de la planification d’une charge de travail vision, vous devez connaître le champ de vision (FOV) des objets que vous évaluez. Le champ de vision détermine le choix de la caméra, le choix du capteur et la configuration de l’objectif. Les composants du champ de vision sont les suivants :

- Distance aux objets. Par exemple, l’objet est-il surveillé sur un tapis roulant avec la caméra 60 centimètres au-dessus ou sur un parc de stationnement ? Les capteurs et les configurations des objectifs des caméras diffèrent selon les distances.

- Zone de couverture. la zone que la vision par ordinateur tente de surveiller est-elle petite ou grande ? Ce facteur est directement corrélé à la résolution, l’objectif et le type de capteur de la caméra.

- Direction du soleil. Si la charge de travail de vision par ordinateur est en extérieur, vous devez tenir compte de la direction du soleil tout au long de la journée. Le changement constant de l’angle du soleil peut avoir un impact sur le modèle de vision par ordinateur. Si la caméra reçoit la lumière directe du soleil au travers de l’objectif, elle risque d’être aveuglée jusqu’à ce que l’angle du soleil change. Si le soleil fait de l’ombre sur l’objet surveillé, celui-ci peut être obscurci.

- Angle de la caméra par rapport aux objets. Si la caméra est trop haute ou trop basse, les détails que la charge de travail essaye de capturer peuvent lui échapper.

Interface de communication

Lors de la planification d’une charge de travail de vision par ordinateur, il est important de comprendre comment la sortie de la caméra interagit avec le reste du système. Les caméras communiquent avec les appareils IoT Edge selon plusieurs moyens standard :

Le protocole RTSP (Real Time Streaming Protocol) est un protocole réseau de niveau application qui contrôle les serveurs de vidéo en streaming. RTSP transfère les données vidéo temps réel de la caméra vers le point de terminaison de calcul IoT Edge via une connexion TCP/IP.

ONVIF (Open Network Video Interface Forum) est un forum industriel mondial ouvert qui développe des standards ouverts pour les caméras basées sur IP. Ces standards décrivent la communication entre les caméras IP et les systèmes en aval, l’interopérabilité et l’open source.

Les caméras connectés par USB (Universal Serial Bus) se connectent directement via le port USB à l’appareil de calcul IoT Edge. Cette connexion est moins complexe, mais limite la distance à laquelle la caméra peut se trouver par rapport à l’appareil IoT Edge.

CSI (Camera Serial Interface) comprend plusieurs standards de l’alliance MIPI (Mobile Industry Processor Interface). CSI décrit comment communiquer entre une caméra et un processeur hôte. CSI-2, publié en 2005, a plusieurs couches :

- Couche physique (C-PHY ou D-PHY)

- Couche de fusion des voies

- Couche de protocole de bas niveau

- Couche de conversion de pixel en octet

- Couche Application

CSI-2 v3.0 a ajouté la prise en charge de la profondeur de couleur RAW-24, de Unified Serial Link (Liaison série unifié) et Smart Region of Interest (Région d’intérêt intelligente).

Contributeurs

Cet article est géré par Microsoft. Il a été écrit à l’origine par les contributeurs suivants.

Auteur principal :

- Keith Hill | Chef de projet senior

Pour afficher les profils LinkedIn non publics, connectez-vous à LinkedIn.