Installer le conteneur de lecture par reconnaissance optique de caractères de Vision Azure AI 3.2 GA

Les conteneurs vous permettent d’exécuter les API Azure AI Vision dans votre propre environnement et peuvent vous aider à répondre à des exigences spécifiques en matière de sécurité et de gouvernance des données. Cet article explique comment télécharger, installer et exécuter le conteneur Azure AI Vision Read (OCR).

Le conteneur de lecture vous permet d’extraire du texte imprimé et manuscrit d’images et de documents aux formats JPEG, PNG, BMP, PDF et TIFF. Pour plus d’informations sur le service Read, consultez ce Guide pratique de l’API Read.

Nouveautés

La version en disponibilité générale 3.2-model-2022-04-30 du conteneur Read est disponible avec prise en charge de 164 langues et d’autres améliorations. Si vous êtes un client existant, suivez les instructions de téléchargement pour commencer.

Le conteneur OCR Read 3.2 est le dernier modèle en disponibilité générale et fournit :

- Nouveaux modèles pour une précision accrue.

- Prise en charge de plusieurs langues dans le même document.

- Prise en charge d’un total de 164 langues. Consultez la liste complète des langues prises en charge par la reconnaissance optique de caractères.

- Une seule opération pour les documents et les images.

- Prise en charge des documents et des images de grande taille.

- Scores de confiance.

- Prise en charge des documents contenant à la fois du texte imprimé et du texte manuscrit.

- Possibilité d'extraire le texte de la page ou des pages sélectionnées dans un document.

- Choix de l’ordre de sortie des lignes de texte, de l’ordre par défaut à un ordre de lecture plus naturel pour les langues latines uniquement.

- Classification des lignes de texte comme style manuscrit ou non pour les langues latines uniquement.

Si vous utilisez actuellement un conteneur Read 2.0, consultez le guide de migration pour en savoir plus sur les modifications apportées aux nouvelles versions.

Prérequis

Vous devez respecter les prérequis suivants avant d’utiliser les conteneurs :

| Obligatoire | Objectif |

|---|---|

| Moteur Docker | Vous avez besoin d’un moteur Docker installé sur un ordinateur hôte. Docker fournit des packages qui configurent l’environnement Docker sur macOS, Windows et Linux. Pour apprendre les principes de base de Docker et des conteneurs, consultez la vue d’ensemble de Docker. Vous devez configurer Docker pour permettre aux conteneurs de se connecter à Azure et de lui envoyer des données de facturation. Sur Windows, vous devez également configurer Docker pour prendre en charge les conteneurs Linux. |

| Bonne connaissance de Docker | Vous devez avoir une compréhension élémentaire des concepts Docker, notamment les registres, référentiels, conteneurs et images conteneurs, ainsi qu’une maîtrise des commandes docker de base. |

| Ressource Vision par ordinateur | Pour pouvoir utiliser le conteneur, vous devez disposer des éléments suivants : Une ressource Vision par ordinateur, la clé d’API associée et l’URI de point de terminaison. Les deux valeurs, disponibles dans les pages Vue d’ensemble et Clés de la ressource, sont nécessaires au démarrage du conteneur. {API_KEY} : L’une des deux clés de ressource disponibles à la page Clés {ENDPOINT_URI} : Le point de terminaison tel qu'il est fourni à la pageVue d’ensemble |

Si vous n’avez pas d’abonnement Azure, créez un compte gratuit avant de commencer.

Collecter les paramètres obligatoires

Trois paramètres principaux sont obligatoires pour tous les conteneurs Azure AI. Les termes du contrat de licence logiciel Microsoft doivent être présents avec la valeur Accepter. Un URI de point de terminaison et une clé API sont également nécessaires.

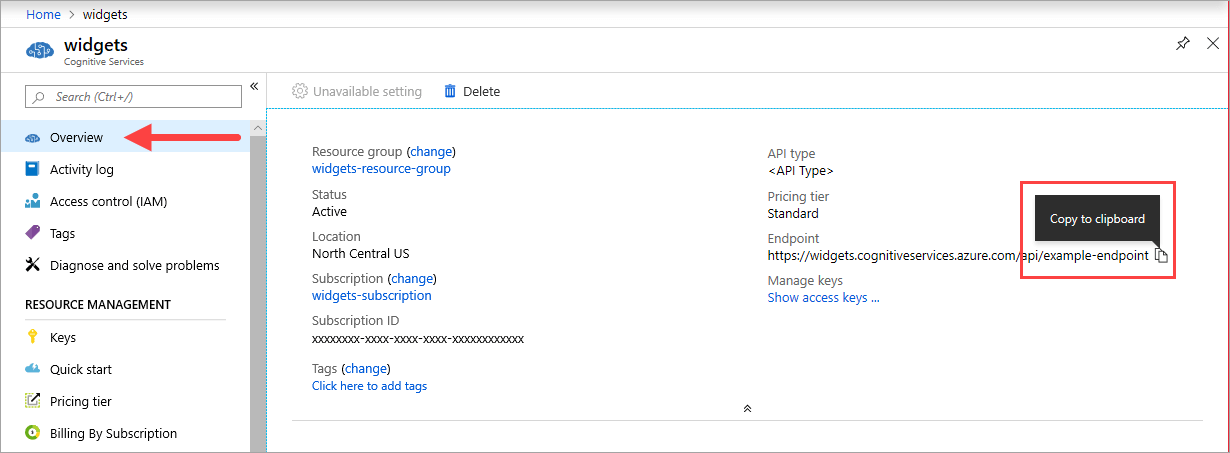

URI de point de terminaison

La valeur {ENDPOINT_URI} est disponible sur la page Vue d’ensemble du portail Azure de la ressource Azure AI Services correspondante. Accédez à la page Vue d’ensemble, puis pointez sur le point de terminaison pour afficher une icône Copier dans le Presse-papiers . Copiez et utilisez le point de terminaison si nécessaire.

Touches

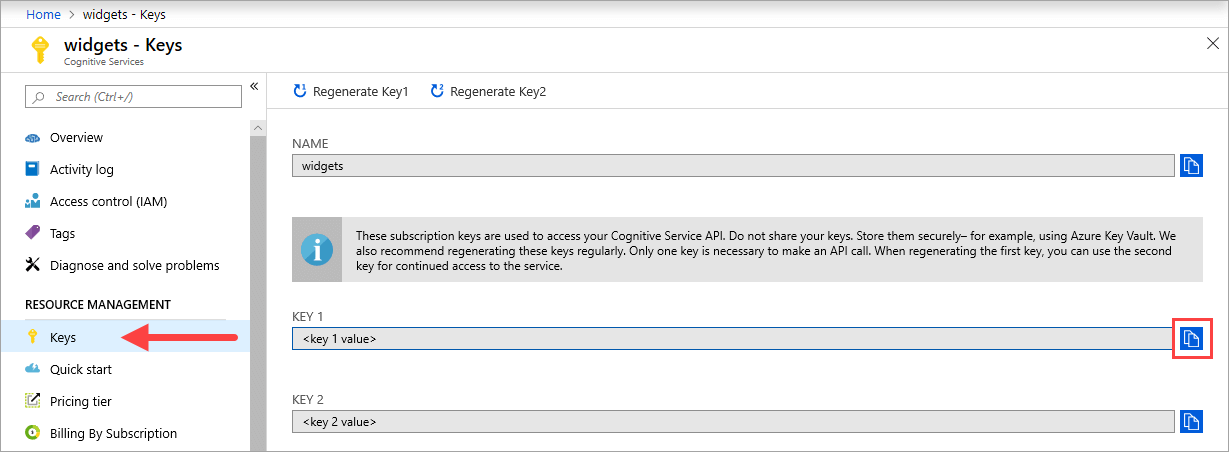

La valeur {API_KEY} est utilisée pour démarrer le conteneur et est disponible sur la page Clés de la ressource Azure AI Services correspondante sur le portail Azure. Accédez à la page Clés, puis sélectionnez l’icône Copier dans le Presse-papiers .

Important

Ces clés d’abonnement sont utilisées pour accéder à votre API Azure AI Services. Ne partagez pas vos clés. Stockez-les en toute sécurité. Par exemple, utilisez Azure Key Vault. Nous vous recommandons également de regénérer ces clés régulièrement. Une seule clé est nécessaire pour effectuer un appel d’API. Lors de la régénération de la première clé, vous pouvez utiliser la deuxième clé pour un accès continu au service.

Ordinateur hôte requis

L’hôte est un ordinateur x64 qui exécute le conteneur Docker. Il peut s’agir d’un ordinateur local ou d’un service d’hébergement Docker dans Azure, comme :

- Azure Kubernetes Service.

- Azure Container Instances.

- Un cluster Kubernetes déployé sur Azure Stack. Pour plus d’informations, consultez Déployer Kubernetes sur Azure Stack.

Prise en charge d’Advanced Vector Extension

L’ordinateur hôte est l’ordinateur qui exécute le conteneur docker. L’hôte doit prendre en charge Advanced Vector Extensions (AVX2). Vous pouvez vérifier cette prise en charge AVX2 sur les hôtes Linux avec la commande suivante :

grep -q avx2 /proc/cpuinfo && echo AVX2 supported || echo No AVX2 support detected

Avertissement

L’ordinateur hôte doit obligatoirement prendre en charge AVX2. Le conteneur ne fonctionnera pas correctement sans prise en charge AVX2.

Exigences et suggestions relatives au conteneur

Notes

Les exigences et les suggestions sont basées sur des tests d’évaluation effectués avec une seule requête par seconde, à partir d’une image de 523 Mo d’une lettre d’entreprise analysée qui contient 29 lignes et 803 caractères au total. La configuration recommandée a entraîné une réponse environ 2 fois plus rapide par rapport à la configuration minimale.

Le tableau suivant décrit l'allocation de ressources minimale et recommandée pour chaque conteneur OCR Read.

| Conteneur | Minimum | Recommandé |

|---|---|---|

| Read 3.2 2022-04-30 | 4 cœurs, 8 Go de mémoire | 8 cœurs, 16 Go de mémoire |

| Read 3.2 2021-04-12 | 4 cœurs, 16 Go de mémoire | 8 cœurs, 24 Go de mémoire |

- Chaque cœur doit être cadencé à au moins 2,6 gigahertz (GHz).

Le nombre de cœurs et la quantité de mémoire correspondent aux paramètres --cpus et --memory qui sont utilisés dans le cadre de la commande docker run.

Obtenir l’image conteneur

L’image conteneur Read OCR Vision Azure AI se trouve dans le syndicat du registre de conteneurs mcr.microsoft.com. Elle réside dans le référentiel azure-cognitive-services et se nomme read. Le nom complet de l’image conteneur est mcr.microsoft.com/azure-cognitive-services/vision/read.

Pour utiliser la dernière version du conteneur, vous pouvez utiliser l’étiquette latest. Vous trouverez aussi la liste complète des étiquettes sur MCR.

Les images conteneur suivantes sont disponibles pour la Lecture.

| Conteneur | Nom de registre de conteneurs / référentiel / image | Étiquettes |

|---|---|---|

| Read 3.2 GA | mcr.microsoft.com/azure-cognitive-services/vision/read:3.2-model-2022-04-30 |

dernière version, 3.2, 3.2-model-2022-04-30 |

Utilisez la commande docker pull pour télécharger une image conteneur.

docker pull mcr.microsoft.com/azure-cognitive-services/vision/read:3.2-model-2022-04-30

Conseil

Vous pouvez utiliser la commande docker images pour lister vos images conteneurs téléchargées. Par exemple, la commande suivante liste l’ID, le référentiel et la balise de chaque image conteneur téléchargée dans un tableau :

docker images --format "table {{.ID}}\t{{.Repository}}\t{{.Tag}}"

IMAGE ID REPOSITORY TAG

<image-id> <repository-path/name> <tag-name>

Comment utiliser le conteneur

Une fois que le conteneur est sur l’ordinateur hôte, appliquez la procédure suivante pour travailler avec le conteneur.

- Exécutez le conteneur avec les paramètres de facturation requis. D’autres exemples de commande

docker runsont disponibles. - Interrogez le point de terminaison de prédiction du conteneur.

Exécuter le conteneur

Utilisez la commande docker run pour exécuter le conteneur. Consultez Collecter les paramètres obligatoires pour plus d’informations sur la façon d’obtenir les valeurs {ENDPOINT_URI} et {API_KEY}.

Exemples de la commande docker run sont disponibles.

docker run --rm -it -p 5000:5000 --memory 16g --cpus 8 \

mcr.microsoft.com/azure-cognitive-services/vision/read:3.2-model-2022-04-30 \

Eula=accept \

Billing={ENDPOINT_URI} \

ApiKey={API_KEY}

La commande ci-dessus :

- Exécute le dernier conteneur OCR Read en disponibilité générale à partir de l’image conteneur.

- Alloue 8 cœurs de processeur et 16 gigaoctets (Go) de mémoire.

- Expose le port TCP 5000 et alloue un pseudo-TTY pour le conteneur.

- Supprime automatiquement le conteneur après sa fermeture. L’image conteneur est toujours disponible sur l’ordinateur hôte.

Vous pouvez également exécuter le conteneur à l’aide de variables d’environnement :

docker run --rm -it -p 5000:5000 --memory 16g --cpus 8 \

--env Eula=accept \

--env Billing={ENDPOINT_URI} \

--env ApiKey={API_KEY} \

mcr.microsoft.com/azure-cognitive-services/vision/read:3.2-model-2022-04-30

D’autres exemples de commande docker run sont disponibles.

Important

Vous devez spécifier les options Eula, Billing et ApiKey pour exécuter le conteneur, sinon il ne démarrera pas. Pour plus d'informations, consultez Facturation.

Si vous vous servez du stockage Azure pour stocker des images à traiter, vous pouvez créer une chaîne de connexion à utiliser au moment de l’appel du conteneur.

Pour rechercher votre chaîne de connexion :

- Sur le Portail Azure, accédez à Comptes de stockage et recherchez votre compte.

- Dans la liste de navigation de gauche, sélectionnez Clés d’accès.

- Votre chaîne de connexion se trouve sous Chaîne de connexion.

Exécuter plusieurs conteneurs sur le même hôte

Si vous envisagez d’exécuter plusieurs conteneurs avec les ports exposés, veillez à exécuter chaque conteneur avec un port exposé différent. Par exemple, exécutez le premier conteneur sur le port 5000 et le second conteneur sur le port 5001.

Vous pouvez avoir ce conteneur, et un autre conteneur Azure AI services qui s’exécutent ensemble sur l’hôte. Vous pouvez également disposer de plusieurs conteneurs du même conteneur Azure AI services en cours d’exécution.

Valider l’exécution d’un conteneur

Il existe plusieurs façons de confirmer que le conteneur s’exécute. Recherchez l’adresse IP externe et le port exposé du conteneur en question, puis ouvrez le navigateur web de votre choix. Utilisez les différentes URL de requête suivantes pour vérifier que le conteneur est en cours d’exécution. Les exemples d’URL de requête listés ici sont http://localhost:5000, mais votre conteneur spécifique peut varier. Veillez à vous fier à l’adresse IP externe de votre conteneur et au port exposé.

| URL de la demande | Objectif |

|---|---|

http://localhost:5000/ |

Le conteneur fournit une page d’accueil. |

http://localhost:5000/ready |

Demandée avec la fonction d’extraction, cette URL permet de vérifier que le conteneur est prêt à accepter une requête sur le modèle. Cette requête peut être utilisée pour les probes liveness et readiness de Kubernetes. |

http://localhost:5000/status |

Également demandée avec la fonction d’extraction, cette URL permet de vérifier si la clé API servant à démarrer le conteneur est valide sans provoquer de requête de point de terminaison. Cette requête peut être utilisée pour les probes liveness et readiness de Kubernetes. |

http://localhost:5000/swagger |

Le conteneur fournit un ensemble complet de documentation pour les points de terminaison et une fonctionnalité Essayer. Avec cette fonctionnalité, vous pouvez entrer vos paramètres dans un formulaire HTML basé sur le web, et constituer la requête sans avoir à écrire du code. Une fois la requête retournée, un exemple de commande CURL est fourni pour illustrer les en-têtes HTTP, et le format du corps qui est nécessaire. |

Interroger le point de terminaison de prédiction du conteneur

Le conteneur fournit des API de point de terminaison de prédiction de requête basées sur REST.

Utilisez l’hôte, http://localhost:5000, pour les API de conteneur. Le chemin d'accès à Swagger est visible à l'adresse : http://localhost:5000/swagger/.

Lecture asynchrone

Vous pouvez utiliser conjointement les opérations POST /vision/v3.2/read/analyze et GET /vision/v3.2/read/operations/{operationId} pour lire de façon asynchrone une image, ce qui est similaire à la façon dont le service Vision Azure AI utilise ces opérations REST correspondantes. La méthode POST asynchrone retourne un operationId qui est utilisé comme identificateur de la requête HTTP GET.

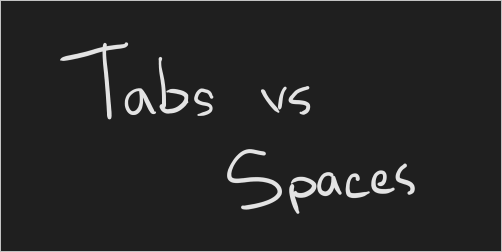

À partir de l’interface utilisateur Swagger, sélectionnez le Analyze pour le développer dans le navigateur. Ensuite, sélectionnez Faites un essai>Choisir un fichier. Dans cet exemple, nous allons utiliser l’image suivante :

Lorsque le POST asynchrone s’est correctement exécuté, il retourne le code d’état HTTP 202. Dans la réponse, un en-tête operation-location contient le point de terminaison de résultat de la requête.

content-length: 0

date: Fri, 04 Sep 2020 16:23:01 GMT

operation-location: http://localhost:5000/vision/v3.2/read/operations/a527d445-8a74-4482-8cb3-c98a65ec7ef9

server: Kestrel

operation-location est l’URL complète qui est accessible via HTTP GET. Voici la réponse JSON à l’exécution de l’URL operation-location à partir de l’image précédente :

{

"status": "succeeded",

"createdDateTime": "2021-02-04T06:32:08.2752706+00:00",

"lastUpdatedDateTime": "2021-02-04T06:32:08.7706172+00:00",

"analyzeResult": {

"version": "3.2.0",

"readResults": [

{

"page": 1,

"angle": 2.1243,

"width": 502,

"height": 252,

"unit": "pixel",

"lines": [

{

"boundingBox": [

58,

42,

314,

59,

311,

123,

56,

121

],

"text": "Tabs vs",

"appearance": {

"style": {

"name": "handwriting",

"confidence": 0.96

}

},

"words": [

{

"boundingBox": [

68,

44,

225,

59,

224,

122,

66,

123

],

"text": "Tabs",

"confidence": 0.933

},

{

"boundingBox": [

241,

61,

314,

72,

314,

123,

239,

122

],

"text": "vs",

"confidence": 0.977

}

]

},

{

"boundingBox": [

286,

171,

415,

165,

417,

197,

287,

201

],

"text": "paces",

"appearance": {

"style": {

"name": "handwriting",

"confidence": 0.746

}

},

"words": [

{

"boundingBox": [

286,

179,

404,

166,

405,

198,

290,

201

],

"text": "paces",

"confidence": 0.938

}

]

}

]

}

]

}

}

Important

Si vous déployez plusieurs conteneurs Read OCR derrière un équilibreur de charge, par exemple sous Docker Compose ou Kubernetes, vous devez avoir un cache externe. Étant donné que le conteneur de traitement et le conteneur de requêtes GET peuvent être différents, un cache externe est utilisé pour stocker les résultats et les partager entre les conteneurs. Pour plus d’informations sur les paramètres de cache, consultez l’article Configurer les conteneurs Docker Vision Azure AI.

Lecture synchrone

Vous pouvez utiliser l’opération suivante pour lire une image en mode synchrone.

POST /vision/v3.2/read/syncAnalyze

C’est uniquement lorsque l’image est lue dans son intégralité que l’API retourne une réponse JSON. La seule exception à ce comportement est dans le cas où une erreur se produit. Si une erreur se produit, le code JSON suivant est retourné :

{

"status": "Failed"

}

L’objet de réponse JSON contient le même graphe d’objets que la version asynchrone. Si vous êtes un utilisateur JavaScript et visez la cohérence des types, vous pouvez envisager d’utiliser TypeScript pour caster la réponse JSON.

Pour obtenir un exemple de cas d’utilisation, consultez ce bac à sable TypeScript, puis sélectionnez Exécuter pour vous rendre compte de sa facilité d’utilisation.

Exécuter le conteneur déconnecté d’Internet

Pour utiliser ce conteneur déconnecté d’Internet, vous devez d’abord demander un accès en remplissant une application et en achetant un plan d’engagement. Pour plus d’informations, consultez Utiliser des conteneurs Docker dans des environnements déconnectés.

Si vous avez été autorisé à exécuter le conteneur déconnecté d’Internet, utilisez l’exemple suivant qui montre la mise en forme de la commande docker run que vous allez utiliser, avec des valeurs d’espace réservé. Remplacez ces valeurs d’espace réservé par vos propres valeurs.

Le paramètre DownloadLicense=True de votre commande docker run télécharge un fichier de licence qui permet à votre conteneur Docker de s’exécuter quand il n’est pas connecté à Internet. Il contient également une date d’expiration après laquelle le conteneur ne pourra plus être exécuté avec ce fichier de licence. Vous ne pouvez utiliser un fichier de licence qu’avec le conteneur pour lequel vous avez été approuvé. Par exemple, vous ne pouvez pas utiliser le fichier de licence d’un conteneur de reconnaissance vocale avec un conteneur Document Intelligence.

| Paramètre substituable | Valeur | Format ou exemple |

|---|---|---|

{IMAGE} |

L’image conteneur que vous souhaitez utiliser. | mcr.microsoft.com/azure-cognitive-services/form-recognizer/invoice |

{LICENSE_MOUNT} |

Chemin où la licence sera téléchargée et montée. | /host/license:/path/to/license/directory |

{ENDPOINT_URI} |

Point de terminaison permettant d’authentifier votre demande de service. Cette information est disponible dans le portail Azure, sur la page Key and endpoint (Clé et point de terminaison) de votre ressource. | https://<your-custom-subdomain>.cognitiveservices.azure.com |

{API_KEY} |

Clé de votre ressource Analyse de texte. Cette information est disponible dans le portail Azure, sur la page Key and endpoint (Clé et point de terminaison) de votre ressource. | xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxx |

{CONTAINER_LICENSE_DIRECTORY} |

Emplacement du dossier de licence sur le système de fichiers local du conteneur. | /path/to/license/directory |

docker run --rm -it -p 5000:5000 \

-v {LICENSE_MOUNT} \

{IMAGE} \

eula=accept \

billing={ENDPOINT_URI} \

apikey={API_KEY} \

DownloadLicense=True \

Mounts:License={CONTAINER_LICENSE_DIRECTORY}

Une fois le fichier de licence téléchargé, vous pourrez exécuter le conteneur dans un environnement déconnecté. L’exemple suivant illustre la mise en forme de la commande docker run que vous allez utiliser, avec des valeurs d’espace réservé. Remplacez ces valeurs d’espace réservé par vos propres valeurs.

Quel que soit l’emplacement d’exécution du conteneur, le fichier de licence doit être monté sur le conteneur et l’emplacement du dossier de licence sur le système de fichiers local du conteneur doit être spécifié avec Mounts:License=. Un montage de sortie doit également être spécifié afin que les enregistrements d’utilisation puissent être écrits pour la facturation.

| Espace réservé | Valeur | Format ou exemple |

|---|---|---|

{IMAGE} |

L’image conteneur que vous souhaitez utiliser. | mcr.microsoft.com/azure-cognitive-services/form-recognizer/invoice |

{MEMORY_SIZE} |

Quantité appropriée de mémoire à allouer à votre conteneur. | 4g |

{NUMBER_CPUS} |

Quantité appropriée de processeurs à allouer à votre conteneur. | 4 |

{LICENSE_MOUNT} |

Chemin où la licence sera localisée et montée. | /host/license:/path/to/license/directory |

{OUTPUT_PATH} |

Chemin de sortie pour la journalisation des enregistrements d’utilisation. | /host/output:/path/to/output/directory |

{CONTAINER_LICENSE_DIRECTORY} |

Emplacement du dossier de licence sur le système de fichiers local du conteneur. | /path/to/license/directory |

{CONTAINER_OUTPUT_DIRECTORY} |

Emplacement du dossier de sortie sur le système de fichiers local du conteneur. | /path/to/output/directory |

docker run --rm -it -p 5000:5000 --memory {MEMORY_SIZE} --cpus {NUMBER_CPUS} \

-v {LICENSE_MOUNT} \

-v {OUTPUT_PATH} \

{IMAGE} \

eula=accept \

Mounts:License={CONTAINER_LICENSE_DIRECTORY}

Mounts:Output={CONTAINER_OUTPUT_DIRECTORY}

Arrêter le conteneur

Pour arrêter le conteneur, dans l’environnement de ligne de commande où le conteneur est en cours d’exécution, sélectionnez Ctrl+C.

Dépannage

Si vous exécutez le conteneur avec un montage de sortie et la journalisation activée, il génère des fichiers journaux qui sont utiles pour résoudre les problèmes qui se produisent lors du démarrage ou de l’exécution du conteneur.

Conseil

Pour plus d’informations et de conseils sur la résolution des problèmes, consultez les questions fréquentes (FAQ) sur les conteneurs Azure AI.

Si vous avez des difficultés à exécuter un conteneur Azure AI services, vous pouvez essayer d’utiliser le conteneur de diagnostics Microsoft. Utilisez ce conteneur pour diagnostiquer dans votre environnement de déploiement les erreurs courantes pouvant nuire au bon fonctionnement des conteneurs Azure AI.

Pour obtenir le conteneur, utilisez la commande docker pull suivante :

docker pull mcr.microsoft.com/azure-cognitive-services/diagnostic

Exécutez ensuite le conteneur. Remplacez {ENDPOINT_URI} par votre point de terminaison et {API_KEY} par la clé de votre ressource :

docker run --rm mcr.microsoft.com/azure-cognitive-services/diagnostic \

eula=accept \

Billing={ENDPOINT_URI} \

ApiKey={API_KEY}

Le conteneur teste la connectivité réseau avec le point de terminaison de facturation.

Billing

Les conteneurs Azure AI envoient des informations de facturation à Azure à l’aide de la ressource correspondante dans votre compte Azure.

Les requêtes sur le conteneur sont facturées au niveau tarifaire de la ressource Azure utilisée pour le paramètre ApiKey.

La licence des conteneurs Azure AI Services ne vous permet pas de les exécuter sans les connecter au point de terminaison du compteur ou de la facturation. Vous devez configurer les conteneurs de manière à ce qu’ils communiquent les informations de facturation au point de terminaison de facturation à tout moment. Les conteneurs Azure AI Services n’envoient pas de données client, telles que l’image ou le texte analysé, à Microsoft.

Connexion à Azure

Le conteneur a besoin des valeurs d’arguments de facturation pour s’exécuter. Ces valeurs permettent au conteneur de se connecter au point de terminaison de facturation. Le conteneur crée des rapports sur l’utilisation toutes les 10 à 15 minutes. Si le conteneur ne se connecte pas à Azure dans la fenêtre de temps imparti, il continue de s’exécuter, mais ne traite pas les requêtes tant que le point de terminaison de facturation n’est pas restauré. Une tentative de connexion est effectuée 10 fois, toutes les 10 à 15 minutes. S’il ne parvient pas à se connecter au point de terminaison de facturation au cours de ces 10 essais, le conteneur cesse de traiter les demandes. Pour obtenir un exemple des informations envoyées à Microsoft en lien avec la facturation, consultez le Forum aux questions sur le conteneur Azure AI Services.

Arguments de facturation

La commande docker run démarre le conteneur quand les trois options suivantes ont des valeurs valides :

| Option | Description |

|---|---|

ApiKey |

Clé API de la ressource Azure AI Services utilisée pour le suivi des informations de facturation. La valeur de cette option doit être définie sur une clé API pour la ressource provisionnée spécifiée dans Billing. |

Billing |

Le point de terminaison de la ressource Azure AI Services utilisée pour le suivi des informations de facturation. La valeur de cette option doit être définie sur l’URI de point de terminaison d’une ressource Azure provisionnée. |

Eula |

Indique que vous avez accepté la licence pour le conteneur. La valeur de cette option doit être définie sur accepter. |

Pour plus d’informations sur ces options, consultez Configurer des conteneurs.

Résumé

Dans cet article, vous avez découvert des concepts et le flux de travail pour le téléchargement, l’installation et l’exécution des conteneurs Vision Azure AI. En résumé :

- Vision Azure AI fournit un conteneur Linux pour Docker, et encapsule le conteneur Lire.

- L'image du conteneur Read requiert une application pour l'exécuter.

- Les images conteneurs s’exécutent dans Docker.

- Vous pouvez utiliser l’API REST ou kit de développement logiciel (SDK) pour appeler des opérations dans des conteneurs OCR Read en spécifiant l’URI hôte du conteneur.

- Vous devez spécifier les informations de facturation lors de l’instanciation d’un conteneur.

Important

La licence ne prévoit pas que les conteneurs Azure AI services soient exécutés sans être connectés à Azure à des fins de contrôle. Les clients doivent configurer les conteneurs de manière à ce qu’ils communiquent les informations de facturation au service de contrôle à tout moment. Les conteneurs Azure AI n’envoient pas de données relatives aux clients (par exemple, l’image ou le texte analysés) à Microsoft.

Étapes suivantes

- Pour obtenir les paramètres de configuration, passez en revue Configurer des conteneurs.

- Pour en savoir plus sur la reconnaissance du texte imprimé et manuscrit, passez en revue Vue d’ensemble de la reconnaissance optique de caractères.

- Pour plus d'informations sur les méthodes prises en charge par le conteneur, reportez-vous à l'API Read.

- Pour résoudre les problèmes liés à la fonctionnalité Vision Azure AI, reportez-vous au Forum aux questions (FAQ).

- Utiliser plus de conteneurs Azure AI