Notes de publication Azure DevOps Server 2020

| Developer Community Exigences du système Termes | du contrat de licence | DevOps Blog | SHA-1 Hachages

Dans cet article, vous trouverez des informations sur la dernière version pour Azure DevOps Server.

Pour en savoir plus sur l’installation ou la mise à niveau d’un déploiement de Azure DevOps Server, consultez Azure DevOps Server Configuration requise. Pour télécharger des produits Azure DevOps, accédez à la page Téléchargements Azure DevOps Server.

La mise à niveau directe vers Azure DevOps Server 2020 est prise en charge à partir de Azure DevOps Server 2019 ou de Team Foundation Server 2015 ou version ultérieure. Si votre déploiement TFS est sur TFS 2010 ou une version antérieure, vous devez effectuer certaines étapes intermédiaires avant de procéder à la mise à niveau vers Azure DevOps Server 2019. Pour plus d’informations, consultez Installer et configurer Azure DevOps en local.

Mise à niveau sécurisée de Azure DevOps Server 2019 vers Azure DevOps Server 2020

Azure DevOps Server 2020 introduit un nouveau modèle de rétention d’exécution de pipeline (build) qui fonctionne en fonction des paramètres au niveau du projet.

Azure DevOps Server 2020 gère différemment la rétention des build, en fonction des stratégies de rétention au niveau du pipeline. Certaines configurations de stratégie entraînent la suppression des exécutions de pipeline après la mise à niveau. Les exécutions de pipeline qui ont été conservées manuellement ou qui sont conservées par une version ne seront pas supprimées après la mise à niveau.

Lisez notre billet de blog pour plus d’informations sur la mise à niveau sécurisée de Azure DevOps Server 2019 à Azure DevOps Server 2020.

Azure DevOps Server 2020 Update 0.2 Patch 6 Date de publication : 14 novembre 2023

Nous avons publié un correctif pour Azure DevOps Server 2020 Update 0.2 qui inclut les correctifs suivants.

- Extension de la liste de caractères autorisée des tâches PowerShell pour la validation des paramètres Activer les arguments des tâches de l’interpréteur de commandes.

Notes

Pour implémenter des correctifs pour ce correctif, vous devez suivre un certain nombre d’étapes pour mettre à jour manuellement les tâches.

Installer les correctifs

Important

Nous avons publié des mises à jour de l’agent Azure Pipelines avec le correctif 4 publié le 12 septembre 2023. Si vous n’avez pas installé les mises à jour de l’agent comme décrit dans les notes de publication du correctif 4, nous vous recommandons d’installer ces mises à jour avant d’installer le correctif 6. La nouvelle version de l’agent après l’installation du correctif 4 sera 3.225.0.

Configurer TFX

- Suivez les étapes décrites dans la documentation de chargement des tâches dans la collection de projets pour installer et vous connecter avec tfx-cli.

Mettre à jour des tâches à l’aide de TFX

| Fichier | Hachage SHA-256 |

|---|---|

| Tasks20231103.zip | 389BA66EEBC32622FB83402E21373CE20AE040F70461B9F9AF9EFCED5034D2E5 |

- Téléchargez et extrayezTasks20231103.zip.

- Remplacez le répertoire par les fichiers extraits.

- Exécutez les commandes suivantes pour charger les tâches :

tfx build tasks upload --task-zip-path AzureFileCopyV1.1.230.0.zip

tfx build tasks upload --task-zip-path AzureFileCopyV2.2.230.0.zip

tfx build tasks upload --task-zip-path AzureFileCopyV3.3.230.0.zip

tfx build tasks upload --task-zip-path AzureFileCopyV4.4.230.0.zip

tfx build tasks upload --task-zip-path AzureFileCopyV5.5.230.0.zip

tfx build tasks upload --task-zip-path BashV3.3.226.2.zip

tfx build tasks upload --task-zip-path BatchScriptV1.1.226.0.zip

tfx build tasks upload --task-zip-path PowerShellV2.2.230.0.zip

tfx build tasks upload --task-zip-path SSHV0.0.226.1.zip

tfx build tasks upload --task-zip-path WindowsMachineFileCopyV1.1.230.0.zip

tfx build tasks upload --task-zip-path WindowsMachineFileCopyV2.2.230.0.zip

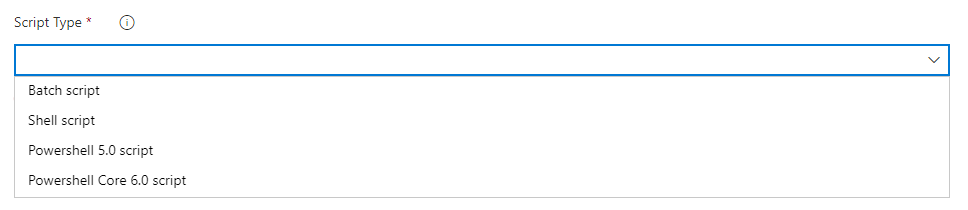

Configuration requise du pipeline

Pour utiliser le nouveau comportement, une variable AZP_75787_ENABLE_NEW_LOGIC = true doit être définie dans les pipelines qui utilisent les tâches affectées.

Sur classique :

Définissez la variable dans l’onglet variable du pipeline.

Exemple YAML :

variables:

- name: AZP_75787_ENABLE_NEW_LOGIC

value: true

Azure DevOps Server 2020 Update 0.2 Patch 5 Date de publication : 10 octobre 2023

Important

Nous avons publié des mises à jour de l’agent Azure Pipelines avec le correctif 4 publié le 12 septembre 2023. Si vous n’avez pas installé les mises à jour de l’agent comme décrit dans les notes de publication du correctif 4, nous vous recommandons d’installer ces mises à jour avant d’installer le correctif 5. La nouvelle version de l’agent après l’installation du correctif 4 sera 3.225.0.

Nous avons publié un correctif pour Azure DevOps Server 2020 Update 0.2 qui inclut les correctifs suivants.

- Correction d’un bogue où l’identité « Propriétaire de l’analyse » s’affiche en tant qu’identité inactive sur les machines de mise à niveau corrective.

Azure DevOps Server 2020 Update 0.2 Patch 4 Date de publication : 12 septembre 2023

Nous avons publié un correctif pour Azure DevOps Server 2020 Update 0.2 qui inclut les correctifs suivants.

- CVE-2023-33136 : Azure DevOps Server vulnérabilité d’exécution de code à distance.

- CVE-2023-38155 : vulnérabilité d’élévation de privilèges Azure DevOps Server et Team Foundation Server.

Important

Déployez le correctif dans un environnement de test et assurez-vous que les pipelines de l’environnement fonctionnent comme prévu avant d’appliquer le correctif en production.

Notes

Pour implémenter des correctifs pour ce correctif, vous devez suivre un certain nombre d’étapes pour mettre à jour manuellement l’agent et les tâches.

Installer les correctifs

- Téléchargez et installez Azure DevOps Server 2020 Update 0.2 patch 4.

Mettre à jour l’agent Azure Pipelines

- Téléchargez l’agent à partir de : https://github.com/microsoft/azure-pipelines-agent/releases/tag/v3.225.0 - Agent_20230825.zip

- Utilisez les étapes décrites dans la documentation des agents Windows auto-hébergés pour déployer l’agent.

Notes

Le AZP_AGENT_DOWNGRADE_DISABLED doit être défini sur « true » pour empêcher le rétrogradé de l’agent. Sur Windows, la commande suivante peut être utilisée dans une invite de commandes d’administration, suivie d’un redémarrage. setx AZP_AGENT_DOWNGRADE_DISABLED true /M

Configurer TFX

- Suivez les étapes décrites dans la documentation de chargement des tâches dans la collection de projets pour installer et vous connecter avec tfx-cli.

Mettre à jour des tâches à l’aide de TFX

- Téléchargez et extrayezTasks_20230825.zip.

- Remplacez le répertoire par les fichiers extraits.

- Exécutez les commandes suivantes pour charger les tâches :

tfx build tasks upload --task-zip-path AzureFileCopyV1.1.226.3.zip

tfx build tasks upload --task-zip-path AzureFileCopyV2.2.226.2.zip

tfx build tasks upload --task-zip-path AzureFileCopyV3.3.226.2.zip

tfx build tasks upload --task-zip-path AzureFileCopyV4.4.226.2.zip

tfx build tasks upload --task-zip-path AzureFileCopyV5.5.226.2.zip

tfx build tasks upload --task-zip-path BashV3.3.226.2.zip

tfx build tasks upload --task-zip-path BatchScriptV1.1.226.0.zip

tfx build tasks upload --task-zip-path PowerShellV2.2.226.1.zip

tfx build tasks upload --task-zip-path SSHV0.0.226.1.zip

tfx build tasks upload --task-zip-path WindowsMachineFileCopyV1.1.226.2.zip

tfx build tasks upload --task-zip-path WindowsMachineFileCopyV2.2.226.2.zip

Configuration requise du pipeline

Pour utiliser le nouveau comportement, une variable AZP_75787_ENABLE_NEW_LOGIC = true doit être définie dans les pipelines qui utilisent les tâches affectées.

Sur classique :

Définissez la variable dans l’onglet variable du pipeline.

Exemple YAML :

variables:

- name: AZP_75787_ENABLE_NEW_LOGIC

value: true

Azure DevOps Server 2020 Update 0.2 Patch 3 Date de publication : 8 août 2023

Nous avons publié un correctif pour Azure DevOps Server 2020 Update 0.2 qui inclut les correctifs suivants.

- Correction d’un bogue qui interfère avec l’envoi de packages lors de la mise à niveau à partir de 2018 ou d’une version antérieure.

Azure DevOps Server 2020 Update 0.2 Patch 2 Date de publication : 13 juin 2023

Nous avons publié un correctif pour Azure DevOps Server 2020 Update 0.2 qui inclut les correctifs suivants.

- Correction d’un bogue qui interfère avec l’envoi de packages lors de la mise à niveau à partir de 2018 ou d’une version antérieure.

Azure DevOps Server 2020 Update 0.2 Patch 1 Date de publication : 18 octobre 2022

Nous avons publié un correctif pour Azure DevOps Server 2020 Update 0.2 qui inclut les correctifs suivants.

- Résolvez le problème lié aux identités AD nouvellement ajoutées qui n’apparaissent pas dans les sélecteurs d’identité de boîte de dialogue de sécurité.

- Correction d’un problème avec le filtre Demandé par membre du groupe dans les paramètres du web hook.

- Corrigez l’erreur de génération de case activée-in gated lorsque les paramètres d’organisation du pipeline avaient une étendue d’autorisation de travail configurée comme Limiter l’étendue de l’autorisation de travail au projet actuel pour les pipelines sans mise en production.

Azure DevOps Server 2020.0.2 Date de publication : 17 mai 2022

Azure DevOps Server 2020.0.2 est un cumul de correctifs de bogues. Vous pouvez installer directement Azure DevOps Server 2020.0.2 ou effectuer une mise à niveau à partir de Azure DevOps Server 2020 ou de Team Foundation Server 2013 ou version ultérieure.

Notes

L’outil de migration de données sera disponible pour Azure DevOps Server 2020.0.2 environ trois semaines après cette version. Pour consulter la liste des versions actuellement prises en charge pour l’importation, cliquez ici.

Cette version inclut des correctifs pour les éléments suivants :

Impossible d’ignorer la file d’attente de build à l’aide du bouton « Exécuter ensuite ». Auparavant, le bouton « Exécuter ensuite » était activé uniquement pour les administrateurs de collection de projets.

Révoquez tous les jetons d’accès personnels après la désactivation du compte Active Directory d’un utilisateur.

Azure DevOps Server 2020.0.1 Patch 9 Date de publication : 26 janvier 2022

Nous avons publié un correctif pour Azure DevOps Server 2020.0.1 qui inclut les correctifs suivants.

- Email notifications n’ont pas été envoyées lors de l’utilisation du @mention contrôle dans un élément de travail.

- Correction TF400813 erreur lors du changement de compte. Cette erreur s’est produite lors de la mise à niveau de TFS 2018 vers Azure DevOps Server 2020.0.1.

- Résolution d’un problème lié au chargement de la page résumé De la vue d’ensemble du projet.

- Amélioration de la synchronisation des utilisateurs Active Directory.

- Résolution de la vulnérabilité Elasticsearch en supprimant la classe jndilookup des fichiers binaires log4j.

Procédure d’installation :

- Mettez à niveau le serveur avec le correctif 9.

- Vérifiez la valeur du Registre à l’adresse

HKLM:\Software\Elasticsearch\Version. Si la valeur de Registre n’existe pas, ajoutez une valeur de chaîne et définissez version sur 5.4.1 (Nom = Version, Valeur = 5.4.1). - Exécutez la commande

PS C:\Program Files\{TFS Version Folder}\Search\zip> .\Configure-TFSSearch.ps1 -Operation updateupdate comme indiqué dans le fichier lisez-moi. Il peut renvoyer un avertissement du type : Impossible de se connecter au serveur distant. Ne fermez pas la fenêtre, car la mise à jour effectue de nouvelles tentatives jusqu’à ce qu’elle soit terminée.

Notes

Si Azure DevOps Server et Elasticsearch sont installés sur des ordinateurs différents, suivez les étapes décrites ci-dessous.

- Mettez à niveau le serveur avec patch 9..

- Vérifiez la valeur du Registre à l’adresse

HKLM:\Software\Elasticsearch\Version. Si la valeur de Registre n’existe pas, ajoutez une valeur de chaîne et définissez version sur 5.4.1 (Nom = Version, Valeur = 5.4.1). - Copiez le contenu du dossier nommé zip, situé dans

C:\Program Files\{TFS Version Folder}\Search\ziple dossier de fichiers distants Elasticsearch. - Exécutez

Configure-TFSSearch.ps1 -Operation updatesur l’ordinateur serveur Elasticsearch.

Hachage SHA-256 : B0C05A972C73F253154AEEB7605605EF2E596A96A3720AE942D7A9DDD881545E

Azure DevOps Server 2020.0.1 Patch 8 Date de publication : 15 décembre 2021

Le correctif 8 pour Azure DevOps Server 2020.0.1 inclut des correctifs pour les éléments suivants.

- Problème de localisation pour les états de disposition des éléments de travail personnalisés.

- Problème de localisation dans le modèle de notification par e-mail.

- Problème lié à la troncation des journaux de console lorsqu’il existe plusieurs liens identiques dans une ligne.

- Problème avec l’évaluation des règles NOTSAMEAS lorsque plusieurs règles NOTSAMEAS ont été définies pour un champ.

Azure DevOps Server 2020.0.1 Patch 7 Date de publication : 26 octobre 2021

Le correctif 7 pour Azure DevOps Server 2020.0.1 inclut des correctifs pour les éléments suivants.

- Auparavant, Azure DevOps Server pouviez uniquement créer des connexions à GitHub Enterprise Server. Avec ce correctif, les administrateurs de projet peuvent créer des connexions entre Azure DevOps Server et les dépôts sur GitHub.com. Vous trouverez ce paramètre dans la page connexions GitHub sous Paramètres du projet.

- Résoudre le problème avec le widget Plan de test. Le rapport d’exécution des tests affichait un utilisateur incorrect sur les résultats.

- Résolution d’un problème lié au chargement de la page résumé De la vue d’ensemble du projet.

- Correction du problème lié à l’envoi d’e-mails pour confirmer la mise à niveau du produit.

Azure DevOps Server 2020.0.1 Patch 6 Date de publication : 14 septembre 2021

Le correctif 6 pour Azure DevOps Server 2020.0.1 inclut des correctifs pour les éléments suivants.

- Correction de l’échec de téléchargement/chargement des artefacts.

- Résolvez le problème lié aux données de résultats de test incohérentes.

Azure DevOps Server 2020.0.1 Patch 5 Date de publication : 10 août 2021

Le correctif 5 pour Azure DevOps Server 2020.0.1 inclut des correctifs pour les éléments suivants.

- Correction de l’erreur d’interface utilisateur de définition de build.

- Modification de l’historique de navigation pour afficher les fichiers au lieu du dépôt racine.

- Correction du problème lié aux tâches de remise d’e-mails pour certains types d’éléments de travail.

Azure DevOps Server 2020.0.1 Patch 4 Date de publication : 15 juin 2021

Le correctif 4 pour Azure DevOps Server 2020.0.1 inclut des correctifs pour les éléments suivants.

- Correction du problème lié à l’importation de données. L’importation de données prenait beaucoup de temps pour les clients qui ont beaucoup de cas de test obsolètes. Cela était dû aux références qui ont augmenté la taille de la

tbl_testCaseReferencestable. Avec ce correctif, nous avons supprimé les références aux cas de test obsolètes pour accélérer le processus d’importation des données.

Azure DevOps Server 2020.0.1 Patch 3 Date de publication : 11 mai 2021

Nous avons publié un correctif pour Azure DevOps Server 2020.0.1 qui corrige les problèmes suivants.

- Données de résultats de test incohérentes lors de l’utilisation de Microsoft.TeamFoundation.TestManagement.Client.

Si vous avez Azure DevOps Server 2020.0.1, vous devez installer Azure DevOps Server 2020.0.1 Patch 3.

Vérification de l’installation

Option 1 : exécutez

devops2020.0.1patch3.exe CheckInstall, devops2020.0.1patch3.exe est le fichier téléchargé à partir du lien ci-dessus. La sortie de la commande indique soit que le correctif a été installé, soit qu’il n’est pas installé.Option 2 : Vérifiez la version du fichier suivant :

[INSTALL_DIR]\Azure DevOps Server 2020\Application Tier\bin\Microsoft.Teamfoundation.Framework.Server.dll. Azure DevOps Server 2020.0.1 est installéc:\Program Files\Azure DevOps Server 2020sur par défaut. Après avoir installé Azure DevOps Server 2020.0.1 Patch 3, la version sera 18.170.31228.1.

Azure DevOps Server 2020.0.1 Patch 2 Date de publication : 13 avril 2021

Notes

Si vous avez Azure DevOps Server 2020, vous devez d’abord mettre à jour vers Azure DevOps Server 2020.0.1 . Une fois sur 2020.0.1, installez Azure DevOps Server 2020.0.1 Patch 2

Nous avons publié un correctif pour Azure DevOps Server 2020.0.1 qui corrige les problèmes suivants.

- CVE-2021-27067 : Divulgation d’informations

- CVE-2021-28459 : Élévation de privilèges

Pour implémenter des correctifs pour ce correctif, vous devez suivre les étapes ci-dessous pour l’installation générale des correctifs, les installations de tâches AzureResourceGroupDeploymentV2 et AzureResourceManagerTemplateDeploymentV3 .

Installation générale des correctifs

Si vous avez Azure DevOps Server 2020.0.1, vous devez installer Azure DevOps Server 2020.0.1 Patch 2.

Vérification de l’installation

Option 1 : exécutez

devops2020.0.1patch2.exe CheckInstall, devops2020.0.1patch2.exe est le fichier téléchargé à partir du lien ci-dessus. La sortie de la commande indique soit que le correctif a été installé, soit qu’il n’est pas installé.Option 2 : Vérifiez la version du fichier suivant :

[INSTALL_DIR]\Azure DevOps Server 2020\Application Tier\bin\Microsoft.Teamfoundation.Framework.Server.dll. Azure DevOps Server 2020.0.1 est installéc:\Program Files\Azure DevOps Server 2020sur par défaut. Après avoir installé Azure DevOps Server 2020.0.1 Patch 2, la version sera 18.170.31123.3.

Installation de la tâche AzureResourceGroupDeploymentV2

Notes

Toutes les étapes mentionnées ci-dessous doivent être effectuées sur un ordinateur Windows

Installer

Extrayez le package AzureResourceGroupDeploymentV2.zip dans un nouveau dossier sur votre ordinateur. Par exemple : D :\tasks\AzureResourceGroupDeploymentV2.

Téléchargez et installez Node.js 14.15.1 et npm (inclus avec le téléchargement Node.js) en fonction de votre ordinateur.

Ouvrez une invite de commandes en mode administrateur et exécutez la commande suivante pour installer tfx-cli.

npm install -g tfx-cli

Create un jeton d’accès personnel avec des privilèges d’accès complets et copiez-le. Ce jeton d’accès personnel sera utilisé lors de l’exécution de la commande tfx login .

Exécutez la commande suivante à partir de l’invite de commandes. Lorsque vous y êtes invité, entrez l’URL du service et le jeton d’accès personnel.

~$ tfx login

Copyright Microsoft Corporation

> Service URL: {url}

> Personal access token: xxxxxxxxxxxx

Logged in successfully

- Exécutez la commande suivante pour charger la tâche sur le serveur. Utilisez le chemin d’accès du fichier .zip extrait à l’étape 1.

~$ tfx build tasks upload --task-path *<Path of the extracted package>*

Installation de la tâche AzureResourceManagerTemplateDeploymentV3

Notes

Toutes les étapes mentionnées ci-dessous doivent être effectuées sur un ordinateur Windows

Installer

Extrayez le package AzureResourceManagerTemplateDeploymentV3.zip dans un nouveau dossier sur votre ordinateur. Par exemple : D :\tasks\AzureResourceManagerTemplateDeploymentV3.

Téléchargez et installez Node.js 14.15.1 et npm (inclus avec le téléchargement Node.js) en fonction de votre ordinateur.

Ouvrez une invite de commandes en mode administrateur et exécutez la commande suivante pour installer tfx-cli.

npm install -g tfx-cli

Create un jeton d’accès personnel avec des privilèges d’accès complets et copiez-le. Ce jeton d’accès personnel sera utilisé lors de l’exécution de la commande tfx login .

Exécutez ce qui suit à partir de l’invite de commandes. Lorsque vous y êtes invité, entrez l’URL du service et le jeton d’accès personnel.

~$ tfx login

Copyright Microsoft Corporation

> Service URL: {url}

> Personal access token: xxxxxxxxxxxx

Logged in successfully

- Exécutez la commande suivante pour charger la tâche sur le serveur. Utilisez le chemin du fichier .zip extrait à l’étape 1.

~$ tfx build tasks upload --task-path *<Path of the extracted package>*

Azure DevOps Server 2020.0.1 Patch 1 Date de publication : 9 février 2021

Nous avons publié un correctif pour Azure DevOps Server 2020.0.1 qui corrige ce qui suit. Consultez le billet de blog pour plus d’informations.

- Résoudre le problème signalé dans ce ticket de commentaires Developer Community | Le bouton Nouveau cas de test ne fonctionne pas

- Incluez les correctifs publiés avec Azure DevOps Server Correctif 2 2020.

Azure DevOps Server 2020 Patch 3 Date de publication : 9 février 2021

Nous avons publié un correctif pour Azure DevOps Server 2020 qui corrige ce qui suit. Consultez le billet de blog pour plus d’informations.

- Résoudre le problème signalé dans ce ticket de commentaires Developer Community | Le bouton Nouveau cas de test ne fonctionne pas

Azure DevOps Server 2020.0.1 Date de publication : 19 janvier 2021

Azure DevOps Server 2020.0.1 est un cumul de correctifs de bogues. Vous pouvez installer directement Azure DevOps Server 2020.0.1 ou effectuer une mise à niveau à partir d’une installation existante. Les versions prises en charge pour la mise à niveau sont Azure DevOps Server 2020, Azure DevOps Server 2019 et Team Foundation Server 2012 ou version ultérieure.

Cette version inclut les corrections des bugs suivants :

- Résoudre un problème de mise à niveau à partir de Azure DevOps Server 2019 où le proxy Git peut cesser de fonctionner après la mise à niveau.

- Correction de l’exception System.OutOfMemoryException pour les collections non-ENU avant Team Foundation Server 2017 lors de la mise à niveau vers Azure DevOps Server 2020. Résout le problème signalé dans ce ticket de commentaires Developer Community.

- Échec de maintenance provoqué par des Microsoft.Azure.DevOps.ServiceEndpoints.Sdk.Server.Extensions.dll manquants. Résout le problème signalé dans ce ticket de commentaires Developer Community.

- Correction d’une erreur de nom de colonne non valide dans Analytics lors de la mise à niveau vers Azure DevOps Server 2020. Résout le problème signalé dans ce ticket de commentaires Developer Community.

- XSS stocké lors de l’affichage des étapes de cas de test dans les résultats du cas de test.

- Échec de l’étape de mise à niveau lors de la migration des données de résultats des points vers le TCM.

Azure DevOps Server 2020 Patch 2 Date de publication : 12 janvier 2021

Nous avons publié un correctif pour Azure DevOps Server 2020 qui corrige ce qui suit. Consultez le billet de blog pour plus d’informations.

- Les détails de la série de tests n’affichent pas les détails de l’étape de test pour les données de test migrées à l’aide d’OpsHub Migration

- Exception sur l’initialiseur pour « Microsoft.TeamFoundation.TestManagement.Server.TCMLogger »

- Les builds non conservées sont immédiatement supprimées après la migration vers Azure DevOps Server 2020

- Corriger l’exception du fournisseur de données

Azure DevOps Server 2020 Date du correctif 1 : 8 décembre 2020

Nous avons publié un correctif pour Azure DevOps Server 2020 qui corrige ce qui suit. Consultez le billet de blog pour plus d’informations.

- CVE-2020-17145 : vulnérabilité d’usurpation d’identité Azure DevOps Server et Team Foundation Services

Azure DevOps Server 2020 Date de publication : 6 octobre 2020

Azure DevOps Server 2020 est un cumul de correctifs de bogues. Il inclut toutes les fonctionnalités du Azure DevOps Server RC2 2020 publié précédemment.

Notes

Azure DevOps 2020 Server rencontre un problème lors de l’installation de l’un des assemblys utilisés par le système de fichiers virtuel Git (GVFS).

Si vous effectuez une mise à niveau à partir d’Azure DevOps 2019 (n’importe quelle version) ou d’un candidat de publication Azure DevOps 2020 et que vous effectuez une installation vers le même répertoire que la version précédente, l’assembly Microsoft.TeamFoundation.Git.dll n’est pas installé. Vous pouvez vérifier que vous avez rencontré le problème en recherchant Microsoft.TeamFoundation.Git.dll dans les <Install Dir>\Version Control Proxy\Web Services\bindossiers et <Install Dir>\Application Tier\TFSJobAgent<Install Dir>\Tools . Si le fichier est manquant, vous pouvez exécuter une réparation pour restaurer les fichiers manquants.

Pour exécuter une réparation, accédez à Settings -> Apps & Features la Azure DevOps Server machine/machine virtuelle et exécutez une réparation sur Azure DevOps 2020 Server. Une fois la réparation terminée, vous pouvez redémarrer la machine/machine virtuelle.

Azure DevOps Server 2020 RC2 Date de publication : 11 août 2020

Azure DevOps Server 2020 RC2 est un cumul de correctifs de bogues. Il inclut toutes les fonctionnalités du Azure DevOps Server 2020 RC1 publié précédemment.

Azure DevOps Server 2020 RC1 date de publication : 10 juillet 2020

Nous avons re-publié Azure DevOps Server RC1 2020 pour résoudre ce Developer Community ticket de commentaires.

Auparavant, après la mise à niveau de Azure DevOps Server 2019 Update 1.1 vers Azure DevOps Server 2020 RC1, vous n’étiez pas en mesure d’afficher les fichiers dans Repos, Pipelines et Wiki de l’interface utilisateur web. Un message d’erreur indiquant qu’une erreur inattendue s’est produite dans cette région de la page. Vous pouvez essayer de recharger ce composant ou d’actualiser la page entière. Avec cette version, nous avons résolu ce problème. Consultez le billet de blog pour plus d’informations.

Azure DevOps Server 2020 RC1 Date de publication : 30 juin 2020

Résumé des nouveautés de Azure DevOps Server 2020

Azure DevOps Server 2020 introduit de nombreuses nouvelles fonctionnalités. Voici les principales :

- Pipelines à plusieurs étapes

- Déploiement continu dans YAML

- Suivre la progression des éléments parents à l’aide du backlog Rollup on Boards

- Ajouter le filtre « Élément de travail parent » au tableau des tâches et sprinter le backlog

- Nouvelle interface utilisateur web pour Azure Repos pages d’accueil

- Administration de la stratégie de branche interpo

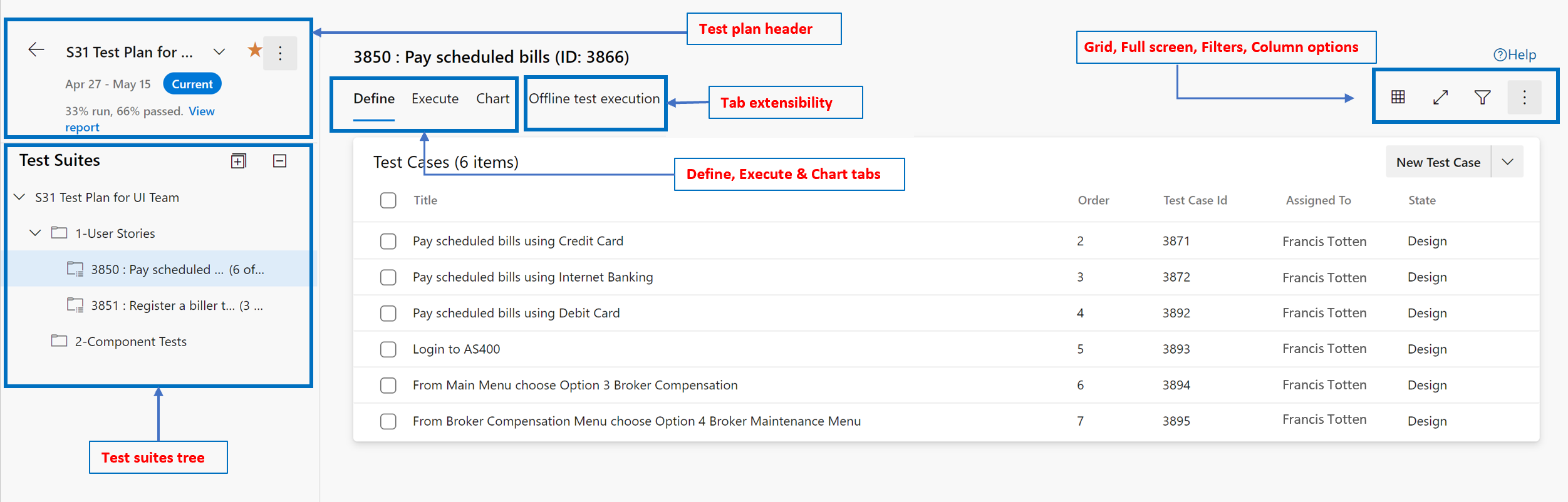

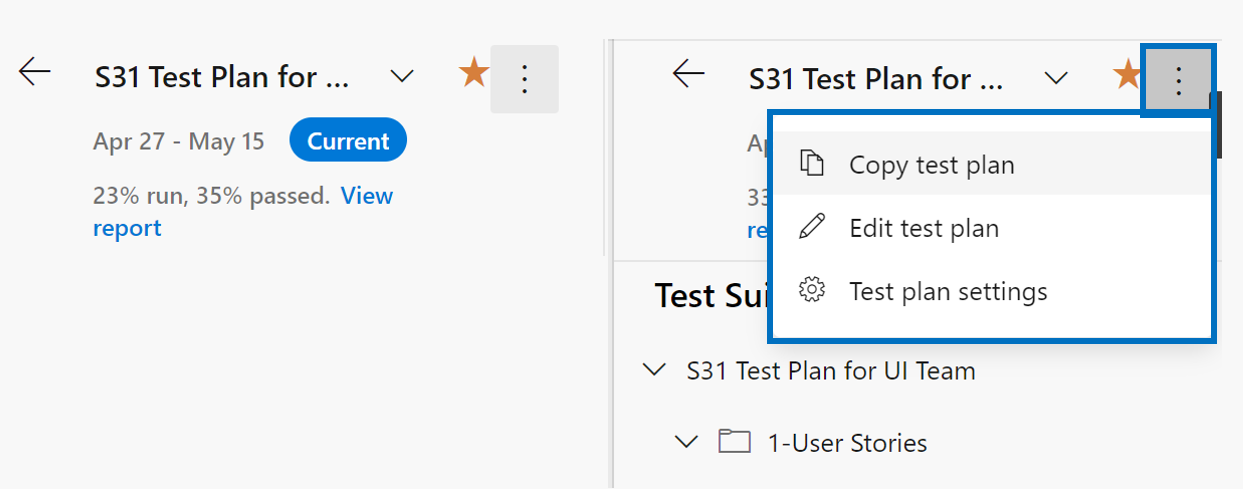

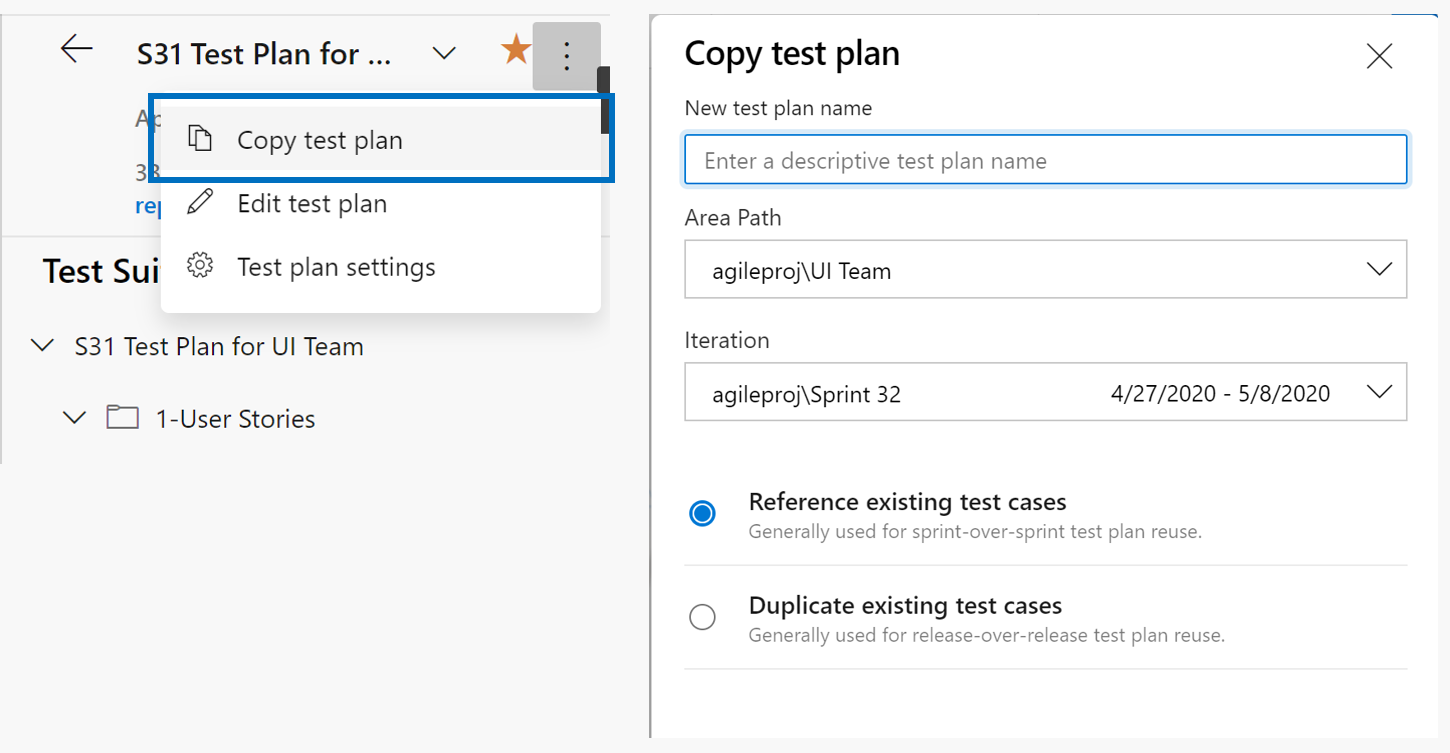

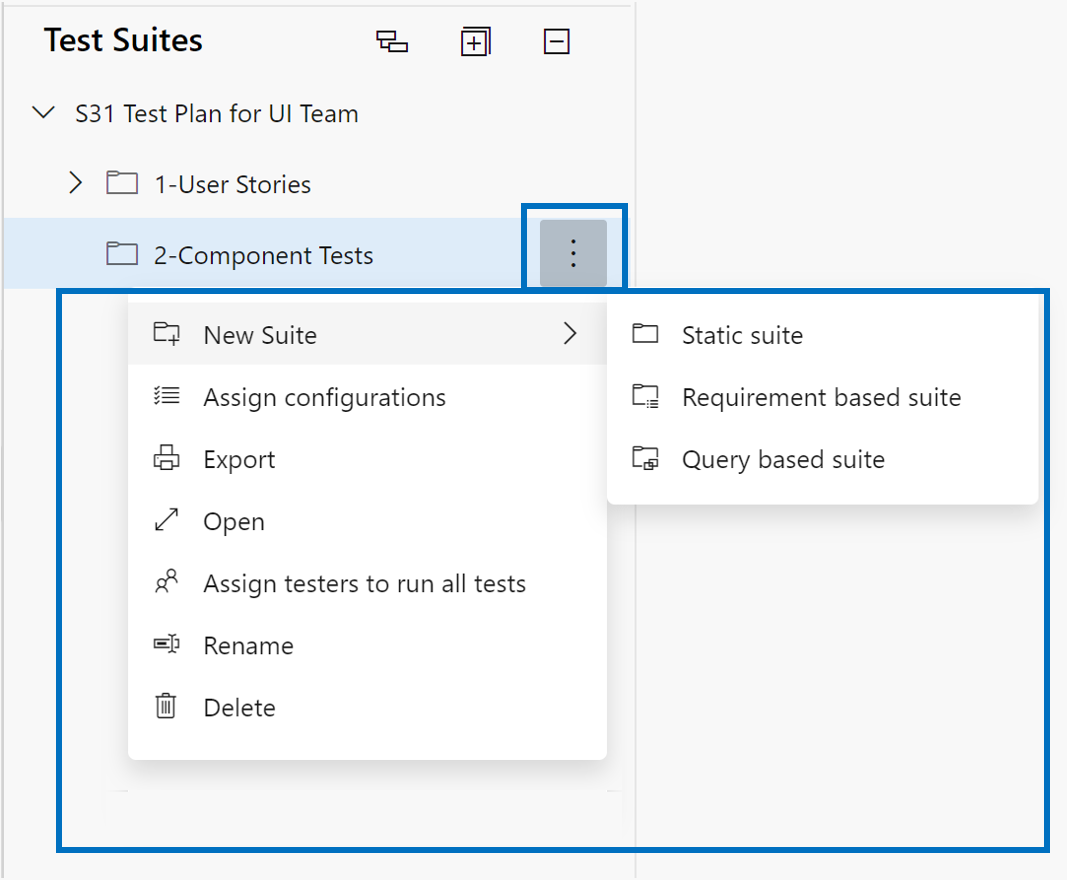

- Page Nouveau plan de test

- Modification enrichie pour les pages wiki de code

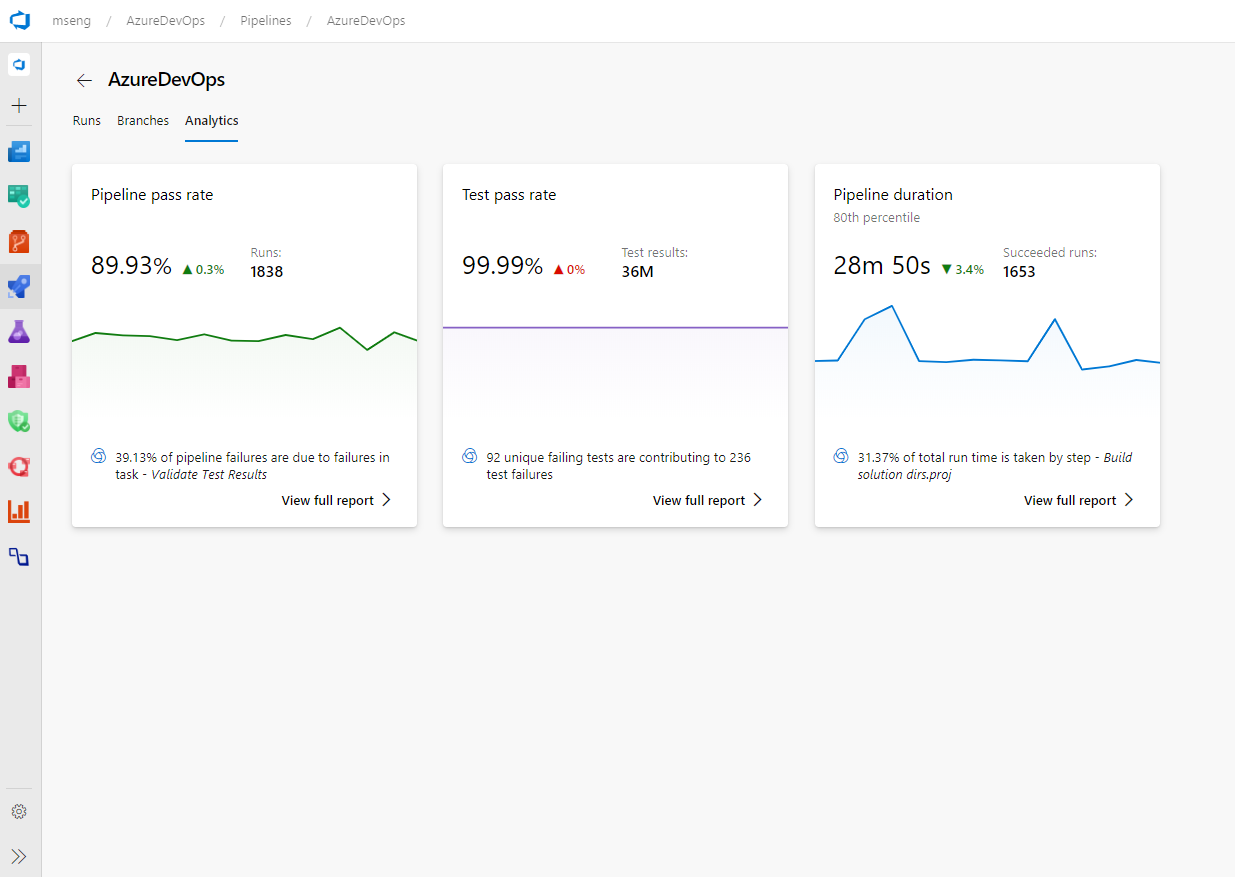

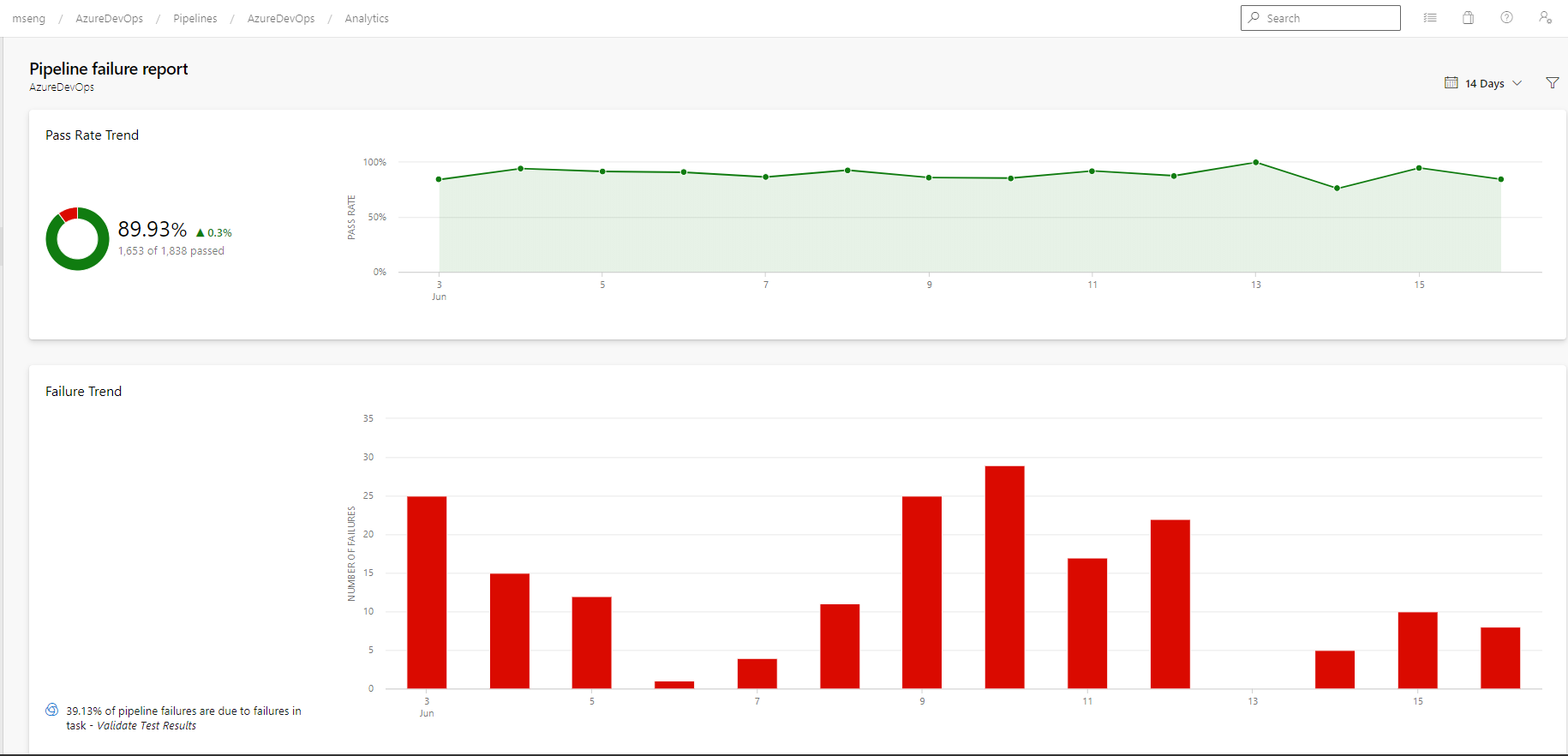

- Rapports d’échec et de durée du pipeline

Vous pouvez également accéder à des sections individuelles pour voir toutes les nouvelles fonctionnalités de chaque service :

Général

Disponibilité générale d’Azure DevOps CLI

En février, nous avons introduit l’extension Azure DevOps pour Azure CLI. L’extension vous permet d’interagir avec Azure DevOps à partir de la ligne de commande. Nous avons collecté vos commentaires qui nous ont aidés à améliorer l’extension et à ajouter d’autres commandes. Nous sommes maintenant heureux d’annoncer que l’extension est en disponibilité générale.

Pour en savoir plus sur l’interface CLI Azure DevOps, consultez la documentation ici.

Utiliser le profil de publication pour déployer Azure WebApps pour Windows à partir du Centre de déploiement

Vous pouvez maintenant utiliser l’authentification basée sur le profil de publication pour déployer vos applications Web Azure pour Windows à partir du Centre de déploiement. Si vous avez l’autorisation de déployer sur une application Web Azure pour Windows à l’aide de son profil de publication, vous pouvez configurer le pipeline à l’aide de ce profil dans les workflows du Centre de déploiement.

Boards

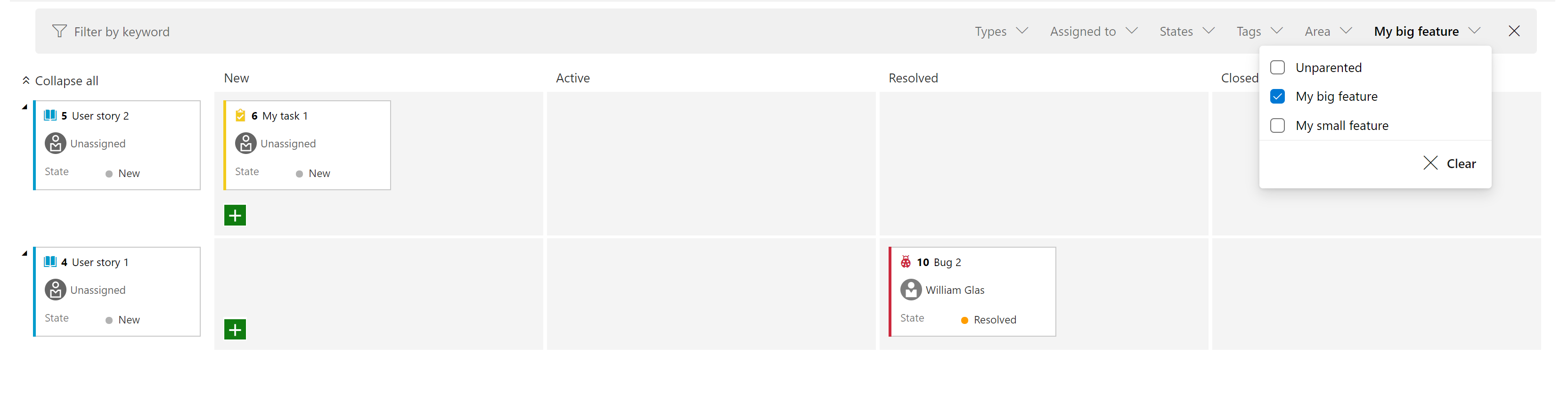

Ajouter le filtre « Élément de travail parent » au tableau des tâches et sprinter le backlog

Nous avons ajouté un nouveau filtre au tableau Sprint et au backlog Sprint. Cela vous permet de filtrer les éléments de backlog au niveau des exigences (première colonne à gauche) par leur parent. Par exemple, dans la capture d’écran ci-dessous, nous avons filtré l’affichage pour afficher uniquement les témoignages d’utilisateurs où le parent est « Ma grande fonctionnalité ».

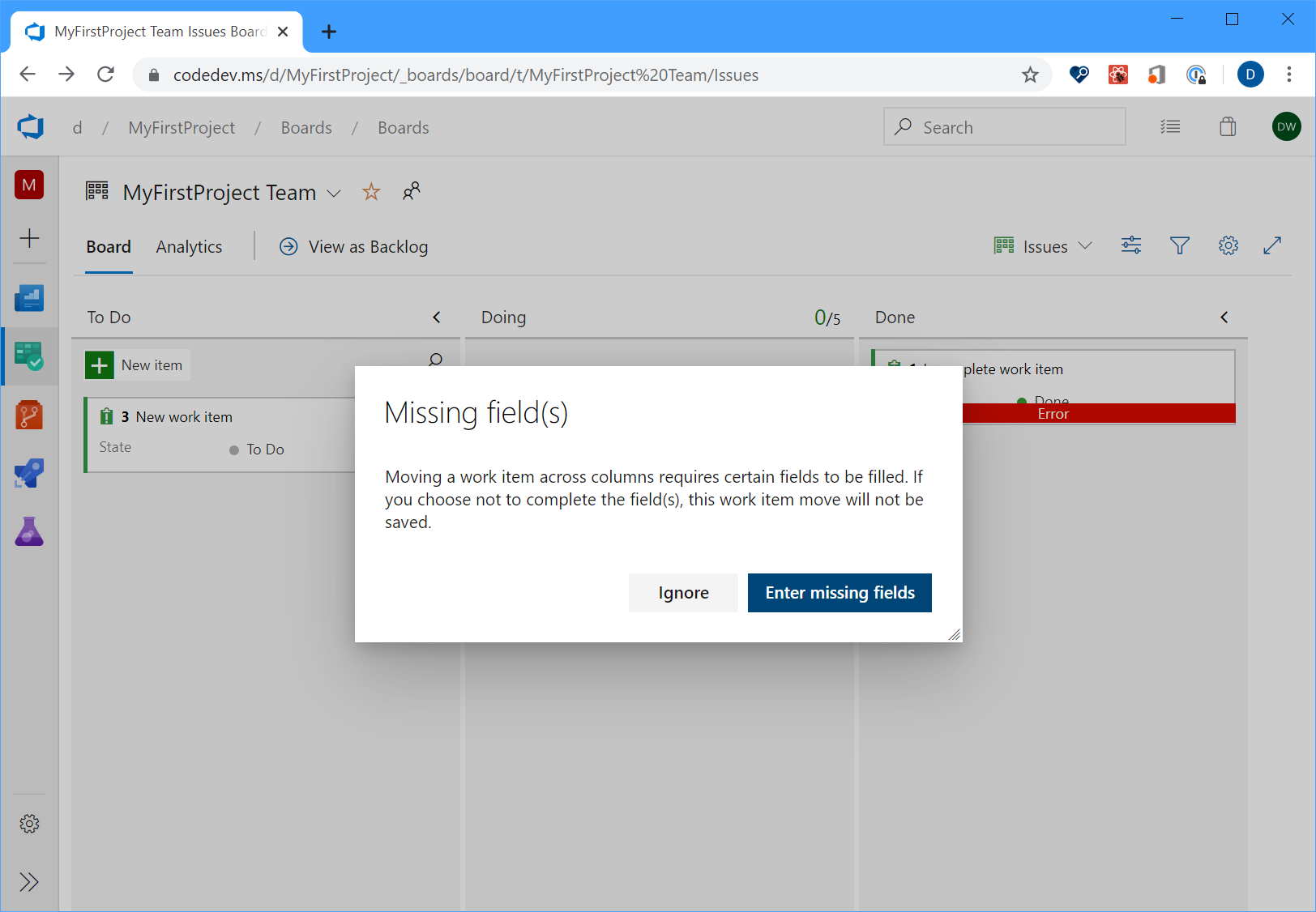

Améliorer l’expérience de gestion des erreurs : champs obligatoires sur bogue/tâche

Historiquement, à partir du tableau Kanban, si vous avez déplacé un élément de travail d’une colonne vers une autre où le changement d’état a déclenché des règles de champ, le carte afficherait simplement un message d’erreur rouge qui vous obligera à ouvrir l’élément de travail pour comprendre la cause racine. Dans sprint 170, nous avons amélioré l’expérience afin que vous puissiez maintenant cliquer sur le message d’erreur rouge pour afficher les détails de l’erreur sans avoir à ouvrir l’élément de travail lui-même.

Rechargement dynamique de l’élément de travail

Auparavant, lors de la mise à jour d’un élément de travail et qu’un deuxième membre de l’équipe apportait des modifications au même élément de travail, le deuxième utilisateur perdait ses modifications. Maintenant, tant que vous modifiez tous les deux des champs différents, vous verrez des mises à jour actives des modifications apportées à l’élément de travail.

Gérer les chemins d’itération et de zone à partir de la ligne de commande

Vous pouvez maintenant gérer les chemins d’itération et de zone à partir de la ligne de commande à l’aide des az boards iteration commandes et az boards area . Par exemple, vous pouvez configurer et gérer les chemins d’itération et de zone de manière interactive à partir de l’interface CLI, ou automatiser l’ensemble de l’installation à l’aide d’un script. Pour plus d’informations sur les commandes et la syntaxe, consultez la documentation ici.

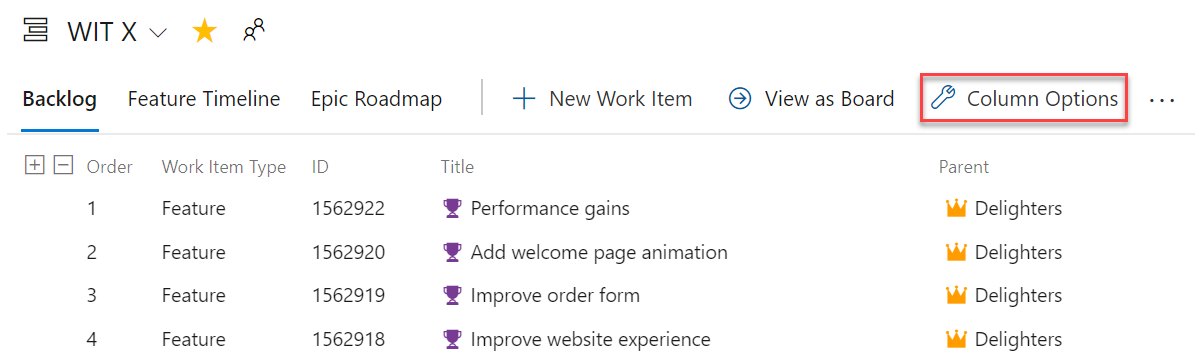

Option colonne parente d’élément de travail en tant que colonne

Vous avez maintenant la possibilité de voir le parent de chaque élément de travail dans votre backlog de produit ou votre backlog de sprint. Pour activer cette fonctionnalité, accédez à Options de colonne dans le backlog souhaité, puis ajoutez la colonne Parent .

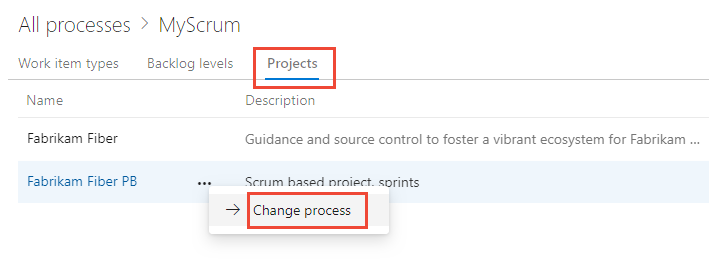

Modifier le processus utilisé par un projet

Vos outils doivent changer au fur et à mesure que votre équipe le fait. Vous pouvez maintenant basculer vos projets de n’importe quel modèle de processus prête à l’emploi vers n’importe quel autre processus prête à l’emploi. Par exemple, vous pouvez changer votre projet d’utilisation d’Agile à Scrum, ou de base à Agile. Vous trouverez une documentation détaillée complète ici.

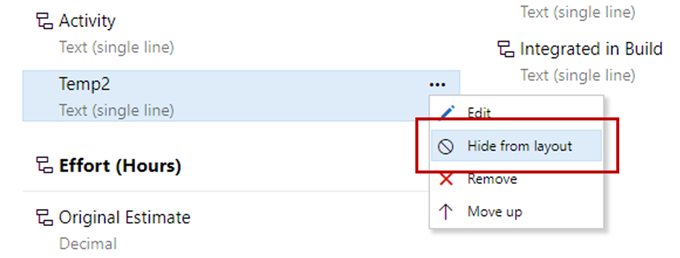

Masquer les champs personnalisés de la disposition

Vous pouvez désormais masquer les champs personnalisés de la disposition du formulaire lors de la personnalisation de votre processus. Le champ sera toujours disponible à partir des requêtes et des API REST. Cela s’avère pratique pour le suivi de champs supplémentaires lors de l’intégration à d’autres systèmes.

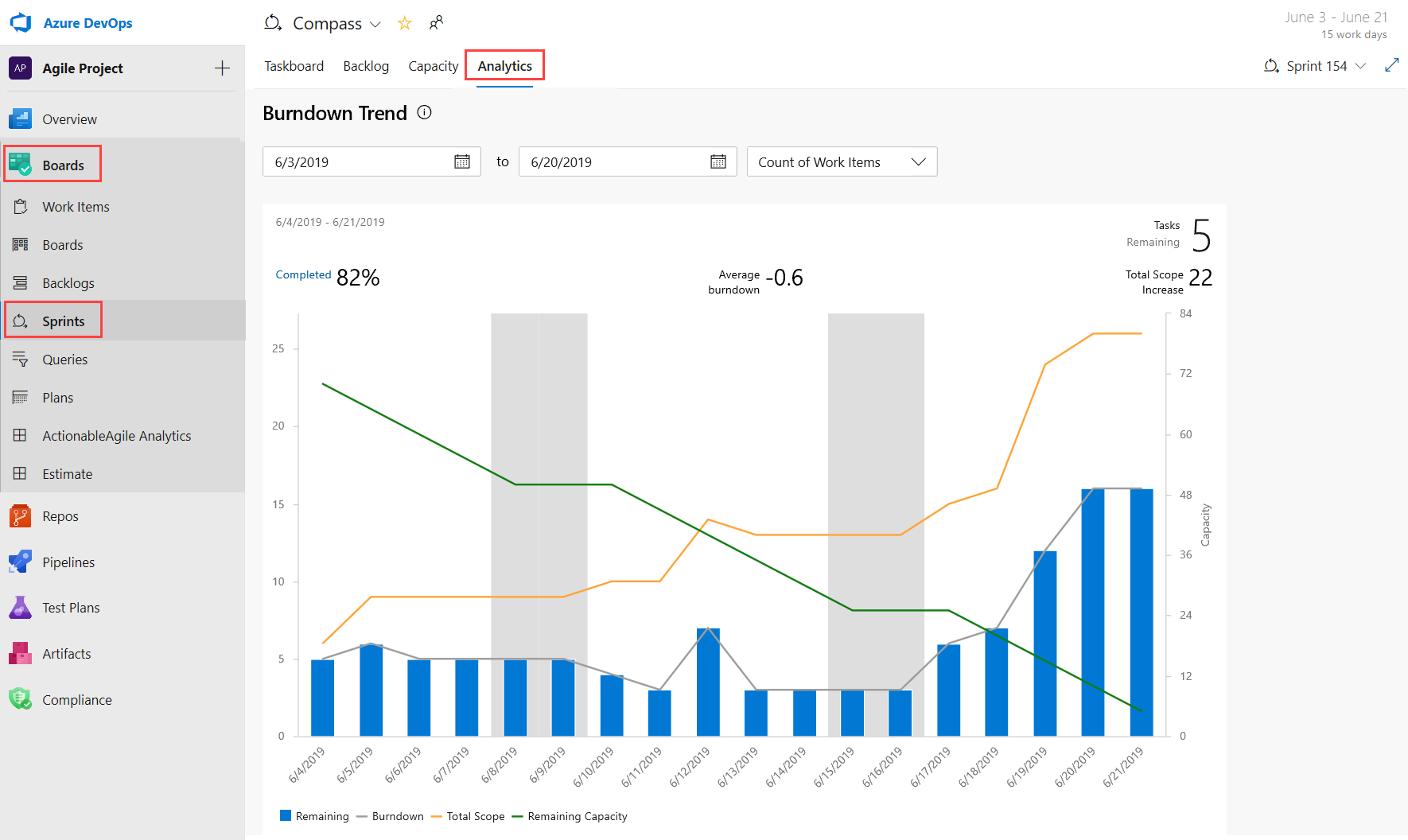

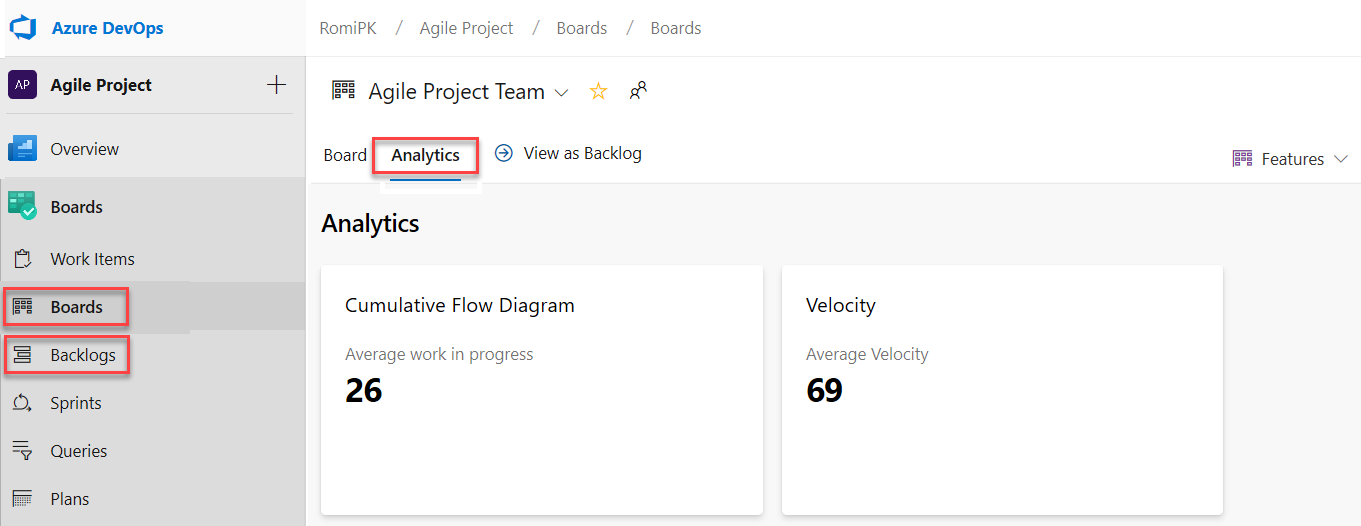

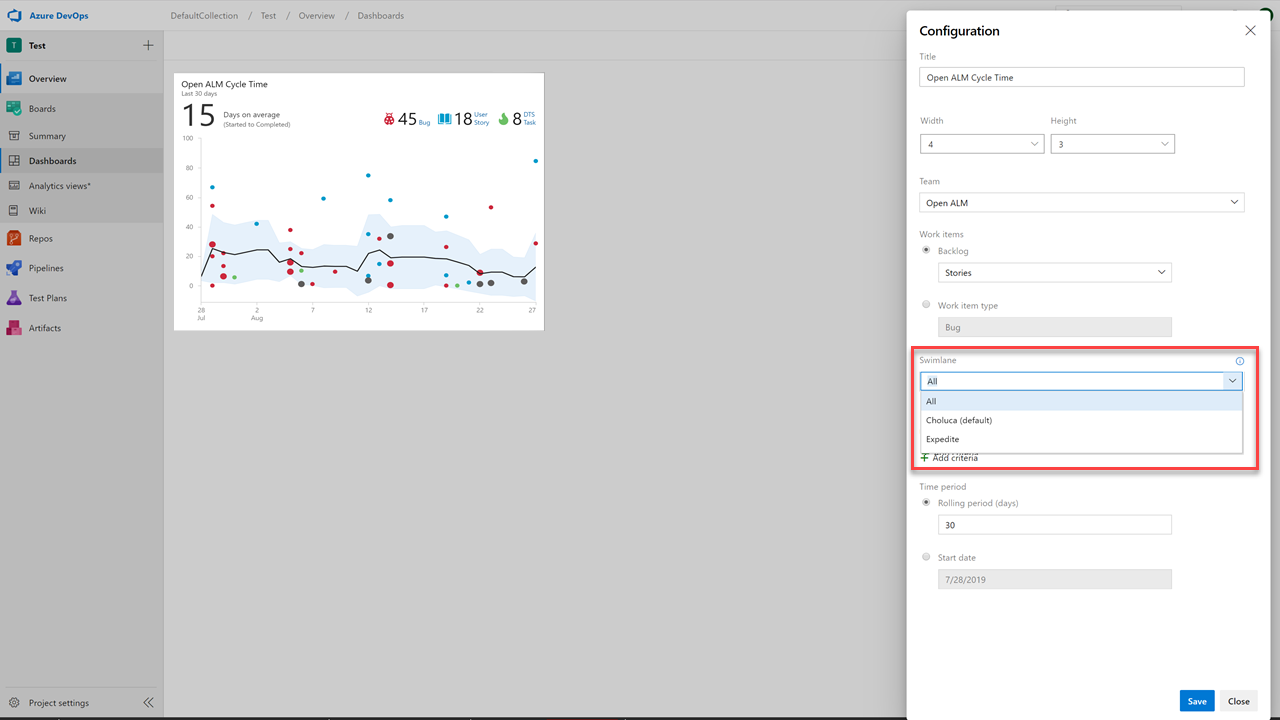

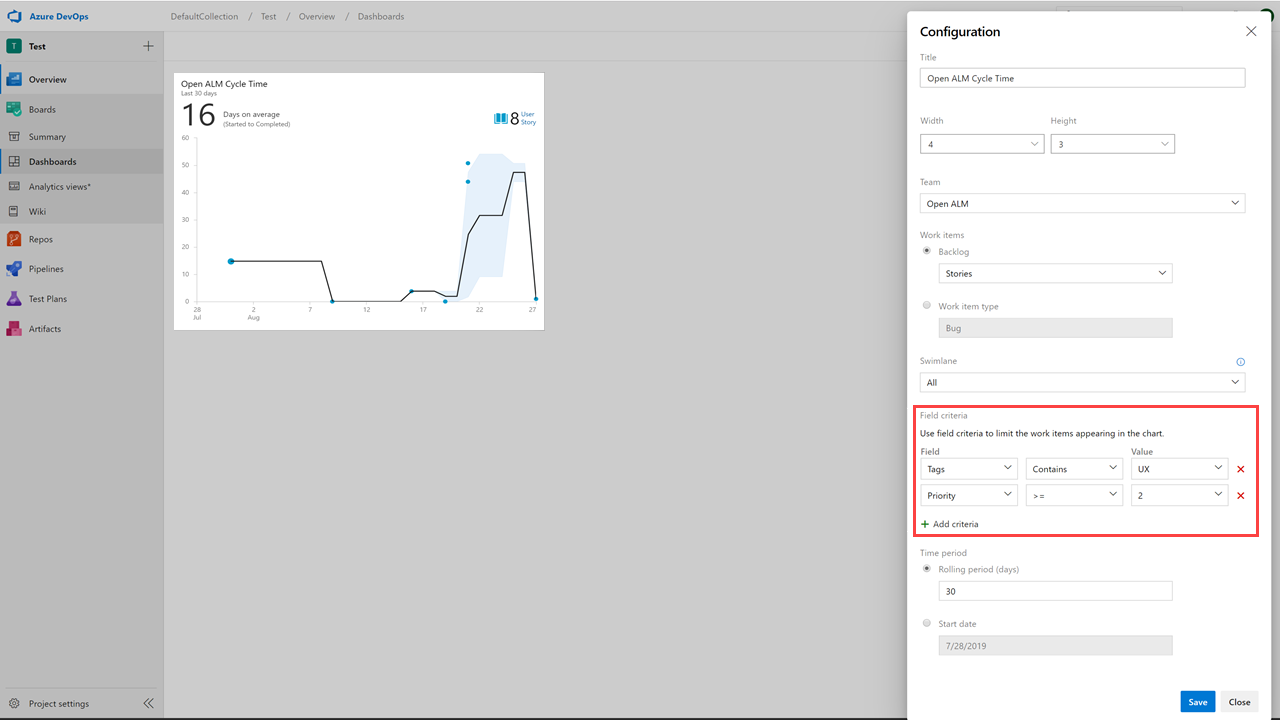

Obtenez des informations sur l’intégrité de votre équipe avec trois nouveaux rapports Azure Boards

Vous ne pouvez pas corriger ce que vous ne voyez pas. Par conséquent, vous souhaitez garder un œil attentif sur l’état et l’intégrité de leurs processus de travail. Grâce à ces rapports, nous vous permet de suivre plus facilement les métriques importantes avec un effort minimal dans Azure Boards.

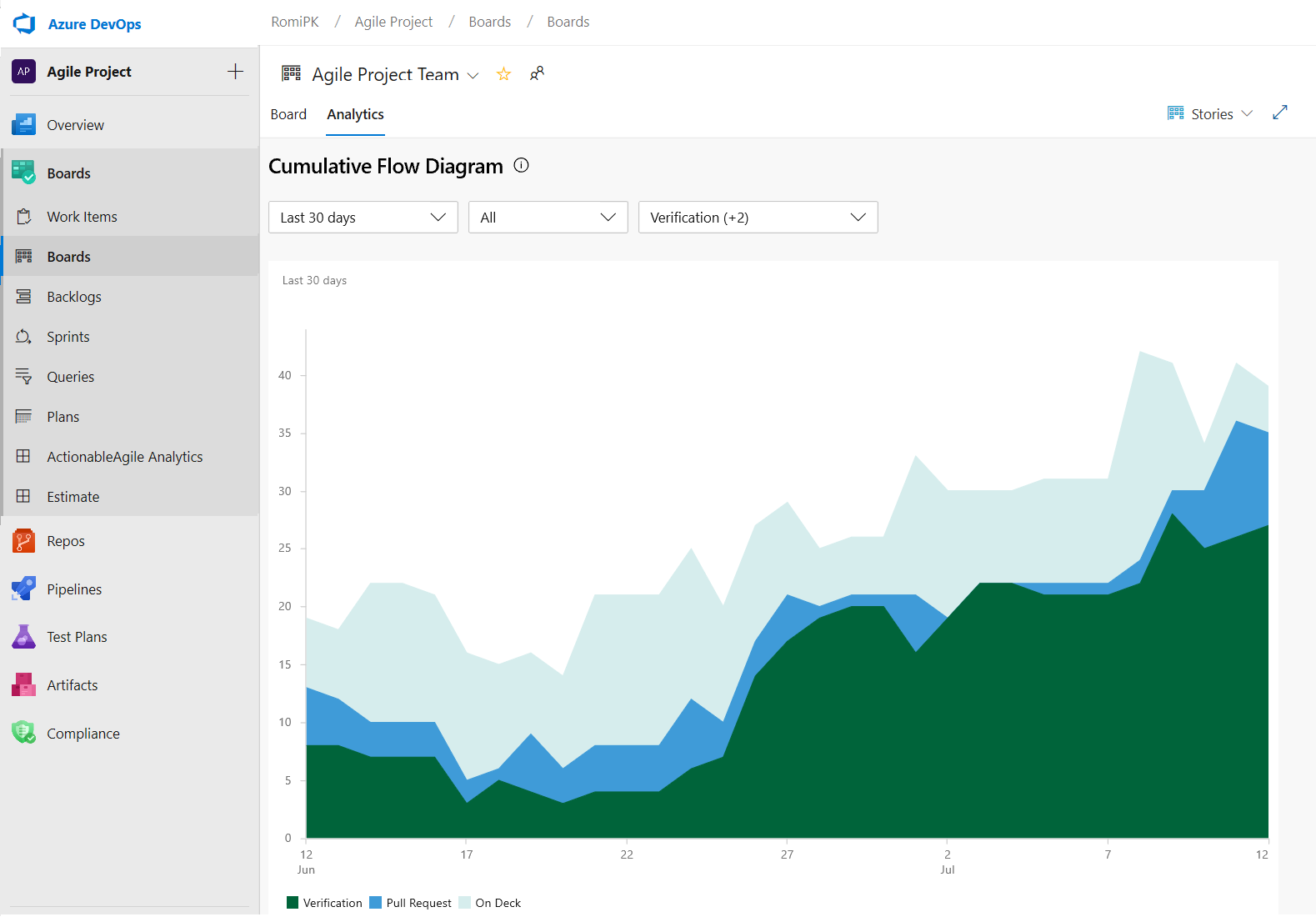

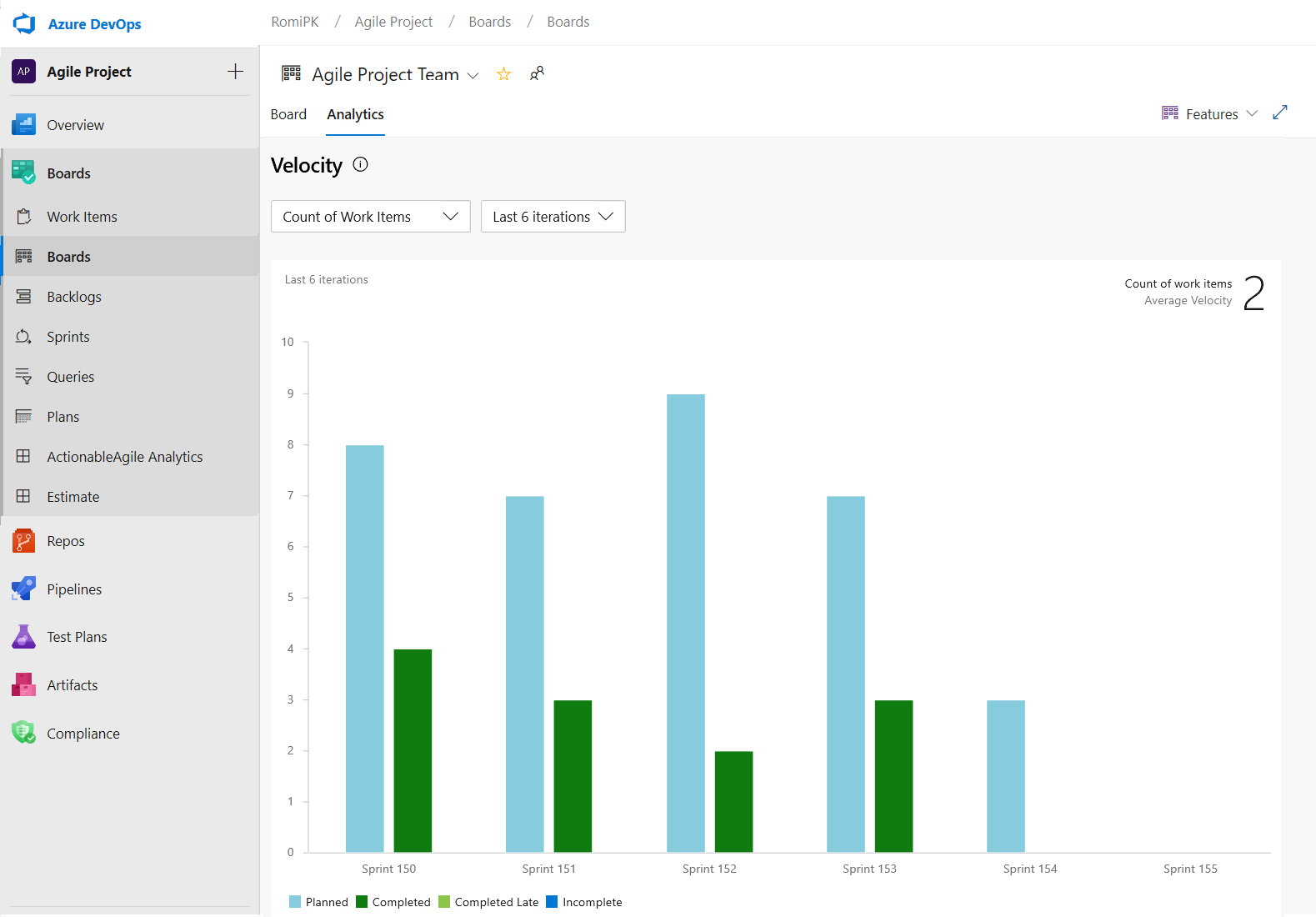

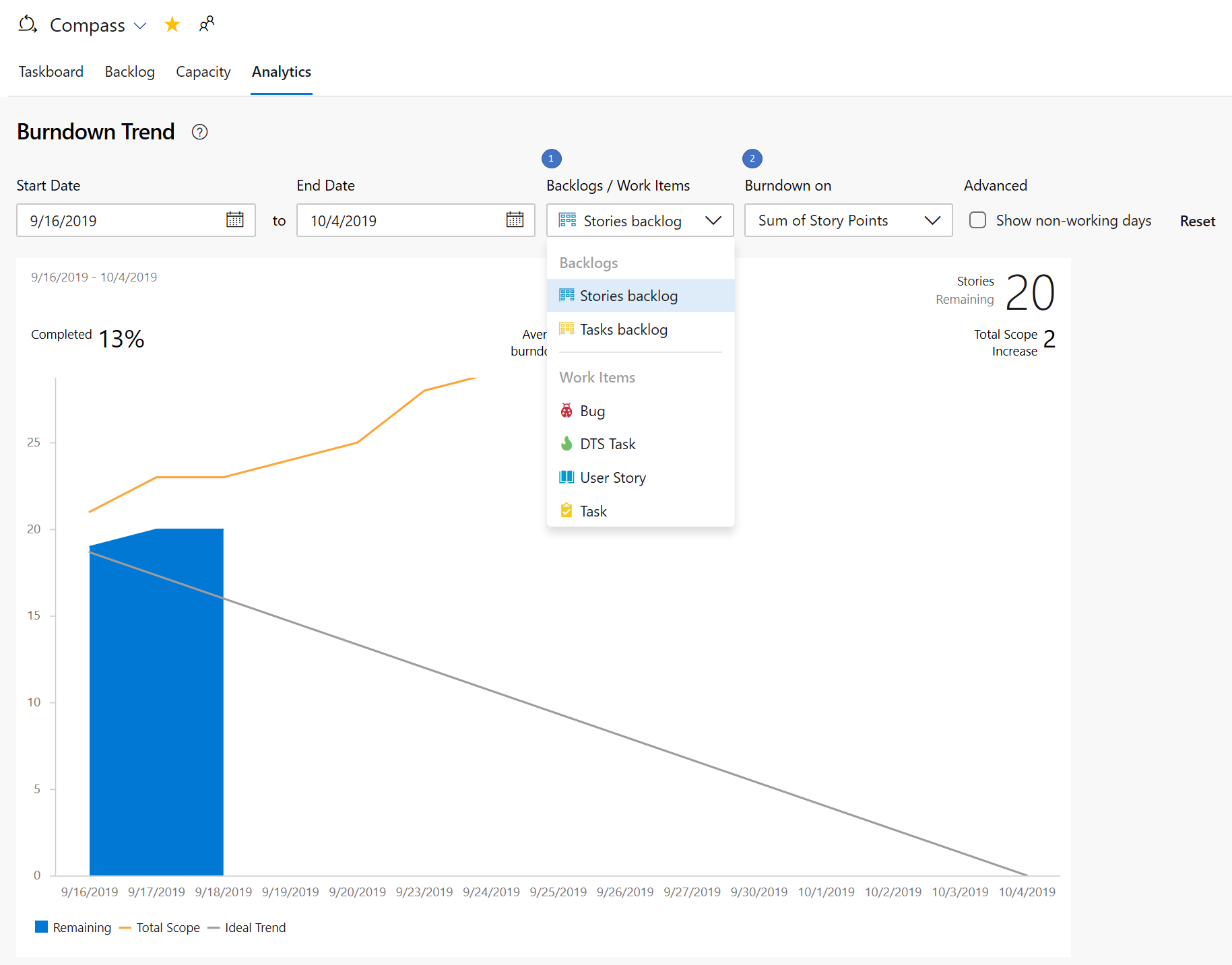

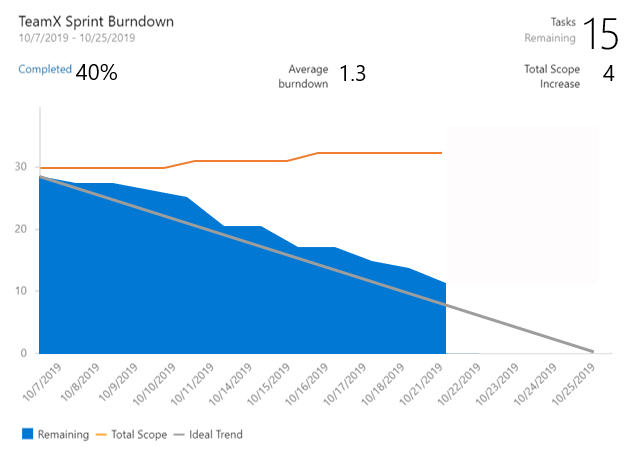

Les trois nouveaux rapports interactifs sont : Burndown, Diagramme de flux cumulé (CFD) et Vitesse. Vous pouvez voir les rapports dans l’onglet Nouvelle analyse.

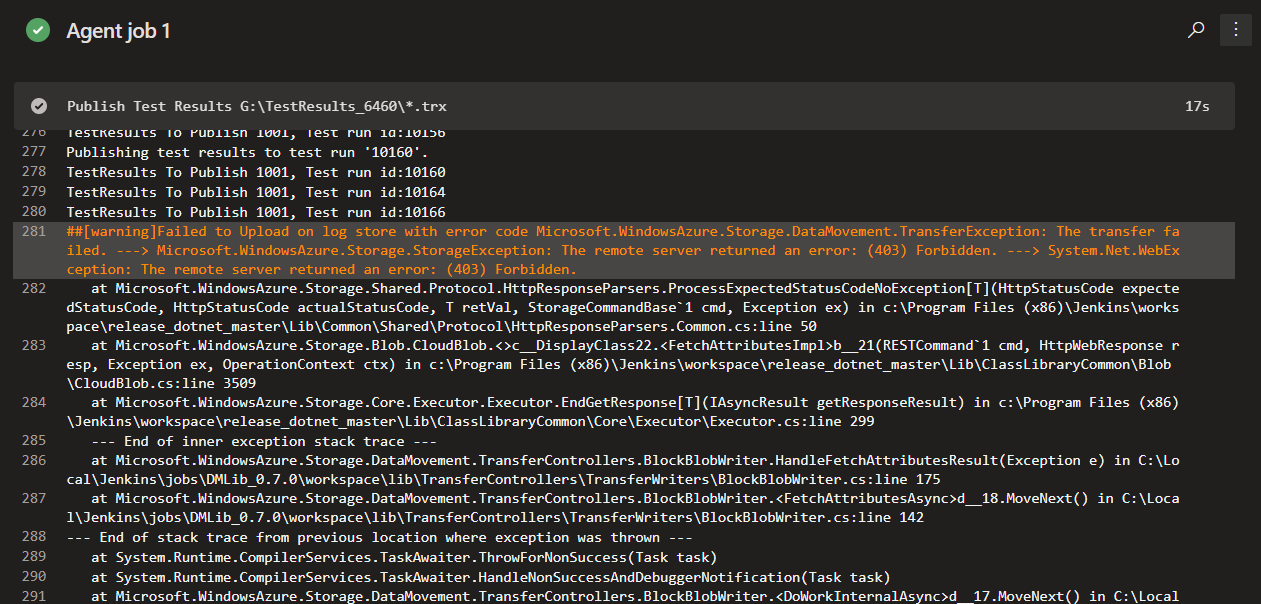

Les métriques telles que le sprint burndown, le flux de travail et la vélocité de l’équipe vous donnent une visibilité sur la progression de votre équipe et vous aident à répondre à des questions telles que :

- Combien de travail nous reste-t-il dans ce sprint ? Sommes-nous en bonne voie pour le terminer ?

- Quelle étape du processus de développement prend la plus longue ? Pouvons-nous faire quelque chose à ce sujet ?

- Sur la base des itérations précédentes, combien de travail devons-nous planifier pour le prochain sprint ?

Notes

Les graphiques précédemment affichés dans les en-têtes ont été remplacés par ces rapports améliorés.

Les nouveaux rapports sont entièrement interactifs et vous permettent de les ajuster à vos besoins. Vous trouverez les nouveaux rapports sous l’onglet Analyse dans chaque hub.

Le graphique de burndown se trouve sous le hub Sprints .

Les rapports CFD et Velocity sont accessibles à partir de l’onglet Analytique sous Tableaux et backlogs en cliquant sur le carte approprié.

Avec les nouveaux rapports, vous disposez de plus de contrôle et d’informations sur votre équipe. Voici quelques exemples :

- Les rapports Sprint Burndown et Velocity peuvent être définis pour utiliser le nombre d’éléments de travail ou la somme du travail restant.

- Vous pouvez ajuster la durée du burndown du sprint sans affecter les dates du projet. Par conséquent, si votre équipe passe généralement le premier jour de chaque planification de sprint, vous pouvez maintenant faire correspondre le graphique pour le refléter.

- Le graphique Burndown comporte désormais un filigrane montrant les week-ends.

- Le rapport CFD vous permet de supprimer des colonnes de tableau comme La conception pour mieux vous concentrer sur le flux sur lequel les équipes ont le contrôle.

Voici un exemple de rapport CFD montrant le flux des 30 derniers jours du backlog Stories.

Le graphique De vitesse peut désormais être suivi pour tous les niveaux de backlog. Par exemple, vous pouvez maintenant ajouter des fonctionnalités et des epics, alors qu’avant le graphique précédent ne supportait que les exigences. Voici un exemple de rapport de vitesse pour les 6 dernières itérations du backlog fonctionnalités.

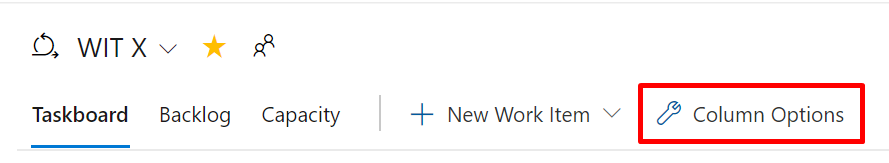

Personnaliser les colonnes du tableau des tâches

Nous sommes heureux d’annoncer que nous avons ajouté une option pour vous permettre de personnaliser les colonnes du tableau des tâches. Vous pouvez maintenant ajouter, supprimer, renommer et réorganiser les colonnes.

Pour configurer les colonnes de votre tableau des tâches, accédez à Options de colonne.

Cette fonctionnalité a été hiérarchisée en fonction d’une suggestion du Developer Community.

Bascule pour afficher ou masquer les éléments de travail enfants terminés dans le backlog

Souvent, lors de l’affinement du backlog, vous souhaitez uniquement voir les éléments qui n’ont pas été terminés. Vous pouvez maintenant afficher ou masquer les éléments enfants terminés dans le backlog.

Si le bouton bascule est activé, vous verrez tous les éléments enfants dans un état terminé. Lorsque le bouton bascule est désactivé, tous les éléments enfants dans un état terminé sont masqués dans le backlog.

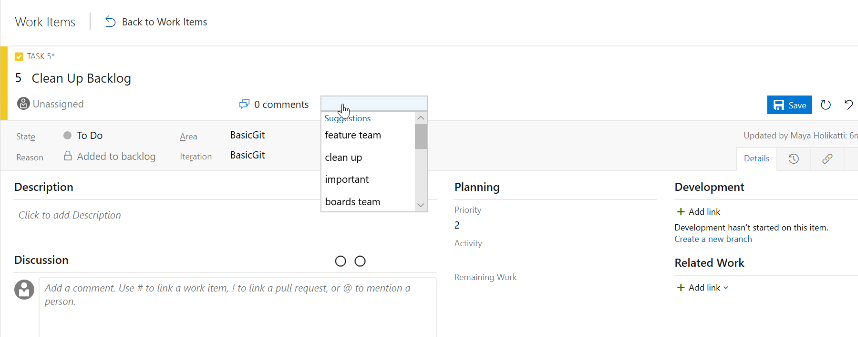

Balises les plus récentes affichées lors de l’étiquetage d’un élément de travail

Lors de l’étiquetage d’un élément de travail, l’option de saisie automatique affiche désormais jusqu’à cinq de vos balises les plus récemment utilisées. Cela facilite l’ajout des informations appropriées à vos éléments de travail.

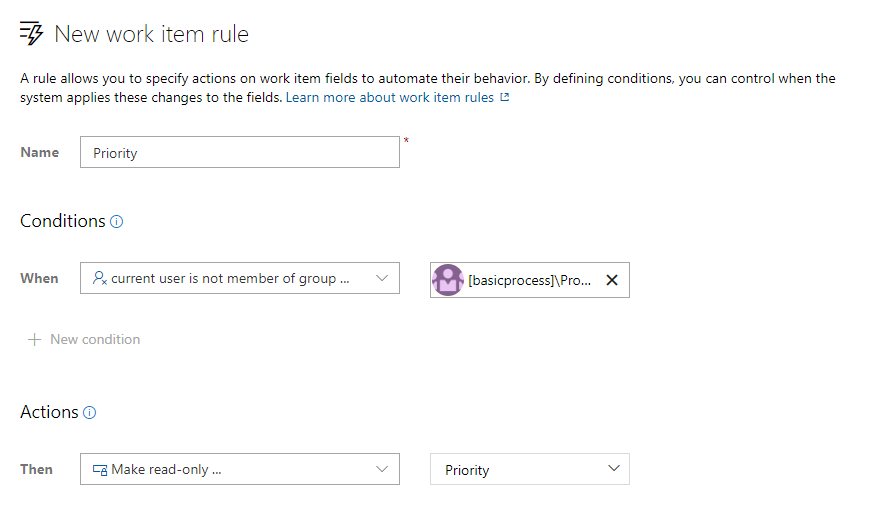

Règles en lecture seule et obligatoires pour l’appartenance à un groupe

Les règles d’élément de travail vous permettent de définir des actions spécifiques sur les champs d’élément de travail pour automatiser leur comportement. Vous pouvez créer une règle pour définir un champ en lecture seule ou obligatoire en fonction de l’appartenance au groupe. Par exemple, vous pouvez accorder aux propriétaires de produits la possibilité de définir la priorité de vos fonctionnalités tout en les rendant en lecture seule pour tout le monde.

Personnaliser les valeurs de la liste de sélection système

Vous pouvez maintenant personnaliser les valeurs de n’importe quelle liste de choix système (à l’exception du champ de raison), comme Gravité, Activité, Priorité, etc. Les personnalisations de la liste de sélection sont limitées afin que vous puissiez gérer des valeurs différentes pour le même champ pour chaque type d’élément de travail.

Nouveau paramètre d’URL d’élément de travail

Partagez des liens vers des éléments de travail avec le contexte de votre tableau ou backlog avec notre nouveau paramètre d’URL d’élément de travail. Vous pouvez maintenant ouvrir une boîte de dialogue d’élément de travail sur votre tableau, votre backlog ou votre expérience de sprint en ajoutant le paramètre ?workitem=[ID] à l’URL.

Toute personne avec laquelle vous partagez le lien atterrira alors avec le même contexte que celui que vous aviez lorsque vous avez partagé le lien !

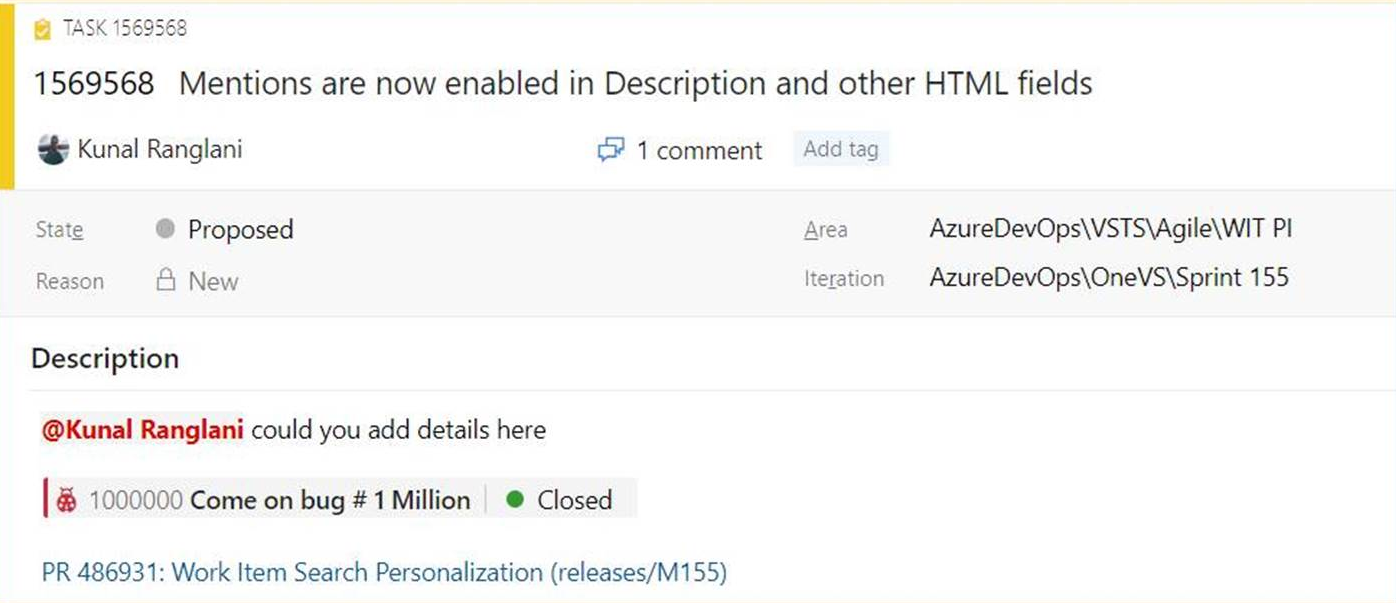

Mentionnez des personnes, des éléments de travail et des demandes de tirage dans les champs de texte

Lorsque nous avons écouté vos commentaires, nous avons entendu dire que vous souhaitiez pouvoir mention personnes, éléments de travail et demandes de tirage dans la zone description de l’élément de travail (et d’autres champs HTML) sur l’élément de travail et pas seulement dans les commentaires. Parfois, vous collaborez avec quelqu’un sur un élément de travail ou souhaitez mettre en évidence une demande de tirage dans la description de votre élément de travail, mais vous n’avez pas eu le moyen d’ajouter ces informations. Vous pouvez maintenant mention personnes, éléments de travail et demandes de tirage dans tous les champs de texte long de l’élément de travail.

Vous pouvez consulter un exemple ici.

- Pour utiliser des mentions de personnes, tapez le @ signe et le nom de la personne que vous souhaitez mention. @mentionsdans les champs d’élément de travail génèreront des Notifications par e-mail comme ce qu’il fait pour les commentaires.

- Pour utiliser les mentions d’élément de travail, tapez le # signe suivi de l’ID ou du titre de l’élément de travail. #mentions créez un lien entre les deux éléments de travail.

- Pour utiliser les mentions de tirage, ajoutez un ! suivi de votre ID ou nom de demande de tirage.

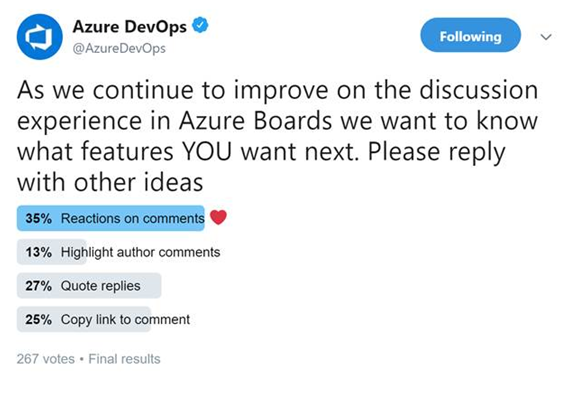

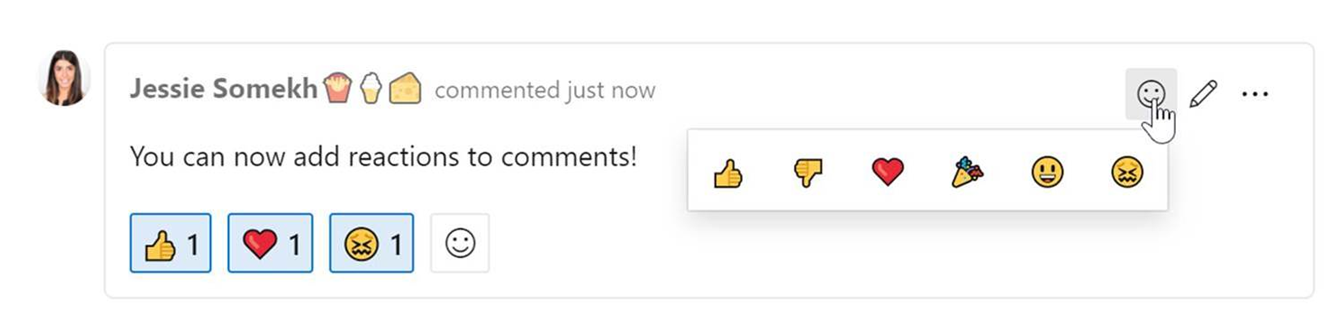

Réactions sur les commentaires de discussion

L’un de nos main objectifs est de rendre les éléments de travail plus collaboratifs pour les équipes. Récemment, nous avons mené un sondage sur Twitter pour savoir quelles fonctionnalités de collaboration vous souhaitez dans les discussions sur l’élément de travail. Apporter des réactions aux commentaires a remporté le sondage, alors nous les ajoutons ! Voici les résultats du sondage Twitter.

Vous pouvez ajouter des réactions à n’importe quel commentaire, et il existe deux façons d’ajouter vos réactions : l’icône smiley en haut à droite de n’importe quel commentaire, ainsi qu’en bas d’un commentaire à côté de toutes les réactions existantes. Vous pouvez ajouter les six réactions si vous le souhaitez, ou juste une ou deux. Pour supprimer votre réaction, cliquez sur la réaction au bas de votre commentaire et elle sera supprimée. Vous pouvez voir ci-dessous l’expérience d’ajout d’une réaction, ainsi que l’apparence des réactions sur un commentaire.

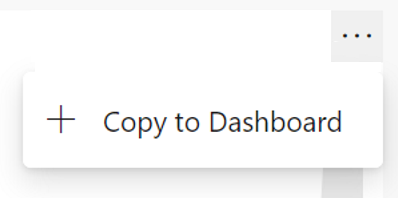

Épingler Azure Boards rapports au tableau de bord

Dans la mise à jour Sprint 155, nous avons inclus des versions mises à jour des rapports CFD et Velocity. Ces rapports sont disponibles sous l’onglet Analytique de Tableaux et backlogs. Vous pouvez maintenant épingler les rapports directement à votre tableau de bord. Pour épingler les rapports, pointez sur le rapport, sélectionnez les points de suspension « ... » et Copier dans le tableau de bord.

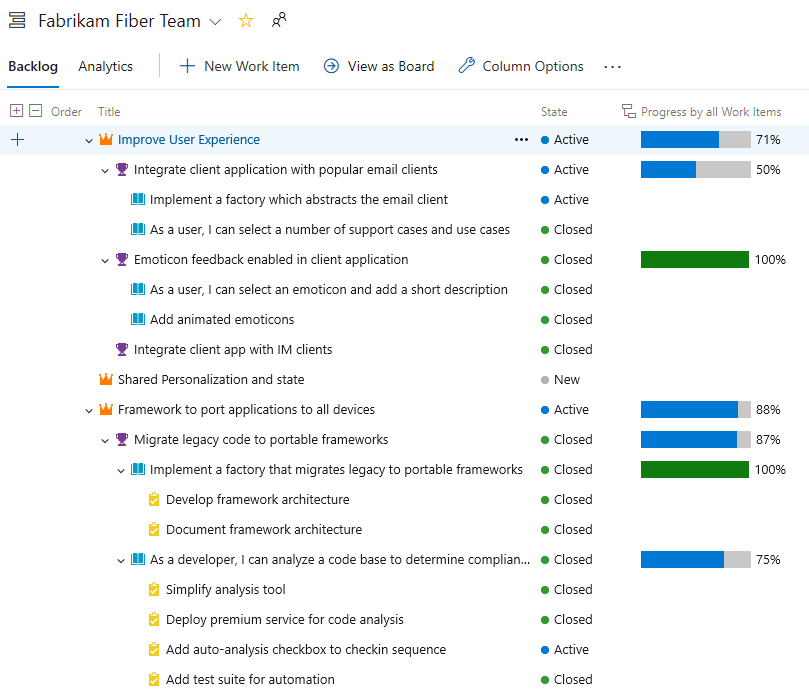

Suivre la progression des éléments parents à l’aide du backlog Rollup on Boards

Les colonnes de cumul affichent des barres de progression et/ou des totaux de champs numériques ou d’éléments descendants au sein d’une hiérarchie. Les éléments descendants correspondent à tous les éléments enfants de la hiérarchie. Une ou plusieurs colonnes de cumul peuvent être ajoutées à un backlog de produit ou de portefeuille.

Par exemple, nous présentons ici Progression par éléments de travail qui affiche les barres de progression des éléments de travail ascendants en fonction du pourcentage d’éléments descendants qui ont été fermés. Les éléments descendants pour Epics incluent toutes les fonctionnalités enfants et leurs éléments de travail enfants ou petits-enfants. Les éléments descendants des fonctionnalités incluent tous les récits utilisateur enfants et leurs éléments de travail enfants.

Mises à jour dynamiques du tableau des tâches

Votre tableau des tâches s’actualise désormais automatiquement lorsque des modifications se produisent ! À mesure que d’autres membres de l’équipe déplacent ou réorganisent des cartes dans le tableau des tâches, votre tableau est automatiquement mis à jour avec ces modifications. Vous n’avez plus besoin d’appuyer sur F5 pour voir les dernières modifications.

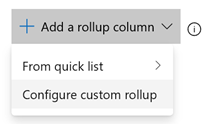

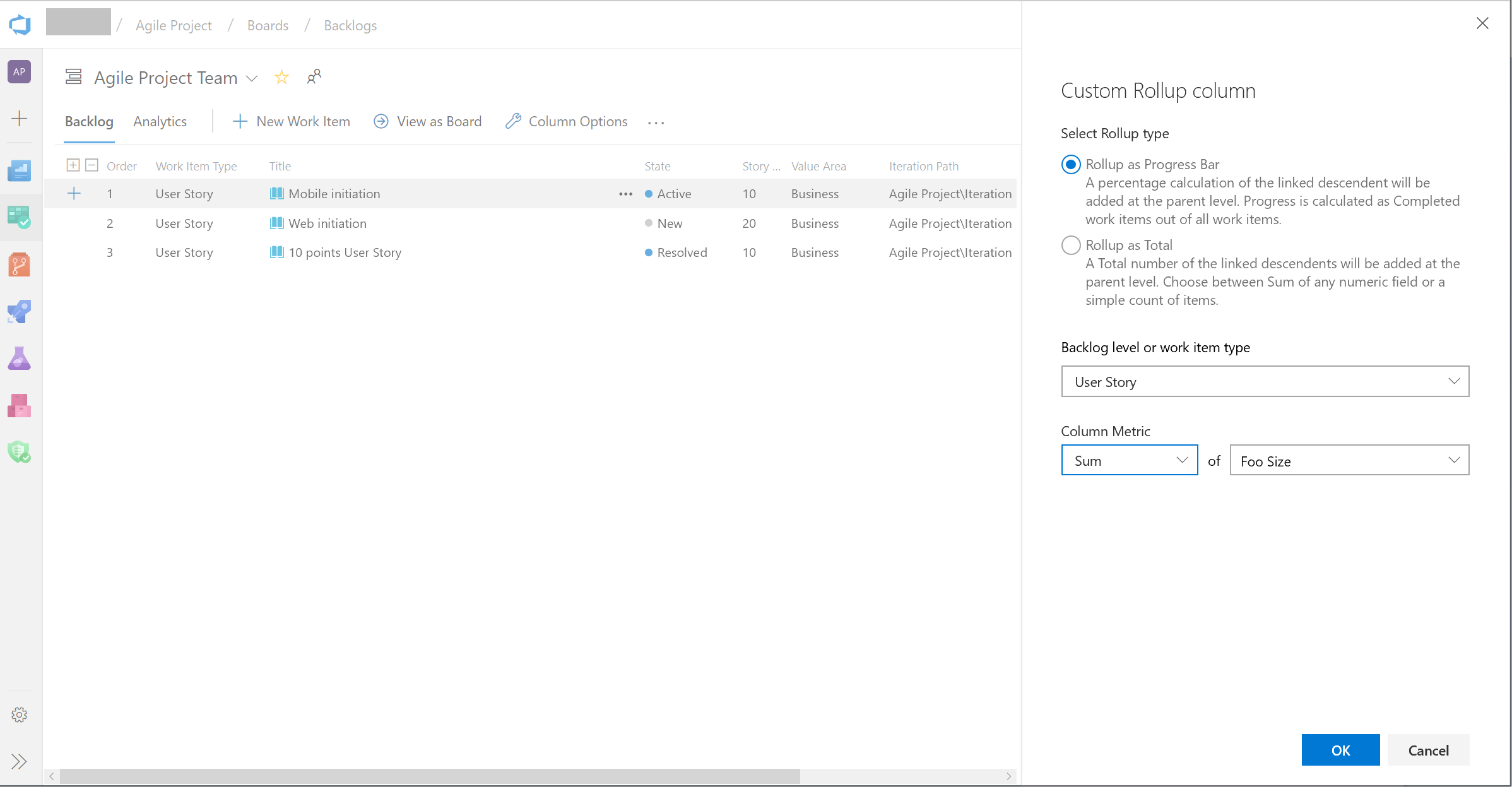

Prise en charge des champs personnalisés dans les colonnes de cumul

Le cumul peut désormais être effectué sur n’importe quel champ, y compris les champs personnalisés. Lorsque vous ajoutez une colonne de correctif cumulatif, vous pouvez toujours choisir une colonne de correctif cumulatif dans la liste rapide. Toutefois, si vous souhaitez effectuer un cumul sur des champs numériques qui ne font pas partie du modèle de processus prête à l’emploi, vous pouvez configurer votre propre colonne comme suit :

- Dans votre backlog, cliquez sur « Options de colonne ». Ensuite, dans le panneau, cliquez sur « Ajouter une colonne de correctif cumulatif », puis sur Configurer le correctif cumulatif personnalisé.

- Choisissez entre Barre de progression et Total.

- Sélectionnez un type d’élément de travail ou un niveau Backlog (généralement, les backlogs agrègent plusieurs types d’éléments de travail).

- Sélectionnez le type d’agrégation. Nombre d’éléments de travail ou Somme. Pour Somme, vous devez sélectionner le champ à résumer.

- Le bouton OK vous ramène au volet d’options de colonne où vous pouvez réorganiser votre nouvelle colonne personnalisée.

Notez que vous ne pouvez pas modifier votre colonne personnalisée après avoir cliqué sur OK. Si vous devez apporter une modification, supprimez la colonne personnalisée et ajoutez-en une autre comme vous le souhaitez.

Nouvelle règle pour masquer les champs d’un formulaire d’élément de travail en fonction de la condition

Nous avons ajouté une nouvelle règle au moteur de règles hérité pour vous permettre de masquer les champs dans un formulaire d’élément de travail. Cette règle masque les champs en fonction de l’appartenance au groupe d’utilisateurs. Par exemple, si l’utilisateur appartient au groupe « propriétaire du produit », vous pouvez masquer un champ spécifique au développeur. Pour plus d’informations, consultez la documentation ici.

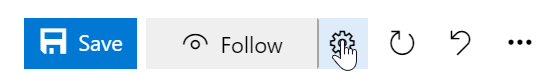

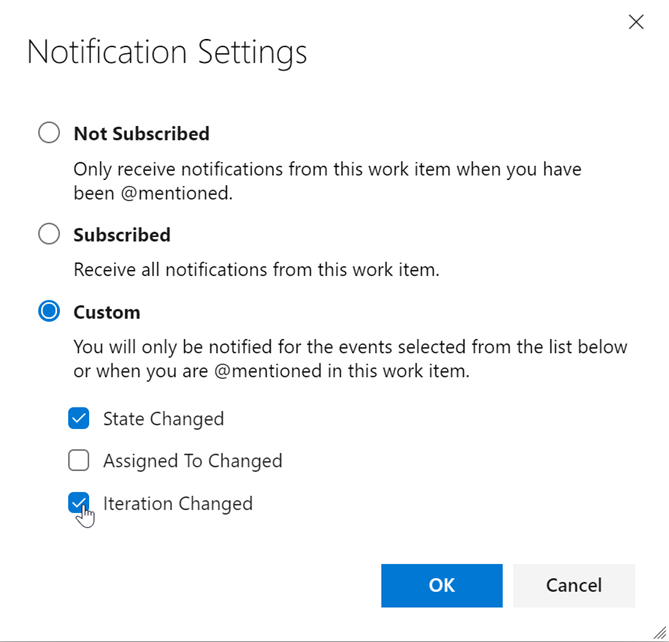

Paramètres de notification d’élément de travail personnalisé

Il est extrêmement important de rester à jour sur les éléments de travail pertinents pour vous ou votre équipe. Il aide les équipes à collaborer et à rester sur la bonne voie avec les projets et s’assure que toutes les bonnes parties sont impliquées. Toutefois, les différents intervenants ont des niveaux d’investissement différents dans différents efforts, et nous croyons que cela devrait se refléter dans votre capacité à suivre les status d’un élément de travail.

Auparavant, si vous vouliez suivre un élément de travail et recevoir des notifications sur les modifications apportées, vous obteniez Notifications par e-mail pour toutes les modifications apportées à l’élément de travail. Après avoir pris en compte vos commentaires, nous rendons le suivi d’un élément de travail plus flexible pour toutes les parties prenantes. Maintenant, vous verrez un nouveau bouton paramètres en regard du bouton Suivre dans le coin supérieur droit de l’élément de travail. Vous accédez alors à une fenêtre contextuelle qui vous permettra de configurer vos options suivantes.

Dans Paramètres de notification, vous pouvez choisir parmi trois options de notification. Tout d’abord, vous pouvez être complètement désinscrit. Deuxièmement, vous pouvez être entièrement abonné, où vous recevez des notifications pour toutes les modifications d’élément de travail. Enfin, vous pouvez choisir d’être averti pour certains des principaux événements de modification d’élément de travail. Vous pouvez sélectionner une seule ou les trois options. Cela permet aux membres de l’équipe de suivre les éléments de travail à un niveau supérieur et de ne pas être distraits par chaque modification effectuée. Avec cette fonctionnalité, nous allons éliminer les e-mails inutiles et vous permettre de vous concentrer sur les tâches cruciales à accomplir.

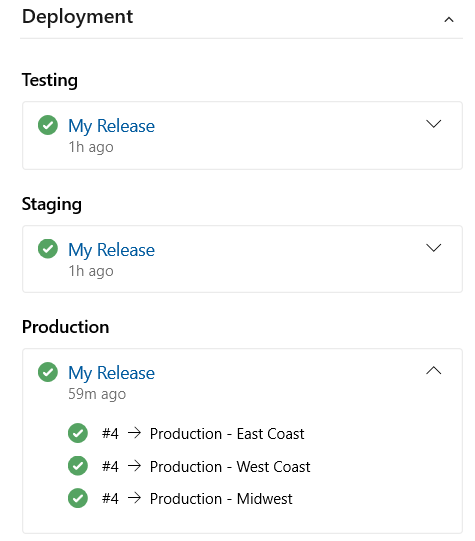

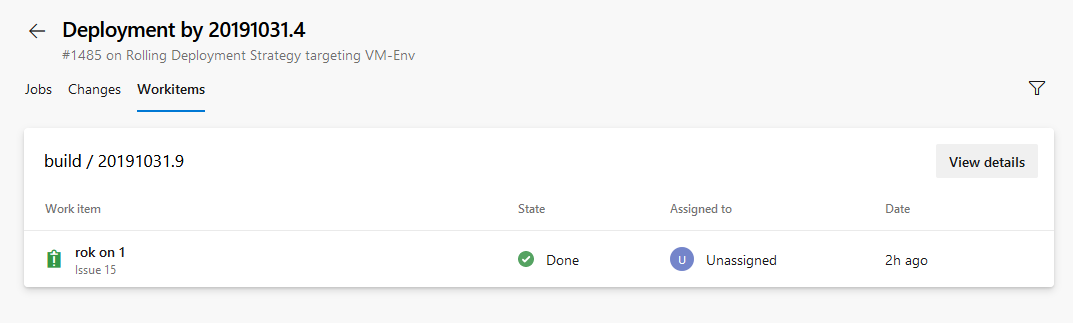

Lier des éléments de travail à des déploiements

Nous sommes ravis de publier le contrôle de déploiement sur le formulaire d’élément de travail. Ce contrôle lie vos éléments de travail à une mise en production et vous permet de suivre facilement où votre élément de travail a été déployé. Pour en savoir plus, consultez la documentation ici.

Importer des éléments de travail à partir d’un fichier CSV

Jusqu’à présent, l’importation d’éléments de travail à partir d’un fichier CSV dépendait de l’utilisation du plug-in Excel. Dans cette mise à jour, nous fournissons une expérience d’importation de première classe directement à partir de Azure Boards afin que vous puissiez importer de nouveaux éléments de travail ou mettre à jour des éléments de travail existants. Pour plus d’informations, consultez la documentation ici.

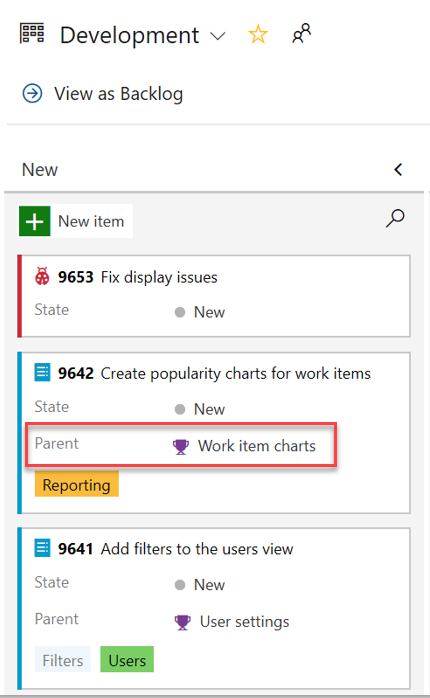

Ajouter un champ parent aux cartes d’élément de travail

Le contexte parent est désormais disponible dans votre tableau Kanban en tant que nouveau champ pour les cartes d’éléments de travail. Vous pouvez maintenant ajouter le champ Parent à vos cartes, en contournant la nécessité d’utiliser des solutions de contournement telles que des balises et des préfixes.

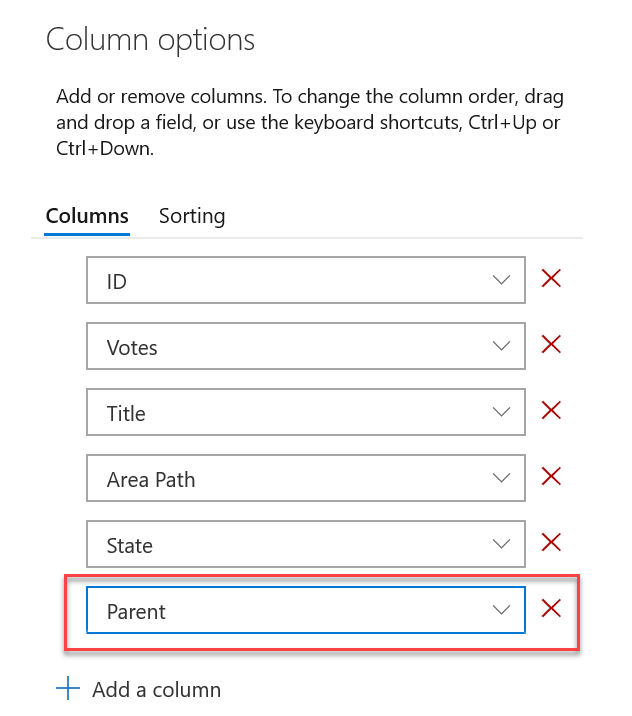

Ajouter un champ parent au backlog et aux requêtes

Le champ parent est désormais disponible lors de l’affichage des backlogs et des résultats de requête. Pour ajouter le champ parent, utilisez la vue Options de colonne .

Repos

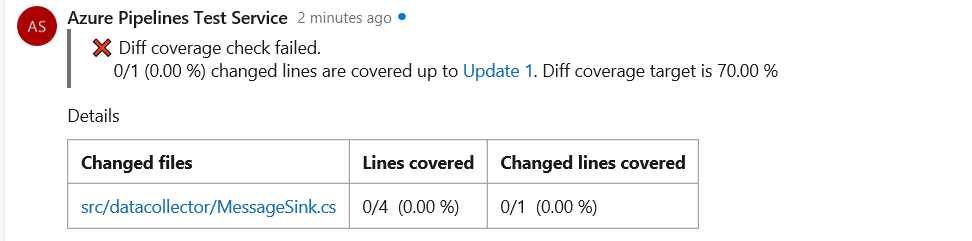

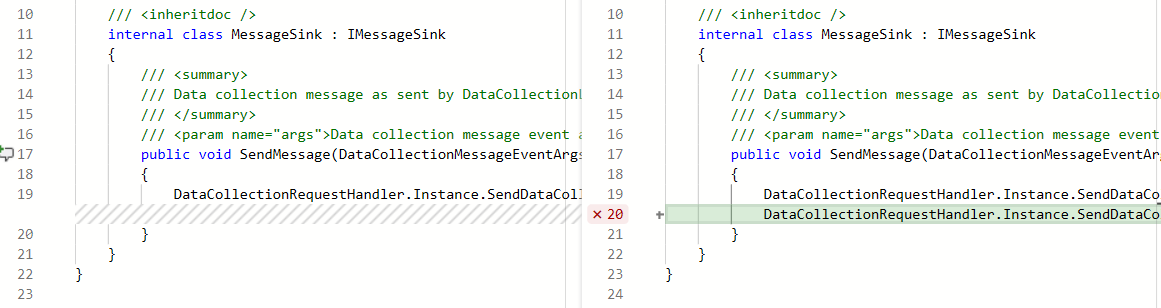

Métriques de couverture du code et stratégie de branche pour les demandes de tirage

Vous pouvez maintenant voir les métriques de couverture du code pour les modifications dans la vue des demandes de tirage (PR). Cela garantit que vous avez correctement testé vos modifications par le biais de tests automatisés. Les status de couverture s’affichent sous forme de commentaire dans la vue d’ensemble de la demande de tirage. Vous pouvez afficher les détails des informations de couverture pour chaque ligne de code modifiée dans la vue diff fichier.

En outre, les propriétaires de référentiels peuvent désormais définir des stratégies de couverture du code et empêcher la fusion de modifications importantes et non testées dans une branche. Les seuils de couverture souhaités peuvent être définis dans un azurepipelines-coverage.yml fichier de paramètres archivé à la racine du dépôt et la stratégie de couverture peut être définie à l’aide de la configuration existante d’une stratégie de branche pour les fonctionnalités de services supplémentaires dans Azure Repos.

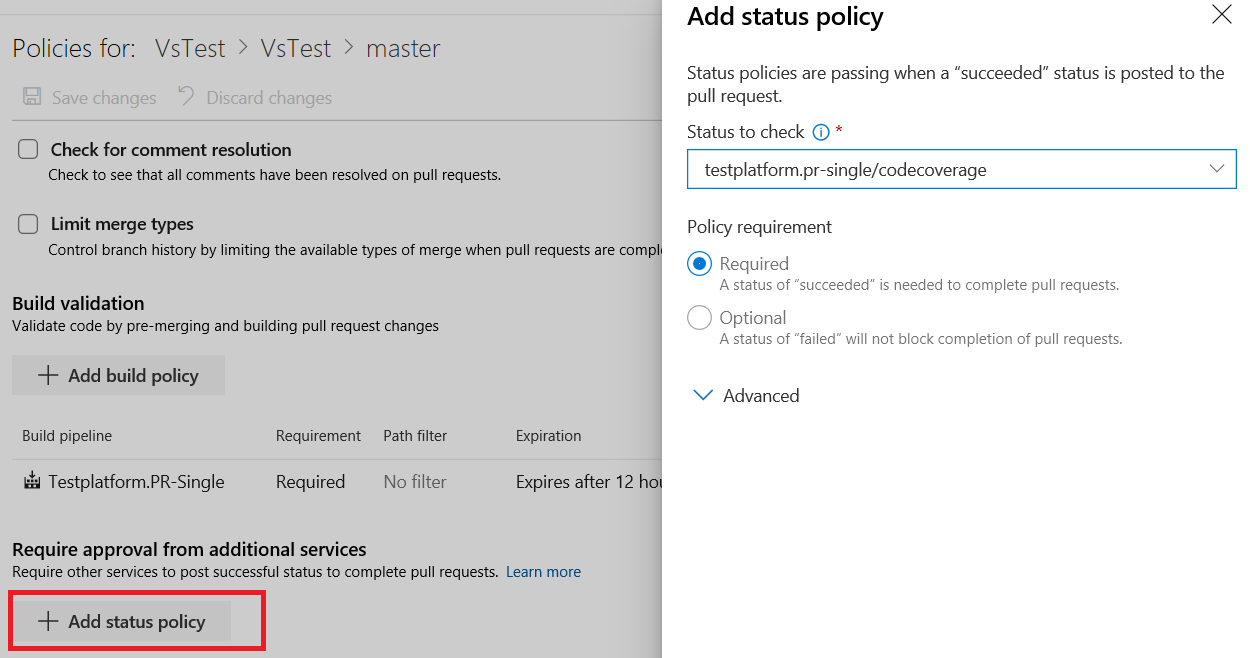

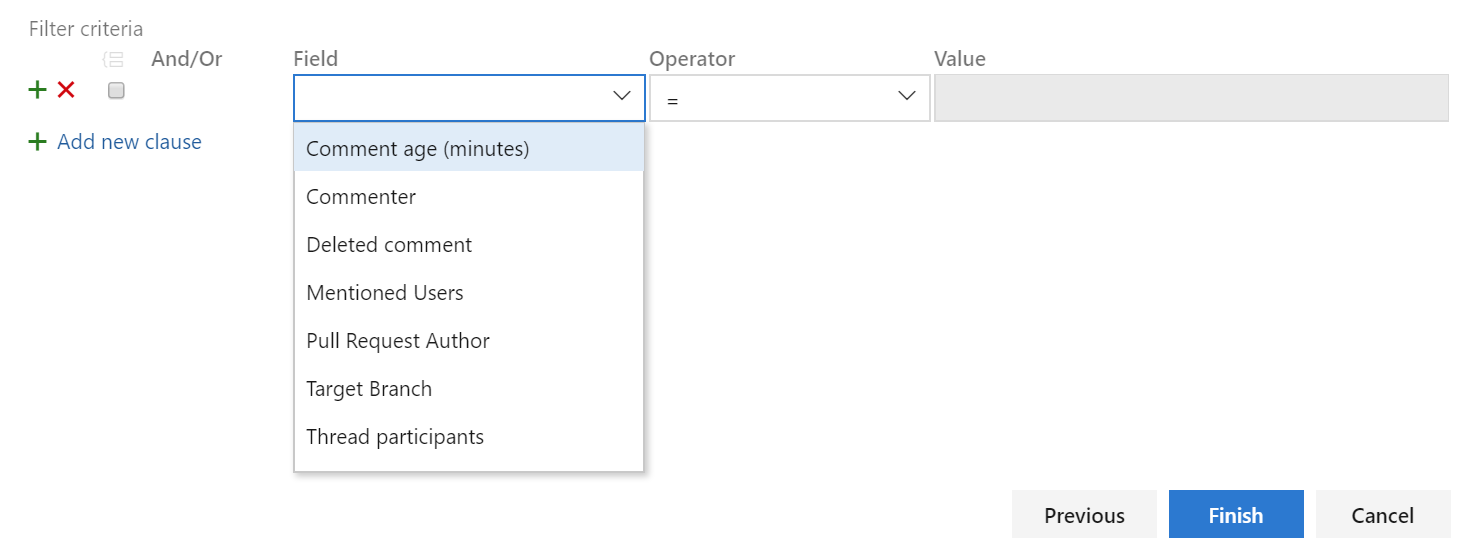

Filtrer les notifications de commentaires à partir des demandes de tirage

Les commentaires dans les demandes de tirage peuvent souvent générer beaucoup de bruit en raison des notifications. Nous avons ajouté un abonnement personnalisé qui vous permet de filtrer les notifications de commentaires auxquelles vous vous abonnez en fonction de l’âge du commentaire, du commentaire, du commentaire supprimé, des utilisateurs mentionnés, de l’auteur de la demande de tirage, de la branche cible et des participants au thread. Vous pouvez créer ces abonnements de notification en cliquant sur l’icône utilisateur dans le coin supérieur droit et en accédant à Paramètres utilisateur.

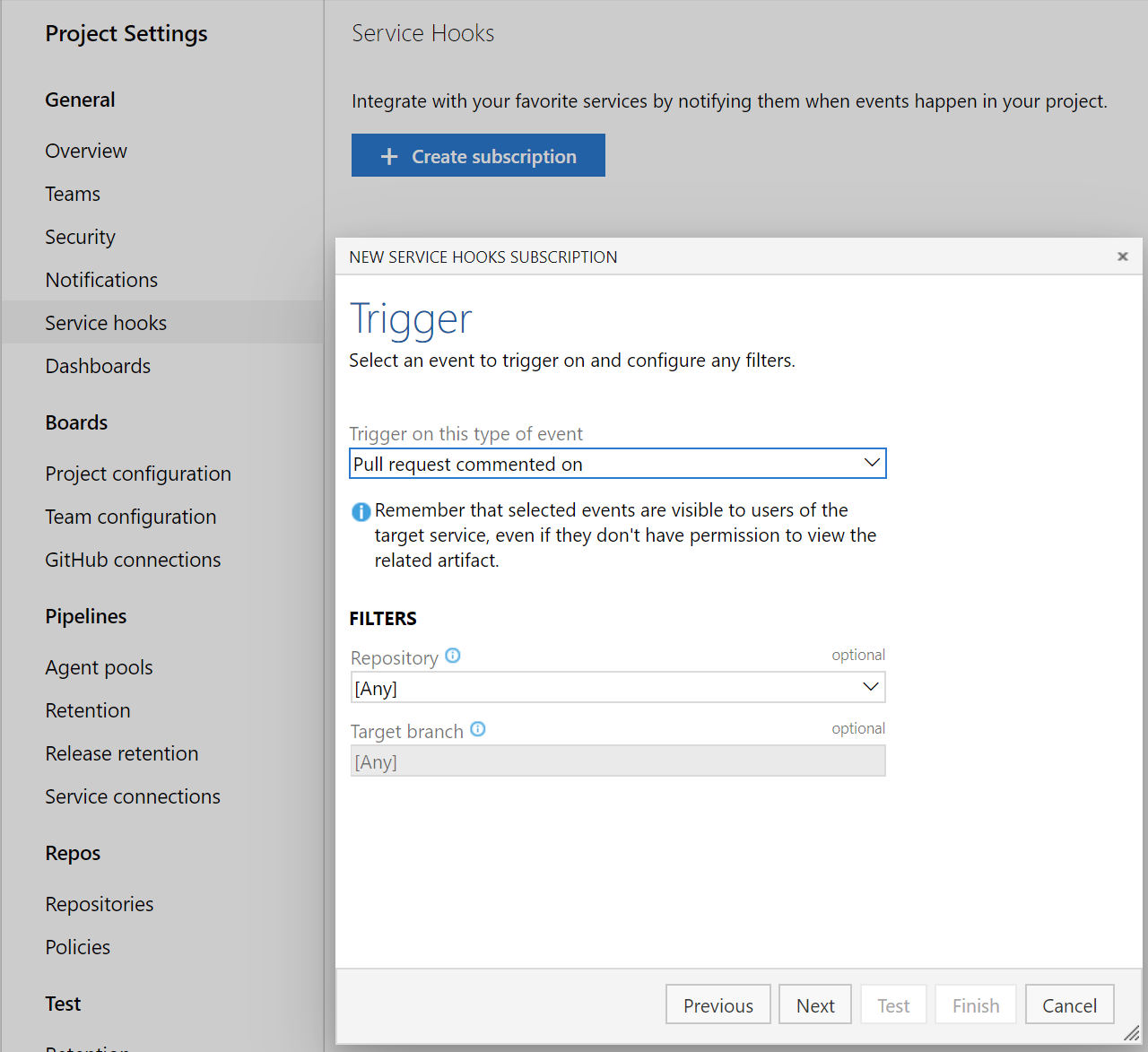

Hooks de service pour les commentaires de demande de tirage

Vous pouvez maintenant créer des hooks de service pour les commentaires dans une demande de tirage en fonction du dépôt et de la branche cible.

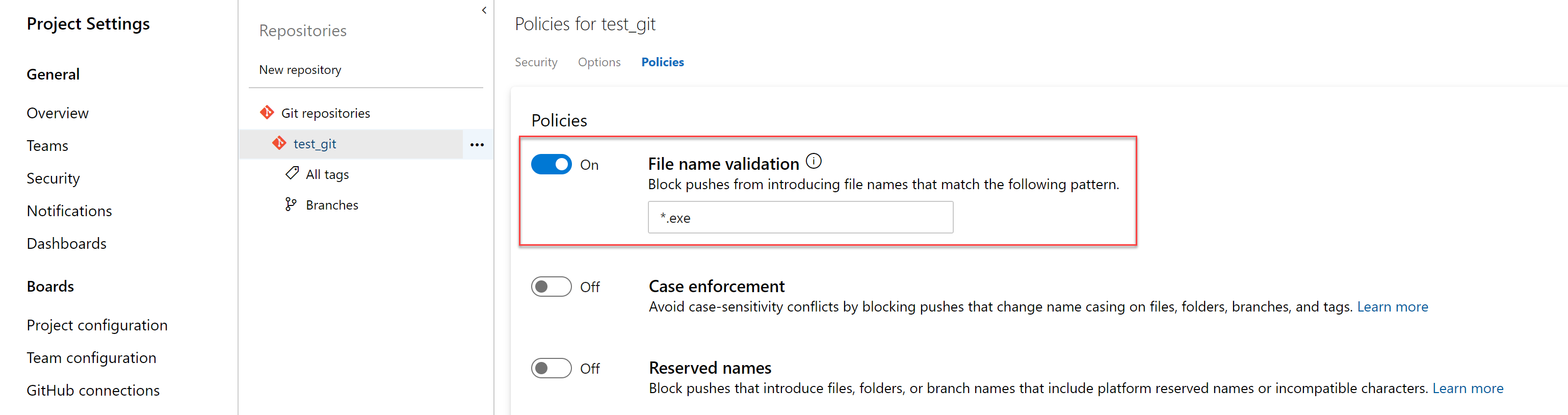

Stratégie de blocage des fichiers avec des modèles spécifiés

Les administrateurs peuvent désormais définir une stratégie pour empêcher les validations d’être envoyées à un dépôt en fonction des types de fichiers et des chemins d’accès. La stratégie de validation de nom de fichier bloque les envois (push) qui correspondent au modèle fourni.

Résoudre les éléments de travail via des commits à l’aide de mots clés

Vous pouvez maintenant résoudre les éléments de travail via des validations effectuées sur le branche par défaut à l’aide de mots clés tels que corriger, corriger ou corriger. Par exemple, vous pouvez écrire : « cette modification corrigée #476 » dans votre message de validation et l’élément de travail #476 sera terminé lorsque la validation est envoyée ou fusionnée dans le branche par défaut. Pour plus d’informations, consultez la documentation ici.

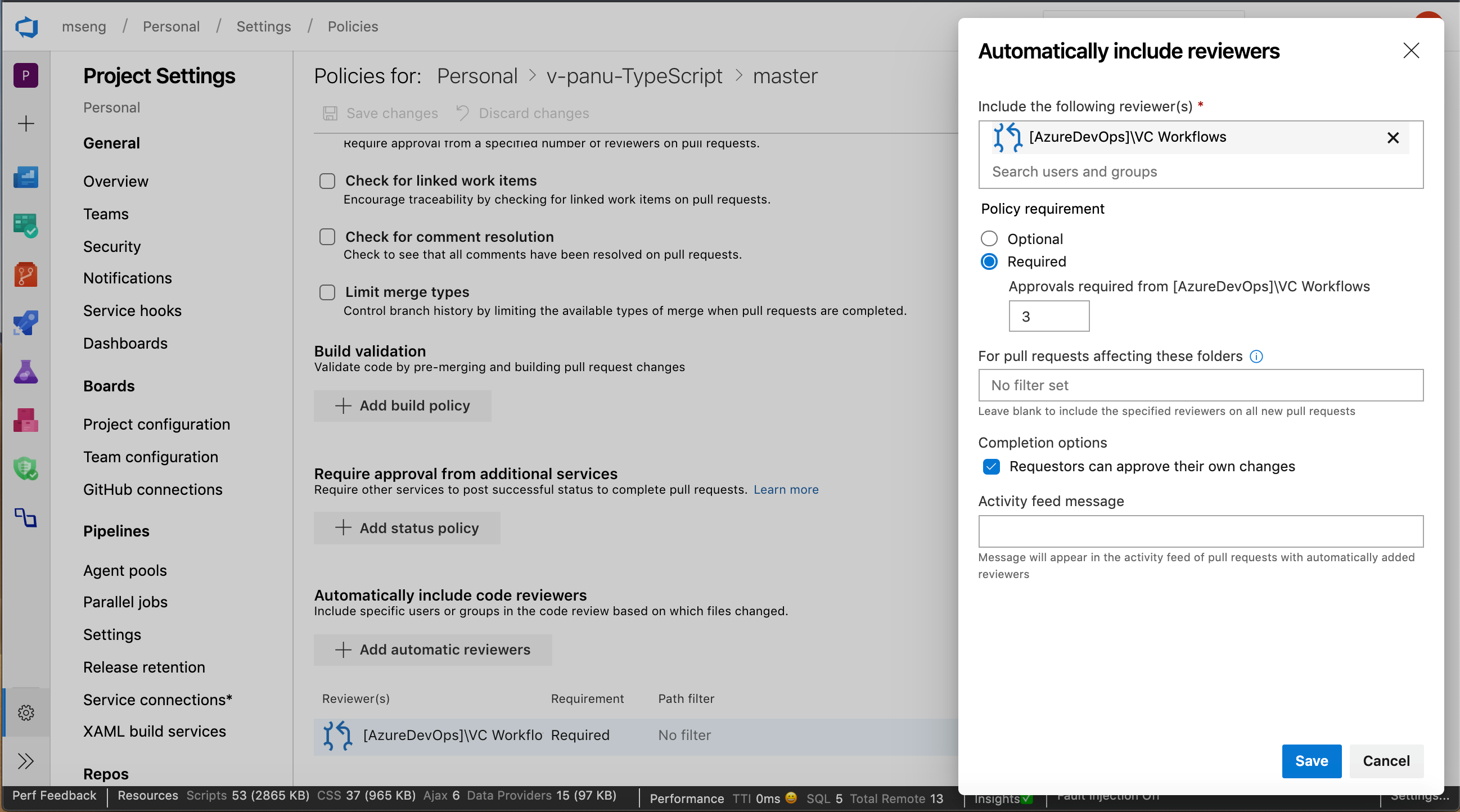

Granularité pour les réviseurs automatiques

Auparavant, lors de l’ajout de réviseurs au niveau du groupe à une demande de tirage, une seule approbation du groupe ajouté était requise. Vous pouvez maintenant définir des stratégies qui nécessitent plusieurs réviseurs d’une équipe pour approuver une demande de tirage lors de l’ajout de réviseurs automatiques. En outre, vous pouvez ajouter une stratégie pour empêcher les demandeurs d’approuver leurs propres modifications.

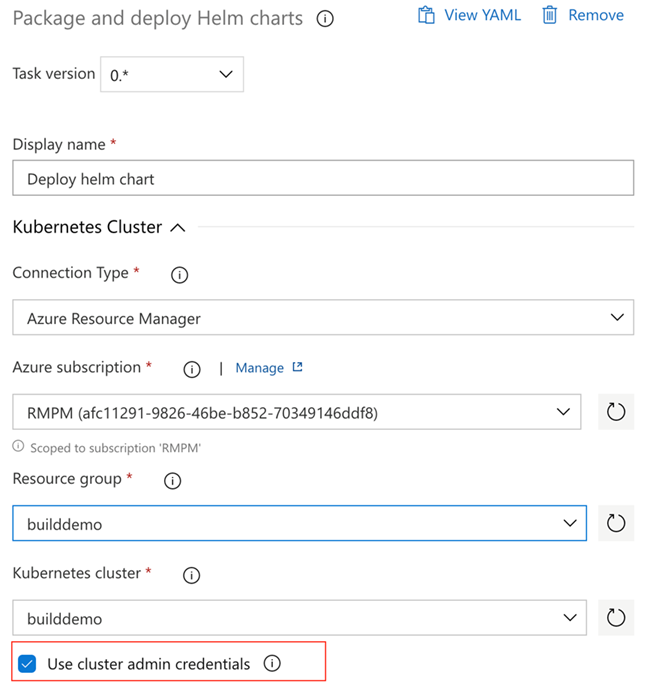

Utiliser l’authentification basée sur un compte de service pour se connecter à AKS

Auparavant, lors de la configuration d’Azure Pipelines à partir du centre de déploiement AKS, nous utilisions une connexion Azure Resource Manager. Cette connexion avait accès à l’ensemble du cluster et pas seulement à l’espace de noms pour lequel le pipeline a été configuré. Avec cette mise à jour, nos pipelines utiliseront l’authentification basée sur un compte de service pour se connecter au cluster afin qu’il ait uniquement accès à l’espace de noms associé au pipeline.

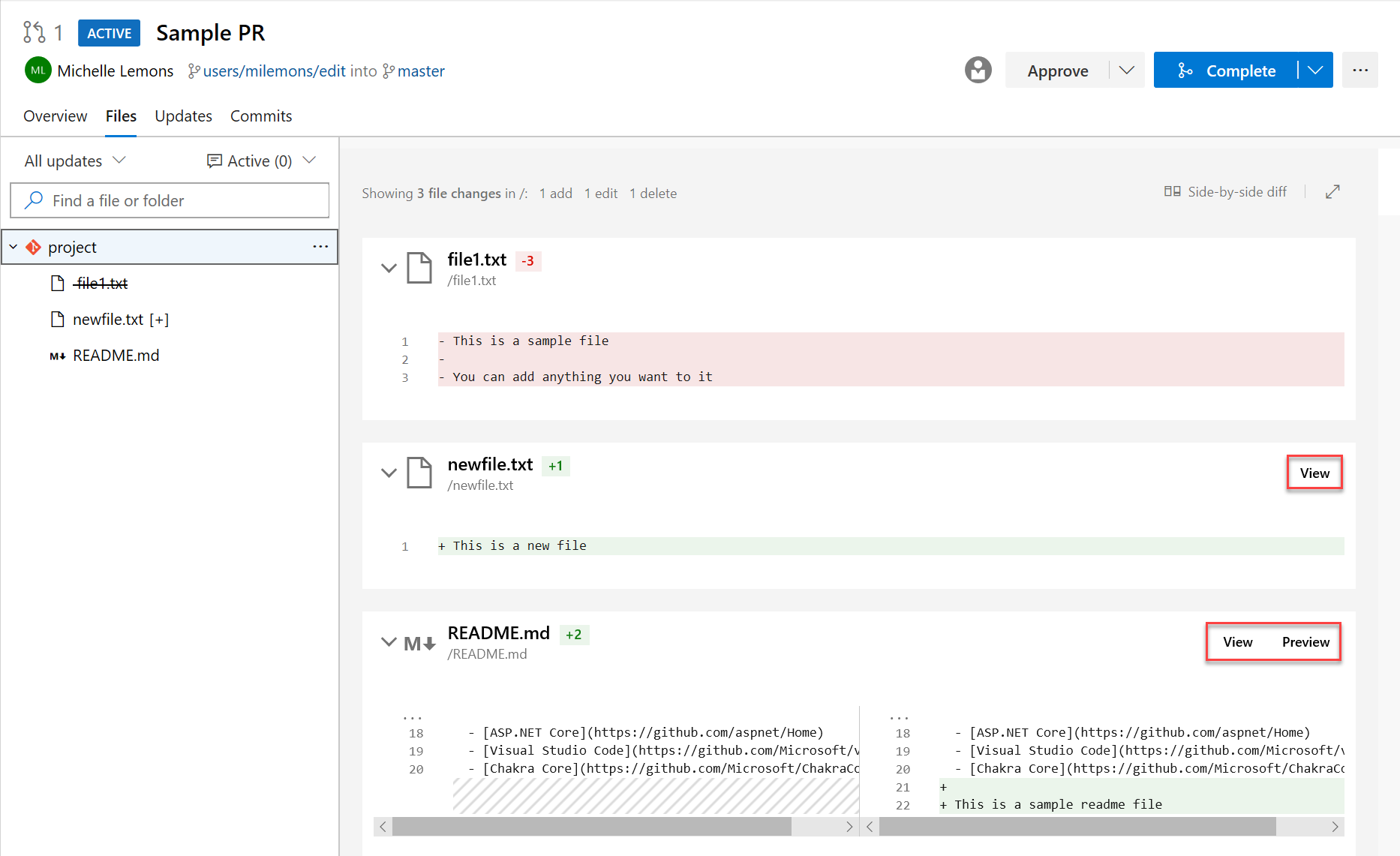

Aperçu des fichiers Markdown dans la demande de tirage côte à côte diff

Vous pouvez maintenant voir un aperçu de l’apparence d’un fichier markdown à l’aide du nouveau bouton Aperçu . En outre, vous pouvez voir le contenu complet d’un fichier à partir du diff côte à côte en sélectionnant le bouton Afficher.

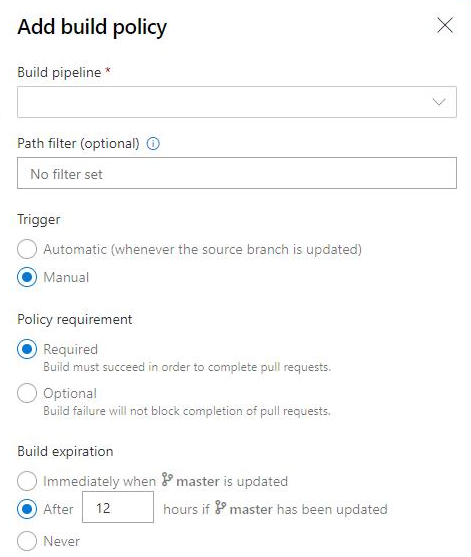

Expiration de la stratégie de génération pour les builds manuelles

Les stratégies appliquent les standards de qualité du code et de gestion des modifications de votre équipe. Auparavant, vous pouviez définir des stratégies d’expiration de build pour les builds automatisées. Maintenant, vous pouvez également définir des stratégies d’expiration de build pour vos builds manuelles.

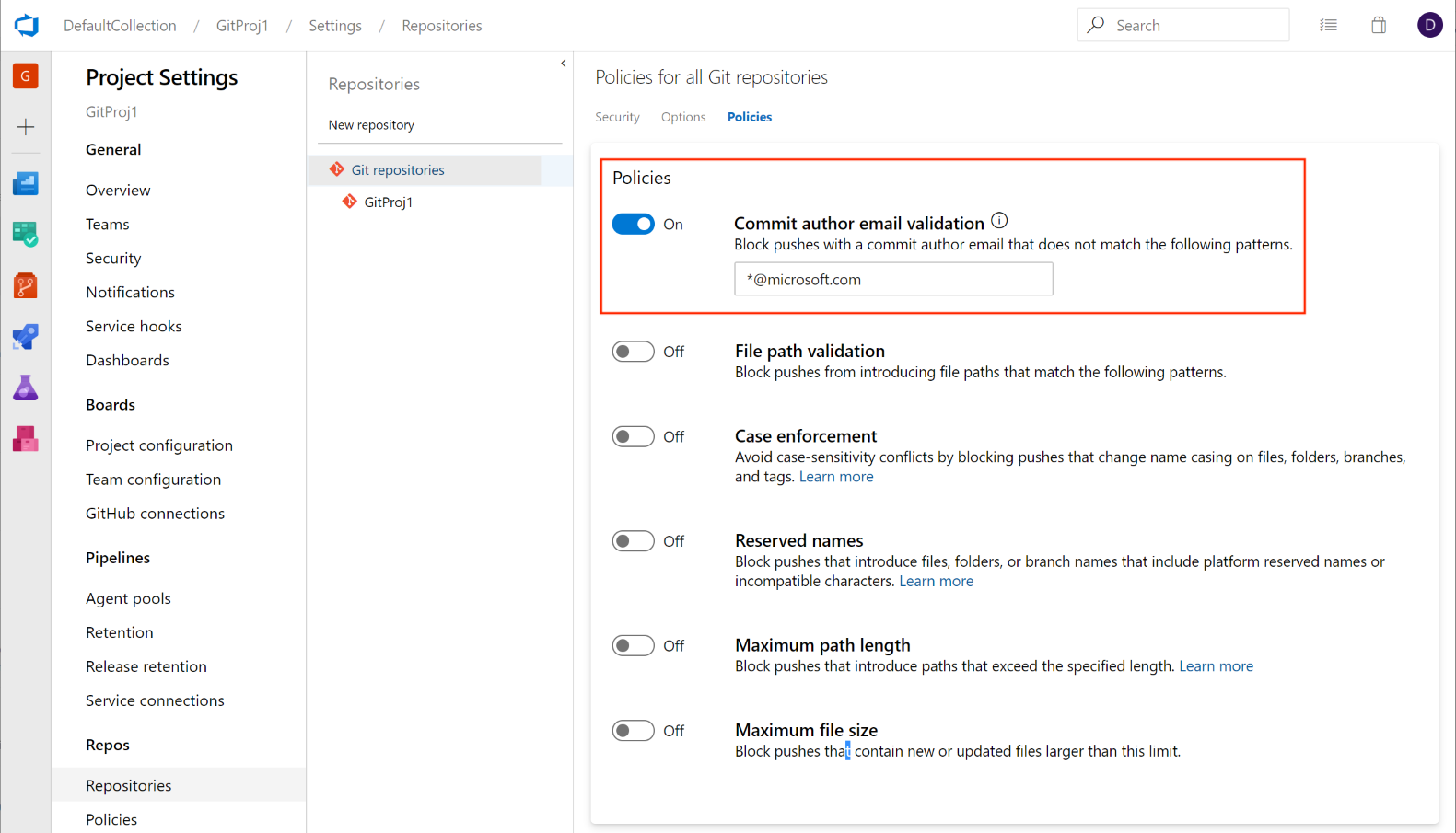

Ajouter une stratégie pour bloquer les validations en fonction de l’e-mail de l’auteur de la validation

Les administrateurs peuvent désormais définir une stratégie push pour empêcher les validations d’être envoyées à un dépôt pour lequel l’e-mail de l’auteur de la validation ne correspond pas au modèle fourni.

Cette fonctionnalité a été hiérarchisée en fonction d’une suggestion du Developer Community pour offrir une expérience similaire. Nous continuerons à garder le ticket ouvert et à encourager les utilisateurs à nous indiquer les autres types de stratégies push que vous souhaitez voir.

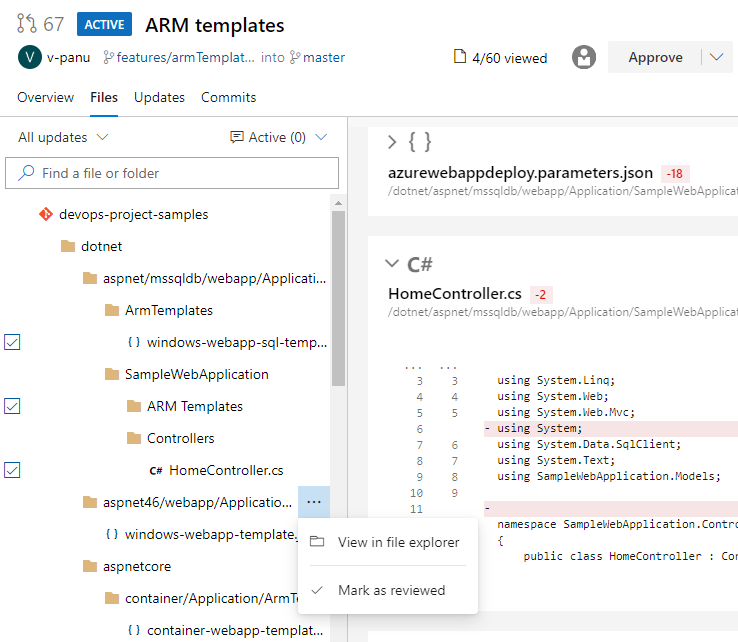

Marquer les fichiers comme révisés dans une demande de tirage

Parfois, vous devez passer en revue les demandes de tirage qui contiennent des modifications apportées à un grand nombre de fichiers et il peut être difficile de suivre les fichiers que vous avez déjà examinés. Vous pouvez maintenant marquer les fichiers comme étant examinés dans une demande de tirage.

Vous pouvez marquer un fichier comme étant révisé à l’aide du menu déroulant en regard d’un nom de fichier ou en pointant et en cliquant sur le nom du fichier.

Notes

Cette fonctionnalité est uniquement destinée à suivre votre progression lorsque vous passez en revue une demande de tirage. Il ne représente pas le vote sur les demandes de tirage. Ces marques ne seront visibles que par le réviseur.

Cette fonctionnalité a été hiérarchisée en fonction d’une suggestion du Developer Community.

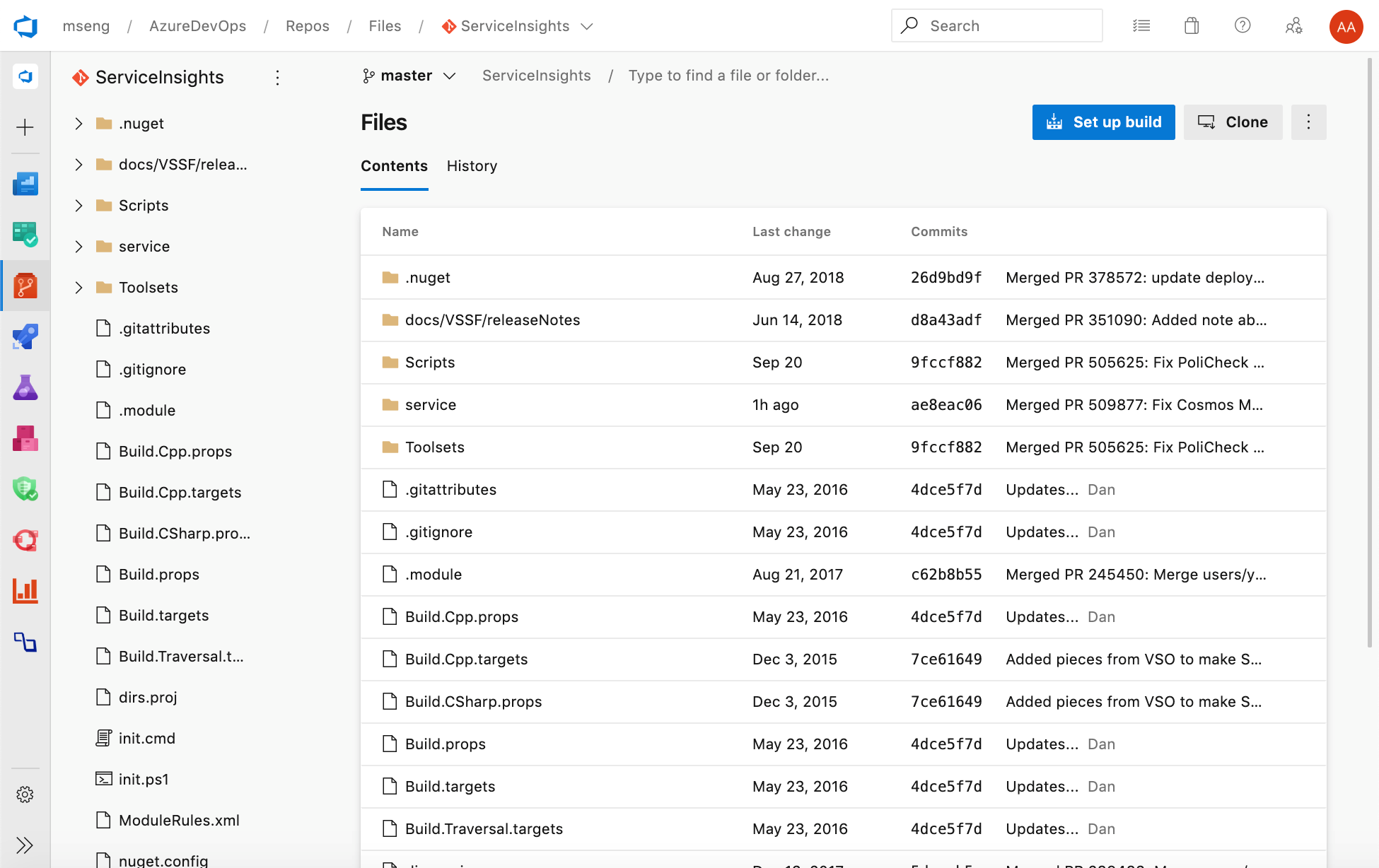

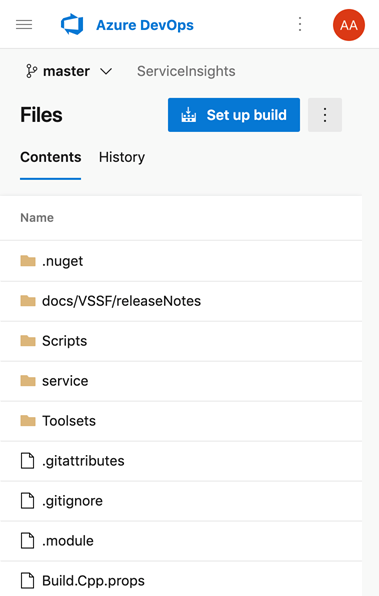

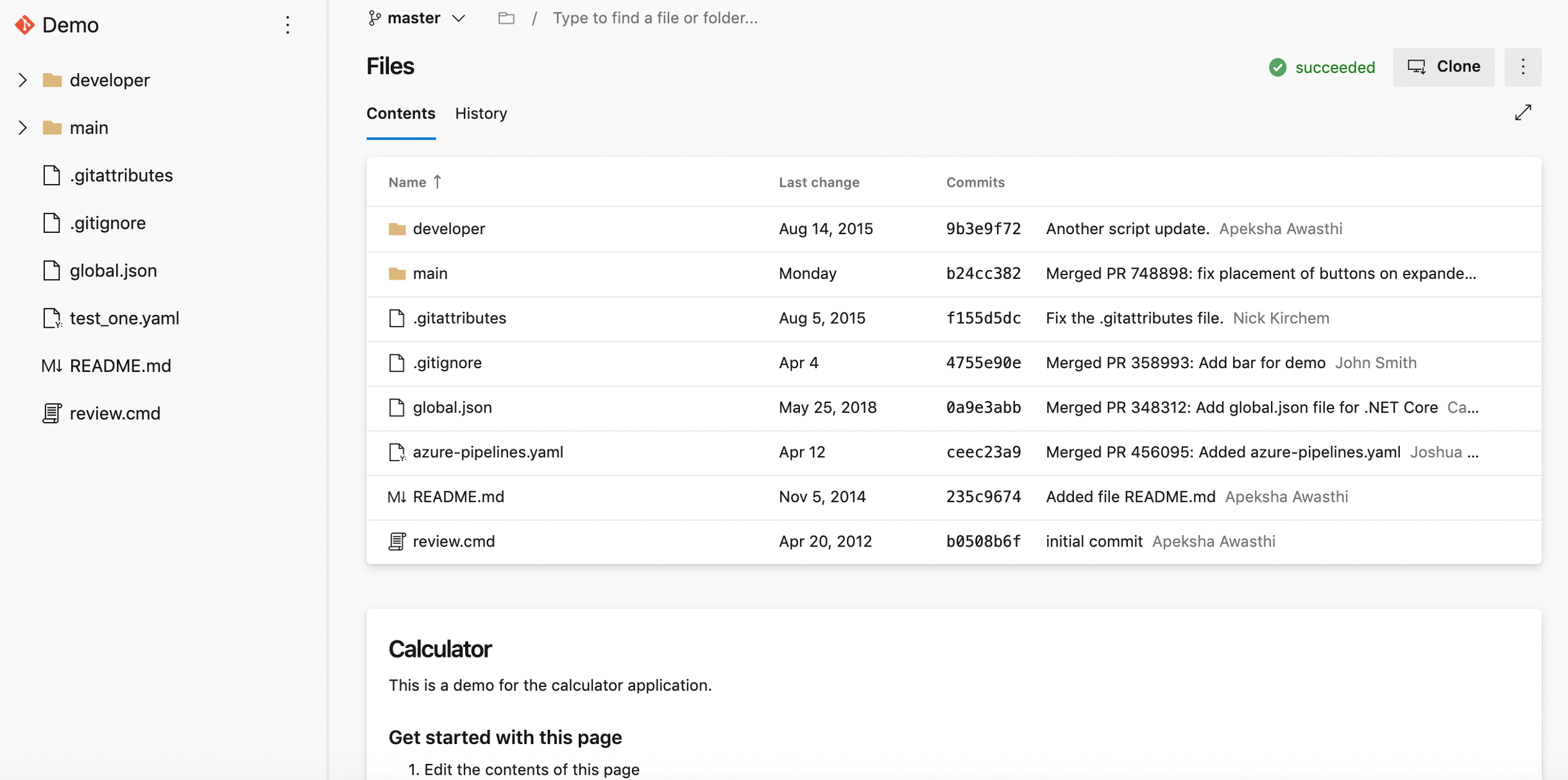

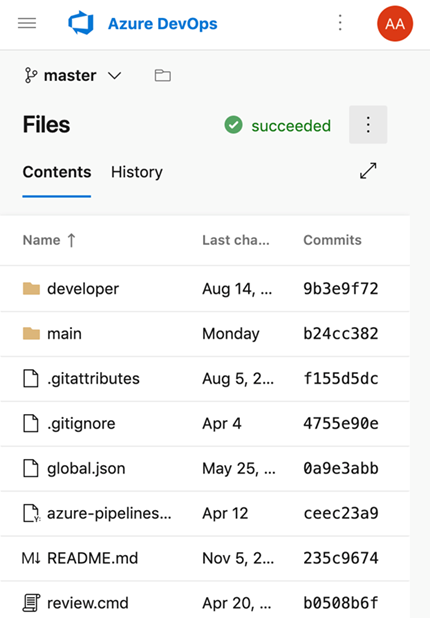

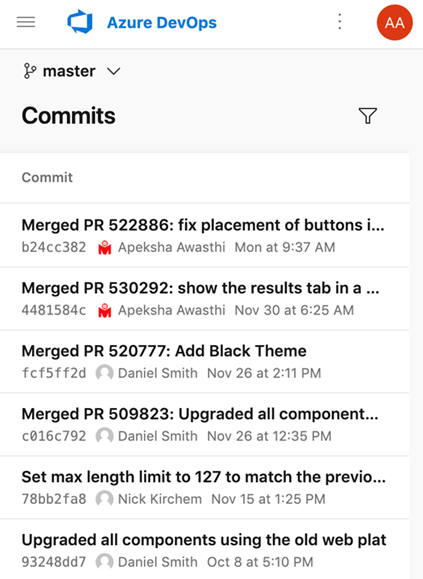

Nouvelle interface utilisateur web pour Azure Repos pages d’accueil

Vous pouvez maintenant essayer nos nouvelles pages d’accueil modernes, rapides et conviviales pour les mobiles dans Azure Repos. Ces pages sont disponibles en tant que pages d’accueil New Repos. Les pages d’accueil incluent toutes les pages à l’exception des détails de la demande de tirage, des détails de validation et de la comparaison des branches.

Web

Mobile

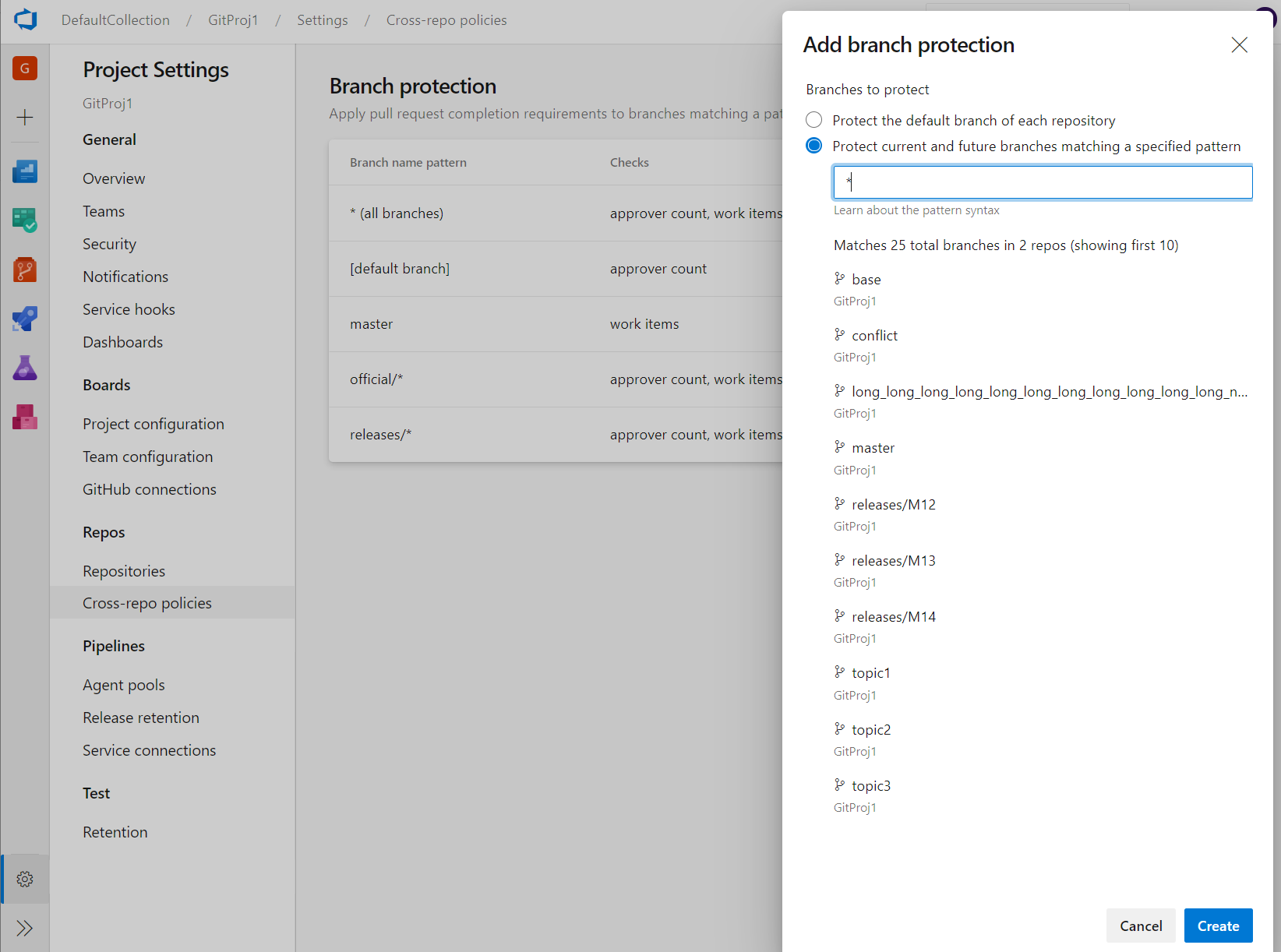

Administration de la stratégie de branche interpo

Les stratégies de branche sont l’une des fonctionnalités puissantes de Azure Repos qui vous aident à protéger les branches importantes. Bien que la possibilité de définir des stratégies au niveau du projet existe dans l’API REST, il n’y avait pas d’interface utilisateur pour celle-ci. Désormais, les administrateurs peuvent définir des stratégies sur une branche spécifique ou le branche par défaut sur tous les dépôts de leur projet. Par exemple, un administrateur peut exiger deux réviseurs minimum pour toutes les demandes de tirage effectuées dans chaque branche main dans chaque dépôt de son projet. Vous trouverez la fonctionnalité Ajouter une protection de branche dans les paramètres du projet Repos.

Nouvelles pages d’accueil de conversion de plateforme web

Nous avons mis à jour l’expérience utilisateur des pages d’accueil Repos pour la rendre moderne, rapide et adaptée aux mobiles. Voici deux exemples de pages qui ont été mises à jour. Nous continuerons à mettre à jour d’autres pages dans les mises à jour ultérieures.

Expérience web :

Expérience mobile :

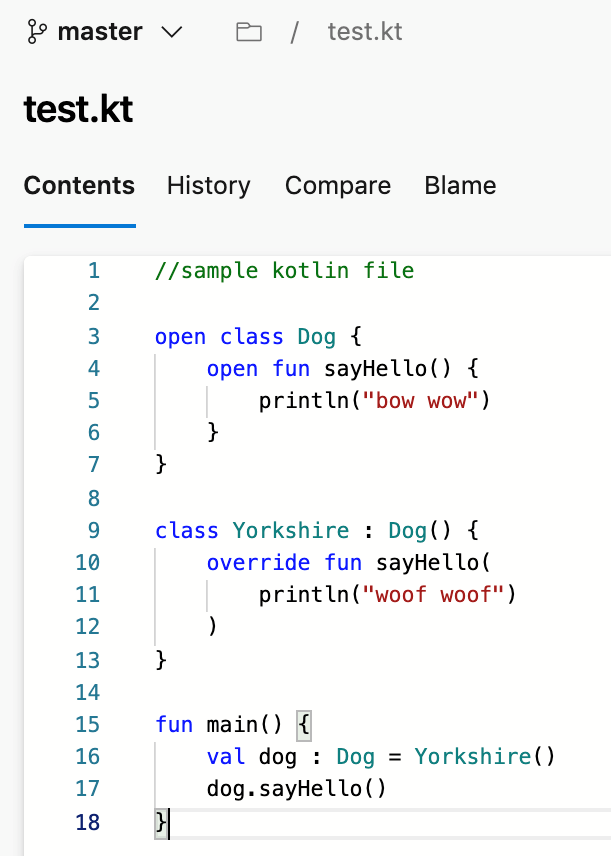

Prise en charge du langage Kotlin

Nous sommes heureux d’annoncer que nous prenons désormais en charge la mise en surbrillance de la langue Kotlin dans l’éditeur de fichiers. La mise en surbrillance améliore la lisibilité de votre fichier texte Kotlin et vous aide à analyser rapidement pour rechercher les erreurs. Nous avons hiérarchisé cette fonctionnalité en fonction d’une suggestion du Developer Community.

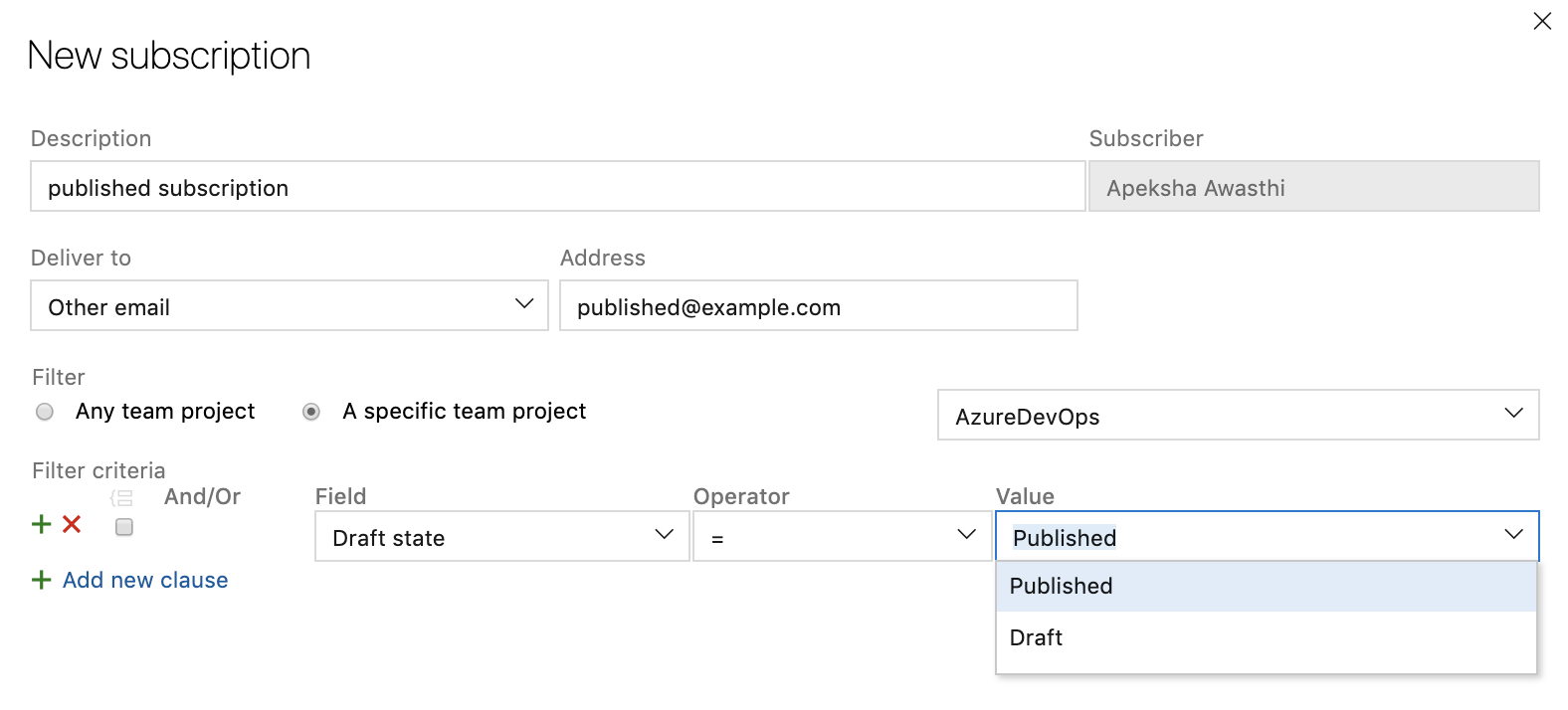

Abonnement aux notifications personnalisées pour les brouillons de demandes de tirage

Pour réduire le nombre de Notifications par e-mail des demandes de tirage, vous pouvez maintenant créer un abonnement de notification personnalisé pour les demandes de tirage créées ou mises à jour à l’état brouillon. Vous pouvez obtenir des e-mails spécifiquement pour les brouillons de demandes de tirage ou filtrer les e-mails des brouillons de demandes de tirage afin que votre équipe ne soit pas avertie avant que la demande de tirage soit prête à être examinée.

Amélioration de l’actionabilité des demandes de tirage

Lorsque vous avez de nombreuses demandes de tirage à examiner, il peut être difficile de comprendre où vous devez agir en premier. Pour améliorer l’action des demandes de tirage, vous pouvez maintenant créer plusieurs requêtes personnalisées sur la page de liste des demandes de tirage avec plusieurs nouvelles options à filtrer par exemple l’état brouillon. Ces requêtes créent des sections distinctes et réductibles sur votre page de demande de tirage, en plus de « Créé par moi » et « Attribué à moi ». Vous pouvez également refuser d’examiner une demande de tirage à laquelle vous avez été ajouté via le menu Vote ou le menu contextuel de la page de liste de demandes de tirage. Dans les sections personnalisées, vous voyez maintenant des onglets distincts pour les demandes de tirage sur lesquelles vous avez fourni une révision ou que vous avez refusé de vérifier. Ces requêtes personnalisées fonctionnent entre les référentiels sous l’onglet « Mes demandes de tirage » de la page d’accueil de la collection. Si vous souhaitez revenir à une demande de tirage, vous pouvez la marquer et elles s’afficheront en haut de votre liste. Enfin, les demandes de tirage qui ont été définies sur la saisie semi-automatique seront marquées d’une pilule indiquant « Saisie semi-automatique » dans la liste.

Pipelines

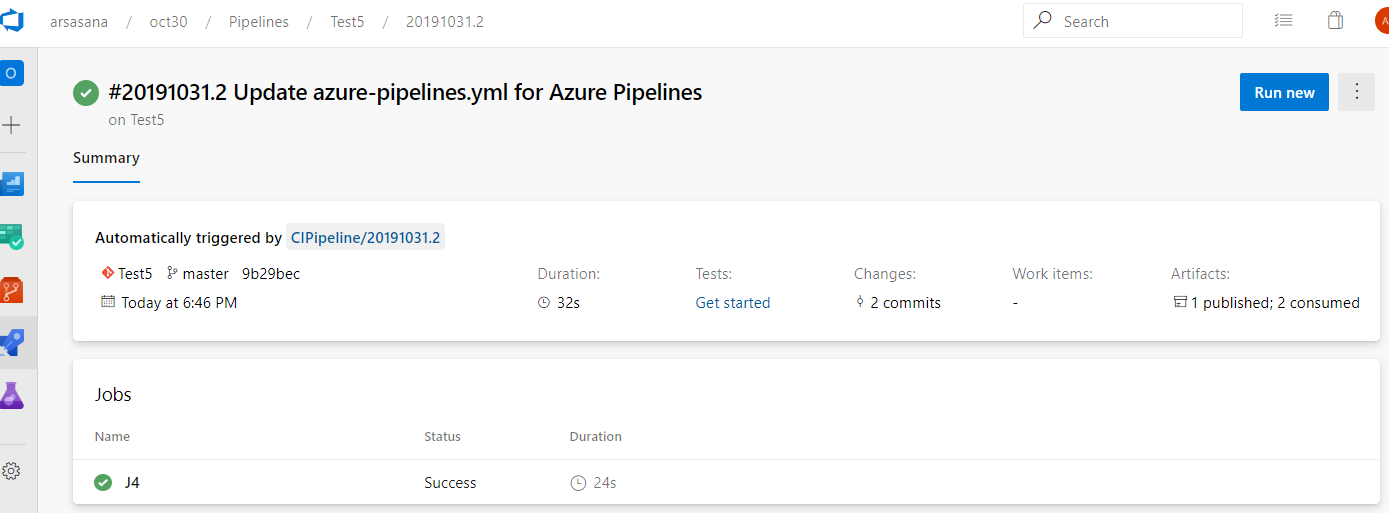

Pipelines à plusieurs étapes

Nous avons travaillé sur une expérience utilisateur mise à jour pour gérer vos pipelines. Ces mises à jour rendent les pipelines modernes et cohérents avec l’orientation d’Azure DevOps. En outre, ces mises à jour regroupent des pipelines de build classiques et des pipelines YAML à plusieurs étapes dans une expérience unique. Il est adapté aux mobiles et apporte diverses améliorations à la façon dont vous gérez vos pipelines. Vous pouvez explorer et afficher les détails du pipeline, les détails de l’exécution, l’analyse du pipeline, les détails du travail, les journaux et bien plus encore.

Les fonctionnalités suivantes sont incluses dans la nouvelle expérience :

- affichage et gestion de plusieurs étapes

- approbation des exécutions de pipeline

- faire défiler tout le chemin dans les journaux pendant qu’un pipeline est toujours en cours

- Intégrité par branche d’un pipeline.

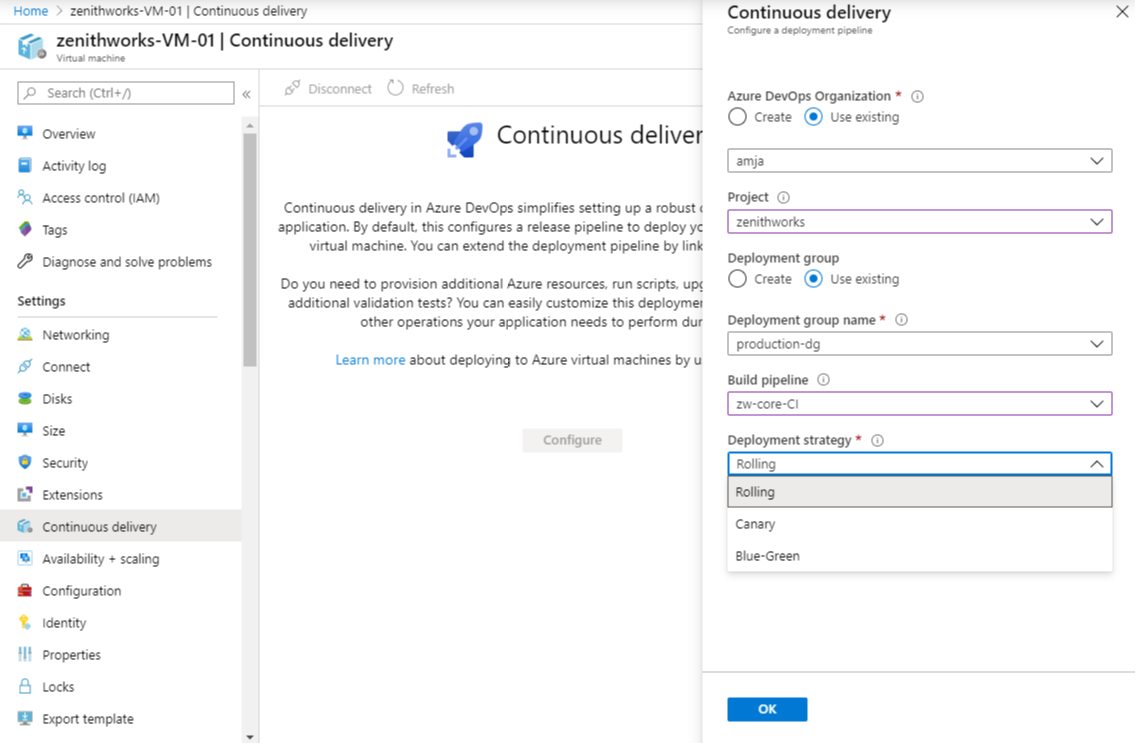

Déploiement continu dans YAML

Nous sommes ravis de fournir des fonctionnalités DE CD YAML Azure Pipelines. Nous offrons désormais une expérience YAML unifiée afin que vous puissiez configurer chacun de vos pipelines pour effectuer ci, CD ou CI et CD ensemble. Les fonctionnalités CD YAML introduisent plusieurs nouvelles fonctionnalités avancées qui sont disponibles pour toutes les collections à l’aide de pipelines YAML à plusieurs étapes. Voici les principales :

- Pipelines YAML multiphases (pour CI et CD)

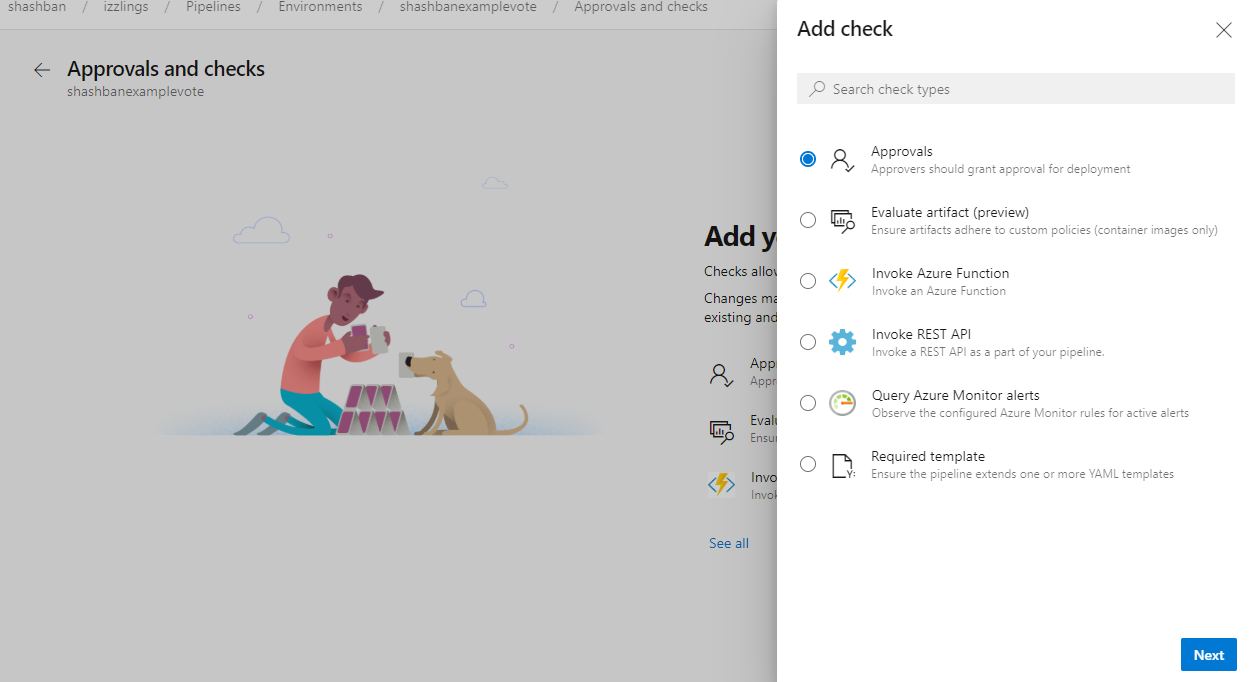

- Approbations et vérifications des ressources

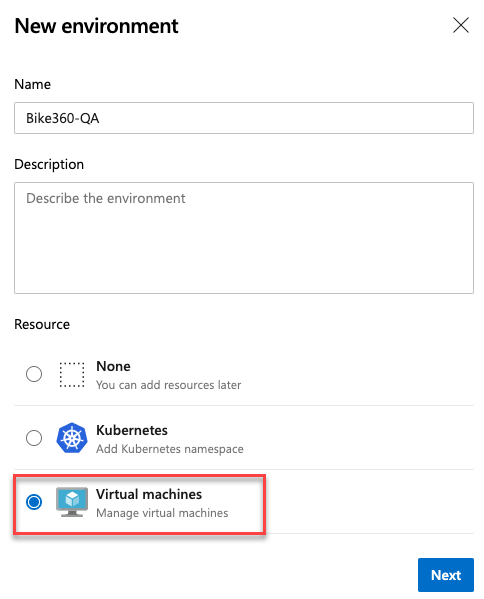

- Environnements et stratégies de déploiement

- Ressources Kubernetes et machine virtuelle dans l’environnement

- Passer en revue les applications pour la collaboration

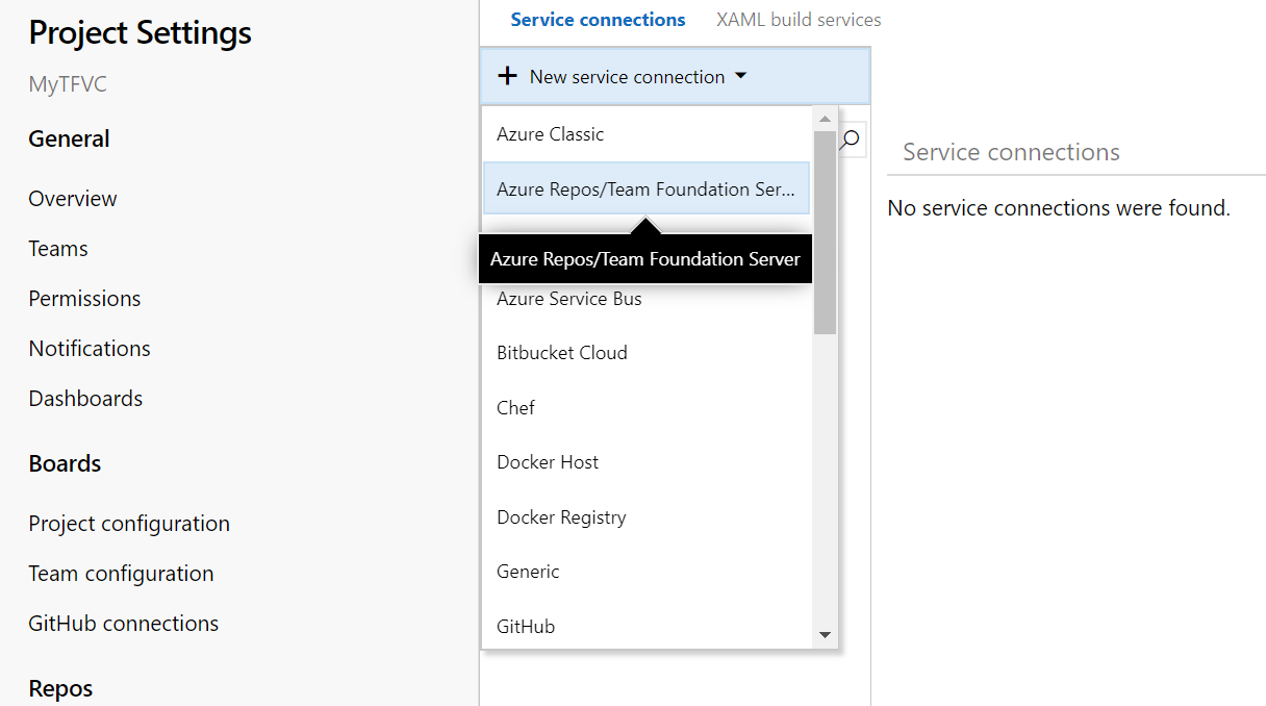

- Expérience utilisateur actualisée pour les connexions de service

- Ressources dans les pipelines YAML

Si vous êtes prêt à commencer à créer, case activée la documentation ou le blog pour la création de pipelines CI/CD à plusieurs étapes.

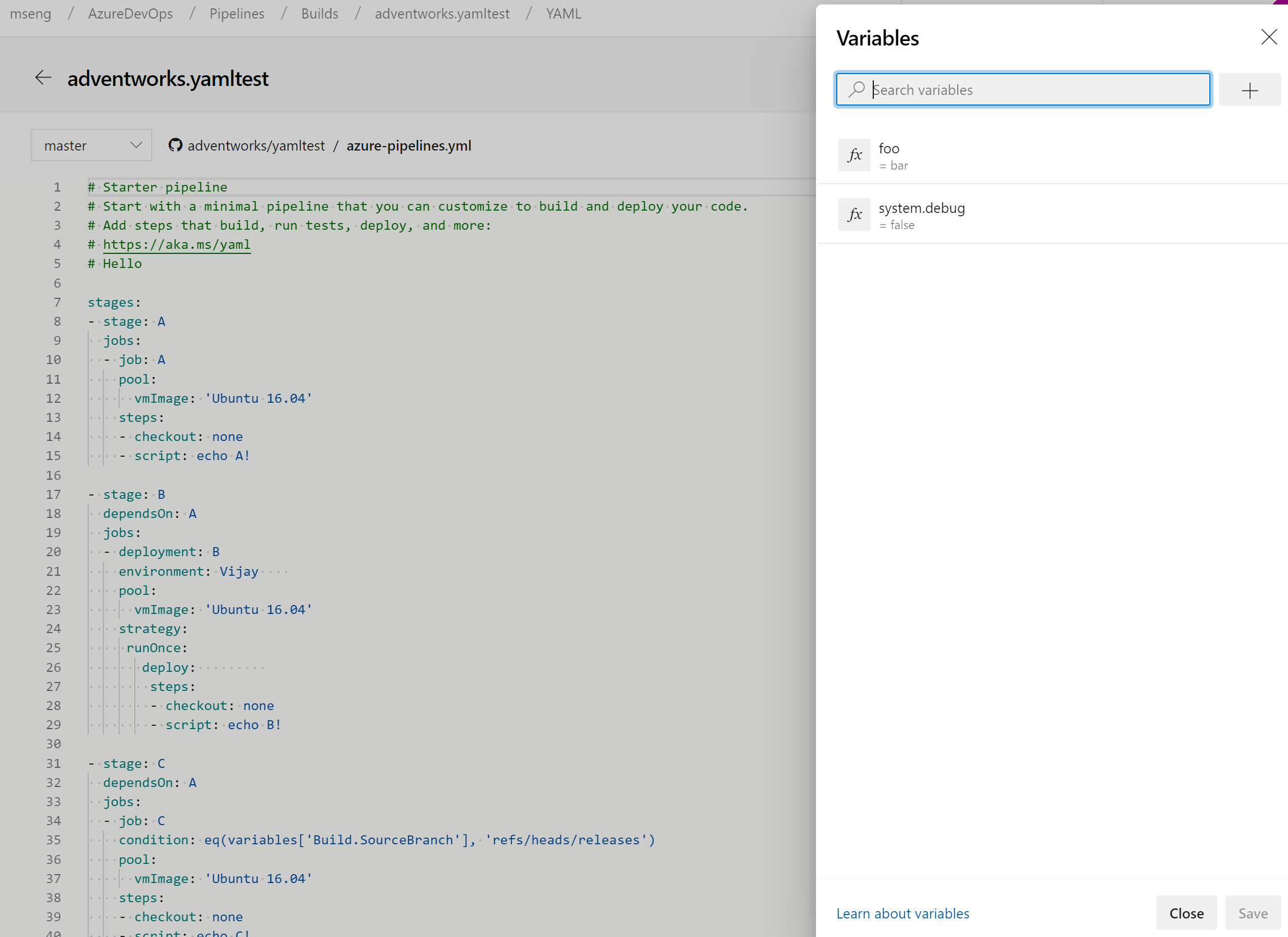

Gérer les variables de pipeline dans l’éditeur YAML

Nous avons mis à jour l’expérience de gestion des variables de pipeline dans l’éditeur YAML. Vous n’avez plus besoin d’accéder à l’éditeur classique pour ajouter ou mettre à jour des variables dans vos pipelines YAML.

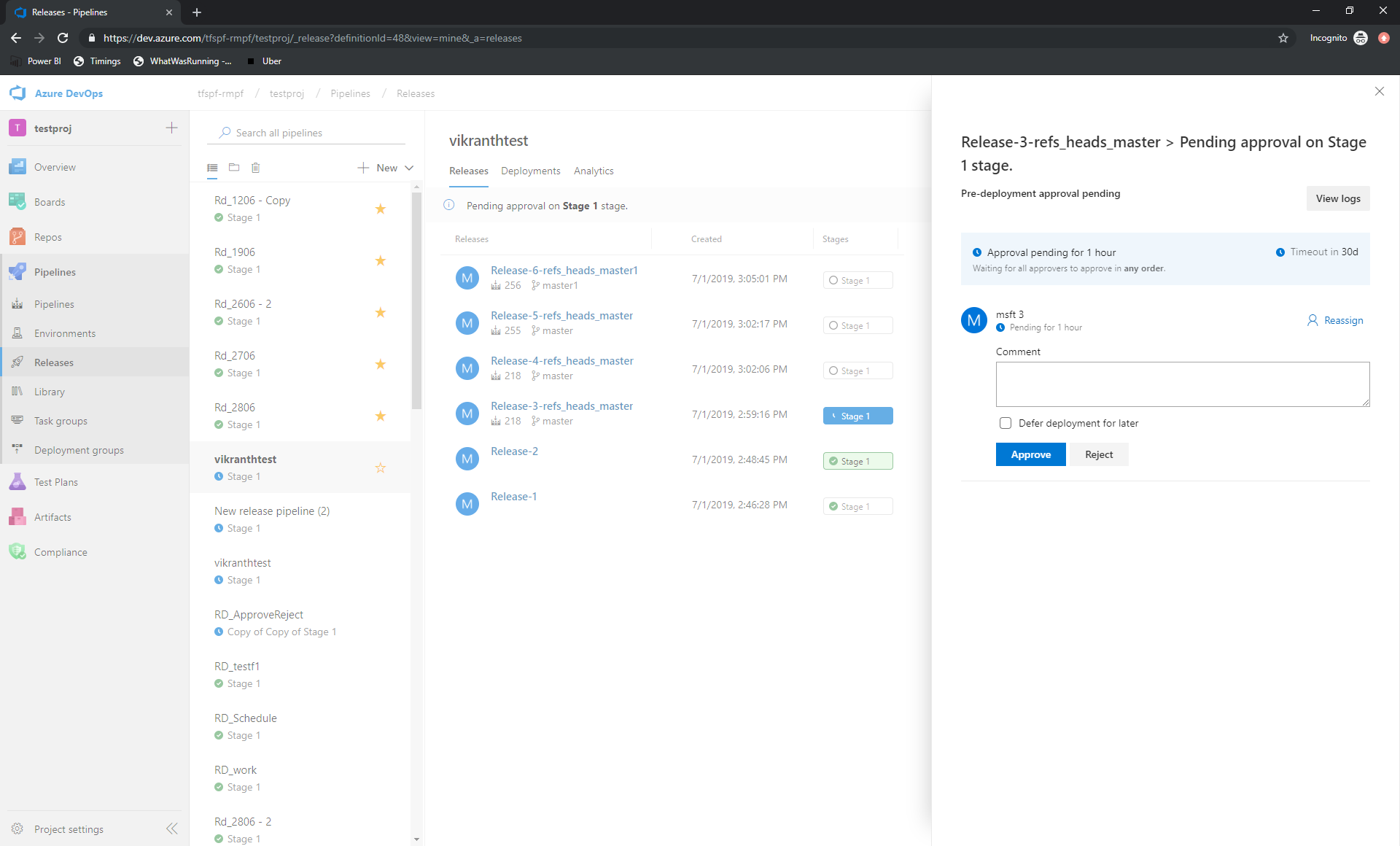

Approuver des mises en production directement à partir du hub Des mises en production

L’action sur les approbations en attente a été facilitée. Auparavant, il était possible d’approuver une version à partir de la page de détails de la version. Vous pouvez maintenant approuver les mises en production directement à partir du hub Mises en production.

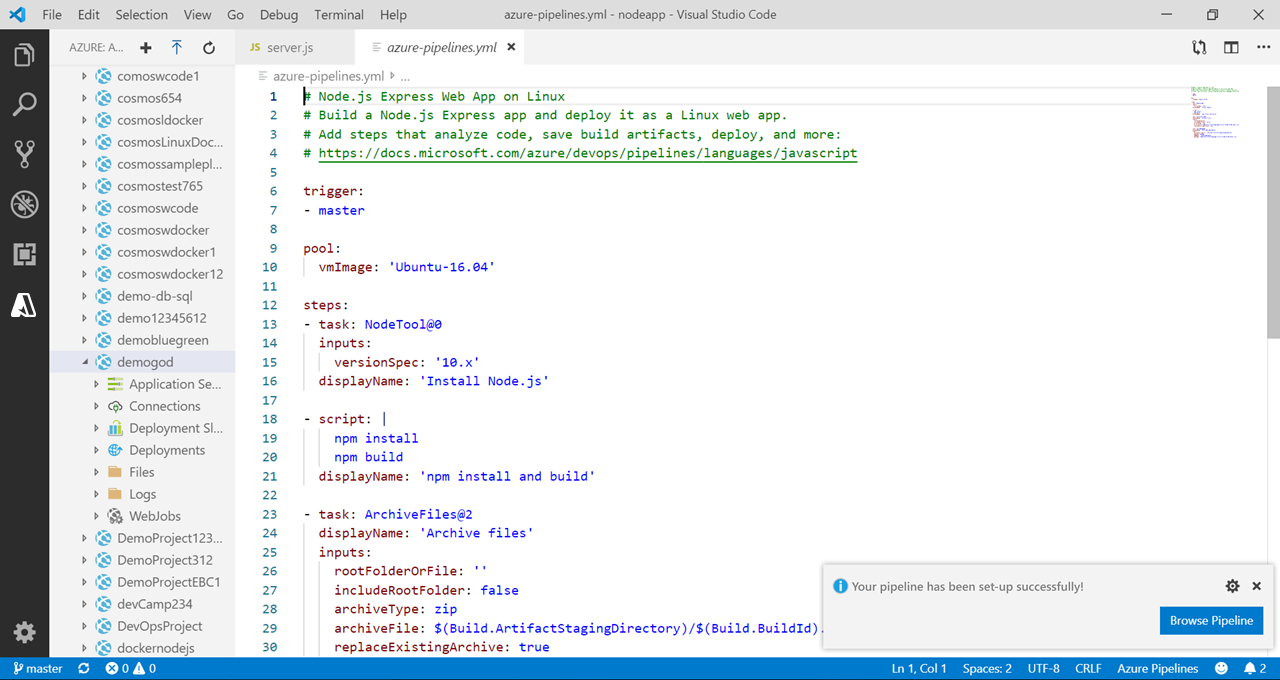

Améliorations apportées à la prise en main des pipelines

La possibilité de renommer le fichier généré est une question courante de l’Assistant de prise en main. Actuellement, il est archivé comme azure-pipelines.yml à la racine de votre dépôt. Vous pouvez maintenant mettre à jour ce nom de fichier ou un autre emplacement avant d’enregistrer le pipeline.

Enfin, vous aurez plus de contrôle lors de l’archivage du azure-pipelines.yml fichier dans une autre branche, car vous pouvez choisir d’ignorer la création d’une demande de tirage à partir de cette branche.

Afficher un aperçu d’un document YAML entièrement analysé sans valider ou exécuter le pipeline

Nous avons ajouté une préversion, mais nous n’avons pas le mode d’exécution pour les pipelines YAML. À présent, vous pouvez essayer un pipeline YAML sans le valider dans un dépôt ou l’exécuter. Étant donné un pipeline existant et une nouvelle charge utile YAML facultative, cette nouvelle API vous rendra le pipeline YAML complet. Dans les prochaines mises à jour, cette API sera utilisée dans une nouvelle fonctionnalité d’éditeur.

Pour les développeurs : POST vers dev.azure.com/<org>/<project>/_apis/pipelines/<pipelineId>/runs?api-version=5.1-preview avec un corps JSON comme suit :

{

"PreviewRun": true,

"YamlOverride": "

# your new YAML here, optionally

"

}

La réponse contient le YAML rendu.

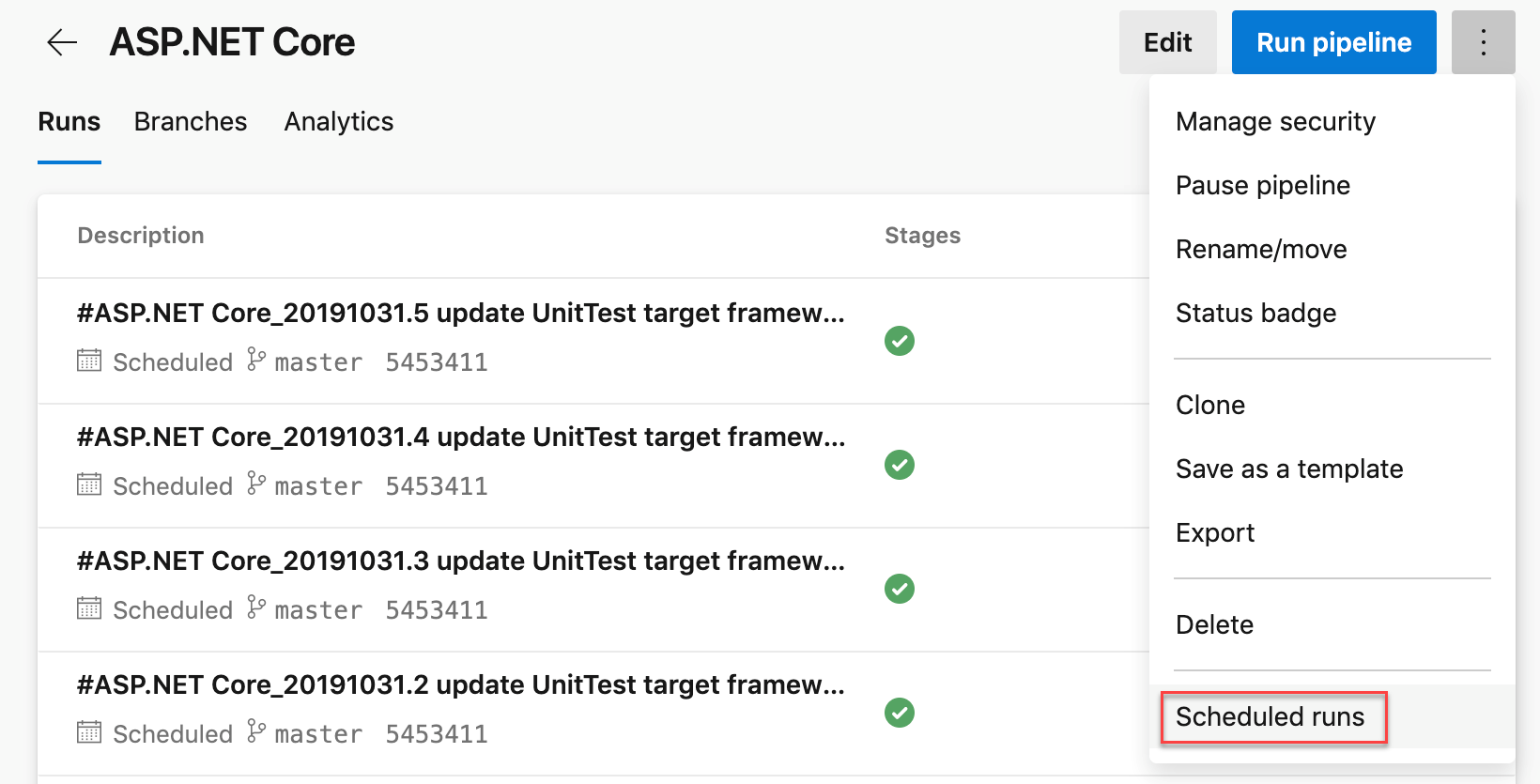

Planifications Cron dans YAML

Auparavant, vous pouviez utiliser l’éditeur d’interface utilisateur pour spécifier un déclencheur planifié pour les pipelines YAML. Avec cette version, vous pouvez planifier des builds à l’aide de la syntaxe cron dans votre fichier YAML et tirer parti des avantages suivants :

- Configuration en tant que code : vous pouvez suivre les planifications avec votre pipeline dans le cadre du code.

- Expressif : vous avez plus de pouvoir expressif dans la définition des planifications que ce que vous avez pu faire avec l’interface utilisateur. Pour instance, il est plus facile de spécifier une planification unique qui démarre une exécution toutes les heures.

- Standard du secteur : de nombreux développeurs et administrateurs sont déjà familiarisés avec la syntaxe cron.

schedules:

- cron: "0 0 * * *"

displayName: Daily midnight build

branches:

include:

- main

- releases/*

exclude:

- releases/ancient/*

always: true

Nous vous avons également permis de diagnostiquer facilement les problèmes liés aux planifications cron. Les exécutions planifiées dans le menu Exécuter le pipeline vous donnent un aperçu des quelques exécutions planifiées à venir pour votre pipeline afin de vous aider à diagnostiquer les erreurs avec vos planifications cron.

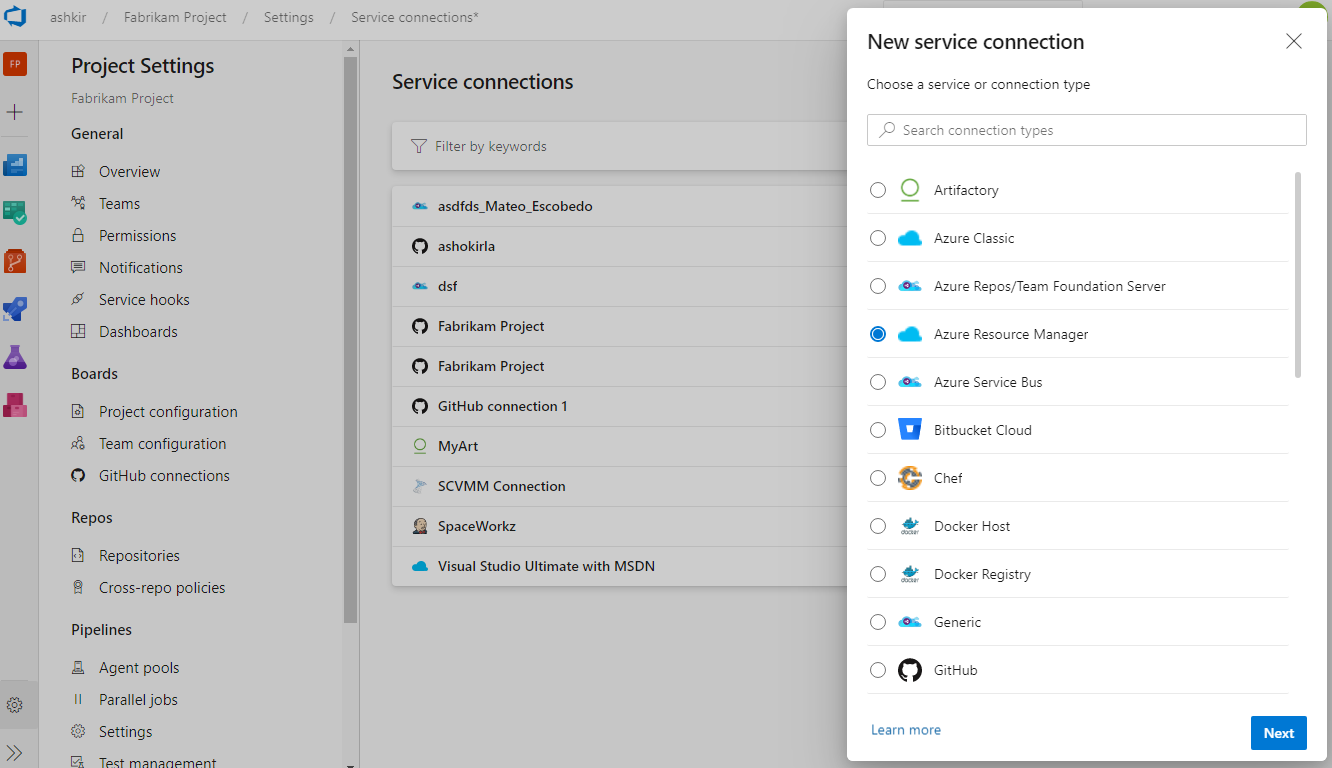

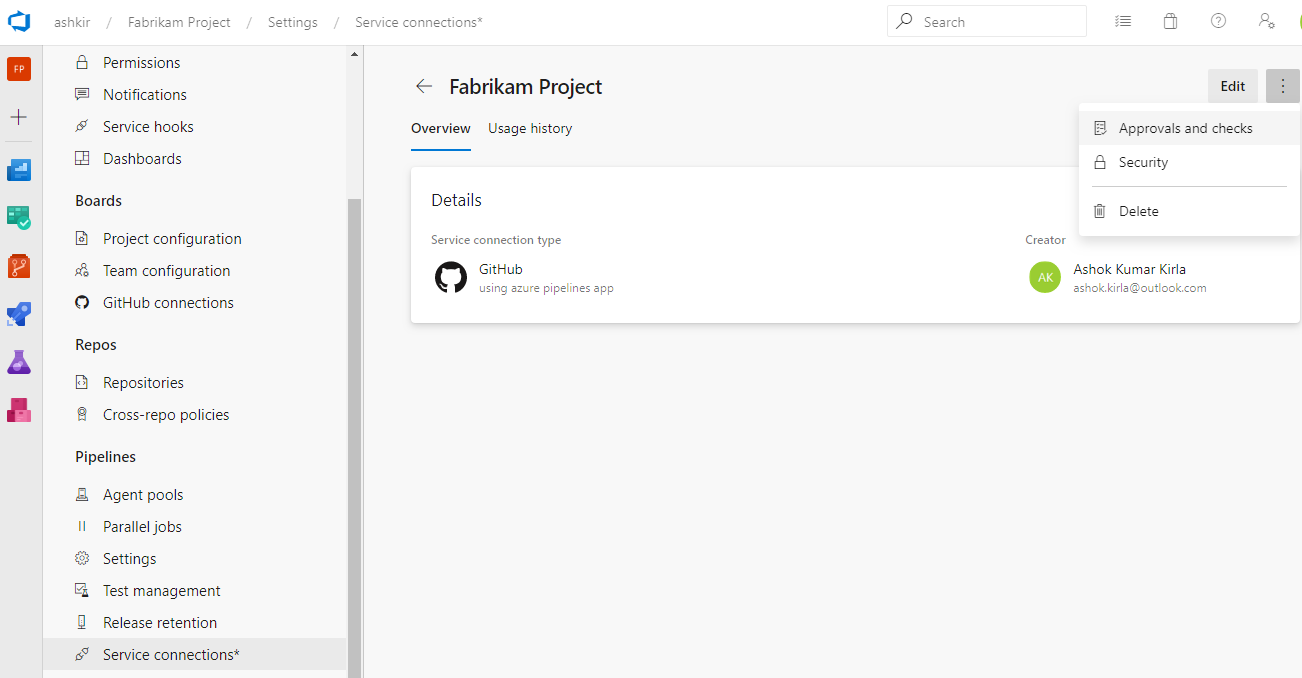

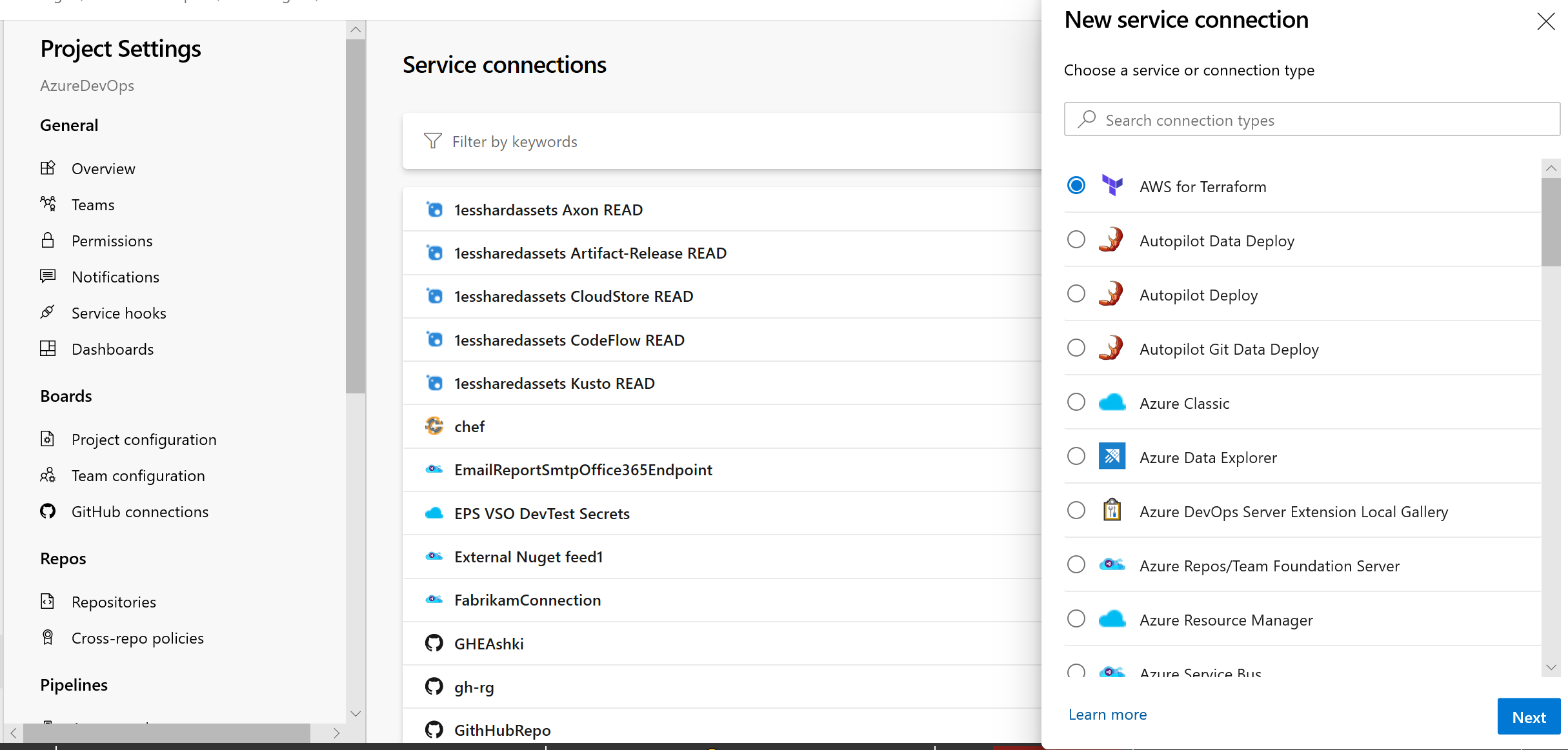

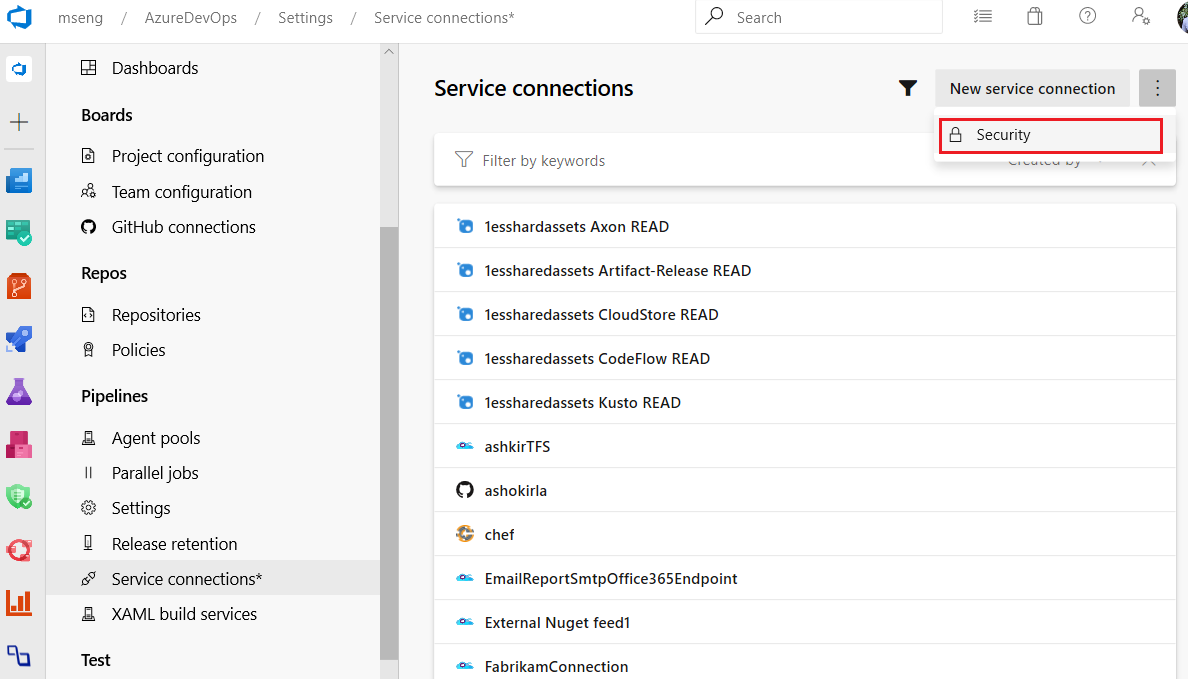

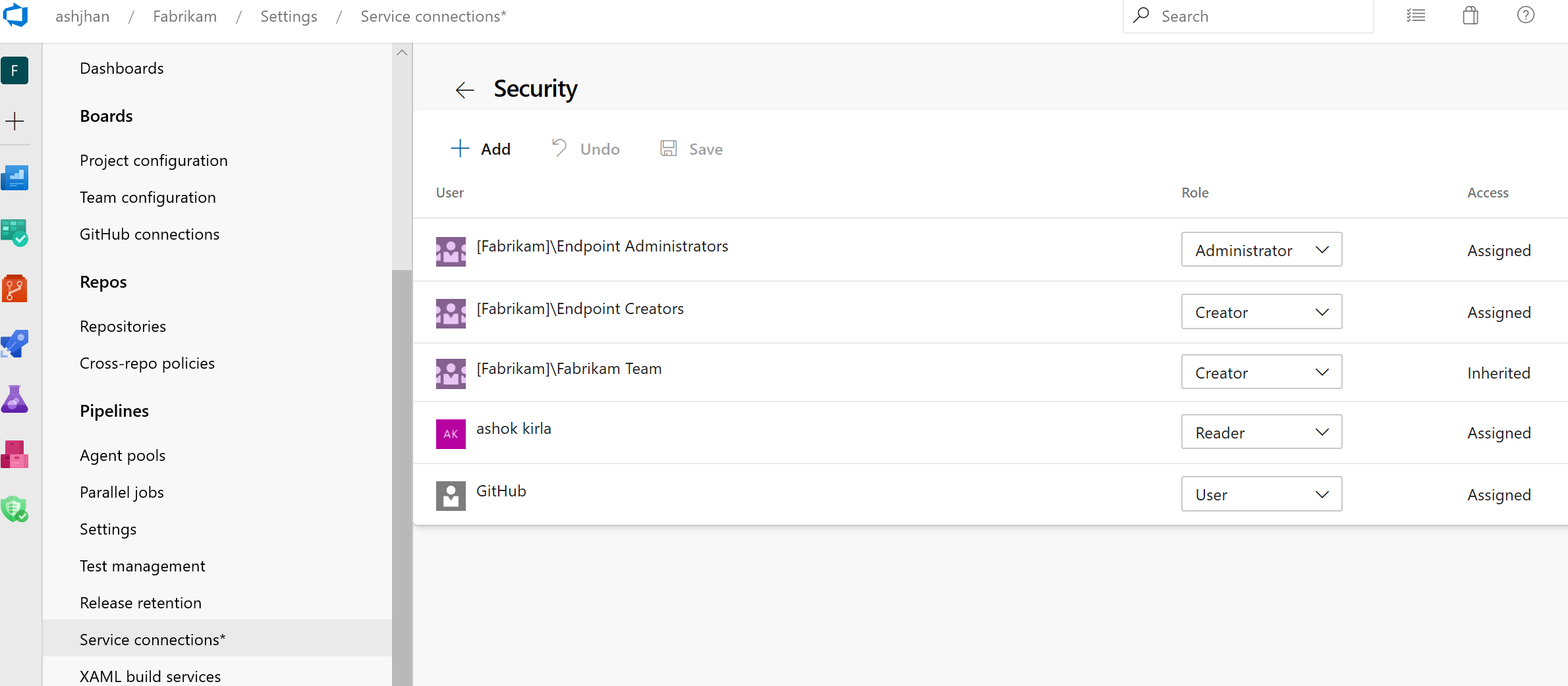

interface utilisateur des connexions Mises à jour au service

Nous avons travaillé sur une expérience utilisateur mise à jour pour gérer vos connexions de service. Ces mises à jour rendent l’expérience de connexion de service moderne et cohérente avec la direction d’Azure DevOps. Nous avons introduit la nouvelle interface utilisateur pour les connexions de service en tant que fonctionnalité en préversion plus tôt cette année. Merci à tous ceux qui ont essayé la nouvelle expérience et nous ont fait part de leurs précieux commentaires.

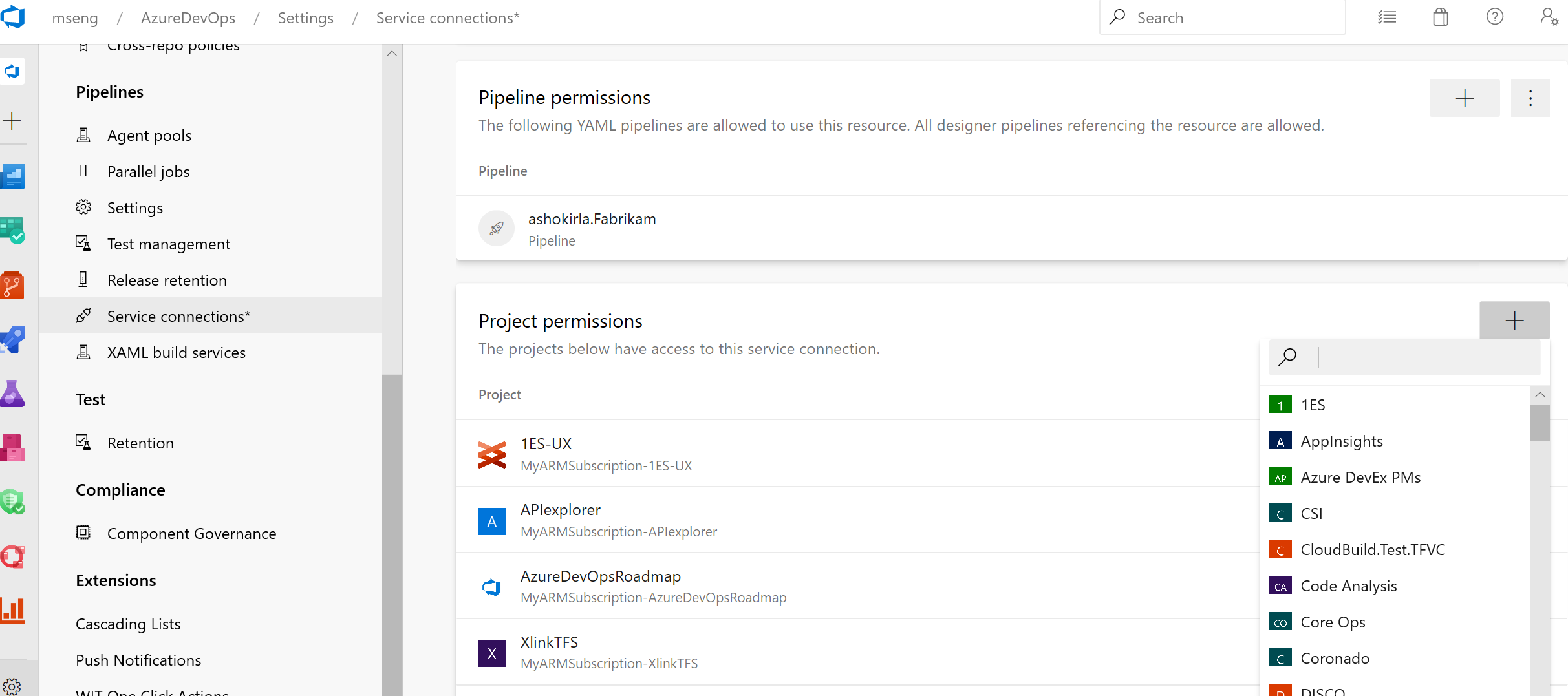

En plus de l’actualisation de l’expérience utilisateur, nous avons également ajouté deux fonctionnalités essentielles pour l’utilisation des connexions de service dans les pipelines YAML : les autorisations de pipeline, les approbations et les vérifications.

La nouvelle expérience utilisateur sera activée par défaut avec cette mise à jour. Vous aurez toujours la possibilité de refuser la préversion.

Notes

Nous prévoyons d’introduire le partage inter-projets de Connections de service en tant que nouvelle fonctionnalité. Vous trouverez plus d’informations sur l’expérience de partage et les rôles de sécurité ici.

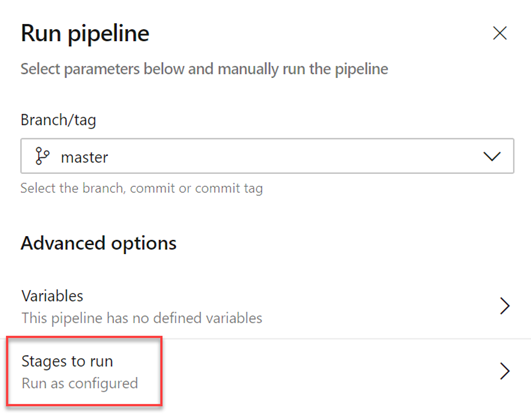

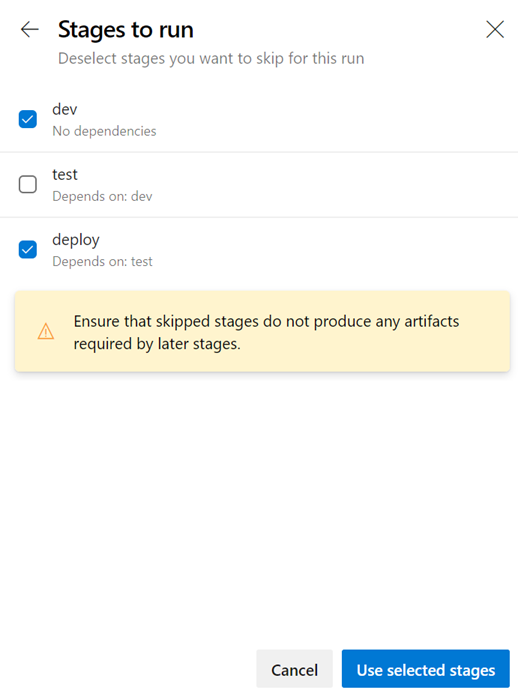

Ignorer des étapes dans un pipeline YAML

Lorsque vous démarrez une exécution manuelle, vous pouvez parfois ignorer quelques étapes dans votre pipeline. Par instance, si vous ne souhaitez pas déployer en production ou si vous souhaitez ignorer le déploiement dans quelques environnements en production. Vous pouvez maintenant effectuer cette opération avec vos pipelines YAML.

Le panneau de pipeline d’exécution mis à jour présente la liste des étapes du fichier YAML, et vous avez la possibilité d’ignorer une ou plusieurs de ces phases. Vous devez faire preuve de prudence lorsque vous ignorez des étapes. Par instance, si votre première étape produit certains artefacts nécessaires aux étapes suivantes, vous ne devez pas ignorer la première étape. Le panneau d’exécution présente un avertissement générique chaque fois que vous ignorez des étapes qui ont des dépendances en aval. Il vous appartient de déterminer si ces dépendances sont de véritables dépendances d’artefacts ou si elles sont simplement présentes pour le séquencement des déploiements.

Ignorer une étape revient à ressailler les dépendances entre les phases. Toutes les dépendances immédiates en aval de l’étape ignorée dépendent de l’amont parent de l’étape ignorée. Si l’exécution échoue et si vous tentez de réexécuter une phase ayant échoué, cette tentative aura également le même comportement d’évitement. Pour modifier les étapes ignorées, vous devez commencer une nouvelle exécution.

Nouvelle interface utilisateur des connexions de service en tant qu’expérience par défaut

Il existe une nouvelle interface utilisateur des connexions de service. Cette nouvelle interface utilisateur repose sur des normes de conception modernes et comprend diverses fonctionnalités critiques pour prendre en charge les pipelines CD YAML à plusieurs étapes, comme les approbations, les autorisations et le partage entre projets.

Pour en savoir plus sur les connexions de service, cliquez ici.

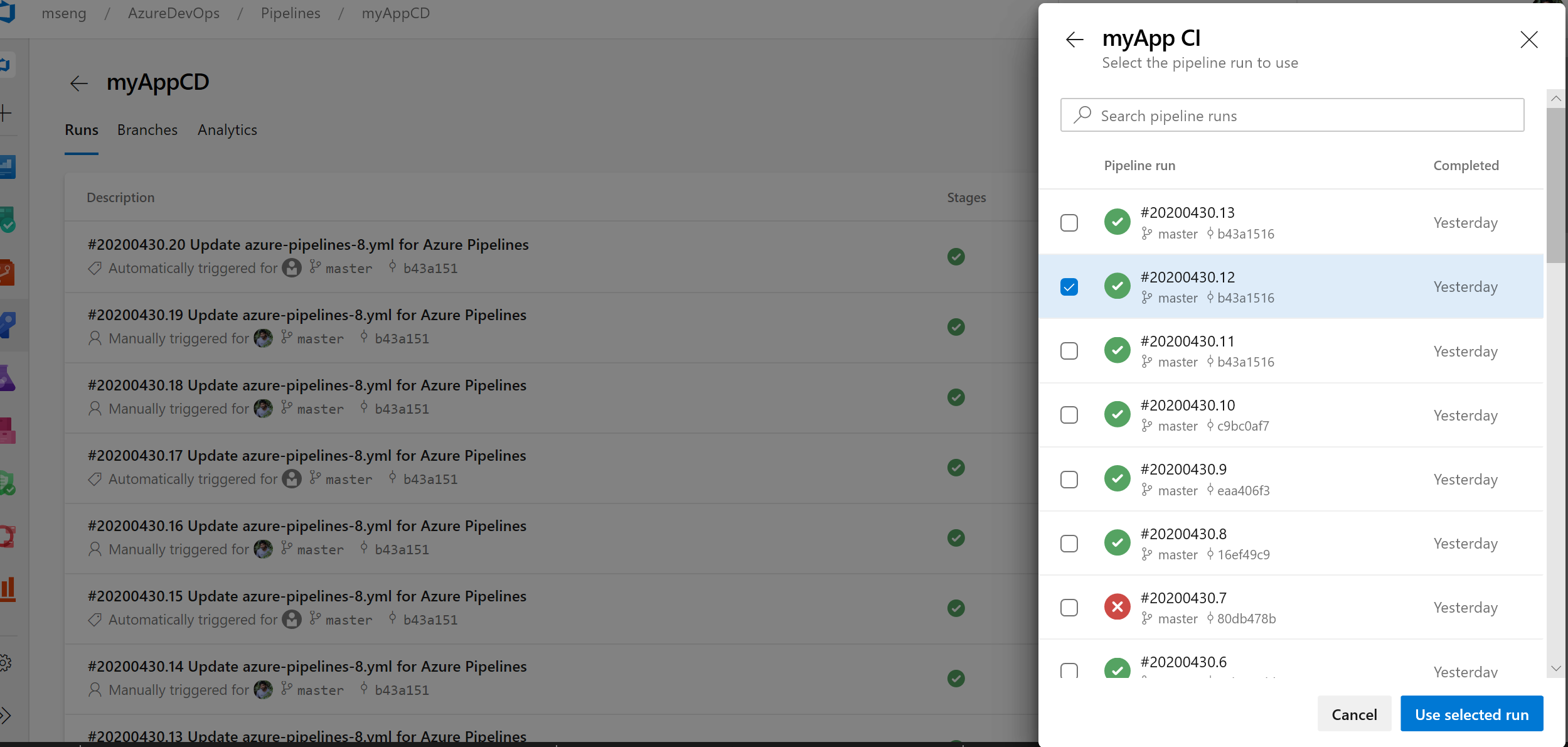

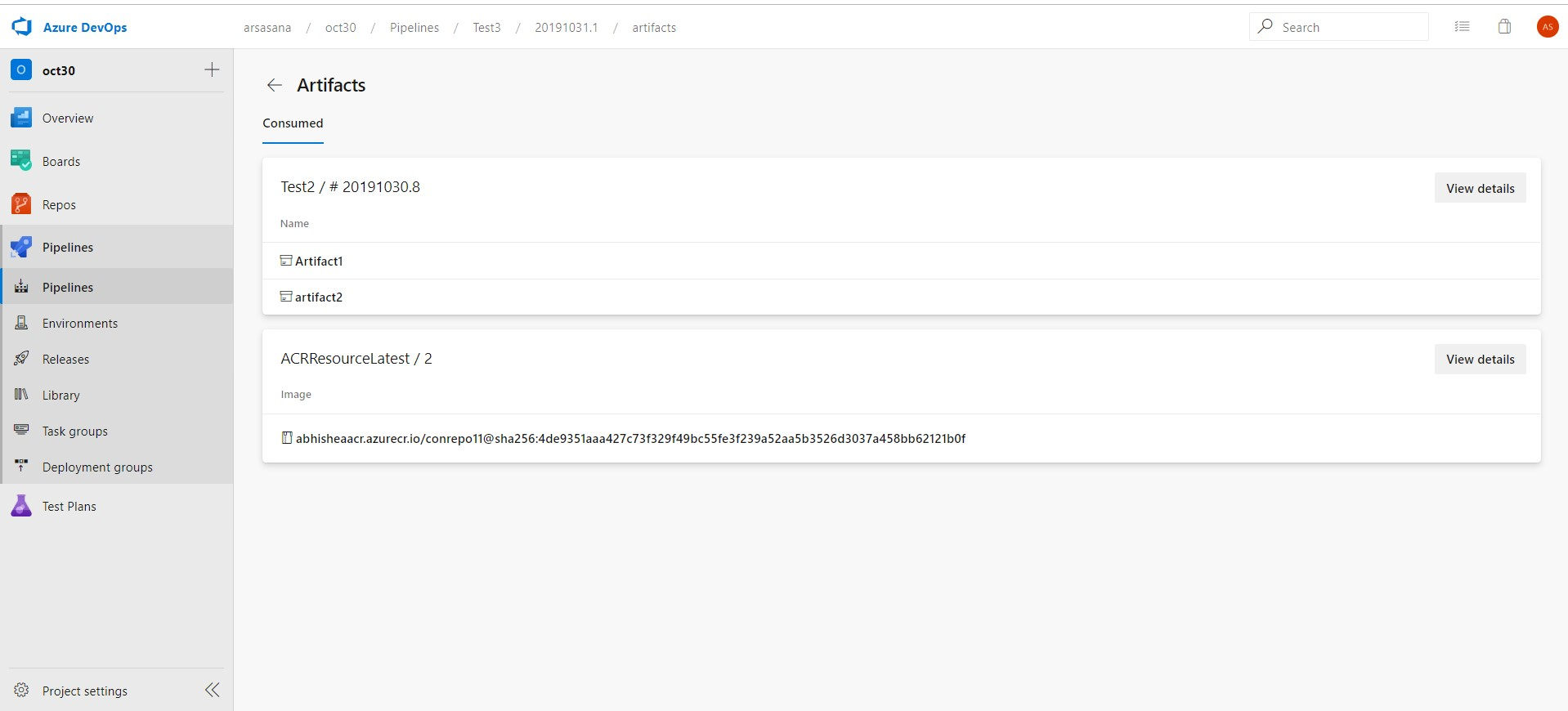

Sélecteur de version de ressource de pipeline dans la boîte de dialogue Créer une exécution

Nous avons ajouté la possibilité de récupérer manuellement les versions de ressources de pipeline dans la boîte de dialogue Créer une exécution. Si vous consommez un pipeline en tant que ressource dans un autre pipeline, vous pouvez désormais choisir la version de ce pipeline lors de la création d’une exécution.

az Améliorations de l’interface CLI pour Azure Pipelines

Groupe de variables de pipeline et commandes de gestion des variables

Il peut être difficile de porter des pipelines basés sur YAML d’un projet vers un autre, car vous devez configurer manuellement les variables de pipeline et les groupes de variables. Toutefois, avec le groupe de variables de pipeline et les commandes de gestion des variables , vous pouvez maintenant créer un script pour configurer et gérer des variables de pipeline et des groupes de variables, qui peuvent à leur tour être contrôlés par version, ce qui vous permet de partager facilement les instructions pour déplacer et configurer des pipelines d’un projet à un autre.

Exécuter le pipeline pour une branche de demande de tirage

Lors de la création d’une demande de tirage, il peut être difficile de vérifier si les modifications peuvent interrompre l’exécution du pipeline sur la branche cible. Toutefois, avec la possibilité de déclencher une exécution de pipeline ou de mettre en file d’attente une build pour une branche de demande de tirage, vous pouvez maintenant valider et visualiser les modifications apportées en l’exécutant sur le pipeline cible. Pour plus d’informations, consultez la documentation sur les commandes az pipelines run et az pipelines build queue .

Ignorer la première exécution du pipeline

Lorsque vous créez des pipelines, vous souhaitez parfois créer et valider un fichier YAML et ne pas déclencher l’exécution du pipeline, car cela peut entraîner une exécution défectueuse pour diverses raisons : l’infrastructure n’est pas prête ou n’a pas besoin de créer et de mettre à jour des groupes de variables/variables, etc. Avec Azure DevOps CLI, vous pouvez maintenant ignorer la première exécution automatisée du pipeline lors de la création d’un pipeline en incluant le paramètre --skip-first-run. Pour plus d’informations, consultez la documentation az pipeline create command .

Amélioration de la commande de point de terminaison de service

Les commandes CLI de point de terminaison de service ne prend en charge que la configuration et la gestion des points de terminaison de service azure rm et github. Toutefois, avec cette version, les commandes de point de terminaison de service vous permettent de créer n’importe quel point de terminaison de service en fournissant la configuration via un fichier et fournissent des commandes optimisées : az devops service-endpoint github et az devops service-endpoint azurerm, qui fournissent une prise en charge de première classe pour créer des points de terminaison de service de ces types. Pour plus d’informations, consultez la documentation sur les commandes .

Travaux de déploiement

Un travail de déploiement est un type spécial de travail utilisé pour déployer votre application dans un environnement. Avec cette mise à jour, nous avons ajouté la prise en charge des références d’étape dans un travail de déploiement. Par exemple, vous pouvez définir un ensemble d’étapes dans un fichier et y faire référence dans un travail de déploiement.

Nous avons également ajouté la prise en charge de propriétés supplémentaires au travail de déploiement. Par exemple, voici quelques propriétés d’un travail de déploiement que vous pouvez désormais définir :

- timeoutInMinutes : durée d’exécution du travail avant l’annulation automatique

- cancelTimeoutInMinutes : le temps nécessaire à l’exécution toujours même en cas d’annulation de tâches avant de les terminer

- condition : exécuter le travail de manière conditionnelle

- variables : les valeurs codées en dur peuvent être ajoutées directement, ou des groupes de variables, un groupe de variables soutenu par un coffre de clés Azure peut être référencé ou vous pouvez faire référence à un ensemble de variables définies dans un fichier.

- continueOnError : si les travaux futurs doivent s’exécuter même en cas d’échec de ce travail de déploiement ; la valeur par défaut est « false »

Pour plus d’informations sur les travaux de déploiement et la syntaxe complète permettant de spécifier un travail de déploiement, consultez Tâche de déploiement.

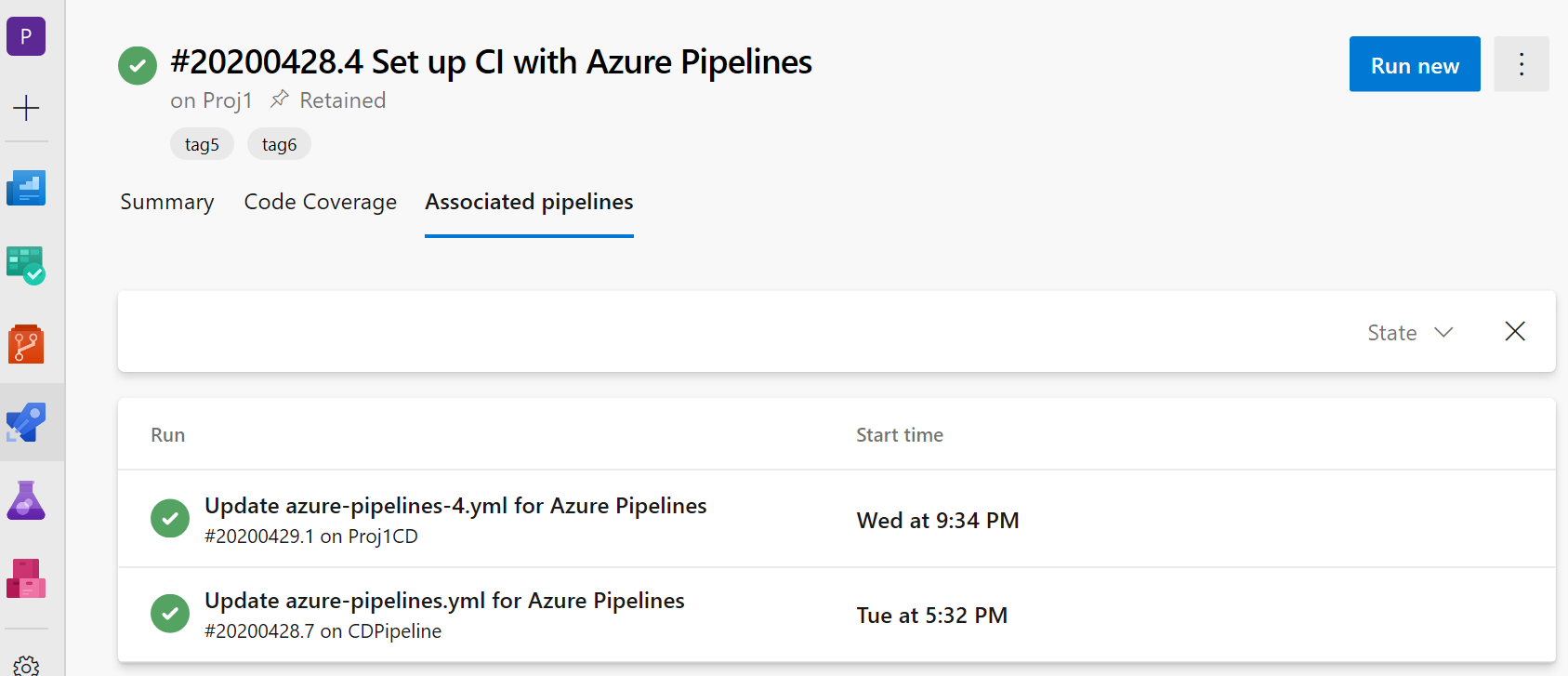

Affichage des informations sur les pipelines CD associés dans les pipelines CI

Nous avons ajouté la prise en charge des détails des pipelines CD YAML où les pipelines CI sont appelés ressources de pipeline. Dans la vue d’exécution de votre pipeline CI, vous voyez maintenant un nouvel onglet « Pipelines associés » dans lequel vous pouvez trouver toutes les exécutions de pipeline qui consomment votre pipeline et les artefacts qu’il contient.

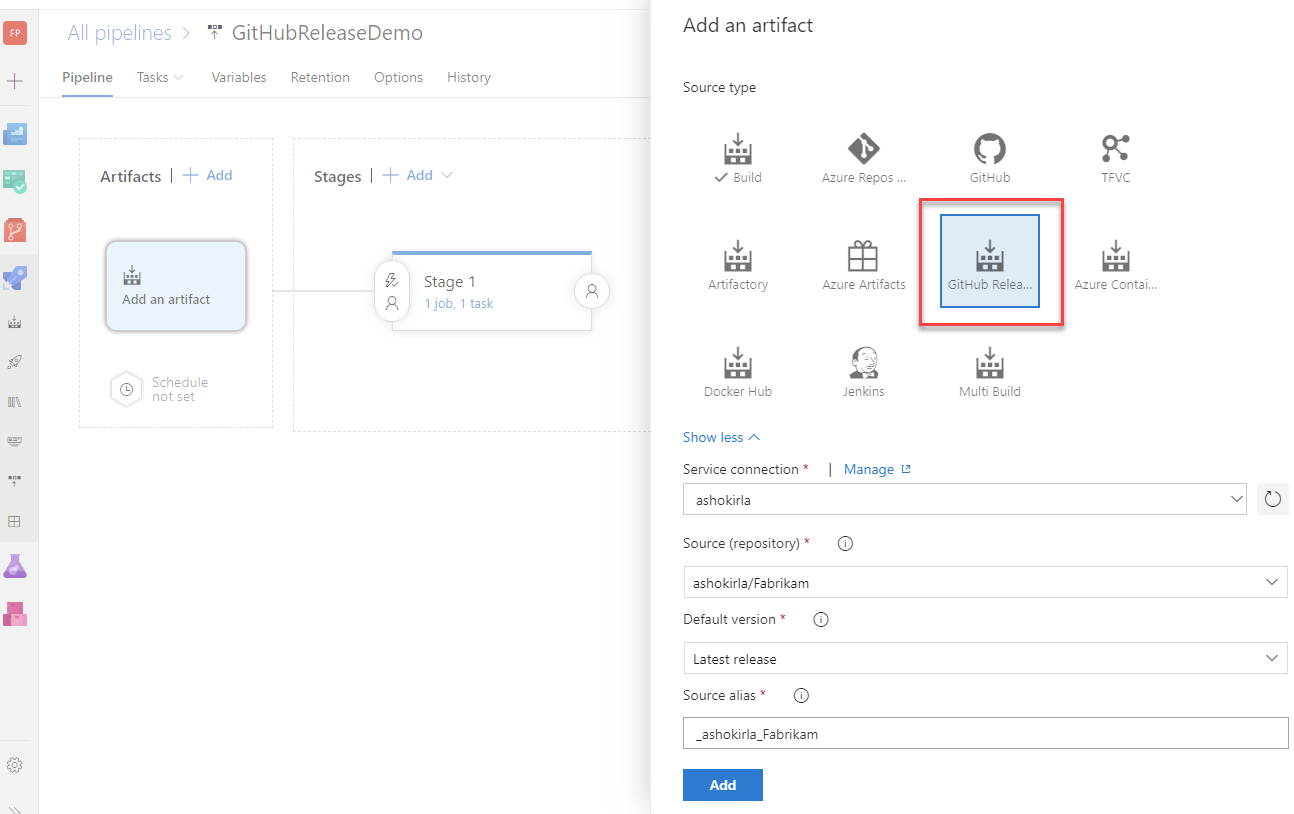

Prise en charge des packages GitHub dans les pipelines YAML

Nous avons récemment introduit un nouveau type de ressource appelé packages qui ajoute la prise en charge de l’utilisation des packages NuGet et npm à partir de GitHub en tant que ressource dans les pipelines YAML. Dans le cadre de cette ressource, vous pouvez désormais spécifier le type de package (NuGet ou npm) que vous souhaitez utiliser à partir de GitHub. Vous pouvez également activer les déclencheurs de pipeline automatisés lors de la publication d’une nouvelle version de package. Aujourd’hui, la prise en charge est disponible uniquement pour la consommation de packages à partir de GitHub, mais à l’avenir, nous prévoyons d’étendre la prise en charge pour consommer des packages à partir d’autres référentiels de packages tels que NuGet, npm, AzureArtifacts et bien d’autres. Pour plus d’informations, reportez-vous à l’exemple ci-dessous :

resources:

packages:

- package: myPackageAlias # alias for the package resource

type: Npm # type of the package NuGet/npm

connection: GitHubConn # Github service connection of type PAT

name: nugetTest/nodeapp # <Repository>/<Name of the package>

version: 1.0.9 # Version of the packge to consume; Optional; Defaults to latest

trigger: true # To enable automated triggers (true/false); Optional; Defaults to no triggers

Notes

Aujourd’hui, les packages GitHub prennent uniquement en charge l’authentification basée sur PAT, ce qui signifie que la connexion de service GitHub dans la ressource de package doit être de type PAT. Une fois cette limitation levée, nous fournirons la prise en charge d’autres types d’authentification.

Par défaut, les packages ne sont pas automatiquement téléchargés dans vos travaux, d’où la raison pour laquelle nous avons introduit une macro getPackage qui vous permet de consommer le package défini dans la ressource. Pour plus d’informations, reportez-vous à l’exemple ci-dessous :

- job: job1

pool: default

steps:

- getPackage: myPackageAlias # Alias of the package resource

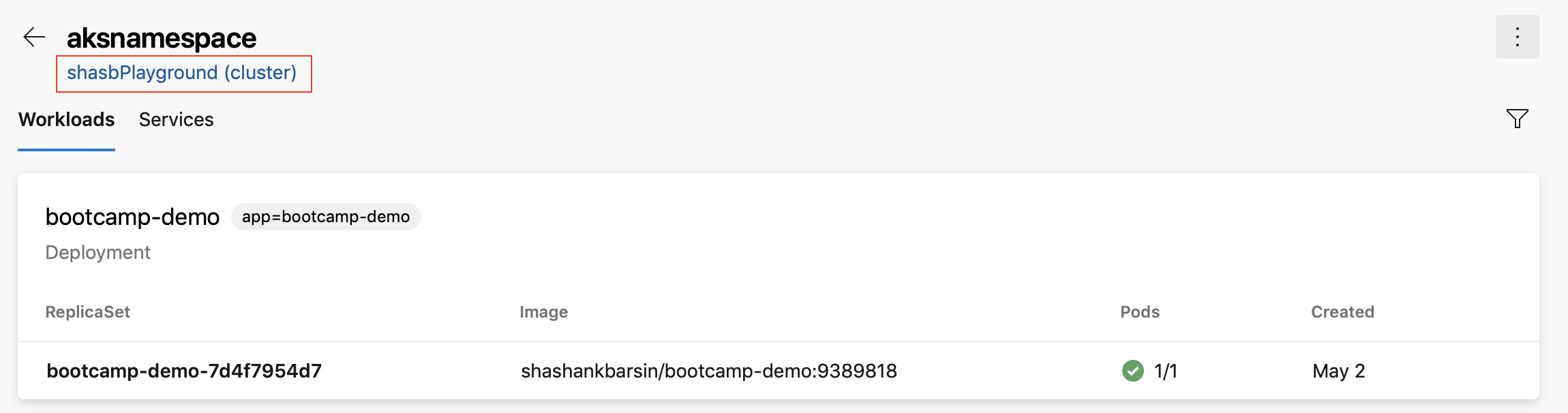

lien de cluster Azure Kubernetes Service dans la vue de ressources des environnements Kubernetes

Nous avons ajouté un lien vers l’affichage des ressources des environnements Kubernetes afin que vous puissiez accéder au panneau Azure pour le cluster correspondant. Cela s’applique aux environnements mappés à des espaces de noms dans Azure Kubernetes Service clusters.

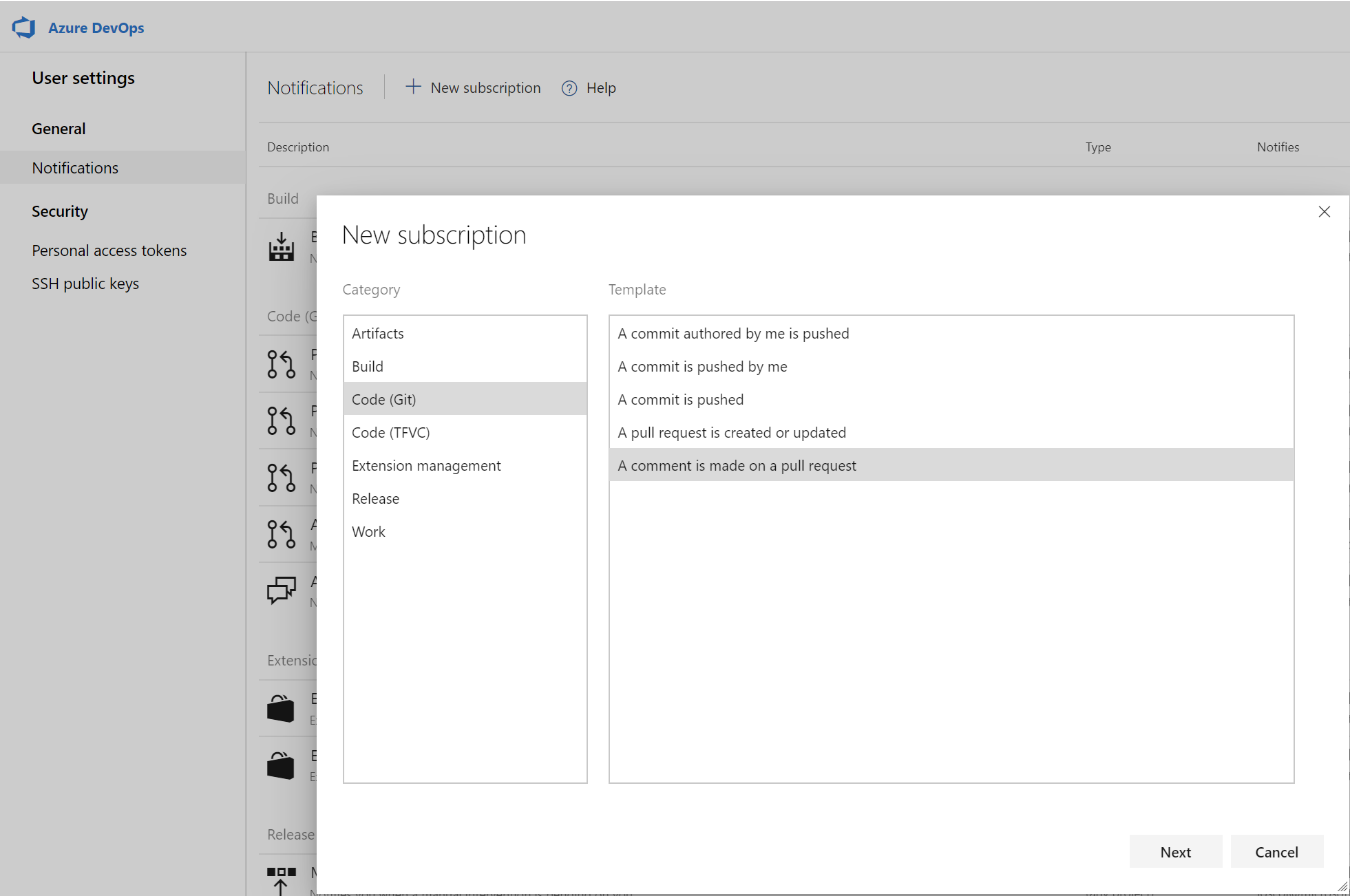

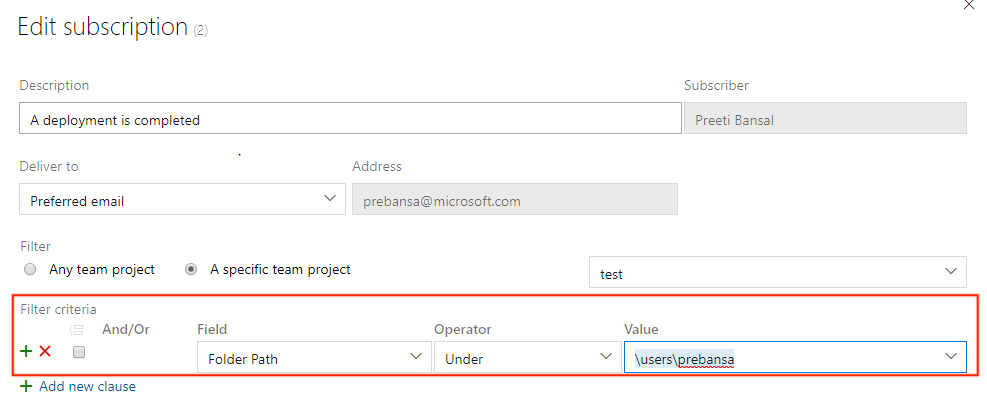

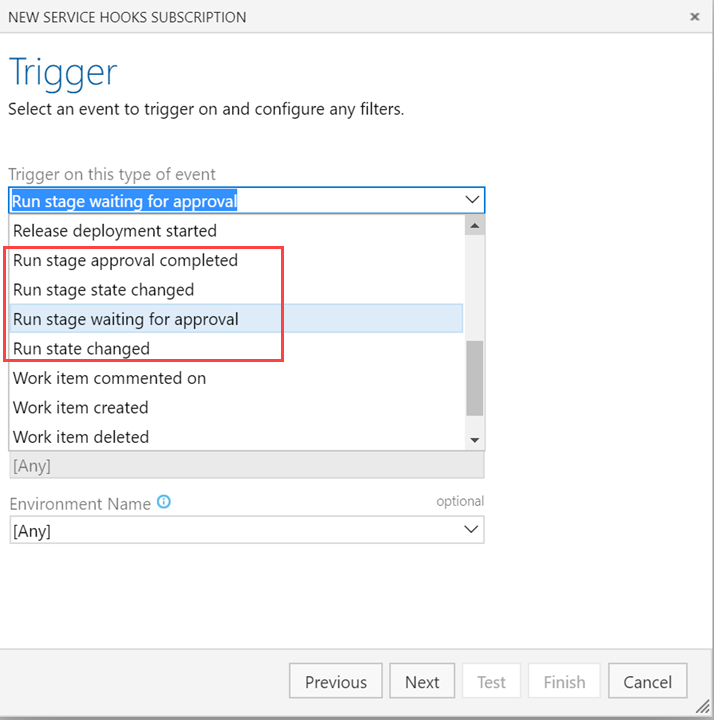

Filtres de dossiers de mise en production dans les abonnements de notification

Les dossiers permettent d’organiser les pipelines pour faciliter la détectabilité et le contrôle de sécurité. Souvent, vous pouvez configurer des Notifications par e-mail personnalisées pour tous les pipelines de mise en production, qui sont représentés par tous les pipelines sous un dossier. Auparavant, vous deviez configurer plusieurs abonnements ou avoir une requête complexe dans les abonnements pour obtenir des e-mails ciblés. Avec cette mise à jour, vous pouvez maintenant ajouter une clause de dossier de mise en production aux événements de déploiement terminés et d’approbation en attente , et simplifier les abonnements.

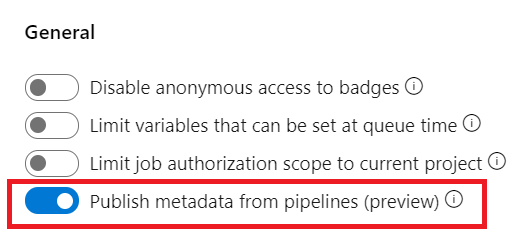

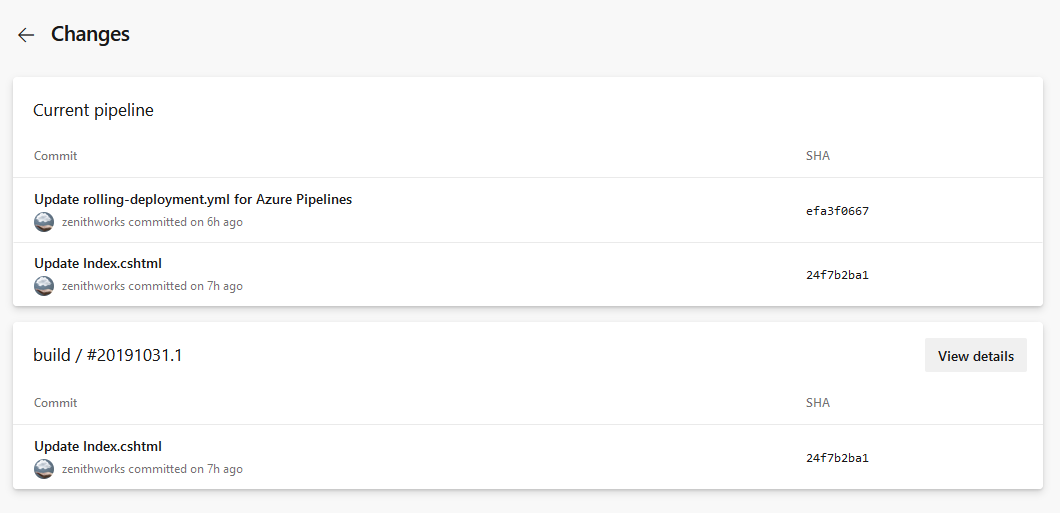

Lier des éléments de travail avec des pipelines YAML à plusieurs étapes

Actuellement, vous pouvez lier automatiquement des éléments de travail avec des builds classiques. Toutefois, cela n’a pas été possible avec les pipelines YAML. Avec cette mise à jour, nous avons résolu cette lacune. Lorsque vous exécutez correctement un pipeline à l’aide du code d’une branche spécifiée, Azure Pipelines associe automatiquement l’exécution à tous les éléments de travail (qui sont déduits par le biais des validations dans ce code). Lorsque vous ouvrez l’élément de travail, vous pouvez voir les exécutions dans lesquelles le code de cet élément de travail a été généré. Pour configurer cela, utilisez le panneau des paramètres d’un pipeline.

Annuler une étape dans une exécution de pipeline YAML à plusieurs étapes

Lors de l’exécution d’un pipeline YAML à plusieurs étapes, vous pouvez maintenant annuler l’exécution d’une phase pendant qu’elle est en cours. Cela est utile si vous savez que la phase va échouer ou si vous avez une autre exécution que vous souhaitez démarrer.

Étapes ayant échoué lors de l’échec de la nouvelle tentative

L’une des fonctionnalités les plus demandées dans les pipelines à plusieurs étapes est la possibilité de réessayer une étape ayant échoué sans avoir à commencer par le début. Avec cette mise à jour, nous ajoutons une grande partie de cette fonctionnalité.

Vous pouvez maintenant réessayer une étape de pipeline lorsque l’exécution échoue. Tous les travaux ayant échoué lors de la première tentative et ceux qui dépendent transitivement de ces travaux ayant échoué sont tous tentés de nouveau.

Cela peut vous aider à gagner du temps de plusieurs façons. Par instance, lorsque vous exécutez plusieurs travaux dans une phase, vous souhaiterez peut-être que chaque étape exécute des tests sur une plateforme différente. Si les tests sur une plateforme échouent alors que d’autres réussissent, vous pouvez gagner du temps en ne ré-exécutant pas les travaux qui ont réussi. Autre exemple, une étape de déploiement peut avoir échoué en raison d’une connexion réseau défaillante. La nouvelle tentative de cette étape vous permet de gagner du temps en n’ayant pas à produire une autre build.

Il existe quelques lacunes connues dans cette fonctionnalité. Par exemple, vous ne pouvez pas réessayer une étape que vous annulez explicitement. Nous nous efforçons de combler ces lacunes dans les futures mises à jour.

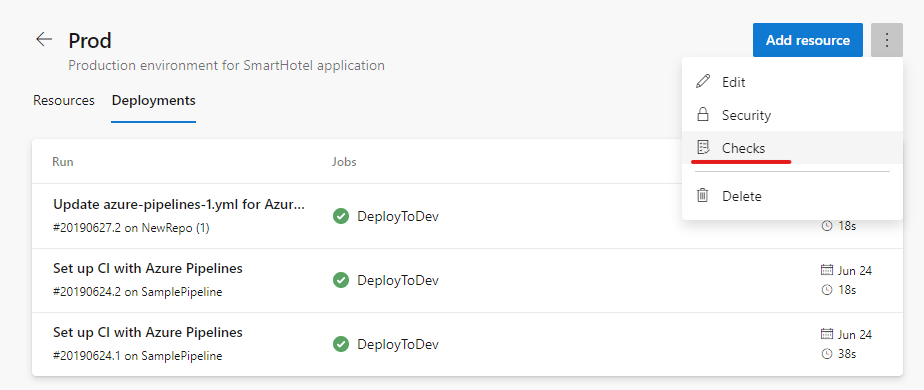

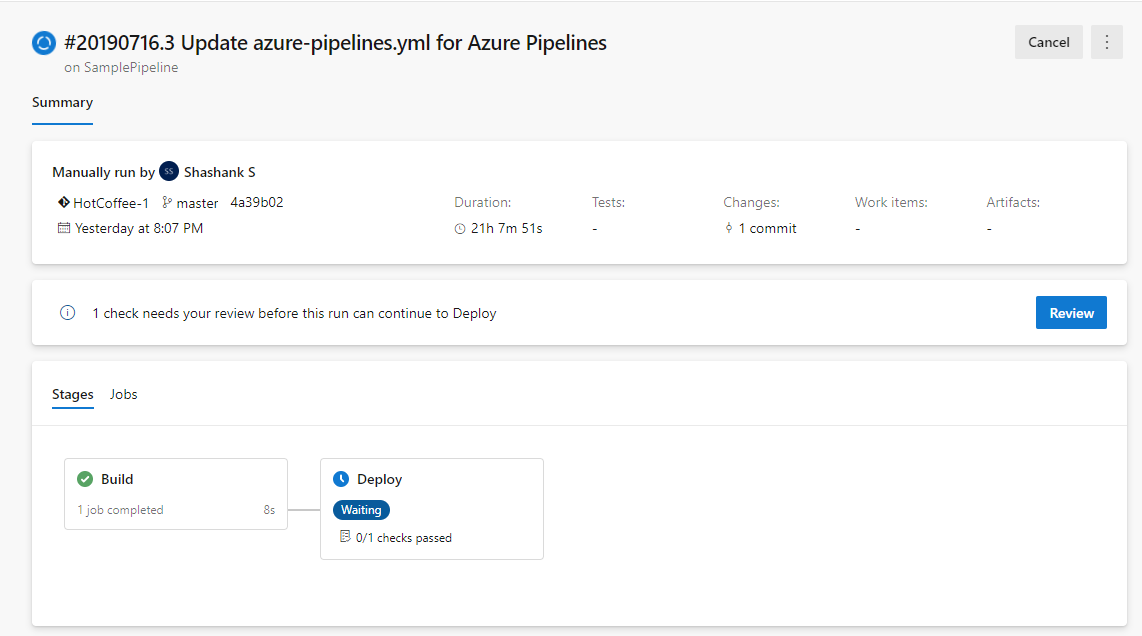

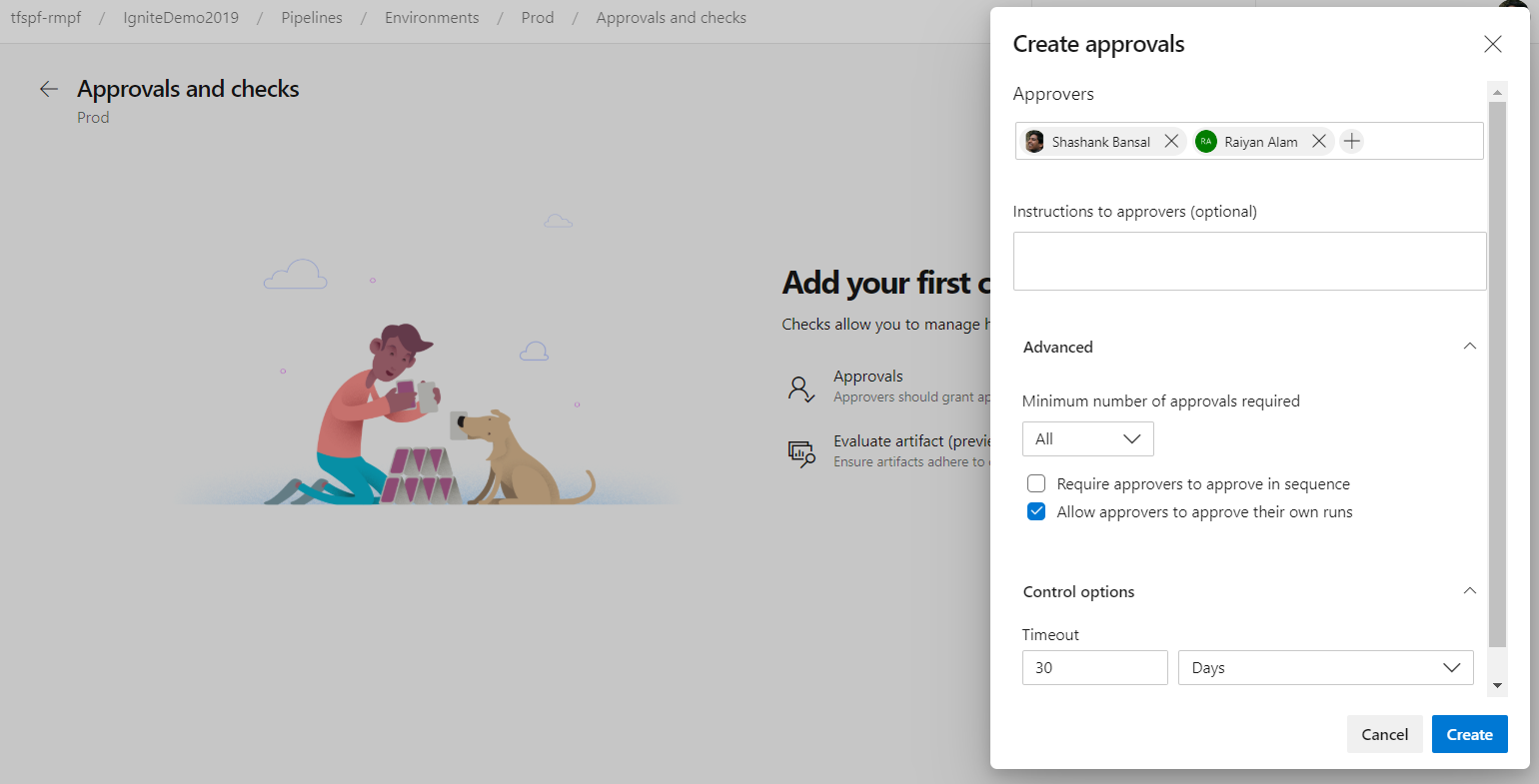

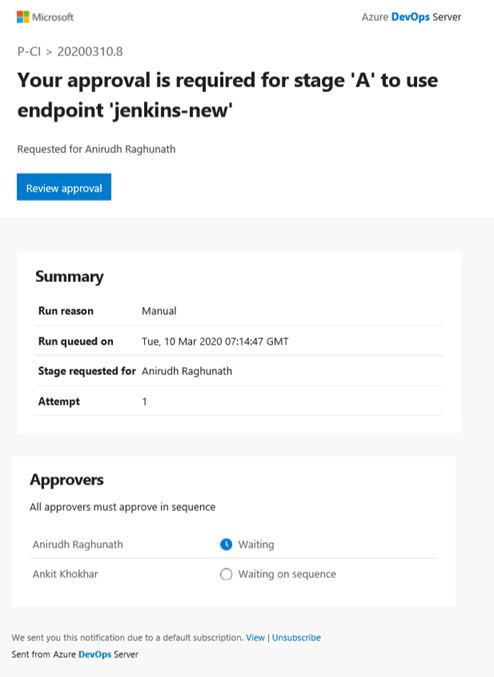

Approbations dans les pipelines YAML à plusieurs étapes

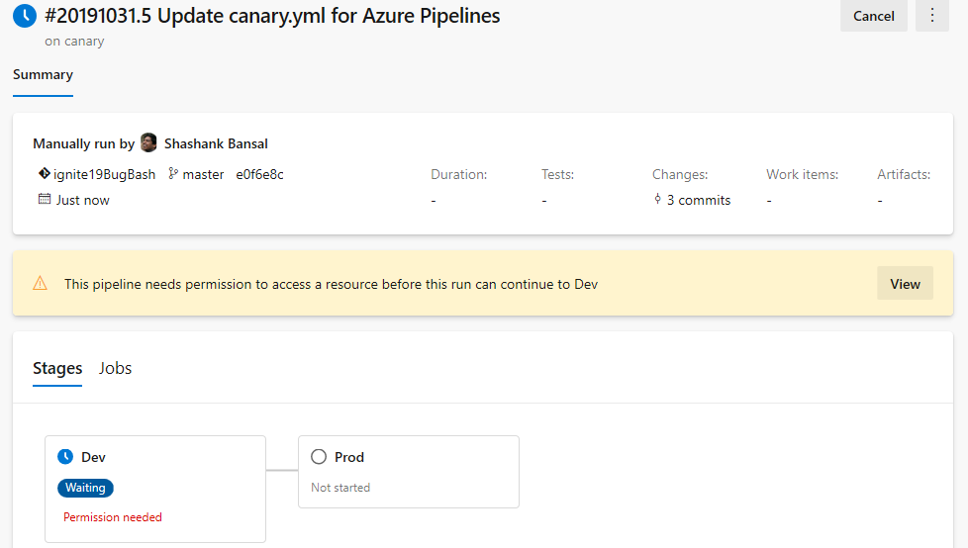

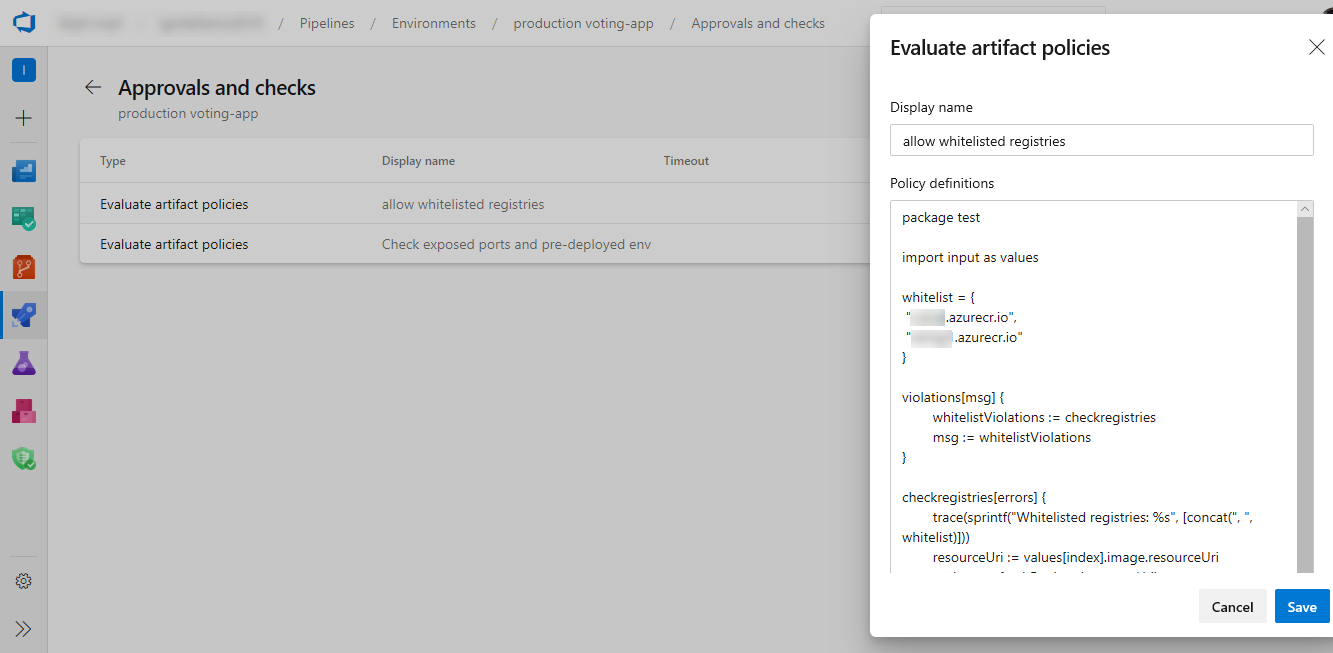

Vos pipelines CD YAML peuvent contenir des approbations manuelles. Les propriétaires d’infrastructure peuvent protéger leurs environnements et demander des approbations manuelles avant qu’une étape de tout pipeline ne soit déployée sur eux. Grâce à la séparation complète des rôles entre les propriétaires d’infrastructure (environnement) et d’application (pipeline), vous vous assurerez d’une approbation manuelle pour le déploiement dans un pipeline particulier et bénéficierez d’un contrôle central dans l’application des mêmes vérifications sur tous les déploiements dans l’environnement.

Les exécutions de pipeline déployées sur dev s’arrêtent pour approbation au début de la phase.

Augmentation de la limite et de la fréquence du délai d’expiration des portes

Auparavant, le délai d’expiration de la porte dans les pipelines de mise en production était de trois jours. Avec cette mise à jour, la limite de délai d’expiration a été augmentée à 15 jours pour autoriser les portes avec des durées plus longues. Nous avons également augmenté la fréquence de la porte à 30 minutes.

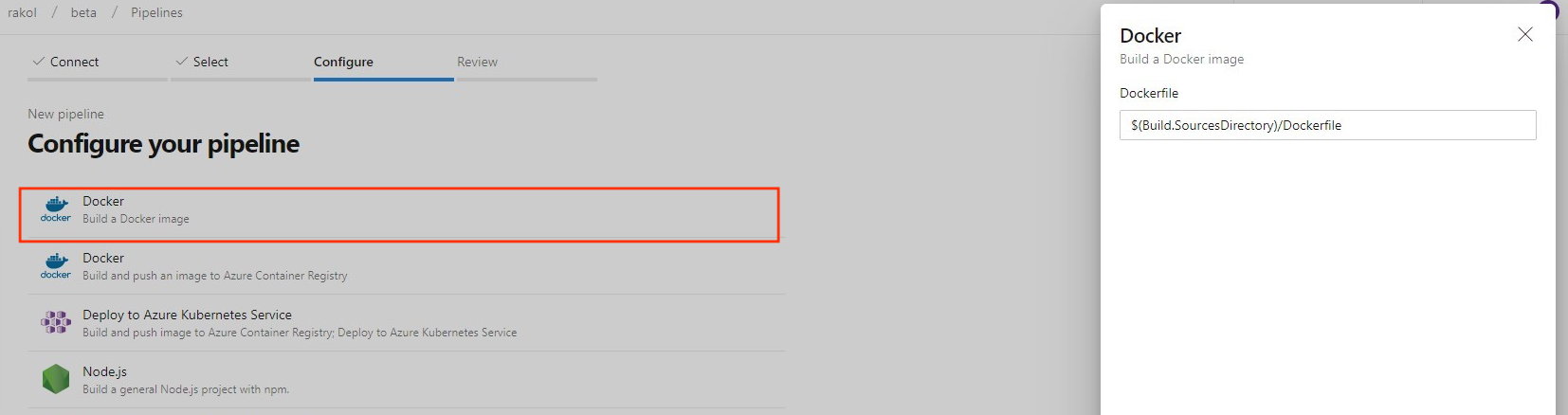

Nouveau modèle d’image de build pour Dockerfile

Auparavant, lors de la création d’un pipeline pour un fichier Dockerfile lors de la création d’un nouveau pipeline, le modèle recommandait d’envoyer l’image à un Azure Container Registry et de la déployer sur un Azure Kubernetes Service. Nous avons ajouté un nouveau modèle pour vous permettre de créer une image à l’aide de l’agent sans avoir à envoyer (push) à un registre de conteneurs.

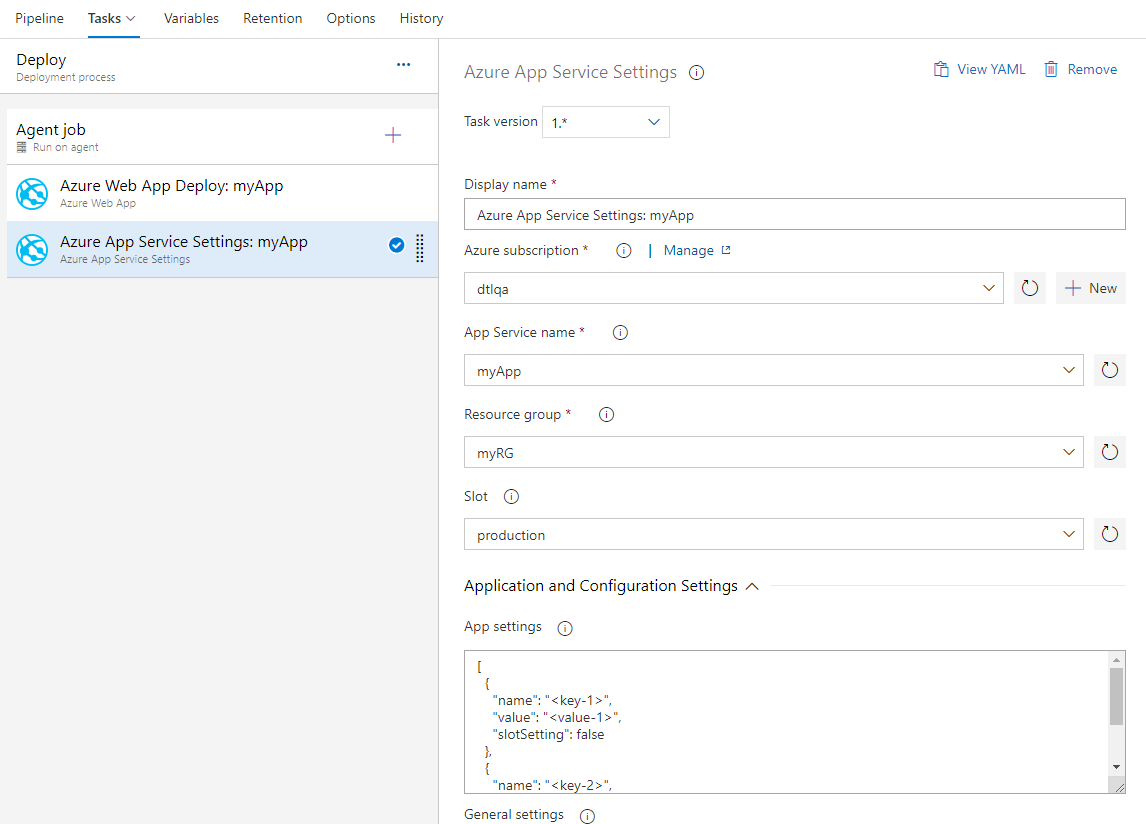

Nouvelle tâche de configuration des paramètres d’application Azure App Service

Azure App Service permet la configuration via différents paramètres tels que les paramètres d’application, les chaînes de connexion et d’autres paramètres de configuration générale. Nous avons maintenant une nouvelle tâche Azure Pipelines Azure App Service Paramètres qui prend en charge la configuration de ces paramètres en bloc à l’aide de la syntaxe JSON sur votre application web ou l’un de ses emplacements de déploiement. Cette tâche peut être utilisée avec d’autres tâches App Service pour déployer, gérer et configurer vos applications web, applications de fonction ou tout autre service App Services conteneurisé.

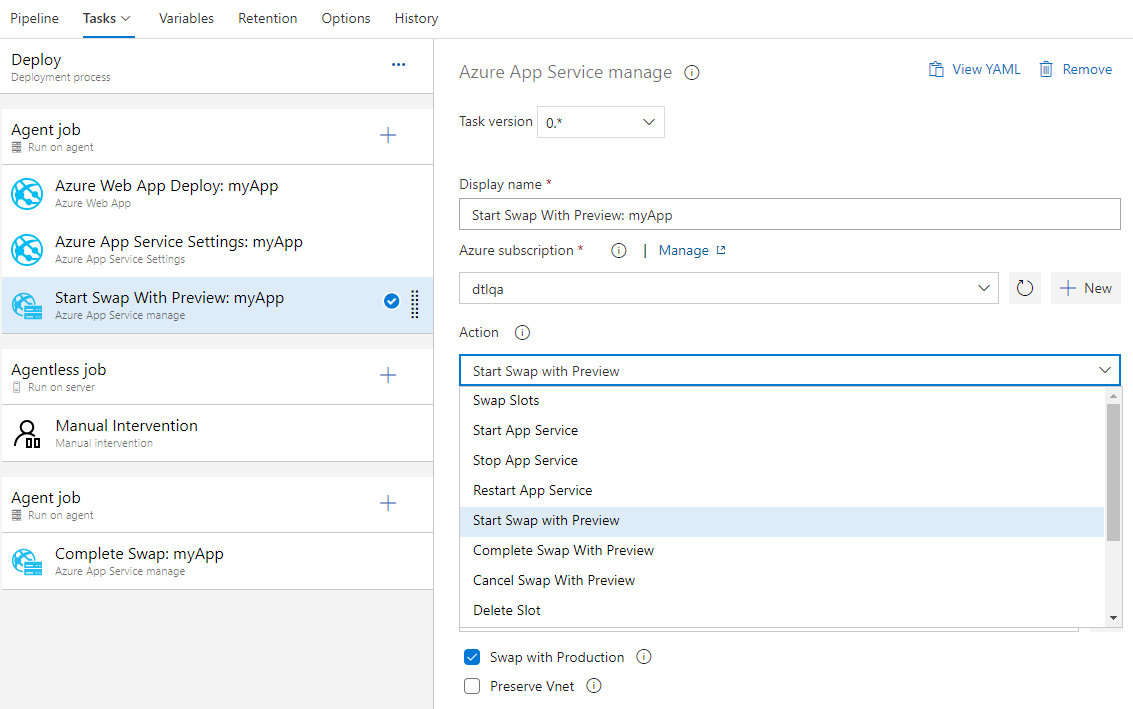

Azure App Service prend désormais en charge l’échange avec la préversion

Azure App Service prend désormais en charge l’échange avec préversion sur ses emplacements de déploiement. Il s’agit d’un bon moyen de valider l’application avec la configuration de production avant que l’application ne soit réellement échangée d’un emplacement intermédiaire vers un emplacement de production. Cela garantit également que l’emplacement cible/de production ne subit pas de temps d’arrêt.

Azure App Service tâche prend désormais en charge cet échange en plusieurs phases via les nouvelles actions suivantes :

- Démarrer l’échange avec la préversion : lance un échange avec un aperçu (échange multiphase) et applique la configuration de l’emplacement cible (par exemple, l’emplacement de production) à l’emplacement source.

- Terminer l’échange avec la préversion : lorsque vous êtes prêt à terminer l’échange en attente, sélectionnez l’action Terminer l’échange avec l’aperçu.

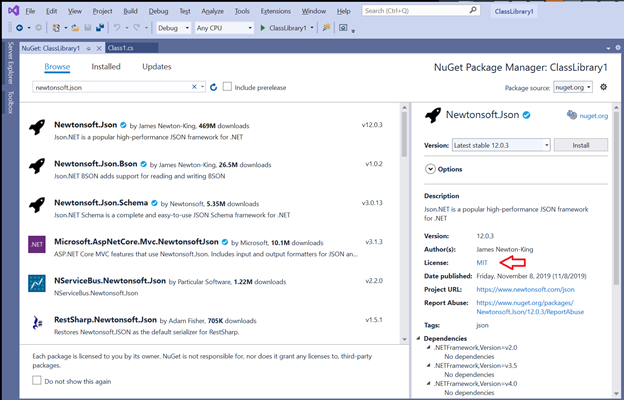

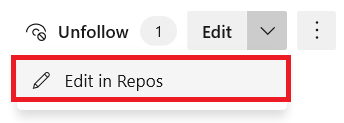

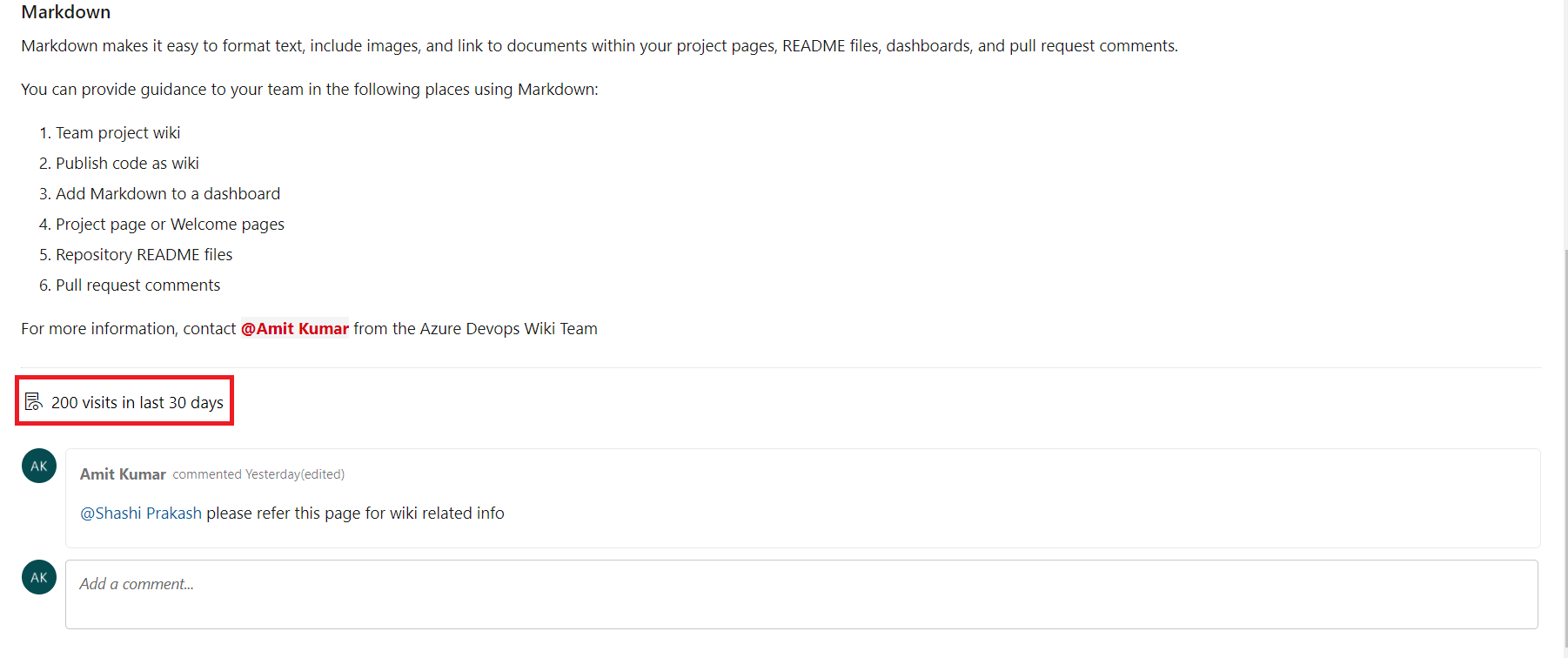

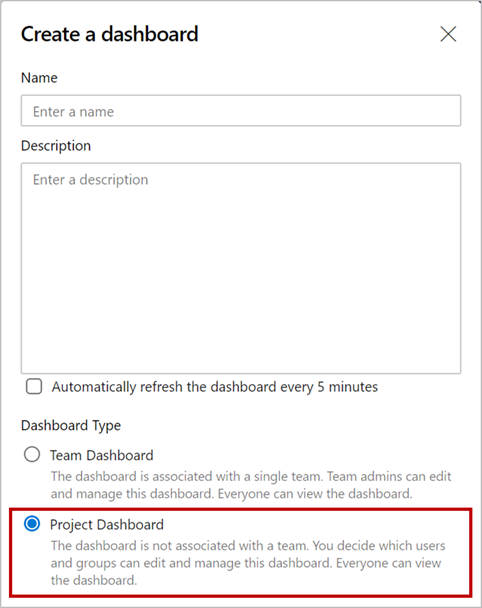

- Annuler l’échange avec la préversion : pour annuler un échange en attente, sélectionnez Annuler l’échange avec la préversion.