Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

L’outil Open Model LLM permet l’utilisation de différents modèles Open Model et Foundational Models, tels que Falcon et Llama 2, pour le traitement en langage naturel dans le flux d’invite Azure Machine Learning.

Attention

Avis de dépréciation : l’outil Open Model LLM a été déprécié en faveur de l’outil LLM, qui fournit une prise en charge de tous les modèles pris en charge par l’API d’inférence du modèle IA Azure et donc il offre une plus grande flexibilité.

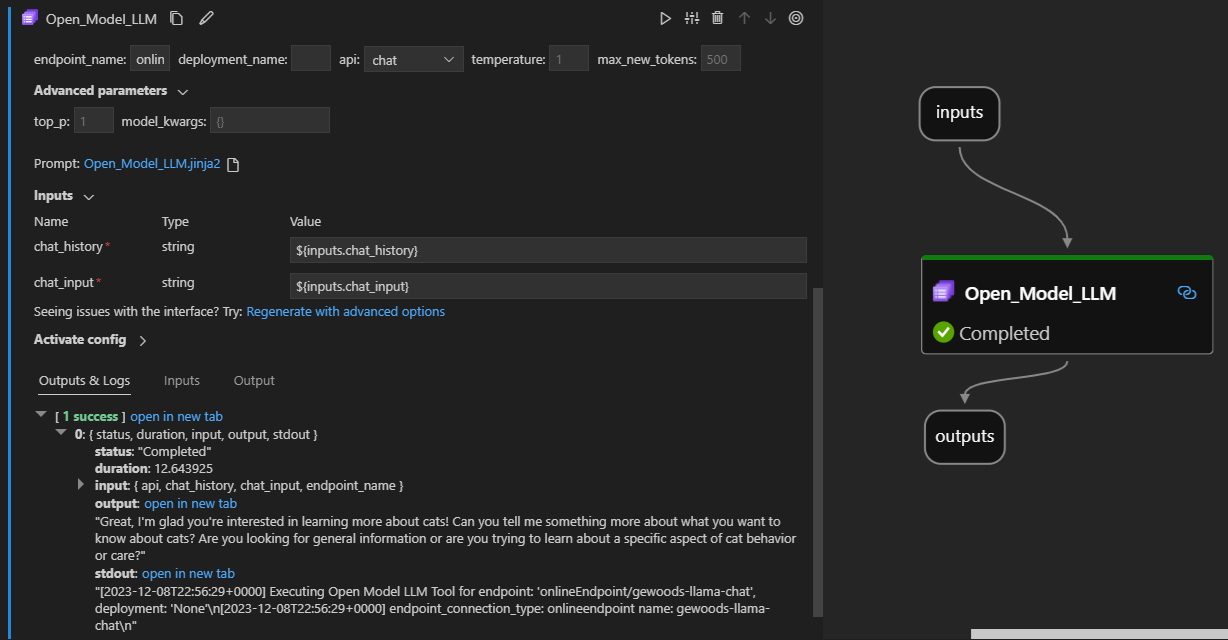

Voici ce que cela donne en action sur l’extension de flux rapide Visual Studio Code. Dans cet exemple, l’outil est utilisé pour appeler un point de terminaison de conversation LlaMa-2 et demander « Qu’est-ce que CI ? ».

Cet outil de flux d’invite prend en charge deux types d’API LLM différents :

- Conversation : illustré dans l’exemple précédent. Le type d’API de conversation facilite les conversations interactives avec des entrées et des réponses textuelles.

- Saisie semi-automatique : le type d’API de saisie semi-automatique est utilisé pour générer des saisies de texte de réponse uniques en fonction de l’entrée d’invite fournie.

Vue d’ensemble rapide : Comment faire utiliser l’outil Open Model LLM ?

- Choisissez un modèle dans le catalogue de modèles Azure Machine Learning et déployez-le.

- Connectez-vous au déploiement du modèle.

- Configurez les paramètres de l’outil llm de modèle ouvert.

- Préparez l’invite.

- Exécutez le flux.

Conditions préalables : Déploiement de modèle

- Choisissez le modèle correspondant à votre scénario dans le catalogue de modèles Azure Machine Learning.

- Utilisez le bouton Déployer pour déployer le modèle sur un point de terminaison d’inférence en ligne Azure Machine Learning.

- Utilisez l’une des options de déploiement Paiement à l’utilisation.

Pour plus d’informations, consultez Déployer des modèles de base sur des points de terminaison pour l’inférence.

Conditions préalables : Se connecter au modèle

Pour que le flux d’invite utilise votre modèle déployé, vous devez vous y connecter. Il existe deux façons de se connecter.

Connexions de point de terminaison

Une fois votre flux associé à un espace de travail Azure Machine Learning ou Azure AI Studio, l’outil Open Model LLM peut utiliser les points de terminaison de cet espace de travail.

Utilisation d’espaces de travail Azure Machine Learning ou Azure AI Studio : si vous utilisez un flux d’invite dans l’un des espaces de travail de navigateurs basés sur des pages web, les points de terminaison en ligne disponibles sur cet espace de travail qui sont automatiquement disponibles.

Utilisation de VS Code ou de code en premier : si vous utilisez le flux d’invite dans VS Code ou l’une des offres Code First, vous devez vous connecter à l’espace de travail. L’outil Open Model LLM utilise le client Azure.identity DefaultAzureCredential pour l’autorisation. L’une des façons consiste à définir des valeurs d’informations d’identification d’environnement.

Connexions personnalisées

L’outil Open Model LLM utilise CustomConnection. Le flux d’invite prend en charge deux types de connexions :

Connexions d’espace de travail : connexions stockées en tant que secrets sur un espace de travail Azure Machine Learning. Bien que ces connexions puissent être utilisées, dans de nombreux endroits, elles sont généralement créées et conservées dans l’interface utilisateur de Studio. Pour savoir comment créer une connexion personnalisée dans l’interface utilisateur de Studio, découvrez comment créer une connexion personnalisée.

Connexions locales : connexions stockées localement sur votre ordinateur. Ces connexions ne sont pas disponibles dans l’expérience utilisateur studio, mais peuvent être utilisées avec l’extension VS Code. Pour savoir comment créer une connexion personnalisée locale, découvrez comment créer une connexion locale.

Les clés requises à définir sont les suivantes :

- endpoint_url

- Cette valeur se trouve sur le point de terminaison d’inférence créé précédemment.

- endpoint_api_key

- Veillez à la définir comme valeur secrète.

- Cette valeur se trouve sur le point de terminaison d’inférence créé précédemment.

- model_family

- Valeurs prises en charge : LLAMA, DOLLY, GPT2 ou FALCON

- Cette valeur dépend du type de déploiement que vous ciblez.

Exécution de l’outil : Entrées

L’outil Open Model LLM a de nombreux paramètres, dont certains sont requis. Consultez le tableau suivant pour plus d’informations, vous pouvez faire correspondre ces paramètres à la capture d’écran précédente pour plus de clarté visuelle.

| Nom | Type | Description | Obligatoire |

|---|---|---|---|

| api | string | Mode API qui dépend du modèle utilisé et du scénario sélectionné. Valeurs prises en charge : (Saisie semi-automatique | Conversation) | Oui |

| endpoint_name | string | Nom d’un point de terminaison d’inférence en ligne avec un modèle pris en charge déployé sur celui-ci. Prend la priorité sur la connexion. | Oui |

| température | float | Caractère aléatoire du texte généré. 1 constitue la valeur par défaut. | Non |

| max_new_tokens | entier | Nombre maximal de jetons à générer dans la saisie semi-automatique. La valeur par défaut est 500. | Non |

| top_p | float | Probabilité d’utiliser le meilleur choix parmi les jetons générés. 1 constitue la valeur par défaut. | Non |

| model_kwargs | dictionnaire | Cette entrée est utilisée pour fournir une configuration spécifique au modèle utilisé. Par exemple, le modèle Llama-02 peut utiliser {"temperature » :0.4}. Faire défaut: {} | Non |

| deployment_name | string | Le nom du déploiement à cibler sur le point de terminaison d’inférence en ligne. Si aucune valeur n’est passée, les paramètres de trafic de l’équilibreur de charge d’inférence sont utilisés. | Non |

| prompt | string | L’invite de texte utilisée par le modèle de langage pour générer sa réponse. | Oui |

Sorties

| API | Type de retour | Description |

|---|---|---|

| Completion | string | Texte d’un achèvement prédit |

| Conversation | string | Le texte d’une réponse dans la conversation |

Déploiement sur un point de terminaison en ligne

Lorsque vous déployez un flux contenant l’outil Open Model LLM sur un point de terminaison en ligne, il existe une étape supplémentaire pour configurer des autorisations. Pendant le déploiement via les pages web, il existe un choix entre les types d’identité attribués par le système et attribués par l’utilisateur. Dans les deux cas, à l’aide de la Portail Azure (ou d’une fonctionnalité similaire), ajoutez le rôle de fonction de travail « Lecteur » à l’identité sur l’espace de travail Azure Machine Learning ou le projet Ai Studio, qui héberge le point de terminaison. Le déploiement de flux d’invite peut avoir besoin d’être actualisé.