Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Azure Managed Instance pour Apache Cassandra dispose désormais d’une fonctionnalité de mise en cache double écriture (préversion) via l’utilisation de machines virtuelles de série L. Cette implémentation vise à réduire la latence de fin et à améliorer les performances de lecture, en particulier pour les charges de travail gourmandes en lecture. Ces types de machines virtuelles spécifiques sont équipés de disques attachés localement pour augmenter les opérations d’entrée/sortie par seconde (IOPS) pour les opérations de lecture et réduire la latence de fin.

Important

La mise en cache double écriture est en préversion publique. Cette fonctionnalité est fournie sans contrat de niveau de service, nous la déconseillons dans des charges de travail de production. Pour plus d’informations, consultez Conditions d’Utilisation Supplémentaires relatives aux Évaluations Microsoft Azure.

Avantages de l’utilisation de la mise en cache double écriture

Latence de fin réduite : cette implémentation se concentre sur la réduction de la latence de fin pour améliorer l’expérience utilisateur, en particulier dans les applications sensibles au temps, en réduisant les retards dans les opérations de lecture.

Optimisation des charges de travail gourmandes en lecture : cette implémentation concerne les scénarios avec de lourdes charges de travail de lecture. La conception cible spécifiquement et améliore les performances de lecture. Elle tient compte des exigences des applications où les opérations de lecture fréquentes sont la norme.

Habilitation des disques localisés : les types de machines virtuelles désignés présentent des disques attachés localement, un élément clé qui permet à l’architecture d'augmenter l'IOPS pour les opérations de lecture. Ce choix de conception vise à optimiser l’efficacité et la réactivité de l’extraction de données.

Augmentation des IOPS : les disques NVMe (Nonvolatile Memory Express) attachés localement augmentent les IOPS pour les lectures et réduisent la latence de fin. Cette implémentation vise à fournir une solution complète qui traite les goulots d’étranglement des performances pour les charges de travail gourmandes en lecture.

Comment accéder aux machines virtuelles de série L

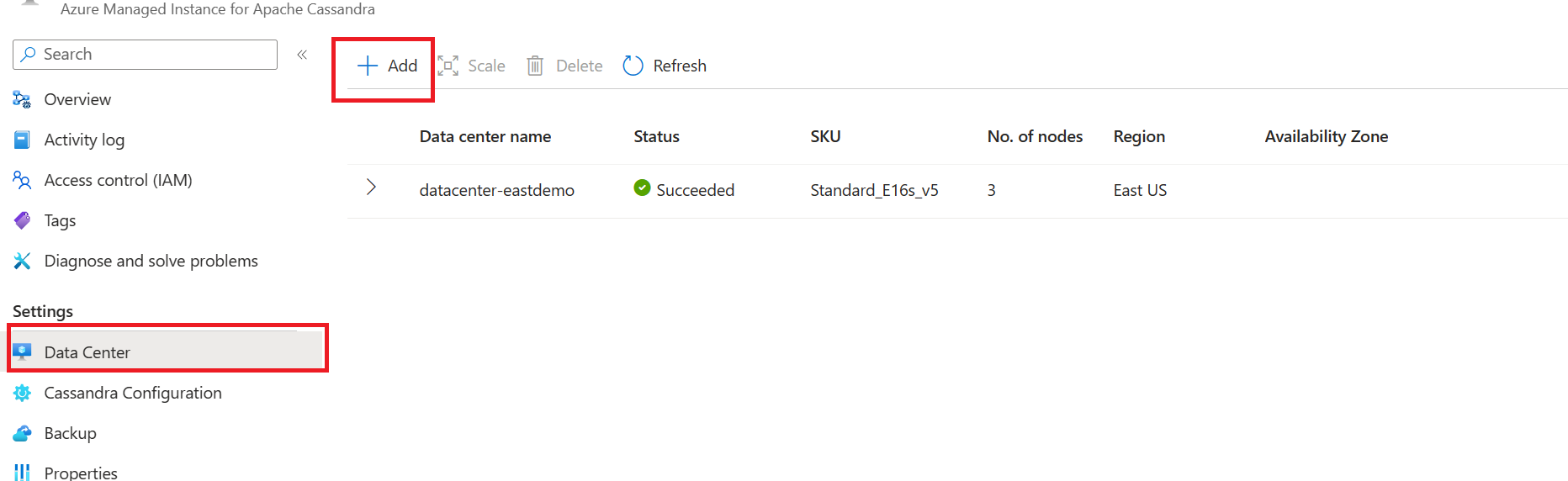

Pour les clusters Azure Managed Instance pour Apache Cassandra existants, vous pouvez accéder aux machines virtuelles de série L en ajoutant un nouveau centre de données :

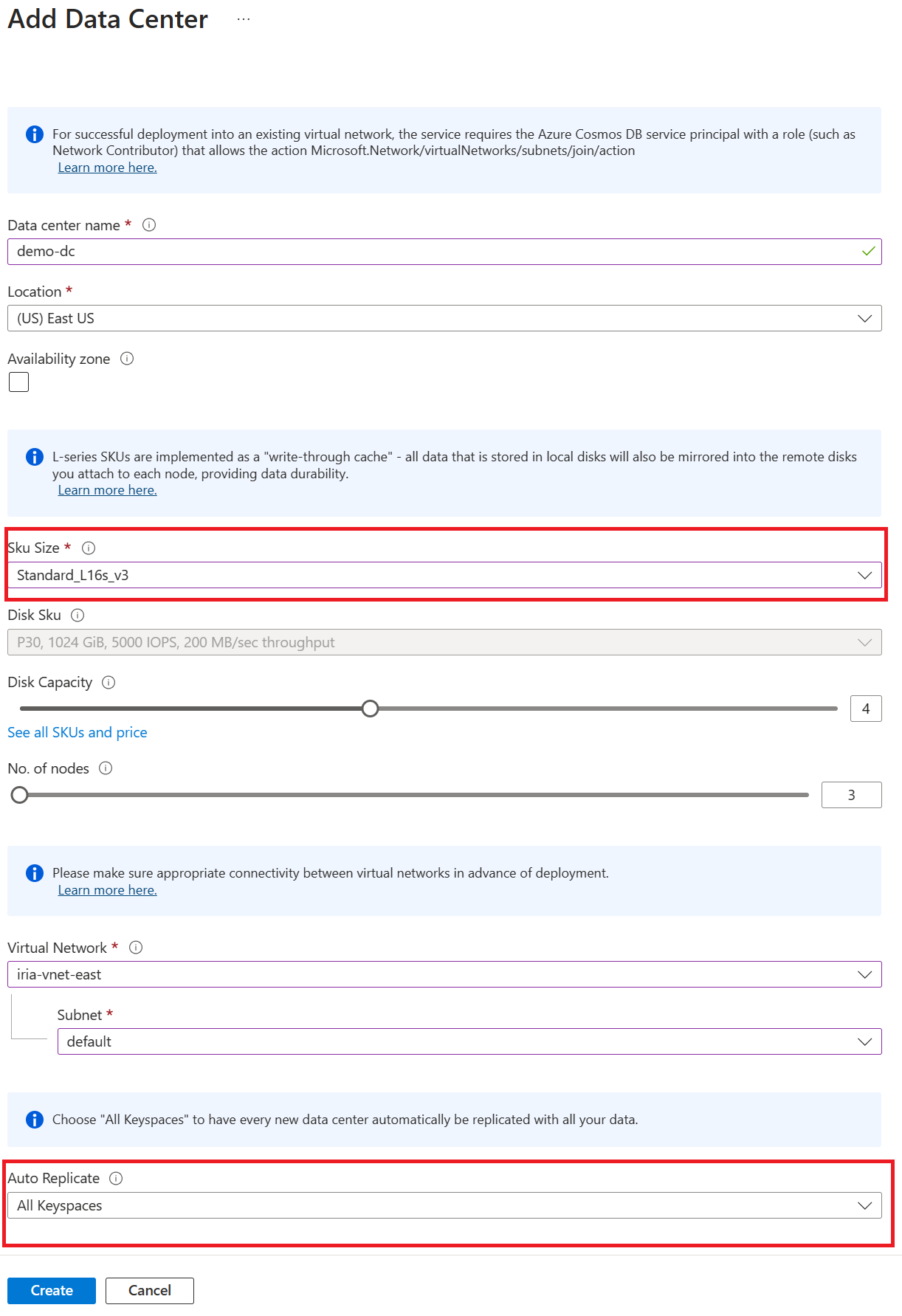

Dans le volet Centre de données, sélectionnez le bouton Ajouter.

Dans la zone Taille de la référence SKU, sélectionnez le type de machine virtuelle de série L de votre choix.

Remarque

Vous pouvez accéder à de nouvelles fonctionnalités de réplication automatique lorsque vous ajoutez un nouveau centre de données. Plus d’informations

Après avoir créé le centre de données, vérifiez qu’il apparaît dans votre liste de centres de données.

Scénario gourmand en lecture avec la mise en cache double écriture

L’analyse suivante explore un exemple de test qui compare les IOPS et la latence entre les disques managés Premium et NVMe pour les lectures. Grâce à un examen détaillé des métriques de performances dans cette comparaison, vous pouvez obtenir des insights précieux sur l’efficacité de la mise en cache double écriture pour les disques NVMe attachés localement.

IOPS pour les disques managés Premium et les disques NVMe locaux

L’exemple suivant montre les IOPS d’un tableau RAID 0 avec quatre disques managés Premium (configuration actuelle).

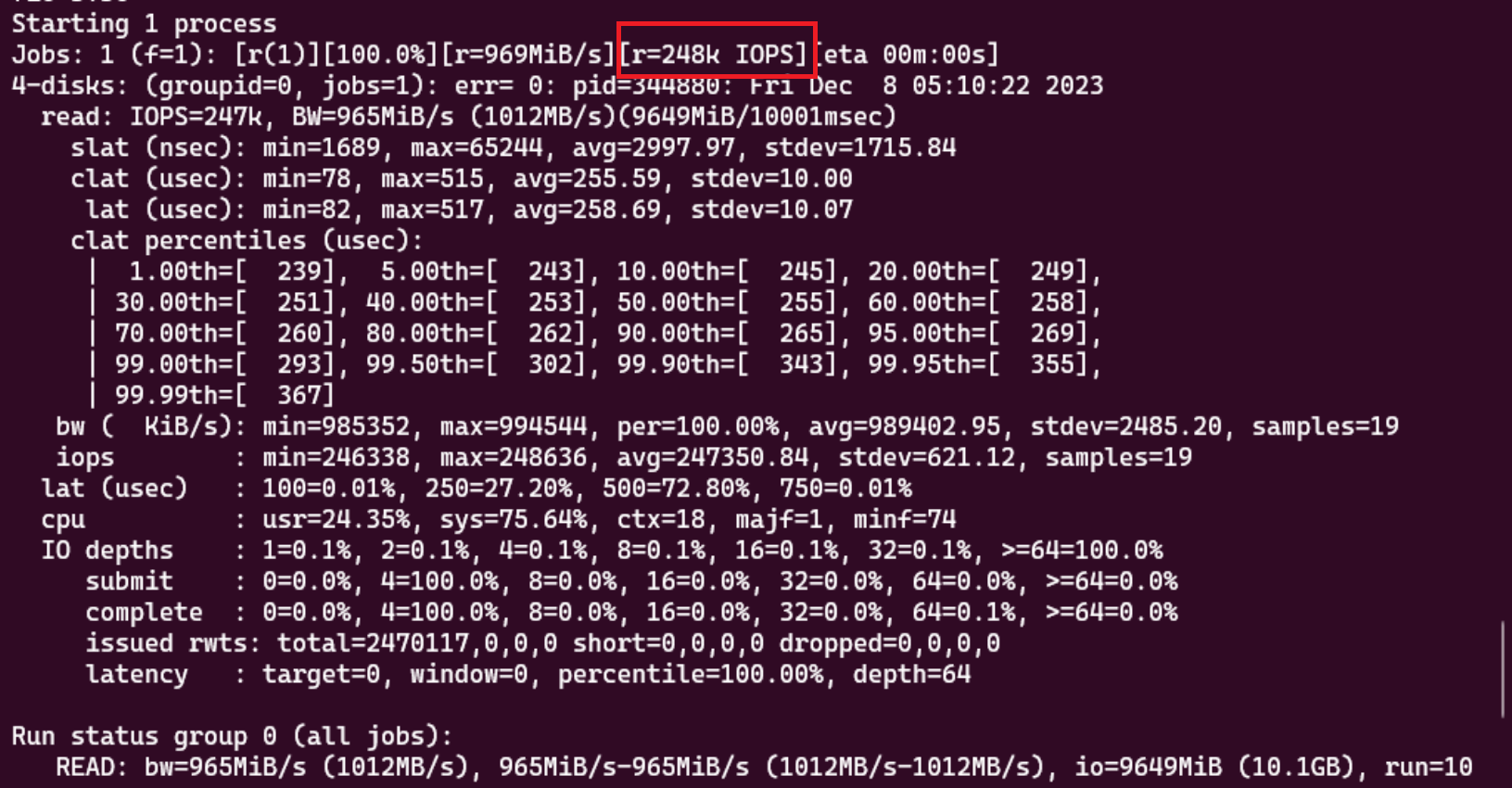

L’exemple suivant montre les IOPS d’un tableau RAID 1 avec des disques NVMe locaux et des disques managés Premium.

L’exemple qui utilise des disques NVMe attachés localement a une meilleure performance de lecture de 248K IOPS.

Latence pour les disques managés Premium et les disques NVMe locaux

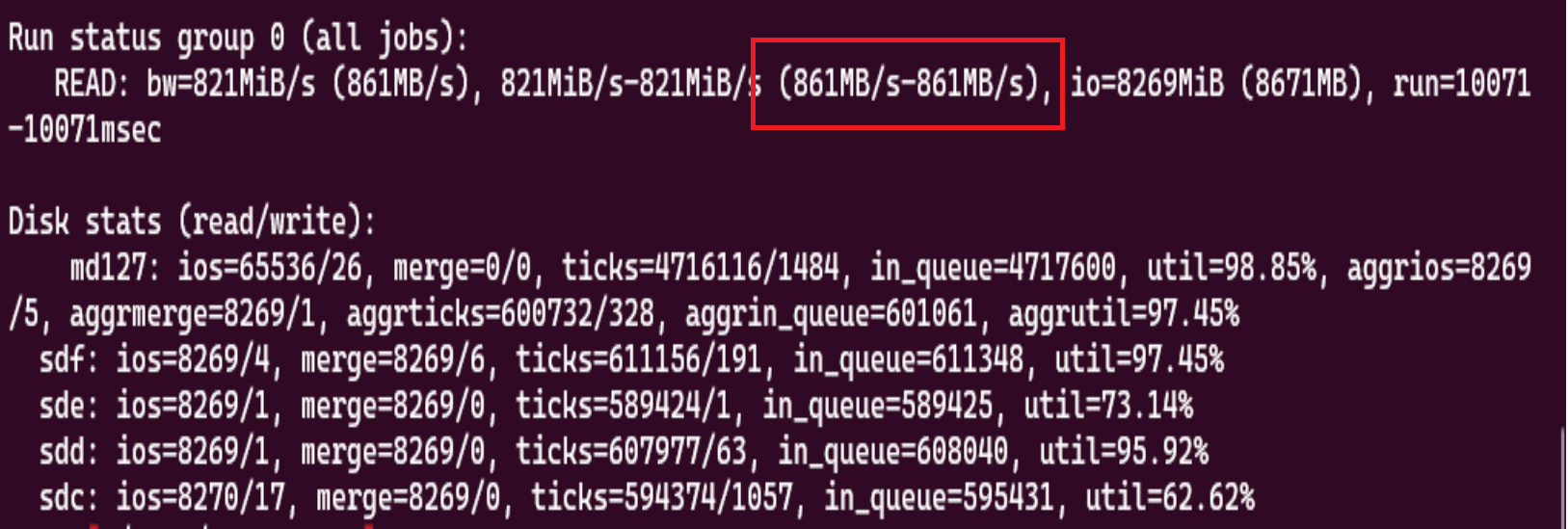

L’exemple suivant montre le débit d’un tableau RAID 0 avec quatre disques managés Premium (configuration actuelle).

L’exemple suivant montre le débit d’un tableau RAID 1 avec des disques NVMe locaux et des disques managés Premium.

L’exemple qui utilise des disques NVMe attachés localement a une capacité de débit plus élevée de 14,9 Gbits/s.

Remarque

Les disques locaux sont éphémères et peuvent être perdus. Toutefois, les données restent intactes dans les disques managés Premium attachés au réseau, car nous mettons en miroir les données entre elles à l’aide de la technologie RAID. Vous pouvez surveiller l’intégrité du tableau RAID via les métriques Azure Monitor de RaidArrayDegradedMetric et RaidArrayRebuildMetric.