Capturer des données à partir d’Event Hubs au format Parquet

Cet article explique comment utiliser l’éditeur sans code pour capturer automatiquement des données de streaming dans Event Hubs dans un compte Azure Data Lake Storage Gen2 au format Parquet.

Prérequis

Un espace de noms Azure Event Hubs avec un hub d’événements et un compte Azure Data Lake Storage Gen2 avec un conteneur pour stocker les données capturées. Ces ressources doivent être accessibles publiquement et ne peuvent pas résider derrière un pare-feu ou être sécurisées dans un réseau virtuel Azure.

Si vous n’avez pas de hub d’événements, créez-en un en suivant les instructions dans Démarrage rapide : Créer un hub d’événements.

Si vous n’avez pas de compte Data Lake Storage Gen2, créez-en un en suivant les instructions dans Créer un compte de stockage

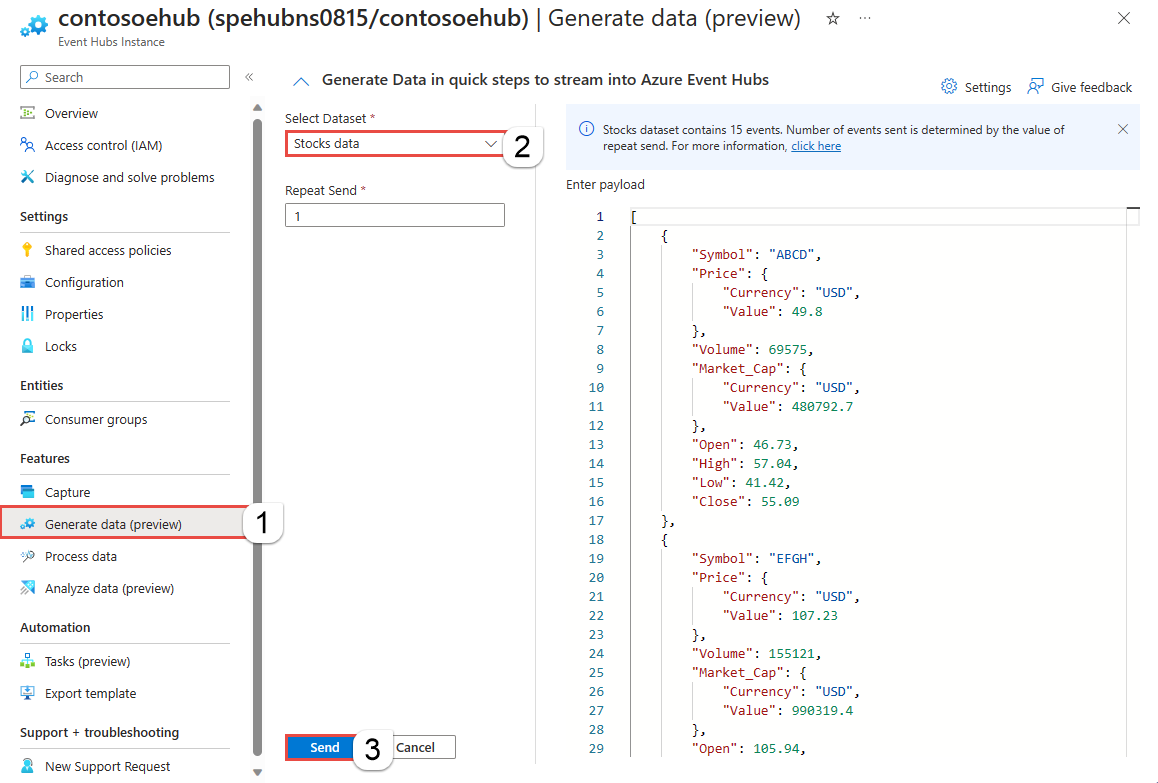

Les données de votre Event Hubs doivent être sérialisées au format JSON, CSV ou Avro. À des fins de test, sélectionnez Générer des données (préversion) dans le menu de gauche, sélectionnez Données de stock pour le jeu de données, puis sélectionnez Envoyer.

Configurer un travail pour capturer des données

Procédez comme suit pour configurer un travail Stream Analytics pour capturer des données dans Azure Data Lake Storage Gen2.

Dans le portail Azure, accédez à votre hub d’événements.

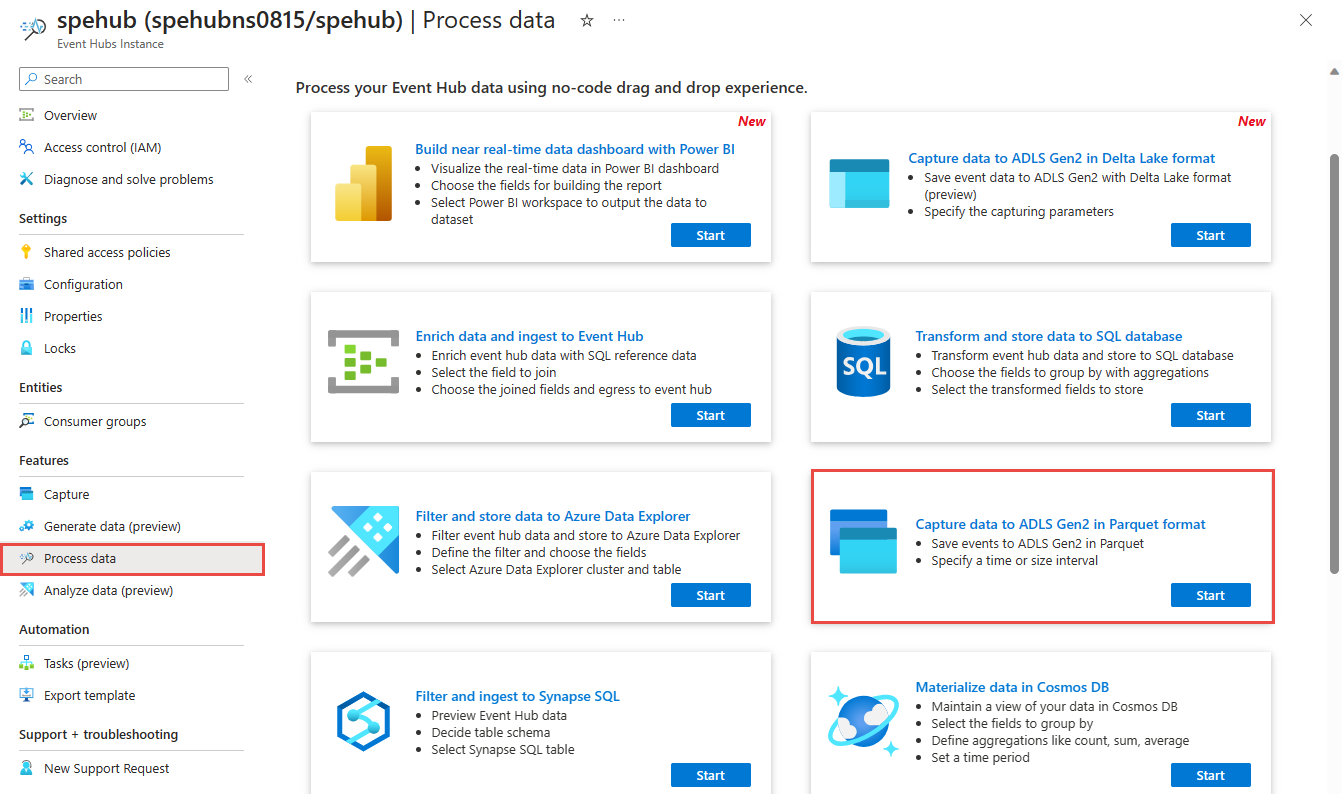

Dans le menu de gauche, sélectionnez Traiter les données sous Fonctionnalités. Puis, sélectionnez Démarrer sur la carte Capturer des données dans ADLS Gen2 au format Parquet.

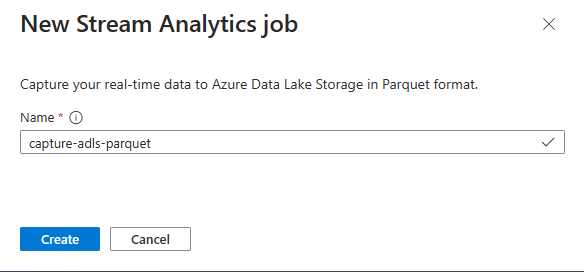

Saisissez un nom pour votre tâche Stream Analytics, puis sélectionnez Créer.

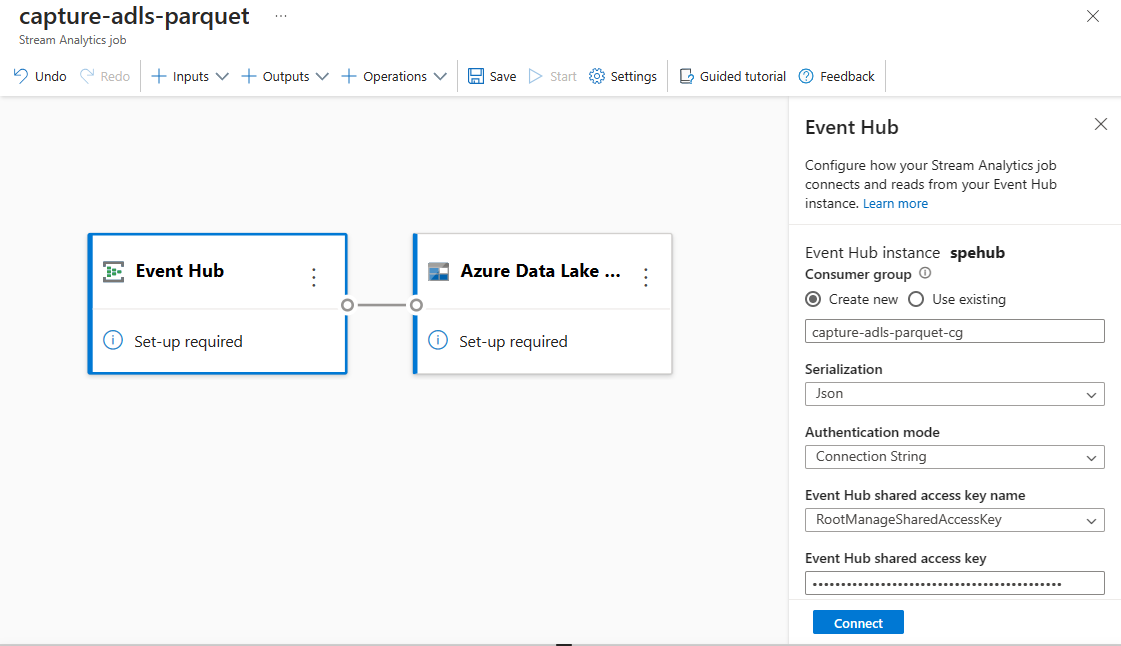

Spécifiez le type de Sérialisation de vos données dans Event Hubs et la méthode d’authentification que la tâche utilise pour se connecter aux Event Hubs. Sélectionnez Connecter.

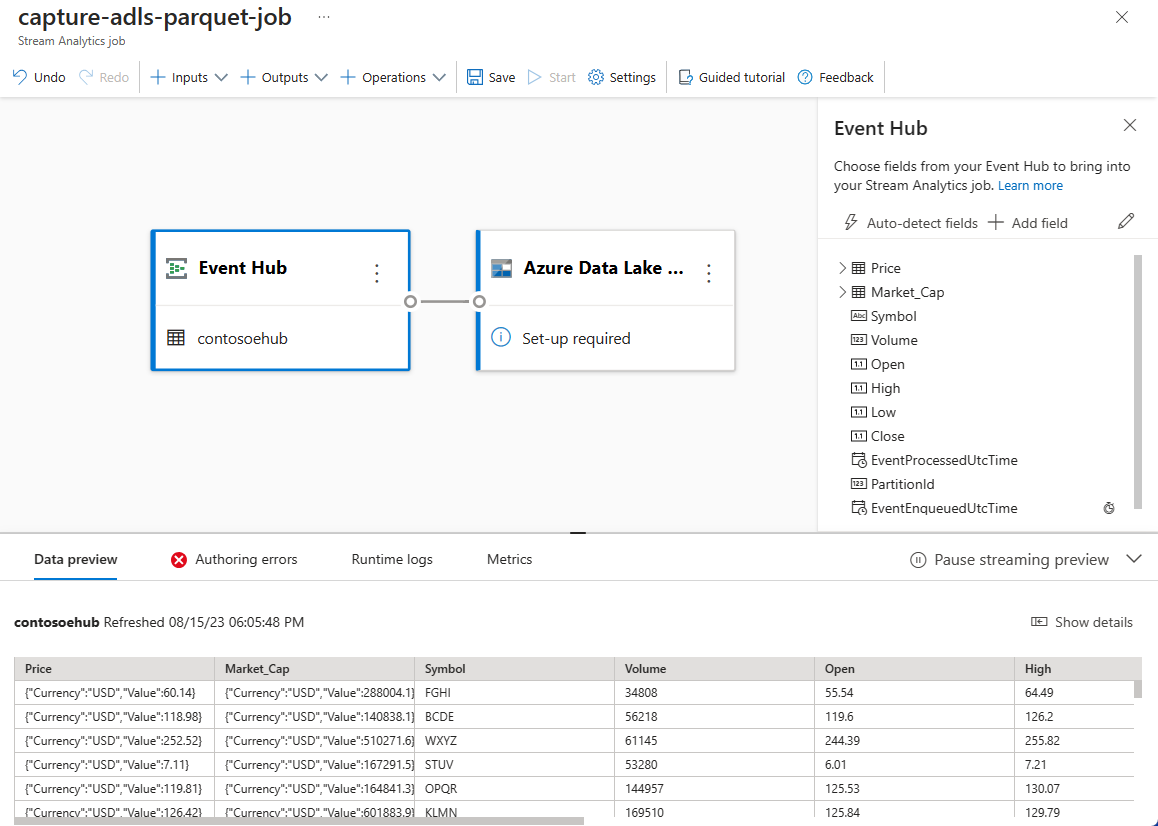

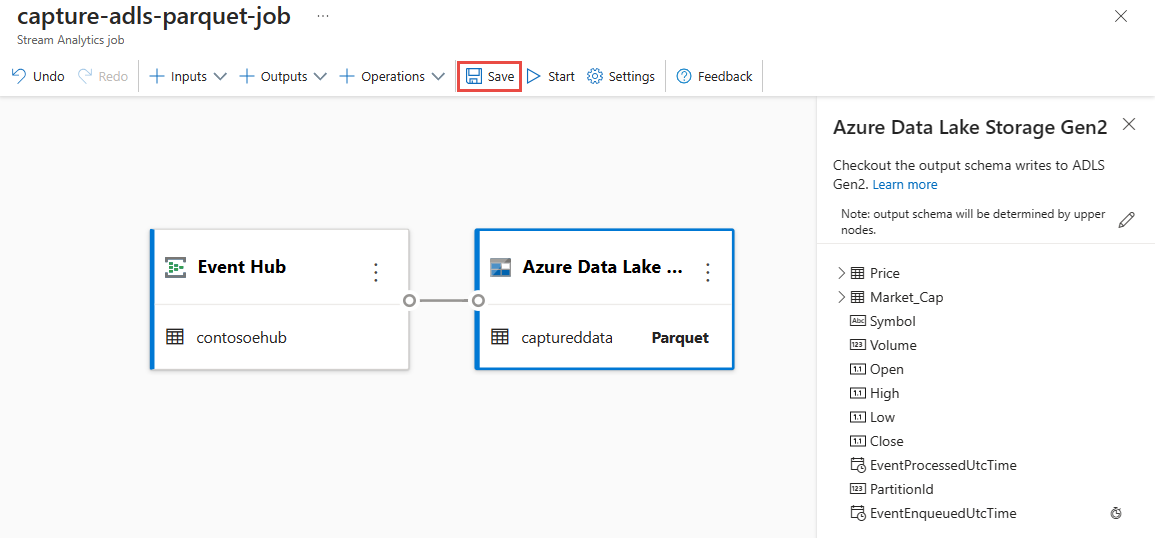

Une fois la connexion établie, vous pouvez voir :

Champs présents dans les données d’entrée. Vous pouvez choisir Ajouter un champ ou sélectionner le symbole trois points en regard d’un champ pour éventuellement supprimer, renommer ou modifier son nom.

Exemple dynamique de données entrantes dans la table d’aperçu des données sous la vue diagramme. Il s’actualise à intervalles réguliers. Vous pouvez sélectionner Suspendre la préversion de streaming pour afficher une vue statique des exemples de données d’entrée.

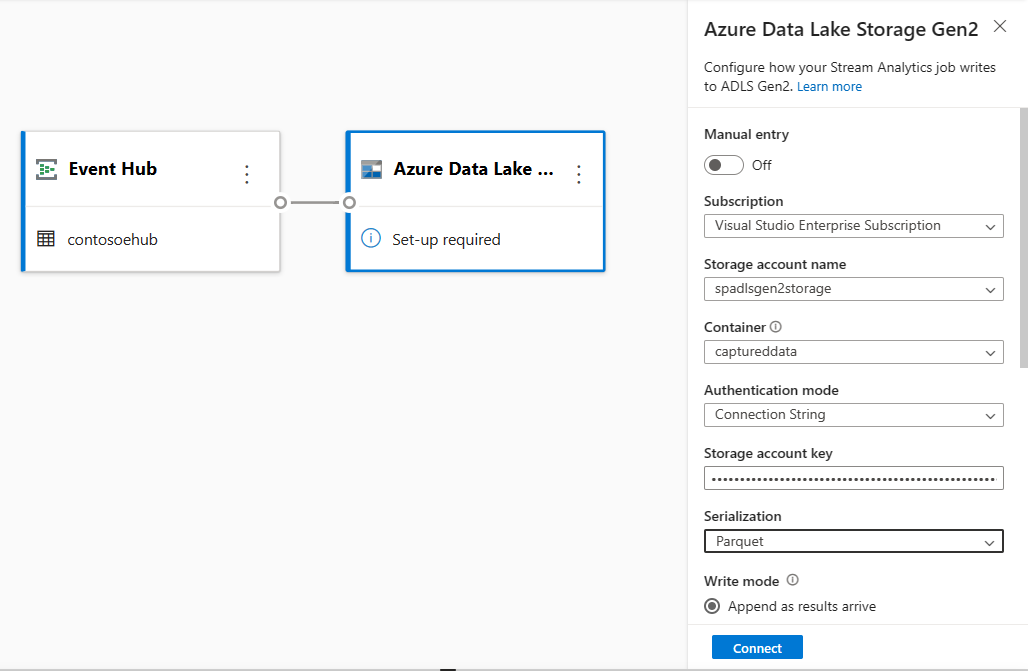

Sélectionnez la vignette Azure Data Lake Storage Gen2 pour modifier la configuration.

Dans la page de configuration Azure Data Lake Storage Gen2, effectuez ces étapes :

Sélectionnez l’abonnement, le nom du compte de stockage et le conteneur dans le menu déroulant.

Une fois l’abonnement sélectionné, la méthode d’authentification et la clé de compte de stockage doivent être renseignées automatiquement.

Sélectionnez Parquet pour le format Sérialisation.

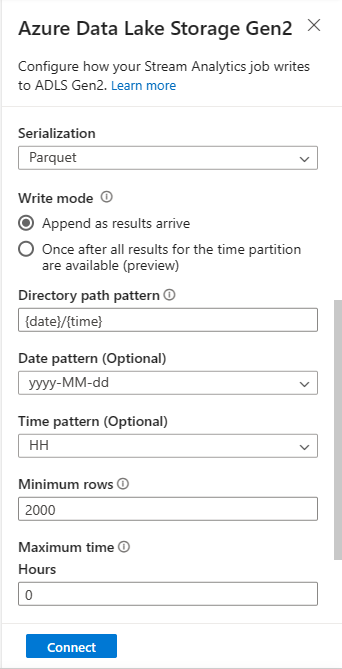

Pour les objets blob de streaming, le modèle de chemin de répertoire est censé être une valeur dynamique. Il est requis pour que la date fasse partie du chemin de fichier de l’objet blob, avec la référence

{date}. Pour en savoir plus sur les modèles de chemin d’accès personnalisés, consultez Partitionnement personnalisé de la sortie des objets blob Azure Stream Analytics.Sélectionnez Se connecter.

Une fois la connexion établie, vous pouvez voir les champs présents dans les données de sortie.

Sélectionnez Enregistrer dans la barre de commandes pour enregistrer votre configuration.

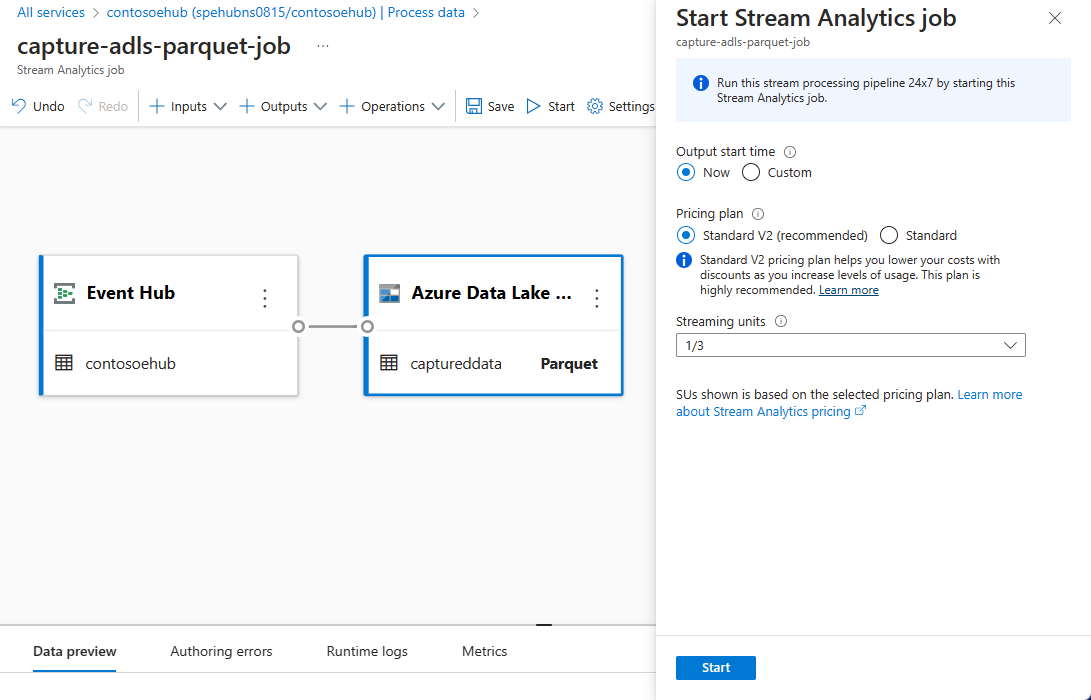

Sélectionnez Démarrer dans la barre de commandes pour démarrer le flux de streaming et capturer des données. Ensuite, dans la fenêtre Démarrer le travail Stream Analytics :

Sélectionnez l’heure de début de sortie.

Sélectionnez le niveau tarifaire.

Sélectionnez le nombre d’unités de streaming (SU) avec laquelle le travail s’exécute. Les SU représentent les ressources de calcul allouées pour exécuter un travail Stream Analytics. Pour plus d’informations, voir Unités de streaming dans Azure Stream Analytics.

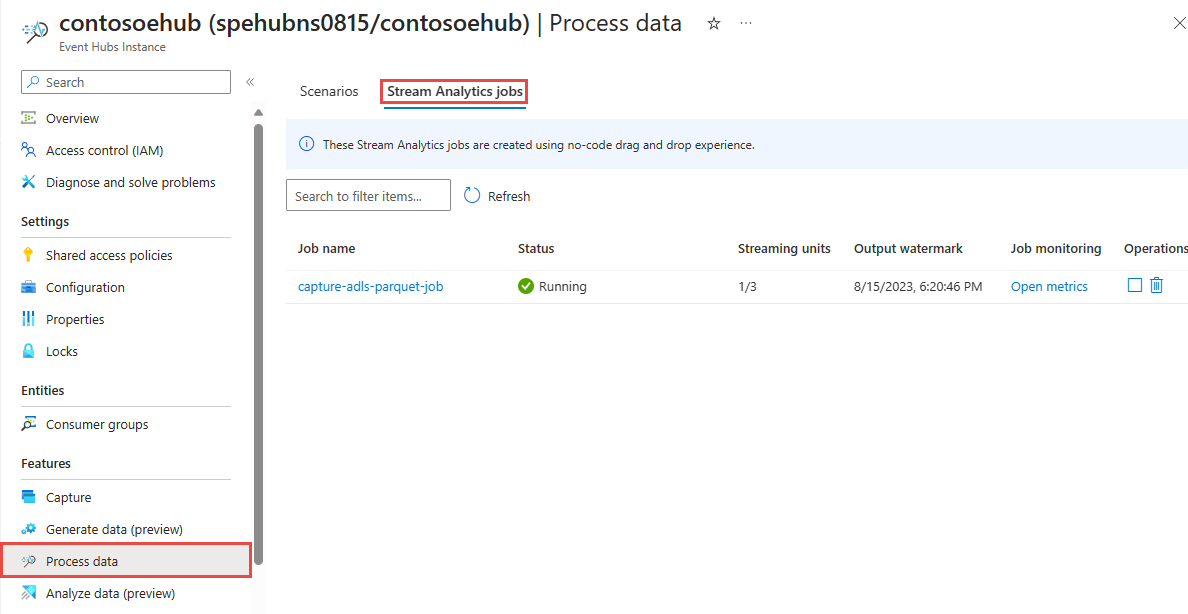

Vous devriez voir la tâche Stream Analytics sous l’onglet Tâche Stream Analytics de la page Traiter les données de votre hub d’événements.

Vérifier la sortie

Dans la page d’instance Event Hubs pour votre hub d’événements, sélectionnez Générer des données, sélectionnez Données de stock pour jeu de données, puis sélectionnez Envoyer pour envoyer des exemples de données au hub d’événements.

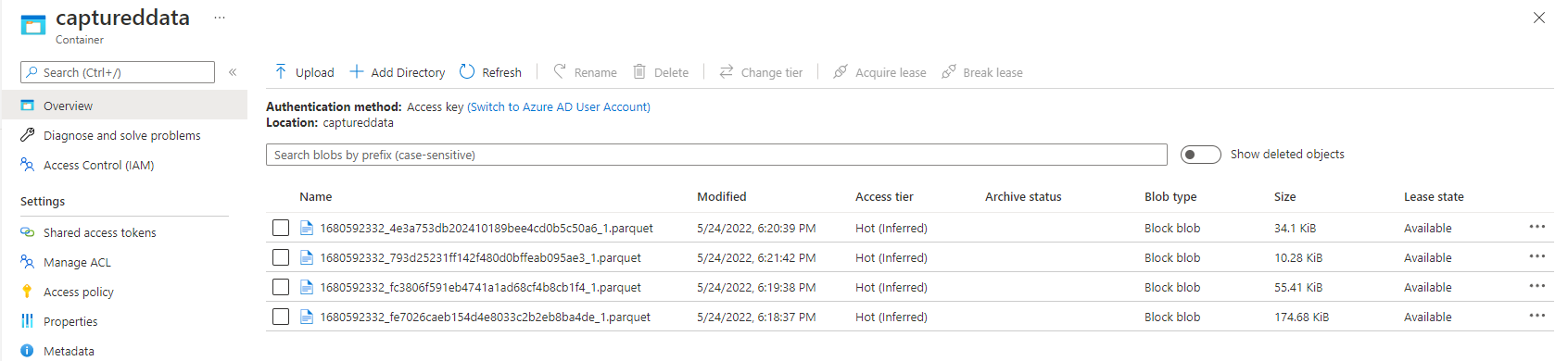

Vérifiez que les fichiers Parquet sont générés dans le conteneur Azure Data Lake Storage.

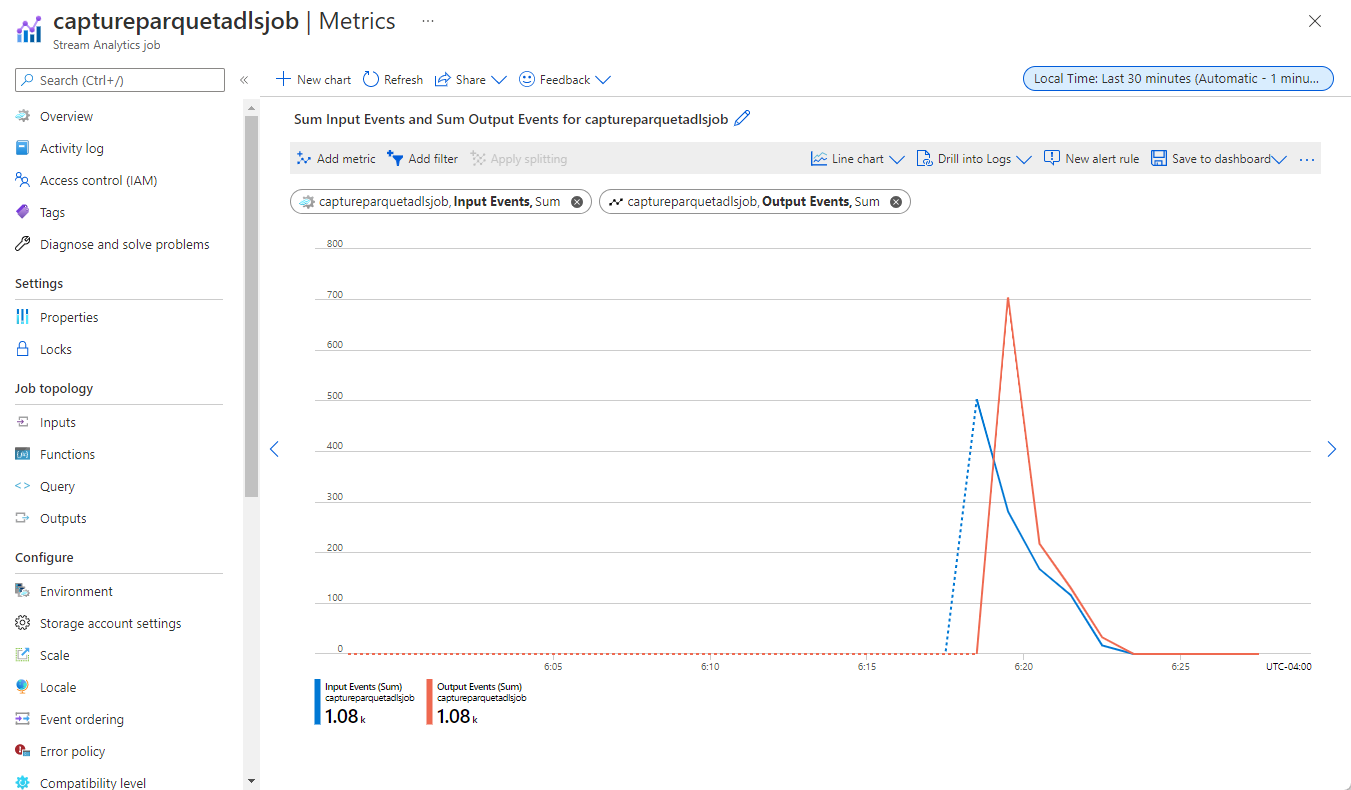

Sélectionnez Traiter des données dans le menu de gauche. Basculez sur l’onglet Tâches Stream Analytics. Sélectionnez Ouvrir les métriques pour les surveiller.

Voici un exemple de capture d’écran des métriques montrant les événements d’entrée et de sortie.

Étapes suivantes

Maintenant, vous savez comment utiliser l’éditeur no code Stream Analytics pour créer un travail qui capture les données Event Hubs dans Azure Data Lake Storage Gen2 au format Parquet. Ensuite, vous pouvez en savoir plus sur Azure Stream Analytics et comment surveiller le travail que vous avez créé.