Comment créer des pools Spark personnalisés dans Microsoft Fabric

Dans ce document, nous expliquons comment créer des pools Apache Spark personnalisés dans Microsoft Fabric pour vos charges de travail d’analytique. Les pools Apache Spark permettent aux utilisateurs de créer des environnements de calcul personnalisés en fonction de leurs besoins spécifiques, ce qui garantit des performances et une utilisation optimale des ressources.

Vous spécifiez les nœuds minimum et maximum pour la mise à l'échelle automatique. En fonction de ces valeurs, le système acquiert et met hors service dynamiquement des nœuds à mesure que les exigences de calcul du travail changent, ce qui se traduit par une mise à l’échelle efficace et une amélioration des performances. L'allocation dynamique des exécuteurs dans les pools Spark réduit également le besoin de configuration manuelle des exécuteurs. Au lieu de cela, le système ajuste le nombre d’exécuteurs en fonction du volume de données et des besoins de calcul au niveau du travail. Ce processus vous permet de vous concentrer sur vos charges de travail sans vous soucier de l’optimisation des performances et de la gestion des ressources.

Remarque

Pour créer un pool Spark personnalisé, vous avez besoin d’un accès administrateur à l’espace de travail. L’administrateur de capacité doit activer l’option Pools d’espaces de travail personnalisés dans la section Calcul Spark des paramètres de capacité Administration. Pour plus d’informations, consultez Paramètres de calcul Spark pour les capacités d’infrastructure.

Créer des pools Spark personnalisés

Pour créer ou gérer le pool Spark associé à votre espace de travail :

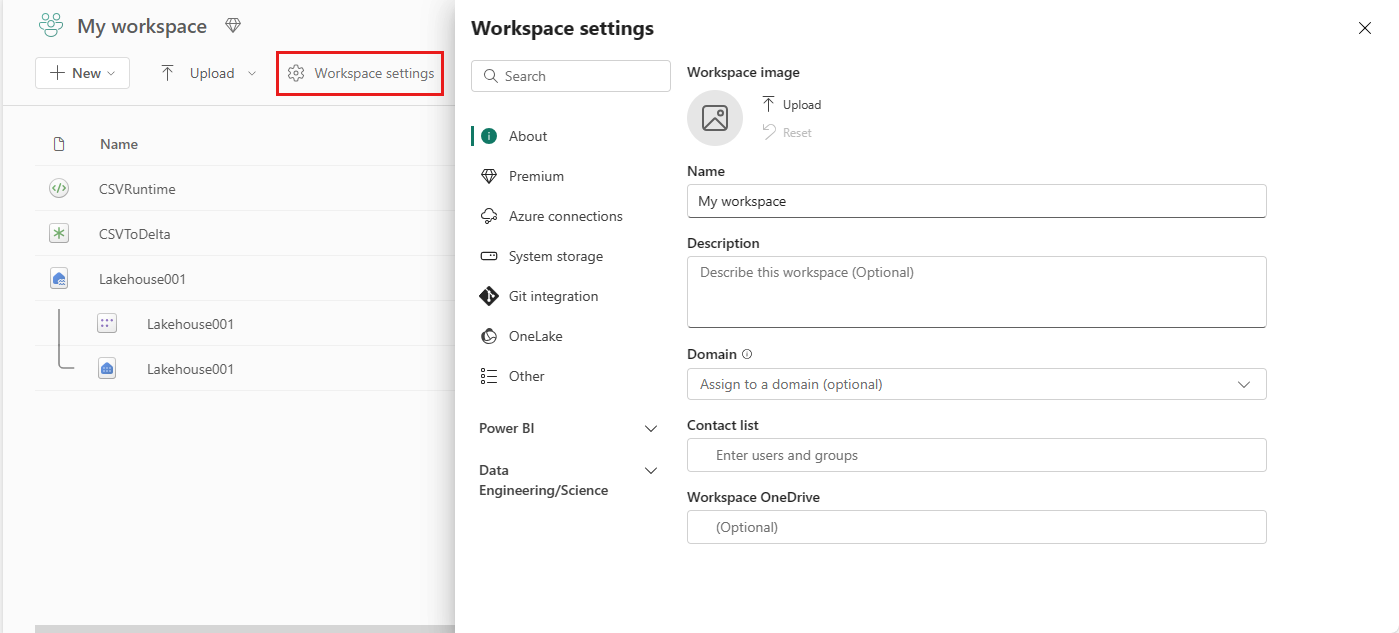

Accédez à votre espace de travail et sélectionnez Paramètres de l'espace de travail.

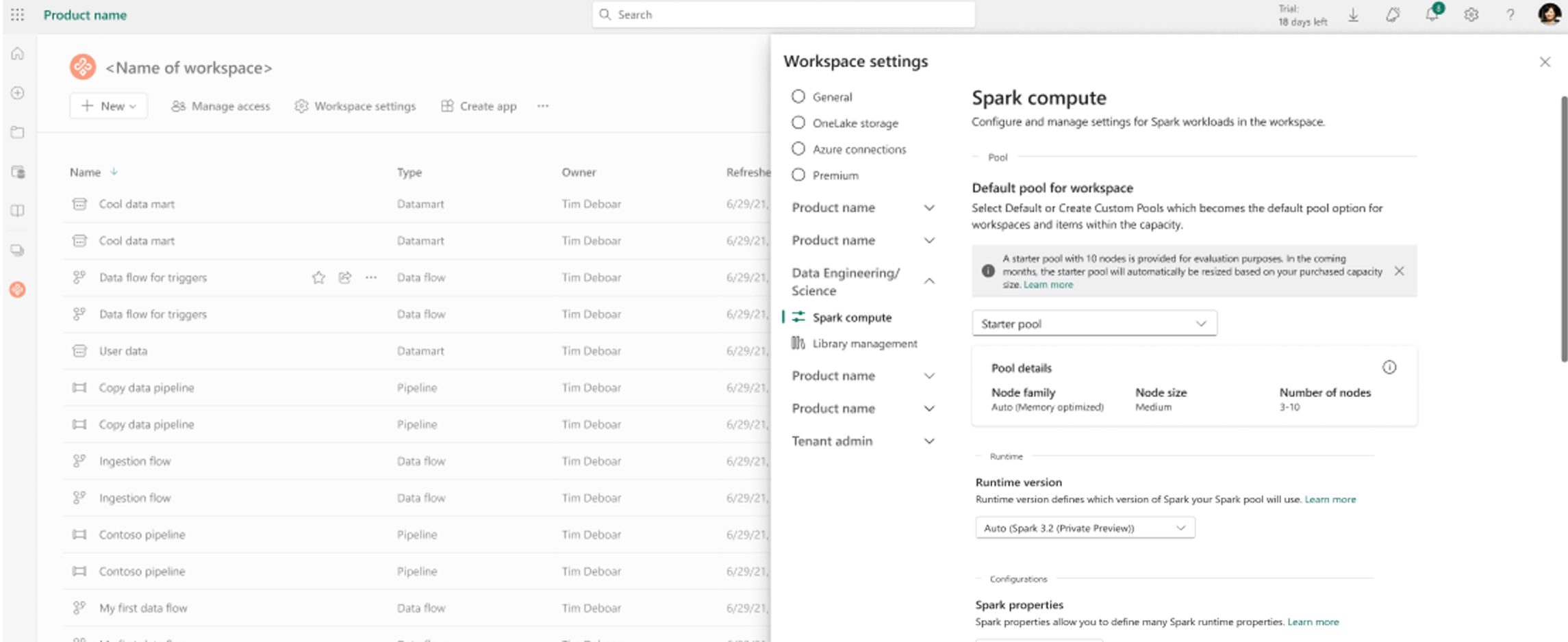

Sélectionnez l’option Data Engineering/Science pour développer le menu, puis sélectionnez Spark Compute.

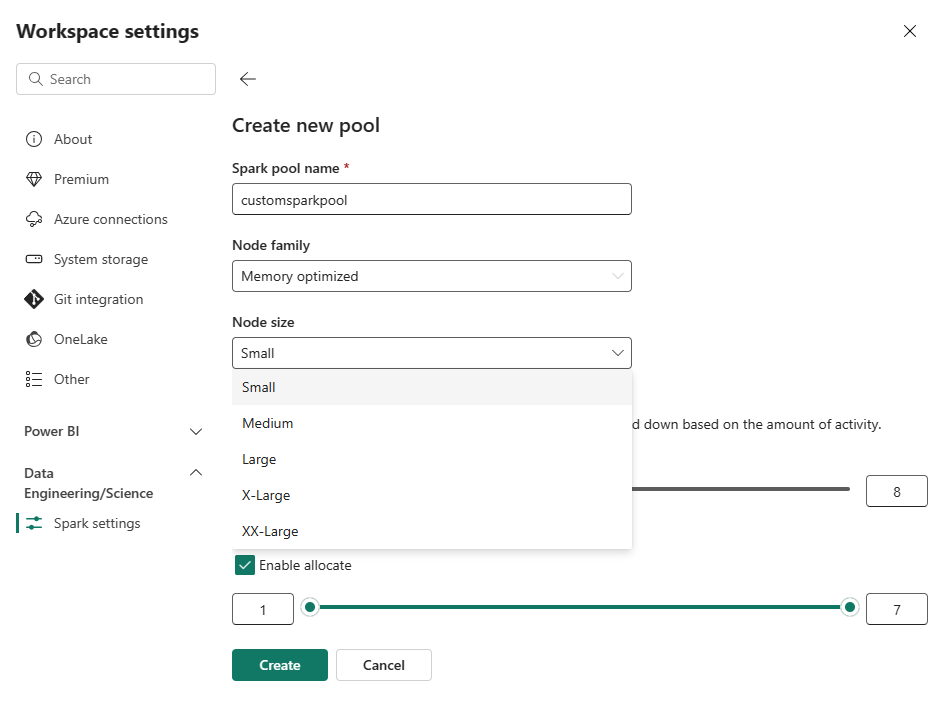

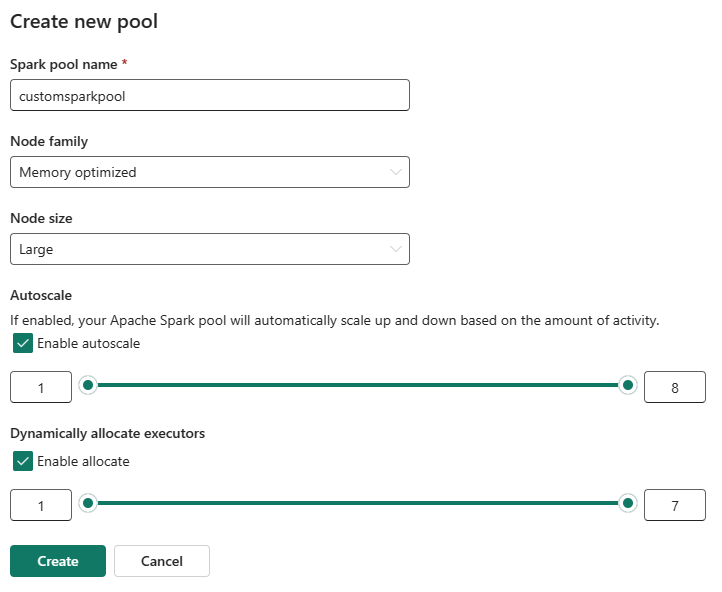

Sélectionnez l’option Nouveau pool. Dans l’écran Créer un pool, nommez votre pool Spark. Choisissez également la famille Node et sélectionnez une taille de nœud parmi les tailles disponibles (Small, Medium, Large, X-Large et XX-Large) en fonction des exigences de calcul de vos charges de travail.

Vous pouvez définir la configuration minimale des nœuds pour vos pools personnalisés sur 1. Étant donné que Fabric Spark offre une disponibilité restaurable pour les clusters avec un seul nœud, vous n'avez pas à vous soucier des échecs de tâches, de la perte de session en cas d'échec ou du paiement excessif du calcul pour les petites tâches Spark.

Vous pouvez activer ou désactiver la mise à l'échelle automatique pour vos pools Spark personnalisés. Lorsque la mise à l’échelle automatique est activée, le pool acquiert dynamiquement de nouveaux nœuds jusqu’à la limite maximale de nœuds spécifiée par l’utilisateur, puis les met hors service après l’exécution du travail. Cette fonctionnalité garantit de meilleures performances en ajustant les ressources en fonction des exigences du travail. Vous êtes autorisé à dimensionner les nœuds, qui s’intègrent dans les unités de capacité achetées dans le cadre de la référence SKU de capacité Fabric.

Vous pouvez également choisir d’activer l’allocation d’exécuteur dynamique pour votre pool Spark, ce qui détermine automatiquement le nombre optimal d’exécuteurs dans la limite maximale spécifiée par l’utilisateur. Cette fonctionnalité ajuste le nombre d’exécuteurs en fonction du volume de données, ce qui améliore les performances et l’utilisation des ressources.

Ces pools personnalisés ont une durée de remplissage automatique par défaut de 2 minutes. Une fois la durée de l’autopause atteinte, la session expire et les clusters ne sont pas alloués. Vous êtes facturé en fonction du nombre de nœuds et de la durée pendant laquelle les pools Spark personnalisés sont utilisés.

Contenu connexe

- Pour en savoir plus, consultez la documentation publique Apache Spark.

- Prise en main des paramètres d’administration de l’espace de travail Spark dans Microsoft Fabric.