Transférer des données en diffusion en continu dans le lakehouse et y accéder avec le point de terminaison d’analytique SQL

Ce guide de démarrage rapide explique comment créer une définition de tâche Spark qui contient du code Python avec le flux structuré Spark pour atterrir les données dans un lakehouse, puis les diffuser via un point de terminaison d’analytique SQL. Après avoir terminé ce démarrage rapide, vous disposez d'une définition de tâche Spark qui s'exécute en continu et le point de terminaison d’analytique SQL peut afficher les données entrantes.

Créer un script Python

Utilisez le code Python suivant qui utilise le streaming structuré Spark pour obtenir des données dans une table Lakehouse.

import sys from pyspark.sql import SparkSession if __name__ == "__main__": spark = SparkSession.builder.appName("MyApp").getOrCreate() tableName = "streamingtable" deltaTablePath = "Tables/" + tableName df = spark.readStream.format("rate").option("rowsPerSecond", 1).load() query = df.writeStream.outputMode("append").format("delta").option("path", deltaTablePath).option("checkpointLocation", deltaTablePath + "/checkpoint").start() query.awaitTermination()Enregistrez votre script en tant que fichier Python (.py) sur votre ordinateur local.

Créer un lakehouse.

Utilisez les étapes suivantes pour créer une maison du lac :

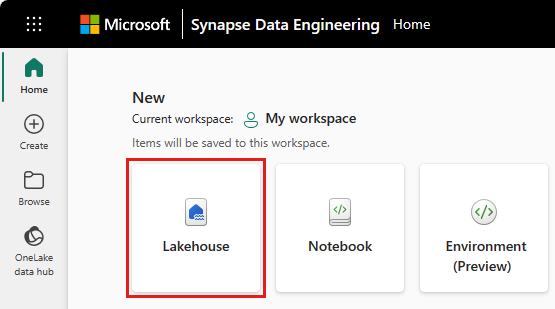

Dans Microsoft Fabric, sélectionnez l'expérience Synapse Data Engineering.

Accédez à l'espace de travail souhaité ou créez-en un nouveau si nécessaire.

Pour créer un Lakehouse, sélectionnez l'icône Lakehouse dans la section Nouveau du volet principal.

Entrez le nom de votre Lakehouse et sélectionnez Créer.

Créer une définition de tâche Spark

Utilisez les étapes suivantes pour créer une définition de tâche Spark :

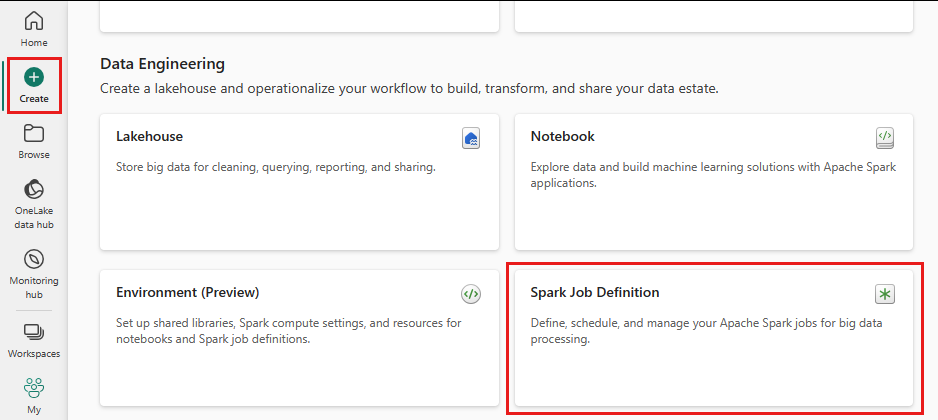

Dans le même espace de travail où vous avez créé une maison du lac, sélectionnez l'icône Créer dans le menu de gauche.

Sous "Ingénierie des données", sélectionnez Spark Job Definition.

Entrez le nom de votre définition de travail Spark, puis sélectionnez Créer.

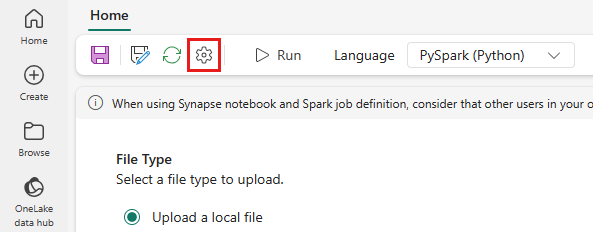

Sélectionnez Télécharger et sélectionnez le fichier Python que vous avez créé à l'étape précédente.

Sous Lakehouse Reference, choisissez le Lakehouse que vous avez créé.

Définir la stratégie de nouvelle tentative pour la définition de tâche Spark

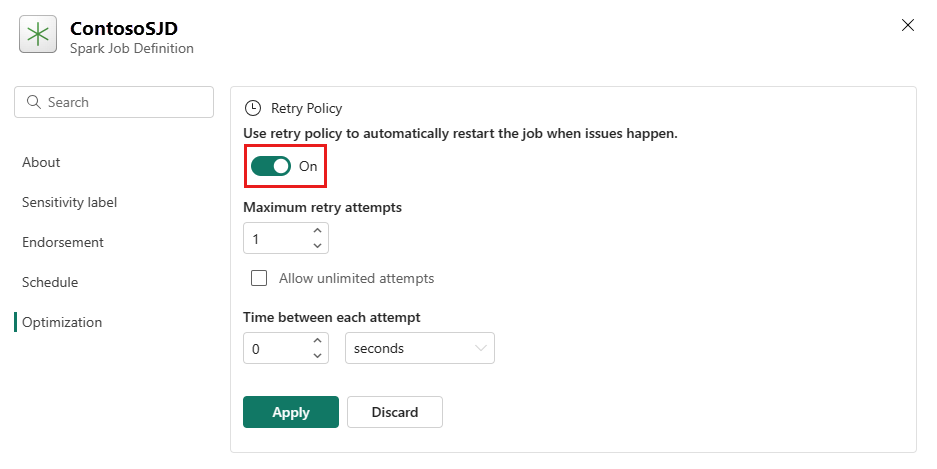

Utilisez les étapes suivantes pour définir la stratégie de nouvelle tentative pour votre définition de tâche Spark :

Dans le menu supérieur, sélectionnez l'icône Paramètres.

Ouvrez l’onglet Optimisation et définissez le déclencheur Stratégie de nouvelle tentativeActivé.

Définissez le nombre maximal de tentatives ou cochez Autoriser les tentatives illimitées.

Spécifiez le délai entre chaque nouvelle tentative et sélectionnez Appliquer.

Remarque

Il existe une limite de durée de vie de 90 jours pour la configuration de la stratégie de nouvelles tentatives. Une fois la stratégie de nouvelles tentatives activée, la tâche sera redémarré en fonction de la stratégie dans les 90 jours. Après cette période, la stratégie de nouvelles tentatives cesse automatiquement de fonctionner et la tâche est terminée. Les utilisateurs devront ensuite redémarrer manuellement la tâche, ce qui réactivera à son tour la stratégie de nouvelles tentatives.

Exécuter et surveiller la définition de tâche Spark

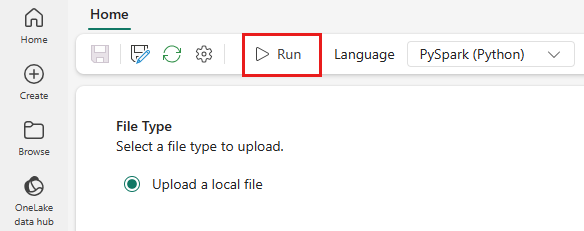

Dans le menu du haut, sélectionnez l'icône Exécuter.

Vérifiez si la définition de la tâche Spark a été soumise avec succès et en cours d'exécution.

Afficher les données à l'aide d'un point de terminaison d’analytique SQL

Dans la vue de l'espace de travail, sélectionnez votre Lakehouse.

Dans le coin droit, sélectionnez Lakehouse et le Point de terminaison d’analytique SQL.

Dans l’aperçu du point de terminaison d’analytique SQL sous Tables, sélectionnez la table que votre script utilise pour atterrir des données. Vous pouvez ensuite prévisualiser vos données à partir du point de terminaison d’analytique SQL.

Contenu connexe

Commentaires

Bientôt disponible : Tout au long de 2024, nous allons supprimer progressivement GitHub Issues comme mécanisme de commentaires pour le contenu et le remplacer par un nouveau système de commentaires. Pour plus d’informations, consultez https://aka.ms/ContentUserFeedback.

Envoyer et afficher des commentaires pour