Comment utiliser Data Wrangler sur des DataFrames Spark (Préversion)

Data Wrangler, un outil basé sur un notebook pour l’analyse exploratoire de données, prend désormais en charge les DataFrames Spark et les DataFrames Pandas, générant du code PySpark en plus du code Python. Pour obtenir une vue d’ensemble de Data Wrangler, qui explique comment explorer et transformer des DataFrames Pandas, consultez le tutoriel principal. Le tutoriel suivant montre comment utiliser Data Wrangler pour explorer et transformer des DataFrames Spark.

Important

Cette fonctionnalité est en préversion.

Prérequis

Obtenir un abonnement Microsoft Fabric. Ou, inscrivez-vous pour un essai gratuit de Microsoft Fabric.

Connectez-vous à Microsoft Fabric.

Utilisez le sélecteur d'expérience sur le côté gauche de votre page d'accueil pour passer à l'expérience science des données Synapse.

Lancement de Data Wrangler avec un DataFrame Spark

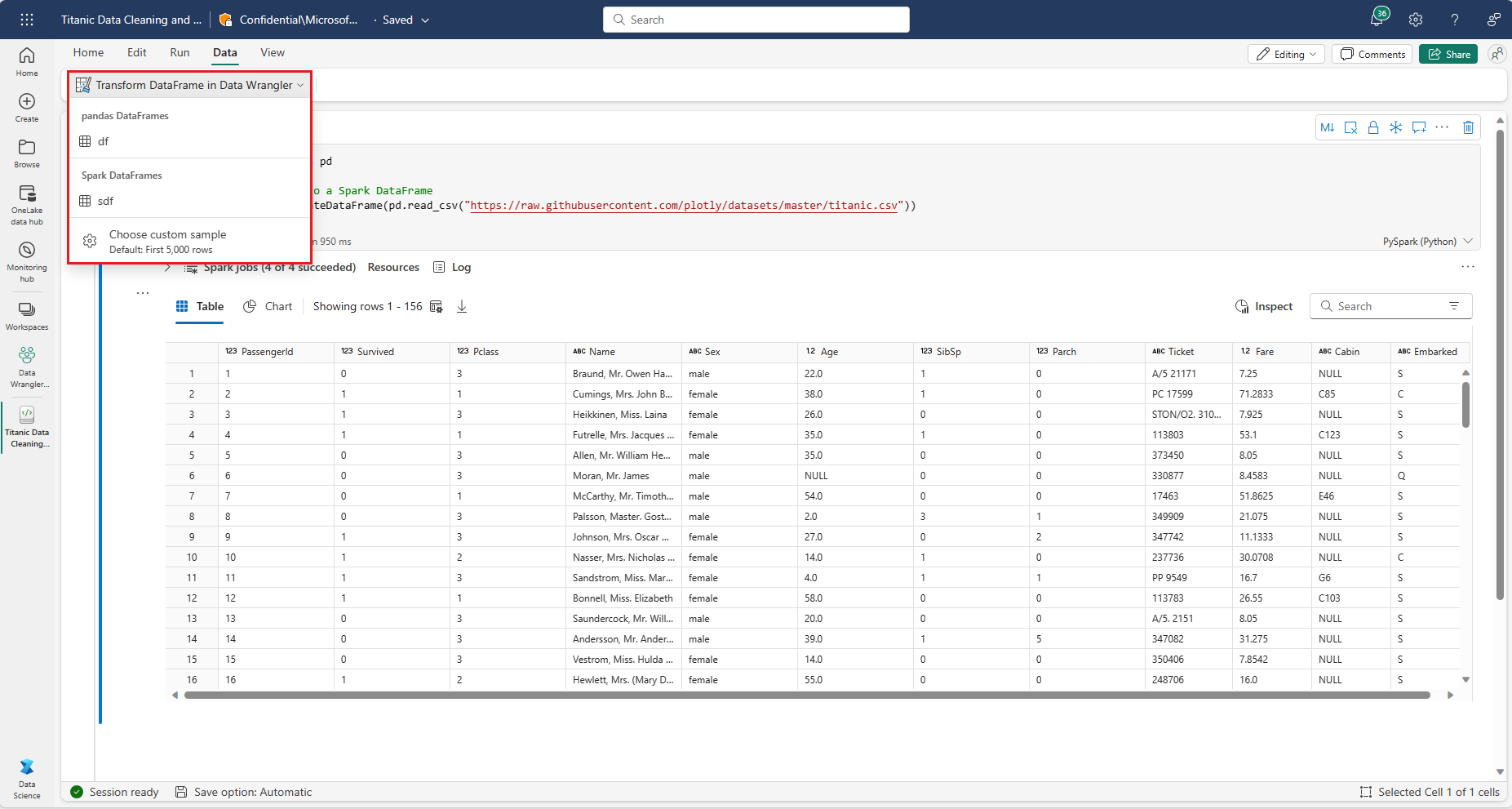

Les utilisateurs peuvent ouvrir des DataFrames Spark dans Data Wrangler directement à partir d’un notebook Microsoft Fabric, en accédant à la même invite de liste déroulante où les DataFrames Pandas sont affichés. Une liste des DataFrames Spark actifs apparaît dans la liste déroulante sous la liste des variables Pandas actives.

L’extrait de code suivant crée un DataFrame Spark avec les mêmes échantillons de données utilisés dans le tutoriel Data Wrangler Pandas :

import pandas as pd

# Read a CSV into a Spark DataFrame

df = spark.createDataFrame(pd.read_csv("https://raw.githubusercontent.com/plotly/datasets/master/titanic.csv"))

display(df)

Sous l’onglet «Données» du ruban de notebook, utilisez l’invite déroulante Data Wrangler pour parcourir les DataFrames actifs disponibles pour modification. Sélectionnez celui que vous souhaitez ouvrir dans Data Wrangler.

Conseil

Data Wrangler ne peut pas être ouvert si le noyau du notebook est occupé. Une cellule en cours d’exécution doit terminer son exécution avant que Data Wrangler puisse être lancé.

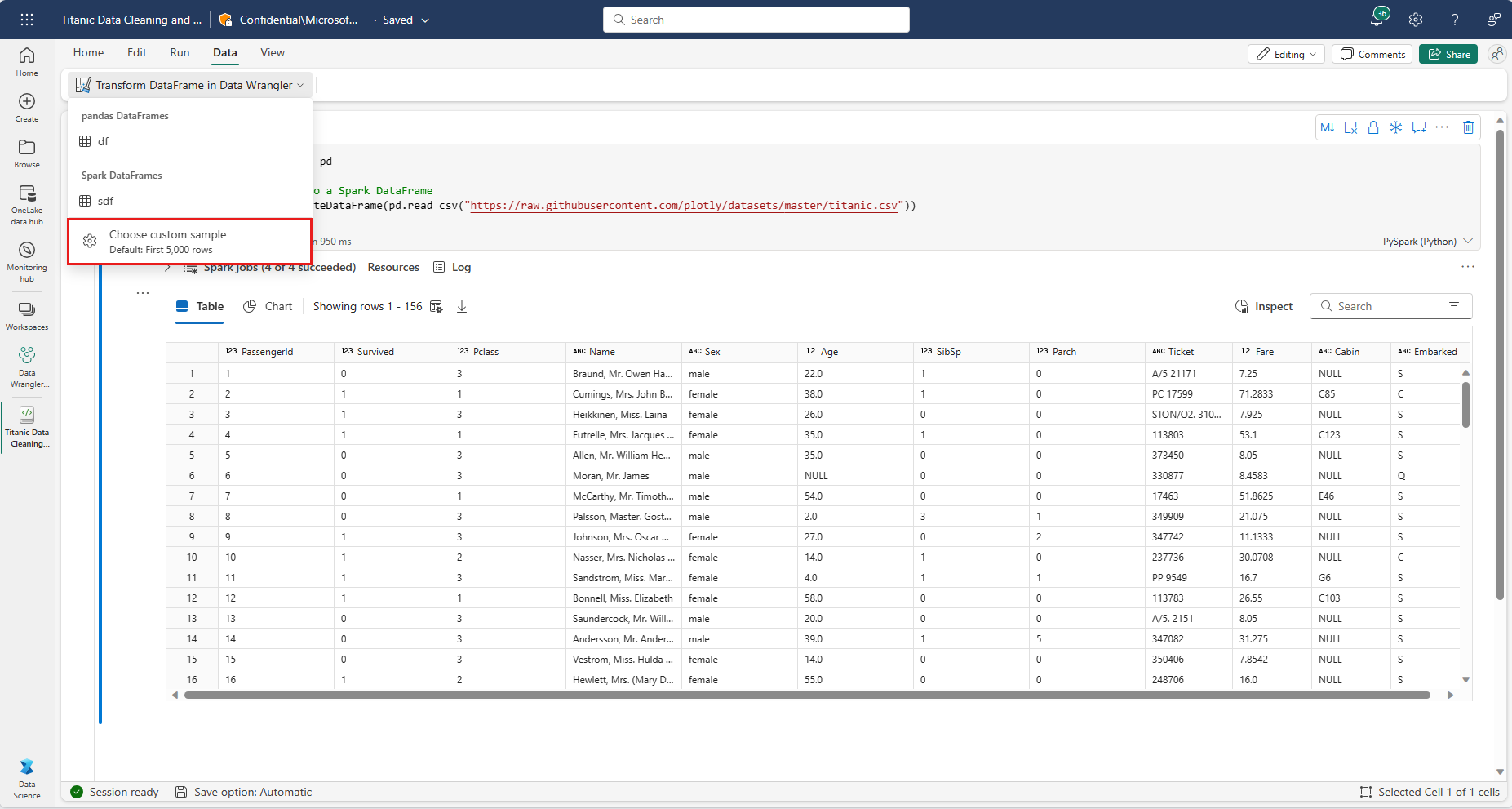

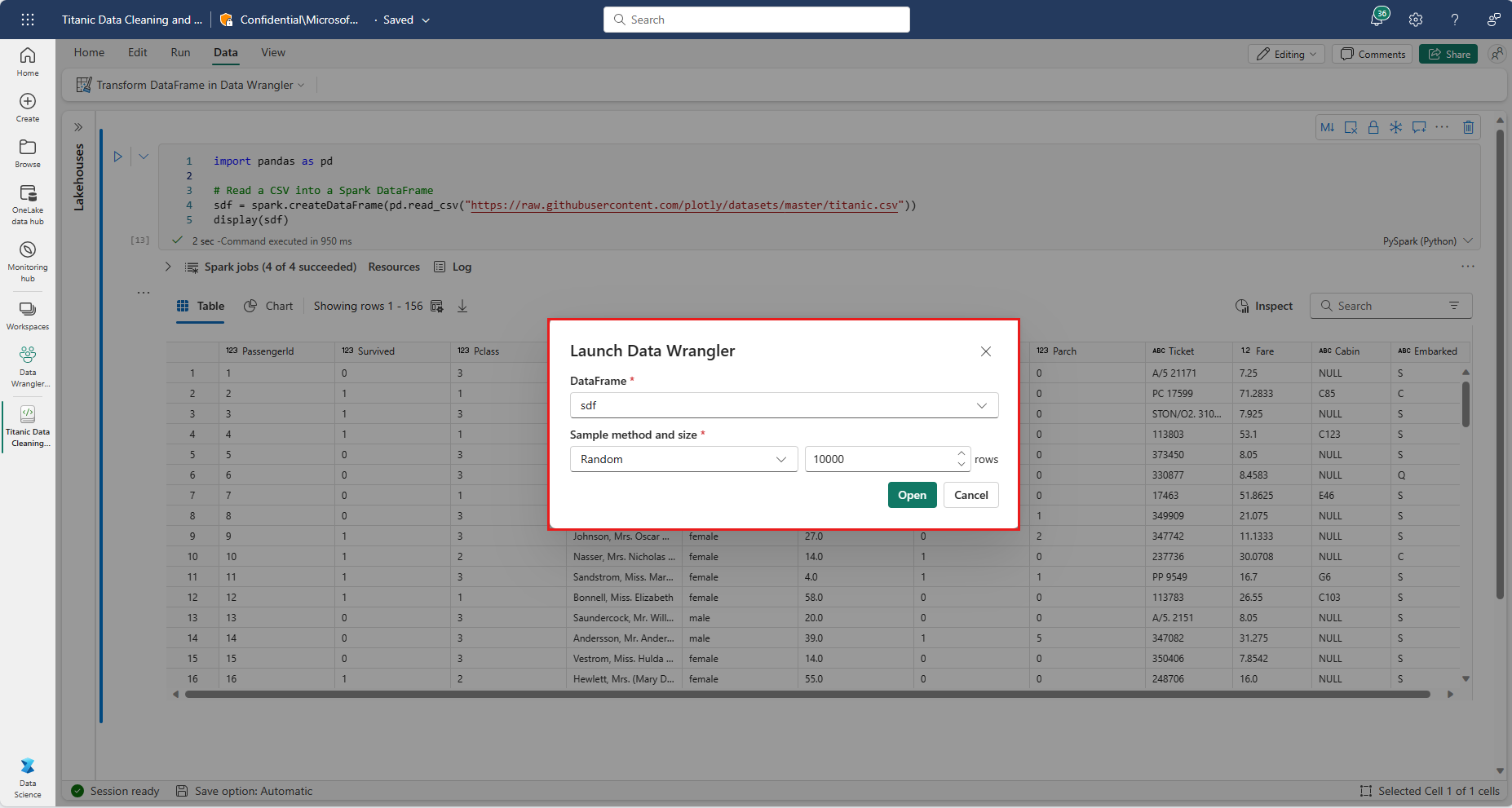

Choix d’échantillons personnalisés

Data Wrangler convertit automatiquement les DataFrames Spark en échantillons Pandas pour des raisons de performances. Toutefois, tout le code généré par l’outil est finalement traduit en PySpark lorsqu’il est réexporté dans le notebook. Comme pour n’importe quel DataFrame Pandas, vous pouvez personnaliser l’échantillon par défaut en sélectionnant « Choisir un échantillon personnalisé » dans le menu déroulant Data Wrangler. Cette opération lance une fenêtre contextuelle avec des options permettant de spécifier la taille de l’échantillon souhaité (nombre de lignes) et la méthode d’échantillonnage (premiers enregistrements, derniers enregistrements ou ensemble aléatoire).

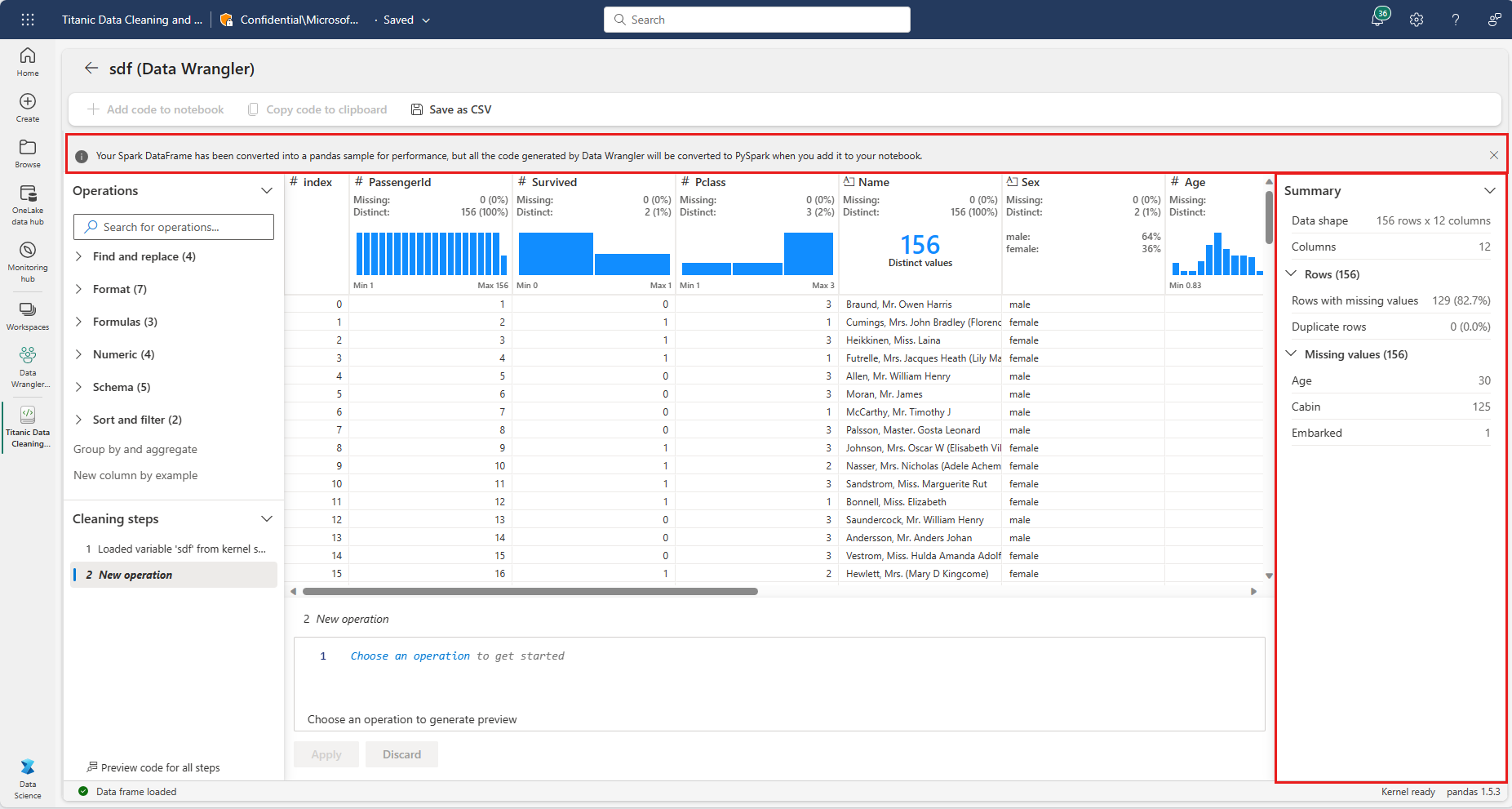

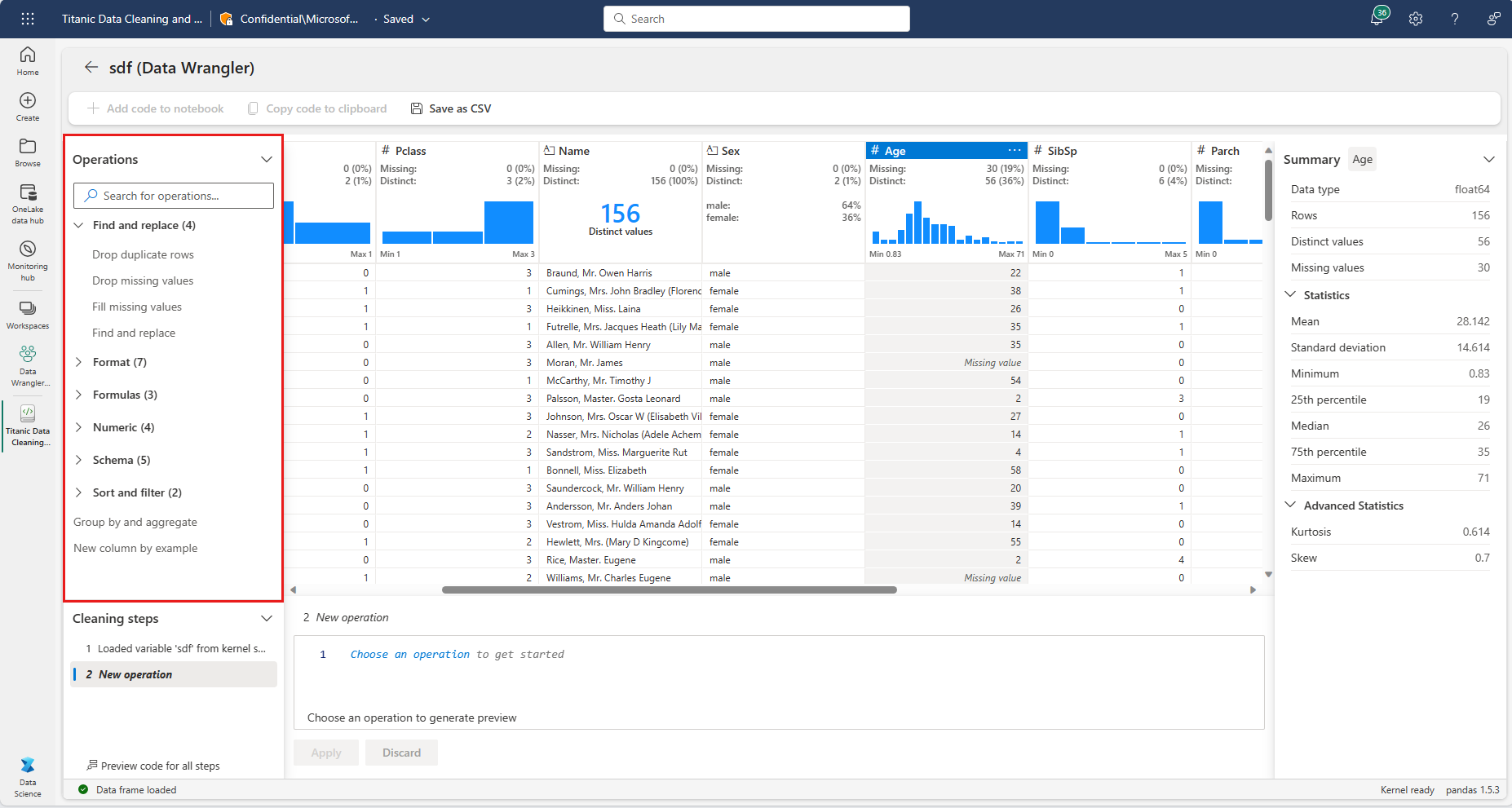

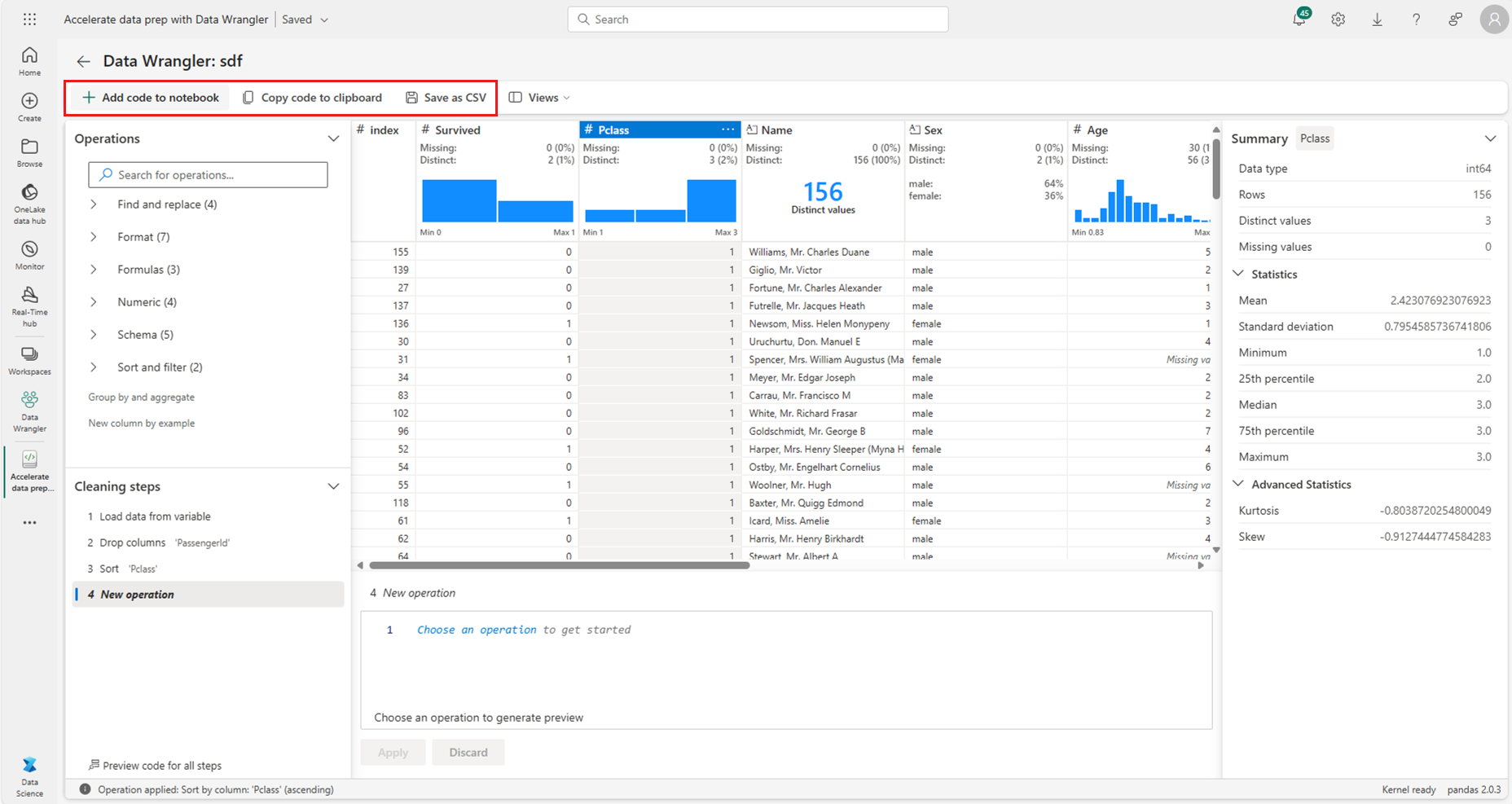

Affichage des statistiques récapitulatives

Lorsque Data Wrangler se charge, une bannière d’information au-dessus de la grille d’aperçu vous rappelle que les DataFrames Spark sont convertis temporairement en échantillons pandas, mais que tout le code généré est finalement converti en PySpark. Sinon, l’utilisation de Data Wrangler sur des DataFrames Spark n’est pas différente de son utilisation sur des DataFrames Pandas. Une vue d’ensemble descriptive du panneau Résumé affiche des informations sur les dimensions de l’échantillon, les valeurs manquantes, etc. La sélection d’une colonne dans la grille Data Wrangler invite le panneau Résumé à mettre à jour et à afficher des statistiques descriptives sur cette colonne spécifique. Des informations rapides sur chaque colonne sont également disponibles dans son en-tête.

Conseil

Les statistiques et les visuels spécifiques aux colonnes (à la fois dans le panneau Résumé et dans les en-têtes de colonne) dépendent du type de données de colonne. Par exemple, un histogramme placé dans un compartiment d’une colonne numérique apparaît dans l’en-tête de colonne uniquement si la colonne est castée en type numérique. Utilisez le panneau Opérations pour recaster les types de colonnes afin d’obtenir l’affichage le plus précis.

Parcourir les opérations de nettoyage des données

Vous trouverez la liste des étapes de nettoyage des données pouvant faire l’objet d’une recherche dans le panneau Opérations. (Une plus petite sélection des mêmes opérations est également disponible dans le menu contextuel de chaque colonne.) Dans le panneau Opérations, la sélection d’une étape de nettoyage des données vous invite à fournir une colonne ou des colonnes cibles, ainsi que tous es paramètres nécessaires pour effectuer l’étape. Par exemple, l’invite de mise à l’échelle numérique d’une colonne nécessite une nouvelle plage de valeurs.

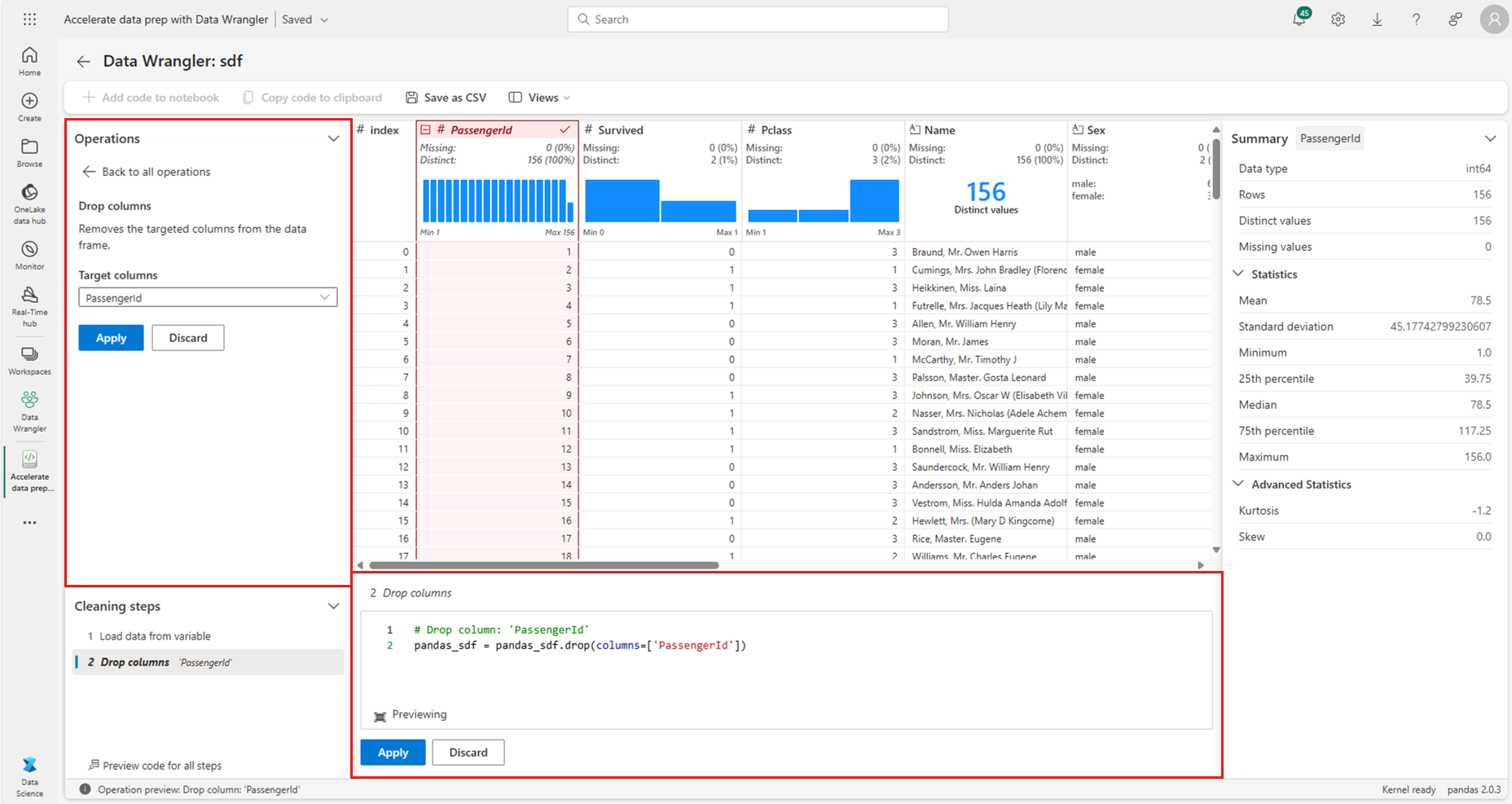

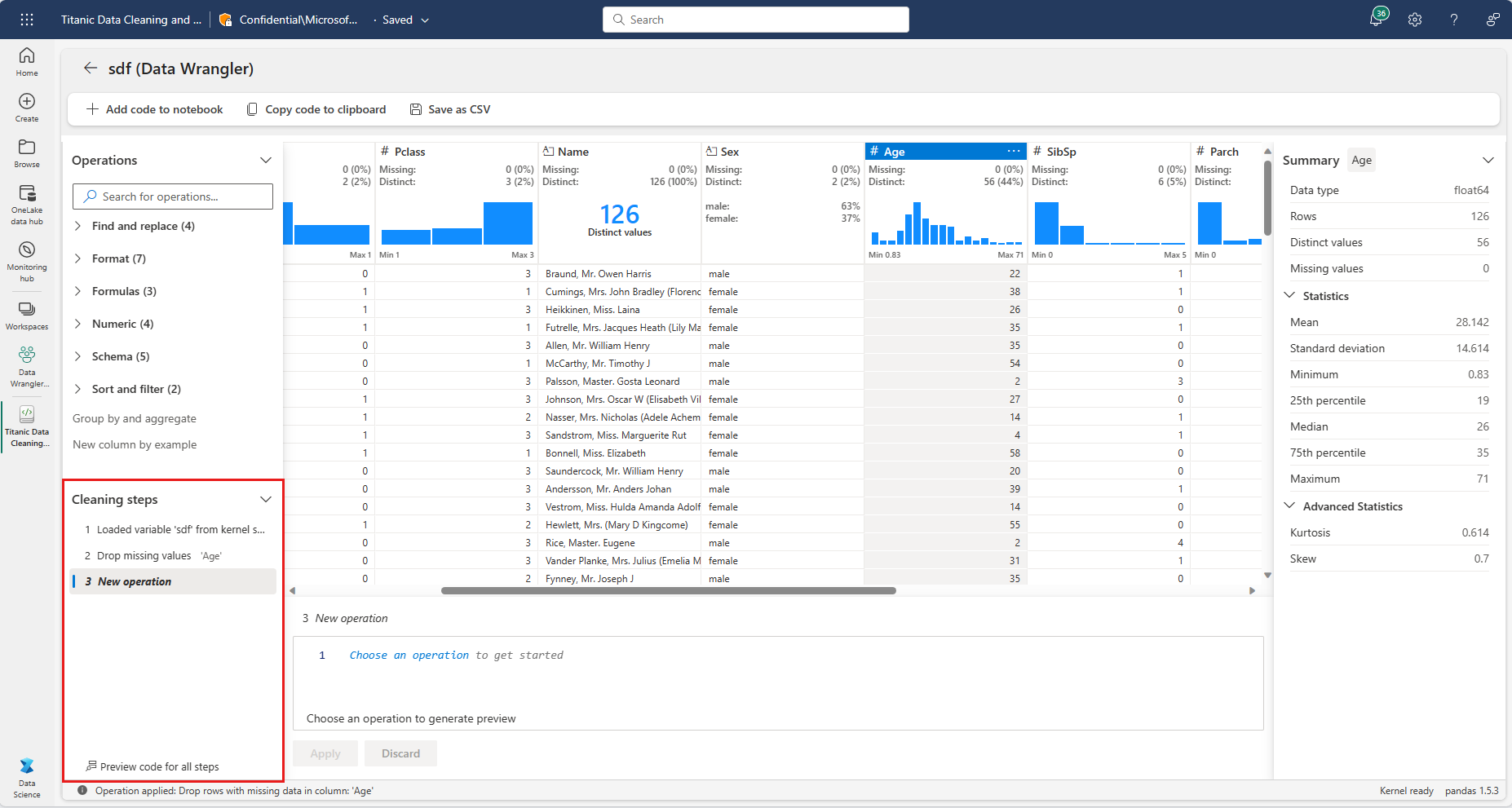

Aperçu et application d’opérations

Les résultats d’une opération sélectionnée sont automatiquement prévisualisés dans la grille d’affichage Data Wrangler, et le code correspondant apparaît automatiquement dans le panneau sous la grille. Pour valider le code en aperçu, sélectionnez «Appliquer» à l’un ou l’autre endroit. Pour vous débarrasser du code en aperçu et essayer une nouvelle opération, sélectionnez «Abandonner».

Une fois qu’une opération est appliquée, la grille d’affichage Data Wrangler et les statistiques récapitulatives sont mises à jour pour refléter les résultats. Le code apparaît dans la liste ouverte des opérations validées, située dans le panneau Étapes de nettoyage.

Conseil

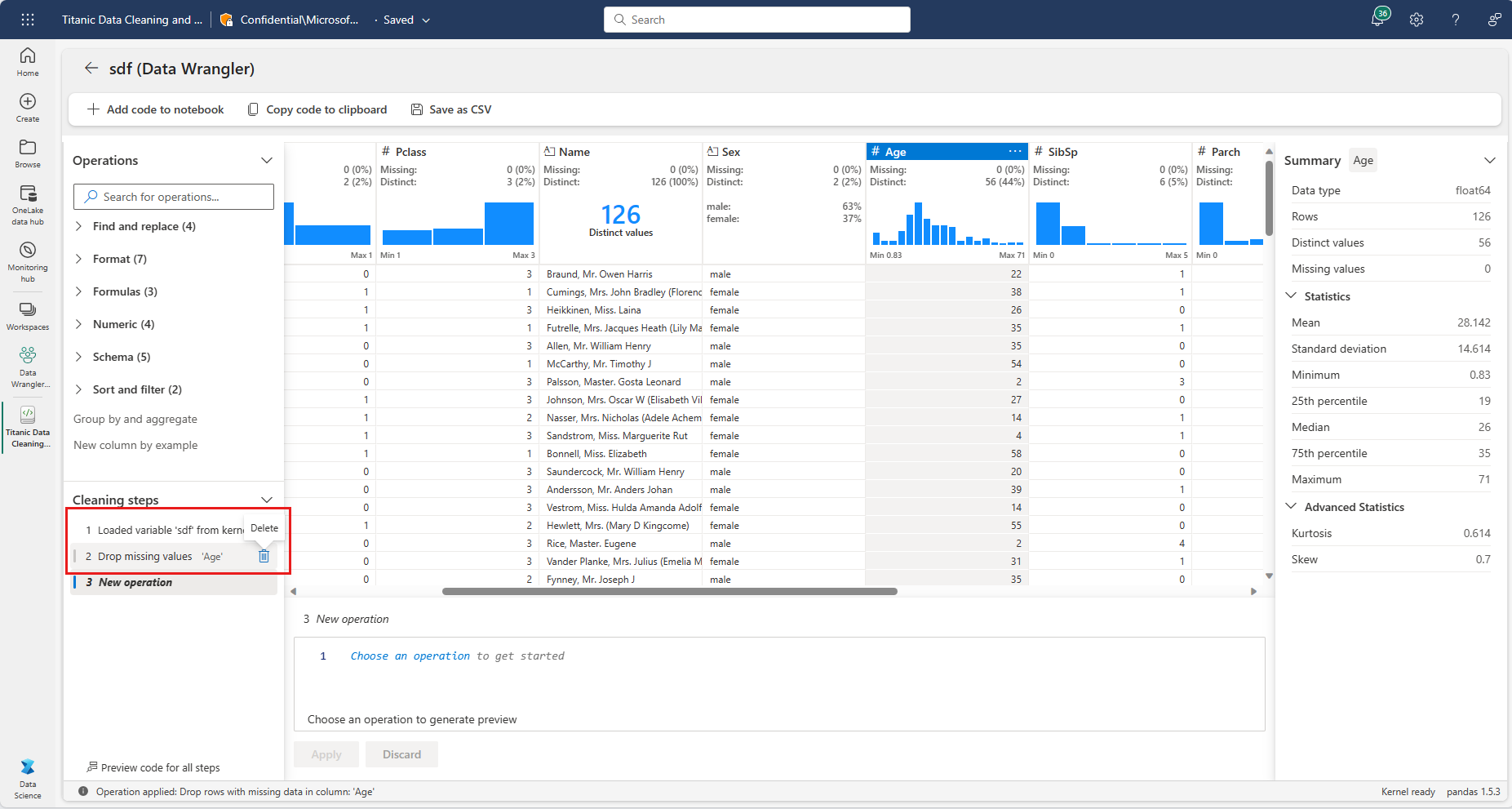

Vous pouvez toujours annuler l’étape la plus récente appliquée avec l’icône Corbeille à côté de celle-ci, qui apparaît si vous pointez votre curseur sur cette étape dans le panneau Étapes de nettoyage.

Le tableau suivant récapitule les opérations actuellement prises en charge par Data Wrangler pour les DataFrames Spark :

| Opération | Description |

|---|---|

| Sort | Trier une colonne par ordre croissant ou décroissant |

| Filter | Filtrer les lignes en fonction d’une ou plusieurs conditions |

| Codage à chaud | Créer des colonnes pour chaque valeur unique dans une colonne existante, indiquant la présence ou l’absence de ces valeurs par ligne |

| Codage à chaud avec délimiteur | Fractionner et coder des données catégorielles à chaud à l’aide d’un délimiteur |

| Modifier le type de colonne | Modifier le type de données d’une colonne |

| Supprimer la colonne | Supprimer une ou plusieurs colonnes |

| Sélectionner une colonne | Choisir une ou plusieurs colonnes à conserver, puis supprimer le reste |

| Renommer la colonne | Renommer une colonne |

| Supprimer les valeurs manquantes | Supprimer les lignes avec des valeurs manquantes |

| Supprimer les valeurs dupliquées | Supprimer toutes les lignes qui ont des valeurs en double dans une ou plusieurs colonnes |

| Remplir les valeurs manquantes | Remplacer les cellules avec des valeurs manquantes par une nouvelle valeur |

| Rechercher et remplacer | Remplacer les cellules par un modèle de correspondance exacte |

| Regrouper par colonne et agréger | Regrouper les valeurs par colonne et agréger les résultats |

| Éliminer les espaces blancs | Supprimer l’espace blanc du début et de la fin du texte |

| Fractionner un texte | Fractionner une colonne en plusieurs colonnes en fonction d’un délimiteur défini par l’utilisateur |

| Convertir du texte en minuscules | Convertir du texte en minuscules |

| Convertir du texte en majuscules | Convertir du texte en majuscules |

| Mettre à l’échelle les valeurs min/max | Mettre à l’échelle une colonne numérique entre une valeur minimale et une valeur maximale |

| Remplissage de Flash | Créer automatiquement une colonne basée sur des exemples dérivés d’une colonne existante |

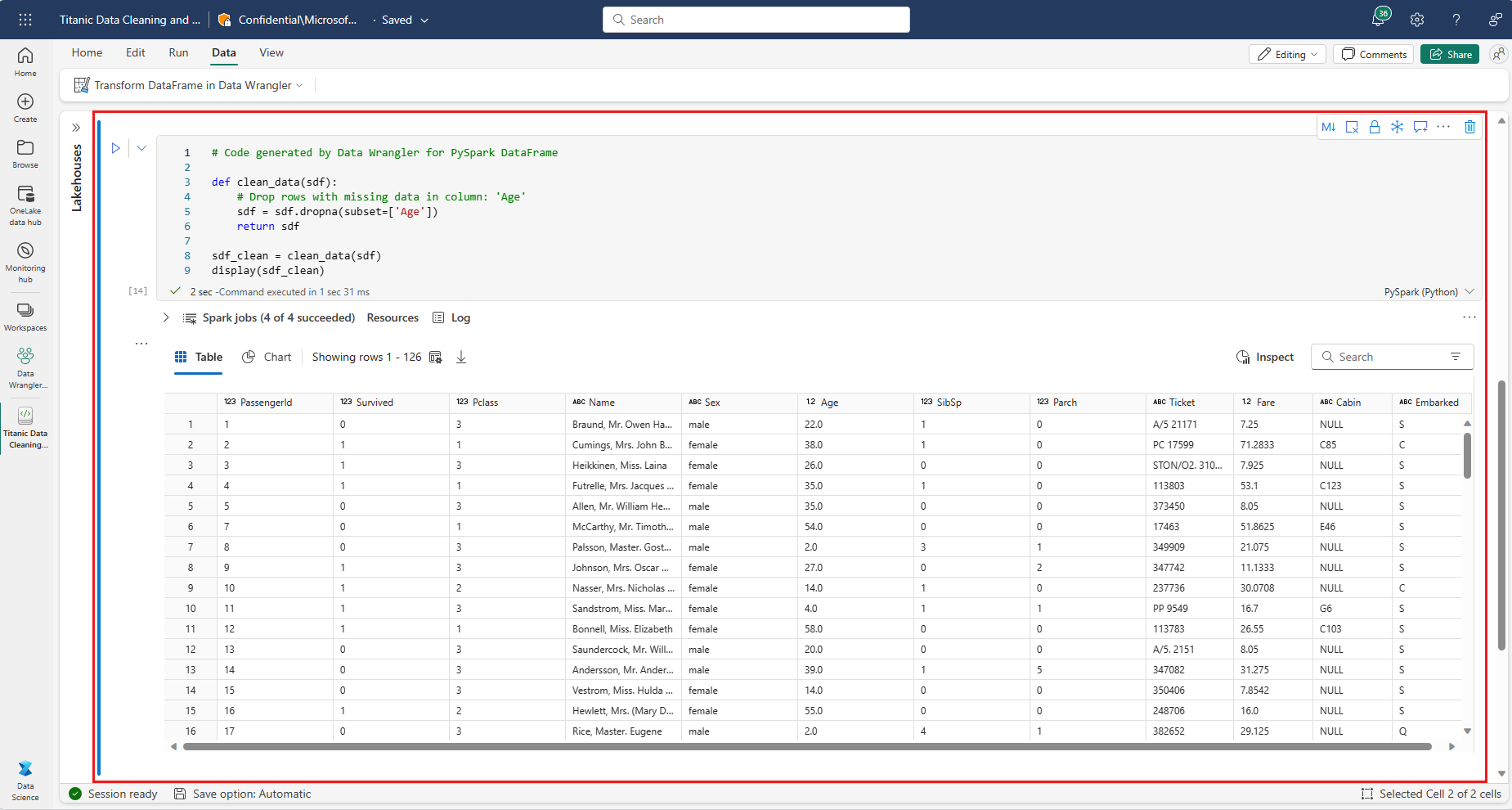

Enregistrement et exportation de code

La barre d’outils située au-dessus de la grille d’affichage Data Wrangler fournit des options permettant d’enregistrer le code généré. Vous pouvez copier le code dans le Presse-papiers ou l’exporter vers le notebook en tant que fonction. Pour les DataFrames Spark, tout le code généré sur l’échantillon Pandas est traduit en PySpark avant de revenir dans le notebook. Avant la fermeture de Data Wrangler, l’outil affiche un aperçu du code PySpark traduit et offre également une option permettant d’exporter également le code Pandas intermédiaire.

Conseil

Le code généré par Data Wrangler ne sera pas appliqué tant que vous n’exécuterez pas manuellement la nouvelle cellule, et il ne remplacera pas votre DataFrame d’origine.

Contenu connexe

- Pour obtenir une vue d’ensemble de Data Wrangler, consultez cet article complémentaire.

- Pour essayer Data Wrangler dans VS Code, consultez Data Wrangler dans VS Code.

Commentaires

Bientôt disponible : Tout au long de 2024, nous allons supprimer progressivement GitHub Issues comme mécanisme de commentaires pour le contenu et le remplacer par un nouveau système de commentaires. Pour plus d’informations, consultez https://aka.ms/ContentUserFeedback.

Envoyer et afficher des commentaires pour