Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Les blocs-notes Microsoft Fabric prennent en charge une interaction transparente avec les données Lakehouse à l'aide de Pandas, la bibliothèque Python la plus populaire pour l'exploration et le traitement des données. Dans un notebook, vous pouvez rapidement lire et écrire des données dans les ressources de Lakehouse dans différents formats de fichiers. Ce guide fournit des exemples de code pour vous aider à démarrer dans votre propre bloc-notes.

Prérequis

Obtenir un abonnement Microsoft Fabric. Ou, inscrivez-vous pour un essai gratuit de Microsoft Fabric.

Connectez-vous à Microsoft Fabric.

Utilisez le sélecteur d’expérience en bas à gauche de votre page d’accueil pour basculer vers Fabric.

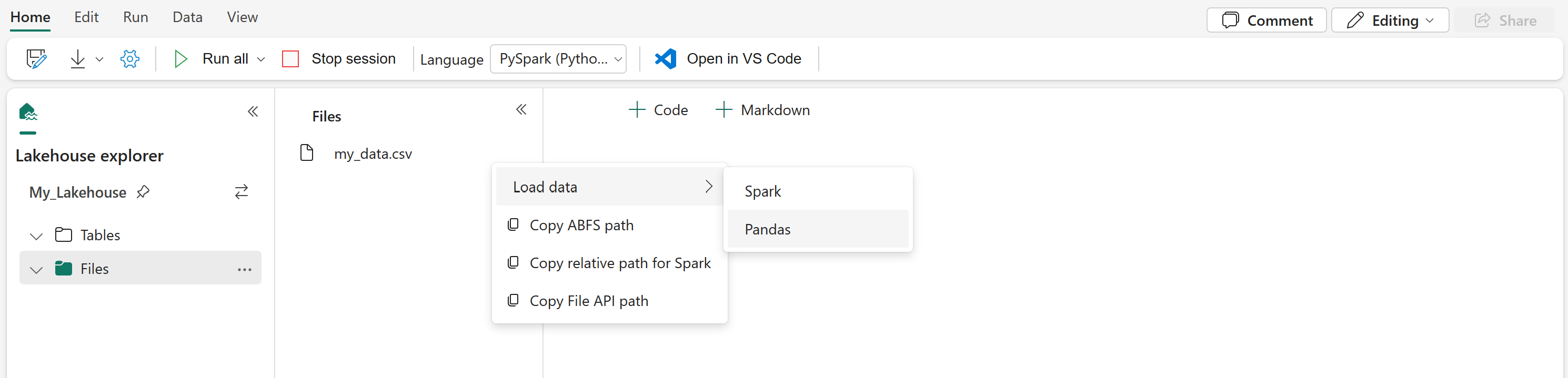

Charger les données de Lakehouse dans un bloc-notes

Une fois que vous avez attaché un Lakehouse à votre notebook Microsoft Fabric, vous pouvez explorer les données stockées sans quitter la page, et les lire dans votre notebook, le tout en quelques étapes. La sélection de n'importe quelle option de surface de fichier Lakehouse pour « Charger les données » dans un Spark ou un Pandas DataFrame. Vous pouvez également copier le chemin ABFS complet du fichier ou un chemin d'accès relatif convivial.

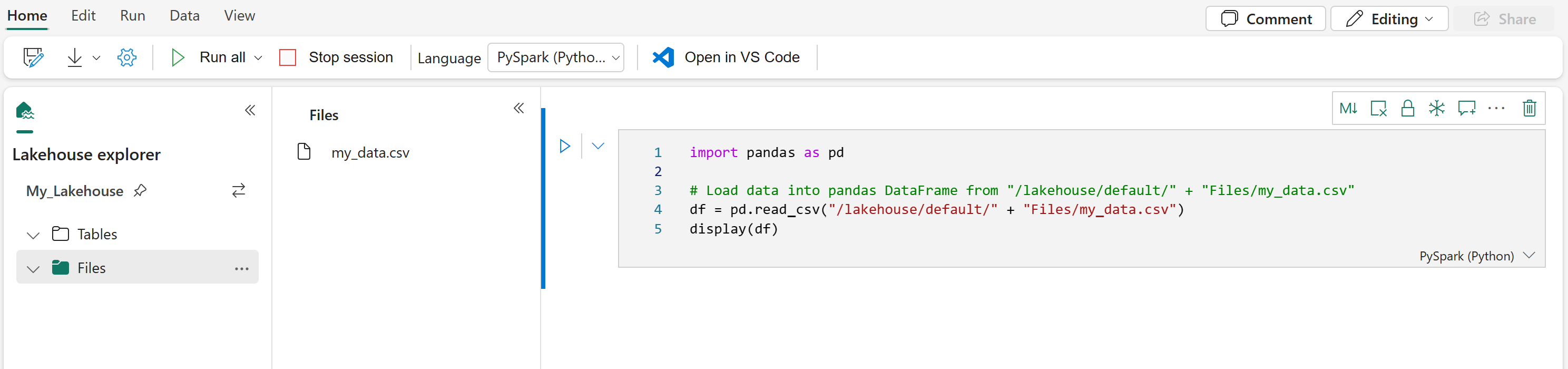

La sélection de l'une des invites « Charger les données » génère une cellule de code pour charger ce fichier dans un DataFrame de votre notebook.

Conversion d'un DataFrame Spark en un DataFrame Pandas

Pour référence, cette commande montre comment convertir un DataFrame Spark en DataFrame Pandas :

# Replace "spark_df" with the name of your own Spark DataFrame

pandas_df = spark_df.toPandas()

Lecture et écriture de divers formats de fichiers

Remarque

La modification de la version d’un package spécifique peut potentiellement interrompre d’autres packages qui en dépendent. Par exemple, la rétrogradation azure-storage-blob peut entraîner des problèmes avec Pandas et diverses autres bibliothèques qui s’appuient sur Pandas, y compris mssparkutils, fsspec_wrapperet notebookutils.

Vous pouvez afficher la liste des packages préinstallés et leurs versions pour chaque runtime ici.

Ces exemples de code décrivent les opérations Pandas permettant de lire et d'écrire différents formats de fichiers.

Remarque

Vous devez remplacer les chemins d'accès aux fichiers dans ces exemples de code. Pandas prend en charge les chemins relatifs, comme indiqué ici, et les chemins ABFS complets. Les chemins d'accès de l'un ou l'autre type peuvent être récupérés et copiés à partir de l'interface conformément à l'étape précédente.

Lire les données d’un fichier CSV

import pandas as pd

# Read a CSV file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

display(df)

Écrire des données sous forme de fichier CSV

import pandas as pd

# Write a Pandas DataFrame into a CSV file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_csv("/LAKEHOUSE_PATH/Files/FILENAME.csv")

Lire les données d'un fichier Parquet

import pandas as pd

# Read a Parquet file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pd.read_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

display(df)

Écrire des données dans un fichier Parquet

import pandas as pd

# Write a Pandas DataFrame into a Parquet file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_parquet("/LAKEHOUSE_PATH/Files/FILENAME.parquet")

Lire les données d'un fichier Excel

import pandas as pd

# Read an Excel file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values. Also need to add correct filepath after Files/ if file is placed in different folders

# if using default lakehouse that attached to the notebook use the code to replace below: df = pandas.read_excel("/lakehouse/default/Files/FILENAME.xlsx")

df = pandas.read_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

display(df)

Écrire des données sous forme de fichier Excel

import pandas as pd

# Write a Pandas DataFrame into an Excel file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_excel("/LAKEHOUSE_PATH/Files/FILENAME.xlsx")

Lire les données d'un fichier JSON

import pandas as pd

# Read a JSON file from your Lakehouse into a Pandas DataFrame

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df = pandas.read_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

display(df)

Écrire des données sous forme de fichier JSON

import pandas as pd

# Write a Pandas DataFrame into a JSON file in your Lakehouse

# Replace LAKEHOUSE_PATH and FILENAME with your own values

df.to_json("/LAKEHOUSE_PATH/Files/FILENAME.json")

Contenu connexe

- Utilisez Data Wrangler pour nettoyer et préparer vos données

- Commencer à entraîner des modèles de ML