Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Dans ce guide, vous allez :

Chargez les données dans OneLake avec l’explorateur de fichiers OneLake.

Utilisez un notebook Fabric pour lire les données sur OneLake et les mettre à jour sous forme de tableau Delta.

Analysez et transformez des données avec Spark à l'aide d'un notebook Fabric.

Interrogez une copie des données sur OneLake avec SQL.

Prérequis

Avant de commencer, vous devez :

Téléchargez et installez l'explorateur de fichiers OneLake.

Créez un espace de travail avec un élément Lakehouse.

Téléchargez le jeu de données WideWorldImportersDW. Vous pouvez utiliser Explorateur Stockage Azure pour vous connecter à

https://fabrictutorialdata.blob.core.windows.net/sampledata/WideWorldImportersDW/csv/full/dimension_cityet télécharger l'ensemble de fichiers csv. Vous pouvez également utiliser vos propres données csv et mettre à jour les détails si nécessaire.

Charger des données

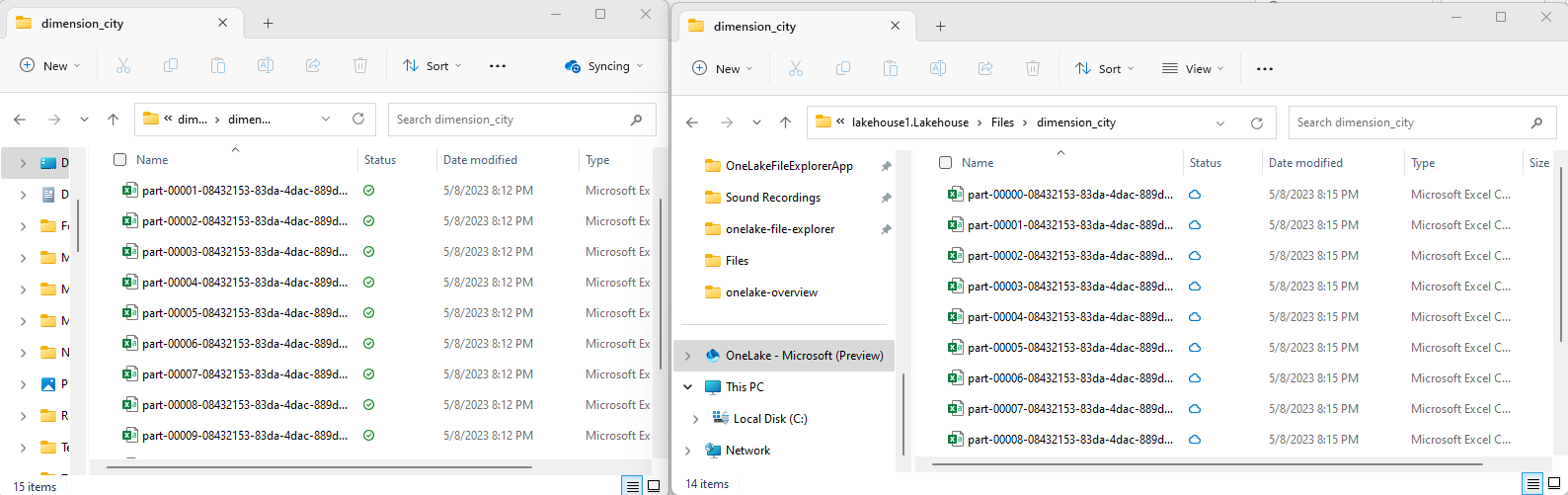

Dans cette section, vous chargez des données de test dans votre lakehouse à l’aide de l’Explorateur de fichiers OneLake.

Dans l’Explorateur de fichiers OneLake, accédez à votre lakehouse et créez un sous-répertoire nommé

dimension_citysous le répertoire/Files.

Copiez vos exemples de fichiers csv dans le répertoire OneLake

/Files/dimension_cityà l'aide de l'explorateur de fichiers OneLake.Accédez à votre lakehouse dans le service Power BI ou Fabric et affichez vos fichiers.

Créer une table Delta

Dans cette section, vous convertissez les fichiers CSV non managés en table managée au format Delta.

Remarque

Créez ou chargez toujours un raccourci vers les données Delta-Parquet directement dans la section Tables du lakehouse. N’imbriquez pas vos tables dans des sous-dossiers sous la section Tables. Le lakehouse ne reconnaît pas les sous-dossiers en tant que tables et les étiquette en tant que Non identifiés.

Dans votre Lakehouse, sélectionnez Ouvrir un bloc-notes, puis Nouveau bloc-notes pour créer un bloc-notes.

À l'aide du notebook Fabric, convertissez les fichiers csv au format Delta. L’extrait de code suivant lit les données du répertoire

/Files/dimension_citycréé par l’utilisateur et les convertit en tableau Deltadim_city.Copiez l’extrait de code dans l’éditeur de cellule du bloc-notes. Remplacez les espaces réservés par vos propres informations d’espace de travail, puis sélectionnez Exécuter la cellule ou Tout exécuter.

import os from pyspark.sql.types import * for filename in os.listdir("/lakehouse/default/Files/dimension_city"): df=spark.read.format('csv').options(header="true",inferSchema="true").load("abfss://<YOUR_WORKSPACE_NAME>@onelake.dfs.fabric.microsoft.com/<YOUR_LAKEHOUSE_NAME>.Lakehouse/Files/dimension_city/"+filename,on_bad_lines="skip") df.write.mode("overwrite").format("delta").save("Tables/dim_city")Conseil

Vous pouvez récupérer le chemin complet d’ABFS vers votre répertoire en cliquant avec le bouton droit sur le nom du répertoire et en sélectionnant Copier le chemin ABFS.

Pour afficher votre nouveau tableau, actualisez la vue du répertoire

/Tables. Sélectionnez d’autres options (...) en regard du répertoire Tables, puis sélectionnez Actualiser.

Interroger et modifier des données

Dans cette section, vous utilisez un bloc-notes Fabric pour interagir avec les données de votre table.

Interrogez votre table avec SparkSQL dans le même notebook Fabric.

%%sql SELECT * from <LAKEHOUSE_NAME>.dim_city LIMIT 10;Modifiez le tableau Delta en ajoutant une nouvelle colonne nommée newColumn avec le type de données entier. Définissez la valeur 9 pour tous les enregistrements de cette colonne nouvellement ajoutée.

%%sql ALTER TABLE <LAKEHOUSE_NAME>.dim_city ADD COLUMN newColumn int; UPDATE <LAKEHOUSE_NAME>.dim_city SET newColumn = 9; SELECT City,newColumn FROM <LAKEHOUSE_NAME>.dim_city LIMIT 10;

Vous pouvez également accéder à tout tableau Delta sur OneLake via un point de terminaison d’analytique SQL. Un point de terminaison d’analytique SQL référence la même copie physique de la table delta sur OneLake et offre l’expérience de T-SQL.

Accédez à votre lakehouse, puis sélectionnez Lakehouse>Point de terminaison d’analytique SQL dans le menu déroulant.

Sélectionnez nouvelle requête SQL pour interroger la table à l’aide de T-SQL.

Copiez et collez le code suivant dans l’éditeur de requête, puis sélectionnez Exécuter.

SELECT TOP (100) * FROM [<LAKEHOUSE_NAME>].[dbo].[dim_city];