Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

Résumé

| Élément | Descriptif |

|---|---|

| État de publication | Disponibilité générale |

| Produits | Power BI (modèles sémantiques) Power BI (flux de données) Fabric (Dataflow Gen2) Power Apps (Flux de données) Dynamics 365 Customer Insights Services d'analyse |

| Types d’authentification pris en charge | Compte d’organisation Clé du compte Clé de signature d’accès partagé (SAP) Service Principal |

| Documentation de référence sur les fonctions |

AzureStorage.DataLake AzureStorage.DataLakeContents |

Remarque

Certaines fonctionnalités peuvent être présentes dans un produit, mais pas d’autres en raison de planifications de déploiement et de fonctionnalités spécifiques à l’hôte.

Conditions préalables

Un abonnement Azure. Consultez Créez votre compte Azure gratuit.

Un compte de stockage qui a un espace de noms hiérarchique. Suivez les instructions de la page Créer un compte de stockage pour en créer un. Cet article part du principe que vous avez créé un compte de stockage nommé

myadlsg2.Vérifiez que vous disposez de l’un des rôles suivants pour le compte de stockage : Lecteur de données Blob, Contributeur aux données Blob ou Propriétaire des données Blob.

Un exemple de fichier de données nommé

Drivers.txtsitué dans votre compte de stockage. Vous pouvez télécharger cet exemple à partir d’Azure Data Lake Git Repository, puis charger ce fichier dans votre compte de stockage.

Fonctionnalités prises en charge

- Importer

- Vue système de fichiers

- Vue dossier CDM

Se connecter à Azure Data Lake Storage Gen2 à partir de Power Query Desktop

Sélectionnez Azure Data Lake Storage Gen2 dans l’expérience obtenir des données. L’expérience d’obtention de données dans Power Query Desktop varie selon les applis. Pour plus d’informations sur l’expérience Power Query Desktop pour obtenir des données avec votre application, accédez à Où obtenir des données.

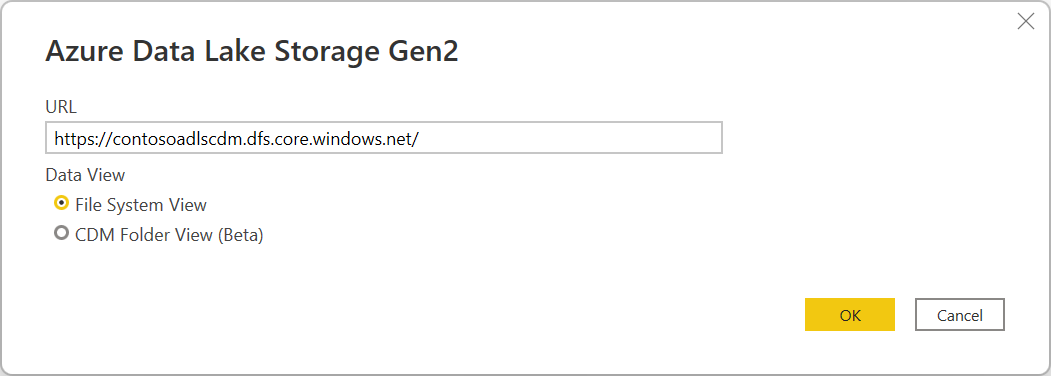

Dans la boîte de dialogue Azure Data Lake Storage Gen2 , indiquez l’URL de votre compte, conteneur ou sous-dossier Azure Data Lake Storage Gen2 à l’aide du format de point de terminaison de conteneur. Les URL pour Data Lake Storage Gen2 ont le modèle suivant :

< https:// accountname.dfs.core.windows.net/><container>/<sous-dossier>

Vous pouvez également sélectionner si vous souhaitez utiliser la vue du système de fichiers ou la vue de dossier Common Data Model.

Sélectionnez OK pour continuer.

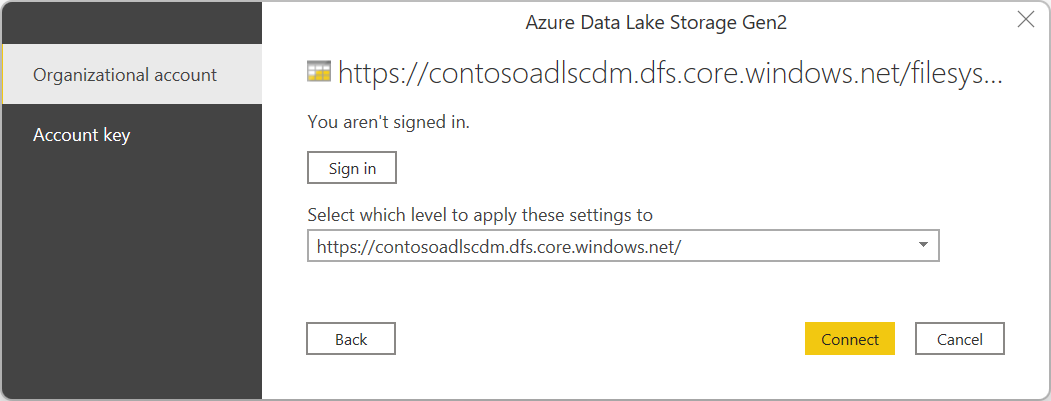

Si c’est la première fois que vous utilisez cette adresse URL, vous êtes invité à sélectionner la méthode d’authentification.

Si vous sélectionnez la méthode compte organisationnel, sélectionnez Se connecter pour vous connecter à votre compte de stockage. Vous allez être redirigé vers la page de connexion de votre organisation. Suivez les invites pour vous connecter au compte. Après vous être connecté avec succès, cliquez sur Connexion.

Si vous sélectionnez la méthode de clé de compte, entrez votre clé de compte, puis sélectionnez Se connecter.

La boîte de dialogue Navigateur affiche tous les fichiers sous l’URL que vous avez fournie. Vérifiez les informations, puis sélectionnez Transformer des données pour transformer les données dans Power Query ou Charger pour charger les données.

Se connecter à Azure Data Lake Storage Gen2 à partir de Power Query Online

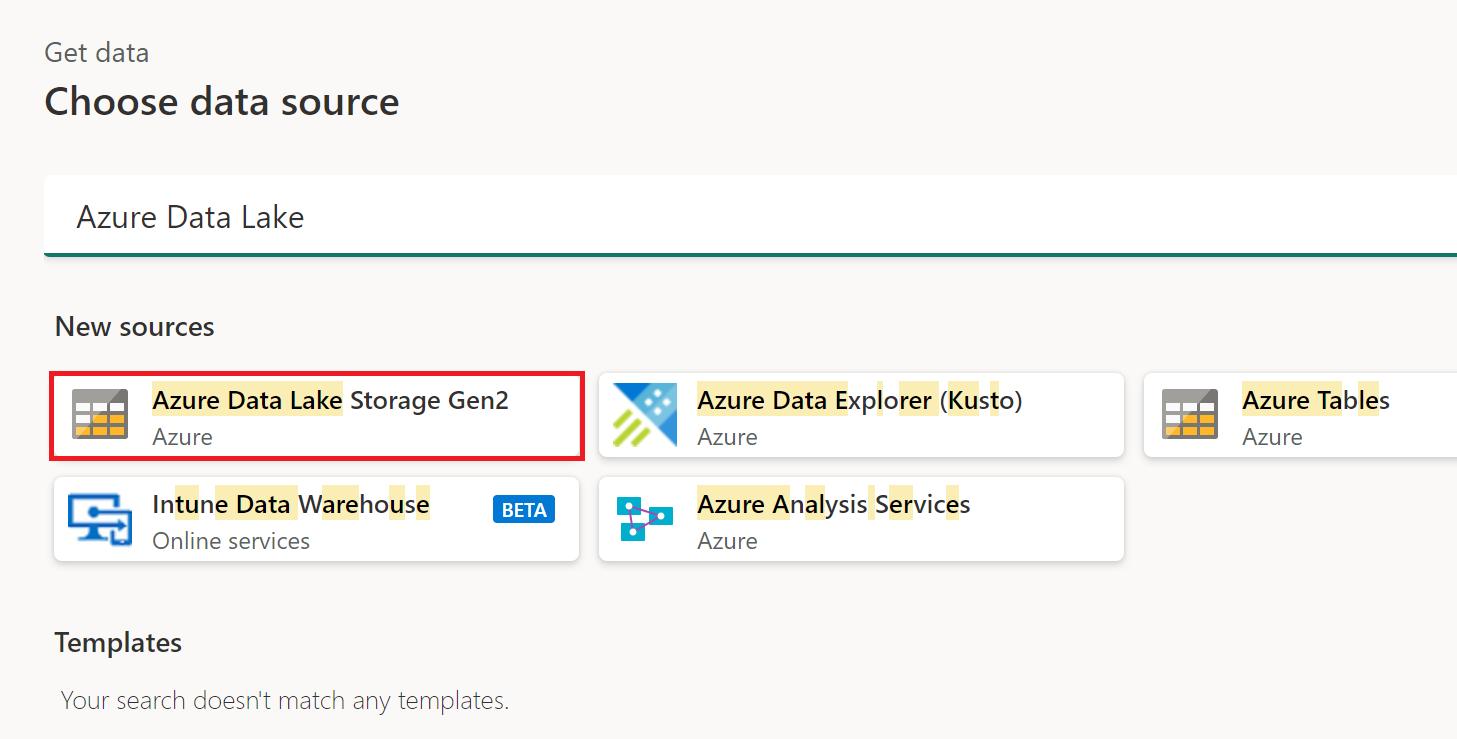

Sélectionnez l’option Azure Data Lake Storage Gen2 dans l’expérience obtenir des données. Chaque appli a sa propre façon d’accéder à l’expérience d’obtention de données de Power Query Online. Pour plus d’informations sur la manière d’accéder à la fonctionnalité de récupération de données dans Power Query Online à partir de votre application, accédez à Où obtenir des données.

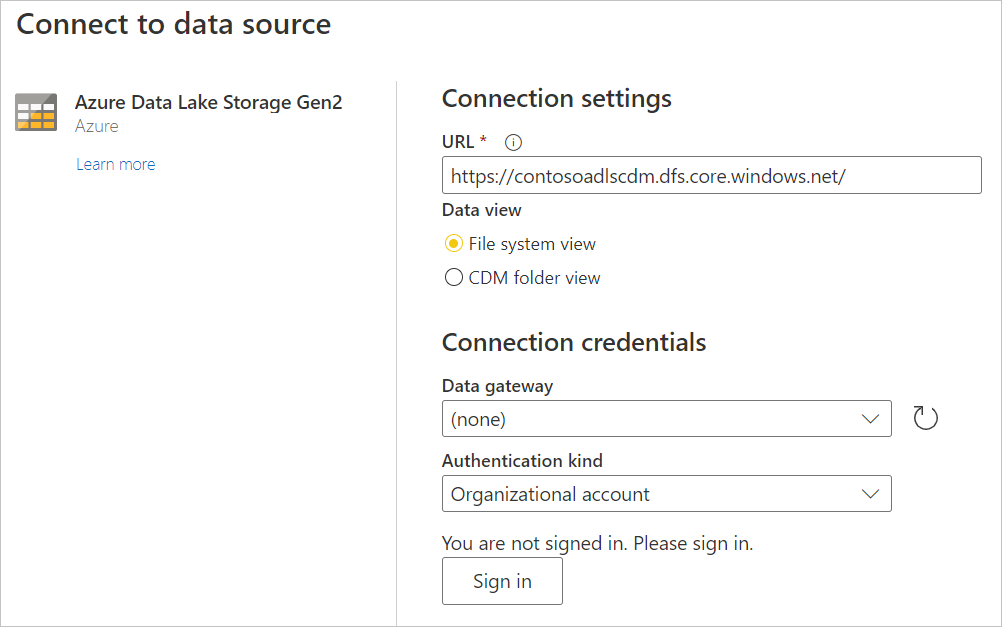

Dans Se connecter à une source de données, entrez l’URL de votre compte Azure Data Lake Storage Gen2. Reportez-vous aux limitations pour déterminer l’URL à utiliser.

Choisissez d’utiliser la vue du système de fichiers ou la vue de dossier Common Data Model.

Si nécessaire, sélectionnez la passerelle de données locale dans la passerelle de données.

Sélectionnez Connexion pour vous connecter au compte Azure Data Lake Storage Gen2. Vous allez être redirigé vers la page de connexion de votre organisation. Suivez les invites pour vous connecter au compte.

Après vous être connecté, sélectionnez Suivant.

La page Choisir des données affiche tous les fichiers sous l’URL que vous avez fournie. Vérifiez les informations, puis sélectionnez Transformer des données pour transformer les données dans Power Query.

Limites

Sous-dossier ou fichier non pris en charge dans Power Query Online et Power BI Desktop

Actuellement, dans Power Query Online et dans Power BI Desktop, le connecteur Azure Data Lake Storage Gen2 prend uniquement en charge les chemins d’accès avec le conteneur, et non le sous-dossier ou le fichier. Par exemple, https://<accountname>.dfs.core.windows.net/<container> fonctionne, tandis que https://<accountname>.dfs.core.windows.net/<container>/<filename> ou https://<accountname>.dfs.core.windows.net/<container>/<subfolder> peut échouer.

Actualiser l’authentification

Microsoft ne prend pas en charge l’actualisation du flux de données ou du modèle sémantique à l’aide de l’authentification OAuth2 lorsque le compte Azure Data Lake Storage Gen2 (ADLS) se trouve dans un autre locataire. Cette limitation s’applique uniquement à ADLS lorsque la méthode d’authentification est OAuth2, c’est-à-dire lorsque vous tentez de vous connecter à un ADLS interlocataire à l’aide d’un compte d’ID Microsoft Entra. Dans ce cas, nous vous recommandons d’utiliser une autre méthode d’authentification qui n’est pas OAuth2/Microsoft Entra ID, telle que la méthode d’authentification de clé.

Exigences relatives au proxy et au pare-feu

Lorsque vous créez un dataflow à l’aide d’une passerelle, vous devrez peut-être modifier certains de vos paramètres proxy ou ports de pare-feu pour vous connecter à votre lac de données Azure. Si un flux de données échoue avec une actualisation liée à la passerelle, cela peut être dû à un problème de pare-feu ou de proxy sur la passerelle vers les points de terminaison de stockage Azure.

Si vous utilisez un proxy avec votre passerelle, vous devrez peut-être configurer le fichier Microsoft.Mashup.Container.NetFX45.exe.config dans la passerelle de données locale. Pour plus d’informations, configurez les paramètres de proxy pour la passerelle de données locale.

Pour activer la connectivité de votre réseau au lac de données Azure, vous devrez peut-être activer la liste d’adresses IP spécifiques sur la machine de passerelle. Par exemple, si votre réseau a des règles de pare-feu en place qui peuvent bloquer ces tentatives, vous devez débloquer les connexions réseau sortantes pour votre lac de données Azure. Pour activer la liste des adresses sortantes requises, utilisez la balise de service AzureDataLake . Plus d’informations : Balises de service de réseau virtuel

Les dataflows prennent également en charge l’option de lac de données « Bring Your Own », ce qui signifie que vous créez votre propre lac de données, gérez vos autorisations et que vous la connectez explicitement à votre dataflow. Dans ce cas, lorsque vous vous connectez à votre environnement de développement ou de production à l’aide d’un compte d’organisation, vous devez activer l’un des rôles suivants pour le compte de stockage : Lecteur de données Blob, Contributeur aux données Blob ou Propriétaire des données Blob.

Power Query Online et stockage Azure se trouvent dans la même région

L’accès direct à un compte de stockage Azure avec le pare-feu activé et dans la même région que Power Query Online n’est pas pris en charge. Cette limitation survient parce que les services Power Query, lorsqu’ils sont déployés dans la même région que le compte de stockage Azure, utilisent des adresses IP Azure privées pour la communication. Pour plus d’informations, reportez-vous à la documentation Azure sur la sécurité du réseau de stockage.

Pour contourner cette limitation et activer l’accès au stockage Azure à partir de Power Query Online dans la même région, utilisez l’une des méthodes suivantes :

- Utilisez une passerelle de données locale, qui sert de pont entre Power Query Online et stockage Azure.

- Utilisez une passerelle de données de réseau virtuel (VNet).