Exercice - Intégrer et utiliser la reconnaissance vocale et la transcription

Dans ce module, vous allez créer une application de réalité mixte qui explore l’utilisation d’Azure Speech Services avec HoloLens 2. Une fois que vous aurez suivi cette série, vous serez en mesure d’utiliser le microphone de votre appareil pour la conversion de parole en texte en temps réel et traduire ce que vous dites dans d’autres langues. Vous saurez aussi tirer parti de la fonctionnalité Reconnaissance de l’intention pour comprendre les commandes vocales à l’aide de l’intelligence artificielle.

Créer et préparer le projet Unity

Dans cette section, vous allez créer un nouveau projet Unity et le préparer au développement MRTK.

Comme prérequis, assurez-vous que vous avez effectué les étapes ci-dessous pour initialiser votre projet et votre application :

- Création du projet Unity et affectation d’un nom pertinent, par exemple MRTK Tutorials

- Changement de plateforme de génération

- Importation des ressources TextMeshPro Essential

- Importation du Mixed Reality Toolkit

- Configuration du projet Unity

- Création et configuration de la scène et attribution d’un nom approprié ; par exemple, AzureSpeechServices

Remarque

Vous pouvez apprendre à configurer votre projet de réalité mixte dans le module Présentation du Mixed Reality Toolkit.

Configurer les fonctionnalités

Dans le menu Unity, sélectionnez Edit>Project Settings... pour ouvrir la fenêtre Player Settings, puis recherchez la section Player>Publishing Settings :

Dans Paramètres de publication, faites défiler jusqu’à la section Fonctionnalités et vérifiez que les fonctionnalités InternetClient, Microphone et SpatialPerception (que vous avez activées lorsque vous avez créé le projet au début du tutoriel) sont toujours activées. Activez ensuite les fonctionnalités InternetClientServer et PrivateNetworkClientServer.

Importer les ressources du tutoriel

Téléchargez et importez les packages Unity personnalisés suivants dans l’ordre dans lequel ils sont listés :

Une fois que vous avez importé les ressources du tutoriel, votre fenêtre de projet doit se présenter comme suit :

Préparer la scène

Dans cette section, vous allez préparer la scène en ajoutant le prefab du tutoriel et configurer le composant Lunarcom Controller (Script) pour contrôler votre scène.

Dans la fenêtre de projet, accédez au dossier Ressources>MRTK.Tutorials.AzureSpeechServices>Prefabs, puis faites glisser le prefab Lunarcom dans la fenêtre Hiérarchie pour l’ajouter à votre scène.

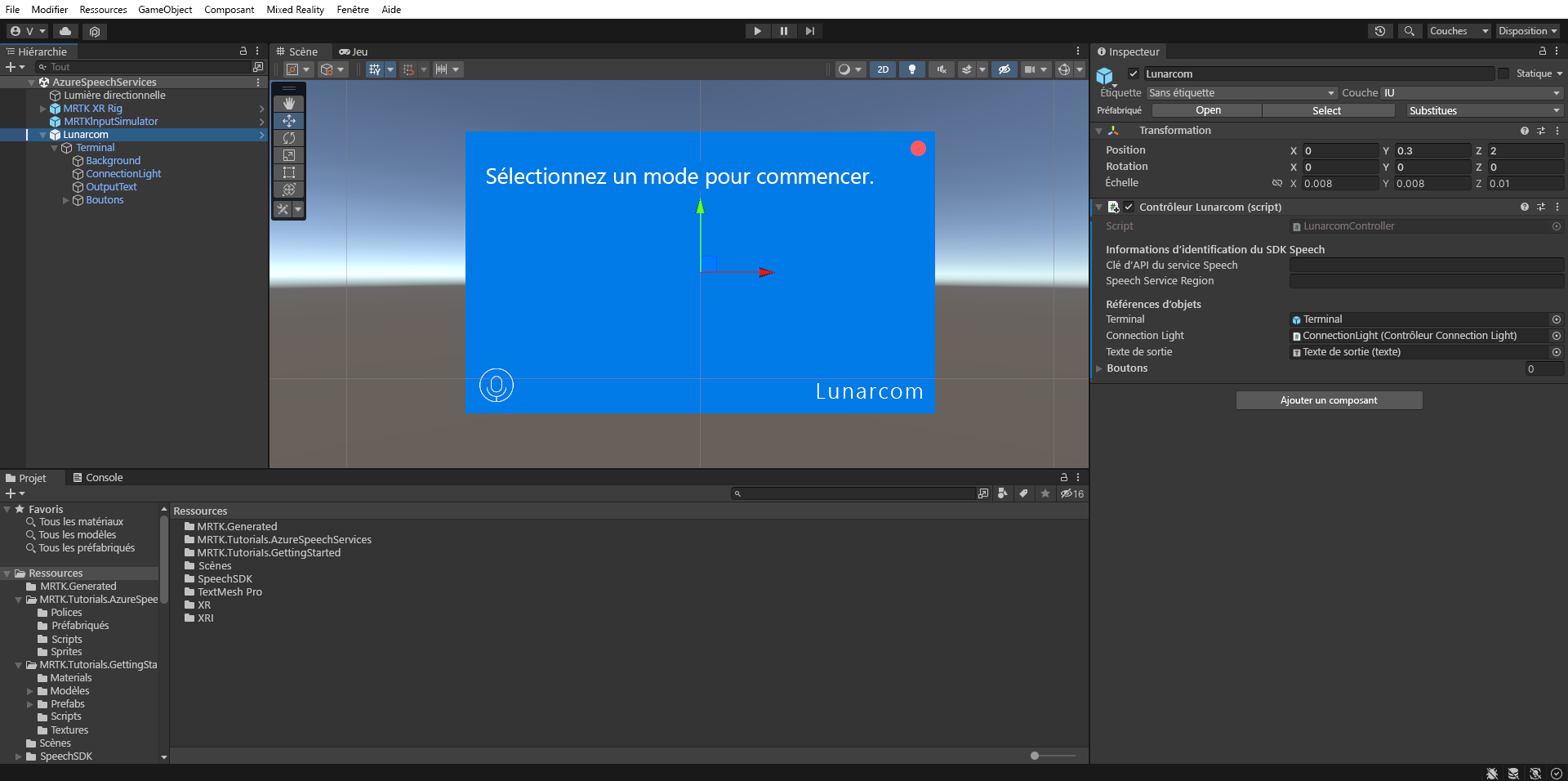

Avec l’objet Lunarcom toujours sélectionné dans la fenêtre Hiérarchie, dans la fenêtre Inspecteur, utilisez le bouton Ajouter un composant pour ajouter le composant Lunarcom Controller (Script) à l’objet Lunarcom.

Avec l’objet Lunarcom toujours sélectionné, développez-le pour révéler ses objets enfants, puis faites glisser l’objet Terminal dans le champ Terminal du composant Lunarcom Controller (Script).

Avec l’objet Lunarcom toujours sélectionné, développez l’objet Terminal pour révéler ses objets enfants, puis faites glisser l’objet ConnectionLight dans le champ Connection Light du composant Lunarcom Controller (Script) et l’objet OutputText dans le champ Texte de sortie.

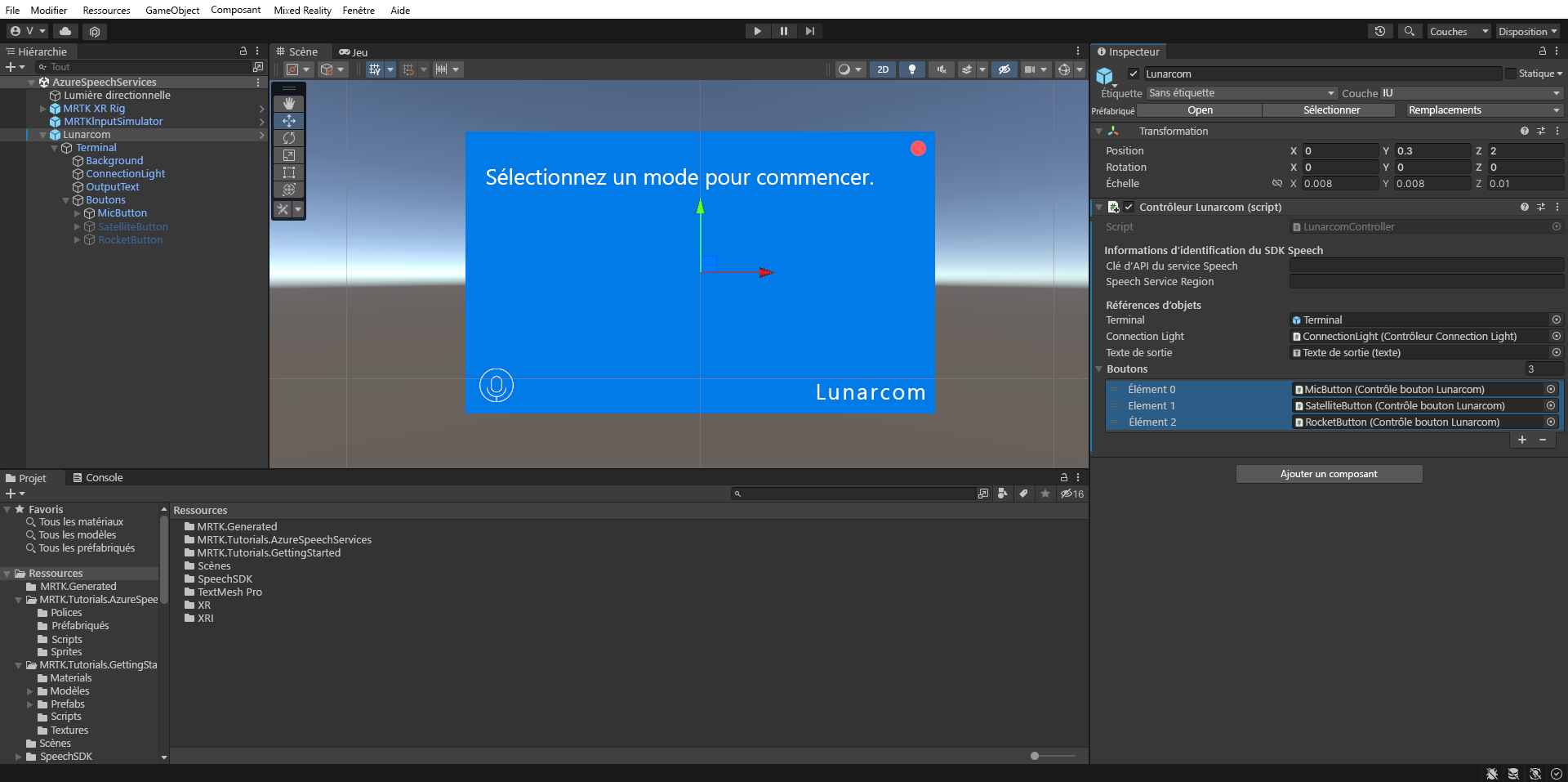

Avec l’objet Lunarcom toujours sélectionné, développez l’objet Buttons pour révéler ses objets enfants, puis dans la fenêtre Inspecteur, développez la liste Boutons, définissez le champ Boutons sur 3, puis faites glisser les objets MicButton, SatelliteButton et RocketButton dans les champs Élément 0, 1 et 2 respectivement.

Connecter le projet Unity à la ressource Azure

Pour utiliser les services Azure Speech, vous devez créer une ressource Azure et obtenir une clé API pour le service Speech. Suivez les instructions de démarrage rapide et notez votre région de service (également appelée Emplacement), ainsi que votre clé API (également appelée Key1 ou Key2).

Dans la fenêtre Hierarchy, sélectionnez l’objet Lunarcom, puis dans la fenêtre Inspector, localisez la section Speech SDK Credentials du composant Lunarcom Controller (Script) et configurez-la de la façon suivante :

- Dans le champ Clé API du service Speech, entrez votre clé API (Key1 ou Key2).

- Dans le champ Région du service Speech, entrez votre région de service (Emplacement) à l’aide de lettres minuscules, avec les espaces supprimés.

Utiliser la reconnaissance vocale pour transcrire la parole

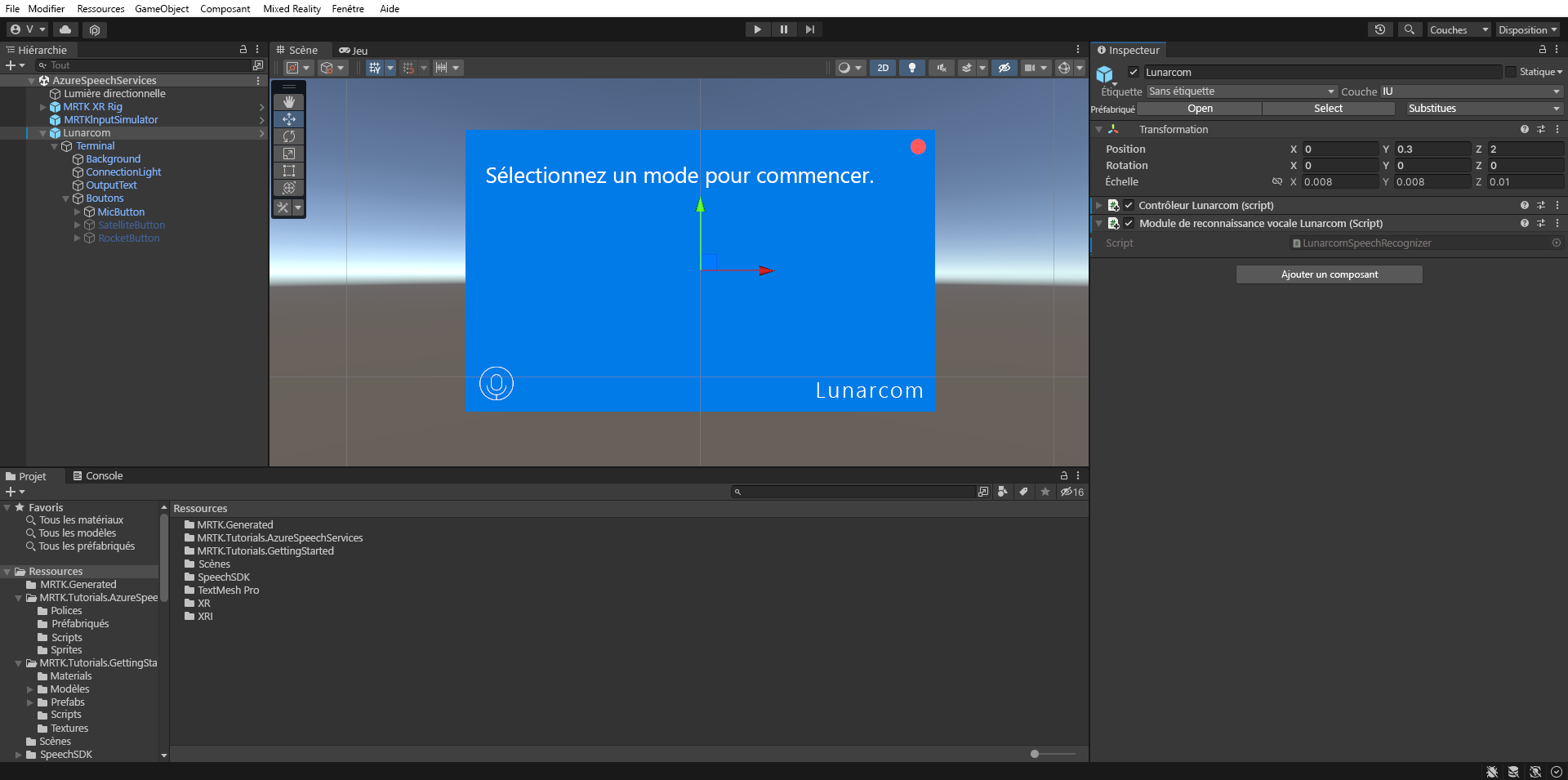

Dans la fenêtre Hiérarchie, sélectionnez l’objet Lunarcom, puis, dans la fenêtre Inspector, utilisez le bouton Ajouter un composant pour ajouter le composant Lunarcom Speech Recognizer (Script) à l’objet Lunarcom.

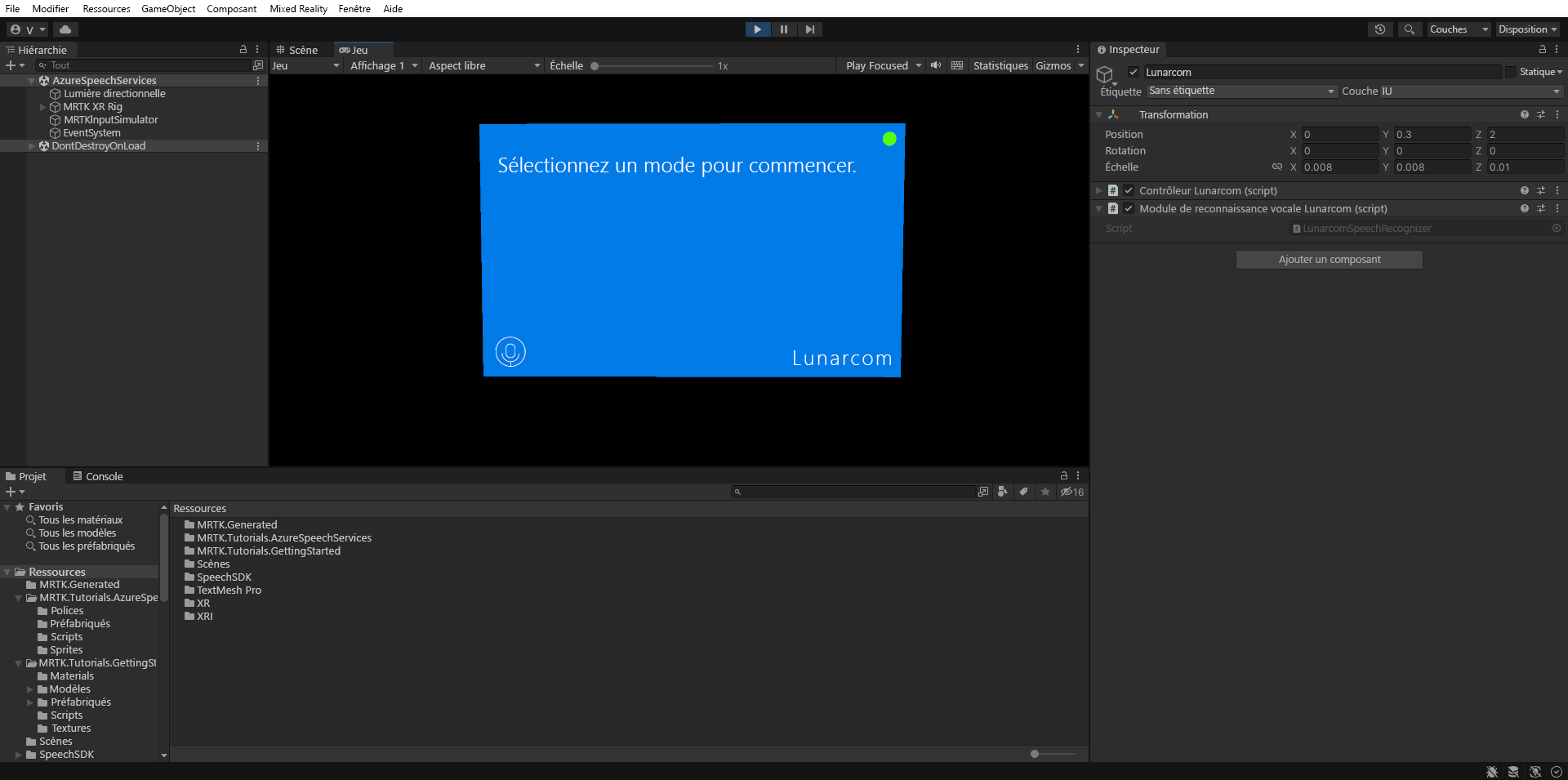

Si vous entrez maintenant en mode Jeu et sélectionnez le bouton Jouer, vous pouvez tester la reconnaissance vocale en appuyant d’abord sur le bouton du microphone :

Ensuite, en supposant que votre ordinateur est doté d’un microphone, quand vous dites quelque chose, votre parole est transcrite sur le panneau du terminal :

Attention

L’application a besoin de se connecter à Azure, donc vérifiez que votre ordinateur/appareil est connecté à Internet.